یہ پوسٹ شیبانگی ساہا، ڈیٹا سائنٹسٹ، اور گریسیلا کراوٹزوف، ایکویلیبرئم پوائنٹ کی شریک بانی اور سی ٹی او نے مشترکہ طور پر لکھی ہے۔

بہت سے افراد ذہنی بیماری کی نئی علامات کا سامنا کر رہے ہیں، جیسے تناؤ، اضطراب، ڈپریشن، مادے کا استعمال، اور پوسٹ ٹرامیٹک اسٹریس ڈس آرڈر (PTSD)۔ کے مطابق کیسر فیملی فاؤنڈیشنملک بھر میں تقریباً نصف بالغوں (47%) نے وبائی امراض کے دوران دماغی صحت پر منفی اثرات کی اطلاع دی ہے، جو کہ وبائی امراض سے پہلے کی سطح سے نمایاں اضافہ ہے۔ اس کے علاوہ، بعض جنسوں اور عمر کے گروہوں میں تناؤ اور پریشانی کی اطلاع دینے کا سب سے زیادہ امکان ہے، جس کی شرح دوسروں کے مقابلے میں بہت زیادہ ہے۔ مزید برآں، چند مخصوص نسلی گروہ دوسروں کے مقابلے میں اپنی ذہنی صحت پر "بڑے اثر" کی اطلاع دیتے ہیں۔

کئی سروے، بشمول سینٹرز فار ڈیزیز کنٹرول (CDC) کے ذریعے جمع کیے گئے، نے خود رپورٹ شدہ رویے سے متعلق صحت کی علامات میں خاطر خواہ اضافہ دکھایا ہے۔ سی ڈی سی کی ایک رپورٹ کے مطابق، جس نے 2020 کے جون کے آخر میں امریکہ بھر کے بالغوں کا سروے کیا، 31 فیصد جواب دہندگان نے اضطراب یا ڈپریشن کی علامات ظاہر کیں، 13 فیصد نے مادے کا استعمال شروع کرنے یا بڑھنے کی اطلاع دی، 26 فیصد نے تناؤ سے متعلق علامات کی اطلاع دی، اور 11 فیصد نے پچھلے 30 دنوں میں خودکشی کے بارے میں سنگین خیالات آنے کی اطلاع دی گئی۔

خود رپورٹ شدہ ڈیٹا، دماغی صحت کی خرابیوں کی تشخیص میں بالکل اہم ہونے کے باوجود، دماغی صحت اور دماغی صحت کے علاج سے متعلق مسلسل بدنما داغ سے متعلق اثرات کا نشانہ بن سکتا ہے۔ مکمل طور پر خود رپورٹ کردہ ڈیٹا پر انحصار کرنے کے بجائے، ہم صحت کے ریکارڈ اور دعوے کے ڈیٹا سے ایک بنیادی سوال کا جواب دینے کی کوشش کرتے ہوئے ذہنی پریشانی کا اندازہ لگا سکتے ہیں اور اس کی پیش گوئی کر سکتے ہیں: کیا ہم یہ پیش گوئی کر سکتے ہیں کہ ممکنہ طور پر کس کو ذہنی صحت سے متعلق مدد کی ضرورت ہو گی؟ اگر ان افراد کی شناخت کی جا سکتی ہے تو، ابتدائی مداخلت کے پروگرام اور وسائل تیار کیے جا سکتے ہیں اور کسی بھی نئے یا بنیادی علامات میں اضافے کا جواب دینے کے لیے استعمال کیے جا سکتے ہیں تاکہ ذہنی امراض کے اثرات اور اخراجات کو کم کیا جا سکے۔

ان لوگوں کے لیے کرنا آسان ہے جنہوں نے پیچیدہ، خلاء سے بھرے دعووں کے ڈیٹا کی بڑی مقدار کو منظم کرنے اور اس پر کارروائی کرنے میں جدوجہد کی ہے! اس پوسٹ میں، ہم کس طرح اشتراک کرتے ہیں توازن پوائنٹ IoT استعمال کیا جاتا ہے ایمیزون سیج میکر ڈیٹا رینگلر ہمارے دماغی صحت کے استعمال کے کیس کے لیے دعووں کے ڈیٹا کی تیاری کو ہموار کرنے کے لیے، عمل کے ہر مرحلے میں ڈیٹا کے معیار کو یقینی بناتے ہوئے

حل جائزہ

ڈیٹا کی تیاری یا فیچر انجینئرنگ ایک تکلیف دہ عمل ہے، جس کے لیے تجربہ کار ڈیٹا سائنسدانوں اور انجینئرز کو ڈیٹا کو درست شکل میں لانے کے لیے درکار مختلف تبدیلیوں (اقدامات) کے لیے ترکیبیں بنانے میں بہت زیادہ وقت اور توانائی صرف کرنے کی ضرورت ہوتی ہے۔ درحقیقت، تحقیق سے پتہ چلتا ہے کہ مشین لرننگ (ML) کے لیے ڈیٹا کی تیاری میں ڈیٹا سائنسدانوں کا 80% وقت خرچ ہوتا ہے۔ عام طور پر، سائنسدان اور انجینئر اپنی تبدیلیوں کو کوڈ کرنے اور تقسیم شدہ پروسیسنگ جابز تخلیق کرنے کے لیے مختلف ڈیٹا پروسیسنگ فریم ورکس، جیسے پانڈاس، پی اسپارک، اور ایس کیو ایل کا استعمال کرتے ہیں۔ ڈیٹا رینگلر کے ساتھ، آپ اس عمل کو خودکار کر سکتے ہیں۔ ڈیٹا رینگلر کا ایک جزو ہے۔ ایمیزون سیج میکر اسٹوڈیو جو ڈیٹا کو درآمد کرنے، تیار کرنے، تبدیل کرنے، فیچرائز کرنے اور تجزیہ کرنے کے لیے ایک اختتام سے آخر تک حل فراہم کرتا ہے۔ آپ ڈیٹا رینگلر کو ضم کر سکتے ہیں۔ ڈیٹا کے بہاؤ اپنے موجودہ ایم ایل ورک فلوز میں ڈیٹا پروسیسنگ اور فیچر انجینئرنگ کو آسان اور ہموار کرنے کے لیے بہت کم یا بغیر کوڈنگ کے استعمال کرتے ہیں۔

اس پوسٹ میں، ہم اگلے مرحلے میں پیشین گوئی کے ماڈلز کی تعمیر کے لیے استعمال کرنے کے لیے اصل خام ڈیٹا سیٹس کو ML کے لیے تیار خصوصیات میں تبدیل کرنے کے لیے اقدامات کرتے ہیں۔ سب سے پہلے، ہم اپنے استعمال کے کیس کے لیے استعمال ہونے والے مختلف ڈیٹاسیٹس کی نوعیت اور ڈیٹا رینگلر کے ذریعے ان ڈیٹاسیٹس میں کیسے شامل ہوئے اس کا جائزہ لیتے ہیں۔ شمولیت اور ڈیٹا سیٹ کے استحکام کے بعد، ہم انفرادی تبدیلیوں کی وضاحت کرتے ہیں جنہیں ہم نے ڈیٹاسیٹ پر لاگو کیا جیسے ڈی-ڈپلیکیشن، گمشدہ اقدار کو سنبھالنا، اور حسب ضرورت فارمولے، جس کے بعد ہم نے تبدیلیوں کی موجودہ حالت کی توثیق کرنے کے لیے بلٹ ان کوئیک ماڈل تجزیہ کا استعمال کیسے کیا۔ پیشین گوئیوں کے لیے

ڈیٹا سیٹ

اپنے تجربے کے لیے، ہم نے پہلے اپنے رویے کی صحت کے کلائنٹ سے مریض کا ڈیٹا ڈاؤن لوڈ کیا۔ اس ڈیٹا میں درج ذیل شامل ہیں:

- ڈیٹا کا دعویٰ

- ایمرجنسی روم کے دورے کی تعداد

- مریضوں کے دورے کی تعداد

- منشیات کے نسخے کا شمار دماغی صحت سے متعلق ہے۔

- درجہ بندی کی حالت کوڈنگ (HCC) دماغی صحت سے متعلق شماروں کی تشخیص کرتی ہے۔

مقصد یہ تھا کہ مریض کی شناخت کی بنیاد پر ان علیحدہ ڈیٹا سیٹس میں شامل ہوں اور دماغی صحت کی تشخیص کی پیشین گوئی کے لیے ڈیٹا کا استعمال کریں۔ ہم نے ڈیٹا رینگلر کا استعمال کرتے ہوئے ڈیٹا کی کئی ملین قطاروں کا ایک بڑے ڈیٹاسیٹ کو تخلیق کیا، جو کہ پانچ الگ الگ ڈیٹا سیٹس کا جوڑ ہے۔ ہم نے ڈیٹا رینگلر کا استعمال کالم کے حسابات کی اجازت دینے کے لیے کئی تبدیلیاں کرنے کے لیے بھی کیا۔ درج ذیل حصوں میں، ہم ڈیٹا کی تیاری کی مختلف تبدیلیوں کی وضاحت کرتے ہیں جن کا ہم نے اطلاق کیا ہے۔

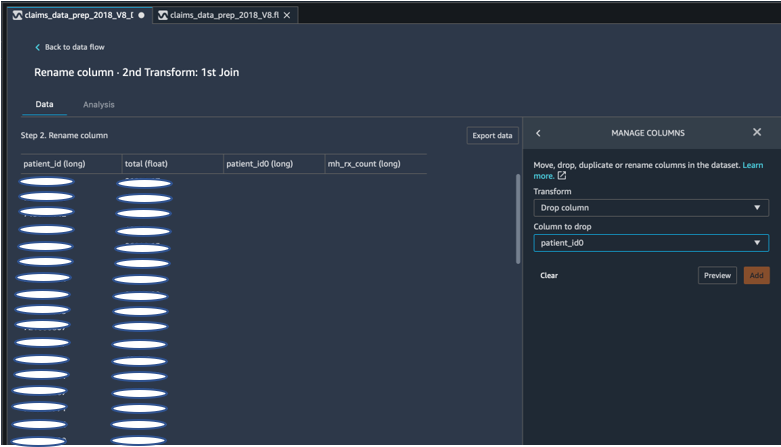

شمولیت کے بعد ڈپلیکیٹ کالم چھوڑ دیں۔

Amazon SageMaker Data Wrangler آپ کے ڈیٹا کو صاف کرنے، تبدیل کرنے اور اسے نمایاں کرنے کے لیے متعدد ML ڈیٹا ٹرانسفارمز فراہم کرتا ہے۔ جب آپ ٹرانسفارم شامل کرتے ہیں، تو یہ ڈیٹا کے بہاؤ میں ایک قدم کا اضافہ کرتا ہے۔ ہر تبدیلی جو آپ شامل کرتے ہیں وہ آپ کے ڈیٹاسیٹ میں ترمیم کرتا ہے اور ایک نیا ڈیٹا فریم تیار کرتا ہے۔ اس کے بعد کی تمام تبدیلیاں نتیجے میں آنے والے ڈیٹا فریم پر لاگو ہوتی ہیں۔ ڈیٹا رینگلر میں بلٹ ان ٹرانسفارمز شامل ہیں، جسے آپ بغیر کسی کوڈ کے کالم کو تبدیل کرنے کے لیے استعمال کر سکتے ہیں۔ آپ PySpark، Pandas، اور PySpark SQL کا استعمال کرتے ہوئے اپنی مرضی کے مطابق تبدیلیاں بھی شامل کر سکتے ہیں۔ کچھ تبدیلیاں اپنی جگہ پر کام کرتی ہیں، جبکہ دیگر آپ کے ڈیٹاسیٹ میں ایک نیا آؤٹ پٹ کالم بناتے ہیں۔

ہمارے تجربات کے لیے، چونکہ ہر مریض کی شناخت پر شمولیت کے بعد، ہمارے پاس ڈپلیکیٹ مریض ID کالم رہ گئے تھے۔ ہمیں ان کالموں کو چھوڑنے کی ضرورت تھی۔ ہم نے صحیح مریض ID کالم کو گرا دیا، جیسا کہ پہلے سے بنایا ہوا استعمال کرتے ہوئے درج ذیل اسکرین شاٹ میں دکھایا گیا ہے۔ کالموں کا نظم کریں۔ ->ڈراپ کالم تبدیلی، صرف ایک مریض ID کالم کو برقرار رکھنے کے لیے (فائنل ڈیٹاسیٹ میں مریض_آئی ڈی)۔

Pandas کا استعمال کرتے ہوئے ڈیٹا سیٹ کو محور کریں۔

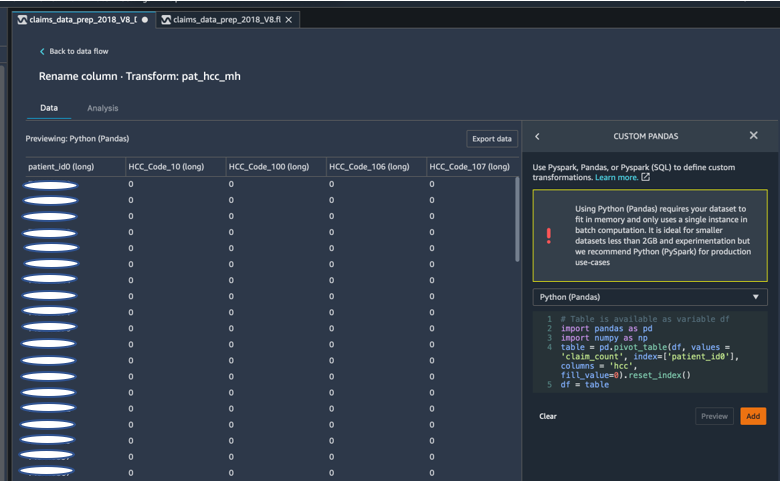

دعووں کے ڈیٹاسیٹس ایمرجنسی وزٹ (ER)، داخل مریض (IP)، نسخے کی گنتی، اور تشخیصی ڈیٹا کے ساتھ مریض کی سطح پر تھے جو پہلے ہی ان کے نمائندے HCC کوڈز (تقریباً 189 کوڈز) کے ذریعے گروپ کیے گئے تھے۔ مریض کا ڈیٹا مارٹ بنانے کے لیے، ہم مریض کے دعوے HCC کوڈز کو جمع کرتے ہیں اور HCC کوڈ کو قطاروں سے کالم تک محور کرتے ہیں۔ ہم نے ڈیٹا سیٹ کو محور کرنے، مریض کے حساب سے HCC کوڈز کی تعداد گننے، اور پھر مریض کی ID پر بنیادی ڈیٹا سیٹ میں شامل ہونے کے لیے پانڈوں کا استعمال کیا۔ ہم نے ڈیٹا رینگلر میں Python (Pandas) کو پسند کے فریم ورک کے طور پر منتخب کرتے ہوئے اپنی مرضی کے مطابق تبدیلی کا اختیار استعمال کیا۔

درج ذیل کوڈ کا ٹکڑا ٹیبل کو محور کرنے کے لیے تبدیلی کی منطق کو ظاہر کرتا ہے:

حسب ضرورت فارمولوں کا استعمال کرتے ہوئے نئے کالم بنائیں

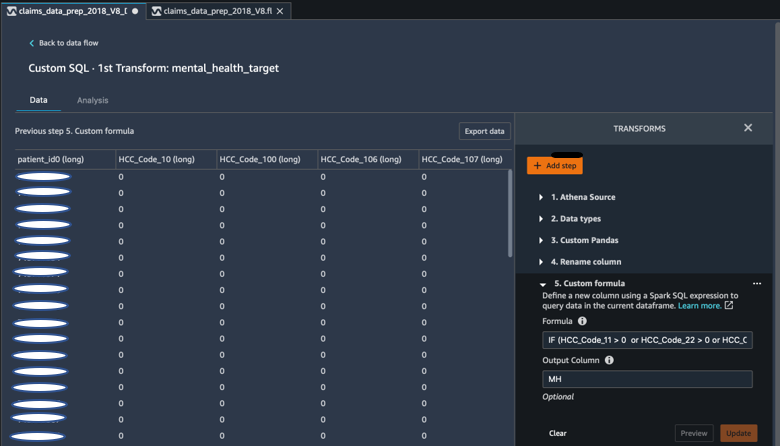

ہم نے تحقیقی لٹریچر کا مطالعہ کیا تاکہ اس بات کا تعین کیا جا سکے کہ دماغی صحت کی تشخیص میں کون سے ایچ سی سی کوڈز متعین ہیں۔ پھر ہم نے یہ منطق ڈیٹا رینگلر کسٹم فارمولہ ٹرانسفارم کا استعمال کرتے ہوئے لکھی جو دماغی صحت کی تشخیص کے ہدف کالم (MH) کا حساب لگانے کے لیے Spark SQL اظہار کا استعمال کرتی ہے، جسے ہم نے ڈیٹا فریم کے آخر میں شامل کیا۔

ہم نے درج ذیل تبدیلی کی منطق کا استعمال کیا:

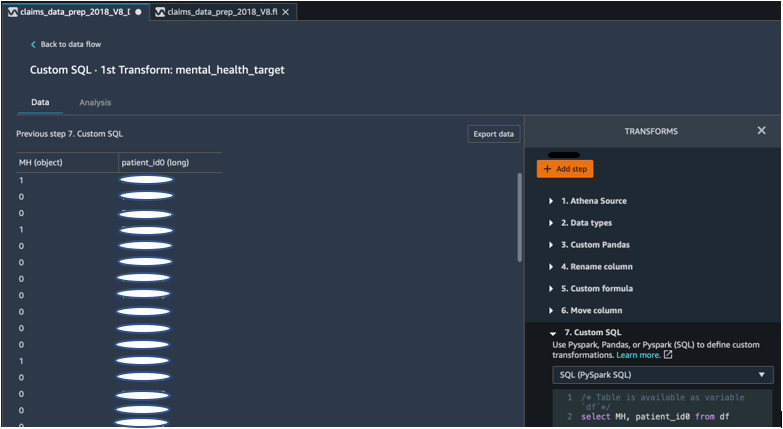

PySpark کا استعمال کرتے ہوئے ڈیٹا فریم سے کالم ڈراپ کریں۔

ہدف (MH) کالم کا حساب لگانے کے بعد، ہم نے تمام غیر ضروری ڈپلیکیٹ کالموں کو چھوڑ دیا۔ ہم نے اپنے بنیادی ڈیٹاسیٹ میں شامل ہونے کے لیے مریض کی شناخت اور MH کالم کو محفوظ رکھا۔ یہ ایک حسب ضرورت ایس کیو ایل ٹرانسفارم کے ذریعے سہولت فراہم کی گئی ہے جو ہماری پسند کے فریم ورک کے طور پر PySpark SQL استعمال کرتا ہے۔

ہم نے مندرجہ ذیل منطق کا استعمال کیا:

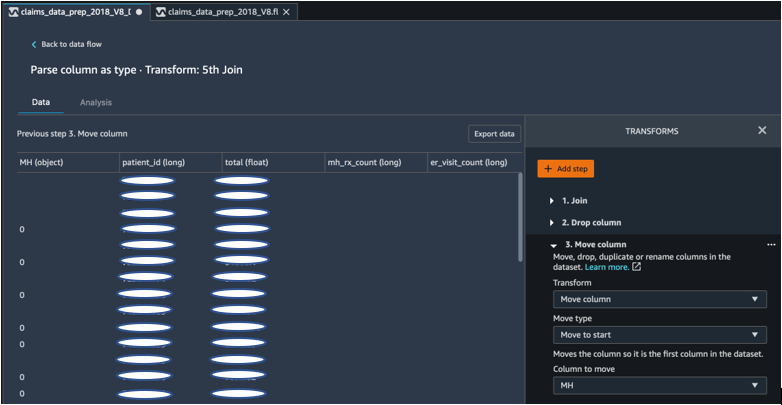

شروع کرنے کے لیے MH کالم کو منتقل کریں۔

ہمارے ML الگورتھم کا تقاضا ہے کہ لیبل لگا ہوا ان پٹ پہلے کالم میں ہو۔ لہذا، ہم نے برآمد کے لیے تیار ہونے کے لیے ڈیٹا فریم کے آغاز میں MH کیلکولیڈ کالم کو منتقل کیا۔

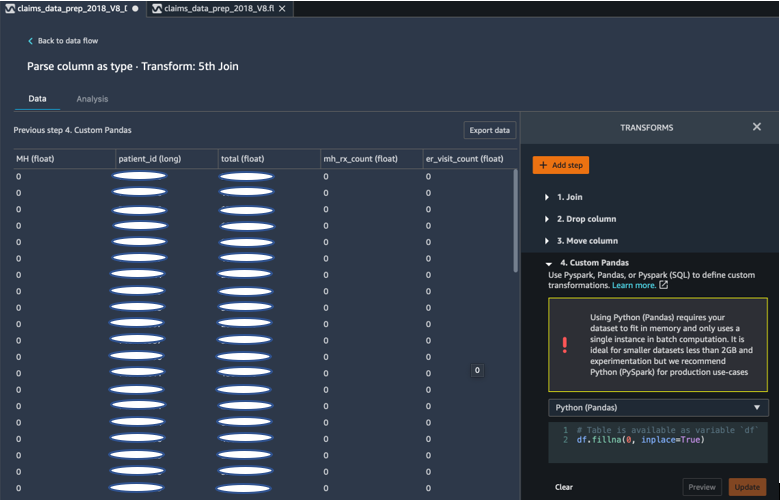

پانڈوں کا استعمال کرتے ہوئے 0 سے خالی جگہ پر کریں۔

ہمارا ML الگورتھم یہ بھی تقاضا کرتا ہے کہ ان پٹ ڈیٹا میں کوئی خالی فیلڈ نہ ہو۔ لہذا، ہم نے فائنل ڈیٹاسیٹ کے خالی فیلڈز کو 0s سے بھر دیا۔ ہم ڈیٹا رینگلر میں کسٹم ٹرانسفارم (پانڈا) کے ذریعے یہ آسانی سے کر سکتے ہیں۔

ہم نے مندرجہ ذیل منطق کا استعمال کیا:

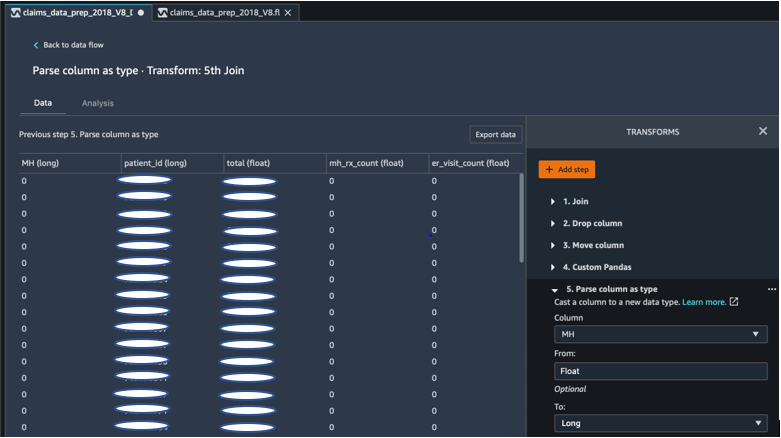

فلوٹ سے لمبے تک کالم کاسٹ کریں۔

آپ ڈیٹا رینگلر میں آسانی سے کسی بھی نئے ڈیٹا ٹائپ پر کالم کو پارس اور کاسٹ بھی کر سکتے ہیں۔ میموری کو بہتر بنانے کے مقاصد کے لیے، ہم اپنے دماغی صحت کے لیبل کے ان پٹ کالم کو فلوٹ کے طور پر کاسٹ کرتے ہیں۔

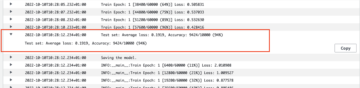

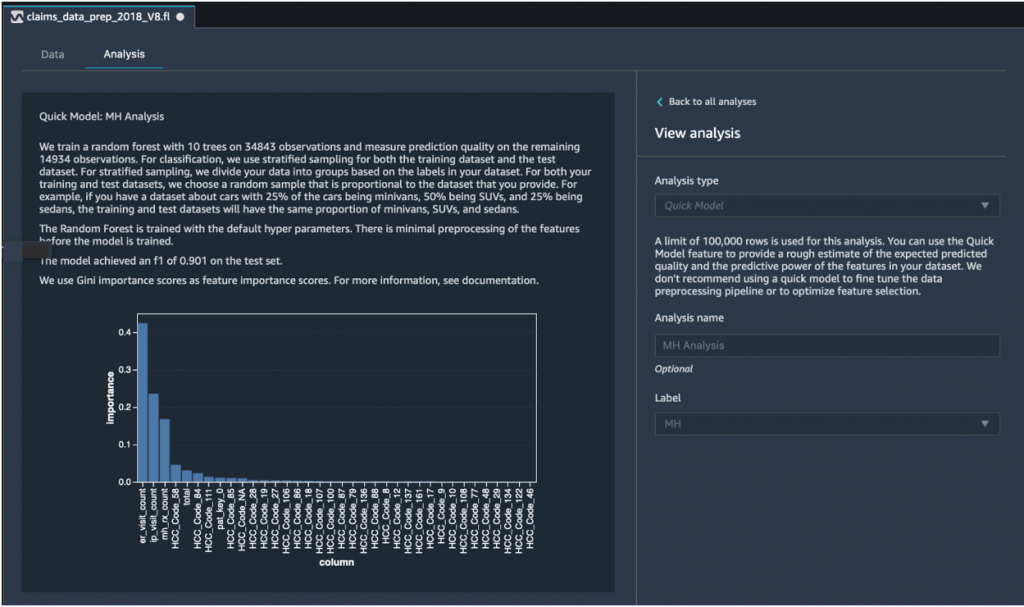

فوری ماڈل تجزیہ: خصوصیت کی اہمیت کا گراف

اپنا حتمی ڈیٹا سیٹ بنانے کے بعد، ہم نے ڈیٹا رینگلر میں کوئیک ماڈل کے تجزیہ کی قسم کا استعمال کیا تاکہ ڈیٹا میں تضادات کی فوری شناخت کی جا سکے اور اگر ہمارے ماڈل کی درستگی متوقع حد میں تھی، یا اگر ہمیں ماڈل کی تربیت کا وقت گزارنے سے پہلے فیچر انجینئرنگ کو جاری رکھنے کی ضرورت تھی۔ ماڈل نے 1 کا F0.901 سکور واپس کیا، جس میں 1 سب سے زیادہ ہے۔ F1 سکور ماڈل کی درستگی اور یاد کو یکجا کرنے کا ایک طریقہ ہے، اور اسے دونوں کے ہارمونک مطلب کے طور پر بیان کیا گیا ہے۔ ان ابتدائی مثبت نتائج کا معائنہ کرنے کے بعد، ہم ڈیٹا کو ایکسپورٹ کرنے اور ایکسپورٹ شدہ ڈیٹا سیٹ کا استعمال کرتے ہوئے ماڈل ٹریننگ کے ساتھ آگے بڑھنے کے لیے تیار تھے۔

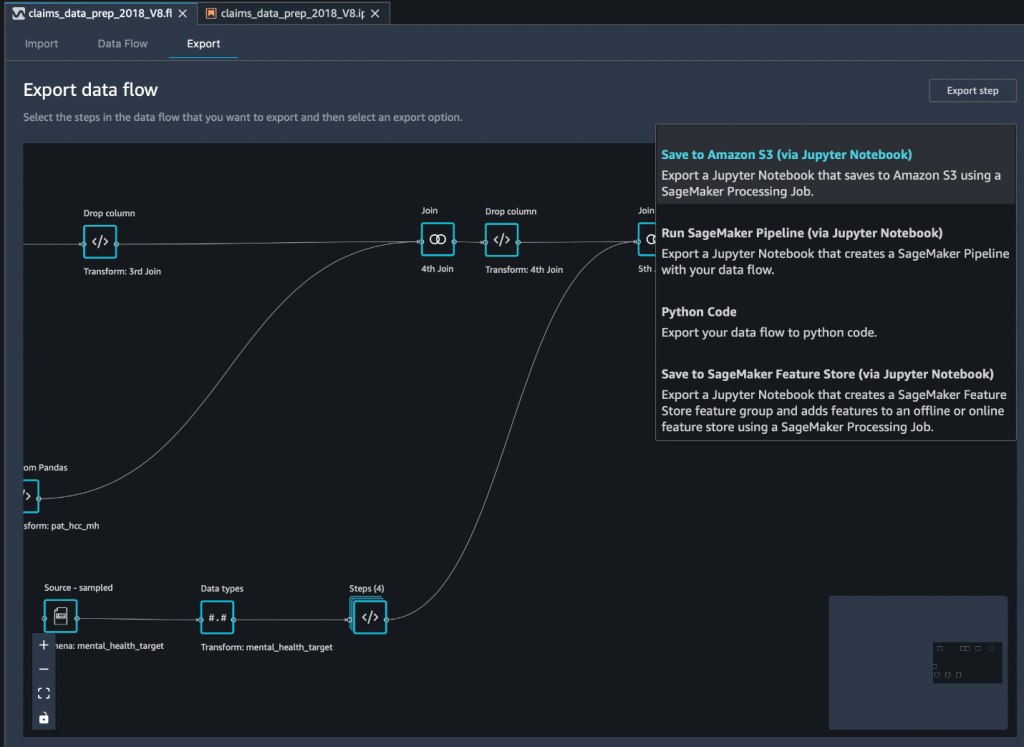

حتمی ڈیٹا سیٹ کو Jupyter نوٹ بک کے ذریعے Amazon S3 میں ایکسپورٹ کریں۔

حتمی قدم کے طور پر، ڈیٹاسیٹ کو اس کی موجودہ شکل (تبدیل شدہ) میں برآمد کرنا ایمیزون سادہ اسٹوریج سروس (ایمیزون S3) ماڈل ٹریننگ پر مستقبل کے استعمال کے لیے، ہم استعمال کرتے ہیں۔ Amazon S3 میں محفوظ کریں (بذریعہ Jupyter Notebook) برآمد کا اختیار. یہ نوٹ بک تقسیم شدہ اور توسیع پذیر شروع ہوتی ہے۔ ایمیزون سیج میکر پروسیسنگ وہ کام جو تیار کردہ ترکیب (ڈیٹا فلو) کو مخصوص ان پٹس (عام طور پر بڑے ڈیٹاسیٹس) پر لاگو کرتا ہے اور نتائج کو Amazon S3 میں محفوظ کرتا ہے۔ آپ اپنے تبدیل شدہ کالم (خصوصیات) کو بھی ایکسپورٹ کر سکتے ہیں۔ ایمیزون سیج میکر فیچر اسٹور یا تبدیلیوں کو پائپ لائن کے طور پر استعمال کرتے ہوئے برآمد کریں۔ ایمیزون سیج میکر پائپ لائنز، یا صرف تبدیلیوں کو ازگر کوڈ کے طور پر برآمد کریں۔

Amazon S3 پر ڈیٹا ایکسپورٹ کرنے کے لیے، آپ کے پاس تین اختیارات ہیں:

- ڈیٹا رینگلر UI کے ذریعے تبدیل شدہ ڈیٹا کو براہ راست Amazon S3 میں ایکسپورٹ کریں۔

- سیج میکر پروسیسنگ جاب کے بطور Jupyter نوٹ بک کے ذریعے تبدیلیاں برآمد کریں (جیسا کہ ہم اس پوسٹ کے لیے کرتے ہیں)۔

- ٹرانسفارمیشنز کو ایمیزون S3 میں ڈیسٹینیشن نوڈ کے ذریعے ایکسپورٹ کریں۔ ایک منزل نوڈ ڈیٹا رینگلر کو بتاتا ہے کہ آپ کے ڈیٹا پر کارروائی کرنے کے بعد اسے کہاں ذخیرہ کرنا ہے۔ منزل کا نوڈ بنانے کے بعد، آپ ڈیٹا کو آؤٹ پٹ کرنے کے لیے پروسیسنگ جاب بناتے ہیں۔

نتیجہ

اس پوسٹ میں، ہم نے دکھایا کہ کس طرح Equilibrium Point IoT ڈیٹا رینگلر کا استعمال کرتا ہے تاکہ ڈیٹا کی صفائی اور ML کی تیاری میں تبدیلی کے لیے ہمارے کلیمز ڈیٹا کی بڑی مقدار کو لوڈ کرنے کے عمل کو تیز کیا جا سکے۔ ہم نے یہ بھی دکھایا کہ ڈیٹا رینگلر میں Pandas اور PySpark کا استعمال کرتے ہوئے اپنی مرضی کے مطابق تبدیلیوں کے ساتھ فیچر انجینئرنگ کو کیسے شامل کیا جائے، جس سے ہمیں کوالٹی اشورینس کے مقاصد کے لیے مرحلہ وار (ہر شمولیت کے بعد) ڈیٹا برآمد کرنے کی اجازت ملتی ہے۔ ڈیٹا رینگلر میں استعمال میں ان آسان ٹرانسفارمز کے اطلاق سے اینڈ ٹو اینڈ ڈیٹا ٹرانسفارمیشن پر خرچ ہونے والے وقت میں تقریباً 50 فیصد کمی واقع ہوتی ہے۔ نیز، ڈیٹا رینگلر میں کوئیک ماڈل کے تجزیہ کی خصوصیت نے ہمیں آسانی سے تبدیلیوں کی حالت کی توثیق کرنے کی اجازت دی جب ہم ڈیٹا کی تیاری اور فیچر انجینئرنگ کے عمل سے گزرتے ہیں۔

اب جب کہ ہم نے اپنے دماغی صحت کے خطرے کے ماڈلنگ کے استعمال کے کیس کے لیے ڈیٹا تیار کر لیا ہے، اگلے مرحلے کے طور پر، ہم SageMaker اور اس کے پیش کردہ بلٹ ان الگورتھم کا استعمال کرتے ہوئے ایک ML ماڈل بنانے کا ارادہ رکھتے ہیں، اپنے دعووں کے ڈیٹاسیٹ کو استعمال کرتے ہوئے ان ممبروں کی شناخت کے لیے استعمال کریں جنہیں دماغی صحت کی تلاش کرنی چاہیے۔ خدمات اس مقام تک پہنچنے سے پہلے جہاں انہیں ضرورت ہو۔ دیکھتے رہنا!

مصنفین کے بارے میں

شبانگی ساہا Equilibrium Point میں ڈیٹا سائنٹسٹ ہے۔ وہ ہیلتھ کیئر پیئر کے دعووں کے ڈیٹا اور مشین لرننگ میں اپنی مہارت کو یکجا کرتی ہے تاکہ ہیلتھ ڈیٹا پائپ لائنز، رپورٹنگ، اور تجزیاتی عمل کو ڈیزائن، لاگو، خودکار، اور دستاویز بنایا جا سکے جو صحت کی دیکھ بھال کی فراہمی کے نظام میں بصیرت اور قابل عمل بہتری کو آگے بڑھاتے ہیں۔ شبانگی نے نارتھ ایسٹرن یونیورسٹی کالج آف سائنس سے بائیو انفارمیٹکس میں ماسٹر آف سائنس اور کھوری کالج آف کمپیوٹر سائنس اینڈ انفارمیشن سائنسز سے بیالوجی اور کمپیوٹر سائنس میں بیچلر آف سائنس حاصل کیا۔

شبانگی ساہا Equilibrium Point میں ڈیٹا سائنٹسٹ ہے۔ وہ ہیلتھ کیئر پیئر کے دعووں کے ڈیٹا اور مشین لرننگ میں اپنی مہارت کو یکجا کرتی ہے تاکہ ہیلتھ ڈیٹا پائپ لائنز، رپورٹنگ، اور تجزیاتی عمل کو ڈیزائن، لاگو، خودکار، اور دستاویز بنایا جا سکے جو صحت کی دیکھ بھال کی فراہمی کے نظام میں بصیرت اور قابل عمل بہتری کو آگے بڑھاتے ہیں۔ شبانگی نے نارتھ ایسٹرن یونیورسٹی کالج آف سائنس سے بائیو انفارمیٹکس میں ماسٹر آف سائنس اور کھوری کالج آف کمپیوٹر سائنس اینڈ انفارمیشن سائنسز سے بیالوجی اور کمپیوٹر سائنس میں بیچلر آف سائنس حاصل کیا۔

گریسیلا کراوٹزوف Equilibrium Point کے شریک بانی اور CTO ہیں۔ گریس نے انجینئرنگ، آپریشنز اور کوالٹی کے اندر C-level/VP لیڈر شپ کے عہدوں پر فائز ہیں، اور صحت کی دیکھ بھال اور تعلیم کی صنعتوں اور IoT صنعتی جگہ کے اندر کاروباری حکمت عملی اور مصنوعات کی ترقی کے لیے ایک ایگزیکٹو کنسلٹنٹ کے طور پر خدمات انجام دیں۔ گریس نے یونیورسٹی آف بیونس آئرس سے الیکٹرو مکینیکل انجینئر میں ماسٹر آف سائنس کی ڈگری حاصل کی اور بوسٹن یونیورسٹی سے کمپیوٹر سائنس میں ماسٹر آف سائنس کی ڈگری حاصل کی۔

گریسیلا کراوٹزوف Equilibrium Point کے شریک بانی اور CTO ہیں۔ گریس نے انجینئرنگ، آپریشنز اور کوالٹی کے اندر C-level/VP لیڈر شپ کے عہدوں پر فائز ہیں، اور صحت کی دیکھ بھال اور تعلیم کی صنعتوں اور IoT صنعتی جگہ کے اندر کاروباری حکمت عملی اور مصنوعات کی ترقی کے لیے ایک ایگزیکٹو کنسلٹنٹ کے طور پر خدمات انجام دیں۔ گریس نے یونیورسٹی آف بیونس آئرس سے الیکٹرو مکینیکل انجینئر میں ماسٹر آف سائنس کی ڈگری حاصل کی اور بوسٹن یونیورسٹی سے کمپیوٹر سائنس میں ماسٹر آف سائنس کی ڈگری حاصل کی۔

ارون پرستھ شنکر AWS کے ساتھ ایک آرٹیفیشل انٹیلی جنس اور مشین لرننگ (AI/ML) ماہر حل آرکیٹیکٹ ہے، جو عالمی صارفین کو اپنے AI سلوشنز کو کلاؤڈ میں موثر اور مؤثر طریقے سے پیمانہ کرنے میں مدد کرتا ہے۔ اپنے فارغ وقت میں، ارون سائنس فائی فلمیں دیکھنا اور کلاسیکی موسیقی سننا پسند کرتے ہیں۔

ارون پرستھ شنکر AWS کے ساتھ ایک آرٹیفیشل انٹیلی جنس اور مشین لرننگ (AI/ML) ماہر حل آرکیٹیکٹ ہے، جو عالمی صارفین کو اپنے AI سلوشنز کو کلاؤڈ میں موثر اور مؤثر طریقے سے پیمانہ کرنے میں مدد کرتا ہے۔ اپنے فارغ وقت میں، ارون سائنس فائی فلمیں دیکھنا اور کلاسیکی موسیقی سننا پسند کرتے ہیں۔

اجے شرما Amazon SageMaker کے لیے ایک سینئر پروڈکٹ مینیجر ہے جہاں وہ SageMaker Data Wrangler پر توجہ مرکوز کرتا ہے، جو ڈیٹا سائنسدانوں کے لیے بصری ڈیٹا کی تیاری کا آلہ ہے۔ AWS سے پہلے، Ajai McKinsey and Company میں ڈیٹا سائنس کے ماہر تھے جہاں انہوں نے دنیا بھر میں معروف فنانس اور انشورنس فرموں کے لیے ML پر مرکوز مصروفیات کی قیادت کی۔ اجائی ڈیٹا سائنس کے بارے میں پرجوش ہے اور جدید ترین الگورتھم اور مشین لرننگ تکنیکوں کو دریافت کرنا پسند کرتا ہے۔

اجے شرما Amazon SageMaker کے لیے ایک سینئر پروڈکٹ مینیجر ہے جہاں وہ SageMaker Data Wrangler پر توجہ مرکوز کرتا ہے، جو ڈیٹا سائنسدانوں کے لیے بصری ڈیٹا کی تیاری کا آلہ ہے۔ AWS سے پہلے، Ajai McKinsey and Company میں ڈیٹا سائنس کے ماہر تھے جہاں انہوں نے دنیا بھر میں معروف فنانس اور انشورنس فرموں کے لیے ML پر مرکوز مصروفیات کی قیادت کی۔ اجائی ڈیٹا سائنس کے بارے میں پرجوش ہے اور جدید ترین الگورتھم اور مشین لرننگ تکنیکوں کو دریافت کرنا پسند کرتا ہے۔

- سکے سمارٹ۔ یورپ کا بہترین بٹ کوائن اور کرپٹو ایکسچینج۔

- پلیٹو بلاک چین۔ Web3 Metaverse انٹیلی جنس۔ علم میں اضافہ۔ مفت رسائی۔

- کرپٹو ہاک۔ Altcoin ریڈار. مفت جانچ.

- Source: https://aws.amazon.com/blogs/machine-learning/build-a-mental-health-machine-learning-risk-model-using-amazon-sagemaker-data-wrangler/

- "

- 100

- 2020

- ہمارے بارے میں

- کے مطابق

- کے پار

- AI

- یلگورتم

- یلگوردمز

- تمام

- اجازت دے رہا ہے

- پہلے ہی

- ایمیزون

- کے درمیان

- مقدار

- تجزیہ

- تجزیاتی

- بے چینی

- درخواست

- مصنوعی

- مصنوعی ذہانت

- مصنوعی انٹیلی جنس اور مشین سیکھنا

- دستیاب

- AWS

- کیا جا رہا ہے

- حیاتیات

- سرحد

- بوسٹن

- تعمیر

- عمارت

- تعمیر میں

- کاروبار

- دعوے

- صفائی

- بادل

- شریک بانی

- کوڈ

- کوڈنگ

- کالج

- کالم

- کمپنی کے

- پیچیدہ

- جزو

- کمپیوٹر سائنس

- شرط

- سمیکن

- کنسلٹنٹ

- جاری

- کنٹرول

- اخراجات

- تخلیق

- اہم

- CTO

- موجودہ

- موجودہ حالت

- اپنی مرضی کے

- گاہکوں

- اعداد و شمار

- ڈیٹا پروسیسنگ

- ڈیٹا سائنس

- ڈیٹا سائنسدان

- ترسیل

- demonstrated,en

- ڈپریشن

- ڈیزائن

- ترقی یافتہ

- ترقی

- بیماری

- تقسیم کئے

- نیچے

- ڈرائیو

- چھوڑ

- گرا دیا

- ابتدائی

- آسانی سے

- تعلیم

- اثرات

- توانائی

- انجینئر

- انجنیئرنگ

- انجینئرز

- کو یقینی بنانے ہے

- تخمینہ

- ایگزیکٹو

- توقع

- تجربہ کار

- تجربہ

- مہارت

- تلاش

- خاندان

- نمایاں کریں

- خصوصیات

- قطعات

- کی مالی اعانت

- پہلا

- بہاؤ

- توجہ مرکوز

- کے بعد

- فارم

- فریم ورک

- مستقبل

- گلوبل

- مقصد

- ہینڈلنگ

- ہونے

- صحت

- صحت کی دیکھ بھال

- مدد

- اعلی

- کس طرح

- کیسے

- HTTPS

- شناخت

- بیماری

- پر عملدرآمد

- اہمیت

- سمیت

- اضافہ

- اضافہ

- انفرادی

- صنعتی

- صنعتوں

- معلومات

- بصیرت

- انشورنس

- ضم

- انٹیلی جنس

- IOT

- IP

- IT

- ایوب

- نوکریاں

- میں شامل

- شامل ہو گئے

- کے ساتھ گفتگو

- بڑے

- بڑے

- تازہ ترین

- قیادت

- معروف

- سیکھنے

- قیادت

- سطح

- سن

- ادب

- تھوڑا

- مشین

- مشین لرننگ

- برقرار رکھنے کے

- مینیجر

- مینیجنگ

- بڑے پیمانے پر

- اراکین

- یاد داشت

- دماغی صحت

- دس لاکھ

- ML

- ماڈل

- ماڈل

- زیادہ

- سب سے زیادہ

- فلم

- موسیقی

- فطرت، قدرت

- نوٹ بک

- تعداد

- متعدد

- تجویز

- آپریشنز

- اصلاح کے

- اختیار

- آپشنز کے بھی

- وبائی

- محور

- پوائنٹ

- مثبت

- پیشن گوئی

- کی پیشن گوئی

- پیشن گوئی

- نسخے

- پرائمری

- عمل

- عمل

- مصنوعات

- پروگرام

- فراہم کرتا ہے

- مقاصد

- معیار

- سوال

- جلدی سے

- رینج

- قیمتیں

- خام

- ریکارڈ

- رپورٹ

- تحقیق

- وسائل

- نتائج کی نمائش

- رسک

- کہا

- توسیع پذیر

- پیمانے

- سائنس

- سائنس

- سائنسدان

- سائنسدانوں

- سروسز

- سیکنڈ اور

- اہم

- سادہ

- حل

- حل

- خلا

- تیزی

- خرچ کرنا۔

- اسٹیج

- شروع کریں

- شروع

- شروع ہوتا ہے

- حالت

- رہنا

- ذخیرہ

- ذخیرہ

- ڈیٹا اسٹور کریں۔

- حکمت عملی

- کشیدگی

- مادہ

- کافی

- کے نظام

- ہدف

- تکنیک

- بتاتا ہے

- کے ذریعے

- بھر میں

- وقت

- کے آلے

- ٹریننگ

- تبدیل

- تبدیلی

- تبدیل

- علاج

- عام طور پر

- یونیورسٹی

- us

- استعمال کی شرائط

- عام طور پر

- استعمال

- مختلف

- ڈبلیو

- کے اندر

- بغیر

- دنیا بھر