آج سوشل میڈیا خبروں کا ایک بہت بڑا ذریعہ ہے۔ صارفین خبریں استعمال کرنے کے لیے فیس بک اور ٹوئٹر جیسے پلیٹ فارمز پر انحصار کرتے ہیں۔ بعض صنعتوں جیسے کہ بیمہ کمپنیاں، پہلے جواب دہندگان، قانون نافذ کرنے والے اداروں، اور سرکاری ایجنسیوں کے لیے، پیش آنے والے متعلقہ واقعات کے بارے میں خبروں پر تیزی سے کارروائی کرنے کے قابل ہونے سے انہیں کارروائی کرنے میں مدد مل سکتی ہے جب کہ یہ واقعات اب بھی سامنے آ رہے ہیں۔

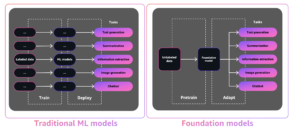

یہ غیر معمولی بات نہیں ہے کہ ٹیکسٹ ڈیٹا سے قدر نکالنے کی کوشش کرنے والی تنظیموں کے لیے کوئی ایسا حل تلاش کیا جائے جس میں ایک پیچیدہ NLP (قدرتی لینگویج پروسیسنگ) ماڈل کی تربیت شامل نہ ہو۔ ان تنظیموں کے لیے، پہلے سے تربیت یافتہ NLP ماڈل کا استعمال زیادہ عملی ہے۔ مزید برآں، اگر منتخب کردہ ماڈل ان کی کامیابی کے میٹرکس کو پورا نہیں کرتا ہے، تو تنظیمیں آسانی سے دوسرے ماڈل کو منتخب کرنے اور دوبارہ جائزہ لینے کے قابل ہونا چاہتی ہیں۔

فی الحال، درج ذیل کی بدولت ٹیکسٹ ڈیٹا سے معلومات نکالنا پہلے سے کہیں زیادہ آسان ہے:

- جدید ترین، عام مقصد کے NLP فن تعمیر جیسے ٹرانسفارمرز کا عروج

- وہ صلاحیت جو ڈویلپرز اور ڈیٹا سائنسدانوں کے پاس مشین لرننگ (ML) ماڈلز کو تیزی سے بنانے، تربیت دینے اور ان کو استعمال کرنے کے لیے کلاؤڈ پر اس طرح کی خدمات کے ساتھ ہے۔ ایمیزون سیج میکر

- سینکڑوں زبانوں میں ہزاروں پہلے سے تربیت یافتہ NLP ماڈلز کی دستیابی اور پلیٹ فارمز میں کمیونٹی کی طرف سے فراہم کردہ متعدد فریم ورکس کی حمایت کے ساتھ گلے لگانا چہرہ حب

اس پوسٹ میں، ہم آپ کو دکھاتے ہیں کہ ایک ریئل ٹائم الرٹ سسٹم کیسے بنایا جائے جو ٹویٹر کی خبروں کو استعمال کرے اور Hugging Face Hub سے پہلے سے تربیت یافتہ ماڈل کا استعمال کرتے ہوئے ٹویٹس کی درجہ بندی کرے۔ آپ اس حل کو زیرو شاٹ کی درجہ بندی کے لیے استعمال کر سکتے ہیں، یعنی آپ ٹویٹس کو عملی طور پر کسی بھی زمرے میں درجہ بندی کر سکتے ہیں، اور ریئل ٹائم انفرنس کے لیے SageMaker کے ساتھ ماڈل کو تعینات کر سکتے ہیں۔

متبادل طور پر، اگر آپ اپنے گاہک کی گفتگو کے بارے میں بصیرت تلاش کر رہے ہیں اور سوشل میڈیا کے تعاملات کا تجزیہ کر کے برانڈ بیداری کو گہرا کر رہے ہیں، تو ہم آپ کی حوصلہ افزائی کرتے ہیں کہ AI سے چلنے والا سوشل میڈیا ڈیش بورڈ. حل استعمال کرتا ہے۔ ایمیزون کی تعریف, ایک مکمل طور پر منظم NLP سروس جو کہ مشین لرننگ کے تجربے کی ضرورت کے بغیر متن میں قیمتی بصیرت اور کنکشن کا پتہ دیتی ہے۔

زیرو شاٹ لرننگ

NLP اور قدرتی زبان کی تفہیم (NLU) کے شعبوں نے متن کی درجہ بندی، سوالوں کے جوابات، خلاصہ، متن کی تخلیق، اور بہت کچھ کے استعمال کے معاملات کو حل کرنے کے لیے تیزی سے ترقی کی ہے۔ یہ ارتقاء ممکن ہوا ہے، جزوی طور پر، جدید ترین، عام مقصد کے فن تعمیر جیسے کہ ٹرانسفارمرز، بلکہ ایسے ماڈلز کی تربیت کے لیے دستیاب زیادہ اور بہتر معیار کے ٹیکسٹ کارپورا کی دستیابی کی بدولت۔

ٹرانسفارمر فن تعمیر ایک پیچیدہ اعصابی نیٹ ورک ہے جس کو شروع سے تربیت حاصل کرنے کے لیے ڈومین کی مہارت اور بہت زیادہ ڈیٹا کی ضرورت ہوتی ہے۔ ایک عام مشق یہ ہے کہ پہلے سے تربیت یافتہ جدید ترین ٹرانسفارمر جیسے BERT، RoBERTa، T5، GPT-2، یا DistilBERT اور ماڈل کو استعمال کے مخصوص کیس میں فائن ٹیون (ٹرانسفر لرننگ) لے جانا ہے۔

اس کے باوجود، پہلے سے تربیت یافتہ NLP ماڈل پر ٹرانسفر لرننگ انجام دینا بھی اکثر ایک مشکل کام ہو سکتا ہے، جس میں ڈیٹا کو درست کرنے کے لیے بڑی مقدار میں لیبل والے ٹیکسٹ ڈیٹا اور ماہرین کی ٹیم کی ضرورت ہوتی ہے۔ یہ پیچیدگی زیادہ تر تنظیموں کو ان ماڈلز کو مؤثر طریقے سے استعمال کرنے سے روکتی ہے، لیکن زیرو شاٹ لرننگ ایم ایل پریکٹیشنرز اور تنظیموں کو اس کمی کو دور کرنے میں مدد کرتی ہے۔

زیرو شاٹ لرننگ ایک مخصوص ایم ایل ٹاسک ہے جس میں کلاسیفائر ٹریننگ کے دوران لیبلز کے ایک سیٹ پر سیکھتا ہے، اور پھر انفرنس کے دوران لیبلز کے مختلف سیٹ پر جانچا جاتا ہے جسے کلاسیفائر نے پہلے کبھی نہیں دیکھا۔ NLP میں، آپ بغیر کسی فائن ٹیوننگ کے ٹیکسٹ کی درجہ بندی کرنے کے لیے قدرتی لینگویج انفرنس (NLI) ٹاسک پر تربیت یافتہ زیرو شاٹ سیکوینس کلاسیفائر استعمال کر سکتے ہیں۔ اس پوسٹ میں، ہم مقبول NLI استعمال کرتے ہیں۔ BART ماڈل bart-large-mnli ٹویٹس کی درجہ بندی کرنے کے لیے۔ یہ ایک بڑا پہلے سے تربیت یافتہ ماڈل (1.6 GB) ہے، جو Hugging Face ماڈل ہب پر دستیاب ہے۔

Hugging Face ایک AI کمپنی ہے جو 100 سے زیادہ مختلف زبانوں میں ہزاروں پہلے سے تربیت یافتہ NLP ماڈلز (ٹرانسفارمرز) کے ساتھ اور TensorFlow اور PyTorch جیسے مختلف فریم ورکس کے تعاون کے ساتھ ایک اوپن سورس پلیٹ فارم (ہگنگ فیس ہب) کا انتظام کرتی ہے۔ ٹرانسفارمرز لائبریری ڈویلپرز اور ڈیٹا سائنسدانوں کو پیچیدہ NLP اور NLU کاموں جیسے درجہ بندی، معلومات نکالنے، سوالوں کے جوابات، خلاصہ، ترجمہ، اور ٹیکسٹ جنریشن میں شروع کرنے میں مدد کرتی ہے۔

AWS اور گلے ملنے والا چہرہ NLP ماڈلز کو اپنانے کو آسان بنانے اور تیز کرنے کے لیے تعاون کر رہے ہیں۔ PyTorch یا TensorFlow میں تربیت اور اندازہ کے لیے ڈیپ لرننگ کنٹینرز (DLCs) کا ایک سیٹ، اور SageMaker Python SDK کے لیے گلے لگانے والے چہرے کے تخمینے اور پیشن گوئی کرنے والے اب دستیاب ہیں۔ یہ صلاحیتیں ہر سطح کی مہارت کے حامل ڈویلپرز کو NLP کے ساتھ آسانی سے شروعات کرنے میں مدد کرتی ہیں۔

حل کا جائزہ

ہم ایک کام کرنے والا حل فراہم کرتے ہیں جو منتخب ٹویٹر اکاؤنٹس سے حقیقی وقت میں ٹویٹس حاصل کرتا ہے۔ اپنے حل کے مظاہرے کے لیے، ہم تین اکاؤنٹس استعمال کرتے ہیں، Amazon Web Services (sawscloud)، AWS سیکیورٹی (@AWSSecurityInfo)، اور ایمیزون سائنس (@AmazonScience)، اور ان کے مواد کو درج ذیل زمروں میں سے ایک میں درجہ بندی کریں: سیکیورٹی، ڈیٹا بیس، کمپیوٹ، اسٹوریج، اور مشین لرننگ۔ اگر ماڈل 40% سے زیادہ اعتماد کے سکور کے ساتھ زمرہ واپس کرتا ہے، تو ایک اطلاع بھیجی جاتی ہے۔

مندرجہ ذیل مثال میں، ماڈل نے ایمیزون ویب سروسز کی طرف سے ایک ٹویٹ کو مشین لرننگ کے زمرے میں، 97% کے اعتماد کے اسکور کے ساتھ، ایک الرٹ پیدا کیا۔

حل ایک ہگنگ فیس پری ٹرینڈ ٹرانسفارمر ماڈل (ہگنگ فیس ہب سے) پر انحصار کرتا ہے تاکہ لیبلز کے سیٹ کی بنیاد پر ٹویٹس کی درجہ بندی کی جا سکے جو کہ تخمینہ کے وقت فراہم کیے جاتے ہیں — ماڈل کو تربیت دینے کی ضرورت نہیں ہے۔ درج ذیل اسکرین شاٹس مزید مثالیں دکھاتے ہیں اور ان کی درجہ بندی کیسے کی گئی تھی۔

ہم آپ کو اپنے لیے حل آزمانے کی ترغیب دیتے ہیں۔ بس سے سورس کوڈ ڈاؤن لوڈ کریں۔ GitHub ذخیرہ اور README فائل میں تعیناتی کی ہدایات پر عمل کریں۔

حل فن تعمیر

حل ٹویٹر کے اختتامی نقطہ سے کھلا کنکشن رکھتا ہے اور، جب کوئی نیا ٹویٹ آتا ہے، تو قطار میں پیغام بھیجتا ہے۔ ایک صارف قطار سے پیغامات پڑھتا ہے، درجہ بندی کے اختتامی نقطہ کو کال کرتا ہے، اور نتائج کے لحاظ سے، آخری صارف کو مطلع کرتا ہے۔

ذیل میں حل کا آرکیٹیکچر ڈایاگرام ہے۔

حل ورک فلو مندرجہ ذیل اجزاء پر مشتمل ہے:

- حل ٹویٹر کے اسٹریم API پر انحصار کرتا ہے تاکہ وہ ٹویٹس حاصل کریں جو ریئل ٹائم میں ترتیب شدہ قواعد (دلچسپی کے اکاؤنٹس سے ٹویٹس) سے مماثل ہوں۔ ایسا کرنے کے لیے، کنٹینر کے اندر چلنے والی ایپلیکیشن ٹوئٹر کے اینڈ پوائنٹ سے کھلا کنکشن رکھتی ہے۔ کا حوالہ دیتے ہیں ٹویٹر API مزید تفصیلات کے لئے.

- کنٹینر چلتا ہے۔ ایمیزون لچکدار کنٹینر سروس (Amazon ECS)، ایک مکمل طور پر منظم کنٹینر آرکیسٹریشن سروس جو آپ کے لیے کنٹینرائزڈ ایپلی کیشنز کو تعینات، ان کا نظم اور اسکیل کرنا آسان بناتی ہے۔ ایک واحد کام بغیر سرور کے بنیادی ڈھانچے پر چلتا ہے جس کے زیر انتظام ہے۔ اے ڈبلیو ایس فارگیٹ.

- ٹویٹر بیئرر ٹوکن محفوظ طریقے سے محفوظ ہے۔ AWS سسٹمز مینیجر پیرامیٹر اسٹورکی صلاحیت AWS سسٹمز مینیجر جو کنفیگریشن ڈیٹا اور رازوں کے لیے محفوظ، درجہ بندی کا ذخیرہ فراہم کرتا ہے۔ کنٹینر کی تصویر پر میزبانی کی گئی ہے۔ ایمیزون لچکدار کنٹینر رجسٹری (Amazon ECR)، ایک مکمل طور پر منظم کنٹینر رجسٹری جو اعلیٰ کارکردگی کی میزبانی کی پیشکش کرتی ہے۔

- جب بھی کوئی نیا ٹویٹ آتا ہے، کنٹینر ایپلی کیشن ٹویٹ کو ایک میں ڈال دیتی ہے۔ ایمیزون سادہ قطار سروس (ایمیزون SQS) قطار۔ Amazon SQS ایک مکمل طور پر منظم میسج کیونگ سروس ہے جو آپ کو مائیکرو سروسز، ڈسٹری بیوٹڈ سسٹمز اور سرور لیس ایپلیکیشنز کو ڈیکپل اور اسکیل کرنے کے قابل بناتی ہے۔

- حل کی منطق ایک میں رہتی ہے۔ او ڈبلیو ایس لامبڈا۔ فنکشن لیمبڈا ایک سرور لیس، ایونٹ سے چلنے والی کمپیوٹ سروس ہے۔ فنکشن قطار سے نئی ٹویٹس استعمال کرتا ہے اور اختتامی نقطہ کو کال کرکے ان کی درجہ بندی کرتا ہے۔

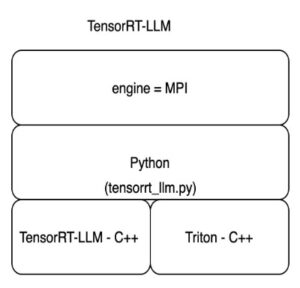

- اختتامی نقطہ Hugging Face ماڈل پر انحصار کرتا ہے اور SageMaker پر ہوسٹ کیا جاتا ہے۔ اختتامی نقطہ تخمینہ چلاتا ہے اور ٹویٹ کی کلاس کو آؤٹ پٹ کرتا ہے۔

- درجہ بندی پر منحصر ہے، فنکشن کے ذریعے ایک اطلاع تیار کرتا ہے۔ ایمیزون سادہ نوٹیفکیشن سروس (Amazon SNS)، ایک مکمل طور پر منظم پیغام رسانی کی خدمت۔ آپ SNS موضوع کو سبسکرائب کر سکتے ہیں، اور متعدد منزلیں یہ اطلاع موصول کر سکتی ہیں (دیکھیں۔ Amazon SNS ایونٹ کے مقامات)۔ مثال کے طور پر، آپ ان باکسز کو ای میل پیغامات کے طور پر اطلاع پہنچا سکتے ہیں (دیکھیں۔ ای میل اطلاعات).

سیج میکر کے ساتھ گلے لگانے والے چہرے کے ماڈل تعینات کریں۔

آپ عوامی طور پر دستیاب 10,000 سے زیادہ ماڈلز میں سے کوئی بھی منتخب کر سکتے ہیں۔ گلے لگانا چہرہ ماڈل ہب اور استعمال کرکے انہیں سیج میکر کے ساتھ تعینات کریں۔ گلے لگانا چہرے کا انفرنس DLCs.

استعمال کرتے وقت AWS کلاؤڈ فارمیشن، آپ عوامی طور پر دستیاب میں سے ایک کو منتخب کرتے ہیں۔ چہرے کا اندازہ لگانے والے کنٹینرز کو گلے لگانا اور ماڈل اور کام کو ترتیب دیں۔ یہ حل استعمال کرتا ہے۔ facebook/bart-large-mnli ماڈل اور زیرو شاٹ کی درجہ بندی کا کام، لیکن آپ اس کے تحت کسی بھی ماڈل کا انتخاب کر سکتے ہیں۔ زیرو شاٹ کی درجہ بندی گلے لگانے والے چہرے کے ماڈل ہب پر۔ آپ اپنے CloudFormation ٹیمپلیٹ میں HF_MODEL_ID اور HF_TASK ماحولیاتی متغیرات کو ترتیب دے کر ان کو ترتیب دیتے ہیں، جیسا کہ درج ذیل کوڈ میں ہے:

متبادل طور پر، اگر آپ AWS CloudFormation استعمال نہیں کر رہے ہیں، تو آپ کوڈ کی چند لائنوں کے ساتھ وہی نتائج حاصل کر سکتے ہیں۔ کا حوالہ دیتے ہیں ایمیزون سیج میکر پر ماڈلز تعینات کریں۔ مزید تفصیلات کے لئے.

مواد کی درجہ بندی کرنے کے لیے، آپ صرف سیج میکر اینڈ پوائنٹ کو کال کریں۔ مندرجہ ذیل ایک ازگر کوڈ کا ٹکڑا ہے:

یاد رکھیں جھوٹی کے لئے قدر ملٹی_کلاس پیرامیٹر اس بات کی نشاندہی کرنے کے لیے کہ ہر کلاس کے لیے تمام امکانات کا مجموعہ 1 تک شامل ہو جائے گا۔

حل میں بہتری

آپ ٹویٹس اور ماڈل کے نتائج کو ذخیرہ کرکے یہاں تجویز کردہ حل کو بڑھا سکتے ہیں۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3)، ایک آبجیکٹ اسٹوریج سروس، ایک آپشن ہے۔ آپ ٹویٹس، نتائج، اور دیگر میٹا ڈیٹا کو JSON آبجیکٹ کے بطور S3 بالٹی میں لکھ سکتے ہیں۔ اس کے بعد آپ اس مواد کا استعمال کرتے ہوئے ایڈہاک سوالات کر سکتے ہیں۔ ایمیزون ایتینا، ایک انٹرایکٹو استفسار سروس جو معیاری SQL کا استعمال کرتے ہوئے Amazon S3 میں ڈیٹا کا تجزیہ کرنا آسان بناتی ہے۔

آپ تاریخ کو نہ صرف بصیرت نکالنے کے لیے استعمال کر سکتے ہیں بلکہ اپنی مرضی کے ماڈل کو تربیت دینے کے لیے بھی استعمال کر سکتے ہیں۔ آپ SageMaker کے ساتھ اپنے ڈیٹا کے ساتھ ماڈل کو تربیت دینے کے لیے Hugging Face سپورٹ کا استعمال کر سکتے ہیں۔ پر مزید جانیں ایمیزون سیج میکر پر ٹریننگ چلائیں۔.

حقیقی دنیا کے استعمال کے معاملات۔

صارفین پہلے ہی سیج میکر پر ہیگنگ فیس ماڈل کے ساتھ تجربہ کر رہے ہیں۔ سیگوروس بولیوار1939 میں قائم ہونے والی کولمبیا کی مالیاتی اور انشورنس کمپنی ایک مثال ہے۔

"ہم نے صارفین اور انشورنس بروکرز کے لیے خطرے کی اطلاع کا حل تیار کیا ہے۔ ہم متعلقہ اکاؤنٹس سے ٹویٹس کی درجہ بندی کرنے کے لیے Hugging Face کے پہلے سے تربیت یافتہ NLP ماڈلز کا استعمال کرتے ہیں تاکہ دعوؤں کو کم کرنے میں مدد کرنے کے لیے روک تھام کی حکمت عملی کے طور پر قریب حقیقی وقت میں اپنے صارفین کے لیے اطلاعات پیدا کی جا سکیں۔ ایک دعوی اس لیے ہوتا ہے کیونکہ صارفین اس خطرے کی سطح سے واقف نہیں ہوتے ہیں جس کا انہیں سامنا ہے۔ یہ حل ہمیں اپنے صارفین میں بیداری پیدا کرنے کی اجازت دیتا ہے، ٹھوس حالات میں خطرے کو قابل پیمائش چیز میں بدل دیتا ہے۔"

- جولین ریکو، سیگوروس بولیوار میں تحقیق اور علم کے سربراہ۔

Seguros Bolívar نے AWS کے ساتھ اپنے حل کو دوبارہ تعمیر کرنے کے لیے کام کیا۔ یہ اب SageMaker پر انحصار کرتا ہے اور اس پوسٹ میں بیان کردہ سے ملتا جلتا ہے۔

نتیجہ

زیرو شاٹ کی درجہ بندی اس وقت مثالی ہے جب آپ کے پاس حسب ضرورت ٹیکسٹ کلاسیفائر کو تربیت دینے کے لیے بہت کم ڈیٹا ہو یا جب آپ حسب ضرورت NLP ماڈل کو تربیت دینے کے متحمل نہ ہوں۔ مخصوص استعمال کے معاملات کے لیے، جب متن مخصوص الفاظ یا اصطلاحات پر مبنی ہوتا ہے، تو یہ بہتر ہے کہ اپنی مرضی کے تربیتی سیٹ کی بنیاد پر زیر نگرانی درجہ بندی کے ماڈل کے ساتھ چلیں۔

اس پوسٹ میں، ہم نے آپ کو دکھایا کہ AWS پر Hugging Face zero-shot ماڈل کا استعمال کرتے ہوئے نیوز کلاسیفائر کیسے بنایا جائے۔ ہم نے ٹویٹر کو اپنے نیوز ماخذ کے طور پر استعمال کیا، لیکن آپ ایک خبر کا ذریعہ منتخب کر سکتے ہیں جو آپ کی مخصوص ضروریات کے لیے زیادہ موزوں ہو۔ مزید برآں، آپ ماڈل کو آسانی سے تبدیل کر سکتے ہیں، صرف CloudFormation ٹیمپلیٹ میں اپنے منتخب کردہ ماڈل کی وضاحت کریں۔

سورس کوڈ کے لیے، کا حوالہ دیں۔ GitHub ذخیرہ اس میں سیٹ اپ کی مکمل ہدایات شامل ہیں۔ آپ اسے خود کلون، تبدیل، تعینات اور چلا سکتے ہیں۔ آپ اسے نقطہ آغاز کے طور پر بھی استعمال کر سکتے ہیں اور زمرہ جات اور الرٹ منطق کو اپنی مرضی کے مطابق بنا سکتے ہیں یا اسی طرح کے استعمال کے معاملے کے لیے کوئی دوسرا حل تیار کر سکتے ہیں۔

براہ کرم اسے آزمائیں، اور ہمیں بتائیں کہ آپ کیا سوچتے ہیں۔ ہمیشہ کی طرح، ہم آپ کے تاثرات کے منتظر ہیں۔ آپ اسے اپنے معمول کے AWS سپورٹ رابطوں، یا میں بھیج سکتے ہیں۔ AWS فورم برائے سیج میکر.

مصنفین کے بارے میں

ڈیوڈ لاریڈو LATAM میں AWS Envision انجینئرنگ میں ایک پروٹو ٹائپنگ آرکیٹیکٹ ہے، جہاں اس نے متعدد مشین لرننگ پروٹو ٹائپ تیار کرنے میں مدد کی ہے۔ اس سے پہلے وہ مشین لرننگ انجینئر کے طور پر کام کر چکے ہیں اور 5 سال سے زیادہ عرصے سے مشین لرننگ کر رہے ہیں۔ اس کی دلچسپی کے شعبے NLP، ٹائم سیریز، اور اینڈ ٹو اینڈ ایم ایل ہیں۔

ڈیوڈ لاریڈو LATAM میں AWS Envision انجینئرنگ میں ایک پروٹو ٹائپنگ آرکیٹیکٹ ہے، جہاں اس نے متعدد مشین لرننگ پروٹو ٹائپ تیار کرنے میں مدد کی ہے۔ اس سے پہلے وہ مشین لرننگ انجینئر کے طور پر کام کر چکے ہیں اور 5 سال سے زیادہ عرصے سے مشین لرننگ کر رہے ہیں۔ اس کی دلچسپی کے شعبے NLP، ٹائم سیریز، اور اینڈ ٹو اینڈ ایم ایل ہیں۔

رافیل ورنک برازیل میں مقیم AWS Envision انجینئرنگ میں ایک سینئر پروٹوٹائپنگ آرکیٹیکٹ ہیں۔ اس سے پہلے، وہ Amazon.com.br اور Amazon RDS پرفارمنس انسائٹس پر سافٹ ویئر ڈویلپمنٹ انجینئر کے طور پر کام کرتا تھا۔

رافیل ورنک برازیل میں مقیم AWS Envision انجینئرنگ میں ایک سینئر پروٹوٹائپنگ آرکیٹیکٹ ہیں۔ اس سے پہلے، وہ Amazon.com.br اور Amazon RDS پرفارمنس انسائٹس پر سافٹ ویئر ڈویلپمنٹ انجینئر کے طور پر کام کرتا تھا۔

وکرم ایلنگو ورجینیا، USA میں واقع Amazon Web Services میں ایک AI/ML ماہر حل آرکیٹیکٹ ہے۔ وکرم مالیاتی اور انشورنس انڈسٹری کے صارفین کو ڈیزائن اور سوچی سمجھی قیادت کے ساتھ مشین لرننگ ایپلی کیشنز کو بڑے پیمانے پر بنانے اور تعینات کرنے میں مدد کرتا ہے۔ وہ فی الحال پورے انٹرپرائز میں قدرتی زبان کی پروسیسنگ، ذمہ دار AI، انفرنس آپٹیمائزیشن، اور ML اسکیلنگ پر مرکوز ہے۔ اپنے فارغ وقت میں، وہ اپنے خاندان کے ساتھ سفر، پیدل سفر، کھانا پکانے اور کیمپنگ سے لطف اندوز ہوتا ہے۔

وکرم ایلنگو ورجینیا، USA میں واقع Amazon Web Services میں ایک AI/ML ماہر حل آرکیٹیکٹ ہے۔ وکرم مالیاتی اور انشورنس انڈسٹری کے صارفین کو ڈیزائن اور سوچی سمجھی قیادت کے ساتھ مشین لرننگ ایپلی کیشنز کو بڑے پیمانے پر بنانے اور تعینات کرنے میں مدد کرتا ہے۔ وہ فی الحال پورے انٹرپرائز میں قدرتی زبان کی پروسیسنگ، ذمہ دار AI، انفرنس آپٹیمائزیشن، اور ML اسکیلنگ پر مرکوز ہے۔ اپنے فارغ وقت میں، وہ اپنے خاندان کے ساتھ سفر، پیدل سفر، کھانا پکانے اور کیمپنگ سے لطف اندوز ہوتا ہے۔

- AI

- ai آرٹ

- AI آرٹ جنریٹر

- عی روبوٹ

- ایمیزون مشین لرننگ

- ایمیزون سیج میکر

- مصنوعی ذہانت

- مصنوعی ذہانت کا سرٹیفیکیشن

- بینکنگ میں مصنوعی ذہانت

- مصنوعی ذہانت والا روبوٹ

- مصنوعی ذہانت والے روبوٹ

- مصنوعی ذہانت سافٹ ویئر

- AWS مشین لرننگ

- blockchain

- بلاکچین کانفرنس

- coingenius

- بات چیت مصنوعی ذہانت

- crypto کانفرنس ai

- dall-e

- گہری سیکھنے

- گوگل عی

- گلے لگانے والا چہرہ

- مشین لرننگ

- قدرتی زبان عملیات

- پلاٹا

- افلاطون اے

- افلاطون ڈیٹا انٹیلی جنس

- افلاطون گیم

- پلیٹو ڈیٹا

- پلیٹو گیمنگ

- پیمانہ ai

- نحو

- تکنیکی طریقہ

- متن کی درجہ بندی

- زیفیرنیٹ

- زیرو شاٹ لرننگ