جنریٹو AI مختلف صنعتوں بشمول تفریح، اشتہارات اور گرافک ڈیزائن میں تخلیقی عمل کو بڑھانے اور تیز کرنے کے لیے ایک عام ٹول بن گیا ہے۔ یہ سامعین کے لیے مزید ذاتی نوعیت کے تجربات کو قابل بناتا ہے اور حتمی مصنوعات کے مجموعی معیار کو بہتر بناتا ہے۔

جنریٹیو AI کا ایک اہم فائدہ صارفین کے لیے منفرد اور ذاتی نوعیت کے تجربات پیدا کرنا ہے۔ مثال کے طور پر، جنریٹو AI کا استعمال سٹریمنگ سروسز کے ذریعے ذاتی نوعیت کے فلمی عنوانات اور بصری تخلیق کرنے کے لیے کیا جاتا ہے تاکہ ناظرین کی مصروفیت کو بڑھایا جا سکے اور صارف کی دیکھنے کی تاریخ اور ترجیحات کی بنیاد پر عنوانات کے لیے بصری تیار کیا جا سکے۔ اس کے بعد سسٹم ٹائٹل کے آرٹ ورک کے ہزاروں تغیرات پیدا کرتا ہے اور ان کی جانچ کرتا ہے تاکہ یہ تعین کیا جا سکے کہ کون سا ورژن سب سے زیادہ صارف کی توجہ اپنی طرف کھینچتا ہے۔ کچھ معاملات میں، ذاتی نوعیت کے آرٹ ورک کے بغیر شوز کے مقابلے TV سیریز کے لیے ذاتی نوعیت کے آرٹ ورک نے کلک ہونے کی شرحوں اور دیکھنے کی شرحوں میں نمایاں اضافہ کیا۔

اس پوسٹ میں، ہم یہ ظاہر کرتے ہیں کہ آپ کس طرح جنریٹو AI ماڈلز جیسے اسٹیبل ڈفیوژن کو ذاتی نوعیت کا اوتار حل بنانے کے لیے استعمال کر سکتے ہیں۔ ایمیزون سیج میکر اور ایک ہی وقت میں ملٹی ماڈل اینڈ پوائنٹس (MMEs) کے ساتھ تخمینہ لاگت کو بچائیں۔ حل یہ ظاہر کرتا ہے کہ کس طرح، اپنی 10-12 تصاویر اپ لوڈ کر کے، آپ ایک ذاتی نوعیت کے ماڈل کو ٹھیک بنا سکتے ہیں جو پھر کسی بھی ٹیکسٹ پرامپٹ کی بنیاد پر اوتار بنا سکتا ہے، جیسا کہ درج ذیل اسکرین شاٹس میں دکھایا گیا ہے۔ اگرچہ یہ مثال ذاتی نوعیت کے اوتار تیار کرتی ہے، لیکن آپ مخصوص اشیاء یا طرزوں پر فائن ٹیوننگ کرکے اس تکنیک کو کسی بھی تخلیقی آرٹ کی نسل پر لاگو کرسکتے ہیں۔

حل جائزہ

مندرجہ ذیل آرکیٹیکچر ڈایاگرام ہمارے اوتار جنریٹر کے لیے آخر سے آخر تک حل کا خاکہ پیش کرتا ہے۔

![]()

اس پوسٹ کا دائرہ کار اور مثال گٹ ہب کوڈ ہم صرف ماڈل ٹریننگ اور انفرنس آرکیسٹریشن پر فوکس کرتے ہیں (پچھلے ڈایاگرام میں گرین سیکشن)۔ آپ مکمل حل فن تعمیر کا حوالہ دے سکتے ہیں اور جو مثال ہم فراہم کرتے ہیں اس کے اوپری حصے پر بنا سکتے ہیں۔

ماڈل ٹریننگ اور انفرنس کو چار مراحل میں تقسیم کیا جا سکتا ہے:

- پر تصاویر اپ لوڈ کریں۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3)۔ اس مرحلے میں، ہم آپ سے اپنی کم از کم 10 ہائی ریزولوشن تصاویر فراہم کرنے کو کہتے ہیں۔ جتنی زیادہ تصاویر، نتیجہ اتنا ہی بہتر، لیکن تربیت میں اتنا ہی زیادہ وقت لگے گا۔

- SageMaker غیر مطابقت پذیر تخمینہ کا استعمال کرتے ہوئے ایک مستحکم ڈفیوژن 2.1 بیس ماڈل کو ٹھیک بنائیں۔ ہم بعد میں اس پوسٹ میں ٹریننگ کے لیے ایک انفرنس اینڈ پوائنٹ کو استعمال کرنے کے استدلال کی وضاحت کرتے ہیں۔ فائن ٹیوننگ کا عمل تصاویر کی تیاری کے ساتھ شروع ہوتا ہے، بشمول چہرے کی کٹائی، پس منظر کی تبدیلی، اور ماڈل کے لیے سائز تبدیل کرنا۔ پھر ہم ماڈل کو ٹھیک کرنے کے لیے لو رینک اڈاپٹیشن (LoRA) کا استعمال کرتے ہیں، جو کہ بڑے لینگویج ماڈلز (LLMs) کے لیے پیرامیٹر سے موثر فائن ٹیوننگ تکنیک ہے۔ آخر میں، پوسٹ پروسیسنگ میں، ہم انفرنس اسکرپٹ اور کنفیگریشن فائلز (tar.gz) کے ساتھ فائن ٹیونڈ LoRA وزن کو پیک کرتے ہیں اور SageMaker MMEs کے لیے S3 بالٹی والے مقام پر اپ لوڈ کرتے ہیں۔

- GPU کے ساتھ SageMaker MMEs کا استعمال کرتے ہوئے ٹھیک ٹیونڈ ماڈلز کی میزبانی کریں۔ SageMaker ایمیزون S3 مقام سے ماڈل کو متحرک طور پر لوڈ اور کیش کرے گا جس کی بنیاد پر ہر ماڈل کے لیے انفرنس ٹریفک ہے۔

- اندازہ لگانے کے لیے ٹھیک ٹیونڈ ماڈل کا استعمال کریں۔ کے بعد ایمیزون سادہ نوٹیفکیشن سروس (ایمیزون ایس این ایس) نوٹیفکیشن جس میں ٹھیک ٹیوننگ کی نشاندہی کی گئی ہے بھیجی گئی ہے، آپ فوری طور پر اس ماڈل کو فراہم کر کے استعمال کر سکتے ہیں۔

target_modelپیرامیٹر جب آپ کا اوتار بنانے کے لیے ایم ایم ای کو طلب کریں۔

ہم مندرجہ ذیل حصوں میں ہر قدم کو مزید تفصیل سے بیان کرتے ہیں اور نمونے کے کوڈ کے کچھ ٹکڑوں کو دیکھتے ہیں۔

تصاویر تیار کریں۔

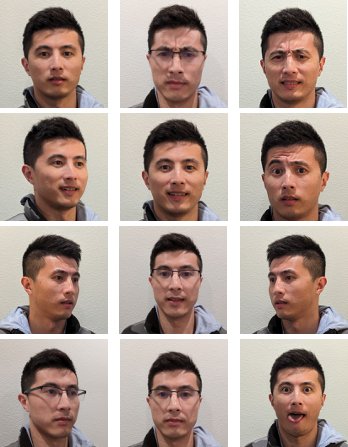

اپنی تصاویر بنانے کے لیے فائن ٹیوننگ سٹیبل ڈفیوژن سے بہترین نتائج حاصل کرنے کے لیے، آپ کو عام طور پر مختلف زاویوں سے، مختلف تاثرات کے ساتھ، اور مختلف پس منظر میں اپنی تصاویر کی ایک بڑی مقدار اور مختلف قسم فراہم کرنے کی ضرورت ہوتی ہے۔ تاہم، ہمارے نفاذ کے ساتھ، آپ اب کم از کم 10 ان پٹ امیجز کے ساتھ اعلیٰ معیار کا نتیجہ حاصل کر سکتے ہیں۔ ہم نے ہر تصویر سے آپ کا چہرہ نکالنے کے لیے خودکار پری پروسیسنگ بھی شامل کی ہے۔ آپ کو صرف اس بات کے جوہر کو حاصل کرنے کی ضرورت ہے کہ آپ متعدد نقطہ نظر سے واضح طور پر کیسے نظر آتے ہیں۔ سامنے والی تصویر، ہر طرف سے پروفائل شاٹ، اور درمیان کے زاویوں سے تصاویر شامل کریں۔ آپ کو چہرے کے مختلف تاثرات کے ساتھ تصاویر بھی شامل کرنی چاہئیں جیسے مسکراہٹ، جھنجھلاہٹ، اور غیر جانبدار اظہار۔ تاثرات کا مرکب ہونا ماڈل کو آپ کے چہرے کی منفرد خصوصیات کو بہتر طریقے سے دوبارہ پیش کرنے کی اجازت دے گا۔ ان پٹ امیجز اوتار کے معیار کا تعین کرتی ہیں جسے آپ تیار کر سکتے ہیں۔ اس بات کو یقینی بنانے کے لیے کہ یہ صحیح طریقے سے ہوا ہے، ہم تصویر کی گرفت اور اپ لوڈ کے عمل میں صارف کی رہنمائی کے لیے ایک بدیہی فرنٹ اینڈ UI تجربہ تجویز کرتے ہیں۔

چہرے کے مختلف تاثرات کے ساتھ مختلف زاویوں پر سیلفی کی تصاویر مندرجہ ذیل ہیں۔

![]()

ایک مستحکم ڈفیوژن ماڈل کو ٹھیک بنائیں

امیزون S3 پر امیجز اپ لوڈ ہونے کے بعد، ہم اس کو طلب کر سکتے ہیں۔ سیج میکر غیر مطابقت پذیر تخمینہ ہمارا تربیتی عمل شروع کرنے کے لیے اختتامی نقطہ۔ غیر مطابقت پذیر اختتامی نقطوں کا مقصد بڑے پے لوڈز (1 جی بی تک) اور طویل پروسیسنگ اوقات (1 گھنٹے تک) کے استعمال کے معاملات کے لیے ہے۔ یہ سیج میکر ہوسٹنگ کی دیگر مقامی خصوصیات جیسے آٹو اسکیلنگ کے علاوہ درخواستوں کو قطار میں کھڑا کرنے کے لیے ایک بلٹ ان قطار بنانے کا طریقہ کار، اور Amazon SNS کے ذریعے کام کی تکمیل کا نوٹیفکیشن میکانزم بھی فراہم کرتا ہے۔

اگرچہ فائن ٹیوننگ کوئی نتیجہ استعمال کرنے کا معاملہ نہیں ہے، لیکن ہم نے اسے یہاں سیج میکر کی تربیتی ملازمتوں کے بدلے استعمال کرنے کا انتخاب کیا ہے کیونکہ اس کے اندر موجود قطار اور نوٹیفکیشن میکانزم اور منظم آٹو اسکیلنگجس میں سروس کے استعمال میں نہ ہونے کی صورت میں 0 واقعات کو کم کرنے کی صلاحیت بھی شامل ہے۔ یہ ہمیں بڑی تعداد میں ہم وقت ساز صارفین تک آسانی سے فائن ٹیوننگ سروس کی پیمائش کرنے کی اجازت دیتا ہے اور اضافی اجزاء کو لاگو کرنے اور ان کا نظم کرنے کی ضرورت کو ختم کرتا ہے۔ تاہم، یہ 1 GB پے لوڈ اور 1 گھنٹہ زیادہ سے زیادہ پروسیسنگ وقت کی خرابی کے ساتھ آتا ہے۔ ہماری جانچ میں، ہم نے پایا کہ ml.g20x بڑی مثال پر تقریباً 10 ان پٹ تصاویر کے ساتھ معقول حد تک اچھے نتائج حاصل کرنے کے لیے 5.2 منٹ کافی وقت ہے۔ تاہم، سیج میکر کی تربیت بڑے پیمانے پر فائن ٹیوننگ ملازمتوں کے لیے تجویز کردہ طریقہ ہوگی۔

غیر مطابقت پذیر اختتامی نقطہ کی میزبانی کرنے کے لیے، ہمیں کئی مراحل کو مکمل کرنا ہوگا۔ سب سے پہلے ہمارے ماڈل سرور کی وضاحت کرنا ہے۔ اس پوسٹ کے لیے، ہم استعمال کرتے ہیں۔ بڑا ماڈل انفرنس کنٹینر (LMI)۔ LMI DJL سرونگ کے ذریعے تقویت یافتہ ہے، جو ایک اعلیٰ کارکردگی، پروگرامنگ لینگویج-ایگنوسٹک ماڈل سرونگ سلوشن ہے۔ ہم نے اس اختیار کا انتخاب کیا کیونکہ سیج میکر کے زیر انتظام انفرنس کنٹینر میں پہلے سے ہی بہت سی تربیتی لائبریریاں موجود ہیں جن کی ہمیں ضرورت ہے، جیسے ہیگنگ فیس ڈفیوزر۔ اور تیز. یہ ہمارے فائن ٹیوننگ کام کے لیے کنٹینر کو اپنی مرضی کے مطابق بنانے کے لیے درکار کام کی مقدار کو بہت کم کر دیتا ہے۔

درج ذیل کوڈ کا ٹکڑا LMI کنٹینر کا وہ ورژن دکھاتا ہے جسے ہم نے اپنی مثال میں استعمال کیا ہے۔

اس کے علاوہ، ہمیں ایک کی ضرورت ہے serving.properties فائل جو سرونگ پراپرٹیز کو ترتیب دیتی ہے، بشمول استعمال کرنے کے لیے انفرنس انجن، ماڈل آرٹفیکٹ کا مقام، اور ڈائنامک بیچنگ۔ آخر میں، ہمارے پاس ایک ہونا ضروری ہے model.py فائل جو ماڈل کو انفرنس انجن میں لوڈ کرتی ہے اور ماڈل سے ڈیٹا ان پٹ اور آؤٹ پٹ تیار کرتی ہے۔ ہماری مثال میں، ہم استعمال کرتے ہیں model.py فائن ٹیوننگ جاب کو اسپن کرنے کے لیے فائل، جس کی ہم بعد کے حصے میں مزید تفصیل سے وضاحت کرتے ہیں۔ دونوں serving.properties اور model.py میں فائلیں فراہم کی جاتی ہیں۔ training_service فولڈر.

ہمارے ماڈل سرور کی وضاحت کرنے کے بعد اگلا مرحلہ ایک اینڈ پوائنٹ کنفیگریشن بنانا ہے جو اس بات کی وضاحت کرتا ہے کہ ہمارا غیر مطابقت پذیر تخمینہ کیسے پیش کیا جائے گا۔ ہماری مثال کے طور پر، ہم صرف زیادہ سے زیادہ ہم آہنگی کی درخواست کی حد اور آؤٹ پٹ S3 مقام کی وضاحت کر رہے ہیں۔ کے ساتہ ml.g5.2xlarge مثال کے طور پر، ہم نے محسوس کیا ہے کہ ہم میموری سے باہر (OOM) استثناء کا سامنا کیے بغیر بیک وقت دو ماڈلز کو ٹھیک کرنے کے قابل ہیں، اور اس لیے ہم نے سیٹ max_concurrent_invocations_per_instance اس نمبر کو ایڈجسٹ کرنے کی ضرورت ہو سکتی ہے اگر ہم ٹیوننگ پیرامیٹرز کا ایک مختلف سیٹ یا چھوٹی مثال کی قسم استعمال کر رہے ہیں۔ ہم اسے ابتدائی طور پر 2 پر سیٹ کرنے اور GPU میموری کے استعمال کی نگرانی کرنے کی تجویز کرتے ہیں۔ ایمیزون کلاؤڈ واچ.

آخر میں، ہم ایک SageMaker ماڈل بناتے ہیں جو کنٹینر کی معلومات، ماڈل فائلز، اور پیکج کرتا ہے۔ AWS شناخت اور رسائی کا انتظام (IAM) ایک ہی شے میں کردار۔ ماڈل کو اینڈ پوائنٹ کنفیگریشن کا استعمال کرتے ہوئے تعینات کیا گیا ہے جس کی ہم نے پہلے وضاحت کی تھی۔

جب اختتامی نقطہ تیار ہو جاتا ہے، تو ہم ذیلی نمونہ کوڈ کا استعمال غیر مطابقت پذیر اختتامی نقطہ کو شروع کرنے اور فائن ٹیوننگ کا عمل شروع کرنے کے لیے کرتے ہیں:

SageMaker پر LMI کے بارے میں مزید تفصیلات کے لیے، رجوع کریں۔ DJLServing اور DeepSpeed ماڈل کے متوازی اندازہ کا استعمال کرتے ہوئے Amazon SageMaker پر بڑے ماڈلز تعینات کریں۔.

درخواست کے بعد، غیر مطابقت پذیر اختتامی نقطہ ہمارے فائن ٹیوننگ کام کو قطار میں کھڑا کرنا شروع کر دیتا ہے۔ ہر کام درج ذیل مراحل سے گزرتا ہے: تصاویر تیار کریں، ڈریم بوتھ اور LoRA فائن ٹیوننگ انجام دیں، اور نمونے کے نمونے تیار کریں۔ آئیے فائن ٹیوننگ کے عمل میں مزید گہرائی میں جائیں۔

تصاویر تیار کریں۔

جیسا کہ ہم نے پہلے ذکر کیا ہے، ان پٹ امیجز کا معیار براہ راست فائن ٹیونڈ ماڈل کے معیار کو متاثر کرتا ہے۔ اوتار کے استعمال کے کیس کے لیے، ہم چاہتے ہیں کہ ماڈل چہرے کی خصوصیات پر توجہ مرکوز کرے۔ صارفین سے درست سائز اور مواد کی احتیاط سے تیار کردہ تصاویر فراہم کرنے کی ضرورت کے بجائے، ہم اس بوجھ کو کم کرنے کے لیے کمپیوٹر ویژن تکنیک کا استعمال کرتے ہوئے ایک پری پروسیسنگ مرحلہ نافذ کرتے ہیں۔ پری پروسیسنگ مرحلے میں، ہم سب سے پہلے ہر تصویر میں سب سے بڑے چہرے کو الگ کرنے کے لیے چہرے کا پتہ لگانے والا ماڈل استعمال کرتے ہیں۔ پھر ہم اپنے ماڈل کے لیے تصویر کو 512 x 512 پکسلز کے مطلوبہ سائز میں کراپ اور پیڈ کرتے ہیں۔ آخر میں، ہم پس منظر سے چہرے کو الگ کرتے ہیں اور پس منظر کی بے ترتیب تغیرات شامل کرتے ہیں۔ اس سے چہرے کی خصوصیات کو نمایاں کرنے میں مدد ملتی ہے، جس سے ہمارے ماڈل کو پس منظر کے بجائے چہرے سے ہی سیکھنے کا موقع ملتا ہے۔ مندرجہ ذیل تصاویر اس عمل کے تین مراحل کو واضح کرتی ہیں۔

| 1 مرحلہ: کمپیوٹر وژن کا استعمال کرتے ہوئے چہرے کا پتہ لگانا | 2 مرحلہ: تصویر کو تراشیں اور 512 x 512 پکسلز پر پیڈ کریں۔ | مرحلہ 3 (اختیاری): سیگمنٹ کریں اور پس منظر کی تبدیلی شامل کریں۔ |

ڈریم بوتھ اور LoRA فائن ٹیوننگ

فائن ٹیوننگ کے لیے، ہم نے ڈریم بوتھ اور LoRA کی تکنیکوں کو ملایا۔ ڈریم بوتھ آپ کو اپنے اسٹیبل ڈفیوژن ماڈل کو ذاتی نوعیت کا بنانے کی اجازت دیتا ہے، ایک منفرد شناخت کنندہ کا استعمال کرتے ہوئے ماڈل کے آؤٹ پٹ ڈومین میں ایک موضوع کو سرایت کرتا ہے اور ماڈل کی لینگویج ویژن ڈکشنری کو بڑھاتا ہے۔ یہ ایک طریقہ استعمال کرتا ہے جسے کہا جاتا ہے۔ پیشگی تحفظ مضمون کی کلاس کے ماڈل کے معنوی علم کو محفوظ رکھنے کے لیے، اس صورت میں ایک شخص، اور کلاس میں موجود دیگر اشیاء کو حتمی امیج آؤٹ پٹ کو بہتر بنانے کے لیے استعمال کریں۔ اس طرح ڈریم بوتھ موضوع کی صرف چند ان پٹ تصاویر کے ساتھ اعلیٰ معیار کے نتائج حاصل کر سکتا ہے۔

درج ذیل کوڈ کا ٹکڑا ہمارے ان پٹ کو دکھاتا ہے۔ trainer.py ہمارے اوتار حل کے لیے کلاس۔ غور کریں کہ ہم نے انتخاب کیا۔ <<TOK>> منفرد شناخت کنندہ کے طور پر۔ یہ جان بوجھ کر کسی ایسے نام کو منتخب کرنے سے بچنے کے لیے کیا گیا ہے جو ماڈل کی لغت میں پہلے سے موجود ہو۔ اگر نام پہلے سے موجود ہے تو، ماڈل کو اس موضوع کو سیکھنا اور پھر دوبارہ سیکھنا پڑتا ہے، جس سے فائن ٹیوننگ کے خراب نتائج برآمد ہو سکتے ہیں۔ مضمون کی کلاس مقرر ہے۔ “a photo of person”جو کہ پہلے لوگوں کی تصاویر بنا کر پہلے سے محفوظ کرنے کے قابل بناتا ہے تاکہ فائن ٹیوننگ کے عمل کے دوران اضافی ان پٹ کے طور پر فیڈ کیا جا سکے۔ اس سے اوور فٹنگ کو کم کرنے میں مدد ملے گی کیونکہ ماڈل پہلے سے محفوظ کرنے کا طریقہ استعمال کرتے ہوئے کسی شخص کے سابقہ علم کو محفوظ رکھنے کی کوشش کرتا ہے۔

کنفیگریشن میں میموری بچانے کے متعدد آپشنز کو فعال کیا گیا ہے، بشمول fp16, use_8bit_adam، اور تدریجی جمع۔ یہ میموری فوٹ پرنٹ کو 12 جی بی سے کم کر دیتا ہے، جو ایک ساتھ دو ماڈلز تک کو ٹھیک کرنے کی اجازت دیتا ہے۔ ml.g5.2xlarge مثال.

LoRA LLMs کے لیے ایک موثر فائن ٹیوننگ تکنیک ہے جو زیادہ تر وزن کو منجمد کر دیتی ہے اور پہلے سے تربیت یافتہ LLM کی مخصوص تہوں کے ساتھ ایک چھوٹے اڈاپٹر نیٹ ورک کو جوڑ دیتی ہے، جس سے تیز تر تربیت اور بہتر اسٹوریج کی سہولت ملتی ہے۔ اسٹیبل ڈفیوژن کے لیے، اڈاپٹر ٹیکسٹ انکوڈر اور انفرنس پائپ لائن کے U-Net اجزاء سے منسلک ہوتا ہے۔ ٹیکسٹ انکوڈر ان پٹ پرامپٹ کو ایک اویکت جگہ میں تبدیل کرتا ہے جسے U-Net ماڈل کے ذریعے سمجھا جاتا ہے، اور U-Net ماڈل بعد کے پھیلاؤ کے عمل میں تصویر بنانے کے لیے اویکت معنی کا استعمال کرتا ہے۔ ٹھیک ٹیوننگ کی پیداوار صرف ہے text_encoder اور U-Net اڈاپٹر کا وزن۔ تخمینہ کے وقت، ان وزنوں کو بیس اسٹیبل ڈفیوژن ماڈل سے دوبارہ جوڑا جا سکتا ہے تاکہ فائن ٹیوننگ کے نتائج کو دوبارہ پیش کیا جا سکے۔

ذیل کے اعداد و شمار اصل مصنف کے ذریعہ فراہم کردہ LoRA فائن ٹیوننگ کا تفصیلی خاکہ ہیں: چینگ-ہان چیانگ، یونگ-سنگ چوانگ، ہنگ-ی لی، "AACL_2022_tutorial_PLMs،" 2022

دونوں طریقوں کو یکجا کر کے، ہم کم پیرامیٹرز کو ترتیب دیتے ہوئے ذاتی نوعیت کا ماڈل بنانے میں کامیاب ہو گئے۔ اس کے نتیجے میں تربیت کا وقت بہت تیز ہوا اور GPU کا استعمال کم ہوا۔ مزید برآں، اڈاپٹر کا وزن صرف 70 MB ہونے کے ساتھ اسٹوریج کو بہتر بنایا گیا، ایک مکمل اسٹیبل ڈفیوژن ماڈل کے لیے 6 GB کے مقابلے، جو کہ 99% سائز میں کمی کی نمائندگی کرتا ہے۔

نمونے کے نمونے تیار کریں۔

فائن ٹیوننگ مکمل ہونے کے بعد، پوسٹ پروسیسنگ مرحلہ LoRA کے وزن کو NVIDIA Triton کے لیے پیش کرنے والی باقی فائلوں کے ساتھ TAR کرے گا۔ ہم ایک Python بیک اینڈ استعمال کرتے ہیں، جس کا مطلب ہے کہ Triton config فائل اور Python اسکرپٹ کی ضرورت ہے جو اندازہ لگانے کے لیے استعمال کی جاتی ہے۔ نوٹ کریں کہ Python اسکرپٹ کا نام ہونا ضروری ہے۔ model.py. فائنل ماڈل TAR فائل میں درج ذیل فائل کا ڈھانچہ ہونا چاہئے:

GPU کے ساتھ SageMaker MMEs کا استعمال کرتے ہوئے ٹھیک ٹیونڈ ماڈلز کی میزبانی کریں۔

ماڈلز کو ٹھیک کرنے کے بعد، ہم SageMaker MME کا استعمال کرتے ہوئے ذاتی نوعیت کے اسٹیبل ڈفیوژن ماڈلز کی میزبانی کرتے ہیں۔ A SageMaker MME ایک طاقتور تعیناتی خصوصیت ہے جو ایک کنٹینر میں ایک ہی اختتامی نقطہ کے پیچھے متعدد ماڈلز کی میزبانی کی اجازت دیتی ہے۔ یہ وسائل کے استعمال کو بہتر بنانے، اخراجات بچانے اور ہزاروں اختتامی پوائنٹس کے انتظام کے آپریشنل بوجھ کو کم کرنے کے لیے خود بخود ٹریفک اور آپ کے ماڈلز کی روٹنگ کا انتظام کرتا ہے۔ ہماری مثال میں، ہم GPU مثالوں پر چلتے ہیں، اور SageMaker MMEs Triton Server کا استعمال کرتے ہوئے GPU کو سپورٹ کرتے ہیں۔ یہ آپ کو ایک ہی GPU ڈیوائس پر متعدد ماڈل چلانے اور تیز رفتار کمپیوٹ کا فائدہ اٹھانے کی اجازت دیتا ہے۔ SageMaker MMEs پر Stable Diffusion کی میزبانی کرنے کے طریقے کے بارے میں مزید تفصیل کے لیے، ملاحظہ کریں۔ مستحکم ڈفیوژن ماڈلز کے ساتھ اعلیٰ معیار کی تصاویر بنائیں اور انہیں Amazon SageMaker کے ساتھ لاگت کے ساتھ تعینات کریں۔.

ہماری مثال کے طور پر، ہم نے ٹھنڈے آغاز کے حالات کے دوران فائن ٹیونڈ ماڈلز کو تیزی سے لوڈ کرنے کے لیے اضافی اصلاح کی۔ یہ LoRA کے اڈاپٹر ڈیزائن کی وجہ سے ممکن ہے۔ چونکہ بیس ماڈل وزن اور کونڈا ماحول تمام عمدہ ماڈلز کے لیے یکساں ہیں، اس لیے ہم ان مشترکہ وسائل کو ہوسٹنگ کنٹینر پر پہلے سے لوڈ کر کے شیئر کر سکتے ہیں۔ اس سے صرف ٹرائٹن کنفگ فائل رہ جاتی ہے، ازگر پسدید (model.py)، اور LoRA اڈاپٹر وزن پہلی درخواست کے بعد Amazon S3 سے متحرک طور پر لوڈ کیے جائیں گے۔ درج ذیل خاکہ ایک ساتھ بہ پہلو موازنہ فراہم کرتا ہے۔

![]()

یہ ماڈل TAR فائل کو تقریباً 6 GB سے 70 MB تک کم کر دیتا ہے، اور اس وجہ سے لوڈ اور پیک کھولنا بہت تیز ہے۔ ہماری مثال میں پری لوڈنگ کرنے کے لیے، ہم نے ایک یوٹیلیٹی Python بیک اینڈ ماڈل بنایا ہے۔ models/model_setup. اسکرپٹ میں ایمیزون S3 سے بیس اسٹیبل ڈفیوژن ماڈل اور کونڈا ماحول کو ایک مشترکہ جگہ پر نقل کیا گیا ہے تاکہ تمام عمدہ ماڈلز میں اشتراک کیا جا سکے۔ مندرجہ ذیل کوڈ کا ٹکڑا ہے جو کام انجام دیتا ہے:

پھر ہر عمدہ ماڈل کنٹینر پر مشترکہ مقام کی طرف اشارہ کرے گا۔ کونڈا ماحول کا حوالہ دیا گیا ہے۔ config.pbtxt.

اسٹیبل ڈفیوژن بیس ماڈل سے بھری ہوئی ہے۔ initialize() ہر ایک کی تقریب model.py فائل اس کے بعد ہم ذاتی نوعیت کے LoRA وزن کو unet اور پر لاگو کرتے ہیں۔ text_encoder ہر عمدہ ماڈل کو دوبارہ پیش کرنے کے لیے ماڈل:

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ آٹوموٹو / ای وی، کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- بلاک آفسیٹس۔ ماحولیاتی آفسیٹ ملکیت کو جدید بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/build-a-personalized-avatar-with-generative-ai-using-amazon-sagemaker/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 1

- 10

- 100

- 12

- 13

- 15٪

- 17

- 20

- 32

- 7

- 70

- 700

- 8

- 9

- a

- کی صلاحیت

- قابلیت

- ہمارے بارے میں

- تیز

- تیز

- تک رسائی حاصل

- قابل رسائی

- جمع کو

- حاصل

- کے پار

- موافقت

- شامل کریں

- شامل کیا

- اس کے علاوہ

- ایڈیشنل

- اس کے علاوہ

- ایڈجسٹ

- فائدہ

- اشتہار.

- کے بعد

- AI

- اے آئی ماڈلز

- AI خدمات

- AI / ML

- تمام

- کم

- کی اجازت

- اجازت دے رہا ہے

- کی اجازت دیتا ہے

- پہلے ہی

- بھی

- اگرچہ

- شوکیا

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون ویب سروسز

- محیطی

- رقم

- an

- اناٹومی

- اور

- کوئی بھی

- ایپلی کیشنز

- کا اطلاق کریں

- نقطہ نظر

- تقریبا

- فن تعمیر

- کیا

- فن

- آرٹ ورک

- AS

- اثاثے

- مدد

- At

- توجہ

- متوجہ

- سماعتوں

- مصنف

- آٹو

- آٹومیٹڈ

- خود کار طریقے سے

- دستیاب

- اوتار

- اوتار

- سے اجتناب

- AWS

- پسدید

- پس منظر

- پس منظر

- برا

- بیس

- کی بنیاد پر

- بنیادی

- BE

- کیونکہ

- بن

- رہا

- پیچھے

- کیا جا رہا ہے

- نیچے

- فائدہ

- BEST

- بہتر

- کے درمیان

- جسم

- دونوں

- ٹوٹ

- تعمیر

- تعمیر میں

- بوجھ

- کاروبار

- لیکن

- by

- کیشے

- کہا جاتا ہے

- کر سکتے ہیں

- صلاحیتوں

- قبضہ

- احتیاط سے

- کیس

- مقدمات

- پکڑے

- چیلنجوں

- بوجھ

- کا انتخاب کیا

- سنیما

- شہر کی تزئین

- طبقے

- واضح طور پر

- کوڈ

- سردی

- مل کر

- امتزاج

- کس طرح

- کامن

- مقابلے میں

- موازنہ

- مکمل

- تکمیل

- پیچیدہ

- اجزاء

- ساخت

- کمپیوٹنگ

- کمپیوٹر

- کمپیوٹر ویژن

- تصور

- سمورتی

- ترتیب

- کنٹینر

- مواد

- تبدیل

- کور

- قیمت

- اخراجات

- کا احاطہ کرتا ہے

- تخلیق

- بنائی

- تخلیق

- تخلیقات

- تخلیقی

- فصل

- cured

- اس وقت

- گاہکوں

- اپنی مرضی کے مطابق

- اپنی مرضی کے مطابق

- کٹ

- اعداد و شمار

- دن

- وقف

- گہری

- گہری سیکھنے

- گہرے

- وضاحت

- کی وضاحت

- وضاحت کرتا ہے

- وضاحت

- جمہوری بنانا

- مظاہرہ

- demonstrated,en

- ثبوت

- تعیناتی

- تعینات

- تعینات

- تعیناتی

- ڈیزائن

- تفصیل

- تفصیلی

- تفصیلات

- کھوج

- اس بات کا تعین

- ڈیولپر

- آلہ

- مختلف

- براڈ کاسٹننگ

- براہ راست

- متنوع

- ڈی آئی

- do

- کرتا

- ڈومین

- کیا

- نیچے

- ڈرافٹ

- مواقع

- دو

- کے دوران

- متحرک

- متحرک طور پر

- e

- ای کامرس

- ہر ایک

- اس سے قبل

- آسانی سے

- ہنر

- ختم

- سرایت کرنا

- چالو حالت میں

- کے قابل بناتا ہے

- مقابلہ کرنا

- کی حوصلہ افزائی

- آخر سے آخر تک

- لامتناہی

- اختتام پوائنٹ

- مصروفیت

- انجن

- انجنیئرنگ

- بڑھانے کے

- بڑھانے

- انٹرپرائز

- تفریح

- ماحولیات

- ماحول

- EPIC

- جوہر

- مثال کے طور پر

- مثال کے طور پر

- اس کے علاوہ

- رعایت

- موجود ہے

- توسیع

- تجربہ

- تجربات

- تجربہ

- مہارت

- وضاحت

- تلاش

- ظاہر

- اظہار

- اظہار

- اضافی

- نکالنے

- چہرہ

- چہرے

- ناکامی

- خاندان

- تیز تر

- نمایاں کریں

- خصوصیات

- فٹ

- چند

- کم

- اعداد و شمار

- فائل

- فائلوں

- فائنل

- آخر

- مالی

- پہلا

- توجہ مرکوز

- توجہ مرکوز

- توجہ مرکوز

- کے بعد

- فوٹ پرنٹ

- کے لئے

- ملا

- چار

- فریم

- سے

- مکمل

- تقریب

- کھیل

- گیمنگ

- پیدا

- پیدا ہوتا ہے

- پیدا کرنے والے

- نسل

- پیداواری

- پیداواری AI۔

- جنریٹر

- حاصل

- GIF

- GitHub کے

- مقصد

- جا

- اچھا

- GPU

- گرافک

- زیادہ سے زیادہ

- بہت

- سبز

- مجموعی

- رہنمائی

- ہاتھوں

- ہے

- ہونے

- he

- مدد

- مدد

- مدد کرتا ہے

- اس کی

- یہاں

- اعلی کارکردگی

- اعلی معیار کی

- بهترین ریزولوشن

- نمایاں کریں

- انتہائی

- ان

- تاریخ

- امید ہے کہ

- میزبان

- ہوسٹنگ

- گھنٹہ

- ہاؤس

- کس طرح

- کیسے

- تاہم

- HTML

- HTTP

- HTTPS

- شناخت

- شناختی

- if

- تصویر

- تصاویر

- فوری طور پر

- اثرات

- پر عملدرآمد

- نفاذ

- کو بہتر بنانے کے

- in

- شامل

- سمیت

- اضافہ

- اضافہ

- انفرادیت

- صنعتوں

- صنعت

- معلومات

- معلوماتی

- ابتدائی طور پر

- جدید

- جدید ٹیکنالوجیز

- ان پٹ

- آدانوں

- متاثر کن

- مثال کے طور پر

- کے بجائے

- ہدایات

- انشورنس

- ارادہ

- دلچسپی

- میں

- بدیہی

- IT

- میں

- خود

- جیمز

- ایوب

- نوکریاں

- شمولیت

- فوٹو

- JSON

- صرف

- صرف ایک

- کلیدی

- علم

- لیبل

- زبان

- بڑے

- سب سے بڑا

- بعد

- تہوں

- قیادت

- رہنما

- قیادت

- جانیں

- سیکھنے

- لی

- لائبریریوں

- لائٹنینگ کا

- کی طرح

- LIMIT

- ایل ایل ایم

- لوڈ

- بوجھ

- محل وقوع

- لانگ

- اب

- دیکھو

- محبت

- لو

- مشین

- مشین لرننگ

- بنا

- مین

- بنا

- بنانا

- انتظام

- میں کامیاب

- مینیجر

- انتظام کرتا ہے

- مینیجنگ

- بہت سے

- مارکیٹنگ

- مارکیٹنگ اور اشتہار بازی

- زیادہ سے زیادہ

- مئی..

- مطلب

- کا مطلب ہے کہ

- میکانزم

- نظام

- میڈیا

- یاد داشت

- ذکر کیا

- پیغام

- طریقہ

- طریقوں

- کم سے کم

- منٹ

- اختلاط

- ML

- ماڈل

- ماڈل

- اعتدال پسند

- نگرانی

- زیادہ

- سب سے زیادہ

- حوصلہ افزائی

- فلم

- بہت

- ایک سے زیادہ

- ضروری

- نام

- نامزد

- مقامی

- قدرتی

- قدرتی زبان عملیات

- ضرورت ہے

- نیٹ ورک

- غیر جانبدار

- اگلے

- کوئی بھی نہیں

- نوٹ بک

- نوٹس..

- نوٹیفیکیشن

- اب

- تعداد

- NVIDIA

- اعتراض

- اشیاء

- of

- بند

- تیل

- on

- ایک

- صرف

- پر

- آپریشنل

- اصلاح کے

- کی اصلاح کریں

- اصلاح

- اختیار

- آپشنز کے بھی

- or

- آرکیسٹرا

- اصل

- OS

- دیگر

- ہمارے

- باہر

- خطوط

- پیداوار

- پر

- مجموعی طور پر

- پیکج

- پیکجوں کے

- پیڈ

- متوازی

- پیرامیٹر

- پیرامیٹرز

- حصہ

- منظور

- جذباتی

- راستہ

- لوگ

- کامل

- انجام دیں

- کارکردگی کا مظاہرہ

- انسان

- شخصیت

- ذاتی بنانا

- نجیکرت

- نقطہ نظر

- تصویر

- تصویر

- تصویر

- پائپ

- پائپ لائن

- پلیٹ فارم

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوائنٹ

- غریب

- تصویر

- امکانات

- ممکن

- پوسٹ

- ممکنہ

- طاقت

- طاقتور

- پیش گو

- ترجیحات

- تیار

- تیار کرتا ہے

- کی تیاری

- تحفظ

- پچھلا

- پرائمری

- پرنٹ

- پہلے

- عمل

- پروسیسنگ

- مصنوعات

- پروڈکٹ مینیجر

- حاصل

- پروفائل

- پروگرامنگ

- منصوبوں

- کو فروغ دینے

- مناسب طریقے سے

- خصوصیات

- فراہم

- فراہم

- فراہم کرتا ہے

- ازگر

- معیار

- مقدار

- بے ترتیب

- رینج

- قیمتیں

- بلکہ

- ترک

- پڑھنا

- تیار

- سفارش

- سفارش کی

- کو کم

- کم

- کم

- کمی

- کی عکاسی

- کے بارے میں

- متعلقہ

- نمائندگی

- درخواست

- درخواستوں

- ضرورت

- وسائل

- وسائل

- جواب

- ذمہ دار

- باقی

- نتیجہ

- نتائج کی نمائش

- Rockstar

- کردار

- تقریبا

- روٹنگ

- رن

- چلتا ہے

- sagemaker

- سیج میکر کا اندازہ

- اسی

- محفوظ کریں

- پیمانے

- سکیلنگ

- سائنس FI

- گنجائش

- اسکرین شاٹس

- سیکشن

- سیکشنز

- دیکھنا

- بیج

- حصے

- SELF

- selfie

- سینئر

- بھیجا

- سیریز

- سروس

- سروسز

- خدمت

- مقرر

- قائم کرنے

- سیٹ اپ

- کئی

- شکل

- سیکنڈ اور

- مشترکہ

- تیز

- وہ

- شاٹ

- ہونا چاہئے

- دکھایا گیا

- شوز

- کی طرف

- اہم

- نمایاں طور پر

- سائمن

- سادہ

- صرف

- ایک

- حالات

- سائز

- چھوٹے

- چھوٹے

- ٹکڑا

- سماجی

- سوشل میڈیا

- سماجی پلیٹ فارم

- حل

- حل

- کچھ

- خلا

- ماہر

- مہارت

- مخصوص

- خرچ کرنا۔

- سپن

- مستحکم

- شروع کریں

- شروع

- شروع ہوتا ہے

- مرحلہ

- مراحل

- ذخیرہ

- ذخیرہ

- محرومی

- سٹریمنگ خدمات

- سلک

- ساخت

- موضوع

- بعد میں

- کامیاب

- اس طرح

- کافی

- فراہمی

- حمایت

- اس بات کا یقین

- کے نظام

- لے لو

- ٹاسک

- ٹیم

- TechCrunch

- تکنیک

- ٹیکنالوجی

- ٹیکنالوجی

- ٹیسٹنگ

- ٹیسٹ

- سے

- کہ

- ۔

- ان

- ان

- تو

- لہذا

- یہ

- اس

- اگرچہ؟

- سوچا

- سوچا قیادت۔

- ہزاروں

- تین

- کے ذریعے

- وقت

- اوقات

- عنوانات

- کرنے کے لئے

- کے آلے

- سب سے اوپر

- ٹریفک

- ٹرین

- ٹریننگ

- تبدیل

- سفر

- رخ

- کوشش

- tv

- دو

- قسم

- عام طور پر

- ui

- کے تحت

- سمجھا

- منفرد

- غیر ضروری

- اپ لوڈ کردہ

- اپ لوڈ کرنا

- us

- امریکا

- استعمال کی شرائط

- استعمال کیس

- استعمال کیا جاتا ہے

- رکن کا

- صارفین

- استعمال

- کا استعمال کرتے ہوئے

- کی افادیت

- استعمال

- قیمت

- مختلف اقسام کے

- مختلف

- ورژن

- کی طرف سے

- لنک

- دیکھنے

- ورجینیا

- نقطہ نظر

- بصری

- چاہتے ہیں

- تھا

- آبی نشان

- we

- ویب

- ویب خدمات

- وزن

- تھے

- کیا

- جب

- جس

- جبکہ

- کس کی

- وسیع

- وسیع رینج

- گے

- ساتھ

- بغیر

- کام

- کام کر

- بدترین

- گا

- X

- سال

- تم

- اور

- اپنے آپ کو

- زیفیرنیٹ