یہ ایک مہمان بلاگ پوسٹ ہے جو athenahealth کے ساتھ لکھی گئی ہے۔

athenahealth ملک بھر میں میڈیکل گروپس اور ہیلتھ سسٹمز کے لیے نیٹ ورک سے چلنے والے سافٹ ویئر اور خدمات کا ایک سرکردہ فراہم کنندہ۔ اس کے الیکٹرانک ہیلتھ ریکارڈز، ریونیو سائیکل مینجمنٹ، اور مریض کی مصروفیت کے ٹولز کسی بھی وقت، کہیں بھی رسائی کی اجازت دیتے ہیں، اپنے صارفین کے لیے بہتر مالیاتی نتائج فراہم کرتے ہیں اور اپنے فراہم کنندہ کے صارفین کو بہتر معیار کی دیکھ بھال فراہم کرنے کے قابل بناتے ہیں۔

مصنوعی ذہانت (AI) کی جگہ میں، athenahealth کاروباری عمل کو تیز کرنے اور متعدد خدمات میں سفارشات، پیشین گوئیاں اور بصیرت فراہم کرنے کے لیے ڈیٹا سائنس اور مشین لرننگ (ML) کا استعمال کرتی ہے۔ خودکار دستاویزی خدمات میں اپنے پہلے نفاذ سے لے کر، فراہم کنندہ مریضوں کے لاکھوں دستاویزات کو چھوئے بغیر پروسیسنگ، ورچوئل اسسٹنٹس میں اس کے حالیہ کام اور ریونیو سائیکل کی کارکردگی کو بہتر بنانے تک، athenahealth نے کارکردگی، سروس کی صلاحیتوں اور فراہم کنندگان کے لیے بہتر نتائج میں مدد کے لیے AI کا اطلاق جاری رکھا ہوا ہے۔ اور ان کے مریض۔

یہ بلاگ پوسٹ ظاہر کرتی ہے کہ athenahealth کس طرح استعمال کرتی ہے۔ AWS پر Kubeflow (Kubeflow کی AWS مخصوص تقسیم) ایک اینڈ ٹو اینڈ ڈیٹا سائنس ورک فلو کی تعمیر اور ہموار کرنے کے لیے جو ضروری ٹولنگ کو محفوظ رکھتا ہے، آپریشنل کارکردگی کو بہتر بناتا ہے، ڈیٹا سائنسدان کی پیداواری صلاحیت کو بڑھاتا ہے، اور اپنی ML صلاحیتوں کو مزید آسانی سے بڑھانے کے لیے مرحلہ طے کرتا ہے۔

Kubeflow ایک اوپن سورس ML پلیٹ فارم ہے جو Kubernetes پر ML ورک فلو کو آسان، پورٹیبل، اور توسیع پذیر بنانے کے لیے وقف ہے۔ Kubeflow متعلقہ اوپن سورس ٹولز کو شامل کرکے یہ حاصل کرتا ہے جو Kubernetes کے ساتھ اچھی طرح سے مربوط ہوتے ہیں۔ ان منصوبوں میں سے کچھ میں پائپ لائن آرکیسٹریشن کے لیے آرگو، سروس میش کے لیے اسٹیو، نوٹ بک کے لیے جوپیٹر، اسپارک، ٹینسر بورڈ، اور کاتب شامل ہیں۔ کیوب فلو پائپ لائنز پورٹیبل، قابل توسیع ML ورک فلو کی تعمیر اور تعیناتی میں مدد کرتی ہے جس میں ڈیٹا نکالنے، پری پروسیسنگ، ماڈل ٹریننگ، اور ماڈل کی تشخیص جیسے اقدامات کو دوبارہ قابل دہرائی جانے والی پائپ لائنوں کی شکل میں شامل کیا جا سکتا ہے۔

AWS اپنی Kubeflow ڈسٹری بیوشن (جسے AWS پر Kubeflow کہا جاتا ہے) فراہم کر کے اوپن سورس Kubeflow کمیونٹی میں حصہ ڈال رہا ہے جو AWS کے زیر انتظام خدمات کے ساتھ انضمام کے ذریعے کم آپریشنل اوور ہیڈ کے ساتھ athenahealth جیسی تنظیموں کو انتہائی قابل اعتماد، محفوظ، پورٹیبل، اور توسیع پذیر ML ورک فلو بنانے میں مدد کرتا ہے۔ AWS مختلف کیوب فلو تعیناتی کے اختیارات فراہم کرتا ہے جیسے تعیناتی کے ساتھ ایمیزون کاگنیٹوکے ساتھ تعیناتی ایمیزون متعلقہ ڈیٹا بیس سروس (ایمیزون آر ڈی ایس) اور ایمیزون سادہ اسٹوریج سروس (ایمیزون S3)، اور ونیلا کی تعیناتی۔ ان اختیارات میں سے ہر ایک کے لیے سروس انٹیگریشن اور دستیاب ایڈ آنز کی تفصیلات کے لیے، ملاحظہ کریں۔ تعیناتی.

آج، AWS پر Kubeflow، درج ذیل AWS سروسز کے ساتھ بڑھا ہوا، Kubeflow کو استعمال کرنے کے لیے ایک واضح راستہ فراہم کرتا ہے:

AWS کے بہت سے صارفین AWS کی تقسیم پر Kubeflow کا فائدہ اٹھا رہے ہیں، بشمول athenahealth۔

یہاں، athenahealth MLOps ٹیم ان چیلنجوں پر تبادلہ خیال کرتی ہے جن کا انہیں سامنا ہوا اور وہ حل جو انہوں نے اپنے Kubeflow کے سفر میں پیدا کیے تھے۔

پچھلے ML ماحول کے ساتھ چیلنجز

AWS پر Kubeflow کو اپنانے سے پہلے، ہمارے ڈیٹا سائنسدانوں نے ٹولز کا ایک معیاری سیٹ اور ایک ایسا عمل استعمال کیا جس سے کسی مخصوص ماڈل کو تربیت دینے کے لیے استعمال ہونے والی ٹیکنالوجی اور ورک فلو میں لچک پیدا ہوتی تھی۔ معیاری ٹولنگ کی مثال کے اجزاء میں ڈیٹا انجیشن API، سیکورٹی سکیننگ ٹولز، CI/CD پائپ لائن جو athenahealth کے اندر کسی اور ٹیم کے ذریعے بنائی اور دیکھ بھال کی جاتی ہے، اور MLOps ٹیم کے ذریعے بنایا اور برقرار رکھنے والا ایک مشترکہ پلیٹ فارم شامل ہے۔ تاہم، جیسا کہ ہمارا AI اور ML کا استعمال پختہ ہوا، ہر ماڈل کے لیے بنائے گئے مختلف ٹولز اور انفراسٹرکچر میں اضافہ ہوا۔ اگرچہ ہم اب بھی موجودہ عمل کی حمایت کرنے کے قابل تھے، ہم نے افق پر درج ذیل چیلنجز دیکھے:

- دیکھ بھال اور ترقی - ماڈل ٹریننگ کے ماحول کو دوبارہ تیار کرنے اور برقرار رکھنے میں زیادہ محنت کی گئی کیونکہ تعینات کردہ ماڈلز کی تعداد میں اضافہ ہوا۔ ہر پروجیکٹ نے تفصیلی دستاویزات کو برقرار رکھا جس میں بتایا گیا کہ حتمی ماڈل بنانے کے لیے ہر اسکرپٹ کو کس طرح استعمال کیا گیا۔ بہت سے معاملات میں، یہ ایک وسیع عمل تھا جس میں 5 سے 10 اسکرپٹ شامل تھے جن میں سے ہر ایک میں کئی آؤٹ پٹ ہوتے تھے۔ ان کو دستی طور پر تفصیلی ہدایات کے ساتھ ٹریک کرنا تھا کہ کس طرح ہر آؤٹ پٹ کو بعد کے عمل میں استعمال کیا جائے گا۔ وقت گزرنے کے ساتھ اس کو برقرار رکھنا مشکل ہو گیا۔ مزید یہ کہ جیسے جیسے منصوبے پیچیدہ ہوتے گئے، ٹولز کی تعداد میں بھی اضافہ ہوتا گیا۔ مثال کے طور پر، زیادہ تر ماڈلز نے GPUs کے ساتھ Spark اور TensorFlow کا استعمال کیا، جس کے لیے ماحولیات کی ایک بڑی قسم کی ضرورت تھی۔ وقت گزرنے کے ساتھ، صارفین اپنے ترقیاتی ماحول میں ٹولز کے نئے ورژنز پر جائیں گے لیکن پھر پرانے اسکرپٹ کو نہیں چلا سکتے جب وہ ورژن غیر موافق ہو گئے۔ نتیجتاً، پرانے منصوبوں کو برقرار رکھنے اور بڑھانے کے لیے انجینئرنگ کے لیے زیادہ وقت اور محنت درکار تھی۔ اس کے علاوہ، جیسے ہی ڈیٹا کے نئے سائنسدان ٹیم میں شامل ہوئے، علم کی منتقلی اور آن بورڈنگ میں زیادہ وقت لگا، کیونکہ مقامی ماحول کو ہم آہنگ کرنے میں بہت سے غیر دستاویزی انحصار شامل تھے۔ پراجیکٹس کے درمیان سوئچنگ میں ایک جیسے مسائل کا سامنا کرنا پڑا کیونکہ ہر ماڈل کا اپنا ورک فلو تھا۔

- سلامتی - ہم سیکیورٹی کو سنجیدگی سے لیتے ہیں، اور اس لیے ML اور ڈیٹا سائنس سے وابستہ تمام معاہدے، قانونی، اور ریگولیٹری ذمہ داریوں کی تعمیل کو ترجیح دیتے ہیں۔ ڈیٹا کو مخصوص طریقوں سے استعمال، ذخیرہ، اور اس تک رسائی حاصل کی جانی چاہیے، اور ہم نے مضبوط عمل کو سرایت کر رکھا ہے تاکہ یہ یقینی بنایا جا سکے کہ ہمارے طرز عمل ہماری قانونی ذمہ داریوں کی تعمیل کے ساتھ ساتھ صنعت کے بہترین طریقوں کے ساتھ ہم آہنگ ہوں۔ کوبی فلو کو اپنانے سے پہلے، اس بات کو یقینی بنانا کہ ڈیٹا کو ایک مخصوص طریقے سے ذخیرہ کیا گیا اور اس تک رسائی حاصل کی گئی جس میں متعدد، متنوع ورک فلوز میں باقاعدہ تصدیق شامل تھی۔ ہم جانتے تھے کہ ہم ان متنوع ورک فلوز کو ایک پلیٹ فارم پر اکٹھا کر کے افادیت کو بہتر بنا سکتے ہیں۔ تاہم، اس پلیٹ فارم کو ہماری معیاری ٹولنگ کے ساتھ اچھی طرح سے ضم کرنے کے لیے کافی لچکدار ہونے کی ضرورت ہوگی۔

- آپریشنز - ہم نے لاگنگ کو مرکزی بنانے اور ورک فلو کی نگرانی کے ذریعے آپریشنل کارکردگی اور انتظام کو بڑھانے کا موقع بھی دیکھا۔ چونکہ ہر ٹیم نے اپنے ٹولز تیار کیے تھے، اس لیے ہم نے یہ معلومات ہر ورک فلو سے انفرادی طور پر اکٹھی کیں اور ان کو اکٹھا کیا۔

ڈیٹا سائنس ٹیم نے ورک فلو کو مستحکم کرنے کے لیے مختلف حلوں کا جائزہ لیا۔ ان ضروریات کو پورا کرنے کے علاوہ، ہم نے ایک ایسا حل تلاش کیا جو موجودہ معیاری انفراسٹرکچر اور ٹولز کے ساتھ بغیر کسی رکاوٹ کے مربوط ہو۔ ہم نے اپنے ورک فلو حل کے طور پر AWS پر Amazon EKS اور Kubeflow کو منتخب کیا۔

ڈیٹا سائنٹسٹ ڈیولپمنٹ سائیکل جس میں Kubeflow شامل ہے۔

ڈیٹا سائنس پروجیکٹ کلین سلیٹ کے ساتھ شروع ہوتا ہے: کوئی ڈیٹا، کوئی کوڈ، صرف کاروباری مسئلہ جو ML سے حل کیا جا سکتا ہے۔ پہلا کام تصور کا ثبوت (POC) ہے اس بات کا پتہ لگانا کہ آیا ڈیٹا میں ML ماڈل کو کاروباری مسئلہ کو حل کرنے کے لیے موثر بنانے کے لیے کافی سگنل موجود ہیں، جس کا آغاز ہمارے Snowflake ڈیٹا گودام سے خام ڈیٹا سیٹ کے لیے استفسار سے ہوتا ہے۔ یہ مرحلہ تکراری ہے، اور ڈیٹا سائنسدان اس عمل کے دوران Kubernetes pods یا Kubeflow Jupyter نوٹ بک استعمال کرتے ہیں۔

ہمارا کیوب فلو کلسٹر کارپینٹر کلسٹر آٹو اسکیلر کا استعمال کرتا ہے، جو ڈیٹا سائنسدانوں کے لیے وسائل کو گھماؤ آسان بناتا ہے کیونکہ انہیں صرف مطلوبہ مثال کی اقسام کی وضاحت پر توجہ مرکوز کرنے کی ضرورت ہوتی ہے، جبکہ پروویژننگ کا کام پہلے سے طے شدہ کارپینٹر پروویژنرز کے ایک سیٹ کے ذریعے کیا جاتا ہے۔ ہمارے پاس CPU اور GPU مثال کی اقسام کے لیے الگ پروویژنرز ہیں، اور Amazon EKS کے ذریعے تعاون یافتہ تمام مثالیں ہماری پروویژن کنفیگریشن کے مطابق ان دو زمروں میں سے ایک میں آتی ہیں۔ ڈیٹا سائنسدان نوڈ سلیکٹرز کا استعمال کرتے ہوئے مثال کی اقسام کا انتخاب کرتے ہیں، اور کارپینٹر نوڈ لائف سائیکل مینجمنٹ کا خیال رکھتا ہے۔

استفسار تیار کرنے کے بعد، ڈیٹا سائنسدان خام ڈیٹا کو Amazon S3 پر کسی مقام پر نکالتے ہیں، پھر ڈیٹا کو دریافت کرنے کے لیے AWS Kubeflow UI سے Jupyter نوٹ بک لانچ کرتے ہیں۔ مقصد فیچر سیٹ بنانا ہے جو پہلے ماڈل کو تربیت دینے کے لیے استعمال کیا جائے گا۔ یہ ڈیٹا سائنسدانوں کو یہ تعین کرنے کی اجازت دیتا ہے کہ آیا گاہک کی کاروباری ضرورت کو پورا کرنے کے لیے ڈیٹا میں کافی سگنل موجود ہیں۔

نتائج کے تسلی بخش ہونے کے بعد، ڈیٹا سائنسدان ترقی کے چکر کے اگلے مرحلے میں چلے جاتے ہیں اور اپنی دریافتوں کو ایک مضبوط پائپ لائن میں بدل دیتے ہیں۔ وہ پی او سی کوڈ کو پروڈکشن کوالٹی کوڈ میں تبدیل کرتے ہیں جو پیمانے پر چلتا ہے۔ منظور شدہ لائبریریوں کے استعمال کے ذریعے تعمیل کو یقینی بنانے کے لیے، مناسب بیس ڈوکر امیج کے ساتھ ایک کنٹینر بنایا گیا ہے۔ ہمارے ڈیٹا سائنسدانوں کے لیے، ہم نے پایا ہے کہ معیاری Python، TensorFlow، اور Spark بیس امیج فراہم کرنے سے زیادہ تر، اگر تمام نہیں، تو کام کے بوجھ کے لیے کافی لچک ملتی ہے۔ اس کے بعد وہ اپنے جزو کی ڈوکر فائل کو اپنے ترقیاتی ماحول کو مزید اپنی مرضی کے مطابق بنانے کے لیے استعمال کر سکتے ہیں۔ اس ڈاکر فائل کو پھر CI/CD عمل کے ذریعے اجزاء کی تصویر بنانے کے لیے استعمال کیا جاتا ہے جو کہ پیداوار میں استعمال کیا جائے گا، اس لیے ترقی اور پیداوار کے ماحول کے درمیان مستقل مزاجی کو برقرار رکھا جاتا ہے۔

ہمارے پاس ایک ٹول ہے جو ڈیٹا سائنسدانوں کو یہ صلاحیت فراہم کرتا ہے کہ وہ Kubernetes پر چلنے والے پوڈ میں اپنے ترقیاتی ماحول کو شروع کر سکیں۔ جب یہ پوڈ چل رہا ہے، ڈیٹا سائنسدان پھر ویژول اسٹوڈیو کوڈ IDE کو براہ راست پوڈ سے منسلک کر سکتے ہیں اور اپنے ماڈل کوڈ کو ڈیبگ کر سکتے ہیں۔ کوڈ کے کامیابی کے ساتھ چلنے کے بعد، وہ پھر اپنی تبدیلیوں کو گٹ میں آگے بڑھا سکتے ہیں اور حالیہ تبدیلیوں کے ساتھ ایک نیا ترقیاتی ماحول پیدا ہوتا ہے۔

معیاری ڈیٹا سائنس پائپ لائن ان مراحل پر مشتمل ہے جس میں نکالنا، پری پروسیسنگ، تربیت اور تشخیص شامل ہیں۔ پائپ لائن کا ہر مرحلہ Kubeflow میں ایک جزو کے طور پر ظاہر ہوتا ہے، جو ایک Kubernetes پوڈ پر مشتمل ہوتا ہے جو ایک کمانڈ چلاتا ہے جس میں کچھ معلومات کو پیرامیٹرز کے طور پر منتقل کیا جاتا ہے۔ یہ پیرامیٹرز یا تو جامد قدریں ہو سکتے ہیں یا پچھلے جزو سے آؤٹ پٹ کے حوالے ہو سکتے ہیں۔ پوڈ میں استعمال ہونے والی ڈاکر امیج CI/CD عمل سے بنائی گئی ہے۔ اس عمل کی تفصیلات اگلے حصے میں زیر بحث CI/CD ورک فلو میں ظاہر ہوتی ہیں۔

Kubeflow پر ترقیاتی سائیکل۔ ترقیاتی کام کا فلو بائیں طرف POC کے ساتھ شروع ہوتا ہے۔ مکمل شدہ ماڈل کو Amazon ECS پر چلنے والے athenahealth ماڈل سرونگ پلیٹ فارم پر تعینات کیا گیا ہے۔

خودکار ورک فلو کو سپورٹ کرنے والا CI/CD عمل

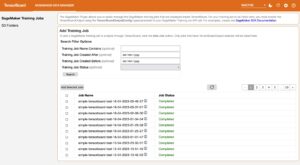

اپنے CI/CD عمل کے حصے کے طور پر، ہم Jenkins کو متوازی طور پر تمام Kubeflow اجزاء کی تصاویر بنانے اور جانچنے کے لیے استعمال کرتے ہیں۔ کامیاب تکمیل پر، پائپ لائن کے اجزاء کے سانچے میں تصاویر کے حوالہ جات شامل ہوتے ہیں، اور نتیجے میں پائپ لائن کوبی فلو پر اپ لوڈ کر دی جاتی ہے۔ جینکنز پائپ لائن میں پیرامیٹرز صارفین کو پائپ لائنز شروع کرنے اور کامیاب تعمیرات کے بعد اپنے ماڈل ٹریننگ ٹیسٹ چلانے کی اجازت دیتے ہیں۔

متبادل طور پر، ایک مختصر ڈیولپمنٹ سائیکل کو برقرار رکھنے کے لیے، ڈیٹا سائنسدان اپنی مقامی مشین سے پائپ لائن کو شروع کر سکتے ہیں، کسی بھی پائپ لائن کے پیرامیٹرز میں ترمیم کرتے ہوئے جن کے ساتھ وہ تجربہ کر رہے ہیں۔

اس بات کو یقینی بنانے کے لیے ٹولنگ موجود ہے کہ CI/CD بلڈ کے حوالہ جات کو بطور ڈیفالٹ استعمال کیا جائے۔ اگر ریپو میں قابل استعمال نمونہ موجود ہے، تو CI/CD منطق اس نمونے کو Amazon ECS پر چلنے والے athenahealth ماڈل سرونگ پلیٹ فارم (پیش گوئی سروس) پر تعینات کرنا جاری رکھے گا۔ اے ڈبلیو ایس فارگیٹ. ان تمام مراحل کے گزر جانے کے بعد، ڈیٹا سائنسدان کوڈ کو پرائمری برانچ میں ضم کر دیتا ہے۔ اس کے بعد پائپ لائنز اور قابل استعمال نمونے کو پیداوار کے لیے دھکیل دیا جاتا ہے۔

CI/CD تعیناتی ورک فلو۔ یہ خاکہ ڈیٹا سائنس کی تعمیر اور تعیناتی کے ورک فلو کو بیان کرتا ہے۔ CI/CD عمل کے ذریعے چلایا جاتا ہے۔ جینکنز.

سلامتی

اپنے ڈیٹا سائنس کے ورک فلو کو مستحکم کرنے میں، ہم ٹریننگ پائپ لائن کو محفوظ بنانے کے لیے اپنے نقطہ نظر کو مرکزی بنانے میں کامیاب ہو گئے۔ اس سیکشن میں، ہم ڈیٹا اور کلسٹر سیکیورٹی کے حوالے سے اپنے نقطہ نظر پر تبادلہ خیال کرتے ہیں۔

ڈیٹا سیکورٹی

athenahealth میں ڈیٹا کی حفاظت انتہائی اہمیت کی حامل ہے۔ اس وجہ سے، ہم ایسے بنیادی ڈھانچے کو تیار اور برقرار رکھتے ہیں جو ان ضوابط اور معیارات کے ساتھ مکمل طور پر مطابقت رکھتا ہو جو ان ڈیٹا کی سلامتی اور سالمیت کی حفاظت کرتے ہیں۔

اس بات کو یقینی بنانے کے لیے کہ ہم ڈیٹا کی تعمیل کے معیارات پر پورا اترتے ہیں، ہم اپنے AWS انفراسٹرکچر کو اپنے athenahealth انٹرپرائز کے رہنما خطوط کے مطابق فراہم کرتے ہیں۔ ڈیٹا کے دو اہم اسٹورز انتہائی قابل توسیع پائپ لائن میٹا ڈیٹا کے لیے Amazon RDS اور پائپ لائن اور ماڈل نمونے کے لیے Amazon S3 ہیں۔ Amazon S3 کے لیے، ہم یقینی بناتے ہیں کہ بالٹیاں انکرپٹڈ ہیں، HTTPS اینڈ پوائنٹس نافذ ہیں، اور بالٹی پالیسیاں اور AWS شناخت اور رسائی کا انتظام ڈیٹا تک رسائی کی اجازت دیتے وقت (IAM) کردار کم از کم استحقاق کے اصولوں پر عمل کرتے ہیں۔ یہ Amazon RDS ڈیٹا کے لیے بھی درست ہے: خفیہ کاری ہمیشہ فعال ہوتی ہے، اور سیکیورٹی گروپس اور اسناد تک رسائی کم از کم استحقاق کے اصول کی پیروی کرتے ہیں۔ یہ معیاری کاری اس بات کو یقینی بناتی ہے کہ صرف مجاز جماعتوں کو ڈیٹا تک رسائی حاصل ہے، اور اس رسائی کو ٹریک کیا جاتا ہے۔

ان اقدامات کے علاوہ، پلیٹ فارم سیکیورٹی کے خطرے کے جائزوں اور مسلسل سیکیورٹی اور تعمیل کے اسکینوں سے بھی گزرتا ہے۔

ہم حساس ڈیٹا پر مشتمل تمام S3 بالٹیوں کے لیے ڈیٹا لائف سائیکل مینجمنٹ کے ذریعے ڈیٹا برقرار رکھنے کی ضروریات کو بھی پورا کرتے ہیں۔ یہ پالیسی خود بخود ڈیٹا کو منتقل کرتی ہے۔ ایمیزون S3 گلیشیر تخلیق کے 30 دن کے بعد۔ اس میں مستثنیات کا انتظام ڈیٹا کی بازیافت کی درخواستوں کے ذریعے کیا جاتا ہے اور ہر کیس کی بنیاد پر منظور یا مسترد کیا جاتا ہے۔ یہ یقینی بناتا ہے کہ تمام ورک فلو ڈیٹا برقرار رکھنے کی پالیسی کی تعمیل کرتے ہیں۔ اس سے ڈیٹا کی بازیافت کا مسئلہ بھی حل ہو جاتا ہے اگر کوئی ماڈل خراب کارکردگی کا مظاہرہ کرتا ہے، اور دوبارہ تربیت کی ضرورت ہوتی ہے، یا جب کسی نئے ماڈل کا پرانے ماڈل کے ڈیٹاسیٹ کی تاریخی تکرار کے خلاف جائزہ لینا ضروری ہوتا ہے۔

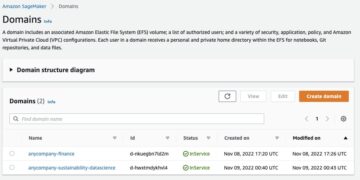

AWS اور Amazon EKS پر Kubeflow کے اندر سے Amazon S3 اور Amazon RDS تک رسائی کو محدود کرنے کے لیے، ہم IRSA (IAM Roles for Service Accounts) کا استعمال کرتے ہیں، جو Kubernetes کے اندر وسائل کے لیے IAM پر مبنی اجازت کی فراہمی فراہم کرتا ہے۔ Kubeflow میں ہر کرایہ دار کا پہلے سے تیار کردہ ایک منفرد سروس اکاؤنٹ ہوتا ہے جسے ہم خاص طور پر کرایہ دار تک رسائی کے تقاضوں کو پورا کرنے کے لیے بنائے گئے IAM کردار سے منسلک ہوتے ہیں۔ ہر صارف کے لیے Amazon Cognito یوزر پولز گروپ کی رکنیت کا استعمال کرتے ہوئے کرایہ داروں تک صارف کی رسائی بھی محدود ہے۔ جب کسی صارف کی کلسٹر سے تصدیق کی جاتی ہے، تو تیار کردہ ٹوکن میں گروپ کے دعوے ہوتے ہیں، اور Kubernetes RBAC اس معلومات کو کلسٹر میں کسی خاص وسائل تک رسائی کی اجازت دینے یا انکار کرنے کے لیے استعمال کرتا ہے۔ اس سیٹ اپ کو اگلے حصے میں مزید تفصیل سے بیان کیا گیا ہے۔

ملٹی یوزر آئسولیشن کا استعمال کرتے ہوئے کلسٹر سیکیورٹی

جیسا کہ ہم نے پچھلے حصے میں نوٹ کیا تھا، ڈیٹا سائنسدان تحقیقی ڈیٹا کا تجزیہ کرتے ہیں، ڈیٹا اینالیٹکس چلاتے ہیں، اور ایم ایل ماڈلز کو تربیت دیتے ہیں۔ وسائل مختص کرنے، ڈیٹا کو منظم کرنے، اور منصوبوں کی بنیاد پر ورک فلو کا نظم کرنے کے لیے، AWS پر Kubeflow Kubernetes نام کی جگہوں کی بنیاد پر تنہائی فراہم کرتا ہے۔ یہ تنہائی Kubeflow UI کے ساتھ تعامل کے لیے کام کرتی ہے۔ تاہم، یہ Kubectl کا استعمال کرتے ہوئے Kubernetes API تک رسائی کو کنٹرول کرنے کے لیے کوئی ٹولنگ فراہم نہیں کرتا ہے۔ اس کا مطلب یہ ہے کہ صارف کی رسائی کو کیوب فلو UI پر کنٹرول کیا جا سکتا ہے لیکن Kubectl کے ذریعے Kubernetes API پر نہیں۔

مندرجہ ذیل خاکہ میں بیان کردہ فن تعمیر گروپ ممبرشپ کی بنیاد پر Kubeflow میں پروجیکٹس تک رسائی کو یکجا کرکے اس مسئلے کو حل کرتا ہے۔ اس کو حاصل کرنے کے لیے، ہم نے AWS مینی فیسٹس پر Kubeflow کا فائدہ اٹھایا، جس میں Amazon Cognito صارف کے پولز کے ساتھ انضمام ہے۔ اس کے علاوہ، ہم کلسٹر کے اندر اجازت کو کنٹرول کرنے کے لیے Kubernetes رول بیسڈ ایکسس کنٹرول (RBAC) کا استعمال کرتے ہیں۔ صارف کی اجازتیں Amazon Cognito گروپ کی رکنیت کی بنیاد پر فراہم کی گئی ہیں۔ یہ معلومات OIDC کلائنٹ کے ذریعہ تیار کردہ ٹوکن کے ساتھ کلسٹر کو بھیجی جاتی ہے۔ یہ عمل بلٹ ان Amazon EKS فعالیت کی بدولت آسان بنایا گیا ہے جو OIDC شناخت فراہم کرنے والوں کو کلسٹر کے ساتھ تصدیق کرنے کی اجازت دیتا ہے۔

پہلے سے طے شدہ طور پر، Amazon EKS کی توثیق IAM توثیق کار کے ذریعے کی جاتی ہے، جو ایک ایسا ٹول ہے جو IAM اسناد کا استعمال کرتے ہوئے EKS کلسٹر کے ساتھ تصدیق کو قابل بناتا ہے۔ اس توثیق کے طریقے کی اپنی خوبیاں ہیں۔ تاہم، یہ ہمارے استعمال کے معاملے کے لیے موزوں نہیں ہے کیونکہ athenahealth پوری تنظیم میں شناختی خدمت کے لیے Microsoft Azure Active Directory استعمال کرتی ہے۔

Kubernetes نام کی جگہ کی تنہائی۔ ڈیٹا سائنسدان اپنے کام کے لیے ضرورت کے مطابق ایک یا ایک سے زیادہ گروپس کی رکنیت حاصل کر سکتے ہیں۔ رسائی کا مستقل بنیادوں پر جائزہ لیا جاتا ہے اور مناسب ہونے پر ہٹا دیا جاتا ہے۔

Azure Active Directory، ایک انٹرپرائز وسیع شناختی خدمت ہونے کے ناطے، Kubeflow کلسٹر تک صارف کی رسائی کو کنٹرول کرنے کے لیے سچائی کا ذریعہ ہے۔ اس کے لیے سیٹ اپ میں Azure انٹرپرائز ایپلی کیشن بنانا شامل ہے جو سروس پرنسپل کے طور پر کام کرتا ہے اور مختلف کرایہ داروں کے لیے گروپس شامل کرتا ہے جنہیں کلسٹر تک رسائی کی ضرورت ہوتی ہے۔ Azure پر اس سیٹ اپ کو Amazon Cognito میں فیڈریٹڈ OIDC شناخت فراہم کرنے والے کے ذریعے عکس بند کیا گیا ہے جو Azure کو تصدیق کی ذمہ داری کو آؤٹ سورس کرتا ہے۔ Azure گروپس تک رسائی SailPoint IdentityIQ کے ذریعے کنٹرول کی جاتی ہے، جو کہ مناسب اجازت دینے یا انکار کرنے کے لیے پروجیکٹ کے مالک کو رسائی کی درخواستیں بھیجتا ہے۔ Amazon Cognito یوزر پول میں، دو ایپلیکیشن کلائنٹس بنائے جاتے ہیں: ایک OIDC شناخت فراہم کنندہ کا استعمال کرتے ہوئے Kubernetes کلسٹر کے لیے تصدیق کو ترتیب دینے کے لیے استعمال کیا جاتا ہے، اور دوسرا Kubeflow UI میں Kubeflow کی تصدیق کو محفوظ بنانے کے لیے۔ ان کلائنٹس کو کلسٹر کے ساتھ تصدیق کے بعد گروپ کے دعوے پاس کرنے کے لیے ترتیب دیا گیا ہے، اور یہ گروپ دعوے RBAC کے ساتھ کلسٹر کے اندر اجازت دینے کے لیے استعمال کیے جاتے ہیں۔

Kubernetes RBAC رول بائنڈنگز گروپس اور کلسٹر رول Kubeflow-edit کے درمیان ترتیب دی جاتی ہیں، جو کلسٹر میں Kubeflow کو انسٹال کرنے پر بنائی جاتی ہے۔ یہ رول بائنڈنگ اس بات کو یقینی بناتی ہے کہ OIDC کے ذریعے لاگ ان ہونے کے بعد کلسٹر کے ساتھ بات چیت کرنے والا کوئی بھی صارف ان نام کی جگہوں تک رسائی حاصل کر سکتا ہے جن کے لیے ان کے گروپ دعووں میں وضاحت کی گئی ہے۔ اگرچہ یہ Kubectl کا استعمال کرتے ہوئے کلسٹر کے ساتھ تعامل کرنے والے صارفین کے لیے کام کرتا ہے، لیکن Kubeflow UI فی الحال گروپ ممبرشپ کی بنیاد پر صارفین تک رسائی فراہم نہیں کرتا ہے کیونکہ یہ RBAC استعمال نہیں کرتا ہے۔ اس کے بجائے، یہ صارفین کی رسائی کو کنٹرول کرنے کے لیے Istio Authorization Policy وسائل کا استعمال کرتا ہے۔ اس چیلنج پر قابو پانے کے لیے، ہم نے ایک حسب ضرورت کنٹرولر تیار کیا ہے جو Amazon Cognito گروپس کو پولنگ کرکے صارفین کو ہم آہنگ کرتا ہے اور گروپ کے بجائے ہر صارف کے لیے متعلقہ رول بائنڈنگز کو جوڑتا یا ہٹاتا ہے۔ یہ سیٹ اپ صارفین کو اس قابل بناتا ہے کہ وہ Kubeflow UI اور Kubectl دونوں کے ساتھ تعامل کرتے وقت یکساں سطح کی اجازتیں حاصل کر سکیں۔

آپریشنل کارکردگی

اس سیکشن میں، ہم اس بات پر تبادلہ خیال کرتے ہیں کہ ہم نے اپنے ورک فلو کو منظم اور ڈیبگ کرنے کے ساتھ ساتھ Kubeflow کو اپ گریڈ کرنے کے آپریشنل اثر کو کم کرنے کے لیے ہمارے پاس دستیاب اوپن سورس اور AWS ٹولز کا کس طرح فائدہ اٹھایا۔

لاگنگ اور نگرانی

لاگنگ کے لیے، ہم اپنے تمام کنٹینر لاگز کو آگے بڑھانے کے لیے FluentD کا استعمال کرتے ہیں۔ ایمیزون اوپن سرچ سروس اور پرومیتھیس کے سسٹم میٹرکس۔ اس کے بعد ہم لاگز اور میٹرکس کو تلاش کرنے اور فلٹر کرنے کے لیے Kibana اور Grafana UI استعمال کرتے ہیں۔ درج ذیل خاکہ بیان کرتا ہے کہ ہم اسے کیسے ترتیب دیتے ہیں۔

کیوب فلو لاگنگ۔ ہم لاگز کو دیکھنے اور چھاننے کے لیے Grafana UI اور Kibana دونوں کا استعمال کرتے ہیں۔

مندرجہ ذیل اسکرین شاٹ ہماری پائپ لائن سے Kibana UI کا منظر ہے۔

نمونہ کبانہ UI منظر۔ کبانا اپنی مرضی کے مطابق نظارے کی اجازت دیتا ہے۔

محفوظ Kubeflow کلسٹر اپ گریڈ

جیسا کہ ہم صارفین کو AWS پر Kubeflow پر بھیجتے ہیں، ہم MLOps ٹیم کو نئی خصوصیات کو جاری کرنے اور انٹیگریٹ کرنے کے ساتھ چست رہنے کی اجازت دیتے ہوئے ایک قابل اعتماد اور مستقل صارف کا تجربہ برقرار رکھتے ہیں۔ سطح پر، Kustomize ہمارے لیے ماڈیولر لگتا ہے کہ ایک وقت میں ایک جزو کو دوسروں پر اثر انداز کیے بغیر کام کرنے اور اپ گریڈ کرنے کے قابل بناتا ہے، اس طرح ہمیں صارفین کو کم سے کم رکاوٹ کے ساتھ نئی صلاحیتیں شامل کرنے کی اجازت ملتی ہے۔ تاہم، عملی طور پر ایسے منظرنامے موجود ہیں جہاں بہترین طریقہ یہ ہے کہ موجودہ کلسٹرز کے لیے اجزاء کی سطح کے اپ گریڈ کو لاگو کرنے کے بجائے صرف ایک نئے Kubernetes کلسٹر کو گھمایا جائے۔ ہمیں استعمال کے دو ایسے معاملات ملے جہاں مکمل طور پر نئے کلسٹرز بنانے میں زیادہ سمجھ آئی:

- Kubernetes ورژن میں اپ گریڈ کرنا جہاں AWS جگہ جگہ کلسٹر اپ گریڈ فراہم کرتا ہے۔ تاہم، یہ جانچنا مشکل ہو جاتا ہے کہ آیا Kubeflow اور Kubernetes وسائل میں سے ہر ایک حسب منشا کام کر رہا ہے اور مینی فیسٹس پسماندہ مطابقت برقرار رکھتے ہیں۔

- Kubeflow کو ایک نئی ریلیز میں اپ گریڈ کرنا جہاں کئی فیچرز شامل یا تبدیل کیے گئے ہیں اور یہ تقریباً ہمیشہ ہی کسی موجودہ Kubernetes کلسٹر پر جگہ جگہ اپ گریڈ کرنے کا امید افزا خیال نہیں ہے۔

اس مسئلے کو حل کرنے کے لیے، ہم نے ایک حکمت عملی تیار کی ہے جو ہمیں کسی موجودہ کام کے بوجھ کو متاثر کیے بغیر محفوظ کلسٹر تبدیلیاں کرنے کے قابل بناتی ہے۔ اس کو حاصل کرنے کے لیے، ہمیں درج ذیل معیارات پر پورا اترنا پڑا:

- کیوب فلو اسٹوریج کو الگ کریں اور وسائل کی گنتی کریں تاکہ پرانے کلسٹر کی فراہمی کو ختم کرتے وقت پائپ لائن میٹا ڈیٹا، پائپ لائن آرٹفیکٹس اور صارف کا ڈیٹا برقرار رہے۔

- AWS مینی فیسٹ پر Kubeflow کے ساتھ ضم کریں تاکہ جب Kubeflow ورژن اپ گریڈ ہوتا ہے تو کم سے کم تبدیلیوں کی ضرورت ہوتی ہے۔

- اگر کلسٹر اپ گریڈ کے بعد چیزیں غلط ہو جائیں تو واپس رول کرنے کا ایک آسان طریقہ ہے۔

- امیدواروں کے کلسٹر کو پروڈکشن میں فروغ دینے کے لیے ایک سادہ انٹرفیس رکھیں

مندرجہ ذیل خاکہ اس فن تعمیر کو واضح کرتا ہے۔

محفوظ Kubeflow کلسٹر اپ گریڈ۔ ایک بار جب Kubeflow امیدوار کی جانچ کامیاب ہو جاتی ہے، تو اسے روٹ 53 میں اپ ڈیٹ کے ذریعے Kubeflow Prod میں ترقی دی جاتی ہے۔

AWS مینی فیسٹس پر Kubeflow Amazon RDS اور Amazon S3 انٹیگریشن کے ساتھ پہلے سے پیک کیا جاتا ہے۔ عام ڈیٹا اسٹورز کے طور پر کام کرنے والی ان منظم خدمات کے ساتھ، ہم نیلے سبز کی تعیناتی کی حکمت عملی ترتیب دے سکتے ہیں۔ اس کو حاصل کرنے کے لیے، ہم نے یقینی بنایا کہ پائپ لائن میٹا ڈیٹا Amazon RDS میں برقرار ہے، جو EKS کلسٹر سے آزادانہ طور پر کام کرتا ہے، اور پائپ لائن لاگز اور نمونے Amazon S3 میں برقرار ہیں۔ پائپ لائن میٹا ڈیٹا اور نمونے کے علاوہ، ہم نے پوڈ لاگز کو Amazon OpenSearch سروس تک پہنچانے کے لیے FluentD بھی ترتیب دیا ہے۔

یہ اس بات کو یقینی بناتا ہے کہ اسٹوریج کی تہہ مکمل طور پر کمپیوٹ لیئر سے الگ ہو گئی ہے اور اس طرح مکمل طور پر نئے EKS کلسٹر پر Kubeflow ورژن اپ ڈیٹس کے دوران ٹیسٹنگ تبدیلیوں کو قابل بناتا ہے۔ تمام ٹیسٹ کامیاب ہونے کے بعد، ہم آسانی سے تبدیل کرنے کے قابل ہو جاتے ہیں۔ ایمیزون روٹ 53 کیوب فلو کی میزبانی کرنے والے امیدوار کلسٹر کو DNS ریکارڈ۔ اس کے علاوہ، ہم پرانے کلسٹر کو چند دنوں کے لیے بیک اپ کے طور پر چلاتے رہتے ہیں اگر ہمیں واپس رول کرنے کی ضرورت ہو۔

ہماری ML پائپ لائن کے لیے AWS پر Amazon EKS اور Kubeflow کے فوائد

AWS پیکج پر Amazon EKS اور Kubeflow نے ہمارے ترقیاتی ورک فلو کو ایک ایسے نمونے پر منتقل کیا جو قابل دہرائی جانے والی ماڈل ٹریننگ کی بھرپور حوصلہ افزائی کرتا ہے۔ یہ ٹولز ہمیں مکمل طور پر متعین کرایہ داروں کے ساتھ مکمل طور پر متعین کلسٹرز رکھنے اور مکمل طور پر متعین کوڈ چلانے کی اجازت دیتے ہیں۔

اس پلیٹ فارم کی تعمیر سے ہونے والی بہت سی جیتیں کم مقداری ہیں اور پلیٹ فارم کے ڈویلپرز اور صارفین دونوں کے لیے ورک فلو کس طرح بہتر ہوئے ہیں اس سے بہت کچھ کرنا ہے۔ مثال کے طور پر، MinIO کو Amazon S3 تک براہ راست رسائی سے تبدیل کر دیا گیا، جو ہمیں اپنے اصل ورک فلو کے قریب لے جاتا ہے اور ان خدمات کی تعداد کو کم کرتا ہے جن کو ہمیں برقرار رکھنا چاہیے۔ ہم Amazon RDS کو Kubeflow کے پس منظر کے طور پر استعمال کرنے کے قابل بھی ہیں، جو کلسٹرز کے درمیان آسانی سے منتقلی کے قابل بناتا ہے اور ہمیں رات کو اپنی پائپ لائنوں کا بیک اپ لینے کی صلاحیت فراہم کرتا ہے۔

ہم نے AWS کے زیر انتظام خدمات کے ساتھ Kubeflow کے انضمام میں بہتری کو بھی فائدہ مند پایا۔ مثال کے طور پر، Amazon RDS، Amazon S3، اور Amazon Cognito کے ساتھ AWS مینی فیسٹس پر Kubeflow میں پہلے سے تشکیل شدہ، ہم Kubeflow کی نئی تقسیموں کو اپ ڈیٹ کرنے میں وقت اور محنت بچاتے ہیں۔ جب ہم آفیشل Kubeflow مینی فیسٹس کو دستی طور پر تبدیل کرتے تھے، تو نئے ورژن کو اپ ڈیٹ کرنے میں ڈیزائن سے لے کر ٹیسٹنگ تک کئی ہفتے لگ جاتے ہیں۔

Amazon EKS پر سوئچ کرنے سے ہمیں Kustomize (اب Kubectl کا حصہ) اور Terraform میں اپنے کلسٹر کی وضاحت کرنے کا موقع ملتا ہے۔ یہ پتہ چلتا ہے کہ پلیٹ فارم کے کام کے لیے، Kubernetes اور Terraform سیکھنے کے لیے کافی وقت لگانے کے بعد کام کرنا بہت آسان ہے۔ کئی تکرار کے بعد، ہمارے لیے دستیاب ٹولز معیاری پلیٹ فارم آپریشنز کو انجام دینا بہت آسان بنا دیتے ہیں جیسے کسی جزو کو اپ گریڈ کرنا یا پورے ڈیولپمنٹ کلسٹر کو تبدیل کرنا۔ کچی ملازمتوں کو چلانے کے مقابلے میں ایمیزون لچکدار کمپیوٹ کلاؤڈ (Amazon EC2) مثالوں میں، اس بات کا موازنہ کرنا مشکل ہے کہ گارنٹیڈ وسائل کی صفائی اور دوبارہ کوشش کرنے والے میکانزم کے ساتھ اچھی طرح سے متعین پوڈز رکھنے سے کتنا بڑا فرق پڑتا ہے۔

Kubernetes بہترین حفاظتی معیارات فراہم کرتا ہے، اور ہم نے صرف اس سطح کو کھرچ لیا ہے جو کثیر صارف تنہائی ہمیں کرنے کی اجازت دیتی ہے۔ ہم ملٹی یوزر آئسولیشن کو ایک پیٹرن کے طور پر دیکھتے ہیں جس کا مستقبل میں زیادہ معاوضہ ہوتا ہے جب ٹریننگ پلیٹ فارم پیداواری سطح کا ڈیٹا تیار کرتا ہے، اور ہم اپنی ٹیم کے باہر سے ڈویلپرز کو لاتے ہیں۔

دریں اثنا، Kubeflow ہمیں قابل تولید ماڈل کی تربیت حاصل کرنے کی اجازت دیتا ہے۔ یہاں تک کہ ایک جیسے اعداد و شمار کے ساتھ، کوئی تربیت ایک جیسے ماڈل تیار نہیں کرتی ہے، لیکن ہمارے پاس اگلی بہترین چیز ہے۔ Kubeflow کے ساتھ، ہم بالکل جانتے ہیں کہ ماڈل کو تربیت دینے کے لیے کون سا کوڈ اور ڈیٹا استعمال کیا گیا تھا۔ آن بورڈنگ میں بہت بہتری آئی ہے کیونکہ ہماری پائپ لائن میں ہر قدم کو واضح اور پروگرام کے لحاظ سے بیان کیا گیا ہے۔ جب نئے ڈیٹا سائنسدانوں کے پاس بگ کو ٹھیک کرنے کا کام ہوتا ہے، تو انہیں بہت کم ہینڈ ہولڈنگ کی ضرورت ہوتی ہے کیونکہ ایک واضح ڈھانچہ ہوتا ہے کہ کوڈ کے آؤٹ پٹس کو مراحل کے درمیان کیسے استعمال کیا جاتا ہے۔

ایک EC2 مثال پر چلنے کے مقابلے میں Kubeflow کا استعمال بھی کارکردگی میں بہت زیادہ بہتری لاتا ہے۔ اکثر ماڈل ٹریننگ میں، ڈیٹا سائنسدانوں کو پری پروسیسنگ اور ٹریننگ کے لیے مختلف ٹولز اور اصلاح کی ضرورت ہوتی ہے۔ مثال کے طور پر، پری پروسیسنگ اکثر تقسیم شدہ ڈیٹا پروسیسنگ ٹولز کا استعمال کرتے ہوئے چلائی جاتی ہے، جیسے اسپارک، جبکہ تربیت اکثر جی پی یو مثالوں کے ذریعے چلائی جاتی ہے۔ کیوب فلو پائپ لائنز کے ساتھ، وہ پائپ لائن میں مختلف مراحل کے لیے مختلف مثال کی قسمیں بتا سکتے ہیں۔ یہ انہیں ایک مرحلے میں طاقتور GPU مثالوں اور دوسرے مرحلے میں تقسیم شدہ پروسیسنگ کے لیے چھوٹی مشینوں کے بیڑے کو استعمال کرنے کی اجازت دیتا ہے۔ نیز، چونکہ کیوب فلو پائپ لائنز مراحل کے درمیان انحصار کو بیان کرتی ہیں، اس لیے پائپ لائنیں مراحل کو متوازی طور پر چلا سکتی ہیں۔

آخر میں، چونکہ ہم نے کلسٹر میں کرایہ داروں کو شامل کرنے کے لیے ایک عمل بنایا ہے، اس لیے اب کلسٹر پر کرایہ دار کے لیے ٹیموں کو رجسٹر کرنے کا ایک زیادہ رسمی طریقہ موجود ہے۔ چونکہ ہم اپنے EKS کلسٹر میں لاگت کو ٹریک کرنے کے لیے Kubecost کا استعمال کرتے ہیں، یہ ہمیں اکاؤنٹ کی سطح پر لاگت سے منسوب کرنے کے بجائے کسی ایک پروجیکٹ سے لاگت منسوب کرنے کی اجازت دیتا ہے، جس میں ڈیٹا سائنس کے تمام پروجیکٹس شامل ہیں۔ Kubecost فی نام کی جگہ پر خرچ کی گئی رقم کی ایک رپورٹ پیش کرتا ہے، جو پائپ لائن چلانے کے لیے ذمہ دار کرایہ دار یا ٹیم کے ساتھ مضبوطی سے جوڑا جاتا ہے۔

تمام فوائد کے باوجود، ہم احتیاط کریں گے کہ اس قسم کی منتقلی صرف اس صورت میں کریں جب صارفین کی طرف سے مکمل خریداری ہو۔ وہ صارفین جو وقت کا استعمال کرتے ہیں Amazon EKS اور Kubernetes کے استعمال سے بہت سے فوائد حاصل کرتے ہیں، لیکن سیکھنے کا ایک اہم وکر ہے۔

نتیجہ

ہمارے اینڈ ٹو اینڈ ایم ایل انفراسٹرکچر میں AWS پائپ لائن پر Kubeflow کے نفاذ کے ساتھ، ہم اپنی ضروری ٹولنگ (جیسے CI/CD اور ماڈل سرونگ) کو برقرار رکھتے ہوئے اپنے ڈیٹا سائنس ورک فلو کو مستحکم اور معیاری بنانے میں کامیاب ہوئے۔ ہمارے ڈیٹا سائنسدان اب مکمل طور پر مختلف ٹول سیٹ کو برقرار رکھنے کا طریقہ سیکھنے کے بغیر اس ورک فلو کی بنیاد پر پروجیکٹس کے درمیان منتقل ہو سکتے ہیں۔ ہمارے کچھ ماڈلز کے لیے، ہمیں نئے ورک فلو (پانچ گنا تیز) کی رفتار پر بھی خوشگوار حیرت ہوئی، جس نے مزید تربیتی تکرار کی اجازت دی اور نتیجتاً بہتر پیشین گوئیوں کے ساتھ ماڈلز تیار کیے۔

ہم نے اپنی MLOps کی صلاحیتوں کو بڑھانے اور اپنے پروجیکٹس کی تعداد اور سائز کو بڑھانے کے لیے ایک ٹھوس بنیاد بھی قائم کی ہے۔ مثال کے طور پر، جیسا کہ ہم ماڈل نسب اور ٹریکنگ میں اپنی گورننس پوزیشن کو سخت کرتے ہیں، ہم نے اپنی توجہ 15 سے زیادہ ورک فلوز سے کم کر کے صرف ایک کر دی ہے۔ اور جب 4 کے آخر میں Log2021shell کی کمزوری سامنے آئی، تو ہم ایک ہی ورک فلو پر توجہ مرکوز کرنے اور ضرورت کے مطابق تیزی سے تدارک کرنے کے قابل ہو گئے (کارکردگی ایمیزون لچکدار کنٹینر رجسٹری (Amazon ECR) اسکین، Amazon OpenSearch سروس کو اپ گریڈ کرنا، ہماری ٹولنگ کو اپ ڈیٹ کرنا، اور مزید) ڈیٹا سائنسدانوں کے جاری کام پر کم سے کم اثر کے ساتھ۔ جیسے جیسے AWS اور Kubeflow اضافہ دستیاب ہوتا ہے، ہم ان کو شامل کر سکتے ہیں جیسا کہ ہم مناسب سمجھتے ہیں۔

یہ ہمیں AWS گود لینے پر ہمارے Kubeflow کے ایک اہم اور غیر واضح پہلو کی طرف لے جاتا ہے۔ اس سفر کے اہم نتائج میں سے ایک ہمارے ڈیٹا سائنسدانوں کے لیے بغیر کسی رکاوٹ کے Kubeflow میں اپ گریڈ اور اضافہ کرنے کی صلاحیت ہے۔ اگرچہ ہم نے پہلے اس کے بارے میں اپنے نقطہ نظر پر تبادلہ خیال کیا تھا، لیکن ہم AWS کے فراہم کردہ Kubeflow مینی فیسٹ پر بھی انحصار کرتے ہیں۔ ورژن 2019 کی ریلیز سے پہلے ہم نے 1.0.0 میں تصور کے ثبوت کے طور پر اپنا Kubeflow سفر شروع کیا۔ (ہم فی الحال 1.4.1 پر ہیں، 1.5 کا جائزہ لے رہے ہیں۔ AWS پہلے ہی 1.6 ورژن پر کام کر رہا ہے۔) درمیانی 3 سالوں میں، کافی مواد کے ساتھ کم از کم چھ ریلیز ہوئی ہیں۔ ان اپ گریڈز کو یکجا کرنے اور ان کی توثیق کرنے اور منشوروں کو پیشین گوئی، قابل اعتماد شیڈول پر جاری کرنے کے اپنے نظم و ضبط کے ذریعے، AWS میں Kubeflow ٹیم ہمارے ترقیاتی روڈ میپ کی منصوبہ بندی کرنے کے لیے athenahealth MLOps ٹیم کو فعال کرنے میں اہم رہی ہے، اور نتیجتاً ہمارے وسائل کی تقسیم اور توجہ کے شعبوں پر۔ مستقبل میں مزید اعتماد کے ساتھ۔

آپ پیروی کر سکتے ہیں AWS Labs GitHub ذخیرہ Kubeflow میں AWS کی تمام شراکتوں کو ٹریک کرنے کے لیے۔ آپ AWS ٹیمیں بھی تلاش کر سکتے ہیں۔ Kubeflow #AWS سلیک چینل; آپ کے تاثرات سے AWS کو Kubeflow پروجیکٹ میں تعاون کرنے کے لیے اگلی خصوصیات کو ترجیح دینے میں مدد ملتی ہے۔

مصنفین کے بارے میں

کنولجیت خرمی ایمیزون ویب سروسز میں ایک سینئر حل آرکیٹیکٹ ہے۔ وہ AWS کے صارفین کے ساتھ رہنمائی اور تکنیکی مدد فراہم کرنے کے لیے کام کرتا ہے تاکہ AWS استعمال کرتے وقت ان کے حل کی قدر کو بہتر بنایا جا سکے۔ کنولجیت کنٹینرائزڈ اور مشین لرننگ ایپلی کیشنز کے ساتھ صارفین کی مدد کرنے میں مہارت رکھتا ہے۔

کنولجیت خرمی ایمیزون ویب سروسز میں ایک سینئر حل آرکیٹیکٹ ہے۔ وہ AWS کے صارفین کے ساتھ رہنمائی اور تکنیکی مدد فراہم کرنے کے لیے کام کرتا ہے تاکہ AWS استعمال کرتے وقت ان کے حل کی قدر کو بہتر بنایا جا سکے۔ کنولجیت کنٹینرائزڈ اور مشین لرننگ ایپلی کیشنز کے ساتھ صارفین کی مدد کرنے میں مہارت رکھتا ہے۔

ٹائلر کالباچ athenahealth میں تکنیکی عملے کے پرنسپل ممبر ہیں۔ ٹائلر کے پاس تجزیات، ڈیٹا سائنس، نیورل نیٹ ورکس، اور ہیلتھ کیئر اسپیس میں مشین لرننگ ایپلی کیشنز کی ترقی میں تقریباً 7 سال کا تجربہ ہے۔ اس نے کئی مشین لرننگ سلوشنز میں تعاون کیا ہے جو فی الحال پروڈکشن ٹریفک کی خدمت کر رہے ہیں۔ فی الحال athenahealth کی انجینئرنگ تنظیم میں پرنسپل ڈیٹا سائنٹسٹ کے طور پر کام کر رہے ہیں، Tyler اس ٹیم کا حصہ رہا ہے جس نے اس کوشش کے آغاز سے ہی athenahealth کے لیے نیا مشین لرننگ ٹریننگ پلیٹ فارم بنایا ہے۔

ٹائلر کالباچ athenahealth میں تکنیکی عملے کے پرنسپل ممبر ہیں۔ ٹائلر کے پاس تجزیات، ڈیٹا سائنس، نیورل نیٹ ورکس، اور ہیلتھ کیئر اسپیس میں مشین لرننگ ایپلی کیشنز کی ترقی میں تقریباً 7 سال کا تجربہ ہے۔ اس نے کئی مشین لرننگ سلوشنز میں تعاون کیا ہے جو فی الحال پروڈکشن ٹریفک کی خدمت کر رہے ہیں۔ فی الحال athenahealth کی انجینئرنگ تنظیم میں پرنسپل ڈیٹا سائنٹسٹ کے طور پر کام کر رہے ہیں، Tyler اس ٹیم کا حصہ رہا ہے جس نے اس کوشش کے آغاز سے ہی athenahealth کے لیے نیا مشین لرننگ ٹریننگ پلیٹ فارم بنایا ہے۔

وکٹر کریلوف athenahealth میں تکنیکی عملے کے پرنسپل ممبر ہیں۔ وکٹر ایک انجینئر اور سکرم ماسٹر ہے، جو ڈیٹا سائنسدانوں کو محفوظ تیز مشین لرننگ پائپ لائنز بنانے میں مدد کرتا ہے۔ athenahealth میں اس نے انٹرفیس، کلینکل آرڈرنگ، نسخے، شیڈولنگ، اینالیٹکس اور اب مشین لرننگ پر کام کیا ہے۔ وہ صاف ستھرے لکھے ہوئے اور اچھی طرح سے یونٹ ٹیسٹ شدہ کوڈ کی قدر کرتا ہے، لیکن کوڈ ون لائنرز کے ساتھ اسے غیر صحت بخش جنون ہے۔ اپنے فارغ وقت میں وہ اپنے کتے کو چہل قدمی کرتے ہوئے پوڈ کاسٹ سننے سے لطف اندوز ہوتا ہے۔

وکٹر کریلوف athenahealth میں تکنیکی عملے کے پرنسپل ممبر ہیں۔ وکٹر ایک انجینئر اور سکرم ماسٹر ہے، جو ڈیٹا سائنسدانوں کو محفوظ تیز مشین لرننگ پائپ لائنز بنانے میں مدد کرتا ہے۔ athenahealth میں اس نے انٹرفیس، کلینکل آرڈرنگ، نسخے، شیڈولنگ، اینالیٹکس اور اب مشین لرننگ پر کام کیا ہے۔ وہ صاف ستھرے لکھے ہوئے اور اچھی طرح سے یونٹ ٹیسٹ شدہ کوڈ کی قدر کرتا ہے، لیکن کوڈ ون لائنرز کے ساتھ اسے غیر صحت بخش جنون ہے۔ اپنے فارغ وقت میں وہ اپنے کتے کو چہل قدمی کرتے ہوئے پوڈ کاسٹ سننے سے لطف اندوز ہوتا ہے۔

ساسنک ویموری athenahealth میں ٹیکنیکل سٹاف کا لیڈ ممبر ہے۔ اسے ہیلتھ کیئر، انشورنس اور بائیو انفارمیٹکس جیسے ڈومینز میں ڈیٹا پر مبنی حل تیار کرنے کے ساتھ کام کرنے کا تجربہ ہے۔ Sasank فی الحال AWS اور Kubernetes پر مشین لرننگ ٹریننگ اور انفرنس پلیٹ فارمز کو ڈیزائن اور تیار کرنے کے ساتھ کام کرتا ہے جو پیمانے پر ML سلوشنز کی تربیت اور تعیناتی میں مدد کرتا ہے۔

ساسنک ویموری athenahealth میں ٹیکنیکل سٹاف کا لیڈ ممبر ہے۔ اسے ہیلتھ کیئر، انشورنس اور بائیو انفارمیٹکس جیسے ڈومینز میں ڈیٹا پر مبنی حل تیار کرنے کے ساتھ کام کرنے کا تجربہ ہے۔ Sasank فی الحال AWS اور Kubernetes پر مشین لرننگ ٹریننگ اور انفرنس پلیٹ فارمز کو ڈیزائن اور تیار کرنے کے ساتھ کام کرتا ہے جو پیمانے پر ML سلوشنز کی تربیت اور تعیناتی میں مدد کرتا ہے۔

انو ٹمکور athenahealth میں آرکیٹیکٹ ہیں۔ انو کے پاس دو دہائیوں سے زیادہ کا فن تعمیر، ڈیزائن، مشین لرننگ، کلاؤڈ آپریشنز، بڑا ڈیٹا، ریئل ٹائم ڈسٹری بیوٹڈ ڈیٹا پائپ لائنز، ایڈ ٹیک، ڈیٹا اینالیٹکس، سوشل میڈیا اینالیٹکس میں مختلف سافٹ ویئر پروڈکٹس بنانے کا تجربہ ہے۔ انو فی الحال مشین لرننگ پلیٹ فارم اور ڈیٹا پائپ لائن ٹیموں پر athenahealth کی پروڈکٹ انجینئرنگ تنظیم میں ایک معمار کے طور پر کام کرتی ہے۔

انو ٹمکور athenahealth میں آرکیٹیکٹ ہیں۔ انو کے پاس دو دہائیوں سے زیادہ کا فن تعمیر، ڈیزائن، مشین لرننگ، کلاؤڈ آپریشنز، بڑا ڈیٹا، ریئل ٹائم ڈسٹری بیوٹڈ ڈیٹا پائپ لائنز، ایڈ ٹیک، ڈیٹا اینالیٹکس، سوشل میڈیا اینالیٹکس میں مختلف سافٹ ویئر پروڈکٹس بنانے کا تجربہ ہے۔ انو فی الحال مشین لرننگ پلیٹ فارم اور ڈیٹا پائپ لائن ٹیموں پر athenahealth کی پروڈکٹ انجینئرنگ تنظیم میں ایک معمار کے طور پر کام کرتی ہے۔

ولیم تسن athenahealth میں سینئر انجینئرنگ مینیجر ہیں۔ اس کے پاس ہیلتھ کیئر آئی ٹی، بڑے ڈیٹا ڈسٹری بیوٹڈ کمپیوٹنگ، ذہین آپٹیکل نیٹ ورکس، ریئل ٹائم ویڈیو ایڈیٹنگ سسٹم، انٹرپرائز سافٹ ویئر، اور گروپ ہیلتھ کیئر انڈر رائٹنگ میں 20 سال سے زیادہ انجینئرنگ لیڈر شپ کا تجربہ ہے۔ ولیم فی الحال پروڈکٹ انجینئرنگ تنظیم میں athenahealth، مشین لرننگ آپریشنز اور DevOps انجینئرنگ ٹیموں میں دو زبردست ٹیموں کی قیادت کر رہے ہیں۔

ولیم تسن athenahealth میں سینئر انجینئرنگ مینیجر ہیں۔ اس کے پاس ہیلتھ کیئر آئی ٹی، بڑے ڈیٹا ڈسٹری بیوٹڈ کمپیوٹنگ، ذہین آپٹیکل نیٹ ورکس، ریئل ٹائم ویڈیو ایڈیٹنگ سسٹم، انٹرپرائز سافٹ ویئر، اور گروپ ہیلتھ کیئر انڈر رائٹنگ میں 20 سال سے زیادہ انجینئرنگ لیڈر شپ کا تجربہ ہے۔ ولیم فی الحال پروڈکٹ انجینئرنگ تنظیم میں athenahealth، مشین لرننگ آپریشنز اور DevOps انجینئرنگ ٹیموں میں دو زبردست ٹیموں کی قیادت کر رہے ہیں۔

- AI

- ai آرٹ

- AI آرٹ جنریٹر

- عی روبوٹ

- ایمیزون کاگنیٹو

- ایمیزون آر ڈی ایس

- مصنوعی ذہانت

- مصنوعی ذہانت کا سرٹیفیکیشن

- بینکنگ میں مصنوعی ذہانت

- مصنوعی ذہانت والا روبوٹ

- مصنوعی ذہانت والے روبوٹ

- مصنوعی ذہانت سافٹ ویئر

- AWS مشین لرننگ

- blockchain

- بلاکچین کانفرنس

- coingenius

- بات چیت مصنوعی ذہانت

- crypto کانفرنس ai

- صارفین کے حل

- dall-e

- گہری سیکھنے

- گوگل عی

- مشین لرننگ

- پلاٹا

- افلاطون اے

- افلاطون ڈیٹا انٹیلی جنس

- افلاطون گیم

- پلیٹو ڈیٹا

- پلیٹو گیمنگ

- پیمانہ ai

- نحو

- زیفیرنیٹ