مانیٹرنگ مشین لرننگ (ML) پیشین گوئیاں تعینات ماڈلز کے معیار کو بہتر بنانے میں مدد کر سکتی ہیں۔ پروڈکشن میں بنائے گئے نتائج سے ڈیٹا حاصل کرنا آپ کو اپنے تعینات کردہ ماڈلز کی نگرانی کرنے اور ماڈل کے معیار میں انحراف کا پتہ لگانے کے قابل بناتا ہے۔ ان انحرافات کی ابتدائی اور فعال شناخت آپ کو اصلاحی اقدامات کرنے کے قابل بناتی ہے، جیسے ماڈلز کو دوبارہ تربیت دینا، اپ اسٹریم سسٹمز کا آڈٹ کرنا، یا معیار کے مسائل کو ٹھیک کرنا۔

او ڈبلیو ایس لامبڈا۔ ایک سرور لیس کمپیوٹ سروس ہے جو پیمانے پر ریئل ٹائم ایم ایل کا اندازہ فراہم کر سکتی ہے۔ اس پوسٹ میں، ہم ایک نمونہ ڈیٹا کیپچر کی خصوصیت کا مظاہرہ کرتے ہیں جسے Lambda ML inference کام کے بوجھ میں تعینات کیا جا سکتا ہے۔

دسمبر 2020 میں، Lambda نے پیکیجنگ فارمیٹ کے طور پر کنٹینر امیجز کے لیے سپورٹ متعارف کرایا۔ اس خصوصیت نے تعیناتی پیکیج سائز کی حد کو 500 MB سے بڑھا کر 10 GB کر دیا ہے۔ اس فیچر کے آغاز سے پہلے، پیکیج کے سائز کی رکاوٹ نے ML فریم ورک جیسے TensorFlow یا PyTorch کو Lambda فنکشنز میں تعینات کرنا مشکل بنا دیا۔ لانچ کے بعد، پیکج کے سائز کی بڑھتی ہوئی حد نے ML کو Lambda میں تعینات کرنے کے لیے ایک قابل عمل اور پرکشش کام کا بوجھ بنا دیا۔ 2021 میں، ML inference Lambda سروس میں تیزی سے بڑھتے ہوئے کام کے بوجھ کی اقسام میں سے ایک تھا۔

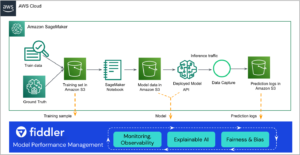

ایمیزون سیج میکر, Amazon کی مکمل طور پر منظم ML سروس، اس کے اپنے ماڈل کی نگرانی کی خصوصیت پر مشتمل ہے۔ تاہم، اس پوسٹ میں نمونہ پروجیکٹ دکھاتا ہے کہ کس طرح ML انفرنس کے لیے لیمبڈا استعمال کرنے والے صارفین کے لیے ماڈل مانیٹرنگ میں استعمال کے لیے ڈیٹا کیپچر کرنا ہے۔ یہ پروجیکٹ لیمبڈا ایکسٹینشنز کا استعمال کرتا ہے تاکہ انفرنس ڈیٹا کو حاصل کیا جا سکے تاکہ انفرنس فنکشن کی کارکردگی اور تاخیر پر پڑنے والے اثرات کو کم کیا جا سکے۔ لیمبڈا ایکسٹینشنز کا استعمال فنکشن ڈویلپرز پر اثر کو بھی کم کرتا ہے۔ ایکسٹینشن کے ذریعے انضمام کے ذریعے، نگرانی کی خصوصیت کو متعدد فنکشنز پر لاگو کیا جا سکتا ہے اور ایک مرکزی ٹیم کے ذریعے برقرار رکھا جا سکتا ہے۔

حل کا جائزہ

اس پروجیکٹ میں سرور لیس ایپلیکیشن کے لیے سورس کوڈ اور معاون فائلیں شامل ہیں جو ڈسٹلبرٹ بیس، پہلے سے تربیت یافتہ سوال جواب دینے والے ماڈل کا استعمال کرتے ہوئے حقیقی وقت کا اندازہ فراہم کرتی ہے۔ اس پروجیکٹ میں ہگنگ فیس سوال اور جواب قدرتی زبان پروسیسنگ (NLP) ماڈل کے ساتھ استعمال کیا گیا ہے۔ پی ٹورچ قدرتی زبان کا اندازہ لگانے کے کاموں کو انجام دینے کے لیے۔ اس پروجیکٹ میں ماڈل کی پیشین گوئیوں کے لیے انفرنس ڈیٹا کیپچر کرنے کا حل بھی شامل ہے۔ لیمبڈا فنکشن رائٹر اس بات کا تعین کر سکتا ہے کہ انفرنس ریکوسٹ ان پٹ سے کون سا ڈیٹا اور پیشین گوئی کا نتیجہ ایکسٹینشن کو بھیجنا ہے۔ اس حل میں، ہم ان پٹ اور جواب کو ماڈل سے ایکسٹینشن پر بھیجتے ہیں۔ توسیع پھر وقتا فوقتا ڈیٹا کو بھیجتی ہے۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3) بالٹی۔ ہم ڈیٹا کیپچر ایکسٹینشن کو ایک کنٹینر امیج کے طور پر بناتے ہیں۔ makefile. پھر ہم لیمبڈا انفرنس فنکشن کو کنٹینر امیج کے طور پر بناتے ہیں اور ایکسٹینشن کنٹینر امیج کو کنٹینر امیج لیئر کے طور پر شامل کرتے ہیں۔ مندرجہ ذیل خاکہ فن تعمیر کا ایک جائزہ دکھاتا ہے۔

لیمبڈا ایکسٹینشنز لیمبڈا کے افعال کو بڑھانے کا ایک طریقہ ہیں۔ اس پروجیکٹ میں، ہم تخمینہ کی درخواست اور تخمینہ سے پیشین گوئی کو لاگ کرنے کے لیے ایک بیرونی لیمبڈا ایکسٹینشن کا استعمال کرتے ہیں۔ بیرونی توسیع لیمبڈا رن ٹائم ماحول میں ایک الگ عمل کے طور پر چلتی ہے، جس سے انفرنس فنکشن پر اثر کم ہوتا ہے۔ تاہم، فنکشن وسائل جیسے سی پی یو، میموری، اور اسٹوریج کو لیمبڈا فنکشن کے ساتھ شیئر کرتا ہے۔ ہم تجویز کرتے ہیں کہ وسائل کی زیادہ سے زیادہ دستیابی کو یقینی بنانے کے لیے لیمبڈا فنکشن میں کافی میموری مختص کریں۔ (ہماری جانچ میں، ہم نے inference Lambda فنکشن کے لیے 5 GB میموری مختص کی اور وسائل کی بہترین دستیابی اور تخمینہ میں تاخیر دیکھی)۔ جب کوئی اندازہ مکمل ہو جاتا ہے، تو Lambda سروس فوری طور پر جواب واپس کر دیتی ہے اور S3 بالٹی کی درخواست اور جواب کو لاگ ان کرنے کے لیے توسیع کا انتظار نہیں کرتی ہے۔ اس پیٹرن کے ساتھ، مانیٹرنگ ایکسٹینشن انفرنس لیٹینسی کو متاثر نہیں کرتی ہے۔ لیمبڈا ایکسٹینشنز کے بارے میں مزید جاننے کے لیے یہ ویڈیو سیریز دیکھیں.

پروجیکٹ کے مواد

اس منصوبے کو استعمال کرتا ہے AWS سرور لیس ایپلیکیشن ماڈل (AWS SAM) کمانڈ لائن انٹرفیس (CLI)۔ یہ کمانڈ لائن ٹول ڈویلپرز کو ایپلی کیشنز کو شروع کرنے اور ترتیب دینے کی اجازت دیتا ہے۔ مقامی طور پر پیکیج، تعمیر، اور جانچ؛ اور AWS کلاؤڈ پر تعینات کریں۔

آپ اس پروجیکٹ کا سورس کوڈ یہاں سے ڈاؤن لوڈ کر سکتے ہیں۔ GitHub ذخیرہ.

اس پروجیکٹ میں درج ذیل فائلیں اور فولڈرز شامل ہیں:

- app/app.py - ایپلیکیشن کے لیمبڈا فنکشن کے لیے کوڈ، بشمول ایم ایل انفرنسنگ کا کوڈ۔

- ایپ/ڈاکر فائل - کنٹینر امیج بنانے کے لیے ڈاکر فائل جو انفرنس فنکشن کو پیک کرتی ہے، ہیگنگ فیس سے ڈاؤن لوڈ کردہ ماڈل، اور لیمبڈا ایکسٹینشن کو ایک پرت کے طور پر بنایا گیا ہے۔ .zip فنکشنز کے برعکس، فنکشن تخلیق وقت پر کنٹینر پیکڈ لیمبڈا فنکشنز کے ساتھ تہوں کو منسلک نہیں کیا جا سکتا۔ اس کے بجائے، ہم پرت بناتے ہیں اور اس کے مواد کو کنٹینر امیج میں کاپی کرتے ہیں۔

- ملانے - ماڈل مانیٹر ایکسٹینشن فائلیں۔ یہ لیمبڈا ایکسٹینشن انفرنس فنکشن میں ان پٹ کو لاگ کرنے اور S3 بالٹی سے متعلقہ پیشین گوئی کے لیے استعمال ہوتی ہے۔

- ایپ/ماڈل - Hugging Face سے ڈاؤن لوڈ کردہ ماڈل۔

- app/requirements.txt - کنٹینر میں پائتھون کی انحصار کو انسٹال کرنا ہے۔

- واقعات - دعوتی واقعات جو آپ فنکشن کو جانچنے کے لیے استعمال کر سکتے ہیں۔

- template.yaml - ایک ڈسکرپٹر فائل جو ایپلیکیشن کے AWS وسائل کی وضاحت کرتی ہے۔

ایپلیکیشن کئی AWS وسائل استعمال کرتی ہے، بشمول Lambda فنکشنز اور ایک ایمیزون API گیٹ وے API ان وسائل کی وضاحت میں کی گئی ہے۔ template.yaml اس منصوبے میں فائل. آپ اسی تعیناتی کے عمل کے ذریعے AWS وسائل کو شامل کرنے کے لیے ٹیمپلیٹ کو اپ ڈیٹ کر سکتے ہیں جو آپ کے ایپلیکیشن کوڈ کو اپ ڈیٹ کرتا ہے۔

شرائط

اس واک تھرو کے لیے، آپ کے پاس درج ذیل شرائط ہونی چاہئیں:

نمونہ کی درخواست کو تعینات کریں۔

پہلی بار اپنی درخواست بنانے کے لیے، درج ذیل مراحل کو مکمل کریں:

- اپنے شیل میں درج ذیل کوڈ کو چلائیں۔ (یہ ایکسٹینشن بھی بنائے گا):

- ماڈل مانیٹر ایپلی کیشن کی ڈوکر امیج بنائیں۔ تعمیراتی مواد میں رہتا ہے۔

.aws-samڈائرکٹری

- ایمیزون ای سی آر میں لاگ ان کریں:

- ایمیزون ای سی آر میں ایک ذخیرہ بنائیں:

aws ecr create-repositoryrepository-name serverless-ml-model-monitor--image-scanning-configuration scanOnPush=true--region us-east-1

- کنٹینر کی تصویر کو ایمیزون ای سی آر پر پش کریں:

- غیر تبصرہ لائن # 1 انچ ایپ/ڈاکر فائل اور درست ای سی آر ریپوزٹری امیج کی طرف اشارہ کرنے کے لیے اس میں ترمیم کریں، پھر لائنز #6 اور #7 میں غیر تبصرہ کریں۔ ایپ/ڈاکر فائل:

- درخواست دوبارہ بنائیں:

ہم دوبارہ تعمیر کرتے ہیں کیونکہ لیمبڈا کنٹینر امیج پیکیجنگ کی قسم کے لیے براہ راست لیمبڈا لیئرز کو سپورٹ نہیں کرتا ہے۔ ہمیں پہلے ماڈل مانیٹرنگ جزو کو کنٹینر امیج کے طور پر بنانا ہوگا، اسے Amazon ECR پر اپ لوڈ کرنا ہوگا، اور پھر اس تصویر کو ماڈل مانیٹرنگ ایپلی کیشن میں کنٹینر لیئر کے طور پر استعمال کرنا ہوگا۔

- آخر میں، لیمبڈا فنکشن، API گیٹ وے، اور ایکسٹینشن تعینات کریں:

یہ کمانڈ آپ کی ایپلیکیشن کو AWS پر پرامپٹس کی ایک سیریز کے ساتھ پیکج اور تعینات کرتا ہے:

- اسٹیک کا نام : تعینات کا نام AWS کلاؤڈ فارمیشن اسٹیک یہ آپ کے اکاؤنٹ اور علاقے کے لیے منفرد ہونا چاہیے، اور ایک اچھا نقطہ آغاز آپ کے پروجیکٹ کے نام سے مماثل ہوگا۔

- AWS علاقہ : AWS علاقہ جس میں آپ اپنی درخواست لگاتے ہیں۔

- تعیناتی سے پہلے تبدیلیوں کی تصدیق کریں۔ : اگر مقرر کیا گیا ہے۔

yesدستی جائزے کے لیے چلانے سے پہلے آپ کو کوئی بھی تبدیلی سیٹ دکھائی جاتی ہے۔ اگر نہیں پر سیٹ کیا جاتا ہے تو، AWS SAM CLI خود بخود ایپلیکیشن کی تبدیلیاں تعینات کر دیتا ہے۔ - AWS SAM CLI IAM رول تخلیق کی اجازت دیں۔ : بہت سے AWS SAM ٹیمپلیٹس، بشمول یہ مثال، تخلیق کرتے ہیں۔ AWS شناخت اور رسائی کا انتظام AWS خدمات تک رسائی کے لیے شامل Lambda فنکشن (آئی اے ایم) کے لیے درکار کردار۔ پہلے سے طے شدہ طور پر، ان کا دائرہ کم از کم مطلوبہ اجازتوں تک ہوتا ہے۔ CloudFormation اسٹیک کو تعینات کرنے کے لیے جو IAM کے کرداروں کو تخلیق یا اس میں ترمیم کرتا ہے،

CAPABILITY_IAMکے لئے قیمتcapabilitiesفراہم کرنا ضروری ہے. اگر اس پرامپٹ کے ذریعے اجازت فراہم نہیں کی جاتی ہے، تو اس مثال کو تعینات کرنے کے لیے آپ کو واضح طور پر پاس کرنا ہوگا--capabilities CAPABILITY_IAMکرنے کے لئےsam deployکمانڈر - samconfig.toml پر دلائل محفوظ کریں۔ : اگر مقرر کیا گیا ہے۔

yes، آپ کے انتخاب کو پروجیکٹ کے اندر ایک کنفیگریشن فائل میں محفوظ کیا جاتا ہے تاکہ مستقبل میں، آپ صرف چلا سکیںsam deployآپ کی درخواست میں تبدیلیاں تعینات کرنے کے لیے پیرامیٹرز کے بغیر۔

آپ تعیناتی کے بعد ظاہر ہونے والی آؤٹ پٹ ویلیوز میں اپنا API گیٹ وے اینڈ پوائنٹ URL تلاش کر سکتے ہیں۔

درخواست کی جانچ کریں۔

ایپلیکیشن کی جانچ کرنے کے لیے، API گیٹ وے اینڈ پوائنٹ پر درخواست بھیجنے کے لیے پوسٹ مین یا curl کا استعمال کریں۔ مثال کے طور پر:

آپ کو مندرجہ ذیل کوڈ کی طرح آؤٹ پٹ دیکھنا چاہئے۔ ایم ایل ماڈل نے سیاق و سباق سے اندازہ لگایا اور ہمارے سوال کا جواب واپس کیا۔

چند منٹوں کے بعد، آپ کو S3 بالٹی میں ایک فائل نظر آنی چاہیے۔ nlp-qamodel-model-monitoring-modelmonitorbucket- لاگ ان پٹ اور تخمینہ کے ساتھ۔

صاف کرو

آپ نے جو نمونہ ایپلیکیشن بنائی ہے اسے حذف کرنے کے لیے، AWS CLI استعمال کریں:

نتیجہ

اس پوسٹ میں، ہم نے لیمبڈا ایکسٹینشن کے طور پر ایک ماڈل مانیٹرنگ فیچر کو لاگو کیا اور اسے لیمبڈا ایم ایل انفرنس ورک بوجھ پر تعینات کیا۔ ہم نے دکھایا کہ اس حل کو آپ کے اپنے AWS اکاؤنٹ میں کیسے بنایا جائے اور اسے کیسے لگایا جائے۔ آخر میں، ہم نے دکھایا کہ مانیٹر کی فعالیت کی تصدیق کے لیے ٹیسٹ کیسے چلایا جائے۔

براہ کرم تبصرے کے سیکشن میں کوئی خیالات یا سوالات فراہم کریں۔ مزید سرور کے بغیر سیکھنے کے وسائل کے لیے، ملاحظہ کریں۔ بے سرور زمین.

مصنفین کے بارے میں

ڈین فاکس سرور لیس کے لیے عالمی اسپیشلسٹ آرگنائزیشن میں پرنسپل اسپیشلسٹ سلوشنز آرکیٹیکٹ ہیں۔ ڈین صارفین کے ساتھ کام کرتا ہے تاکہ وہ قابل توسیع، غلطی برداشت کرنے والی، اعلی کارکردگی کا مظاہرہ کرنے والی، لاگت سے موثر ایپلی کیشنز بنانے کے لیے سرور کے بغیر خدمات کا فائدہ اٹھا سکیں۔ ڈین خوبصورت بولڈر، کولوراڈو میں رہنے اور کام کرنے کے قابل ہونے پر شکر گزار ہے۔

ڈین فاکس سرور لیس کے لیے عالمی اسپیشلسٹ آرگنائزیشن میں پرنسپل اسپیشلسٹ سلوشنز آرکیٹیکٹ ہیں۔ ڈین صارفین کے ساتھ کام کرتا ہے تاکہ وہ قابل توسیع، غلطی برداشت کرنے والی، اعلی کارکردگی کا مظاہرہ کرنے والی، لاگت سے موثر ایپلی کیشنز بنانے کے لیے سرور کے بغیر خدمات کا فائدہ اٹھا سکیں۔ ڈین خوبصورت بولڈر، کولوراڈو میں رہنے اور کام کرنے کے قابل ہونے پر شکر گزار ہے۔

نیوٹن جین AWS Lambda پر مشین لرننگ، ہائی پرفارمنس کمپیوٹنگ (HPC) اور میڈیا پروسیسنگ صارفین کے لیے نئے تجربات بنانے کا ذمہ دار ایک سینئر پروڈکٹ مینیجر ہے۔ وہ کارکردگی کو بڑھانے، تاخیر کو کم کرنے، اسکیل ایبلٹی کو بہتر بنانے، بھروسے کو بڑھانے اور لاگت کو کم کرنے کے لیے نئی صلاحیتوں کی ترقی کی رہنمائی کرتا ہے۔ وہ AWS صارفین کو ان کی کمپیوٹ-انٹینسی ایپلی کیشنز کے لیے ایک موثر سرور لیس حکمت عملی کی وضاحت کرنے میں بھی مدد کرتا ہے۔

نیوٹن جین AWS Lambda پر مشین لرننگ، ہائی پرفارمنس کمپیوٹنگ (HPC) اور میڈیا پروسیسنگ صارفین کے لیے نئے تجربات بنانے کا ذمہ دار ایک سینئر پروڈکٹ مینیجر ہے۔ وہ کارکردگی کو بڑھانے، تاخیر کو کم کرنے، اسکیل ایبلٹی کو بہتر بنانے، بھروسے کو بڑھانے اور لاگت کو کم کرنے کے لیے نئی صلاحیتوں کی ترقی کی رہنمائی کرتا ہے۔ وہ AWS صارفین کو ان کی کمپیوٹ-انٹینسی ایپلی کیشنز کے لیے ایک موثر سرور لیس حکمت عملی کی وضاحت کرنے میں بھی مدد کرتا ہے۔

دکشا شرما AWS میں سولیوشن آرکیٹیکٹ اور مشین لرننگ اسپیشلسٹ ہیں۔ وہ گاہکوں کو ان کے کلاؤڈ کو اپنانے کو تیز کرنے میں مدد کرتی ہے، خاص طور پر مشین لرننگ اور سرور لیس ٹیکنالوجیز کے شعبوں میں۔ ڈکشا تصور کے حسب ضرورت ثبوتوں کو متعین کرتی ہے جو صارفین کو ان کے کاروبار اور IT چیلنجوں کا مقابلہ کرنے میں AWS کی قدر کو ظاہر کرتی ہے۔ وہ صارفین کو AWS کے بارے میں ان کے علم میں اہل بناتی ہے اور ان کے مطلوبہ حل کو تیار کرنے کے لیے صارفین کے ساتھ مل کر کام کرتی ہے۔

دکشا شرما AWS میں سولیوشن آرکیٹیکٹ اور مشین لرننگ اسپیشلسٹ ہیں۔ وہ گاہکوں کو ان کے کلاؤڈ کو اپنانے کو تیز کرنے میں مدد کرتی ہے، خاص طور پر مشین لرننگ اور سرور لیس ٹیکنالوجیز کے شعبوں میں۔ ڈکشا تصور کے حسب ضرورت ثبوتوں کو متعین کرتی ہے جو صارفین کو ان کے کاروبار اور IT چیلنجوں کا مقابلہ کرنے میں AWS کی قدر کو ظاہر کرتی ہے۔ وہ صارفین کو AWS کے بارے میں ان کے علم میں اہل بناتی ہے اور ان کے مطلوبہ حل کو تیار کرنے کے لیے صارفین کے ساتھ مل کر کام کرتی ہے۔

وید رمن میری لینڈ میں مقیم مشین لرننگ کے لیے ایک سینئر اسپیشلسٹ سولیوشن آرکیٹیکٹ ہے۔ ویدا صارفین کے ساتھ کام کرتا ہے تاکہ ان کو موثر، محفوظ اور قابل توسیع مشین لرننگ ایپلی کیشنز کو معمار بنانے میں مدد ملے۔ ویڈا مشین لرننگ کے لیے بغیر سرور ٹیکنالوجیز کا فائدہ اٹھانے میں صارفین کی مدد کرنے میں دلچسپی رکھتا ہے۔

وید رمن میری لینڈ میں مقیم مشین لرننگ کے لیے ایک سینئر اسپیشلسٹ سولیوشن آرکیٹیکٹ ہے۔ ویدا صارفین کے ساتھ کام کرتا ہے تاکہ ان کو موثر، محفوظ اور قابل توسیع مشین لرننگ ایپلی کیشنز کو معمار بنانے میں مدد ملے۔ ویڈا مشین لرننگ کے لیے بغیر سرور ٹیکنالوجیز کا فائدہ اٹھانے میں صارفین کی مدد کرنے میں دلچسپی رکھتا ہے۔

جوش خان سرور لیس کے لیے دنیا بھر میں ٹیک لیڈر اور پرنسپل سلوشنز آرکیٹیکٹ ہے۔ وہ AWS میں سرور لیس ماہرین کی ایک عالمی برادری کی رہنمائی کرتا ہے جو AWS سرور لیس ٹیکنالوجیز کو مؤثر طریقے سے استعمال کرنے میں اسٹارٹ اپس سے لے کر دنیا کے سب سے بڑے کاروباری اداروں تک تمام سائز کے صارفین کی مدد کرتا ہے۔

جوش خان سرور لیس کے لیے دنیا بھر میں ٹیک لیڈر اور پرنسپل سلوشنز آرکیٹیکٹ ہے۔ وہ AWS میں سرور لیس ماہرین کی ایک عالمی برادری کی رہنمائی کرتا ہے جو AWS سرور لیس ٹیکنالوجیز کو مؤثر طریقے سے استعمال کرنے میں اسٹارٹ اپس سے لے کر دنیا کے سب سے بڑے کاروباری اداروں تک تمام سائز کے صارفین کی مدد کرتا ہے۔

- AI

- ai آرٹ

- AI آرٹ جنریٹر

- عی روبوٹ

- مصنوعی ذہانت

- مصنوعی ذہانت کا سرٹیفیکیشن

- بینکنگ میں مصنوعی ذہانت

- مصنوعی ذہانت والا روبوٹ

- مصنوعی ذہانت والے روبوٹ

- مصنوعی ذہانت سافٹ ویئر

- او ڈبلیو ایس لامبڈا۔

- AWS مشین لرننگ

- blockchain

- بلاکچین کانفرنس

- coingenius

- بات چیت مصنوعی ذہانت

- crypto کانفرنس ai

- dall-e

- گہری سیکھنے

- گوگل عی

- مشین لرننگ

- پلاٹا

- افلاطون اے

- افلاطون ڈیٹا انٹیلی جنس

- افلاطون گیم

- پلیٹو ڈیٹا

- پلیٹو گیمنگ

- پیمانہ ai

- نحو

- تکنیکی طریقہ

- زیفیرنیٹ