- 12 فرمائے، 2014

- Vasilis Vryniotis

- . 4 تبصرے

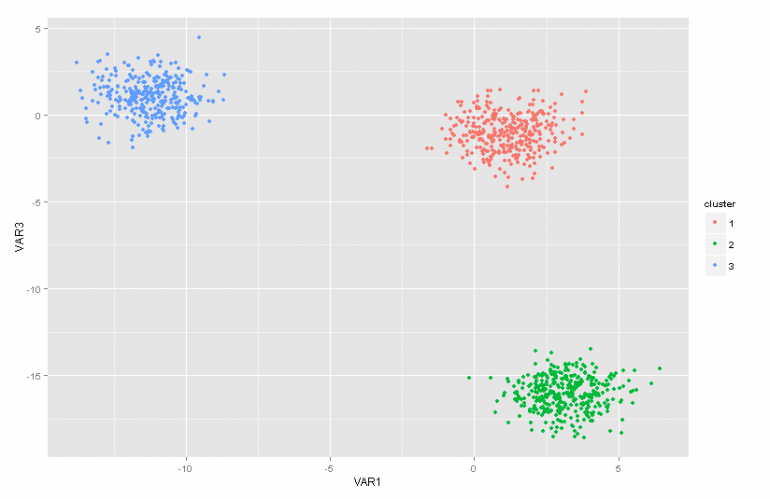

یہ بلاگ پوسٹ ڈیریچلیٹ پروسیس مکسچر ماڈلز پر آرٹیکل سیریز کا دوسرا حصہ ہے۔ پچھلے مضمون میں ہم نے ایک کئی کلسٹر تجزیہ تکنیکوں کا جائزہ اور ہم نے ان کے استعمال سے پیدا ہونے والے کچھ مسائل/حدود پر تبادلہ خیال کیا۔ مزید یہ کہ ہم نے مختصراً Dirichlet Process Mixture Models کو پیش کیا، ہم نے اس بارے میں بات کی کہ وہ کیوں کارآمد ہیں اور ہم نے ان کی کچھ درخواستیں پیش کیں۔

اپ ڈیٹ: ڈیٹام باکس مشین لرننگ فریم ورک اب اوپن سورس اور مفت ہے۔ ڈاؤن لوڈ، اتارنا. جاوا میں Dirichlet Process Mixture Models کے نفاذ کو دیکھنے کے لیے com.datumbox.framework.machinelearning.clustering پیکیج دیکھیں۔

Dirichlet Process Mixture Models کو شروع میں نگلنا قدرے مشکل ہو سکتا ہے کیونکہ یہ لامحدود مرکب ماڈلز ہیں جن میں بہت سی مختلف نمائندگی ہوتی ہے۔ خوش قسمتی سے موضوع تک پہنچنے کا ایک اچھا طریقہ ڈیریچلیٹ ڈسٹری بیوشن کے ساتھ فائنائٹ مکسچر ماڈلز سے شروع کرنا اور پھر لامحدود ماڈلز کی طرف جانا ہے۔

نتیجتاً اس مضمون میں میں مختصراً کچھ اہم ڈسٹری بیوشنز پیش کروں گا جن کی ہمیں ضرورت ہو گی، ہم ان کا استعمال ملٹی نامی امکانی ماڈل کے ساتھ Dirichlet Prior کی تعمیر کے لیے کریں گے اور پھر ہم Dirichlet Distribution کی بنیاد پر Finite Mixture Model پر جائیں گے۔

1. بیٹا تقسیم

۔ بیٹا تقسیم مسلسل تقسیم کا ایک خاندان ہے جس کی وضاحت [0,1] کے وقفے میں کی گئی ہے۔ یہ دو مثبت پیرامیٹرز a اور b کے ذریعہ پیرامیٹرائز کیا گیا ہے اور اس کی شکل ان دو پیرامیٹرز کے انتخاب پر بہت زیادہ منحصر ہے۔

شکل 1: مختلف a، b پیرامیٹرز کے لیے بیٹا تقسیم

بیٹا ڈسٹری بیوشن عام طور پر احتمالات پر تقسیم کو ماڈل کرنے کے لیے استعمال کیا جاتا ہے اور اس میں مندرجہ ذیل امکانی کثافت ہوتی ہے:

![]()

مساوات 1: بیٹا پی ڈی ایف

جہاں Γ(x) گاما فنکشن ہے اور a, b تقسیم کے پیرامیٹرز۔ بیٹا عام طور پر امکانی قدروں کی تقسیم کے طور پر استعمال ہوتا ہے اور ہمیں یہ امکان فراہم کرتا ہے کہ نمونہ شدہ امکان کسی خاص قدر P = p0 کے برابر ہو۔ اس کی تعریف کے مطابق بیٹا ڈسٹری بیوشن بائنری نتائج کے امکان کو ماڈل کرنے کے قابل ہے جو صحیح یا غلط اقدار کو لے لیتا ہے۔ پیرامیٹرز a اور b کو بالترتیب کامیابی اور ناکامی کے سیوڈکاؤنٹس کے طور پر سمجھا جا سکتا ہے۔ اس طرح بیٹا ڈسٹری بیوشن ایک کامیابی اور بی ناکامیوں کے پیش نظر کامیابی کے امکان کو پیش کرتا ہے۔

2. ڈیریچلیٹ کی تقسیم

۔ ڈیریچلیٹ کی تقسیم ایک سے زیادہ نتائج کے لیے بیٹا ڈسٹری بیوشن کو عام کرنا ہے (یا دوسرے لفظوں میں یہ متعدد نتائج والے واقعات کے لیے استعمال ہوتا ہے)۔ یہ k پیرامیٹرز a کے ساتھ پیرامیٹرائزڈ ہے۔i جو کہ مثبت ہونا چاہیے۔ Dirichlet تقسیم بیٹا تقسیم کے برابر ہوتی ہے جب متغیر کی تعداد k = 2 ہو۔

شکل 2: مختلف a کے لیے Dirichlet کی تقسیمi پیرامیٹرز

ڈیریچلیٹ ڈسٹری بیوشن کا استعمال عام طور پر احتمالات پر تقسیم کو ماڈل کرنے کے لیے کیا جاتا ہے اور اس میں مندرجہ ذیل امکانی کثافت ہوتی ہے:

![]()

مساوات 2: ڈیریچلیٹ پی ڈی ایف

جہاں Γ(x) گاما فنکشن ہے، pi قدریں [0,1] اور Σp میں لیں۔i=1۔ ڈیریچلیٹ ڈسٹری بیوشن ماڈل پی کی مشترکہ تقسیم کو پیش کرتا ہے۔i اور P کا امکان فراہم کرتا ہے۔1=p1,P2=p2،….، پیk-1۔=pk-1۔ پی کے ساتھk=1 – ΣPi. جیسا کہ بیٹا کے معاملے میں، ai پیرامیٹرز کو ہر i ایونٹ کی ظاہری شکل کے سیوڈکاؤنٹس کے طور پر سمجھا جا سکتا ہے۔ Dirichlet کی تقسیم کا استعمال k حریف واقعات کے وقوع پذیر ہونے کے امکان کو ماڈل کرنے کے لیے کیا جاتا ہے اور اسے اکثر Dirichlet(a) کے نام سے تعبیر کیا جاتا ہے۔

3. Dirichlet Prior with Multinomial Liquid

جیسا کہ پہلے ذکر کیا گیا ہے ڈیریچلیٹ تقسیم کو امکانی تقسیم پر تقسیم کے طور پر دیکھا جا سکتا ہے۔ ایسی صورتوں میں جہاں ہم k واقعات کے وقوع پذیر ہونے کے امکان کا نمونہ بنانا چاہتے ہیں، ایک Bayesian نقطہ نظر استعمال کرنا ہوگا۔ کثیر الثانی امکان اور ڈیریچلیٹ پرائرز .

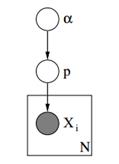

ذیل میں ہم ایسے ماڈل کا گرافیکل ماڈل دیکھ سکتے ہیں۔

شکل 3: کثیر امکان کے ساتھ ڈیریچلیٹ پرائرس کا گرافیکل ماڈل

مندرجہ بالا گرافیکل ماڈل میں، α ایک جہتی ویکٹر ہے جس میں Dirichlet priors کے ہائپر پیرامیٹر ہیں، p امکانی اقدار اور x کے ساتھ ak جہتی ویکٹر ہے۔i 1 سے k تک ایک اسکیلر ویلیو ہے جو ہمیں بتاتی ہے کہ کون سا واقعہ پیش آیا ہے۔ آخر میں ہمیں یہ نوٹ کرنا چاہئے کہ P ویکٹر α کے ساتھ ڈیریچلیٹ کی تقسیم کے پیرامیٹرائزڈ کی پیروی کرتا ہے اور اس طرح P ~ Dirichlet(α)، جبکہ xi متغیرات ڈسکریٹ ڈسٹری بیوشن کی پیروی کرتے ہیں (متعدد) پیرامیٹرائزڈ امکانات کے p ویکٹر کے ساتھ۔ مختلف عنوانات میں مطلوبہ الفاظ کی تعدد کی تقسیم کی نمائندگی کرنے کے لیے اسی طرح کے درجہ بندی کے ماڈلز کو دستاویز کی درجہ بندی میں استعمال کیا جا سکتا ہے۔

4. ڈیریچلیٹ ڈسٹری بیوشن کے ساتھ فائنائٹ مکسچر ماڈل

ڈیریچلیٹ ڈسٹری بیوشن کا استعمال کرکے ہم ایک بنا سکتے ہیں۔ فائنائٹ مکسچر ماڈل جو کلسٹرنگ کو انجام دینے کے لیے استعمال کیا جا سکتا ہے۔ آئیے فرض کریں کہ ہمارے پاس مندرجہ ذیل ماڈل ہے:

![]()

![]()

![]()

![]()

مساوات 3: ڈیریچلیٹ ڈسٹری بیوشن کے ساتھ فائنائٹ مکسچر ماڈل

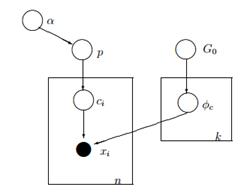

مندرجہ بالا ماڈل مندرجہ ذیل کو فرض کرتا ہے: ہمارے پاس n مشاہدات کے ساتھ ڈیٹا سیٹ X ہے اور ہم اس پر کلسٹر تجزیہ کرنا چاہتے ہیں۔ k ایک مستقل محدود نمبر ہے جو کلسٹرز/اجزاء کی تعداد کو ظاہر کرتا ہے جو ہم استعمال کریں گے۔ سیi متغیر مشاہدے X کے کلسٹر اسائنمنٹ کو محفوظ کرتے ہیں۔i، وہ 1 سے k تک کی قدریں لیتے ہیں اور پیرامیٹر p کے ساتھ ڈسکریٹ ڈسٹری بیوشن کی پیروی کرتے ہیں جو اجزاء کے مرکب امکانات ہیں۔ F ہمارے X کی تخلیقی تقسیم ہے اور اسے پیرامیٹر کے ساتھ پیرامیٹرائز کیا جاتا ہے۔ ![]() جو ہر مشاہدے کے کلسٹر تفویض پر منحصر ہے۔ مجموعی طور پر ہمارے پاس k منفرد ہے۔

جو ہر مشاہدے کے کلسٹر تفویض پر منحصر ہے۔ مجموعی طور پر ہمارے پاس k منفرد ہے۔ ![]() ہمارے کلسٹرز کی تعداد کے برابر پیرامیٹرز۔ دی

ہمارے کلسٹرز کی تعداد کے برابر پیرامیٹرز۔ دی ![]() متغیر ان پیرامیٹرز کو اسٹور کرتا ہے جو جنریٹو F ڈسٹری بیوشن کو پیرامیٹرائز کرتے ہیں اور ہم فرض کرتے ہیں کہ یہ بیس G کی پیروی کرتا ہے۔0 تقسیم p متغیر k کلسٹرز میں سے ہر ایک کے لیے مرکب فیصد کو ذخیرہ کرتا ہے اور پیرامیٹرز α/k کے ساتھ ڈیریچلیٹ کی پیروی کرتا ہے۔ آخر میں α ایک جہتی ویکٹر ہے جس میں Dirichlet کی تقسیم کے ہائپر پیرامیٹر (pseudocounts) ہیں [2]۔

متغیر ان پیرامیٹرز کو اسٹور کرتا ہے جو جنریٹو F ڈسٹری بیوشن کو پیرامیٹرائز کرتے ہیں اور ہم فرض کرتے ہیں کہ یہ بیس G کی پیروی کرتا ہے۔0 تقسیم p متغیر k کلسٹرز میں سے ہر ایک کے لیے مرکب فیصد کو ذخیرہ کرتا ہے اور پیرامیٹرز α/k کے ساتھ ڈیریچلیٹ کی پیروی کرتا ہے۔ آخر میں α ایک جہتی ویکٹر ہے جس میں Dirichlet کی تقسیم کے ہائپر پیرامیٹر (pseudocounts) ہیں [2]۔

شکل 4: ڈیریچلیٹ ڈسٹری بیوشن کے ساتھ فائنائٹ مکسچر ماڈل کا گرافیکل ماڈل

ماڈل کی وضاحت کرنے کا ایک آسان اور کم ریاضیاتی طریقہ درج ذیل ہے۔ ہم فرض کرتے ہیں کہ ہمارے ڈیٹا کو k کلسٹرز میں گروپ کیا جا سکتا ہے۔ ہر کلسٹر کے اپنے پیرامیٹرز ہوتے ہیں۔ ![]() اور وہ پیرامیٹرز ہمارے ڈیٹا کو بنانے کے لیے استعمال کیے جاتے ہیں۔ پیرامیٹرز

اور وہ پیرامیٹرز ہمارے ڈیٹا کو بنانے کے لیے استعمال کیے جاتے ہیں۔ پیرامیٹرز ![]() فرض کیا جاتا ہے کہ وہ کچھ تقسیم G کی پیروی کرتے ہیں۔0. ہر مشاہدے کو ویکٹر x کے ساتھ دکھایا جاتا ہے۔i اور aci قدر جو اس کلسٹر کی نشاندہی کرتی ہے جس سے اس کا تعلق ہے۔ اس کے نتیجے میں ci ایک متغیر کے طور پر دیکھا جا سکتا ہے جو ڈسکریٹ ڈسٹری بیوشن کو پیرامیٹر پی کے ساتھ فالو کرتا ہے جو کہ مرکب امکانات کے علاوہ کچھ نہیں ہے، یعنی ہر کلسٹر کے ہونے کا امکان۔ یہ دیکھتے ہوئے کہ ہم اپنے مسئلے کو بایسیئن طریقے سے ہینڈل کرتے ہیں، ہم پیرامیٹر p کو ایک مستقل نامعلوم ویکٹر نہیں مانتے ہیں۔ اس کے بجائے ہم فرض کرتے ہیں کہ P Dirichlet کی پیروی کرتا ہے جسے ہائپر پیرامیٹر α/k کے ذریعہ پیرامیٹرائز کیا جاتا ہے۔

فرض کیا جاتا ہے کہ وہ کچھ تقسیم G کی پیروی کرتے ہیں۔0. ہر مشاہدے کو ویکٹر x کے ساتھ دکھایا جاتا ہے۔i اور aci قدر جو اس کلسٹر کی نشاندہی کرتی ہے جس سے اس کا تعلق ہے۔ اس کے نتیجے میں ci ایک متغیر کے طور پر دیکھا جا سکتا ہے جو ڈسکریٹ ڈسٹری بیوشن کو پیرامیٹر پی کے ساتھ فالو کرتا ہے جو کہ مرکب امکانات کے علاوہ کچھ نہیں ہے، یعنی ہر کلسٹر کے ہونے کا امکان۔ یہ دیکھتے ہوئے کہ ہم اپنے مسئلے کو بایسیئن طریقے سے ہینڈل کرتے ہیں، ہم پیرامیٹر p کو ایک مستقل نامعلوم ویکٹر نہیں مانتے ہیں۔ اس کے بجائے ہم فرض کرتے ہیں کہ P Dirichlet کی پیروی کرتا ہے جسے ہائپر پیرامیٹر α/k کے ذریعہ پیرامیٹرائز کیا جاتا ہے۔

5. لامحدود کے کلسٹرز کے ساتھ کام کرنا

پچھلا مرکب ماڈل ہمیں بغیر نگرانی کے سیکھنے کو انجام دینے کی اجازت دیتا ہے، ایک Bayesian اپروچ کی پیروی کرتا ہے اور اسے ایک درجہ بندی کی ساخت کے لیے بڑھایا جا سکتا ہے۔ اس کے باوجود یہ ایک محدود ماڈل ہے کیونکہ یہ کلسٹرز کی ایک مستقل پہلے سے طے شدہ k تعداد کا استعمال کرتا ہے۔ نتیجے کے طور پر ہم سے کلسٹر تجزیہ کرنے سے پہلے اجزاء کی تعداد کی وضاحت کرنے کی ضرورت ہوتی ہے اور جیسا کہ ہم نے پہلے زیادہ تر ایپلی کیشنز میں بات کی ہے یہ نامعلوم ہے اور آسانی سے اندازہ نہیں لگایا جا سکتا۔

اس کو حل کرنے کا ایک طریقہ یہ تصور کرنا ہے کہ k کی ایک بہت بڑی قدر ہے جو لامحدودیت کی طرف مائل ہے۔ دوسرے لفظوں میں ہم اس ماڈل کی حد کا تصور کر سکتے ہیں جب k لامحدودیت کی طرف مائل ہوتا ہے۔ اگر ایسا ہے، تو ہم دیکھ سکتے ہیں کہ اس کے باوجود کہ کلسٹرز کی تعداد لامحدود ہے، کلسٹرز کی اصل تعداد جو فعال ہیں (وہ جن میں کم از کم ایک مشاہدہ ہے)، n سے بڑا نہیں ہو سکتا (جو ہے ہمارے ڈیٹاسیٹ میں مشاہدات کی کل تعداد)۔ درحقیقت جیسا کہ ہم بعد میں دیکھیں گے، فعال کلسٹرز کی تعداد n سے نمایاں طور پر کم ہوگی اور وہ متناسب ہوں گے۔ ![]() .

.

یقینا k کی حد کو لامحدود تک لے جانا غیر معمولی بات ہے۔ کئی سوالات اٹھتے ہیں جیسے کہ کیا اس حد کو لینا ممکن ہے، یہ ماڈل کیسا نظر آئے گا اور ہم کیسے تعمیر کر سکتے ہیں اور ایسا ماڈل استعمال کریں۔

اگلے مضمون میں ہم بالکل ان سوالات پر توجہ مرکوز کریں گے: ہم ڈیریچلیٹ کے عمل کی وضاحت کریں گے، ہم ڈی پی کی مختلف نمائندگییں پیش کریں گے اور آخر میں ہم چینی ریستوراں کے عمل پر توجہ مرکوز کریں گے جو کہ ڈیریچلیٹ عمل کی تعمیر کا ایک بدیہی اور موثر طریقہ ہے۔

مجھے امید ہے کہ آپ کو یہ پوسٹ مفید لگی۔ اگر آپ نے ایسا کیا ہے تو براہ کرم مضمون کو فیس بک اور ٹویٹر پر شیئر کرنے کے لیے تھوڑا وقت نکالیں۔ 🙂

- AI

- ai آرٹ

- AI آرٹ جنریٹر

- عی روبوٹ

- مصنوعی ذہانت

- مصنوعی ذہانت کا سرٹیفیکیشن

- مصنوعی ذہانت والا روبوٹ

- مصنوعی ذہانت والے روبوٹ

- مصنوعی ذہانت سافٹ ویئر

- blockchain

- بلاکچین کانفرنس

- coingenius

- بات چیت مصنوعی ذہانت

- crypto کانفرنس ai

- dall-e

- ڈیٹا باکس

- گہری سیکھنے

- گوگل عی

- مشین لرننگ

- مشین لرننگ اور شماریات

- پلاٹا

- افلاطون اے

- افلاطون ڈیٹا انٹیلی جنس

- افلاطون گیم

- پلیٹو ڈیٹا

- پلیٹو گیمنگ

- پیمانہ ai

- نحو

- زیفیرنیٹ