سلسلہ بندی کی متحرک دنیا میں ایمیزون موسیقیگانا، پوڈ کاسٹ، یا پلے لسٹ کی ہر تلاش میں ایک کہانی، ایک موڈ، یا جذبات کا سیلاب ہوتا ہے جو منظر عام پر آنے کا انتظار کرتا ہے۔ یہ تلاشیں نئی دریافتوں، پیارے تجربات، اور دیرپا یادوں کے لیے ایک گیٹ وے کا کام کرتی ہیں۔ سرچ بار صرف گانا تلاش کرنے کے بارے میں نہیں ہے۔ یہ ان لاکھوں فعال صارفین کے بارے میں ہے جو امیر اور متنوع دنیا میں اپنا ذاتی سفر شروع کر رہے ہیں جسے ایمیزون میوزک نے پیش کیا ہے۔

صارفین جس موسیقی کی تلاش کرتے ہیں اسے فوری طور پر تلاش کرنے کے لیے ایک اعلیٰ کسٹمر کا تجربہ فراہم کرنے کے لیے ایک ایسے پلیٹ فارم کی ضرورت ہوتی ہے جو ہوشیار اور جوابدہ ہو۔ Amazon Music اس کو پورا کرنے کے لیے AI کی طاقت کا استعمال کرتا ہے۔ تاہم، ٹریننگ کی لاگت اور AI ماڈلز کے تخمینے کا انتظام کرتے ہوئے کسٹمر کے تجربے کو بہتر بنانا جو سرچ بار کی صلاحیتوں کو تقویت دیتے ہیں، جیسے ریئل ٹائم اسپیل چیک اور ویکٹر کی تلاش، ٹریفک کے زیادہ اوقات میں مشکل ہے۔

ایمیزون سیج میکر خدمات کا ایک اختتام سے آخر تک سیٹ فراہم کرتا ہے جو ایمیزون میوزک کو کم سے کم کوشش کے ساتھ AWS کلاؤڈ پر تعمیر، تربیت اور تعینات کرنے کی اجازت دیتا ہے۔ غیر متفاوت ہیوی لفٹنگ کا خیال رکھ کر، SageMaker آپ کو اپنے مشین لرننگ (ML) ماڈلز پر کام کرنے پر توجہ مرکوز کرنے کی اجازت دیتا ہے، اور انفراسٹرکچر جیسی چیزوں کی فکر نہ کریں۔ مشترکہ ذمہ داری کے ماڈل کے حصے کے طور پر، SageMaker اس بات کو یقینی بناتا ہے کہ وہ جو خدمات فراہم کرتے ہیں وہ قابل اعتماد، پرفارمنس اور توسیع پذیر ہیں، جب کہ آپ اس بات کو یقینی بناتے ہیں کہ ML ماڈلز کا اطلاق ان صلاحیتوں کا بہترین استعمال کرتا ہے جو SageMaker فراہم کرتی ہے۔

اس پوسٹ میں، ہم ایمیزون میوزک نے SageMaker اور NVIDIA Triton Inference Server اور TensorRT کا استعمال کرتے ہوئے کارکردگی اور لاگت کو بہتر بنانے کے لیے کیے گئے سفر پر چلتے ہیں۔ ہم یہ ظاہر کرنے میں گہرائی میں ڈوبتے ہیں کہ بظاہر سادہ، لیکن پیچیدہ، سرچ بار کیسے کام کرتا ہے، جس سے Amazon Music کی کائنات میں تھوڑی سے صفر مایوس کن ٹائپو تاخیر اور متعلقہ حقیقی وقت کے تلاش کے نتائج کے ساتھ ایک غیر منقطع سفر کو یقینی بنایا جاتا ہے۔

Amazon SageMaker اور NVIDIA: تیز اور درست ویکٹر کی تلاش اور اسپیل چیک کی صلاحیتوں کی فراہمی

ایمیزون میوزک 100 ملین سے زیادہ گانوں اور لاکھوں پوڈ کاسٹ اقساط کی ایک وسیع لائبریری پیش کرتا ہے۔ تاہم، صحیح گانا یا پوڈ کاسٹ تلاش کرنا مشکل ہو سکتا ہے، خاص طور پر اگر آپ صحیح عنوان، فنکار، یا البم کا نام نہیں جانتے ہیں، یا تلاش کردہ استفسار بہت وسیع ہے، جیسے "نیوز پوڈ کاسٹ"۔

Amazon Music نے تلاش اور بازیافت کے عمل کو بہتر بنانے کے لیے دو جہتی طریقہ اختیار کیا ہے۔ پہلا قدم یہ ہے کہ ویکٹر سرچ (جسے ایمبیڈنگ پر مبنی بازیافت بھی کہا جاتا ہے) متعارف کرایا جائے، ایک ML تکنیک جو صارفین کو سب سے زیادہ متعلقہ مواد تلاش کرنے میں مدد کر سکتی ہے جسے وہ مواد کے سیمنٹکس کا استعمال کر کے تلاش کر رہے ہیں۔ دوسرے مرحلے میں سرچ اسٹیک میں ٹرانسفارمر پر مبنی ہجے کی اصلاح کا ماڈل متعارف کرانا شامل ہے۔ موسیقی کی تلاش کے دوران یہ خاص طور پر مددگار ثابت ہو سکتا ہے، کیونکہ ہو سکتا ہے صارفین کو ہمیشہ گانے کے عنوان یا فنکار کے نام کی صحیح ہجے معلوم نہ ہو۔ املا درست کرنے سے صارفین کو وہ موسیقی تلاش کرنے میں مدد مل سکتی ہے جس کی وہ تلاش کر رہے ہیں چاہے وہ اپنی تلاش کے استفسار میں ہجے کی غلطی کریں۔

تلاش اور بازیافت پائپ لائن میں ٹرانسفارمر ماڈلز کا تعارف (ویکٹر کی تلاش کے لیے درکار استفسار ایمبیڈنگ جنریشن میں اور ہجے کی تصحیح میں جنریٹو Seq2Seq ٹرانسفارمر ماڈل) مجموعی تاخیر میں نمایاں اضافہ کا باعث بن سکتا ہے، جس سے صارفین کے تجربے پر منفی اثر پڑتا ہے۔ اس لیے، ویکٹر کی تلاش اور املا درست کرنے والے ماڈلز کے لیے اصل وقت کے تخمینے میں تاخیر کو بہتر بنانا ہمارے لیے اولین ترجیح بن گیا۔

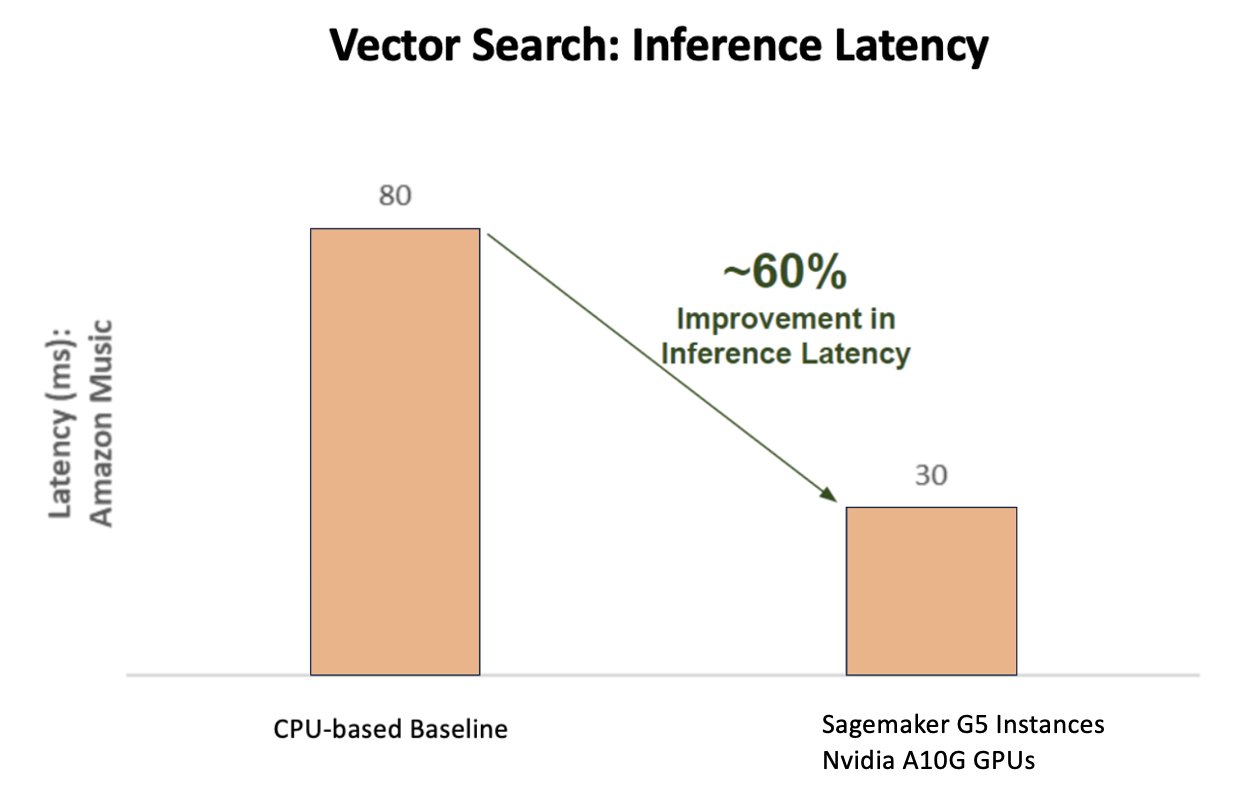

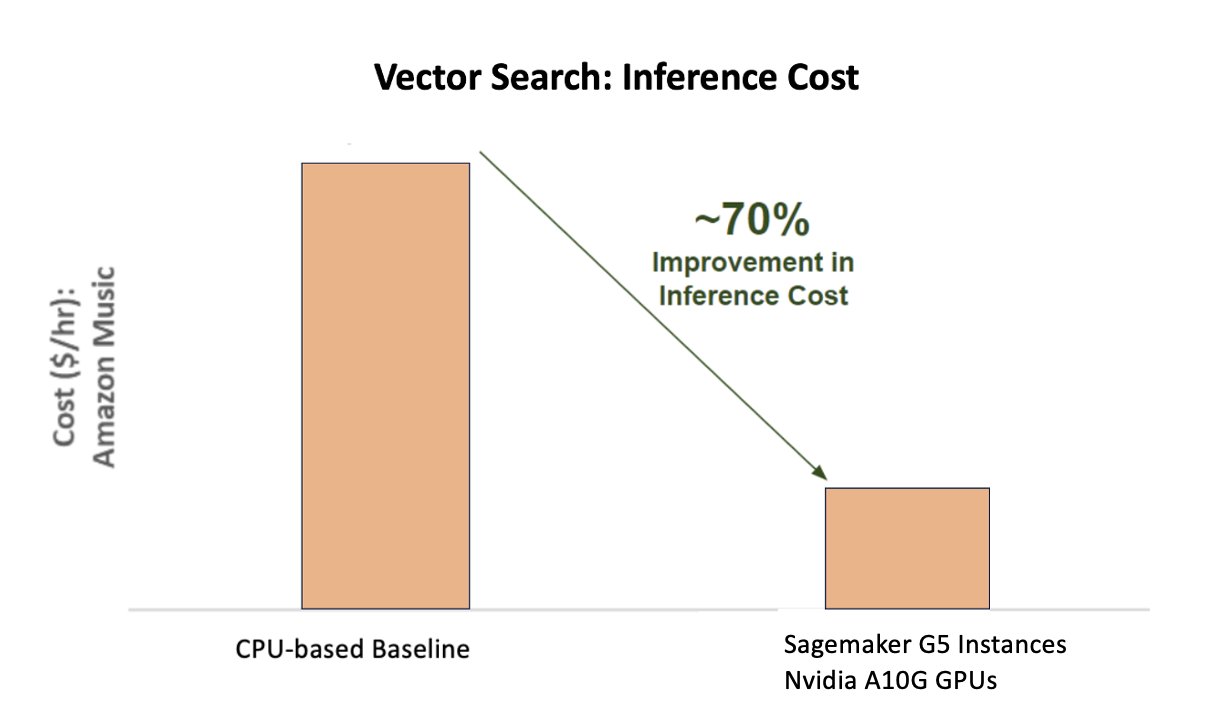

Amazon Music اور NVIDIA اکٹھے ہوئے ہیں تاکہ تلاش کے بار میں بہترین ممکنہ کسٹمر کا تجربہ پیش کیا جا سکے، SageMaker کا استعمال کرتے ہوئے تیز اور درست املا چیک کرنے کی صلاحیتوں اور ویکٹر تلاش پر مبنی تکنیکوں کا استعمال کرتے ہوئے حقیقی وقت میں سیمنٹک تلاش کی تجاویز دونوں کو نافذ کیا جائے۔ حل میں G5 مثالوں سے چلنے والی SageMaker ہوسٹنگ کا استعمال شامل ہے جو NVIDIA A10G Tensor Core GPUs، SageMaker کی حمایت یافتہ NVIDIA Triton Inference Server Container، اور NVIDIA TensorRT ماڈل کی شکل. اسپیل چیک ماڈل کی قیاس میں تاخیر کو چوٹی ٹریفک میں 25 ملی سیکنڈ تک کم کر کے، اور تلاش کے استفسار پر ایمبیڈنگ جنریشن لیٹینسی کو اوسطاً 63% کم کر کے اور CPU پر مبنی انفرنس کے مقابلے میں لاگت میں 73% کمی کر کے، Amazon Music نے سرچ بار کی کارکردگی کو بلند کر دیا ہے۔

مزید برآں، درست نتائج فراہم کرنے کے لیے AI ماڈل کی تربیت کرتے وقت، Amazon Music نے اپنے BART sequence-to-sequence ہجے درست کرنے والے ٹرانسفارمر ماڈل کے لیے تربیتی وقت میں 12 گنا تیز رفتاری حاصل کی، جس سے ان کے GPU کے استعمال کو بہتر بنا کر، وقت اور رقم دونوں کی بچت ہوئی۔

Amazon Music نے NVIDIA کے ساتھ شراکت داری کی تاکہ گاہک کی تلاش کے تجربے کو ترجیح دی جا سکے اور اچھی طرح سے اصلاح شدہ اسپیل چیک اور ویکٹر تلاش کی خصوصیات کے ساتھ ایک سرچ بار تیار کیا جا سکے۔ مندرجہ ذیل حصوں میں، ہم اس بارے میں مزید اشتراک کرتے ہیں کہ ان اصلاحات کو کس طرح ترتیب دیا گیا تھا۔

NVIDIA Tensor Core GPUs کے ساتھ تربیت کو بہتر بنانا

بڑی زبان کے ماڈل کی تربیت کے لیے NVIDIA Tensor Core GPU تک رسائی حاصل کرنا اس کی حقیقی صلاحیت کو حاصل کرنے کے لیے کافی نہیں ہے۔ جی پی یو کے استعمال کو مکمل طور پر زیادہ سے زیادہ کرنے کے لیے تربیت کے دوران اصلاح کے کلیدی اقدامات ہوتے ہیں۔ تاہم، ایک کم استعمال شدہ GPU بلاشبہ وسائل کے غیر موثر استعمال، تربیت کے طویل دورانیے، اور آپریشنل اخراجات میں اضافے کا باعث بنے گا۔

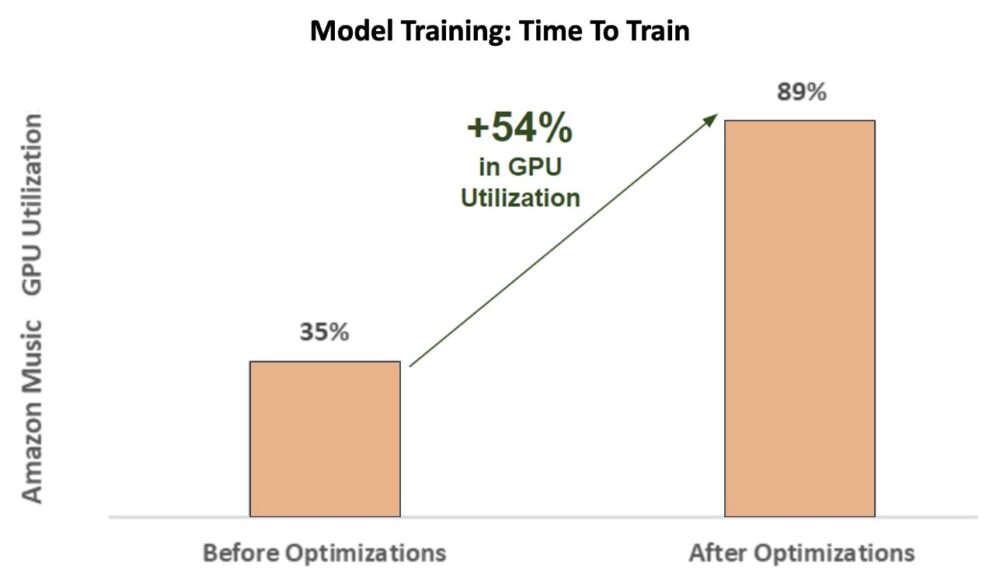

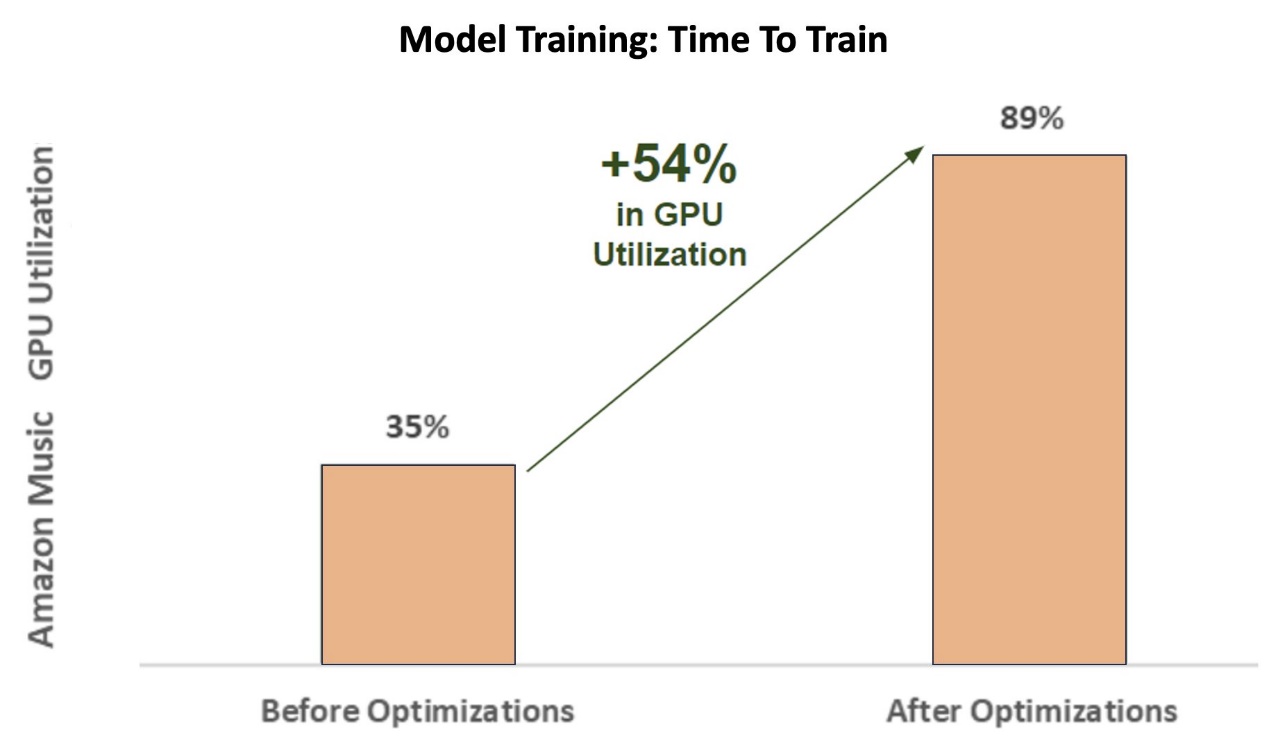

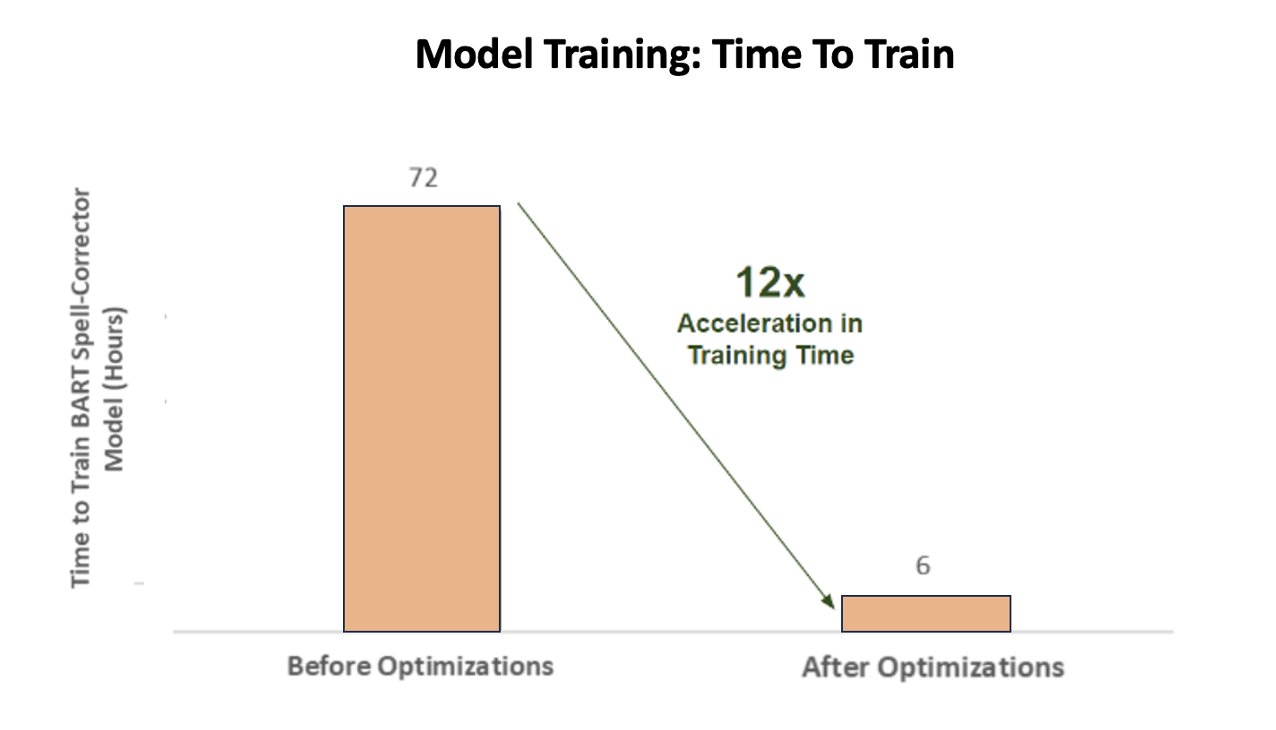

تربیت کے ابتدائی مراحل کے دوران ہجے درست کرنے والا BART (بارٹ بیس) SageMaker ml.p3.24xlarge مثال (8 NVIDIA V100 Tensor Core GPUs) پر ٹرانسفارمر ماڈل، Amazon Music کا GPU استعمال تقریباً 35% تھا۔ NVIDIA GPU- ایکسلریٹڈ ٹریننگ کے فوائد کو زیادہ سے زیادہ کرنے کے لیے، AWS اور NVIDIA سلوشن آرکیٹیکٹس نے امیزون میوزک کو آپٹیمائزیشن کے لیے علاقوں کی نشاندہی کرنے میں مدد کی، خاص طور پر بیچ کے سائز اور درستگی کے پیرامیٹرز کے ارد گرد۔ یہ دو اہم پیرامیٹرز گہری سیکھنے کے ماڈلز کی تربیت کی کارکردگی، رفتار اور درستگی کو متاثر کرتے ہیں۔

نتیجے میں ہونے والی اصلاح سے ایک نیا اور بہتر V100 GPU استعمال ہوا، جو تقریباً 89% پر مستحکم ہے، جس سے Amazon Music کے تربیتی وقت کو 3 دن سے 5-6 گھنٹے تک کم کر دیا گیا۔ بیچ کے سائز کو 32 سے 256 میں تبدیل کرکے اور چلانے جیسی اصلاح کی تکنیکوں کا استعمال کرکے خودکار مخلوط صحت سے متعلق تربیت صرف FP32 درستگی استعمال کرنے کے بجائے، Amazon Music وقت اور پیسہ دونوں بچانے میں کامیاب رہا۔

مندرجہ ذیل چارٹ آپٹیمائزیشن کے بعد GPU کے استعمال میں 54 فیصد فیصد اضافے کی وضاحت کرتا ہے۔

مندرجہ ذیل اعداد و شمار تربیت کے وقت میں تیزی کو واضح کرتا ہے۔

بیچ کے سائز میں اس اضافے نے NVIDIA GPU کو ایک سے زیادہ Tensor Cores میں بیک وقت نمایاں طور پر زیادہ ڈیٹا پر کارروائی کرنے کے قابل بنایا، جس کے نتیجے میں تربیت کا وقت تیز ہوتا ہے۔ تاہم، میموری کے ساتھ ایک نازک توازن برقرار رکھنا ضروری ہے، کیونکہ بڑے بیچ کے سائز زیادہ میموری کا مطالبہ کرتے ہیں۔ NVIDIA Tensor Core GPUs کی طاقت کو غیر مقفل کرنے میں بیچ کے سائز میں اضافہ اور مخلوط درستگی کا استعمال دونوں ہی اہم ہو سکتے ہیں۔

ماڈل کو کنورجنسی کی تربیت حاصل کرنے کے بعد، یہ Amazon Music کے سرچ بار پر انفرنس کی تعیناتی کے لیے بہتر بنانے کا وقت تھا۔

املا کی تصحیح: BART ماڈل کا اندازہ لگانا

SageMaker G5 مثالوں اور NVIDIA Triton Inference Server (ایک اوپن سورس انفرنس سرونگ سافٹ ویئر) کی مدد سے، نیز NVIDIA TensorRT، اعلی کارکردگی والے گہرے سیکھنے کے تخمینے کے لیے ایک SDK جس میں انفرنس آپٹیمائزر اور رن ٹائم شامل ہے، Amazon Music ان کی سپیل چیک BART کو محدود کرتا ہے۔ (بارٹ بیس) چوٹی ٹریفک میں صرف 25 ملی سیکنڈ تک ماڈل سرور کا اندازہ لگانے میں تاخیر۔ اس میں اوور ہیڈز جیسے لوڈ بیلنسنگ، پری پروسیسنگ، ماڈل انفرنسنگ، اور پوسٹ پروسیسنگ ٹائمز شامل ہیں۔

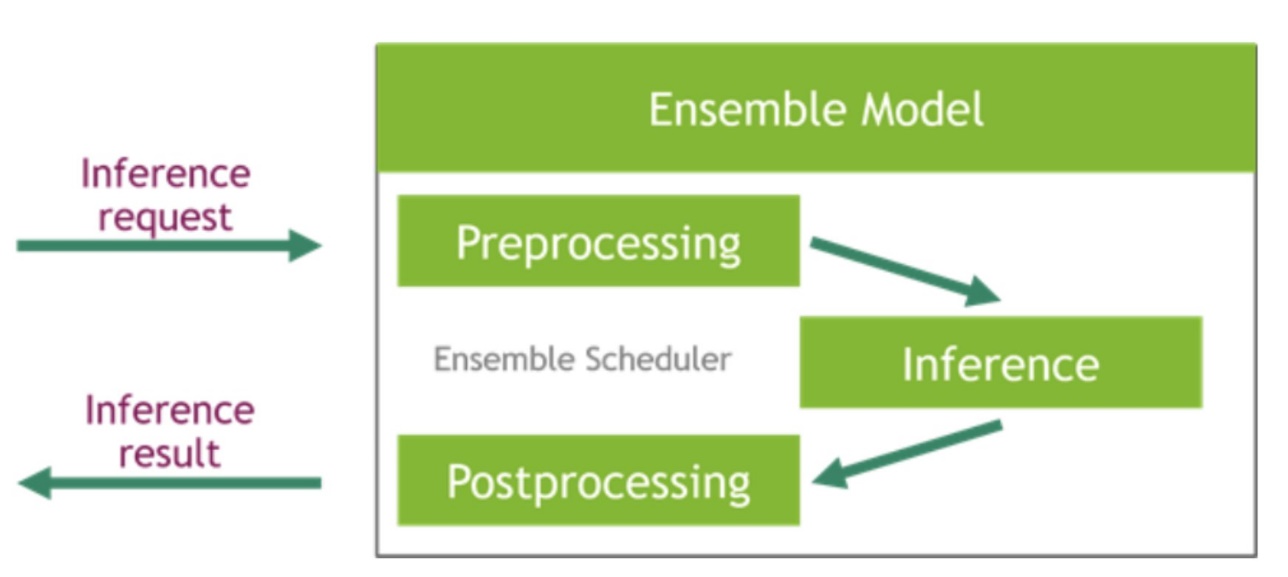

NVIDIA Triton Inference Server دو مختلف قسم کے بیک اینڈز فراہم کرتا ہے: ایک GPU پر ماڈلز کی میزبانی کے لیے، اور ایک Python بیک اینڈ جہاں آپ پری پروسیسنگ اور پوسٹ پروسیسنگ کے مراحل میں استعمال ہونے کے لیے اپنا ذاتی کوڈ لا سکتے ہیں۔ مندرجہ ذیل اعداد و شمار کی وضاحت کرتا ہے ماڈل جوڑ سکیم.

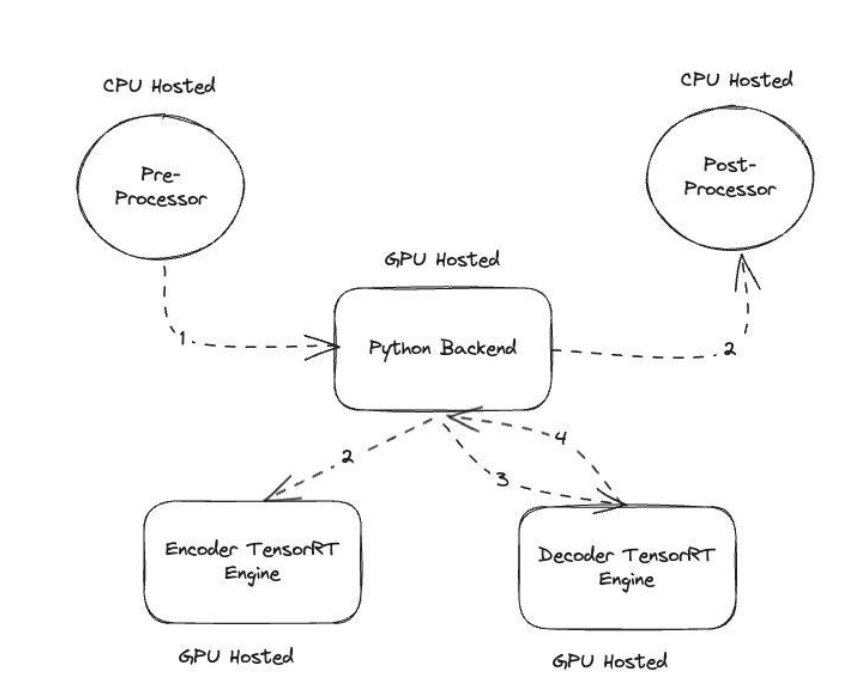

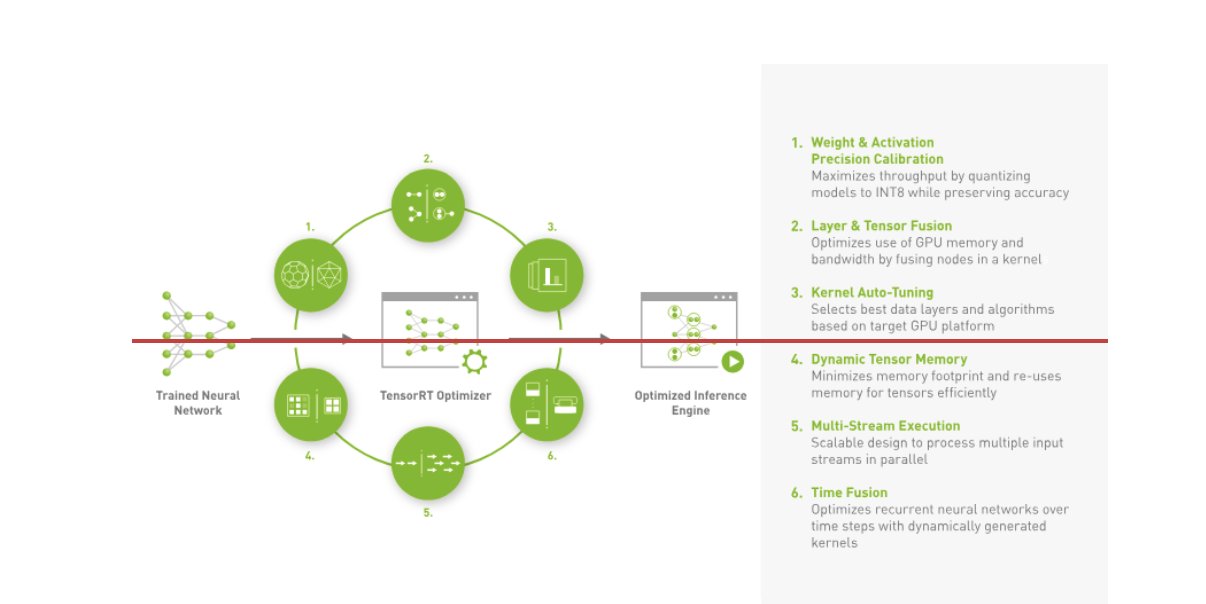

ایمیزون میوزک نے اپنا BART بنایا انفرنس پائپ لائن CPUs پر پری پروسیسنگ (ٹیکسٹ ٹوکنائزیشن) اور پوسٹ پروسیسنگ (ٹوکن ٹو ٹیکسٹ) دونوں مراحل چلا کر، جبکہ ماڈل پر عمل درآمد کا مرحلہ چلتا ہے۔ NVIDIA A10G ٹینسر کور GPUs. ایک ازگر کا بیک اینڈ پری پروسیسنگ اور پوسٹ پروسیسنگ کے مراحل کے بیچ میں بیٹھتا ہے، اور TensorRT سے تبدیل شدہ BART ماڈلز کے ساتھ ساتھ انکوڈر/ڈیکوڈر نیٹ ورکس کے ساتھ بات چیت کرنے کا ذمہ دار ہے۔ TensorRT درست کیلیبریشن، پرت اور ٹینسر فیوژن، کرنل آٹو ٹیوننگ، ڈائنامک ٹینسر میموری، ملٹی اسٹریم ایگزیکیوشن، اور ٹائم فیوژن کے ساتھ انفرنس کی کارکردگی کو بڑھاتا ہے۔

مندرجہ ذیل اعداد و شمار کلیدی ماڈیولز کے اعلیٰ سطحی ڈیزائن کی وضاحت کرتا ہے جو ہجے درست کرنے والے BART ماڈل کی انفرنسنگ پائپ لائن بناتے ہیں۔

ویکٹر کی تلاش: استفسار ایمبیڈنگ جنریشن جملے BERT ماڈل انفرنسنگ

مندرجہ ذیل چارٹ CPU پر مبنی بیس لائن کے مقابلے NVIDIA AI انفرنس پلیٹ فارم کا استعمال کرتے وقت تاخیر (p60 90–800 TPS کی خدمت) میں 900% بہتری کی وضاحت کرتا ہے۔

مندرجہ ذیل چارٹ CPU پر مبنی بیس لائن کے مقابلے NVIDIA AI انفرنس پلیٹ فارم استعمال کرتے وقت لاگت میں 70% بہتری دکھاتا ہے۔

مندرجہ ذیل اعداد و شمار اعلی کارکردگی کے گہرے سیکھنے کے تخمینے کے لیے SDK کی وضاحت کرتا ہے۔ اس میں گہرا سیکھنے کا اندازہ لگانے والا اور رن ٹائم شامل ہے جو قیاس کی ایپلی کیشنز کے لیے کم تاخیر اور اعلی تھرو پٹ فراہم کرتا ہے۔

ان نتائج کو حاصل کرنے کے لیے، ایمیزون میوزک نے کئی مختلف ٹریٹن تعیناتی پیرامیٹرز کا استعمال کرتے ہوئے تجربہ کیا۔ ٹریٹن ماڈل تجزیہ کار، ایک ایسا ٹول جو موثر اندازہ لگانے کے لیے بہترین NVIDIA Triton ماڈل کنفیگریشن تلاش کرنے میں مدد کرتا ہے۔ ماڈل کے تخمینے کو بہتر بنانے کے لیے، ٹرائٹن متحرک بیچنگ اور کنکرنٹ ماڈل پر عملدرآمد جیسی خصوصیات پیش کرتا ہے، اور دیگر لچکدار صلاحیتوں کے لیے فریم ورک سپورٹ رکھتا ہے۔ متحرک بیچنگ انفرنس کی درخواستوں کو اکٹھا کرتی ہے، بغیر کسی رکاوٹ کے ان کو ایک ساتھ گروپ بناتی ہے تاکہ تھرو پٹ کو زیادہ سے زیادہ حاصل کیا جا سکے، یہ سب کچھ Amazon Music کے صارفین کے لیے حقیقی وقت کے ردعمل کو یقینی بناتے ہوئے ہوتا ہے۔ سمورتی ماڈل پر عمل درآمد کی صلاحیت ایک ہی GPU پر ماڈل کی متعدد کاپیوں کی میزبانی کرکے انفرنس کارکردگی کو مزید بڑھاتی ہے۔ آخر میں، استعمال کرتے ہوئے ٹریٹن ماڈل تجزیہ کار، ایمیزون میوزک متحرک بیچنگ اور ماڈل کنکرنسی انفرنس ہوسٹنگ پیرامیٹرز کو احتیاط سے ٹھیک کرنے میں کامیاب رہا تاکہ بہترین سیٹنگیں تلاش کی جا سکیں جو نقلی ٹریفک کا استعمال کرتے ہوئے انفرنس کی کارکردگی کو زیادہ سے زیادہ کرتی ہیں۔

نتیجہ

SageMaker پر Triton Inference Server اور TensorRT کے ساتھ کنفیگریشنز کو بہتر بنانے سے Amazon Music کو ٹریننگ اور انفرنس پائپ لائنز دونوں کے لیے شاندار نتائج حاصل کرنے کا موقع ملا۔ سیج میکر پلیٹ فارم AI پروڈکشن کے لیے آخر سے آخر تک کھلا پلیٹ فارم ہے، جو کہ قدر کے لیے فوری وقت اور ہارڈ ویئر اور سافٹ ویئر دونوں میں AI کے استعمال کے تمام بڑے کیسز کو سپورٹ کرنے کے لیے استعداد فراہم کرتا ہے۔ تربیت کے لیے V100 GPU کے استعمال کو بہتر بنا کر اور NVIDIA A5G Tensor Core GPUs کا استعمال کرتے ہوئے CPUs سے G10 مثالوں میں سوئچ کرنے کے ساتھ ساتھ آپٹمائزڈ NVIDIA سافٹ ویئر جیسے Triton Inference Server اور TensorRT کا استعمال کر کے، Amazon Music جیسی کمپنیاں کارکردگی کو بڑھاتے ہوئے وقت اور پیسہ بچا سکتی ہیں۔ تربیت اور تخمینہ، براہ راست کسٹمر کے بہتر تجربے اور کم آپریٹنگ لاگت کا ترجمہ کرنا۔

SageMaker ML ٹریننگ اور ہوسٹنگ کے لیے غیر متفاوت ہیوی لفٹنگ کو ہینڈل کرتا ہے، جس سے Amazon Music کو ہارڈ ویئر اور سافٹ ویئر دونوں میں قابل اعتماد، قابل توسیع ML آپریشن فراہم کرنے کی اجازت ملتی ہے۔

ہم آپ کی حوصلہ افزائی کرتے ہیں کہ یہ چیک کریں کہ آپ کے کام کے بوجھ کو SageMaker کا استعمال کرتے ہوئے ہمیشہ آپ کے ہارڈ ویئر اور سافٹ ویئر کے انتخاب کا جائزہ لیتے ہوئے بہتر بنایا گیا ہے تاکہ یہ دیکھا جا سکے کہ آیا آپ کم لاگت کے ساتھ بہتر کارکردگی حاصل کر سکتے ہیں۔

AWS میں NVIDIA AI کے بارے میں مزید جاننے کے لیے، درج ذیل سے رجوع کریں:

مصنفین کے بارے میں

سدھارتھ شرما ایمیزون میوزک میں سائنس اور ماڈلنگ ٹیم میں مشین لرننگ ٹیک لیڈ ہے۔ وہ تلاش، بازیافت، درجہ بندی اور NLP سے متعلق ماڈلنگ کے مسائل میں مہارت رکھتا ہے۔ سدھارتھ کے پاس بڑے پیمانے پر مشین لرننگ کے مسائل پر کام کرنے کا ایک بھرپور بیک گراؤنڈ ہے جو کہ دیر سے حساس ہیں جیسے اشتہارات کی ٹارگٹنگ، ملٹی موڈل بازیافت، تلاش کے سوال کو سمجھنا وغیرہ۔ Amazon Music میں کام کرنے سے پہلے، سدھارتھ Meta، Walmart Labs، Rakuten جیسی کمپنیوں میں کام کر رہے تھے۔ ای کامرس سینٹرک ایم ایل کے مسائل پر۔ سدھارتھ نے اپنے کیریئر کا ابتدائی حصہ بے ایریا ایڈ-ٹیک اسٹارٹ اپس کے ساتھ کام کرتے ہوئے گزارا۔

سدھارتھ شرما ایمیزون میوزک میں سائنس اور ماڈلنگ ٹیم میں مشین لرننگ ٹیک لیڈ ہے۔ وہ تلاش، بازیافت، درجہ بندی اور NLP سے متعلق ماڈلنگ کے مسائل میں مہارت رکھتا ہے۔ سدھارتھ کے پاس بڑے پیمانے پر مشین لرننگ کے مسائل پر کام کرنے کا ایک بھرپور بیک گراؤنڈ ہے جو کہ دیر سے حساس ہیں جیسے اشتہارات کی ٹارگٹنگ، ملٹی موڈل بازیافت، تلاش کے سوال کو سمجھنا وغیرہ۔ Amazon Music میں کام کرنے سے پہلے، سدھارتھ Meta، Walmart Labs، Rakuten جیسی کمپنیوں میں کام کر رہے تھے۔ ای کامرس سینٹرک ایم ایل کے مسائل پر۔ سدھارتھ نے اپنے کیریئر کا ابتدائی حصہ بے ایریا ایڈ-ٹیک اسٹارٹ اپس کے ساتھ کام کرتے ہوئے گزارا۔

ترون شرما ایک سافٹ ویئر ڈویلپمنٹ مینیجر ہے جو ایمیزون میوزک سرچ ریلیوینس کی رہنمائی کرتا ہے۔ ان کی سائنسدانوں اور ML انجینئرز کی ٹیم Amazon Music کے صارفین کو سیاق و سباق کے لحاظ سے متعلقہ اور ذاتی نوعیت کے تلاش کے نتائج فراہم کرنے کی ذمہ دار ہے۔

ترون شرما ایک سافٹ ویئر ڈویلپمنٹ مینیجر ہے جو ایمیزون میوزک سرچ ریلیوینس کی رہنمائی کرتا ہے۔ ان کی سائنسدانوں اور ML انجینئرز کی ٹیم Amazon Music کے صارفین کو سیاق و سباق کے لحاظ سے متعلقہ اور ذاتی نوعیت کے تلاش کے نتائج فراہم کرنے کی ذمہ دار ہے۔

جیمز پارک ایمیزون ویب سروسز میں ایک حل آرکیٹیکٹ ہے۔ وہ Amazon.com کے ساتھ AWS پر ٹکنالوجی کے حل کو ڈیزائن کرنے، بنانے اور ان کی تعیناتی کے لیے کام کرتا ہے، اور اسے AI اور مشین لرننگ میں خاص دلچسپی ہے۔ فارغ وقت میں وہ نئی ثقافتوں، نئے تجربات، اور جدید ترین ٹیکنالوجی کے رجحانات کے ساتھ اپ ٹو ڈیٹ رہنے سے لطف اندوز ہوتا ہے۔ آپ اسے اس پر تلاش کر سکتے ہیں۔ لنکڈ.

جیمز پارک ایمیزون ویب سروسز میں ایک حل آرکیٹیکٹ ہے۔ وہ Amazon.com کے ساتھ AWS پر ٹکنالوجی کے حل کو ڈیزائن کرنے، بنانے اور ان کی تعیناتی کے لیے کام کرتا ہے، اور اسے AI اور مشین لرننگ میں خاص دلچسپی ہے۔ فارغ وقت میں وہ نئی ثقافتوں، نئے تجربات، اور جدید ترین ٹیکنالوجی کے رجحانات کے ساتھ اپ ٹو ڈیٹ رہنے سے لطف اندوز ہوتا ہے۔ آپ اسے اس پر تلاش کر سکتے ہیں۔ لنکڈ.

کشتیز گپتا NVIDIA میں ایک حل آرکیٹیکٹ ہے۔ وہ کلاؤڈ صارفین کو GPU AI ٹیکنالوجیز کے بارے میں تعلیم دینے سے لطف اندوز ہوتا ہے جو NVIDIA کو پیش کرنا ہے اور ان کی مشین لرننگ اور ڈیپ لرننگ ایپلی کیشنز کو تیز کرنے میں ان کی مدد کرنا ہے۔ کام سے باہر، وہ دوڑنا، پیدل سفر کرنے اور جنگلی حیات کو دیکھنے سے لطف اندوز ہوتا ہے۔

کشتیز گپتا NVIDIA میں ایک حل آرکیٹیکٹ ہے۔ وہ کلاؤڈ صارفین کو GPU AI ٹیکنالوجیز کے بارے میں تعلیم دینے سے لطف اندوز ہوتا ہے جو NVIDIA کو پیش کرنا ہے اور ان کی مشین لرننگ اور ڈیپ لرننگ ایپلی کیشنز کو تیز کرنے میں ان کی مدد کرنا ہے۔ کام سے باہر، وہ دوڑنا، پیدل سفر کرنے اور جنگلی حیات کو دیکھنے سے لطف اندوز ہوتا ہے۔

جیاہونگ لیو NVIDIA میں کلاؤڈ سروس پرووائیڈر ٹیم میں ایک حل آرکیٹیکٹ ہے۔ وہ مشین لرننگ اور AI سلوشنز کو اپنانے میں کلائنٹس کی مدد کرتا ہے جو NVIDIA ایکسلریٹڈ کمپیوٹنگ کو ان کی ٹریننگ اور انفرنس چیلنجز سے نمٹنے کے لیے فائدہ اٹھاتے ہیں۔ اپنے فارغ وقت میں، وہ اوریگامی، DIY پروجیکٹس، اور باسکٹ بال کھیلنا پسند کرتا ہے۔

جیاہونگ لیو NVIDIA میں کلاؤڈ سروس پرووائیڈر ٹیم میں ایک حل آرکیٹیکٹ ہے۔ وہ مشین لرننگ اور AI سلوشنز کو اپنانے میں کلائنٹس کی مدد کرتا ہے جو NVIDIA ایکسلریٹڈ کمپیوٹنگ کو ان کی ٹریننگ اور انفرنس چیلنجز سے نمٹنے کے لیے فائدہ اٹھاتے ہیں۔ اپنے فارغ وقت میں، وہ اوریگامی، DIY پروجیکٹس، اور باسکٹ بال کھیلنا پسند کرتا ہے۔

تغرل کونوک NVIDIA میں ایک سینئر سولیوشن آرکیٹیکٹ ہے، جو بڑے پیمانے پر تربیت، ملٹی موڈل ڈیپ لرننگ، اور اعلیٰ کارکردگی والے سائنسی کمپیوٹنگ میں مہارت رکھتا ہے۔ NVIDIA سے پہلے، اس نے توانائی کی صنعت میں کام کیا، کمپیوٹیشنل امیجنگ کے لیے الگورتھم تیار کرنے پر توجہ مرکوز کی۔ اپنی پی ایچ ڈی کے حصے کے طور پر، اس نے پیمانے پر عددی نقالی کے لیے طبیعیات پر مبنی گہری سیکھنے پر کام کیا۔ اپنے فارغ وقت میں، وہ پڑھنے، گٹار اور پیانو بجانے سے لطف اندوز ہوتا ہے۔

تغرل کونوک NVIDIA میں ایک سینئر سولیوشن آرکیٹیکٹ ہے، جو بڑے پیمانے پر تربیت، ملٹی موڈل ڈیپ لرننگ، اور اعلیٰ کارکردگی والے سائنسی کمپیوٹنگ میں مہارت رکھتا ہے۔ NVIDIA سے پہلے، اس نے توانائی کی صنعت میں کام کیا، کمپیوٹیشنل امیجنگ کے لیے الگورتھم تیار کرنے پر توجہ مرکوز کی۔ اپنی پی ایچ ڈی کے حصے کے طور پر، اس نے پیمانے پر عددی نقالی کے لیے طبیعیات پر مبنی گہری سیکھنے پر کام کیا۔ اپنے فارغ وقت میں، وہ پڑھنے، گٹار اور پیانو بجانے سے لطف اندوز ہوتا ہے۔

روہیل بھارگوا۔ NVIDIA میں ایک پروڈکٹ مارکیٹنگ مینیجر ہے، جس کی توجہ مخصوص CSP پلیٹ فارمز پر NVIDIA ایپلیکیشن فریم ورک اور SDKs کی تعیناتی پر مرکوز ہے۔

روہیل بھارگوا۔ NVIDIA میں ایک پروڈکٹ مارکیٹنگ مینیجر ہے، جس کی توجہ مخصوص CSP پلیٹ فارمز پر NVIDIA ایپلیکیشن فریم ورک اور SDKs کی تعیناتی پر مرکوز ہے۔

ایلیوتھ ٹریانا اسزا NVIDIA میں ایک ڈویلپر ریلیشنز مینیجر ہے جو Amazon کے AI MLOps، DevOps، سائنسدانوں اور AWS تکنیکی ماہرین کو NVIDIA کمپیوٹنگ اسٹیک میں مہارت حاصل کرنے کے لیے بااختیار بناتا ہے تاکہ ڈیٹا کیوریشن، GPU ٹریننگ، ماڈل انفرنس اور GPUSstan میں GPUSstan میں پروڈکشن کی تعیناتی سے پھیلے جنریٹیو AI فاؤنڈیشن ماڈلز کو تیز اور بہتر بنایا جا سکے۔ . اس کے علاوہ، ایلیوتھ ایک پرجوش ماؤنٹین بائیکر، اسکیئر، ٹینس اور پوکر کھلاڑی ہے۔

ایلیوتھ ٹریانا اسزا NVIDIA میں ایک ڈویلپر ریلیشنز مینیجر ہے جو Amazon کے AI MLOps، DevOps، سائنسدانوں اور AWS تکنیکی ماہرین کو NVIDIA کمپیوٹنگ اسٹیک میں مہارت حاصل کرنے کے لیے بااختیار بناتا ہے تاکہ ڈیٹا کیوریشن، GPU ٹریننگ، ماڈل انفرنس اور GPUSstan میں GPUSstan میں پروڈکشن کی تعیناتی سے پھیلے جنریٹیو AI فاؤنڈیشن ماڈلز کو تیز اور بہتر بنایا جا سکے۔ . اس کے علاوہ، ایلیوتھ ایک پرجوش ماؤنٹین بائیکر، اسکیئر، ٹینس اور پوکر کھلاڑی ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 100

- 12

- 25

- 32

- 35٪

- 7

- 8

- a

- قابلیت

- ہمارے بارے میں

- تیز

- تیز

- تیزی

- تک رسائی حاصل

- پورا

- درستگی

- درست

- حاصل

- حاصل کیا

- کے پار

- فعال

- اس کے علاوہ

- پتہ

- اپنانے

- اشتھارات

- کو متاثر

- کے بعد

- AI

- اے آئی ماڈلز

- AI استعمال کے معاملات

- البم

- یلگوردمز

- تمام

- کی اجازت

- کی اجازت

- اجازت دے رہا ہے

- کی اجازت دیتا ہے

- بھی

- ہمیشہ

- ایمیزون

- ایمیزون ویب سروسز

- Amazon.com

- an

- اور

- درخواست

- ایپلی کیشنز

- نقطہ نظر

- آرکیٹیکٹس

- کیا

- رقبہ

- علاقوں

- ارد گرد

- مصور

- AS

- مدد

- مدد

- At

- اوسط

- AWS

- پسدید

- متوازن

- توازن

- بار

- کی بنیاد پر

- بیس لائن

- باسکٹ بال

- خلیج

- BE

- بن گیا

- کیونکہ

- فوائد

- BEST

- بہتر

- اضافے کا باعث

- فروغ دیتا ہے

- دونوں

- لانے

- وسیع

- تعمیر

- تعمیر

- by

- کر سکتے ہیں

- صلاحیتوں

- صلاحیت

- قبضہ

- پرواہ

- کیریئر کے

- احتیاط سے

- مقدمات

- چیلنجوں

- چیلنج

- چارٹ

- چیک کریں

- پسند ہے

- انتخاب

- کلائنٹس

- بادل

- کوڈ

- COM

- کس طرح

- بات چیت

- کمپنیاں

- مقابلے میں

- کمپیوٹیشنل

- کمپیوٹنگ

- سمورتی

- ترتیب

- کنٹینر

- مواد

- کنورجنس

- کور

- قیمت

- اخراجات

- شلپ

- اہم

- اہم

- CSP

- کیپشن

- اپنی مرضی کے

- گاہک

- گاہک کا تجربہ

- گاہکوں

- اعداد و شمار

- تاریخ

- دن

- کمی

- گہری

- گہری سیکھنے

- تاخیر

- نجات

- ترسیل

- فراہم کرتا ہے

- ڈیمانڈ

- تعیناتی

- تعینات

- تعیناتی

- ڈیزائن

- ڈیولپر

- ترقی

- ترقی

- مختلف

- مشکل

- براہ راست

- ڈوبکی

- متنوع

- ڈی آئی

- نہیں

- کافی

- کے دوران

- متحرک

- e

- ای کامرس

- ابتدائی

- کی تعلیم

- کارکردگی

- ہنر

- کوشش

- بلند

- سرایت کرنا

- جذبات

- ملازم

- بااختیار بنانے

- چالو حالت میں

- کی حوصلہ افزائی

- آخر سے آخر تک

- توانائی

- انجینئرز

- بڑھاتا ہے

- کافی

- کو یقینی بنانے ہے

- خاص طور پر

- وغیرہ

- کا جائزہ لینے

- بھی

- ہر کوئی

- پھانسی

- تجربہ

- تجربات

- ماہرین

- فاسٹ

- خصوصیات

- اعداد و شمار

- آخر

- مل

- تلاش

- پہلا

- لچک

- سیلاب

- توجہ مرکوز

- توجہ مرکوز

- توجہ مرکوز

- کے بعد

- کے لئے

- فارمیٹ

- فاؤنڈیشن

- فریم ورک

- فریم ورک

- سے

- مایوس کن

- مکمل طور پر

- افعال

- مزید

- فیوژن

- گیٹ وے

- نسل

- پیداواری

- پیداواری AI۔

- GPU

- GPUs

- ہینڈل

- ہو

- ہارڈ ویئر

- ہے

- he

- بھاری

- بھاری وزن اٹھانا

- مدد

- مدد گار

- مدد کرتا ہے

- ہائی

- اعلی سطحی

- اعلی کارکردگی

- اسے

- ان

- کی ڈگری حاصل کی

- ہوسٹنگ

- HOURS

- کس طرح

- تاہم

- HTML

- HTTPS

- کی نشاندہی

- if

- وضاحت کرتا ہے

- امیجنگ

- پر عملدرآمد

- اہم

- کو بہتر بنانے کے

- بہتر

- بہتری

- in

- شامل ہیں

- اضافہ

- اضافہ

- اضافہ

- صنعت

- ناکافی

- اثر و رسوخ

- انفراسٹرکچر

- ابتدائی

- مثال کے طور پر

- فوری طور پر

- کے بجائے

- دلچسپی

- میں

- متعارف کرانے

- متعارف کرانے

- IT

- میں

- سفر

- فوٹو

- صرف

- کلیدی

- بچے

- جان

- جانا جاتا ہے

- لیبز

- زبان

- بڑے

- بڑے پیمانے پر

- بڑے

- دیرپا

- تاخیر

- تازہ ترین

- پرت

- قیادت

- معروف

- جانیں

- سیکھنے

- لیوریج

- لائبریری

- اٹھانے

- کی طرح

- حدود

- لنکڈ

- لوڈ

- تلاش

- لو

- کم

- مشین

- مشین لرننگ

- برقرار رکھنے کے

- اہم

- بنا

- بناتا ہے

- مینیجر

- مینیجنگ

- مارکیٹنگ

- ماسٹر

- زیادہ سے زیادہ

- مئی..

- یادیں

- یاد داشت

- میٹا

- مشرق

- دس لاکھ

- لاکھوں

- ملیسیکنڈ

- کم سے کم

- غلطی

- مخلوط

- ML

- ایم ایل اوپس

- ماڈل

- ماڈلنگ

- ماڈل

- ماڈیولز

- قیمت

- زیادہ

- سب سے زیادہ

- ماؤنٹین

- کثیر

- ایک سے زیادہ

- موسیقی

- ضروری

- نام

- ضرورت

- منفی طور پر

- نیٹ ورک

- نئی

- ویزا

- NVIDIA

- of

- پیش کرتے ہیں

- تجویز

- on

- ایک

- صرف

- کھول

- اوپن سورس

- کام

- آپریشنل

- آپریشنز

- زیادہ سے زیادہ

- اصلاح کے

- کی اصلاح کریں

- اصلاح

- اصلاح

- or

- آرکسٹری

- حکم

- دیگر

- باہر

- باہر

- بقایا

- پر

- مجموعی طور پر

- خود

- پیرامیٹرز

- حصہ

- خاص طور پر

- خاص طور پر

- شراکت دار

- جذباتی

- چوٹی

- فیصد

- کارکردگی

- ذاتی

- نجیکرت

- پی ایچ ڈی

- پائپ لائن

- پلیٹ فارم

- پلیٹ فارم

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- کھلاڑی

- کھیل

- podcast

- پوڈ کاسٹ

- پوائنٹ

- پوکر

- ممکن

- پوسٹ

- ممکنہ

- طاقت

- طاقت

- صحت سے متعلق

- پہلے

- ترجیح دیں

- ترجیح

- مسائل

- عمل

- مصنوعات

- پیداوار

- منصوبوں

- فراہم

- فراہم کنندہ

- فراہم کرتا ہے

- فراہم کرنے

- ازگر

- فوری

- رینکنگ

- پڑھنا

- اصل وقت

- کو کم کرنے

- کا حوالہ دیتے ہیں

- متعلقہ

- تعلقات

- مطابقت

- متعلقہ

- قابل اعتماد

- درخواستوں

- کی ضرورت ہے

- وسائل

- جوابات

- ذمہ داری

- ذمہ دار

- قبول

- نتیجے

- نتائج کی نمائش

- امیر

- ٹھیک ہے

- چل رہا ہے

- چلتا ہے

- رن ٹائم

- sagemaker

- اسی

- محفوظ کریں

- بچت

- توسیع پذیر

- پیمانے

- سائنس

- سائنسی

- سائنسدانوں

- sdk

- sdks

- بغیر کسی رکاوٹ کے

- تلاش کریں

- تلاش

- تلاش

- دوسری

- سیکشنز

- دیکھنا

- کی تلاش

- بظاہر

- سیمنٹ

- سینئر

- حساس

- سزا

- خدمت

- سرور

- سروس

- سروس فراہم کرنے والے

- سروسز

- خدمت

- مقرر

- ترتیبات

- کئی

- سیکنڈ اور

- مشترکہ

- شوز

- اہم

- نمایاں طور پر

- سادہ

- بیٹھتا ہے

- سائز

- سائز

- ہوشیار

- سافٹ ویئر کی

- سوفٹ ویئر کی نشوونما

- حل

- حل

- نغمہ

- ماخذ

- تناؤ

- مہارت دیتا ہے

- مہارت

- مخصوص

- تیزی

- جادو

- املا

- خرچ

- ڈھیر لگانا

- شروع

- سترٹو

- رہ

- مستحکم

- مرحلہ

- مراحل

- کہانی

- محرومی

- اس طرح

- اعلی

- حمایت

- تائید

- اس بات کا یقین

- لیا

- لینے

- ھدف بندی

- ٹیم

- ٹیک

- ٹیکنیکل

- تکنیک

- تکنیک

- ٹیکنالوجی

- ٹیکنالوجی

- متن

- کہ

- ۔

- ان

- ان

- وہاں.

- لہذا

- یہ

- وہ

- چیزیں

- اس

- کے ذریعے

- تھرو پٹ

- وقت

- اوقات

- عنوان

- کرنے کے لئے

- مل کر

- ٹوکن بنانا

- ٹوکن

- لیا

- کے آلے

- سب سے اوپر

- ٹی پی

- ٹریفک

- ٹرین

- تربیت یافتہ

- ٹریننگ

- ٹرانسفارمر

- رجحانات

- رخ

- سچ

- دو

- افہام و تفہیم

- بلاشبہ

- کائنات

- غیر مقفل

- بے نقاب

- us

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- صارفین

- استعمال

- کا استعمال کرتے ہوئے

- استعمال کرنا۔

- قیمت

- وسیع

- ورزش

- بہت

- انتظار کر رہا ہے

- چلنا

- Walmart

- تھا

- دیکھ

- طریقوں

- we

- ویب

- ویب خدمات

- اچھا ہے

- تھے

- جب

- جبکہ

- جبکہ

- گے

- ساتھ

- کام

- کام کیا

- کام کر

- کام کرتا ہے

- دنیا

- فکر

- ابھی

- نکلا

- تم

- اور

- زیفیرنیٹ