ہمارے بہت سے AWS صارفین بطور خدمت تحقیق، تجزیات اور کاروباری ذہانت فراہم کرتے ہیں۔ اس قسم کی تحقیق اور کاروباری ذہانت اپنے آخری صارفین کو مارکیٹوں اور حریفوں سے آگے رہنے، ترقی کے مواقع کی نشاندہی کرنے اور مسائل کو فعال طور پر حل کرنے کے قابل بناتی ہے۔ مثال کے طور پر، ہمارے مالیاتی خدمات کے شعبے کے کچھ صارفین ایکوئٹی، ہیج فنڈز، اور سرمایہ کاری کی انتظامی کمپنیوں کے لیے تحقیق کرتے ہیں تاکہ ان کی رجحانات کو سمجھنے اور پورٹ فولیو کی حکمت عملیوں کی شناخت میں مدد کی جا سکے۔ صحت کی صنعت میں، صحت کی تحقیق کا ایک بڑھتا ہوا بڑا حصہ اب معلومات پر مبنی ہے۔ تحقیق کا ایک بڑا سودا ڈیٹا کا تجزیہ شامل کرتا ہے جو ابتدائی طور پر تشخیص، علاج، یا دیگر تحقیقی منصوبوں کے لیے جمع کیا گیا تھا، اور اب نئے تحقیقی مقاصد کے لیے استعمال کیا جا رہا ہے۔ صحت کی تحقیق کی یہ شکلیں نئے کیسوں سے بچنے کے لیے مؤثر بنیادی روک تھام، جلد پتہ لگانے کے لیے ثانوی روک تھام، اور بیماری کے بہتر انتظام کے لیے روک تھام کا باعث بنی ہیں۔ تحقیق کے نتائج نہ صرف معیار زندگی کو بہتر بناتے ہیں بلکہ صحت کی دیکھ بھال کے اخراجات کو کم کرنے میں بھی مدد کرتے ہیں۔

صارفین عوامی اور نجی ذرائع سے معلومات کو ہضم کرتے ہیں۔ اس کے بعد وہ ایک رجحان کا خلاصہ اور شناخت کرنے اور اس معلومات کی بنیاد پر بصیرت پیدا کرنے کے لیے قائم شدہ یا اپنی مرضی کے مطابق قدرتی زبان کی پروسیسنگ (NLP) ماڈلز کا اطلاق کرتے ہیں۔ اس قسم کے تحقیقی کاموں کے لیے استعمال کیے جانے والے NLP ماڈلز بڑے ماڈلز سے نمٹتے ہیں اور عام طور پر کارپس کے سائز اور وقف شدہ اختتامی نقطوں کو مدنظر رکھتے ہوئے اختصار کے لیے طویل مضامین شامل ہوتے ہیں، جو اس وقت لاگت کے لحاظ سے بہتر نہیں ہیں۔ ان ایپلی کیشنز کو دن کے مختلف اوقات میں آنے والی ٹریفک کی ایک بڑی تعداد موصول ہوتی ہے۔

ہمیں یقین ہے کہ صارفین کو صفر تک پیمانہ کرنے اور ضرورت کے مطابق اپنی تخمینہ صلاحیت کو بڑھانے کی صلاحیت سے بہت فائدہ ہوگا۔ یہ تحقیقی لاگت کو بہتر بناتا ہے اور پھر بھی نتائج کے معیار پر سمجھوتہ نہیں کرتا ہے۔ اس پوسٹ میں چہرے کو گلے لگانے کے طریقہ پر تبادلہ خیال کیا گیا ہے۔ ایمیزون سیج میکر غیر مطابقت پذیر تخمینہ اس کو حاصل کرنے میں مدد کر سکتا ہے۔

آپ متعدد گہری سیکھنے والے فریم ورک جیسے TensorFlow، PyTorch، اور Apache MXNet کے ساتھ ٹیکسٹ سمریائزیشن ماڈل بنا سکتے ہیں۔ ان ماڈلز میں عام طور پر مختلف سائز کے متعدد ٹیکسٹ دستاویزات کا ایک بڑا ان پٹ پے لوڈ ہوتا ہے۔ اعلی درجے کے ڈیپ لرننگ ماڈلز کے لیے ماڈل کا اندازہ لگانے سے پہلے کمپیوٹ-انٹینسیو پری پروسیسنگ کی ضرورت ہوتی ہے۔ پروسیسنگ کے اوقات چند منٹوں تک لمبے ہو سکتے ہیں، جو HTTP API پر پے لوڈز کو پاس کر کے ریئل ٹائم انفرنس چلانے کے آپشن کو ہٹا دیتا ہے۔ اس کے بجائے، آپ کو کسی آبجیکٹ اسٹور جیسے ان پٹ پے لوڈز کو متضاد طور پر پروسیس کرنے کی ضرورت ہے۔ ایمیزون سادہ اسٹوریج سروس (Amazon S3) خودکار قطار اور پہلے سے طے شدہ ہم آہنگی کی حد کے ساتھ۔ سسٹم کو اسٹیٹس کی اطلاعات موصول کرنے اور کام مکمل ہونے پر وسائل کو صاف کرکے غیر ضروری اخراجات کو کم کرنے کے قابل ہونا چاہیے۔

SageMaker ڈیٹا سائنسدانوں اور ڈویلپرز کو ML کے لیے مقصد سے تیار کردہ صلاحیتوں کے ایک وسیع سیٹ کو اکٹھا کر کے اعلیٰ معیار کے مشین لرننگ (ML) ماڈلز کو تیزی سے تیار کرنے، بنانے، تربیت دینے اور تعینات کرنے میں مدد کرتا ہے۔ SageMaker XGBoost کے لیے جدید ترین اوپن سورس ماڈل پیش کرنے والے کنٹینرز فراہم کرتا ہے۔کنٹینر, SDK) Sikit-Learn (کنٹینر, SDKPyTorch (کنٹینر, SDK)، TensorFlow (کنٹینر, SDK)، اور اپاچی ایم ایکس نیٹ (کنٹینر, SDK).

- ریئل ٹائم اندازہ اختتامی نقطے کام کے بوجھ کے لیے موزوں ہیں جن پر ms سے سیکنڈ کی ترتیب میں کم تاخیر کی ضروریات کے ساتھ کارروائی کی ضرورت ہے۔

- بیچ کی تبدیلی ڈیٹا کے بڑے بیچوں پر آف لائن پیشین گوئیوں کے لیے مثالی ہے۔

- ایمیزون سیج میکر سرور لیس انفرنس (پیش نظارہ موڈ میں اور اس تحریر کے مطابق پروڈکشن ورک بوجھ کے لیے تجویز نہیں کیا گیا) ایک مقصد سے بنایا گیا انفرنس آپشن ہے جو آپ کے لیے ML ماڈلز کو تعینات کرنا اور اسکیل کرنا آسان بناتا ہے۔ سرور لیس انفرنس ان کام کے بوجھ کے لیے مثالی ہے جن میں ٹریفک کی تیز رفتاری کے درمیان وقفہ وقفہ ہوتا ہے اور وہ سرد آغاز کو برداشت کر سکتے ہیں۔

- غیر مطابقت پذیر اندازہ اختتامی پوائنٹس آنے والی درخواستوں کو قطار میں لگاتے ہیں۔ وہ کام کے بوجھ کے لیے مثالی ہیں جہاں درخواست کے سائز بڑے ہوتے ہیں (1 GB تک) اور انفرنس پروسیسنگ کے اوقات منٹ کی ترتیب میں ہوتے ہیں (15 منٹ تک)۔ غیر مطابقت پذیر تخمینہ آپ کو لاگت کو بچانے کے قابل بناتا ہے جب آپ پر کارروائی کی کوئی درخواست نہیں ہوتی ہے تو مثال کی گنتی کو صفر تک خود بخود سکیل کر کے

حل جائزہ

اس پوسٹ میں، ہم ایک تعینات کرتے ہیں۔ پیگاسس ماڈل جس سے متن کا خلاصہ کرنے کے لیے پہلے سے تربیت دی گئی تھی۔ گلے لگانے والا چہرہ کرنے کے لئے سیج میکر ہوسٹنگ سروسز. ہم سادگی کے لیے اس ماڈل کا استعمال کرتے ہیں جیسا کہ Hugging Face سے ہے۔ تاہم، آپ کر سکتے ہیں اپنی مرضی کے مطابق ڈیٹاسیٹ کی بنیاد پر ماڈل کو ٹھیک کریں۔. آپ میں دستیاب دیگر ماڈلز کو بھی آزما سکتے ہیں۔ گلے لگانا چہرہ ماڈل ہب. ہم ایک غیر مطابقت پذیر انفرنس اینڈ پوائنٹ بھی فراہم کرتے ہیں جو اس ماڈل کی میزبانی کرتا ہے، جس سے آپ پیشین گوئیاں حاصل کر سکتے ہیں۔

غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کا انفرنس ہینڈلر ان پٹ پے لوڈ کے بطور مضمون کی توقع کرتا ہے۔ مضمون کا خلاصہ متن آؤٹ پٹ ہے۔ آؤٹ پٹ کو رجحانات کا تجزیہ کرنے کے لیے ڈیٹا بیس میں ذخیرہ کیا جاتا ہے یا مزید تجزیات کے لیے نیچے کی طرف فیڈ کیا جاتا ہے۔ یہ بہاو تجزیہ ڈیٹا بصیرت حاصل کرتا ہے جو تحقیق میں مدد کرتا ہے۔

ہم یہ ظاہر کرتے ہیں کہ کس طرح غیر مطابقت پذیر انفرنس اینڈ پوائنٹس آپ کو صارف کی وضاحت کردہ ہم آہنگی اور تکمیل کی اطلاعات حاصل کرنے کے قابل بناتے ہیں۔ ہم اختتامی نقطہ کے پیچھے مثالوں کی آٹو اسکیلنگ ترتیب دیتے ہیں تاکہ ٹریفک کم ہونے پر صفر تک اسکیل ہوجائے اور درخواست کی قطار بھرنے پر بیک اپ اسکیل ہوجائے۔

ہم بھی استعمال کرتے ہیں ایمیزون کلاؤڈ واچ قطار کے سائز، پروسیسنگ کے کل وقت، اور پروسیس شدہ درخواستوں کی نگرانی کے لیے میٹرکس۔

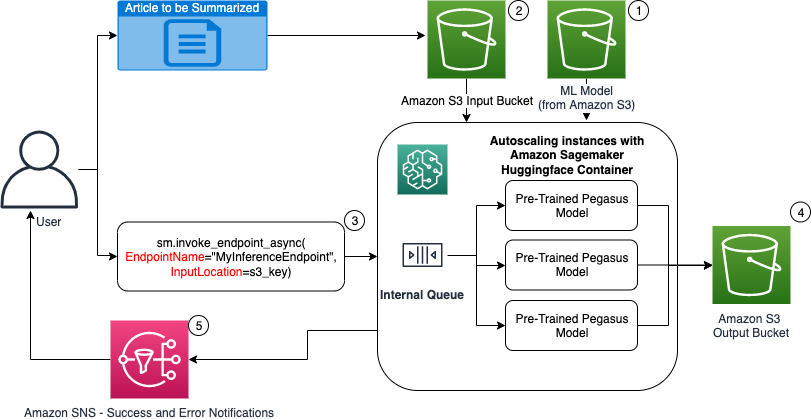

مندرجہ ذیل خاکہ میں، ہم غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کا استعمال کرتے ہوئے انفرنس انجام دیتے وقت شامل اقدامات دکھاتے ہیں۔

- ہمارے پہلے سے تربیت یافتہ PEGASUS ML ماڈل سب سے پہلے اسکیلنگ اینڈ پوائنٹ پر ہوسٹ کیا جاتا ہے۔

- صارف مضمون کو ان پٹ S3 بالٹی میں خلاصہ کرنے کے لیے اپ لوڈ کرتا ہے۔

- اسینکرونس انفرنس اینڈ پوائنٹ کو API کا استعمال کرتے ہوئے طلب کیا جاتا ہے۔

- تخمینہ مکمل ہونے کے بعد، نتیجہ آؤٹ پٹ S3 بالٹی میں محفوظ ہو جاتا ہے۔

- An ایمیزون سادہ نوٹیفکیشن سروس (Amazon SNS) نوٹیفکیشن صارف کو بھیجی جاتی ہے جس میں انہیں مکمل کامیابی یا ناکامی کی اطلاع دی جاتی ہے۔

ایک متضاد تخمینہ اختتامی نقطہ بنائیں

ہم ایک ریئل ٹائم ہوسٹڈ اینڈ پوائنٹ کی طرح غیر مطابقت پذیر انفرنس اینڈ پوائنٹ بناتے ہیں۔ ان اقدامات میں سیج میکر ماڈل بنانا شامل ہے، اس کے بعد اختتامی نقطہ کو ترتیب دینا اور اختتامی نقطہ کو تعینات کرنا۔ دو قسم کے اختتامی نقطوں کے درمیان فرق یہ ہے کہ غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کنفیگریشن میں ایک AsyncInferenceConfig سیکشن یہاں ہم اختتامی نقطہ کی درخواست کے نتائج کے لیے S3 آؤٹ پٹ پاتھ کی وضاحت کرتے ہیں اور اختیاری طور پر کامیابی اور ناکامی پر اطلاعات کے لیے SNS عنوانات شامل کرتے ہیں۔ ہم گاہک کی طرف سے متعین کردہ ہر مثال کے ساتھ ہم آہنگی کی درخواستوں کی زیادہ سے زیادہ تعداد بھی بتاتے ہیں۔ درج ذیل کوڈ دیکھیں:

اسینکرونس انفرنس کے لیے اینڈ پوائنٹ کنفیگریشن بنانے کے لیے API پر تفصیلات کے لیے، دیکھیں ایک غیر مطابقت پذیر انفرنس اینڈ پوائنٹ بنائیں.

غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کو طلب کریں۔

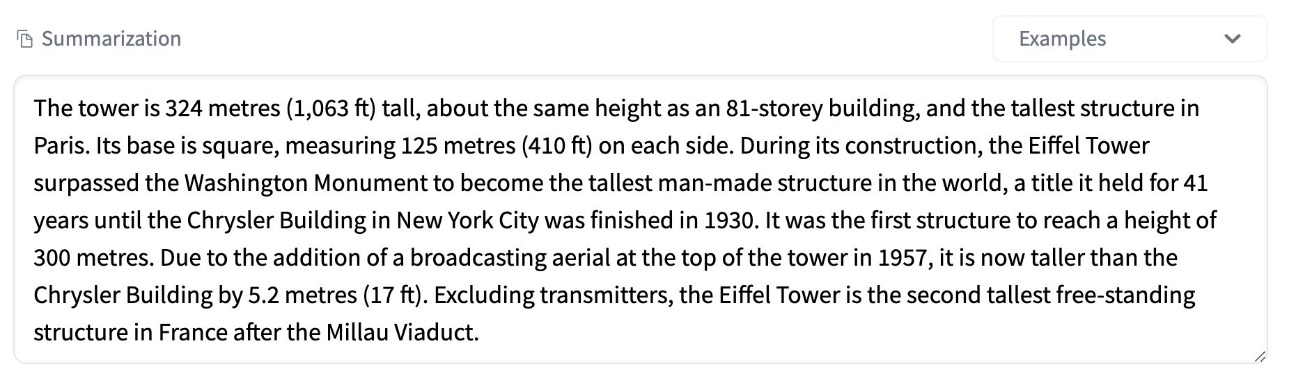

درج ذیل اسکرین شاٹ ایک مختصر مضمون دکھاتا ہے جسے ہم اپنے ان پٹ پے لوڈ کے طور پر استعمال کرتے ہیں:

مندرجہ ذیل کوڈ مضمون کو بطور ایک اپ لوڈ کرتا ہے۔ input.json ایمیزون S3 پر فائل:

ہم ان پٹ پے لوڈ فائل میں Amazon S3 URI استعمال کرتے ہیں تاکہ اختتامی نقطہ کی درخواست کریں۔ رسپانس آبجیکٹ میں ایمیزون S3 میں آؤٹ پٹ لوکیشن شامل ہے تاکہ تکمیل کے بعد نتائج حاصل کیے جا سکیں:

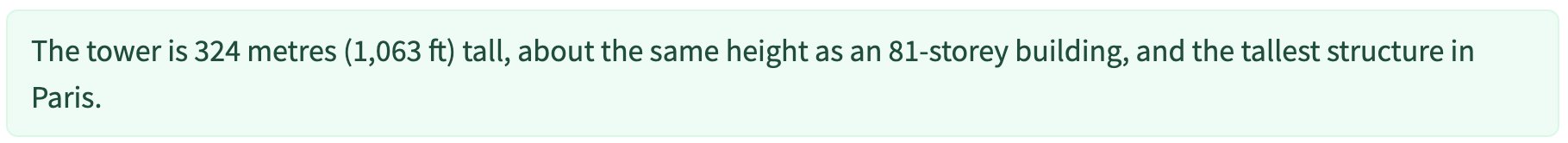

مندرجہ ذیل اسکرین شاٹ نمونہ آؤٹ پٹ پوسٹ کا خلاصہ دکھاتا ہے:

ایک غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کی درخواست کرنے کے لیے API پر تفصیلات کے لیے، دیکھیں ایک غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کی درخواست کریں۔.

درخواست کی درخواستوں کو صارف کی طرف سے متعین کنکرنسی کے ساتھ قطار میں لگائیں۔

غیر مطابقت پذیر انفرنس اینڈ پوائنٹ خود بخود درخواست کی درخواستوں کو قطار میں کھڑا کرتا ہے۔ یہ مختلف مانیٹرنگ میٹرکس کے ساتھ مکمل طور پر منظم قطار ہے اور اس کے لیے مزید کنفیگریشن کی ضرورت نہیں ہے۔ یہ استعمال کرتا ہے۔ MaxConcurrentInvocationsPerInstance پچھلی درخواستوں کے مکمل ہونے کے بعد قطار سے نئی درخواستوں پر کارروائی کرنے کے لیے پچھلی اینڈ پوائنٹ کنفیگریشن میں پیرامیٹر۔ MaxConcurrentInvocationsPerInstance SageMaker کلائنٹ کی طرف سے ماڈل کنٹینر پر بھیجی جانے والی سمورتی درخواستوں کی زیادہ سے زیادہ تعداد ہے۔ اگر کوئی قدر فراہم نہیں کی جاتی ہے، تو SageMaker آپ کے لیے ایک بہترین قیمت کا انتخاب کرتا ہے۔

غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کے اندر آٹو اسکیلنگ کی مثالیں۔

ہم نے کم از کم صفر کی گنجائش اور زیادہ سے زیادہ پانچ مثالوں کی صلاحیت کے ساتھ آٹو اسکیلنگ پالیسی ترتیب دی۔ ریئل ٹائم ہوسٹڈ اینڈ پوائنٹس کے برعکس، غیر مطابقت پذیر انفرنس اینڈ پوائنٹس کم از کم گنجائش کو صفر پر سیٹ کرکے مثالوں کو صفر تک کم کرنے کی حمایت کرتے ہیں۔ ہم استعمال کرتے ہیں ApproximateBacklogSizePerInstance اسکیلنگ پالیسی کنفیگریشن کے لیے میٹرک جس میں مزید اسکیل آؤٹ کرنے کے لیے فی مثال پانچ کے ہدف قطار بیک لاگ کے ساتھ۔ ہم نے کولڈاؤن کی مدت مقرر کی ہے۔ ScaleInCooldown 120 سیکنڈ تک اور ScaleOutCooldown 120 سیکنڈ تک۔ کے لیے قدر ApproximateBacklogSizePerInstance ٹریفک اور پیمانہ کی رفتار کے لیے آپ کی حساسیت کی بنیاد پر منتخب کیا جاتا ہے۔ آپ جتنی تیزی سے اسکیل کریں گے، اتنی ہی کم لاگت آئے گی، لیکن نئی درخواستیں آنے پر آپ کو دوبارہ پیمانہ بڑھانے کا امکان اتنا ہی زیادہ ہوگا۔ جتنا آہستہ آپ اسکیل کریں گے، آپ کو اتنا ہی زیادہ لاگت آئے گی، لیکن آپ کو اس کا امکان کم ہوگا۔ جب آپ کا پیمانہ کم ہوتا ہے تو ایک درخواست آتی ہے۔

غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کو آٹو اسکیل کرنے کے لیے API کی تفصیلات کے لیے، دیکھیں ایک غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کو آٹو اسکیل کریں۔.

غیر مطابقت پذیر انفرنس اینڈ پوائنٹ سے اطلاعات کو ترتیب دیں۔

ہم کامیابی کے لیے دو الگ الگ SNS عنوانات بناتے ہیں اور ہر ایک اختتامی نقطہ کی درخواست کے نتائج کے لیے غلطی کی اطلاعات:

اطلاعات کے دیگر اختیارات میں وقتاً فوقتاً S3 بالٹی کے آؤٹ پٹ کو چیک کرنا، یا S3 بالٹی اطلاعات کو شروع کرنے کے لیے استعمال کرنا شامل ہے۔ او ڈبلیو ایس لامبڈا۔ فائل اپ لوڈ پر فنکشن۔ SNS نوٹیفیکیشنز کو اینڈ پوائنٹ کنفیگریشن سیکشن میں شامل کیا گیا ہے جیسا کہ پہلے بیان کیا گیا ہے۔

غیر مطابقت پذیر انفرنس اینڈ پوائنٹ سے اطلاعات کو کیسے ترتیب دیا جائے اس بارے میں تفصیلات کے لیے، دیکھیں پیشن گوئی کے نتائج چیک کریں۔.

غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کی نگرانی کریں۔

ہم غیر مطابقت پذیر قیاس کے لیے مخصوص بلٹ ان اضافی CloudWatch میٹرکس کے ساتھ غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کی نگرانی کرتے ہیں۔ مثال کے طور پر، ہم ہر ایک مثال کے ساتھ قطار کی لمبائی کی نگرانی کرتے ہیں۔ ApproximateBacklogSizePerInstance اور قطار کی کل لمبائی کے ساتھ ApproximateBacklogSize.

میٹرکس کی مکمل فہرست کے لیے، رجوع کریں۔ غیر مطابقت پذیر انفرنس اینڈ پوائنٹس کی نگرانی کرنا.

ہم اعلی کارکردگی کے ساتھ سب سے زیادہ سرمایہ کاری مؤثر مثال حاصل کرنے کے لیے اختتامی نقطہ کی ترتیب کو بہتر بنا سکتے ہیں۔ مثال کے طور پر، ہم Amazon Elastic Inference یا AWS Inferentia کے ساتھ ایک مثال استعمال کر سکتے ہیں۔ ہم دوسرے ماڈل سرور اور کنٹینر پیرامیٹرز کو ایڈجسٹ کرتے ہوئے بتدریج کنکرنسی لیول کو تھرو پٹ چوٹی تک بڑھا سکتے ہیں۔

کلاؤڈ واچ گرافس

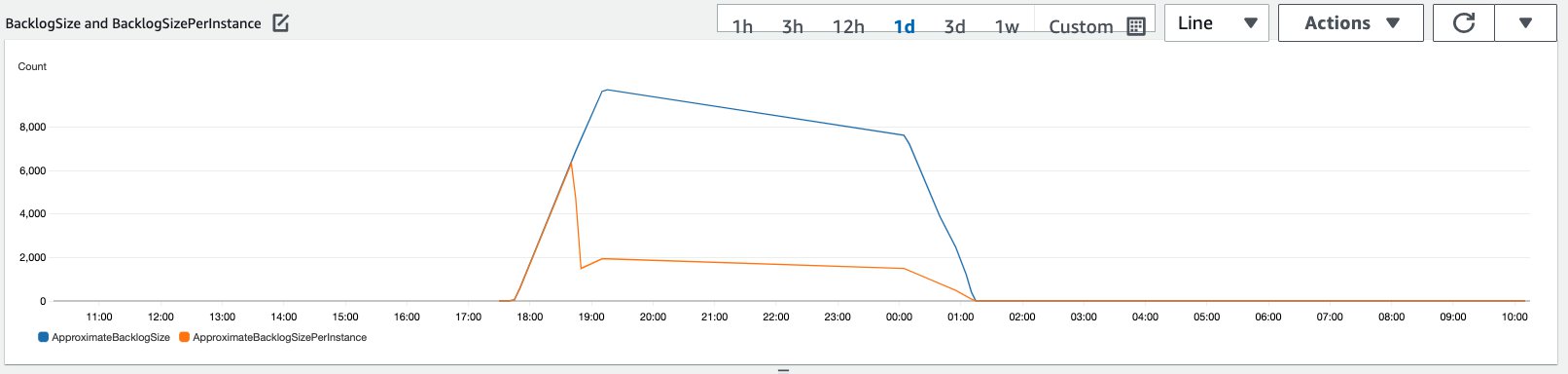

ہم نے پچھلے سیکشن میں بیان کردہ آٹو اسکیلنگ پالیسی کے ساتھ فعال کردہ غیر مطابقت پذیر انفرنس اینڈ پوائنٹ پر ایک مدت کے دوران بہنے والی 10,000 انفرنس درخواستوں کی ٹریفک کی نقل کی۔

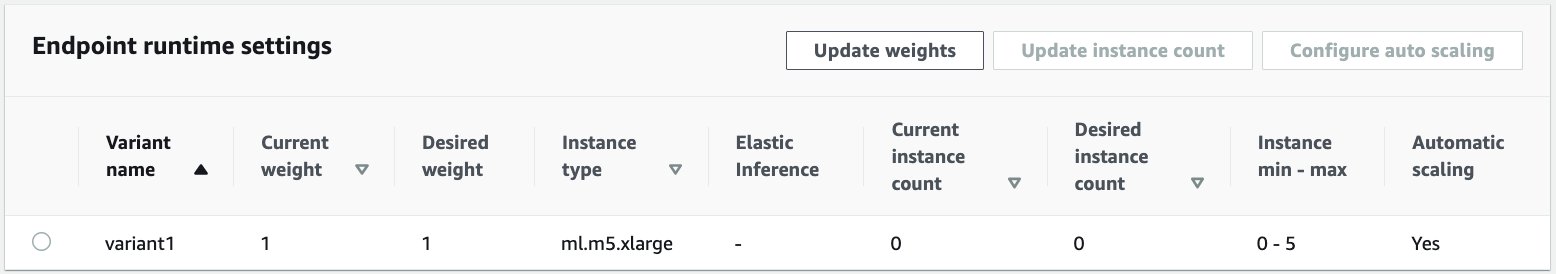

مندرجہ ذیل اسکرین شاٹ درخواستوں کے آنے سے پہلے مثالی میٹرکس دکھاتا ہے۔ ہم ایک لائیو اینڈ پوائنٹ کے ساتھ شروع کرتے ہیں جس میں زیرو مثالیں چل رہی ہیں:

مندرجہ ذیل گراف دکھاتا ہے کہ کس طرح BacklogSize اور BacklogSizePerInstance آٹو اسکیلنگ شروع ہونے کے ساتھ ہی میٹرکس بدل جاتا ہے اور اینڈ پوائنٹ پر بوجھ کو متعدد مثالوں کے ذریعے شیئر کیا جاتا ہے جو آٹو اسکیلنگ کے عمل کے حصے کے طور پر فراہم کیے گئے تھے۔

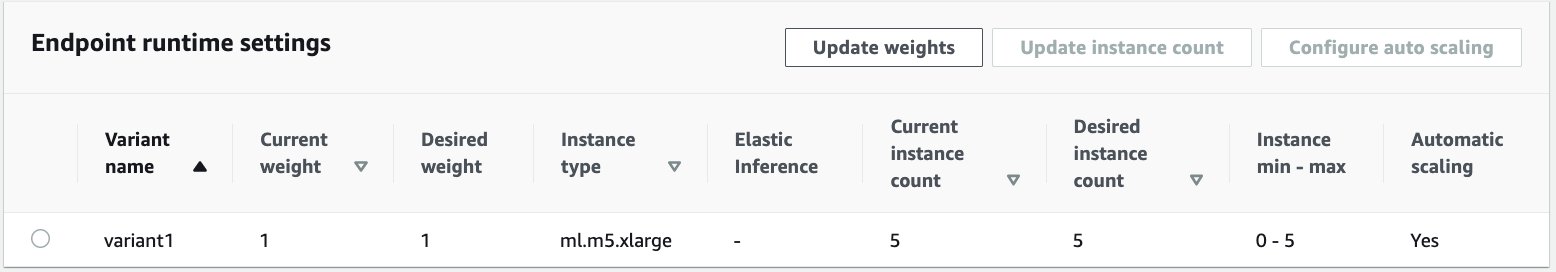

جیسا کہ مندرجہ ذیل اسکرین شاٹ میں دکھایا گیا ہے، قیاس کی تعداد میں اضافہ کے ساتھ ہی واقعات کی تعداد میں اضافہ ہوا:

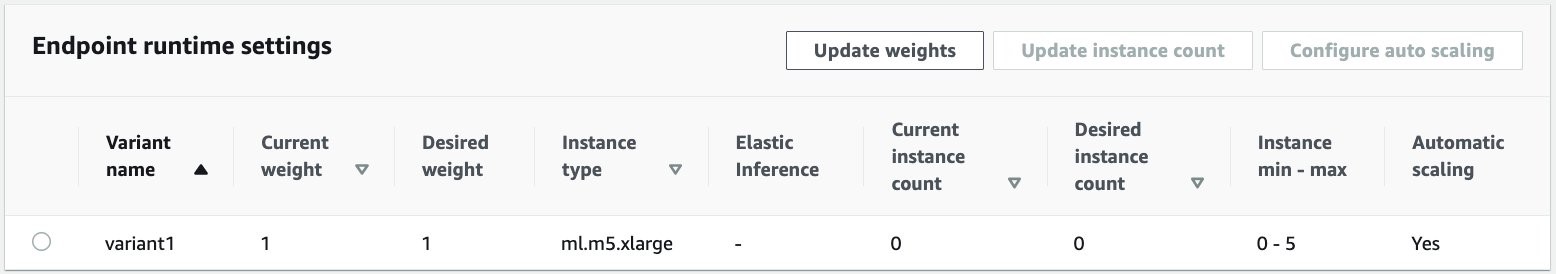

درج ذیل اسکرین شاٹ سے پتہ چلتا ہے کہ کس طرح اسکیلنگ ان اختتامی نقطہ کو صفر چلنے والی مثالوں کی ابتدائی حالت میں واپس لاتی ہے:

صاف کرو

تمام درخواستیں مکمل ہونے کے بعد، ہم اختتامی نقطہ کو حذف کر سکتے ہیں جیسا کہ حقیقی وقت میں میزبانی کے اختتامی پوائنٹس کو حذف کرنا ہے۔ نوٹ کریں کہ اگر ہم غیر مطابقت پذیر انفرنس اینڈ پوائنٹس کی کم از کم صلاحیت کو صفر پر سیٹ کرتے ہیں، تو اس کے صفر تک پہنچنے کے بعد کوئی مثال چارجز نہیں لگتے۔

اگر آپ نے اپنے اختتامی نقطہ کے لیے آٹو اسکیلنگ کو فعال کیا ہے، تو یقینی بنائیں کہ آپ اختتامی نقطہ کو حذف کرنے سے پہلے ایک قابل توسیع ہدف کے طور پر اختتامی نقطہ کی رجسٹریشن منسوخ کر دیتے ہیں۔ ایسا کرنے کے لیے درج ذیل کوڈ کو چلائیں:

استعمال کے بعد اپنا اختتامی نقطہ حذف کرنا یاد رکھیں کیونکہ اس ڈیمو میں استعمال ہونے والی مثالوں کے لیے آپ سے معاوضہ لیا جائے گا۔

آپ کو S3 اشیاء اور SNS عنوانات کو بھی حذف کرنے کی ضرورت ہے۔ اگر آپ نے SNS اطلاعات کو استعمال کرنے اور ان پر کارروائی کرنے کے لیے کوئی اور AWS وسائل بنائے ہیں، تو آپ انہیں حذف بھی کر سکتے ہیں۔

نتیجہ

اس پوسٹ میں، ہم نے دکھایا کہ سیج میکر کی طرف سے نئی غیر مطابقت پذیر انفرنس کی صلاحیت کو ایک عام بڑے ان پٹ پے لوڈ پر کارروائی کرنے کے لیے کیسے استعمال کیا جائے جو کہ خلاصے کے کام کا حصہ ہے۔ اندازہ لگانے کے لیے، ہم نے Hugging Face سے ایک ماڈل استعمال کیا اور اسے غیر مطابقت پذیر انفرنس اینڈ پوائنٹ پر تعینات کیا۔ ہم نے برسٹ ٹریفک، ہائی ماڈل پروسیسنگ اوقات، اور تحقیقی تجزیات کے ساتھ شامل بڑے پے لوڈز کے مشترکہ چیلنجوں کی وضاحت کی۔ غیر مطابقت پذیر انفرنس اینڈ پوائنٹ کی داخلی قطاروں کا انتظام کرنے، پہلے سے طے شدہ ہم آہنگی کی حدود، جوابی اطلاعات کو ترتیب دینے اور خود بخود صفر تک سکیل کرنے کی فطری صلاحیت نے ان چیلنجوں سے نمٹنے میں ہماری مدد کی۔ اس مثال کے لیے مکمل کوڈ پر دستیاب ہے۔ GitHub کے.

SageMaker غیر مطابقت پذیر تخمینہ کے ساتھ شروع کرنے کے لیے، چیک آؤٹ کریں۔ غیر مطابقت پذیر اندازہ.

مصنفین کے بارے میں

دنیش کمار سبرامانی ایڈنبرا، سکاٹ لینڈ میں مقیم UKIR SMB ٹیم کے ساتھ ایک سینئر سولیوشن آرکیٹیکٹ ہے۔ وہ مصنوعی ذہانت اور مشین لرننگ میں مہارت رکھتا ہے۔ دنیش کو تمام صنعتوں میں صارفین کے ساتھ کام کرنے سے لطف آتا ہے تاکہ وہ AWS خدمات کے ساتھ ان کے مسائل حل کر سکیں۔ کام سے باہر، وہ اپنے خاندان کے ساتھ وقت گزارنا، شطرنج کھیلنا اور مختلف صنفوں میں موسیقی سے لطف اندوز ہونا پسند کرتا ہے۔

دنیش کمار سبرامانی ایڈنبرا، سکاٹ لینڈ میں مقیم UKIR SMB ٹیم کے ساتھ ایک سینئر سولیوشن آرکیٹیکٹ ہے۔ وہ مصنوعی ذہانت اور مشین لرننگ میں مہارت رکھتا ہے۔ دنیش کو تمام صنعتوں میں صارفین کے ساتھ کام کرنے سے لطف آتا ہے تاکہ وہ AWS خدمات کے ساتھ ان کے مسائل حل کر سکیں۔ کام سے باہر، وہ اپنے خاندان کے ساتھ وقت گزارنا، شطرنج کھیلنا اور مختلف صنفوں میں موسیقی سے لطف اندوز ہونا پسند کرتا ہے۔

راگھو رمیشا۔ ایمیزون سیج میکر سروس ٹیم کے ساتھ ایم ایل سلوشنز آرکیٹیکٹ ہے۔ وہ صارفین کی ایم ایل پروڈکشن ورک بوجھ کو SageMaker پر پیمانے پر بنانے، تعینات کرنے اور منتقل کرنے میں مدد کرنے پر توجہ مرکوز کرتا ہے۔ وہ مشین لرننگ، AI، اور کمپیوٹر وژن ڈومینز میں مہارت رکھتا ہے، اور UT Dallas سے کمپیوٹر سائنس میں ماسٹر ڈگری رکھتا ہے۔ اپنے فارغ وقت میں وہ سفر اور فوٹو گرافی سے لطف اندوز ہوتے ہیں۔

راگھو رمیشا۔ ایمیزون سیج میکر سروس ٹیم کے ساتھ ایم ایل سلوشنز آرکیٹیکٹ ہے۔ وہ صارفین کی ایم ایل پروڈکشن ورک بوجھ کو SageMaker پر پیمانے پر بنانے، تعینات کرنے اور منتقل کرنے میں مدد کرنے پر توجہ مرکوز کرتا ہے۔ وہ مشین لرننگ، AI، اور کمپیوٹر وژن ڈومینز میں مہارت رکھتا ہے، اور UT Dallas سے کمپیوٹر سائنس میں ماسٹر ڈگری رکھتا ہے۔ اپنے فارغ وقت میں وہ سفر اور فوٹو گرافی سے لطف اندوز ہوتے ہیں۔

- سکے سمارٹ۔ یورپ کا بہترین بٹ کوائن اور کرپٹو ایکسچینج۔

- پلیٹو بلاک چین۔ Web3 Metaverse انٹیلی جنس۔ علم میں اضافہ۔ مفت رسائی۔

- کرپٹو ہاک۔ Altcoin ریڈار. مفت جانچ.

- ماخذ: https://aws.amazon.com/blogs/machine-learning/improve-high-value-research-with-hugging-face-and-amazon-sagemaker-asynchronous-inference-endpoints/

- "

- 000

- 100

- کے پار

- عمل

- سرگرمی

- ایڈیشنل

- پتہ

- اعلی درجے کی

- AI

- تمام

- ایمیزون

- رقم

- تجزیہ

- تجزیاتی

- ایک اور

- اے پی آئی

- درخواست

- ایپلی کیشنز

- مضمون

- مضامین

- مصنوعی

- مصنوعی ذہانت

- مصنوعی انٹیلی جنس اور مشین سیکھنا

- آٹو

- دستیاب

- اوسط

- AWS

- بنیاد

- کیا جا رہا ہے

- سرحد

- تعمیر

- تعمیر میں

- کاروبار

- کاروبار کی ذہانت

- حاصل کر سکتے ہیں

- صلاحیتوں

- اہلیت

- مقدمات

- چیلنجوں

- تبدیل

- الزام عائد کیا

- بوجھ

- جانچ پڑتال

- شطرنج

- صفائی

- کوڈ

- کامن

- کمپنیاں

- حریف

- کمپیوٹر سائنس

- ترتیب

- بسم

- کنٹینر

- کنٹینر

- پر مشتمل ہے

- سرمایہ کاری مؤثر

- اخراجات

- تخلیق

- گاہکوں

- ڈلاس

- اعداد و شمار

- ڈیٹا بیس

- دن

- نمٹنے کے

- وقف

- تعیناتی

- تعینات

- کھوج

- ڈویلپرز

- مختلف

- بیماری

- دستاویزات

- نہیں کرتا

- ڈومینز

- نیچے

- ابتدائی

- موثر

- اختتام پوائنٹ

- قائم

- مثال کے طور پر

- امید ہے

- اخراجات

- چہرہ

- ناکامی

- خاندان

- تیز تر

- فیڈ

- مالی

- مالیاتی خدمات

- پہلا

- کے بعد

- فارمیٹ

- فارم

- مفت

- تقریب

- فنڈز

- پیدا

- عظیم

- ترقی

- صحت

- صحت کی دیکھ بھال

- ہیج فنڈز

- مدد

- مدد کرتا ہے

- یہاں

- ہائی

- کی ڈگری حاصل کی

- کس طرح

- کیسے

- HTTPS

- شناخت

- کو بہتر بنانے کے

- شامل

- شامل

- اضافہ

- اضافہ

- صنعتوں

- صنعت

- معلومات

- بصیرت

- انٹیلی جنس

- سرمایہ کاری

- ملوث

- مسائل

- IT

- زبان

- بڑے

- سیکھنے

- قیادت

- سطح

- لسٹ

- لوڈ

- محل وقوع

- لانگ

- مشین

- مشین لرننگ

- انتظام

- Markets

- پیمائش کا معیار

- ML

- ماڈل

- ماڈل

- نگرانی

- سب سے زیادہ

- MS

- موسیقی

- قدرتی

- نوٹیفیکیشن

- مطلع کرنا

- مواقع

- اختیار

- آپشنز کے بھی

- حکم

- دیگر

- کارکردگی

- ادوار

- فوٹو گرافی

- پالیسی

- پورٹ فولیو

- کی پیشن گوئی

- پیشن گوئی

- روک تھام

- پیش نظارہ

- پرائمری

- نجی

- مسائل

- عمل

- پیداوار

- منصوبوں

- فراہم

- فراہم کرتا ہے

- عوامی

- مقاصد

- معیار

- جلدی سے

- ریمپ

- اصل وقت

- وصول

- کو کم

- کی ضرورت

- ضروریات

- تحقیق

- وسائل

- وسائل

- جواب

- نتائج کی نمائش

- رن

- چل رہا ہے

- توسیع پذیر

- پیمانے

- سکیلنگ

- سائنس

- سائنسدانوں

- ثانوی

- شعبے

- بے سرور

- سروس

- سروسز

- مقرر

- قائم کرنے

- مشترکہ

- اسی طرح

- سادہ

- سائز

- حل

- حل

- مہارت دیتا ہے

- تیزی

- خرچ کرنا۔

- شروع کریں

- شروع

- شروع ہوتا ہے

- حالت

- درجہ

- رہنا

- ذخیرہ

- ذخیرہ

- حکمت عملیوں

- کامیابی

- حمایت

- کی حمایت کرتا ہے

- کے نظام

- ہدف

- کاموں

- ٹیم

- وقت

- مل کر

- موضوعات

- ٹریکنگ

- ٹریفک

- علاج

- رجحانات

- سمجھ

- us

- استعمال کی شرائط

- عام طور پر

- قیمت

- نقطہ نظر

- چاہے

- کے اندر

- کام

- کام کر

- تحریری طور پر

- صفر