تنظیمیں کسٹمر کے تجربے کو بڑھانے، آپریشنل لاگت کو کم کرنے اور کاروباری نتائج کو بہتر بنانے کے لیے نئے امکانات کو کھولنے کے لیے مشین لرننگ (ML) اور AI سروسز کا استعمال کر رہی ہیں۔ ڈیٹا ML اور AI کے استعمال کے معاملات کو زیر کرتا ہے اور کسی تنظیم کے لیے ایک اسٹریٹجک اثاثہ ہے۔ چونکہ ڈیٹا تیزی سے بڑھ رہا ہے، تنظیمیں ڈیٹا کو پری پروسیس کرنے، فیچر انجینئرنگ کرنے، اور پیمانے پر ایم ایل ماڈلز کی تعمیر، تربیت اور آپریشنلائز کرنے کے لیے ایک مربوط، لاگت سے موثر، اور پرفارمنٹ ڈیٹا پلیٹ فارم قائم کرنے کی کوشش کر رہی ہیں۔ اس کو حاصل کرنے کے لیے، AWS ایک متحد جدید ڈیٹا پلیٹ فارم پیش کرتا ہے جس کی طاقت ہے۔ ایمیزون سادہ اسٹوریج سروس (Amazon S3) اینالیٹکس اور ML ورک بوجھ کو سپورٹ کرنے کے لیے مقصد سے بنائے گئے ٹولز اور پروسیسنگ انجنوں کے ساتھ ڈیٹا لیک کے طور پر۔ متحد ایم ایل کے تجربے کے لیے، آپ استعمال کر سکتے ہیں۔ ایمیزون سیج میکر اسٹوڈیوجو پیش کرتا ہے AWS Glue انٹرایکٹو سیشن کے ساتھ مقامی انضمام حساس ڈیٹا تحفظ کے ساتھ پیمانے پر فیچر انجینئرنگ انجام دینے کے لیے۔ اس پوسٹ میں، ہم اس حل کو لاگو کرنے کا طریقہ دکھاتے ہیں۔

ایمیزون سیج میکر ایک مکمل طور پر منظم ML سروس ہے جو آپ کو وسیع پیمانے پر استعمال کے کیسز کے لیے ماڈلز بنانے، تربیت دینے اور ان کی تعیناتی کے قابل بناتی ہے۔ ماڈل ٹریننگ کے لیے، آپ ان میں سے کوئی بھی استعمال کر سکتے ہیں۔ بلٹ ان الگورتھم سیج میکر کے اندر ایم ایل ماڈلز کو تیزی سے تربیت اور تعینات کرنا شروع کرنے کے لیے۔

ماڈل کی تعمیر اور ترقی کے عمل کا ایک اہم جزو فیچر انجینئرنگ ہے۔ AWS گلو پیمانے پر فیچر انجینئرنگ حاصل کرنے کے لیے تجویز کردہ اختیارات میں سے ایک ہے۔ AWS Glue آپ کو بغیر سرور کے Apache Spark انفراسٹرکچر پر تقسیم شدہ انداز میں ڈیٹا انٹیگریشن اور ٹرانسفارمیشن چلانے کے قابل بناتا ہے، اور فیچر انجینئرنگ اور ماڈل ڈیولپمنٹ کے لیے مشہور Spark ML لائبریری کو استعمال کرنا آسان بناتا ہے۔ اس کے علاوہ، آپ AWS Glue کو انکریمنٹل ڈیٹا پروسیسنگ کے ذریعے استعمال کر سکتے ہیں۔ نوکری کے بک مارکسکا استعمال کرتے ہوئے 100 سے زیادہ ذرائع سے ڈیٹا ہضم کریں۔ کنیکٹر، اور استعمال کرتے ہوئے تیز یا غیر متوقع کام کے بوجھ کو چلائیں۔ آٹو اسکیلنگ.

ایم ایل پر مبنی ایپلی کیشنز کے لیے ایک اور اہم ضرورت ڈیٹا سیکیورٹی اور رسائی کنٹرول ہے۔ کم از کم استحقاق تک رسائی کے اصول پر عمل کرتے ہوئے فیچر انجینئرنگ اور ماڈل بنانے کے عمل کے حصے کے طور پر انتہائی حساس ڈیٹا تک کون رسائی حاصل کر سکتا ہے اس پر سخت کنٹرول رکھنے کا عام مطالبہ ہے۔ اس کو حاصل کرنے کے لیے، آپ AWS گلو انضمام کے ساتھ استعمال کر سکتے ہیں۔ AWS جھیل کی تشکیل ڈیٹا لیک اثاثوں کی گورننس اور انتظام میں اضافہ کے لیے۔ Lake Formation کے ساتھ، آپ اپنے Amazon S3 ڈیٹا لیک کے اوپری حصے میں عمدہ ڈیٹا تک رسائی کے کنٹرول اور سیکیورٹی پالیسیوں کو ترتیب دے سکتے ہیں۔ پالیسیوں کی وضاحت ایک مرکزی مقام پر کی گئی ہے، جس سے متعدد تجزیات اور ML خدمات، جیسے AWS Glue، ایمیزون ایتینا، اور SageMaker، Amazon S3 میں ذخیرہ شدہ ڈیٹا کے ساتھ تعامل کرنے کے لیے۔

AWS گلو میں شامل ہے۔ ذاتی طور پر قابل شناخت معلومات (PII) کا پتہ لگانا ٹرانسفارم جو کہ ضرورت کے مطابق اداروں کا پتہ لگانے، نقاب پوش کرنے یا ہٹانے کی صلاحیت فراہم کرتا ہے، تاکہ تعمیل اور حکمرانی میں اضافہ ہو۔ PII ٹرانسفارم کے ساتھ، آپ ڈیٹا سیٹس میں PII ڈیٹا کا پتہ لگا سکتے ہیں اور مختلف صارف گروپوں کے لیے حساس ڈیٹا کو محدود کرنے کے لیے Lake Formation کا استعمال کرتے ہوئے خودکار طور پر فائن گرینڈ ایکسیس کنٹرول کا اطلاق کر سکتے ہیں۔

کیس استعمال کریں۔

ہم پروپینسیٹی ماڈل کے استعمال کے معاملے پر توجہ مرکوز کرتے ہیں جس میں کسٹمر مارکیٹنگ ڈیٹاسیٹ شامل ہوتا ہے اور اس میں دو صارف شخصیات شامل ہوتی ہیں: ایک ڈیٹا انجینئر اور ڈیٹا سائنسدان۔ ڈیٹاسیٹ میں فی گاہک کی معلومات شامل ہیں، بشمول لیڈ سورس، رابطے کے نوٹس، جاب رول، کچھ جھنڈے، فی وزٹ پیج ویوز، اور مزید۔ ڈیٹا سیٹ میں ذاتی فون نمبر جیسی حساس معلومات بھی شامل ہوتی ہیں۔

ڈیٹا انجینئر اینڈ ٹو اینڈ ڈیٹا پروسیسنگ پائپ لائن بنانے کا ذمہ دار ہے، بشمول ڈیٹا کی تیاری، پری پروسیسنگ، اور رسائی کنٹرول۔ ڈیٹا سائنسدان فیچر انجینئرنگ، اور ایم ایل ماڈل کی تربیت اور تعیناتی کا ذمہ دار ہے۔ نوٹ کریں کہ ڈیٹا سائنسدان کو فیچر انجینئرنگ یا ML ماڈل کی تربیت کے لیے کسی بھی PII حساس ڈیٹا تک رسائی کی اجازت نہیں ہے۔

اس استعمال کے کیس کے حصے کے طور پر، ڈیٹا انجینئر ڈیٹاسیٹ کو پری پروسیس کرنے کے لیے ایک ڈیٹا پائپ لائن بناتا ہے، کسی بھی PII معلومات کے لیے ڈیٹاسیٹ کو اسکین کرتا ہے، اور ڈیٹا سائنسدان صارف تک PII کالم تک رسائی کو محدود کرتا ہے۔ نتیجے کے طور پر، جب ڈیٹا سائنسدان فیچر انجینئرنگ انجام دینے اور ML ماڈلز بنانے کے لیے ڈیٹاسیٹ کا استعمال کرتا ہے، تو ان کے پاس PII حساس کالم (اس معاملے میں فون نمبرز) تک رسائی نہیں ہوتی ہے۔ فیچر انجینئرنگ کے عمل میں ٹائپ سٹرنگ کے کالموں کو ایسے فارمیٹ میں تبدیل کرنا شامل ہے جو ML ماڈلز کے لیے بہترین ہے۔ ایک اعلی درجے کے استعمال کے معاملے کے طور پر، آپ جھیل کی تشکیل کا استعمال کرتے ہوئے قطار کی سطح اور سیل سطح کی حفاظت کو لاگو کرنے کے لیے اس رسائی پیٹرن کو بڑھا سکتے ہیں۔

حل جائزہ

حل میں درج ذیل اعلیٰ سطحی اقدامات شامل ہیں:

- کے ساتھ وسائل مرتب کریں۔ AWS کلاؤڈ فارمیشن.

- AWS Glue انٹرایکٹو سیشن پر ڈیٹاسیٹ کو پہلے سے پروسیس کریں، بشمول PII کا پتہ لگانا اور عمدہ رسائی کنٹرول۔

- AWS Glue انٹرایکٹو سیشن پر فیچر انجینئرنگ انجام دیں۔

- SageMaker بلٹ ان XGBoost الگورتھم کا استعمال کرتے ہوئے ایک ML ماڈل کو تربیت دیں اور تعینات کریں۔

- ایم ایل ماڈل کا اندازہ کریں۔

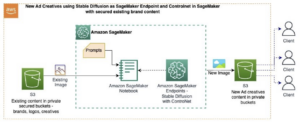

مندرجہ ذیل خاکہ حل کے فن تعمیر کی وضاحت کرتا ہے۔

شرائط

اس ٹیوٹوریل کو مکمل کرنے کے لیے، آپ کو درج ذیل شرائط کا ہونا ضروری ہے:

AWS CloudFormation کے ساتھ وسائل مرتب کریں۔

اس پوسٹ میں فوری سیٹ اپ کے لیے CloudFormation ٹیمپلیٹ شامل ہے۔ آپ اپنی ضروریات کے مطابق اس کا جائزہ لے سکتے ہیں اور اسے اپنی مرضی کے مطابق بنا سکتے ہیں۔ اگر آپ وسائل کو ترتیب دینے کو ترجیح دیتے ہیں۔ AWS مینجمنٹ کنسول اور AWS CloudFormation کے بجائے AWS CLI، اس پوسٹ کے آخر میں ضمیمہ میں دی گئی ہدایات دیکھیں۔

CloudFormation ٹیمپلیٹ درج ذیل وسائل تیار کرتا ہے:

- نمونہ ڈیٹاسیٹ کے ساتھ S3 بالٹیاں

- An او ڈبلیو ایس لامبڈا۔ ڈیٹاسیٹ لوڈ کرنے کا فنکشن

- AWS شناخت اور رسائی کا انتظام (IAM) گروپ، صارفین، کردار، اور پالیسیاں

- جھیل کی تشکیل ڈیٹا جھیل کی ترتیبات اور اجازتیں۔

- سیج میکر صارف پروفائلز

اپنے وسائل بنانے کے لیے، درج ذیل مراحل کو مکمل کریں:

- کنسول میں سائن ان کریں۔

- میں سے انتخاب کریں اسٹیک لانچ کریں۔:

- میں سے انتخاب کریں اگلے.

- کے لئے ڈیٹا انجینئر پی ڈبلیو ڈی اور ڈیٹا سائنٹسٹ پی ڈبلیو ڈی، ڈیٹا انجینئر اور ڈیٹا سائنسدان صارفین کے لیے اپنا پاس ورڈ درج کریں۔

- کے لئے گلو ڈیٹا بیس کا نام، داخل کریں

demo. - کے لئے گلو ٹیبل کا نام، داخل کریں

web_marketing. - کے لئے S3BucketNameForInput، داخل کریں

blog-studio-pii-dataset-. - کے لئے S3BucketNameForOutput، داخل کریں

blog-studio-output-. - کے لئے SageMakerDomainId، اپنی SageMaker ڈومین ID درج کریں جو آپ نے ضروری مراحل میں تیار کی ہے۔

- میں سے انتخاب کریں اگلے.

- اگلے صفحے پر، منتخب کریں۔ اگلے.

- حتمی صفحہ پر تفصیلات کا جائزہ لیں اور منتخب کریں۔ میں تسلیم کرتا ہوں کہ AWS CloudFormation IAM وسائل پیدا کر سکتا ہے۔.

- میں سے انتخاب کریں تخلیق کریں.

اسٹیک بنانے میں 10 منٹ تک لگ سکتے ہیں۔ اسٹیک دو شخصیات کے لیے IAM رولز اور SageMaker صارف پروفائلز بناتا ہے: ڈیٹا انجینئر اور ڈیٹا سائنسدان۔ یہ ایک ڈیٹا بیس ڈیمو اور ٹیبل بھی بناتا ہے۔ web_marketing نمونہ ڈیٹاسیٹ کے ساتھ۔

اسٹیک بنانے کے وقت، ڈیٹا انجینئر شخصیت کو ٹیبل تک مکمل رسائی حاصل ہوتی ہے، لیکن ڈیٹا سائنسدان شخصیت کو ابھی تک ٹیبل تک کوئی رسائی حاصل نہیں ہے۔

ڈیٹا سیٹ کو پہلے سے پروسیس کریں۔

آئیے AWS Glue کے انٹرایکٹو سیشن پر ڈیٹا کی پری پروسیسنگ شروع کریں۔ ڈیٹا انجینئر شخصیت ڈیٹا کی تصدیق کرنا چاہتا ہے تاکہ یہ معلوم ہو سکے کہ آیا وہاں حساس ڈیٹا ہے یا نہیں، اور ڈیٹا سائنسدان شخصیت کو کم سے کم رسائی کی اجازت دینا چاہتا ہے۔ سے نوٹ بک ڈاؤن لوڈ کر سکتے ہیں۔ یہ مقام.

- ڈیٹا انجینئر صارف کا استعمال کرتے ہوئے کنسول میں سائن ان کریں۔

- سیج میکر کنسول پر، منتخب کریں۔ صارفین.

- ڈیٹا انجینئر صارف کو منتخب کریں اور منتخب کریں۔ سٹوڈیو کھولیں۔.

- ایک نئی نوٹ بک بنائیں اور منتخب کریں۔ SparkAnalytics 1.0 لیے تصویر اور گلو پی اسپارک لیے دانا.

- Boto3 کے نئے ورژن کو انسٹال کرنے کے لیے درج ذیل جادو کے ساتھ ایک انٹرایکٹو سیشن شروع کریں (یہ استعمال کرنے کے لیے ضروری ہے۔

create_data_cells_filterطریقہ): - سیشن شروع کریں:

- نئے بنائے گئے ٹیبل سے AWS Glue DynamicFrame بنائیں، اور انتخاب کی اقسام کو حل کریں۔ کیٹلاگ اسکیما کی بنیاد پر، کیونکہ ہم ڈیٹا کی بنیاد پر خود بخود قیاس شدہ اسکیما کے بجائے کیٹلاگ میں بیان کردہ اسکیما کو استعمال کرنا چاہتے ہیں:

- ٹیبل میں تصدیق کریں کہ آیا AWS Glue PII کا پتہ لگانے کا استعمال کرتے ہوئے کوئی PII ڈیٹا موجود ہے:

- تصدیق کریں کہ آیا PII کے طور پر درجہ بند کالموں میں حساس ڈیٹا ہے یا نہیں (اگر نہیں، تو غیر حساس کالموں کو چھوڑنے کے لیے classified_map کو اپ ڈیٹ کریں):

- خودکار طور پر پائے جانے والے کالمز کے لیے ڈیٹا سیل فلٹر کا استعمال کرتے ہوئے لیک فارمیشن کی اجازتیں مرتب کریں، اور کالموں کو ڈیٹا سائنسدان شخصیت تک محدود رکھیں:

- یہ دیکھنے کے لیے کہ PII کالم دکھائی نہیں دے رہے ہیں، ڈیٹا سائنسدان کے بطور اسٹوڈیو میں لاگ ان کریں۔ سے نوٹ بک ڈاؤن لوڈ کر سکتے ہیں۔ یہ مقام.

- ایک نئی نوٹ بک بنائیں اور منتخب کریں۔ SparkAnalytics 1.0 لیے تصویر اور گلو پی اسپارک لیے دانا:

فیچر انجینئرنگ انجام دیں۔

ہم ڈیٹا سائنسدان صارف کے طور پر فیچر انجینئرنگ انجام دینے کے لیے Apache Spark ML لائبریری کا استعمال کرتے ہیں اور پھر آؤٹ پٹ کو Amazon S3 پر لکھتے ہیں۔

- درج ذیل سیل میں، ہم سے خصوصیات کا اطلاق کرتے ہیں۔ اپاچی اسپارک ایم ایل لائبریری:

StringIndexerلیبل کے ایک سٹرنگ کالم کو لیبل انڈیکس کے کالم سے نقشہ بناتا ہے۔OneHotEncoderایک زمرہ کی خصوصیت کا نقشہ بناتا ہے، جس کی نمائندگی لیبل انڈیکس کے طور پر کی جاتی ہے، زیادہ سے زیادہ ایک واحد قدر کے ساتھ ایک بائنری ویکٹر پر جو ایک مخصوص زمرہ کی خصوصیت کی موجودگی کی نشاندہی کرتی ہے۔ یہ تبدیلی ML الگورتھم کے لیے استعمال ہوتی ہے جو مسلسل خصوصیات کی توقع کرتے ہیں۔VectorAssemblerایک ٹرانسفارمر ہے جو کالموں کی دی گئی فہرست کو ایک واحد ویکٹر کالم میں جوڑتا ہے، جو پھر الگورتھم جیسے لاجسٹک ریگریشن اور فیصلے کے درختوں کے لیے ML ماڈلز کی تربیت میں استعمال ہوتا ہے۔

- حتمی تبدیل شدہ ڈیٹا فریم پائپ لائن لائبریری کا استعمال کرتے ہوئے بنایا جا سکتا ہے۔ ایک پائپ لائن کو مراحل کی ترتیب کے طور پر بیان کیا گیا ہے۔ یہ مراحل ترتیب سے چلائے جاتے ہیں اور ان پٹ ڈیٹا فریم ہر مرحلے سے گزرتے ہی تبدیل ہو جاتا ہے۔

- اس کے بعد، ہم ڈیٹا سیٹ کو ٹرین میں تقسیم کرتے ہیں، ڈیٹا فریم کی توثیق کرتے ہیں اور ٹیسٹ کرتے ہیں اور ML ماڈل کو تربیت دینے کے لیے اسے S3 بالٹی میں محفوظ کرتے ہیں (مندرجہ ذیل کوڈ میں اپنا AWS اکاؤنٹ ID فراہم کریں):

ایم ایل ماڈل کو ٹرین اور تعینات کریں۔

پچھلے حصے میں، ہم نے فیچر انجینئرنگ مکمل کی، جس میں کنورٹنگ سٹرنگ کالم شامل تھے۔ region, jobrole، اور usedpromo ایک فارمیٹ میں جو ایم ایل ماڈلز کے لیے بہترین ہے۔ ہم نے کالم بھی شامل کیے جیسے pageviewspervisit اور totalwebvisits، جو ہمیں ایک پروڈکٹ خریدنے کے لیے گاہک کے رجحان کا اندازہ لگانے میں مدد کرے گا۔

اب ہم SageMaker بلٹ ان XGBoost الگورتھم کا استعمال کرتے ہوئے ٹرین اور توثیق ڈیٹاسیٹ کو پڑھ کر ایک ML ماڈل کو تربیت دیتے ہیں۔ پھر ہم ماڈل کو تعینات کرتے ہیں اور درستگی کی جانچ کرتے ہیں۔ سے نوٹ بک ڈاؤن لوڈ کر سکتے ہیں۔ یہ مقام.

درج ذیل سیل میں، ہم دوسری S3 بالٹی سے ڈیٹا پڑھ رہے ہیں، جس میں ہمارے فیچر انجینئرنگ آپریشنز کا آؤٹ پٹ شامل ہے۔ پھر ہم ماڈل کو تربیت دینے کے لیے بلٹ ان الگورتھم XGBoost استعمال کرتے ہیں۔

- ایک نئی نوٹ بک کھولیں۔ منتخب کریں۔ ڈیٹا سائنس لیے تصویر اور ازگر 3 لیے دانا (مندرجہ ذیل کوڈ میں اپنا AWS اکاؤنٹ ID فراہم کریں):

- تربیت مکمل ہونے پر، ہم SageMaker ہوسٹنگ سروسز کا استعمال کرتے ہوئے ماڈل کو تعینات کر سکتے ہیں:

ایم ایل ماڈل کا اندازہ کریں۔

ہم ٹیسٹ ڈیٹاسیٹ کا استعمال ماڈل کا جائزہ لینے کے لیے کرتے ہیں اور کسی بھی جاری چارجز سے بچنے کے لیے جب ہم مکمل کر لیتے ہیں تو انفرنس اینڈ پوائنٹ کو حذف کر دیتے ہیں۔

- مندرجہ ذیل کوڈ کے ساتھ ماڈل کا اندازہ کریں:

نمونہ چلانے کے لیے درستگی کا نتیجہ %84.6 تھا۔ ڈیٹاسیٹ کی بے ترتیب تقسیم کی وجہ سے یہ آپ کی دوڑ کے لیے قدرے مختلف ہو سکتا ہے۔

- ہم مندرجہ ذیل کوڈ کے ساتھ انفرنس اینڈ پوائنٹ کو حذف کر سکتے ہیں:

صاف کرو

اب آخری مرحلے پر، وسائل کو صاف کرنا۔

- CloudFormation اسٹیک کے ذریعے بنائی گئی دو بالٹیاں خالی کریں۔

- صارف سے وابستہ ایپس کو حذف کریں۔

profiles data-scientistاورdata-engineerسٹوڈیو کے اندر - CloudFormation اسٹیک کو حذف کریں۔

نتیجہ

اس پوسٹ میں، ہم نے ایک ایسے حل کا مظاہرہ کیا جو ڈیٹا انجینئرز اور ڈیٹا سائنسدانوں جیسے لوگوں کو فیچر انجینئرنگ کو پیمانے پر انجام دینے کے قابل بناتا ہے۔ AWS Glue انٹرایکٹو سیشنز کے ساتھ، آپ کسی بھی بنیادی ڈھانچے کو منظم کرنے کی ضرورت کے بغیر خودکار PII کا پتہ لگانے اور عمدہ رسائی کنٹرول کے ساتھ پیمانے پر فیچر انجینئرنگ آسانی سے حاصل کر سکتے ہیں۔ اسٹوڈیو کو سنگل انٹری پوائنٹ کے طور پر استعمال کر کے، آپ اینڈ ٹو اینڈ ایم ایل ورک فلو بنانے کے لیے ایک آسان اور مربوط تجربہ حاصل کر سکتے ہیں: ڈیٹا کی تیاری اور حفاظت سے لے کر ایم ایل ماڈلز کی تعمیر، تربیت، ٹیوننگ اور تعیناتی تک۔ مزید جاننے کے لیے، ملاحظہ کریں۔ AWS Glue انٹرایکٹو سیشن کے ساتھ شروع کرنا اور ایمیزون سیج میکر اسٹوڈیو.

ہم اس نئی صلاحیت کے بارے میں بہت پرجوش ہیں اور یہ دیکھنے کے خواہاں ہیں کہ آپ اس کے ساتھ کیا بنانے جا رہے ہیں!

ضمیمہ: کنسول اور AWS CLI کے ذریعے وسائل مرتب کریں۔

CloudFormation ٹیمپلیٹ کے بجائے کنسول اور AWS CLI کا استعمال کرتے ہوئے وسائل ترتیب دینے کے لیے اس سیکشن میں دی گئی ہدایات کو مکمل کریں۔

شرائط

اس ٹیوٹوریل کو مکمل کرنے کے لیے، آپ کو AWS CLI تک رسائی حاصل ہونی چاہیے (دیکھیں۔ AWS CLI کے ساتھ شروع کرنا) یا کمانڈ لائن تک رسائی کا استعمال کریں۔ AWS CloudShell.

IAM گروپ، صارفین، کردار اور پالیسیاں ترتیب دیں۔

اس سیکشن میں، ہم دو IAM صارفین بناتے ہیں: ڈیٹا-انجینئر اور ڈیٹا-سائنٹسٹ، جو IAM گروپ ڈیٹا-پلیٹ فارم-گروپ سے تعلق رکھتے ہیں۔ پھر ہم IAM گروپ میں ایک واحد IAM پالیسی شامل کرتے ہیں۔

- IAM کنسول پر، JSON ٹیب پر پالیسی بنائیں نام کی ایک نئی IAM کے زیر انتظام پالیسی بنانے کے لیے

DataPlatformGroupPolicy. پالیسی گروپ میں صارفین کو اسٹوڈیو تک رسائی کی اجازت دیتی ہے، لیکن صرف ایک ٹیگ کے ساتھ SageMaker صارف پروفائل کا استعمال کرتے ہوئے جو ان کے IAM صارف نام سے ملتا ہے۔ اجازتیں فراہم کرنے کے لیے درج ذیل JSON پالیسی دستاویز کا استعمال کریں: - ایک IAM گروپ بنائیں کہا جاتا ہے

data-platform-group. - ڈیٹا پلیٹ فارم گروپ پالیسی نامی AWS مینیجڈ پالیسی کو تلاش کریں اور گروپ میں منسلک کریں۔

- IAM صارفین بنائیں IAM گروپ ڈیٹا پلیٹ فارم گروپ کے تحت ڈیٹا انجینئر اور ڈیٹا سائنسدان کہا جاتا ہے۔

- ایک نئی منظم پالیسی بنائیں SageMakerExecutionPolicy کے نام سے (مندرجہ ذیل کوڈ میں اپنا علاقہ اور اکاؤنٹ ID فراہم کریں):

- ایک نئی منظم پالیسی بنائیں نام

SageMakerAdminPolicy: - ایک IAM کردار بنائیں ڈیٹا انجینئر (ڈیٹا انجینئر) کے لیے SageMaker کے لیے، جو متعلقہ صارف پروفائل کے ایگزیکیوشن رول کے طور پر استعمال ہوتا ہے۔ پر اجازت کی پالیسی منسلک کریں۔ صفحہ، AmazonSageMakerFullAccess (AWS مینیجڈ پالیسی) بطور ڈیفالٹ منسلک ہے۔ کم از کم استحقاق برقرار رکھنے کے لیے آپ بعد میں اس پالیسی کو ہٹا دیتے ہیں۔

- کے لئے کردار کا نامSageMakerStudioExecutionRole_data-engineer کے کردار کو نام دینے کے لیے اس سیکشن کے شروع میں متعارف کرائے گئے نام کنونشن کا استعمال کریں۔

- کے لئے ٹیگز، کلیدی صارف پروفائل نام اور ویلیو ڈیٹا انجینئر شامل کریں۔

- میں سے انتخاب کریں کردار بنائیں.

- باقی پالیسیاں شامل کرنے کے لیے، پر رولز صفحہ، کردار کا نام منتخب کریں جو آپ نے ابھی بنایا ہے۔

- کے تحت اجازت، AmazonSageMakerFullAccess پالیسی کو ہٹا دیں۔

- پر اجازت کی پالیسی منسلک کریں۔ صفحہ، AWS کے زیر انتظام پالیسی AwsGlueSessionUserRestrictedServiceRole، اور کسٹمر کے زیر انتظام پالیسیاں SageMakerExecutionPolicy اور SageMakerAdminPolicy جو آپ نے بنائی ہیں منتخب کریں۔

- میں سے انتخاب کریں پالیسیاں منسلک کریں۔.

- میں ترمیم کریں آپ کے کردار کا اعتماد کا رشتہ:

- ایک IAM کردار بنائیں ڈیٹا سائنسدان (ڈیٹا سائنسدان) کے لیے SageMaker کے لیے، جو متعلقہ صارف پروفائل کے ایگزیکیوشن رول کے طور پر استعمال ہوتا ہے۔

- کے لئے کردار کا نامSageMakerStudioExecutionRole_data-scientist کے کردار کا نام دیں۔

- کے لئے ٹیگز، کلیدی صارف پروفائل نام اور ویلیو ڈیٹا سائنسدان شامل کریں۔

- میں سے انتخاب کریں کردار بنائیں.

- باقی پالیسیاں شامل کرنے کے لیے، پر رولز صفحہ، کردار کا نام منتخب کریں جو آپ نے ابھی بنایا ہے۔

- کے تحت اجازت، AmazonSageMakerFullAccess پالیسی کو ہٹا دیں۔

- پر اجازت کی پالیسی منسلک کریں۔ صفحہ، AWS کے زیر انتظام پالیسی AwsGlueSessionUserRestrictedServiceRole، اور کسٹمر کے زیر انتظام پالیسی SageMakerExecutionPolicy جو آپ نے بنائی ہے منتخب کریں۔

- میں سے انتخاب کریں پالیسیاں منسلک کریں۔.

- میں ترمیم کریں آپ کے کردار کا اعتماد کا رشتہ:

سیج میکر صارف پروفائلز کو ترتیب دیں۔

کے ساتھ اپنے سیج میکر صارف پروفائلز بنانے کے لیے studiouserid ٹیگ، درج ذیل مراحل کو مکمل کریں:

- ڈیٹا انجینئر کے لیے اسٹوڈیو صارف پروفائل بنانے کے لیے AWS CLI یا CloudShell کا استعمال کریں (مندرجہ ذیل کوڈ میں اپنا اکاؤنٹ ID اور اسٹوڈیو ڈومین ID فراہم کریں):

- اکاؤنٹ آئی ڈی اور اسٹوڈیو ڈومین آئی ڈی کو تبدیل کرتے ہوئے ڈیٹا سائنسدان کے لیے صارف پروفائل بنانے کے لیے مرحلہ دہرائیں:

S3 بالٹیاں بنائیں اور نمونہ ڈیٹا سیٹ اپ لوڈ کریں۔

اس سیکشن میں، آپ دو S3 بالٹیاں بناتے ہیں۔ پہلی بالٹی میں ویب مارکیٹنگ سے متعلق ایک نمونہ ڈیٹاسیٹ ہے۔ دوسری بالٹی ڈیٹا سائنسدان کے ذریعہ فیچر انجینئرنگ کے کاموں سے آؤٹ پٹ کو ذخیرہ کرنے کے لیے استعمال کیا جاتا ہے، اور اس آؤٹ پٹ ڈیٹاسیٹ کو ایم ایل ماڈل کی تربیت کے لیے استعمال کیا جاتا ہے۔

سب سے پہلے، ان پٹ ڈیٹا کے لیے S3 بالٹی بنائیں:

- لوڈ ڈیٹاسیٹ.

- ایمیزون S3 کنسول پر، منتخب کریں۔ بالٹیاں۔ نیوی گیشن پین میں.

- میں سے انتخاب کریں بالٹی بنائیں.

- کے لئے ریجنSageMaker ڈومین کے ساتھ وہ علاقہ منتخب کریں جس میں آپ کے بنائے گئے صارف پروفائلز شامل ہوں۔

- کے لئے بالٹی کا نام، داخل کریں

blog-studio-pii-dataset-. - میں سے انتخاب کریں بالٹی بنائیں.

- اپنی بنائی ہوئی بالٹی کو منتخب کریں اور منتخب کریں۔ اپ لوڈ کریں.

- میں فائلوں کا انتخاب کریں سیکشن کا انتخاب کریں، فائلیں شامل کریں اور اپنے ڈاؤن لوڈ کردہ ڈیٹاسیٹ کو اپ لوڈ کریں۔

اب آپ آؤٹ پٹ ڈیٹا کے لیے بالٹی بناتے ہیں: - پر بالٹیاں۔ صفحہ، منتخب کریں بالٹی بنائیں.

- کے لئے ریجنSageMaker ڈومین کے ساتھ وہ علاقہ منتخب کریں جس میں آپ کے بنائے گئے صارف پروفائلز شامل ہوں۔

- کے لئے بالٹی کا نام، داخل کریں

blog-studio-output-. - میں سے انتخاب کریں بالٹی بنائیں.

AWS Glue ڈیٹا بیس اور ٹیبل بنائیں

اس سیکشن میں، آپ ڈیٹاسیٹ کے لیے AWS Glue ڈیٹا بیس اور ٹیبل بناتے ہیں۔

- جھیل فارمیشن کنسول پر، نیچے ڈیٹا کیٹلاگ نیویگیشن پین میں، منتخب کریں۔ ڈیٹا بیس.

- میں سے انتخاب کریں ڈیٹا بیس شامل کریں۔.

- کے لئے نام، ڈیمو درج کریں۔

- میں سے انتخاب کریں ڈیٹا بیس بنائیں.

- کے تحت ڈیٹا کیٹلاگمنتخب کریں میزیں.

- کے لئے نام، داخل کریں

web_marketing. - کے لئے ڈیٹا بیسمنتخب

demo. - کے لئے راستہ شامل کریں۔ان پٹ ڈیٹا کے لیے اپنی S3 بالٹی کا راستہ درج کریں۔

- کے لئے کی درجہ بندیمنتخب کریں CSV.

- کے تحت سکیممنتخب کریں اسکیما اپ لوڈ کریں۔.

- ٹیکسٹ باکس میں درج ذیل JSON سرنی درج کریں:

- میں سے انتخاب کریں اپ لوڈ کریں.

- میں سے انتخاب کریں جمع کرائیں.

- کے تحت ٹیبل کی تفصیلاتمنتخب کریں ٹیبل میں ترمیم کریں۔.

- کے تحت ٹیبل کی خصوصیاتمنتخب کریں شامل کریں.

- کے لئے کلیدی، داخل کریں

skip.header.line.count، کے لئے قدر، 1 درج کریں۔ - میں سے انتخاب کریں محفوظ کریں.

جھیل کی تشکیل کی اجازتوں کو ترتیب دیں۔

اس سیکشن میں، آپ IAM کے کردار کی اجازت دینے کے لیے Lake Formation کی اجازتیں ترتیب دیتے ہیں۔ SageMakerStudioExecutionRole_data-engineer ایک ڈیٹا بیس بنانے اور S3 لوکیشن کو لیک فارمیشن میں رجسٹر کرنے کے لیے۔

سب سے پہلے، جھیل کی تشکیل کی اجازتوں میں مقام کے تحت میزوں کا نظم کرنے کے لیے ڈیٹا لیک لوکیشن کو رجسٹر کریں:

- میں سے انتخاب کریں ڈیٹا جھیل کے مقامات.

- میں سے انتخاب کریں رجسٹر مقام.

- کے لئے ایمیزون S3 کا راستہ، داخل کریں

s3://blog-studio-pii-dataset-/(وہ بالٹی جس میں ڈیٹاسیٹ ہوتا ہے)۔ - میں سے انتخاب کریں رجسٹر مقام.

اب آپ IAM کے کرداروں کو لیک فارمیشن ڈیٹا بیس اور ٹیبل کی اجازت دیتے ہیں۔SageMakerStudioExecutionRole_data-engineerاورSageMakerStudioExecutionRole_data-scientist.سب سے پہلے، کے لیے ڈیٹا بیس کی اجازت دیں۔SageMakerStudioExecutionRole_data-engineer: - کے تحت اجازتمنتخب کریں ڈیٹا لیک کی اجازت.

- کے تحت ڈیٹا کی اجازتمنتخب کریں گرانٹ.

- کے لئے پرنسپلمنتخب کریں IAM صارفین اور کردار، اور کردار کو منتخب کریں۔

SageMakerStudioExecutionRole_data-engineer. - کے لئے پالیسی ٹیگز یا کیٹلاگ وسائلمنتخب کریں نامزد ڈیٹا کیٹلاگ وسائل.

- کے لئے ڈیٹا بیس، ڈیمو کا انتخاب کریں۔

- کے لئے ڈیٹا بیس کی اجازت، منتخب سپر.

- میں سے انتخاب کریں گرانٹ.

اگلا، کے لیے ٹیبل کی اجازت دیں۔SageMakerStudioExecutionRole_data-engineer: - کے تحت ڈیٹا کی اجازتمنتخب کریں گرانٹ.

- کے لئے پرنسپلمنتخب کریں IAM صارفین اور کردار، اور کردار کو منتخب کریں۔

SageMakerStudioExecutionRole_data-engineer. - کے لئے پالیسی ٹیگز یا کیٹلاگ وسائلمنتخب کریں نامزد ڈیٹا کیٹلاگ وسائل.

- کے لئے ڈیٹا بیسمنتخب کریں

demo. - کے لئے میزیںمنتخب کریں

web_marketing. - کے لئے ٹیبل اجازتیں، منتخب سپر.

- کے لئے گرانٹ ایبل اجازتیں، منتخب سپر.

- میں سے انتخاب کریں گرانٹ.

آخر میں، کے لیے ڈیٹا بیس کی اجازت دیں۔SageMakerStudioExecutionRole_data-scientist: - کے تحت ڈیٹا کی اجازتمنتخب کریں گرانٹ.

- کے لئے پرنسپلمنتخب کریں IAM صارفین اور کردار، اور کردار کو منتخب کریں۔

SageMakerStudioExecutionRole_data-scientist. - کے لئے پالیسی ٹیگز یا کیٹلاگ وسائلمنتخب کریں نامزد ڈیٹا کیٹلاگ وسائل.

- کے لئے ڈیٹا بیسمنتخب کریں

demo. - کے لئے ڈیٹا بیس کی اجازت، منتخب بیان.

- میں سے انتخاب کریں گرانٹ.

مصنفین کے بارے میں

پروین کمار AWS میں ایک تجزیاتی حل آرکیٹیکٹ ہے جس میں کلاؤڈ-مقامی خدمات کا استعمال کرتے ہوئے جدید ڈیٹا اور تجزیاتی پلیٹ فارمز کو ڈیزائن کرنے، بنانے اور ان پر عمل درآمد کرنے میں مہارت حاصل ہے۔ اس کی دلچسپی کے شعبے سرور لیس ٹیکنالوجی، جدید کلاؤڈ ڈیٹا گودام، اسٹریمنگ، اور ایم ایل ایپلی کیشنز ہیں۔

نوریٹاکا سیکیاما AWS Glue ٹیم میں ایک پرنسپل بگ ڈیٹا آرکیٹیکٹ ہے۔ وہ اس پوسٹ کی طرح نتائج فراہم کرنے کے لیے مختلف ٹیموں کے ساتھ تعاون سے لطف اندوز ہوتا ہے۔ اپنے فارغ وقت میں، وہ اپنے خاندان کے ساتھ ویڈیو گیمز کھیلنے سے لطف اندوز ہوتا ہے۔

- اعلی درجے کی (300)

- AI

- ai آرٹ

- AI آرٹ جنریٹر

- عی روبوٹ

- ایمیزون سیج میکر

- مصنوعی ذہانت

- مصنوعی ذہانت کا سرٹیفیکیشن

- بینکنگ میں مصنوعی ذہانت

- مصنوعی ذہانت والا روبوٹ

- مصنوعی ذہانت والے روبوٹ

- مصنوعی ذہانت سافٹ ویئر

- AWS بگ ڈیٹا

- AWS گلو

- AWS جھیل کی تشکیل

- AWS مشین لرننگ

- blockchain

- بلاکچین کانفرنس

- coingenius

- بات چیت مصنوعی ذہانت

- crypto کانفرنس ai

- dall-e

- گہری سیکھنے

- گوگل عی

- مشین لرننگ

- پلاٹا

- افلاطون اے

- افلاطون ڈیٹا انٹیلی جنس

- افلاطون گیم

- پلیٹو ڈیٹا

- پلیٹو گیمنگ

- پیمانہ ai

- نحو

- سوچا قیادت۔

- زیفیرنیٹ