آج، ہم یہ اعلان کرتے ہوئے پرجوش ہیں کہ میٹا کے تیار کردہ لاما 2 فاؤنڈیشن ماڈلز صارفین کے لیے دستیاب ہیں۔ ایمیزون سیج میکر جمپ اسٹارٹ. لاما 2 فیملی آف لارج لینگویج ماڈلز (LLMs) 7 بلین سے 70 بلین پیرامیٹرز کے پیمانے پر پہلے سے تربیت یافتہ اور ٹھیک ٹیونڈ جنریٹو ٹیکسٹ ماڈلز کا مجموعہ ہے۔ فائن ٹیونڈ LLMs، جسے Llama-2-chat کہا جاتا ہے، ڈائیلاگ کے استعمال کے معاملات کے لیے موزوں ہیں۔ آپ آسانی سے ان ماڈلز کو آزما سکتے ہیں اور انہیں SageMaker JumpStart کے ساتھ استعمال کر سکتے ہیں، جو کہ ایک مشین لرننگ (ML) مرکز ہے جو الگورتھم، ماڈلز، اور ML سلوشنز تک رسائی فراہم کرتا ہے تاکہ آپ ML کے ساتھ تیزی سے شروعات کر سکیں۔

اس پوسٹ میں، ہم SageMaker JumpStart کے ذریعے Llama 2 ماڈلز کو استعمال کرنے کے طریقہ پر چلتے ہیں۔

لاما 2 کیا ہے؟

Llama 2 ایک خودکار رجعت پسند زبان کا ماڈل ہے جو ایک بہتر ٹرانسفارمر فن تعمیر کا استعمال کرتا ہے۔ Llama 2 انگریزی میں تجارتی اور تحقیقی استعمال کے لیے ہے۔ یہ پیرامیٹر سائز کی ایک رینج میں آتا ہے — 7 بلین، 13 بلین، اور 70 بلین — نیز پہلے سے تربیت یافتہ اور ٹھیک ٹیونڈ تغیرات۔ میٹا کے مطابق، ٹیون شدہ ورژنز سپروائزڈ فائن ٹیوننگ (SFT) اور ہیومن فیڈ بیک (RLHF) کے ساتھ کمک سیکھنے کا استعمال کرتے ہیں تاکہ مدد اور حفاظت کے لیے انسانی ترجیحات کے مطابق ہوں۔ لاما 2 کو عوامی طور پر دستیاب ذرائع سے ڈیٹا کے 2 ٹریلین ٹوکنز پر پہلے سے تربیت دی گئی تھی۔ ٹیون شدہ ماڈلز اسسٹنٹ کی طرح چیٹ کے لیے بنائے گئے ہیں، جبکہ پہلے سے تربیت یافتہ ماڈلز کو قدرتی زبان کی تخلیق کے مختلف کاموں کے لیے ڈھالا جا سکتا ہے۔ اس سے قطع نظر کہ ایک ڈویلپر ماڈل کا کون سا ورژن استعمال کرتا ہے، میٹا کی طرف سے ذمہ دار استعمال گائیڈ اضافی فائن ٹیوننگ کی رہنمائی میں مدد کر سکتا ہے جو مناسب حفاظتی تخفیف کے ساتھ ماڈلز کو اپنی مرضی کے مطابق اور بہتر بنانے کے لیے ضروری ہو سکتا ہے۔

سیج میکر جمپ اسٹارٹ کیا ہے؟

With SageMaker JumpStart, ML practitioners can choose from a broad selection of open source foundation models. ML practitioners can deploy foundation models to dedicated ایمیزون سیج میکر نیٹ ورک الگ تھلگ ماحول سے مثالیں اور ماڈل ٹریننگ اور تعیناتی کے لیے SageMaker کا استعمال کرتے ہوئے ماڈلز کو اپنی مرضی کے مطابق بنائیں۔

اب آپ چند کلکس کے ساتھ لاما 2 کو دریافت اور تعینات کر سکتے ہیں۔ ایمیزون سیج میکر اسٹوڈیو یا پروگرامی طور پر SageMaker Python SDK کے ذریعے، آپ کو SageMaker خصوصیات کے ساتھ ماڈل کی کارکردگی اور MLOps کنٹرول حاصل کرنے کے قابل بناتا ہے جیسے ایمیزون سیج میکر پائپ لائنز, ایمیزون سیج میکر ڈیبگر، یا کنٹینر لاگز۔ ماڈل کو AWS محفوظ ماحول میں اور آپ کے VPC کنٹرولز کے تحت تعینات کیا گیا ہے، جو ڈیٹا کی حفاظت کو یقینی بنانے میں مدد کرتا ہے۔ لاما 2 ماڈل آج ایمیزون سیج میکر اسٹوڈیو میں دستیاب ہیں، ابتدائی طور پر us-east 1 اور us-west 2 خطوں.

ماڈلز دریافت کریں۔

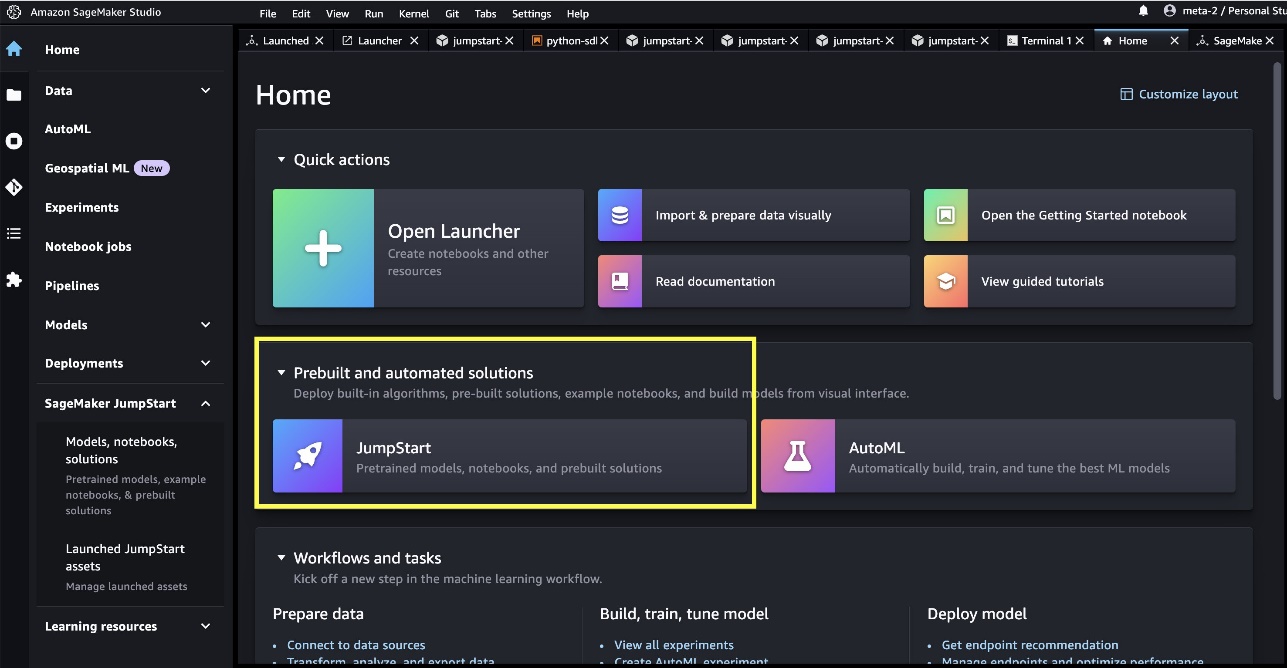

آپ SageMaker Studio UI اور SageMaker Python SDK میں SageMaker JumpStart کے ذریعے فاؤنڈیشن ماڈلز تک رسائی حاصل کر سکتے ہیں۔ اس سیکشن میں، ہم سیج میکر اسٹوڈیو میں ماڈلز کو دریافت کرنے کا طریقہ دیکھتے ہیں۔

سیج میکر اسٹوڈیو ایک مربوط ترقیاتی ماحول (IDE) ہے جو ایک واحد ویب پر مبنی بصری انٹرفیس فراہم کرتا ہے جہاں آپ ڈیٹا کی تیاری سے لے کر اپنے ML ماڈلز کی تعمیر، تربیت، اور تعیناتی تک تمام ML ترقیاتی مراحل کو انجام دینے کے لیے مقصد کے لیے بنائے گئے ٹولز تک رسائی حاصل کر سکتے ہیں۔ شروع کرنے اور SageMaker اسٹوڈیو کو ترتیب دینے کے طریقے کے بارے میں مزید تفصیلات کے لیے، رجوع کریں۔ ایمیزون سیج میکر اسٹوڈیو.

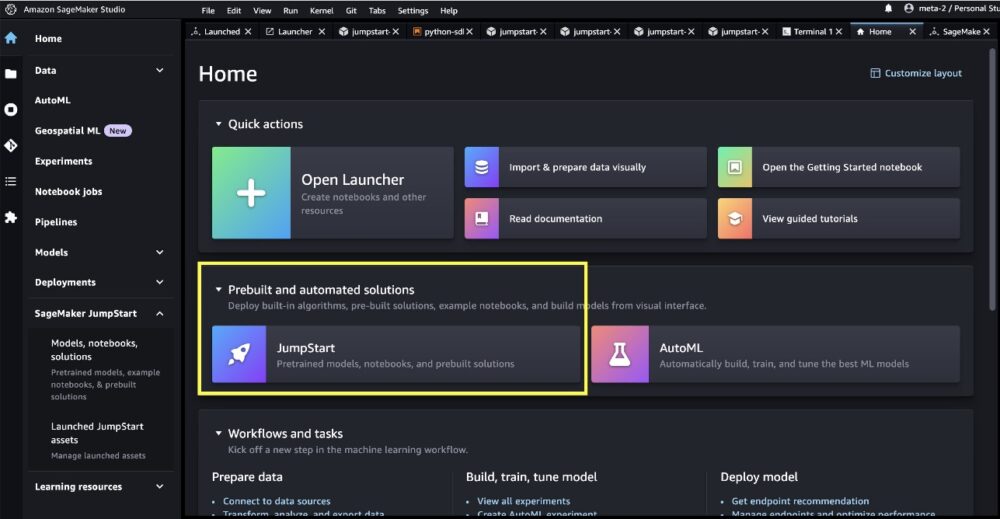

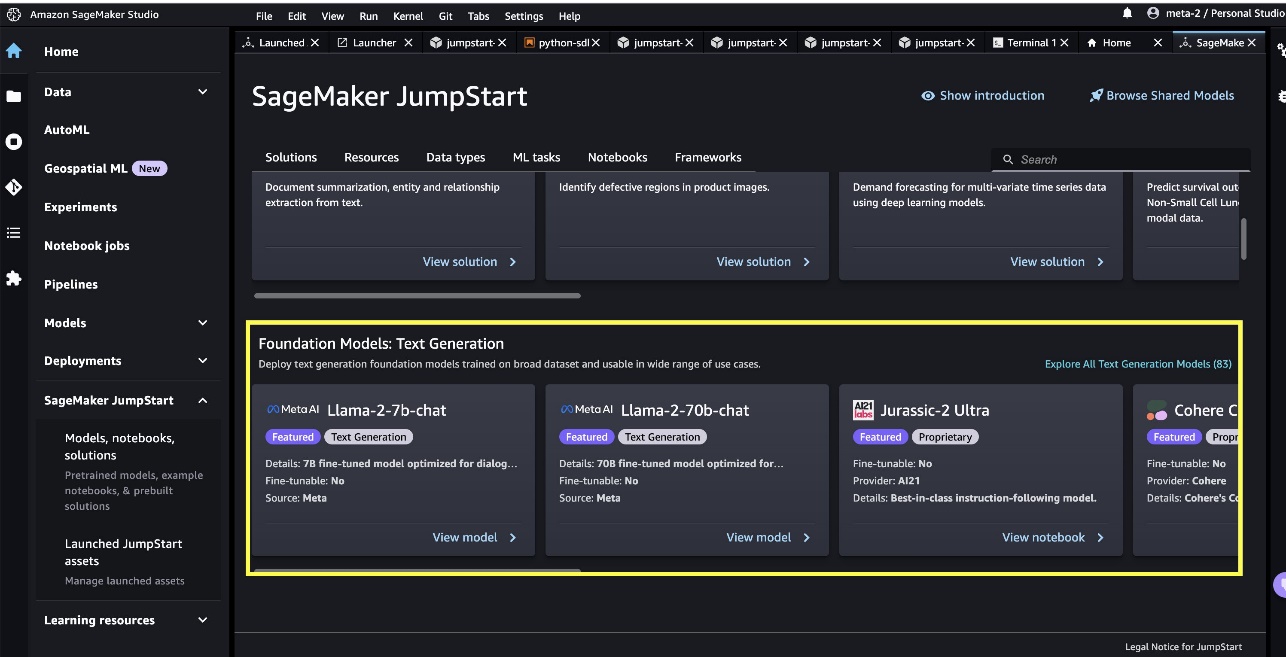

سیج میکر اسٹوڈیو پر آنے کے بعد، آپ سیج میکر جمپ اسٹارٹ تک رسائی حاصل کر سکتے ہیں، جس میں پہلے سے تربیت یافتہ ماڈلز، نوٹ بکس اور پہلے سے تیار کردہ حل شامل ہیں۔ پہلے سے تعمیر شدہ اور خودکار حل.

سیج میکر جمپ اسٹارٹ لینڈنگ پیج سے، آپ حل، ماڈل، نوٹ بک اور دیگر وسائل کو براؤز کر سکتے ہیں۔ آپ کو دو فلیگ شپ لاما 2 ماڈل مل سکتے ہیں۔ فاؤنڈیشن ماڈل: ٹیکسٹ جنریشن carousel. If you don’t see Llama 2 models, update your SageMaker Studio version by shutting down and restarting. For more information about version updates, refer to اسٹوڈیو ایپس کو بند کریں اور اپ ڈیٹ کریں۔.

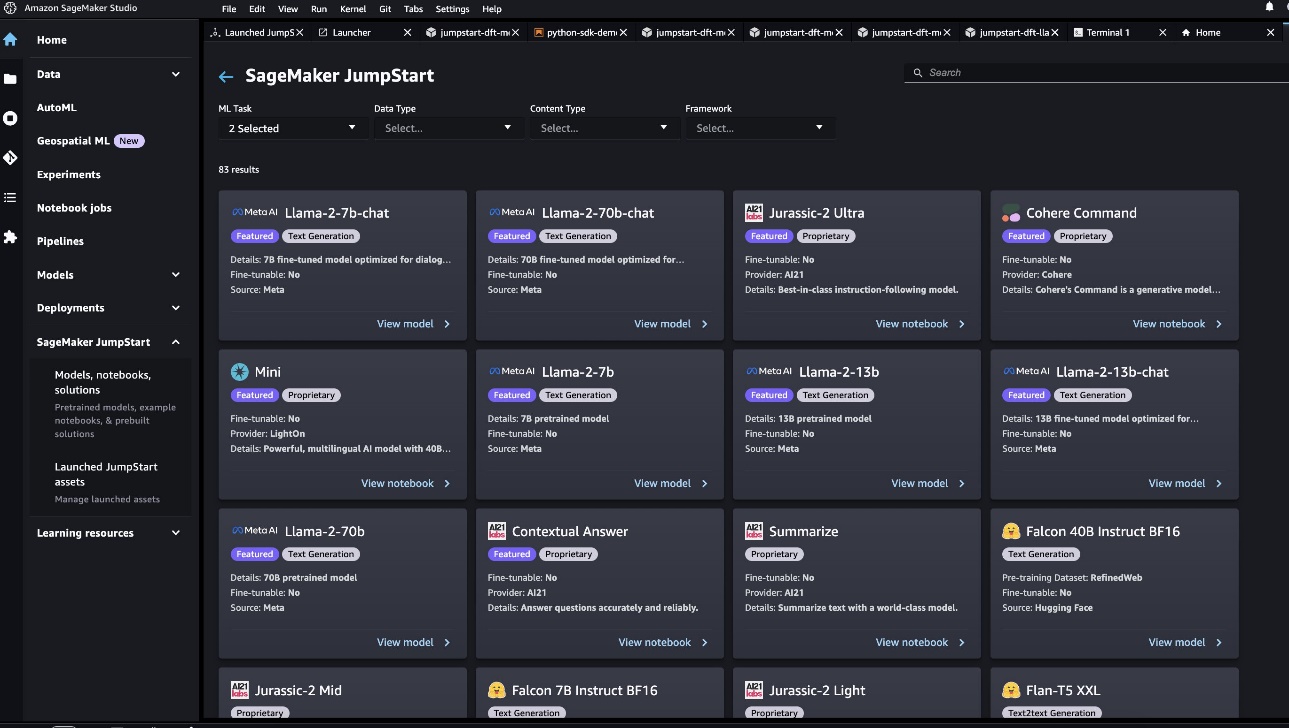

آپ دیگر چار ماڈل کی مختلف حالتیں بھی منتخب کر کے تلاش کر سکتے ہیں۔ تمام ٹیکسٹ جنریشن ماڈلز کو دریافت کریں۔ یا تلاش کرنا llama تلاش کے باکس میں.

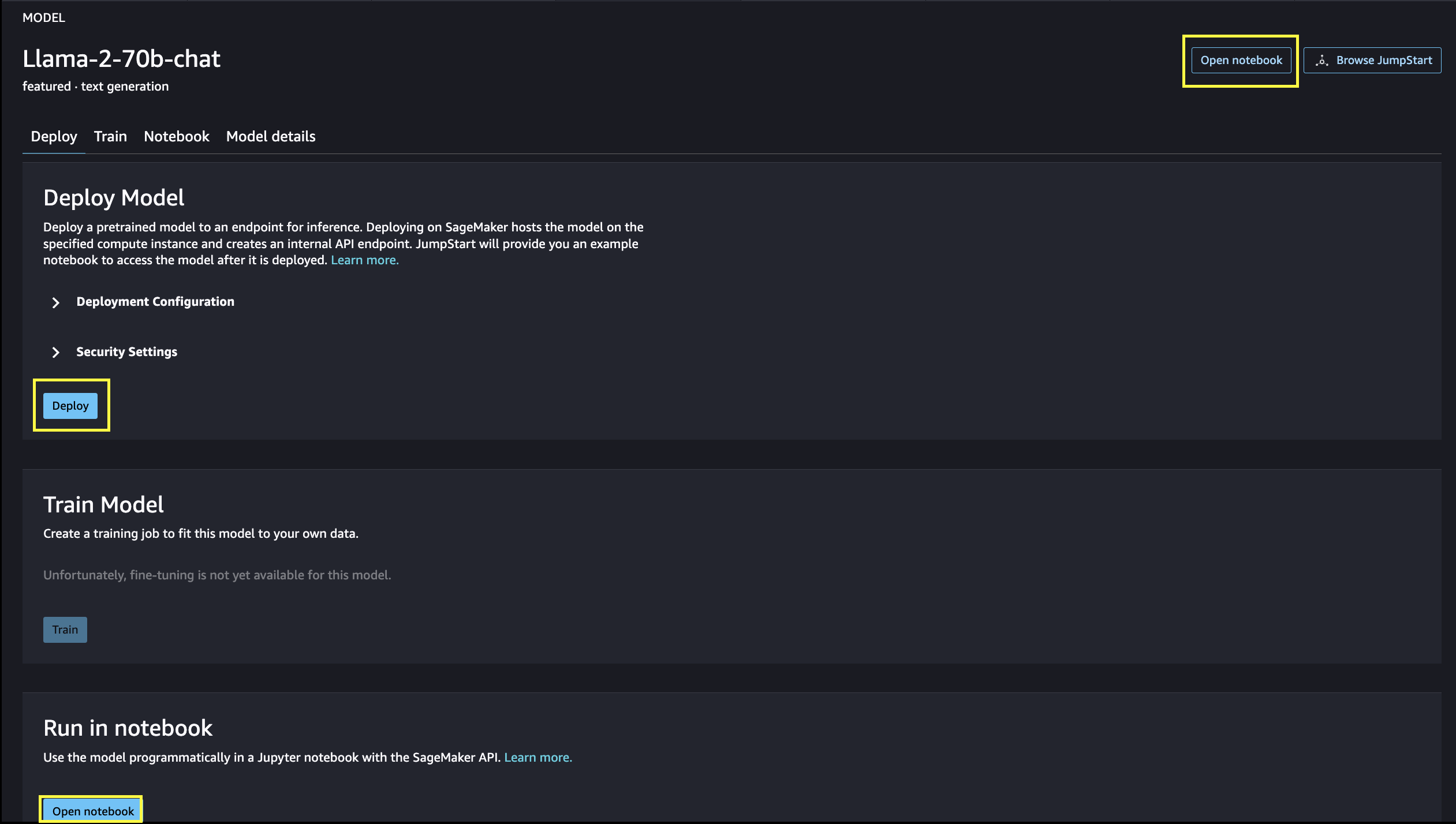

آپ ماڈل کے بارے میں تفصیلات دیکھنے کے لیے ماڈل کارڈ کا انتخاب کر سکتے ہیں جیسے کہ لائسنس، تربیت کے لیے استعمال ہونے والا ڈیٹا، اور استعمال کرنے کا طریقہ۔ آپ کو دو بٹن بھی مل سکتے ہیں، تعینات اور نوٹ بک کھولیں۔، جو آپ کو ماڈل استعمال کرنے میں مدد کرتا ہے۔

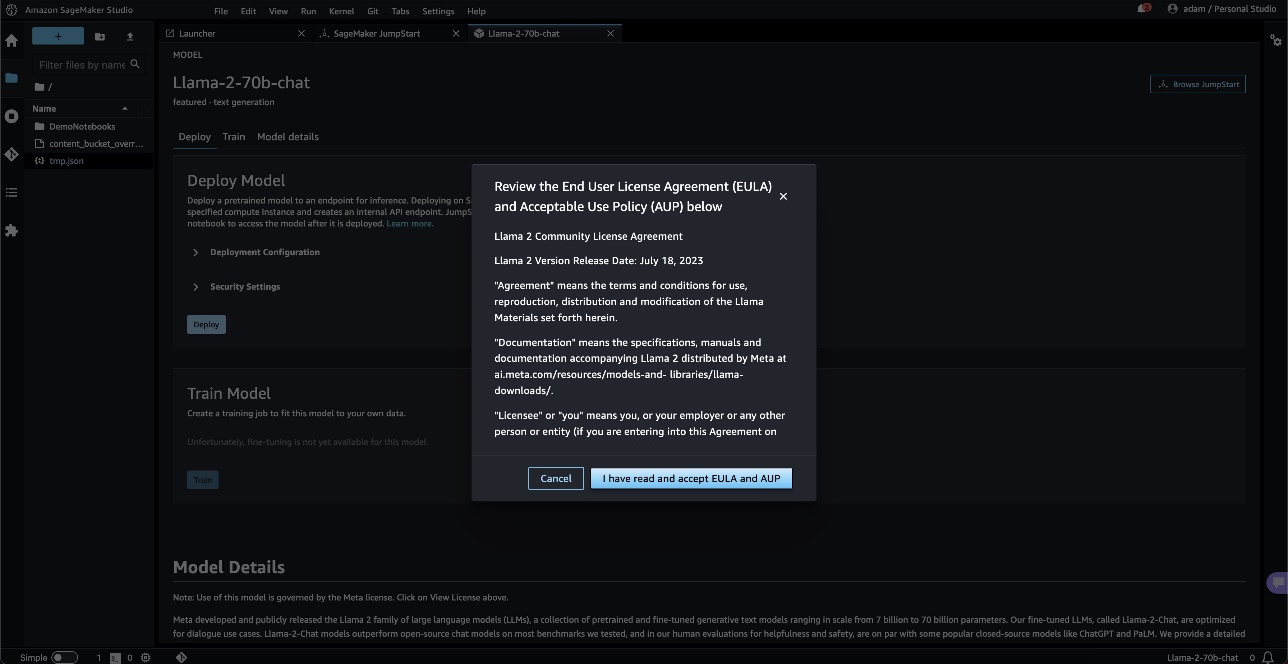

جب آپ کسی بھی بٹن کا انتخاب کرتے ہیں، تو ایک پاپ اپ اختتامی صارف کے لائسنس کا معاہدہ اور آپ کو تسلیم کرنے کے لیے قابل قبول استعمال کی پالیسی دکھائے گا۔

تسلیم کرنے پر، آپ ماڈل کو استعمال کرنے کے لیے اگلے مرحلے پر جائیں گے۔

ایک ماڈل تعینات کریں۔

جب آپ کا انتخاب کریں تعینات اور شرائط کو تسلیم کریں، ماڈل کی تعیناتی شروع ہو جائے گی۔ متبادل طور پر، آپ مثال کے نوٹ بک کے ذریعے تعینات کر سکتے ہیں جو منتخب کر کے ظاہر ہوتی ہے۔ نوٹ بک کھولیں۔. مثال کی نوٹ بک اختتام سے آخر تک رہنمائی فراہم کرتی ہے کہ اندازہ کے لیے ماڈل کو کیسے تعینات کیا جائے اور وسائل کو صاف کیا جائے۔

نوٹ بک کا استعمال کرتے ہوئے تعینات کرنے کے لیے، ہم ایک مناسب ماڈل کو منتخب کرکے شروع کرتے ہیں، جس کی وضاحت کی گئی ہے۔ model_id. آپ مندرجہ ذیل کوڈ کے ساتھ SageMaker پر کسی بھی منتخب ماڈل کو تعینات کر سکتے ہیں:

یہ ماڈل کو ڈیفالٹ کنفیگریشنز کے ساتھ SageMaker پر تعینات کرتا ہے، بشمول ڈیفالٹ مثال کی قسم اور ڈیفالٹ VPC کنفیگریشنز۔ آپ ان کنفیگریشنز کو غیر ڈیفالٹ ویلیوز بتا کر تبدیل کر سکتے ہیں۔ جمپ اسٹارٹ ماڈل. اس کے تعینات ہونے کے بعد، آپ SageMaker پیشن گوئی کے ذریعے تعینات اختتامی نقطہ کے خلاف تخمینہ چلا سکتے ہیں:

فائن ٹیون شدہ چیٹ ماڈلز (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) صارف اور چیٹ اسسٹنٹ کے درمیان چیٹ کی تاریخ کو قبول کرتے ہیں، اور بعد میں چیٹ تیار کرتے ہیں۔ پہلے سے تربیت یافتہ ماڈلز (Llama-2-7b, Llama-2-13b, Llama-2-70b) کو سٹرنگ پرامپٹ کی ضرورت ہوتی ہے اور فراہم کردہ پرامپٹ پر متن کی تکمیل کو انجام دیتے ہیں۔ درج ذیل کوڈ دیکھیں:

نوٹ کریں کہ بطور ڈیفالٹ، accept_eula جھوٹ پر سیٹ ہے. آپ کو سیٹ کرنے کی ضرورت ہے۔ accept_eula=true اختتامی نقطہ کو کامیابی سے شروع کرنے کے لیے۔ ایسا کرنے سے، آپ صارف کے لائسنس کے معاہدے اور قابل قبول استعمال کی پالیسی کو قبول کرتے ہیں جیسا کہ پہلے ذکر کیا گیا ہے۔ آپ بھی ڈاؤن لوڈ، اتارنا لائسنس کا معاہدہ.

Custom_attributes EULA کو پاس کرنے کے لیے استعمال کیا جاتا ہے کلیدی/قدر کے جوڑے۔ کلید اور قدر کو الگ کیا جاتا ہے۔ = اور جوڑے الگ ہوتے ہیں۔ ;. اگر صارف ایک ہی کلید کو ایک سے زیادہ بار پاس کرتا ہے، تو آخری قدر رکھی جاتی ہے اور اسکرپٹ ہینڈلر کو بھیج دی جاتی ہے (یعنی اس صورت میں، مشروط منطق کے لیے استعمال کیا جاتا ہے)۔ مثال کے طور پر، اگر accept_eula=false; accept_eula=true پھر سرور کو منتقل کیا جاتا ہے۔ accept_eula=true رکھا جاتا ہے اور اسکرپٹ ہینڈلر کو دیا جاتا ہے۔

انفرنس پیرامیٹرز اختتامی نقطہ پر ٹیکسٹ جنریشن کے عمل کو کنٹرول کرتے ہیں۔ زیادہ سے زیادہ نئے ٹوکن کنٹرول سے مراد ماڈل کے ذریعہ تیار کردہ آؤٹ پٹ کا سائز ہے۔ نوٹ کریں کہ یہ الفاظ کی تعداد کے برابر نہیں ہے کیونکہ ماڈل کی الفاظ انگریزی زبان کے الفاظ کے برابر نہیں ہیں، اور ہر ٹوکن انگریزی زبان کا لفظ نہیں ہو سکتا۔ درجہ حرارت آؤٹ پٹ میں بے ترتیب پن کو کنٹرول کرتا ہے۔ اعلی درجہ حرارت کے نتیجے میں زیادہ تخلیقی اور فریب کاری پیدا ہوتی ہے۔ تمام قیاس کے پیرامیٹرز اختیاری ہیں۔

درج ذیل جدول میں سیج میکر جمپ سٹارٹ کے ساتھ دستیاب تمام لاما ماڈلز کی فہرست دی گئی ہے۔ model_ids, پہلے سے طے شدہ مثال کی اقسام، اور کل ٹوکنز کی زیادہ سے زیادہ تعداد (ان پٹ ٹوکنز کی تعداد اور جنریٹڈ ٹوکنز کی تعداد) ان میں سے ہر ایک ماڈل کے لیے تعاون یافتہ ہے۔

| ماڈل کا نام | ماڈل کی شناخت | زیادہ سے زیادہ کل ٹوکن | پہلے سے طے شدہ مثال کی قسم |

| للہ -2-7b | meta-textgeneration-llama-2-7b | 4096 | ml.g5.2xlarge |

| Llama-2-7b-چیٹ | meta-textgeneration-llama-2-7b-f | 4096 | ml.g5.2xlarge |

| للہ -2-13b | meta-textgeneration-llama-2-13b | 4096 | ml.g5.12xlarge |

| Llama-2-13b-چیٹ | meta-textgeneration-llama-2-13b-f | 4096 | ml.g5.12xlarge |

| للہ -2-70b | meta-textgeneration-llama-2-70b | 4096 | ml.g5.48xlarge |

| Llama-2-70b-چیٹ | meta-textgeneration-llama-2-70b-f | 4096 | ml.g5.48xlarge |

نوٹ کریں کہ SageMaker اینڈ پوائنٹس کی ٹائم آؤٹ کی حد 60s ہے۔ اس طرح، اگرچہ ماڈل 4096 ٹوکن بنانے کے قابل ہو سکتا ہے، اگر ٹیکسٹ جنریشن میں 60 سے زیادہ وقت لگتا ہے، تو درخواست ناکام ہو جائے گی۔ 7B، 13B، اور 70B ماڈلز کے لیے، ہم سیٹ کرنے کی تجویز کرتے ہیں۔ max_new_tokens ٹوکنز کی کل تعداد کو 1500K سے کم رکھتے ہوئے بالترتیب 1000، 500 اور 4 سے زیادہ نہیں۔

Llama-2-70b کے لیے اشارہ اور مثال کا اشارہ

آپ متن کے کسی بھی ٹکڑے کے لیے متن کی تکمیل کے لیے Llama ماڈل استعمال کر سکتے ہیں۔ ٹیکسٹ جنریشن کے ذریعے، آپ متعدد کام انجام دے سکتے ہیں، جیسے سوالات کے جوابات، زبان کا ترجمہ، جذبات کا تجزیہ، اور بہت کچھ۔ اختتامی نقطہ پر ان پٹ پے لوڈ درج ذیل کوڈ کی طرح لگتا ہے:

ذیل میں نمونے کے کچھ نمونے کے اشارے اور ماڈل کے ذریعہ تیار کردہ متن ہیں۔ تمام آؤٹ پٹ انفرنس پیرامیٹرز کے ساتھ تیار کیے جاتے ہیں۔ {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

اگلی مثال میں، ہم دکھاتے ہیں کہ لاما ماڈلز کو چند شاٹ ان سیاق و سباق سیکھنے کے ساتھ کیسے استعمال کیا جائے، جہاں ہم ماڈل کو دستیاب تربیتی نمونے فراہم کرتے ہیں۔ نوٹ کریں کہ ہم صرف تعینات کردہ ماڈل کا اندازہ لگاتے ہیں اور اس عمل کے دوران، ماڈل کا وزن تبدیل نہیں ہوتا ہے۔

Llama-2-70b-chat کے لیے اشارہ اور مثال کا اشارہ

Llama-2-Chat ماڈلز کے ساتھ، جو ڈائیلاگ کے استعمال کے کیسز کے لیے بہتر بنائے گئے ہیں، چیٹ ماڈل کے اختتامی پوائنٹس کا ان پٹ چیٹ اسسٹنٹ اور صارف کے درمیان پچھلی تاریخ ہے۔ آپ اب تک ہونے والی گفتگو سے متعلقہ سوالات پوچھ سکتے ہیں۔ آپ سسٹم کنفیگریشن بھی فراہم کر سکتے ہیں، جیسے کہ وہ شخصیات جو چیٹ اسسٹنٹ کے رویے کی وضاحت کرتی ہیں۔ اختتامی نقطہ پر ان پٹ پے لوڈ درج ذیل کوڈ کی طرح لگتا ہے:

ذیل میں نمونے کے کچھ نمونے کے اشارے اور ماڈل کے ذریعہ تیار کردہ متن ہیں۔ تمام آؤٹ پٹ انفرنس پیرامیٹرز کے ساتھ تیار کیے جاتے ہیں۔ {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

مندرجہ ذیل مثال میں، صارف نے اسسٹنٹ کے ساتھ پیرس میں سیاحتی مقامات کے بارے میں بات چیت کی ہے۔ اگلا، صارف چیٹ اسسٹنٹ کے ذریعہ تجویز کردہ پہلے آپشن کے بارے میں پوچھتا ہے۔

مندرجہ ذیل مثالوں میں، ہم سسٹم کی کنفیگریشن سیٹ کرتے ہیں:

صاف کرو

نوٹ بک چلانے کے بعد، تمام وسائل کو حذف کرنا یقینی بنائیں تاکہ اس عمل میں آپ کے بنائے گئے تمام وسائل حذف ہو جائیں اور آپ کی بلنگ روک دی جائے:

نتیجہ

اس پوسٹ میں، ہم نے آپ کو دکھایا کہ سیج میکر اسٹوڈیو میں لاما 2 ماڈلز کے ساتھ کیسے آغاز کیا جائے۔ اس کے ساتھ، آپ کو چھ Llama 2 فاؤنڈیشن ماڈلز تک رسائی حاصل ہے جو اربوں پیرامیٹرز پر مشتمل ہے۔ چونکہ فاؤنڈیشن ماڈل پہلے سے تربیت یافتہ ہوتے ہیں، اس لیے وہ تربیت اور بنیادی ڈھانچے کے اخراجات کو کم کرنے میں بھی مدد کر سکتے ہیں اور آپ کے استعمال کے معاملے کے لیے حسب ضرورت کو فعال کر سکتے ہیں۔ SageMaker JumpStart کے ساتھ شروع کرنے کے لیے، درج ذیل وسائل ملاحظہ کریں:

مصنفین کے بارے میں

جون جیت گیا۔ سیج میکر جمپ اسٹارٹ کے ساتھ پروڈکٹ مینیجر ہے۔ وہ فاؤنڈیشن ماڈلز کو آسانی سے قابل دریافت اور قابل استعمال بنانے پر توجہ مرکوز کرتا ہے تاکہ صارفین کو تخلیقی AI ایپلی کیشنز بنانے میں مدد مل سکے۔ ایمیزون پر اس کے تجربے میں موبائل شاپنگ ایپلی کیشن اور آخری میل کی ترسیل بھی شامل ہے۔

جون جیت گیا۔ سیج میکر جمپ اسٹارٹ کے ساتھ پروڈکٹ مینیجر ہے۔ وہ فاؤنڈیشن ماڈلز کو آسانی سے قابل دریافت اور قابل استعمال بنانے پر توجہ مرکوز کرتا ہے تاکہ صارفین کو تخلیقی AI ایپلی کیشنز بنانے میں مدد مل سکے۔ ایمیزون پر اس کے تجربے میں موبائل شاپنگ ایپلی کیشن اور آخری میل کی ترسیل بھی شامل ہے۔

ڈاکٹر وویک مدن Amazon SageMaker جمپ سٹارٹ ٹیم کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ انہوں نے Urbana-Champaign میں یونیورسٹی آف الینوائے سے پی ایچ ڈی کی اور جارجیا ٹیک میں پوسٹ ڈاکٹریٹ ریسرچر تھے۔ وہ مشین لرننگ اور الگورتھم ڈیزائن میں ایک فعال محقق ہے اور اس نے EMNLP، ICLR، COLT، FOCS، اور SODA کانفرنسوں میں مقالے شائع کیے ہیں۔

ڈاکٹر وویک مدن Amazon SageMaker جمپ سٹارٹ ٹیم کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ انہوں نے Urbana-Champaign میں یونیورسٹی آف الینوائے سے پی ایچ ڈی کی اور جارجیا ٹیک میں پوسٹ ڈاکٹریٹ ریسرچر تھے۔ وہ مشین لرننگ اور الگورتھم ڈیزائن میں ایک فعال محقق ہے اور اس نے EMNLP، ICLR، COLT، FOCS، اور SODA کانفرنسوں میں مقالے شائع کیے ہیں۔  ڈاکٹر کائل الریچ Amazon SageMaker جمپ سٹارٹ ٹیم کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔

ڈاکٹر کائل الریچ Amazon SageMaker جمپ سٹارٹ ٹیم کے ساتھ ایک اپلائیڈ سائنٹسٹ ہے۔ اس کی تحقیقی دلچسپیوں میں توسیع پذیر مشین لرننگ الگورتھم، کمپیوٹر ویژن، ٹائم سیریز، بایسیئن نان پیرامیٹرکس، اور گاوسی عمل شامل ہیں۔ اس کی پی ایچ ڈی ڈیوک یونیورسٹی سے ہے اور اس نے نیور آئی پی ایس، سیل اور نیوران میں مقالے شائع کیے ہیں۔  ڈاکٹر آشیش کھیتان Amazon SageMaker JumpStart کے ساتھ ایک سینئر اپلائیڈ سائنٹسٹ ہے اور مشین لرننگ الگورتھم تیار کرنے میں مدد کرتا ہے۔ انہوں نے یونیورسٹی آف الینوائے اربانا-چمپین سے پی ایچ ڈی کی۔ وہ مشین لرننگ اور شماریاتی اندازہ میں ایک فعال محقق ہے، اور اس نے NeurIPS، ICML، ICLR، JMLR، ACL، اور EMNLP کانفرنسوں میں بہت سے مقالے شائع کیے ہیں۔

ڈاکٹر آشیش کھیتان Amazon SageMaker JumpStart کے ساتھ ایک سینئر اپلائیڈ سائنٹسٹ ہے اور مشین لرننگ الگورتھم تیار کرنے میں مدد کرتا ہے۔ انہوں نے یونیورسٹی آف الینوائے اربانا-چمپین سے پی ایچ ڈی کی۔ وہ مشین لرننگ اور شماریاتی اندازہ میں ایک فعال محقق ہے، اور اس نے NeurIPS، ICML، ICLR، JMLR، ACL، اور EMNLP کانفرنسوں میں بہت سے مقالے شائع کیے ہیں۔  سندر رنگناتھن AWS میں GenAI/Frameworks GTM ماہرین کے عالمی سربراہ ہیں۔ وہ بڑے لینگویج ماڈلز، GenAI، اور AWS سروسز جیسے Amazon EC2، EKS، EFA، AWS Batch، اور Amazon SageMaker میں بڑے پیمانے پر ML ورک بوجھ کے لیے GTM حکمت عملی تیار کرنے پر توجہ مرکوز کرتا ہے۔ اس کے تجربے میں NetApp، Micron Technology، Qualcomm، اور Mentor Graphics میں پروڈکٹ مینجمنٹ اور مصنوعات کی ترقی میں قائدانہ کردار شامل ہیں۔

سندر رنگناتھن AWS میں GenAI/Frameworks GTM ماہرین کے عالمی سربراہ ہیں۔ وہ بڑے لینگویج ماڈلز، GenAI، اور AWS سروسز جیسے Amazon EC2، EKS، EFA، AWS Batch، اور Amazon SageMaker میں بڑے پیمانے پر ML ورک بوجھ کے لیے GTM حکمت عملی تیار کرنے پر توجہ مرکوز کرتا ہے۔ اس کے تجربے میں NetApp، Micron Technology، Qualcomm، اور Mentor Graphics میں پروڈکٹ مینجمنٹ اور مصنوعات کی ترقی میں قائدانہ کردار شامل ہیں۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ آٹوموٹو / ای وی، کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- بلاک آفسیٹس۔ ماحولیاتی آفسیٹ ملکیت کو جدید بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 1

- 10

- 100

- 11

- 13

- 15٪

- 17

- 19

- 20

- 30

- 31

- 33

- 360 ڈگری

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- قابلیت

- ہمارے بارے میں

- قبول کریں

- قابل قبول

- تک رسائی حاصل

- رسائی پذیری

- قابل رسائی

- کے مطابق

- تسلیم کرتے ہیں

- کے پار

- فعال

- شامل کریں

- انہوں نے مزید کہا

- ایڈیشنل

- پتہ

- کے بعد

- پھر

- کے خلاف

- معاہدہ

- AI

- یلگورتم

- یلگوردمز

- سیدھ کریں

- تمام

- کی اجازت

- ساتھ

- بھی

- ہمیشہ

- am

- ایمیزون

- ایمیزون EC2

- ایمیزون سیج میکر

- ایمیزون سیج میکر جمپ اسٹارٹ

- ایمیزون سیج میکر اسٹوڈیو

- ایمیزون ویب سروسز

- امریکی

- an

- تجزیہ

- اور

- اور بنیادی ڈھانچہ

- اعلان کریں

- ایک اور

- جواب

- کوئی بھی

- کسی

- درخواست

- ایپلی کیشنز

- اطلاقی

- کی تعریف

- مناسب

- آرک

- فن تعمیر

- کیا

- فن

- AS

- مدد

- اسسٹنٹ

- At

- ماحول

- پرکشش

- آٹومیٹڈ

- دستیاب

- AWS

- کیلا

- بنیادی

- جنگ

- Bayesian

- BE

- خوبصورت

- خوبصورتی

- بن گیا

- کیونکہ

- بن

- رہا

- بیئر

- اس سے پہلے

- رویے

- بیجنگ

- یقین ہے کہ

- خیال کیا

- BEST

- کے درمیان

- بلنگ

- ارب

- اربوں

- سیاہ

- باکس

- توڑ

- سانس لینے والا

- وسیع

- تعمیر

- عمارت

- تعمیر

- لیکن

- بٹن

- by

- کہا جاتا ہے

- کر سکتے ہیں

- دارالحکومت

- کار کے

- کارڈ

- carousel

- کیس

- مقدمات

- CAT

- تبدیل

- چاکلیٹ

- میں سے انتخاب کریں

- منتخب کریں

- شہر

- کلاسک

- کوڈ

- مجموعہ

- مل کر

- یکجا

- آتا ہے

- آنے والے

- تجارتی

- کمپنی کے

- تکمیل

- کمپیوٹر

- کمپیوٹر ویژن

- کانفرنسوں

- اعتماد

- ترتیب

- سمجھا

- مسلسل

- تعمیر

- پر مشتمل ہے

- کنٹینر

- پر مشتمل ہے

- مواد

- متعلقہ

- جاری

- مسلسل

- کنٹرول

- کنٹرول

- آسان

- بات چیت

- اخراجات

- ملک

- ہمت

- احاطہ

- تخلیق

- بنائی

- تخلیقی

- ثقافتی

- ثقافت

- کپ

- گاہکوں

- اصلاح

- اپنی مرضی کے مطابق

- اعداد و شمار

- ڈیٹا کی حفاظت

- وقف

- اعتراف کے

- پہلے سے طے شدہ

- وضاحت

- ترسیل

- تعیناتی

- تعینات

- تعینات

- تعیناتی

- تعینات کرتا ہے

- ڈیزائن

- ڈیزائن

- مطلوبہ

- منزل

- منزلوں

- تفصیلات

- ترقی

- ترقی یافتہ

- ڈیولپر

- ترقی

- ترقی

- مکالمے کے

- فرق

- مختلف

- مشکل

- دریافت

- مخصوص

- do

- دستاویزی

- کر

- کیا

- نہیں

- دگنی

- نیچے

- ڈیوک

- ڈیوک یونیورسٹی

- کے دوران

- e

- ہر ایک

- اس سے قبل

- آسانی سے

- آسان

- ایڈورڈ

- آئنسٹائن

- یا تو

- ای میل

- کو چالو کرنے کے

- کو فعال کرنا

- آخر

- آخر سے آخر تک

- اختتام پوائنٹ

- انجنیئرنگ

- انگریزی

- لطف اندوز

- کافی

- کو یقینی بنانے کے

- ماحولیات

- کا سامان

- آسمان

- بھی

- واقعات

- سب

- مثال کے طور پر

- مثال کے طور پر

- بہت پرجوش

- تجربہ

- تجربہ

- تجربات

- ایکسپریس

- FAIL

- ناکام

- منصفانہ

- جھوٹی

- خاندان

- مشہور

- دور

- کارنامے

- شامل

- خصوصیات

- آراء

- فٹ

- چند

- فلمیں

- فائنل

- آخر

- مل

- پہلا

- فلیگ شپ

- فلوٹ

- بہنا

- توجہ مرکوز

- کے بعد

- کے لئے

- آگے

- ملا

- فاؤنڈیشن

- چار

- فرانس

- فرانسیسی

- سے

- مکمل طور پر

- مزید

- مستقبل

- جنرل

- پیدا

- پیدا

- نسل

- پیداواری

- پیداواری AI۔

- جارجیا

- حاصل

- دے دو

- گلاس

- گلوبل

- Go

- جا

- گرافکس

- عظیم

- زیادہ سے زیادہ

- جھنڈا

- بڑھائیں

- رہنمائی

- رہنمائی

- تھا

- ہینڈل

- ہوا

- خوش

- ہارڈ

- مشکل کام

- ہے

- ہونے

- he

- سر

- مدد

- مدد

- مدد کرتا ہے

- یہاں

- hi

- ہائی

- اعلی

- ان

- تاریخی

- تاریخ

- ہاؤسنگ

- کس طرح

- کیسے

- HTML

- HTTPS

- حب

- انسانی

- i

- مشہور

- خیال

- if

- ii

- ایلی نوائے

- اثر

- درآمد

- اہم

- متاثر کن

- in

- شامل

- شامل ہیں

- سمیت

- شامل

- معلومات

- انفراسٹرکچر

- ابتدائی طور پر

- ان پٹ

- متاثر

- متاثر کن

- مثال کے طور پر

- فوری طور پر

- ہدایات

- ضم

- ارادہ

- مفادات

- انٹرفیس

- میں

- الگ الگ

- IT

- میں

- سفر

- فوٹو

- صرف

- رکھتے ہوئے

- رکھی

- کلیدی

- بچے

- جان

- جانا جاتا ہے

- لینڈنگ

- تاریخی

- زبان

- بڑے

- بڑے پیمانے پر

- سب سے بڑا

- آخری

- مرحوم

- شروع

- قوانین

- قیادت

- جانیں

- سیکھیں اور بڑھیں

- سیکھنے

- کم سے کم

- کم

- سطح

- لائسنس

- زندگی

- روشنی

- کی طرح

- LIMIT

- فہرستیں

- ادب

- ll

- لاما

- منطق

- لانگ

- طویل وقت

- تلاش

- دیکھنا

- محبت

- محبت کرتا تھا

- کم

- مشین

- مشین لرننگ

- بنا

- بنا

- بناتا ہے

- بنانا

- انتظام

- مینیجر

- بہت سے

- چمتکار

- معاملہ

- زیادہ سے زیادہ

- مئی..

- مطلب

- پیمائش

- میڈیا

- درمیانہ

- ذکر کیا

- پیغام

- میٹا

- مائکرون

- منٹ

- منٹ

- مرکب

- ML

- ایم ایل اوپس

- موبائل

- ماڈل

- ماڈل

- لمحہ

- ماہ

- زیادہ

- سب سے زیادہ

- سب سے زیادہ مقبول

- تحریک

- فلم

- بہت

- میوزیم

- عجائب گھر

- موسیقی

- نام

- قدرتی

- ضروری

- ضرورت ہے

- ضرورت

- نیٹ ورک

- نئی

- NY

- اگلے

- نہیں

- نوٹ بک

- اب

- تعداد

- متعدد

- NY

- of

- پیش کرتے ہیں

- کی پیشکش

- تجویز

- تیل

- on

- ایک بار

- ایک

- صرف

- کھول

- اوپن سورس

- کی اصلاح کریں

- اصلاح

- اختیار

- or

- دیگر

- دیگر

- دوسری صورت میں

- ہمارے

- باہر

- پیداوار

- پر

- مجموعی طور پر

- صفحہ

- جوڑے

- کاغذ.

- کاغذات

- پیرامیٹر

- پیرامیٹرز

- پیرس

- حصہ

- منظور

- منظور

- گزرتا ہے

- گزشتہ

- امن

- انجام دیں

- کارکردگی

- مستقل

- فون

- تصاویر

- طبعیات

- ٹکڑا

- پزا

- پلاسٹک

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- کھیلا

- پالیسی

- پاپ اپ

- مقبول

- پوسٹ

- پوسٹل

- پیش گو

- ترجیحات

- کی تیاری

- حال (-)

- پچھلا

- عمل

- عمل

- مصنوعات

- مصنوعات کی ترقی

- پروڈکٹ مینجمنٹ

- پروڈکٹ مینیجر

- تجاویز

- فخر

- فراہم

- فراہم

- فراہم کرتا ہے

- فراہم کرنے

- عوامی

- عوامی ذرائع نقل و حمل

- عوامی طور پر

- شائع

- مقصد

- ڈال

- ازگر

- qualcomm

- سوالات

- فوری

- جلدی سے

- ریمپ

- بے ترتیب پن

- رینج

- لے کر

- تیار

- وجوہات

- وصول

- ہدایت

- سفارش

- سفارش کی

- مراد

- بے شک

- خطوں

- رشتہ دار

- تناسب

- بار بار

- کی نمائندگی

- درخواست

- کی ضرورت ہے

- تحقیق

- محقق

- وسائل

- بالترتیب

- جواب

- باقی

- نتیجہ

- نتائج کی نمائش

- دریائے

- کردار

- کردار

- رن

- چل رہا ہے

- s

- سیفٹی

- sagemaker

- نمک

- اسی

- توسیع پذیر

- پیمانے

- سائنسدان

- سائنسدانوں

- sdk

- سمندر

- تلاش کریں

- تلاش

- سیکشن

- محفوظ بنانے

- سیکورٹی

- دیکھنا

- دیکھ کر

- لگ رہا تھا

- منتخب

- منتخب

- انتخاب

- بھیجنے

- سینئر

- جذبات

- سیریز

- سروسز

- خدمت

- مقرر

- قائم کرنے

- شکل

- شارک

- خریداری

- ہونا چاہئے

- دکھائیں

- سے ظاہر ہوا

- شوز

- کواڑ بند کرنے

- اہمیت

- اہم

- سادہ

- صرف

- ایک

- سائٹ

- سائٹس

- چھ

- سائز

- آہستہ آہستہ

- چھوٹے

- So

- اب تک

- سماجی

- سوشل میڈیا

- حل

- کچھ

- ماخذ

- ذرائع

- خصوصی

- ماہرین

- مخصوص

- تیزی

- کھڑا ہے

- شروع کریں

- شروع

- حالت

- امریکہ

- شماریات

- مرحلہ

- مراحل

- بند کر دیا

- حکمت عملی

- سلک

- ساخت

- سٹوڈیو

- شاندار

- موضوع

- بعد میں

- کامیابی

- کامیابی کے ساتھ

- اس طرح

- تائید

- اس بات کا یقین

- علامت

- کے نظام

- ٹیبل

- لے لو

- لیتا ہے

- کاموں

- ذائقہ

- ٹیم

- ٹیک

- ٹیکنالوجی

- عارضی

- شرائط

- سے

- شکریہ

- کہ

- ۔

- دارالحکومت

- مستقبل

- ماخذ

- دنیا

- ان

- ان

- نظریہ

- وہاں.

- یہ

- وہ

- چیزیں

- لگتا ہے کہ

- اس

- اگرچہ؟

- کے ذریعے

- ٹائگر

- وقت

- وقت کا سلسلہ

- اوقات

- عنوان

- کرنے کے لئے

- آج

- مل کر

- ٹوکن

- ٹوکن

- اوزار

- سب سے اوپر

- کل

- ٹاور

- ٹرین

- ٹریننگ

- ٹرانسفارمر

- ترجمہ کریں

- ترجمہ

- نقل و حمل

- ٹریلین

- کوشش

- دو

- قسم

- اقسام

- ui

- کے تحت

- ناقابل فراموش

- منفرد

- یونیورسٹی

- جب تک

- اپ ڈیٹ کریں

- تازہ ترین معلومات

- استعمال کے قابل

- استعمال کی شرائط

- استعمال کیس

- استعمال کیا جاتا ہے

- رکن کا

- صارفین

- استعمال

- کا استعمال کرتے ہوئے

- قیمت

- اقدار

- مختلف اقسام کے

- ورژن

- ورژن

- بہت

- کی طرف سے

- لنک

- خیالات

- نقطہ نظر

- دورہ

- زائرین

- حجم

- چاہتے تھے

- جنگ

- تھا

- we

- ویب

- ویب خدمات

- ویب پر مبنی ہے

- ویب سائٹ

- اچھا ہے

- وہیل

- کیا

- کیا ہے

- جب

- جبکہ

- جس

- جبکہ

- کیوں

- گے

- کھڑکیاں

- ساتھ

- لفظ

- الفاظ

- کام

- کام کرتا ہے

- دنیا

- عالمی شہرت یافتہ

- لپیٹو

- سال

- یارک

- تم

- اور

- اپنے آپ کو

- زیفیرنیٹ

- زپ