جنریٹو AI بوم کمپیوٹ کے پابند ہے۔ اس کی منفرد خاصیت ہے کہ زیادہ کمپیوٹ شامل کرنے سے براہ راست بہتر پروڈکٹ کا نتیجہ نکلتا ہے۔ عام طور پر، R&D سرمایہ کاری زیادہ براہ راست اس بات سے منسلک ہوتی ہے کہ کوئی پروڈکٹ کتنی قیمتی تھی، اور یہ تعلق واضح طور پر ذیلی ہے۔ لیکن فی الحال مصنوعی ذہانت کے ساتھ ایسا نہیں ہے اور اس کے نتیجے میں، آج صنعت کو چلانے والا ایک اہم عنصر صرف تربیت اور تخمینہ کی لاگت ہے۔

اگرچہ ہمیں صحیح اعداد کا علم نہیں ہے، لیکن ہم نے معتبر ذرائع سے سنا ہے کہ کمپیوٹ کی سپلائی اتنی محدود ہے، ڈیمانڈ اس سے 10(!) کے فیکٹر سے آگے نکل جاتی ہے، اس لیے ہمارے خیال میں یہ کہنا مناسب ہے، ابھی، حسابی وسائل تک رسائی - سب سے کم کل لاگت پر - AI کمپنیوں کی کامیابی کا تعین کرنے والا عنصر بن گیا ہے۔.

درحقیقت، ہم نے دیکھا ہے کہ بہت سی کمپنیاں اپنے مجموعی سرمائے کا 80% سے زیادہ حسابی وسائل پر خرچ کرتی ہیں!

اس پوسٹ میں، ہم ایک AI کمپنی کے لیے لاگت کے عوامل کو توڑنے کی کوشش کرتے ہیں۔ قطعی تعداد وقت کے ساتھ ساتھ بدل جائے گی، لیکن ہم AI کمپنیوں کی جانب سے کمپیوٹ وسائل تک رسائی کے پابند ہونے سے فوری ریلیف نہیں دیکھتے ہیں۔ لہذا، امید ہے کہ، یہ زمین کی تزئین کے ذریعے سوچنے کے لئے ایک مددگار فریم ورک ہے۔

AI ماڈل کمپیوٹیشنل طور پر اتنے مہنگے کیوں ہیں؟

تخلیقی AI ماڈلز کی وسیع اقسام ہیں، اور اندازہ اور تربیت کے اخراجات ماڈل کے سائز اور قسم پر منحصر ہیں۔ خوش قسمتی سے، آج سب سے زیادہ مقبول ماڈلز زیادہ تر ٹرانسفارمر پر مبنی فن تعمیر ہیں، جن میں مقبول بڑے لینگوئج ماڈل (LLMs) جیسے GPT-3، GPT-J، یا BERT شامل ہیں۔ جبکہ ٹرانسفارمرز کا اندازہ لگانے اور سیکھنے کے لیے آپریشنز کی صحیح تعداد ماڈل کے لیے مخصوص ہے (دیکھیں۔ اس اخبار)، انگوٹھے کا کافی حد تک درست اصول ہے جو صرف ماڈل کے پیرامیٹرز کی تعداد (یعنی نیورل نیٹ ورکس کے وزن) اور ان پٹ اور آؤٹ پٹ ٹوکنز کی تعداد پر منحصر ہے۔

ٹوکن بنیادی طور پر چند حروف کی مختصر ترتیب ہیں۔ وہ الفاظ یا الفاظ کے حصوں سے مطابقت رکھتے ہیں۔ ٹوکنز کے لیے بصیرت حاصل کرنے کا بہترین طریقہ یہ ہے کہ عوامی طور پر دستیاب آن لائن ٹوکنائزرز کے ساتھ ٹوکنائزیشن آزمائیں (مثلاً، اوپنائی)۔ GPT-3 کے لیے، ایک ٹوکن کی اوسط لمبائی 4 حروف ہیں۔.

ٹرانسفارمرز کے لیے انگوٹھے کا اصول یہ ہے کہ ایک ماڈل کے لیے فارورڈ پاس (یعنی اندازہ) p ان پٹ اور لمبائی کے آؤٹ پٹ تسلسل کے پیرامیٹرز n ٹوکن ہر ایک, تقریبا لیتا ہے 2*n*p فلوٹنگ پوائنٹ آپریشنز (FLOPS)¹۔ ایک ہی ماڈل کے لئے تربیت تقریبا لیتا ہے 6*p FLOPS فی ٹوکن (یعنی، اضافی پسماندہ پاس کے لیے مزید چار آپریشنز کی ضرورت ہے²)۔ آپ ٹریننگ ڈیٹا میں ٹوکن کی رقم سے اس کو ضرب دے کر ٹریننگ کی کل لاگت کا تخمینہ لگا سکتے ہیں۔

ٹرانسفارمرز کے لیے میموری کی ضروریات بھی ماڈل کے سائز پر منحصر ہوتی ہیں۔ اندازہ کے لیے، ہمیں ضرورت ہے۔ p میموری میں فٹ ہونے کے لیے ماڈل پیرامیٹرز۔ سیکھنے کے لیے (یعنی بیک پروپیگیشن)، ہمیں فارورڈ اور بیکورڈ پاس کے درمیان فی پیرامیٹر اضافی درمیانی قدریں ذخیرہ کرنے کی ضرورت ہے۔ فرض کریں کہ ہم 32 بٹ فلوٹنگ پوائنٹ نمبرز استعمال کرتے ہیں، یہ ایک اضافی 8 بائٹس فی پیرامیٹر ہے۔ 175-بلین پیرامیٹر ماڈل کی تربیت کے لیے، ہمیں میموری میں ایک ٹیرا بائٹ سے زیادہ ڈیٹا رکھنے کی ضرورت ہوگی - یہ آج کے کسی بھی GPU سے زیادہ ہے اور ہم سے ماڈل کو کارڈز میں تقسیم کرنے کی ضرورت ہے۔ اندازہ اور تربیت کے لیے یادداشت کی ضروریات کو کم لمبائی کی فلوٹنگ پوائنٹ ویلیوز کا استعمال کرتے ہوئے بہتر بنایا جا سکتا ہے، جس میں 16 بٹ عام ہو جائیں گے اور مستقبل قریب میں 8 بٹ متوقع ہیں۔

مندرجہ بالا جدول میں کئی مشہور ماڈلز کے سائز اور کمپیوٹ کی قیمتیں ہیں۔ GPT-3 میں تقریباً 175 بلین پیرامیٹرز ہیں، جو 1,024 ٹوکنز کے ان پٹ اور آؤٹ پٹ کے لیے، تقریباً 350 ٹریلین فلوٹنگ پوائنٹ آپریشنز (یعنی، ٹیرا فلاپس یا ٹی ایف ایل او پی ایس) کی کمپیوٹیشنل لاگت کا نتیجہ ہیں۔ GPT-3 جیسے ماڈل کو تربیت دینے میں تقریباً 3.14*10^23 فلوٹنگ پوائنٹ آپریشنز لگتے ہیں۔ میٹا کے ایل ایل اے ایم اے جیسے دوسرے ماڈلز ہیں۔ اس سے بھی زیادہ تقاضوں کا حساب اس طرح کے ماڈل کی تربیت اب تک بنی نوع انسان کی جانب سے کیے گئے کمپیوٹیشنل طور پر انتہائی گہرے کاموں میں سے ایک ہے۔

خلاصہ کرنے کے لئے: AI انفراسٹرکچر مہنگا ہے کیونکہ بنیادی الگورتھمک مسائل انتہائی کمپیوٹیشنل مشکل ہیں۔ ایک ملین اندراجات کے ساتھ ڈیٹا بیس ٹیبل کو ترتیب دینے کی الگورتھمک پیچیدگی GPT-3 کے ساتھ ایک لفظ پیدا کرنے کی پیچیدگی کے مقابلے میں معمولی ہے۔ اس کا مطلب ہے کہ آپ سب سے چھوٹا ماڈل منتخب کرنا چاہتے ہیں جو آپ کے استعمال کے معاملے کو حل کرتا ہے۔

اچھی خبر یہ ہے کہ، ٹرانسفارمرز کے لیے، ہم آسانی سے اندازہ لگا سکتے ہیں کہ ایک مخصوص سائز کا ماڈل کتنا کمپیوٹ اور میموری استعمال کرے گا۔ اور، اس طرح، صحیح ہارڈ ویئر کو چننا اگلا غور بن جاتا ہے۔

GPUs کے لیے وقت اور لاگت کی دلیل

کمپیوٹیشنل پیچیدگی وقت میں کیسے ترجمہ کرتی ہے؟ ایک پروسیسر کور عام طور پر فی سائیکل میں 1-2 ہدایات پر عمل درآمد کر سکتا ہے، اور پروسیسر کی گھڑی کی شرح گزشتہ 3 سالوں سے 15 گیگا ہرٹز کے قریب مستحکم رہی ہے۔ ڈینارڈ اسکیلنگ. کسی بھی متوازی فن تعمیر کا استحصال کیے بغیر ایک واحد GPT-3 انفرنس آپریشن کو انجام دینے میں 350 TFLOPS/(3 GHz*1 FLOP) یا 116,000 سیکنڈز یا 32 گھنٹے لگیں گے۔ یہ جنگلی طور پر ناقابل عمل ہے؛ اس کے بجائے ہمیں خصوصی چپس کی ضرورت ہے جو اس کام کو تیز کریں۔

عملی طور پر، آج تمام AI ماڈلز ایسے کارڈز پر چلتے ہیں جو بہت بڑی تعداد میں خصوصی کور استعمال کرتے ہیں۔ مثال کے طور پر، ایک NVIDIA A100 GPU میں 512 "ٹینسر کور" ہوتے ہیں جو ایک سائیکل میں 4×4 میٹرکس ضرب (جو 64 ضرب اور اضافے، یا 128 FLOPS کے برابر ہے) انجام دے سکتے ہیں۔ AI ایکسلریٹر کارڈز کو اکثر GPUs (گرافکس پروسیسنگ یونٹس) کہا جاتا ہے، کیونکہ فن تعمیر کو اصل میں ڈیسک ٹاپ گیمنگ کے لیے تیار کیا گیا تھا۔ مستقبل میں ہم امید کرتے ہیں کہ AI تیزی سے ایک الگ پروڈکٹ فیملی بن جائے گا۔

A100 کی کارکردگی برائے نام ہے۔ 312 TFLOPS جو نظریہ طور پر GPT-3 کا تخمینہ تقریباً 1 سیکنڈ تک کم کر دے گا۔ تاہم یہ کئی وجوہات کی بنا پر ایک حد سے زیادہ آسان حساب ہے۔ سب سے پہلے، زیادہ تر استعمال کے معاملات میں، رکاوٹ GPU کی کمپیوٹ طاقت نہیں ہے بلکہ خصوصی گرافکس میموری سے ٹینسر کور تک ڈیٹا حاصل کرنے کی صلاحیت ہے۔ دوسرا، 175 بلین وزن 700GB تک لے جائے گا اور کسی بھی GPU کی گرافکس میموری میں فٹ نہیں ہوگا۔ پارٹیشننگ اور ویٹ سٹریمنگ جیسی تکنیکوں کو استعمال کرنے کی ضرورت ہے۔ اور، تیسرا، بہت ساری اصلاحیں ہیں (مثال کے طور پر، مختصر فلوٹنگ پوائنٹ کی نمائندگی کا استعمال، جیسے FP16، FP8، یا اسپارس میٹرکس) جو حساب کو تیز کرنے کے لیے استعمال ہو رہی ہیں۔ لیکن، مجموعی طور پر، مندرجہ بالا ریاضی ہمیں آج کے LLMs کی مجموعی حسابی لاگت کا ایک ادراک فراہم کرتا ہے۔

ٹرانسفارمر ماڈل کی تربیت میں تخمینہ لگانے کے حساب سے تین گنا زیادہ وقت لگتا ہے۔ تاہم، یہ دیکھتے ہوئے کہ ٹریننگ ڈیٹا سیٹ ایک انفرنس پرامپٹ سے تقریباً 300 ملین گنا بڑا ہے، تربیت میں 1 بلین کے فیکٹر سے زیادہ وقت لگتا ہے۔ ایک GPU پر، تربیت میں کئی دہائیاں لگیں گی۔ عملی طور پر یہ سرشار ڈیٹا سینٹرز میں یا زیادہ امکان ہے کہ کلاؤڈ میں بڑے کمپیوٹ کلسٹرز پر کیا جاتا ہے۔ تربیت کا متوازی ہونا بھی مشکل ہے، کیونکہ نوڈس کے درمیان اپ ڈیٹ شدہ وزن کا تبادلہ کرنا پڑتا ہے۔ GPUs کے درمیان میموری اور بینڈوڈتھ اکثر ایک بہت زیادہ اہم عنصر بن جاتا ہے، جس میں تیز رفتار آپس میں جڑے ہوئے اور سرشار کپڑے عام ہوتے ہیں۔ بہت بڑے ماڈلز کی تربیت کے لیے، ایک مناسب نیٹ ورک سیٹ اپ بنانا بنیادی چیلنج ہو سکتا ہے۔ مستقبل کو دیکھتے ہوئے، AI ایکسلریٹر کے پاس کارڈ پر یا چپ پر بھی نیٹ ورکنگ کی صلاحیتیں ہوں گی۔

یہ کمپیوٹیشنل پیچیدگی لاگت میں کیسے ترجمہ کرتی ہے؟ ایک GPT-3 کا اندازہ، جو کہ ہم نے اوپر دیکھا، A1 پر تقریباً 100 سیکنڈ لگتے ہیں، 0.0002 ٹوکنز کے لیے خام کمپیوٹ لاگت $0.0014 اور $1,000 کے درمیان ہوگی (اس کا موازنہ OpenAI کے $0.002/1000 ٹوکنز کی قیمت سے ہوتا ہے)۔ ایک صارف جو ایک دن میں 100 تخمینہ کی درخواستیں تیار کرتا ہے اس کی لاگت ہر سال ڈالر کے حساب سے ہوگی۔ یہ بہت کم قیمت کا نقطہ ہے اور انسانوں کے ذریعہ ٹیکسٹ پر مبنی AI کے زیادہ تر استعمال کے معاملات کو مالی طور پر قابل عمل بناتا ہے۔

ٹریننگ دوسری طرف GPT-3 بہت زیادہ مہنگا ہے۔ مندرجہ بالا شرحوں پر 3.14*10^23 FLOPS کے لیے صرف کمپیوٹ لاگت کا دوبارہ حساب لگانا ہمیں A560,000 کارڈز پر $100 کا تخمینہ دیتا ہے۔ واحد ٹریننگ رن. عملی طور پر، تربیت کے لیے ہمیں GPU میں تقریباً 100% کارکردگی نہیں ملے گی۔ تاہم ہم تربیت کا وقت کم کرنے کے لیے اصلاح کا بھی استعمال کر سکتے ہیں۔ GPT-3 ٹریننگ لاگت کے دوسرے تخمینے سے $500,000 کرنے کے لئے million 4.6 ملین ، ہارڈ ویئر کے مفروضوں پر منحصر ہے۔ نوٹ کریں کہ یہ ایک رن کی لاگت ہے نہ کہ مجموعی لاگت۔ ممکنہ طور پر ایک سے زیادہ رنز کی ضرورت ہوگی اور کلاؤڈ فراہم کرنے والے طویل مدتی وعدے چاہیں گے (نیچے اس پر مزید)۔ ٹاپ آف دی لائن ماڈلز کی تربیت مہنگی رہتی ہے، لیکن اچھی مالی اعانت سے چلنے والے اسٹارٹ اپ کی پہنچ کے اندر۔

خلاصہ کرنے کے لیے، تخلیقی AI کو آج AI انفراسٹرکچر میں بڑے پیمانے پر سرمایہ کاری کی ضرورت ہے۔ یہ یقین کرنے کی کوئی وجہ نہیں ہے کہ مستقبل قریب میں یہ تبدیلی آئے گی۔ GPT-3 جیسے ماڈل کو تربیت دینا ان سب سے زیادہ کمپیوٹیشنل کاموں میں سے ایک ہے جو بنی نوع انسان نے اب تک کیا ہے۔ اور جب کہ GPUs تیز تر ہو رہے ہیں، اور ہم تربیت کو بہتر بنانے کے طریقے تلاش کر رہے ہیں، AI کی تیز رفتار توسیع ان دونوں اثرات کی نفی کرتی ہے۔

AI انفراسٹرکچر کے لیے غور و فکر

اس مقام تک، ہم نے آپ کو AI ماڈلز کی تربیت اور اندازہ لگانے کے لیے درکار پیمانے کے بارے میں کچھ بصیرت فراہم کرنے کی کوشش کی ہے، اور کون سے بنیادی پیرامیٹرز انہیں چلاتے ہیں۔ اس سیاق و سباق کے ساتھ، اب ہم کچھ عملی رہنمائی فراہم کرنا چاہتے ہیں کہ کس طرح یہ فیصلہ کیا جائے کہ کون سا AI انفراسٹرکچر استعمال کرنا ہے۔

بیرونی بمقابلہ اندرون خانہ بنیادی ڈھانچہ

آئیے اس کا سامنا کریں: GPUs اچھے ہیں۔ بہت سے انجینئرز اور انجینئرنگ ذہن رکھنے والے بانیوں کو اپنے AI ہارڈویئر کی فراہمی کی طرف تعصب ہے، نہ صرف اس وجہ سے کہ یہ ماڈل ٹریننگ پر عمدہ کنٹرول فراہم کرتا ہے، بلکہ اس لیے کہ کمپیوٹنگ پاور کی بڑی مقدار کو استعمال کرنے کے بارے میں کچھ مزہ آتا ہے (نمائش A).

تاہم حقیقت یہ ہے۔ بہت سے اسٹارٹ اپس - خاص طور پر ایپ کمپنیوں کو - کو اپنا AI انفراسٹرکچر بنانے کی ضرورت نہیں ہے۔ دن 1 پر۔ اس کے بجائے، ہوسٹڈ ماڈل سروسز جیسے OpenAI یا Hugging Face (زبان کے لیے) اور Replicate (تصویر تیار کرنے کے لیے) بانیوں کو بنیادی ڈھانچے یا ماڈلز کو منظم کرنے کی ضرورت کے بغیر پروڈکٹ مارکیٹ فٹ کے لیے تیزی سے تلاش کرنے کی اجازت دیتی ہیں۔

یہ خدمات اتنی اچھی ہو گئی ہیں کہ بہت سی کمپنیاں ان سے کبھی فارغ نہیں ہوئیں۔ ڈویلپرز فوری انجینئرنگ اور اعلیٰ ترتیب کے فائن ٹیوننگ خلاصہ (یعنی API کالز کے ذریعے فائن ٹیوننگ) کے ذریعے ماڈل کی کارکردگی پر بامعنی کنٹرول حاصل کر سکتے ہیں۔ ان خدمات کے لیے قیمتوں کا تعین کھپت پر مبنی ہے، اس لیے یہ الگ الگ انفراسٹرکچر چلانے سے اکثر سستا بھی ہوتا ہے۔ ہم نے ایپ کمپنیوں کو $50 ملین سے زیادہ ARR پیدا کرتے ہوئے دیکھا ہے، اور ان کی قیمت $1 بلین سے زیادہ ہے، جو ہوسٹڈ ماڈل سروسز چلاتی ہیں۔

دوسری طرف، کچھ اسٹارٹ اپس - خاص طور پر وہ لوگ جو نئے فاؤنڈیشن ماڈلز کی تربیت کرتے ہیں یا عمودی طور پر مربوط AI ایپلی کیشنز بناتے ہیں - اپنے ماڈلز کو براہ راست چلانے سے گریز نہیں کر سکتے GPUs پر۔ یا تو اس لیے کہ ماڈل مؤثر طریقے سے پروڈکٹ ہے اور ٹیم "ماڈل-مارکیٹ فٹ" کی تلاش کر رہی ہے، یا اس لیے کہ کچھ صلاحیتوں کو حاصل کرنے یا بڑے پیمانے پر معمولی لاگت کو کم کرنے کے لیے تربیت اور/یا تخمینہ پر عمدہ کنٹرول کی ضرورت ہے۔ کسی بھی طرح سے، بنیادی ڈھانچے کا انتظام مسابقتی فائدہ کا ذریعہ بن سکتا ہے۔

کلاؤڈ بمقابلہ ڈیٹا سینٹر تیار ہے۔

زیادہ تر معاملات میں، کلاؤڈ آپ کے AI انفراسٹرکچر کے لیے صحیح جگہ ہے۔ کم سامنے کی لاگت، اوپر اور نیچے کی پیمائش کرنے کی صلاحیت، علاقائی دستیابی، اور اپنا ڈیٹا سینٹر بنانے سے کم خلفشار زیادہ تر اسٹارٹ اپس اور بڑی کمپنیوں کے لیے مجبور ہیں۔

لیکن اس اصول میں چند مستثنیات ہیں:

- اگر آپ بہت بڑے پیمانے پر کام کر رہے ہیں، تو یہ آپ کے اپنے ڈیٹا سینٹر کو چلانے کے لیے زیادہ لاگت سے موثر ہو سکتا ہے۔ صحیح قیمت پوائنٹ جغرافیائی محل وقوع اور سیٹ اپ کی بنیاد پر مختلف ہوتی ہے، لیکن اس کے لیے عام طور پر ہر سال $50 ملین سے زیادہ کے بنیادی ڈھانچے کے اخراجات کی ضرورت ہوتی ہے۔

- آپ کو بہت مخصوص ہارڈ ویئر کی ضرورت ہے جو آپ کلاؤڈ فراہم کنندہ سے حاصل نہیں کرسکتے ہیں۔ مثال کے طور پر، GPU قسمیں جو وسیع پیمانے پر دستیاب نہیں ہیں، نیز غیر معمولی میموری، اسٹوریج، یا نیٹ ورکنگ کی ضروریات۔

- آپ کو کوئی ایسا بادل نہیں مل سکتا جو جغرافیائی سیاسی لحاظ سے قابل قبول ہو۔

اگر آپ اپنا ڈیٹا سینٹر بنانا چاہتے ہیں، تو آپ کے اپنے سیٹ اپ کے لیے GPUs کی قیمت/کارکردگی کا جامع تجزیہ کیا گیا ہے (مثال کے طور پر، ٹم ڈیٹمر کا تجزیہ)۔ کارڈ کی قیمت اور کارکردگی کے علاوہ، ہارڈ ویئر کا انتخاب بھی طاقت، جگہ اور کولنگ پر منحصر ہے۔ مثال کے طور پر، دو RTX 3080 Ti کارڈز ایک ساتھ A100 کے برابر خام کمپیوٹ کی گنجائش رکھتے ہیں، لیکن متعلقہ بجلی کی کھپت 700W بمقابلہ 300W ہے۔ تین سال کے لائف سائیکل میں $3,500/kWh کی مارکیٹ ریٹ پر 0.10 kWh پاور کا فرق RTX3080 Ti کی قیمت میں تقریباً 2x (تقریباً $1,000) اضافہ کرتا ہے۔

ان سب نے کہا، ہم توقع کرتے ہیں کہ سٹارٹ اپ کی اکثریت کلاؤڈ کمپیوٹنگ استعمال کرے گی۔

کلاؤڈ سروس فراہم کرنے والوں کا موازنہ کرنا

ایمیزون ویب سروسز (AWS)، Microsoft Azure، اور Google Cloud Platform (GCP) سبھی GPU مثالیں پیش کرتے ہیں، لیکن نئے فراہم کنندگان بھی خاص طور پر AI کام کے بوجھ پر توجہ مرکوز کرتے دکھائی دے رہے ہیں۔ یہاں ایک فریم ورک ہے جسے ہم نے دیکھا ہے کہ بہت سے بانی کلاؤڈ فراہم کنندہ کو منتخب کرنے کے لیے استعمال کرتے ہیں:

قیمت سے: نیچے دی گئی جدول 7 اپریل 2023 تک بہت سے بڑے اور چھوٹے خاص کلاؤڈز کے لیے قیمتوں کا تعین دکھاتی ہے۔ یہ ڈیٹا صرف اشارہ ہے، کیونکہ مثالیں نیٹ ورک بینڈوتھ، ڈیٹا ایگریس لاگت، CPU اور نیٹ ورک سے اضافی لاگت، دستیاب چھوٹ، اور دیگر عوامل کے لحاظ سے کافی حد تک مختلف ہوتی ہیں۔

مخصوص ہارڈ ویئر پر گنتی کی صلاحیت ایک شے ہے۔ سادہ لوح، ہم کافی یکساں قیمتوں کی توقع کریں گے، لیکن ایسا نہیں ہے۔ اور جب کہ بادلوں کے درمیان نمایاں فرق موجود ہے، وہ یہ بتانے کے لیے ناکافی ہیں کہ آن ڈیمانڈ NVIDIA A100 کی قیمت فراہم کرنے والوں کے درمیان تقریباً 4x کے عنصر سے مختلف ہوتی ہے۔

قیمت کے پیمانے کے اوپری سرے پر، بڑے عوامی بادل برانڈ کی ساکھ، ثابت شدہ وشوسنییتا، اور کام کے بوجھ کی ایک وسیع رینج کو منظم کرنے کی ضرورت کی بنیاد پر ایک پریمیم وصول کرتے ہیں۔ چھوٹے خصوصی AI فراہم کنندگان کم قیمتیں پیش کرتے ہیں، یا تو مقصد سے بنائے گئے ڈیٹا سینٹرز (مثلاً، Coreweave) چلا کر یا دوسرے کلاؤڈز (مثلاً، Lambda Labs) کو ثالثی کر کے۔

عملی طور پر، زیادہ تر بڑے خریدار براہ راست کلاؤڈ فراہم کنندگان کے ساتھ قیمتوں پر بات چیت کرتے ہیں، اکثر کچھ کم از کم اخراجات کی ضرورت کے ساتھ ساتھ کم سے کم وقت کے وعدوں کا بھی عہد کرتے ہیں (ہم نے 1-3 سال دیکھے ہیں)۔ گفت و شنید کے بعد بادلوں کے درمیان قیمت کا فرق کچھ سکڑ جاتا ہے، لیکن ہم نے اوپر والے جدول میں درجہ بندی کو نسبتاً مستحکم دیکھا ہے۔ یہ نوٹ کرنا بھی ضروری ہے کہ چھوٹی کمپنیاں بڑے اخراجات کے وعدوں کے بغیر خصوصی کلاؤڈز سے جارحانہ قیمتیں حاصل کر سکتی ہیں۔

دستیابی: سب سے طاقتور GPUs (مثلاً Nvidia A100s) پچھلے 12 سے زیادہ مہینوں سے مسلسل کم سپلائی میں ہیں۔

یہ سوچنا منطقی ہوگا کہ سب سے اوپر تین کلاؤڈ فراہم کنندگان کے پاس بہترین دستیابی ہے، ان کی بڑی قوت خرید اور وسائل کے پول کے پیش نظر۔ لیکن، کسی حد تک حیرت انگیز طور پر، بہت سے سٹارٹ اپس نے اسے سچ نہیں پایا۔ بڑے بادلوں میں بہت سارے ہارڈ ویئر ہوتے ہیں لیکن ان کے پاس صارفین کی بڑی ضرورتوں کو بھی پورا کرنا ہوتا ہے — جیسے، Azure ChatGPT کے لیے بنیادی میزبان ہے — اور مانگ کو پورا کرنے کے لیے مسلسل صلاحیت میں اضافہ/لیز پر دے رہا ہے۔ دریں اثنا، Nvidia نے نئے خصوصی فراہم کنندگان کے لیے مختص سمیت پوری صنعت میں ہارڈ ویئر کو وسیع پیمانے پر دستیاب کرنے کا عہد کیا ہے۔ (وہ یہ دونوں منصفانہ ہونے اور چند بڑے گاہکوں پر انحصار کم کرنے کے لیے کرتے ہیں جو ان کے ساتھ مقابلہ بھی کرتے ہیں۔)

نتیجتاً، بہت سے اسٹارٹ اپس کو مزید دستیاب چپس مل جاتی ہیں، بشمول جدید ترین Nvidia H100s، چھوٹے کلاؤڈ فراہم کنندگان پر۔ اگر آپ ایک نئی انفراسٹرکچر کمپنی کے ساتھ کام کرنے کے خواہاں ہیں، تو آپ ہارڈ ویئر کے انتظار کے اوقات کو کم کرنے اور اس عمل میں ممکنہ طور پر پیسے بچانے کے قابل ہو سکتے ہیں۔

ڈلیوری ماڈل کی گنتی کریں: بڑے بادل آج صرف سرشار GPUs کے ساتھ مثالیں پیش کرتے ہیں، اس کی وجہ یہ ہے کہ GPU ورچوئلائزیشن اب بھی ایک حل طلب مسئلہ ہے۔ سپیشلائزڈ AI کلاؤڈز دوسرے ماڈلز پیش کرتے ہیں، جیسے کنٹینرز یا بیچ جابز، جو انفرادی کاموں کو بغیر کسی مثال کے سٹارٹ اپ اور ٹیر ڈاون لاگت کے بغیر ہینڈل کر سکتے ہیں۔ اگر آپ اس ماڈل کے ساتھ آرام دہ ہیں، تو یہ کافی حد تک لاگت کو کم کر سکتا ہے۔

نیٹ ورک آپس میں جڑتا ہے: تربیت کے لیے، خاص طور پر، نیٹ ورک بینڈوتھ فراہم کنندہ کے انتخاب میں ایک اہم عنصر ہے۔ کچھ بڑے ماڈلز کو تربیت دینے کے لیے نوڈس کے درمیان مخصوص کپڑوں کے ساتھ کلسٹرز، جیسے NVLink کی ضرورت ہوتی ہے۔ امیج جنریشن کے لیے، ایگریس ٹریفک فیس بھی ایک بڑی لاگت کا ڈرائیور ہو سکتی ہے۔

کسٹمر سپورٹ: بڑے کلاؤڈ فراہم کنندگان ہزاروں پروڈکٹ SKUs میں صارفین کے ایک بہت بڑے تالاب کی خدمت کرتے ہیں۔ کسٹمر سپورٹ کی توجہ حاصل کرنا، یا کسی مسئلے کو حل کرنا مشکل ہو سکتا ہے، جب تک کہ آپ بڑے گاہک نہ ہوں۔ دوسری طرف بہت سے خصوصی AI کلاؤڈز، چھوٹے صارفین کے لیے بھی تیز رفتار اور ذمہ دار سپورٹ پیش کرتے ہیں۔ یہ جزوی طور پر اس لیے ہے کہ وہ چھوٹے پیمانے پر کام کر رہے ہیں، بلکہ اس لیے بھی کہ ان کے کام کا بوجھ زیادہ یکساں ہے — اس لیے وہ AI سے متعلق مخصوص خصوصیات اور کیڑے پر توجہ مرکوز کرنے کے لیے زیادہ ترغیب یافتہ ہیں۔

GPUs کا موازنہ کرنا

باقی سب برابر ہونے کی وجہ سے، اوپر والے GPUs تقریباً تمام کام کے بوجھ پر بہترین کارکردگی کا مظاہرہ کریں گے۔ تاہم، جیسا کہ آپ نیچے دیے گئے جدول میں دیکھ سکتے ہیں، بہترین ہارڈ ویئر بھی کافی زیادہ مہنگا ہے۔ اپنی مخصوص ایپلیکیشن کے لیے صحیح قسم کے GPU کا انتخاب لاگت کو کافی حد تک کم کر سکتا ہے اور ایک قابل عمل اور ناقابل عمل کاروباری ماڈل کے درمیان فرق کر سکتا ہے۔

یہ فیصلہ کرنا کہ فہرست میں کتنا نیچے جانا ہے — یعنی آپ کی درخواست کے لیے سب سے زیادہ لاگت والے GPU انتخاب کا تعین کرنا — بڑی حد تک ایک تکنیکی فیصلہ ہے جو اس مضمون کے دائرہ کار سے باہر ہے۔ لیکن ہم ذیل میں انتخاب کے کچھ معیارات کا اشتراک کریں گے جنہیں ہم نے دیکھا ہے کہ وہ سب سے اہم ہیں:

تربیت بمقابلہ اندازہ: جیسا کہ ہم نے اوپر والے پہلے حصے میں دیکھا، ٹرانسفارمر ماڈل کی تربیت کے لیے ہمیں ماڈل وزن کے علاوہ ٹریننگ کے لیے 8 بائٹس ڈیٹا ذخیرہ کرنے کی ضرورت ہوتی ہے۔ اس کا مطلب ہے کہ 12GB میموری کے ساتھ ایک عام اعلیٰ درجے کا صارف GPU بمشکل 4-بلین پیرامیٹر ماڈل کو تربیت دینے کے لیے استعمال کیا جا سکتا ہے۔ عملی طور پر، بڑے ماڈلز کی تربیت مشینوں کے کلسٹرز پر کی جاتی ہے جس میں ترجیحی طور پر بہت سے GPUs فی سرور، بہت سارے VRAM، اور سرورز کے درمیان اعلی بینڈوتھ کنکشن ہوتے ہیں (یعنی، ٹاپ اینڈ ڈیٹا سینٹر GPUs کے استعمال سے بنائے گئے کلسٹرز)۔

خاص طور پر، بہت سے ماڈلز NVIDIA H100 پر سب سے زیادہ لاگت سے موثر ہوں گے، لیکن آج تک اسے تلاش کرنا مشکل ہے اور عام طور پر ایک سال سے زیادہ طویل مدتی عزم کی ضرورت ہوتی ہے۔ NVIDIA A100 آج سب سے زیادہ ماڈل ٹریننگ چلاتا ہے۔ اسے تلاش کرنا آسان ہے لیکن، بڑے کلسٹرز کے لیے، طویل مدتی عزم کی بھی ضرورت پڑ سکتی ہے۔

میموری کی ضروریات: بڑے LLMs میں پیرامیٹر شمار ہوتے ہیں جو کسی بھی کارڈ میں فٹ ہونے کے لیے بہت زیادہ ہوتے ہیں۔ انہیں متعدد کارڈز میں تقسیم کرنے کی ضرورت ہے اور تربیت کی طرح ایک سیٹ اپ کی ضرورت ہے۔ دوسرے لفظوں میں، آپ کو شاید H100s یا A100s کی ضرورت ہو گی یہاں تک کہ LLM تخمینہ کے لیے۔ لیکن چھوٹے ماڈل (مثال کے طور پر، مستحکم بازی) کو بہت کم VRAM کی ضرورت ہوتی ہے۔ اگرچہ A100 اب بھی مقبول ہے، ہم نے دیکھا ہے کہ اسٹارٹ اپس A10، A40، A4000، A5000 اور A6000، یا یہاں تک کہ RTX کارڈز استعمال کرتے ہیں۔

ہارڈ ویئر سپورٹ: اگرچہ ہم نے NVIDIA پر چلنے کی بات کی ہے کہ کمپنیوں میں کام کے بوجھ کی اکثریت، کچھ نے دوسرے دکانداروں کے ساتھ تجربہ کرنا شروع کر دیا ہے۔ سب سے زیادہ عام گوگل ٹی پی یو ہے، لیکن ایسا لگتا ہے کہ انٹیل کے گاڈی 2 کو بھی کچھ کرشن مل رہا ہے۔ ان دکانداروں کے ساتھ چیلنج یہ ہے کہ آپ کے ماڈل کی کارکردگی اکثر ان چپس کے لیے سافٹ ویئر کی اصلاح کی دستیابی پر بہت زیادہ منحصر ہوتی ہے۔ کارکردگی کو سمجھنے کے لیے آپ کو ممکنہ طور پر پی او سی کرنا پڑے گا۔

تاخیر کے تقاضے: عام طور پر، کم تاخیر سے متعلق حساس کام کا بوجھ (مثال کے طور پر، بیچ ڈیٹا پروسیسنگ یا ایپلیکیشنز جن کو انٹرایکٹو UI جوابات کی ضرورت نہیں ہوتی ہے) کم طاقتور GPUs استعمال کر سکتے ہیں۔ اس سے کمپیوٹ کی لاگت 3-4x تک کم ہو سکتی ہے (مثلاً A100s کا AWS پر A10s سے موازنہ کرنا)۔ دوسری طرف صارف کا سامنا کرنے والی ایپس کو ایک پرکشش، حقیقی وقت میں صارف کا تجربہ فراہم کرنے کے لیے اکثر ٹاپ اینڈ کارڈز کی ضرورت ہوتی ہے۔ لاگت کو قابل انتظام حد تک لانے کے لیے ماڈلز کو بہتر بنانا اکثر ضروری ہوتا ہے۔

تیز پن: تخلیقی AI کمپنیاں اکثر مانگ میں ڈرامائی اضافہ دیکھتی ہیں کیونکہ ٹیکنالوجی بہت نئی اور دلچسپ ہے۔ نئے پروڈکٹ کی ریلیز کی بنیاد پر، درخواست کی مقدار میں ایک دن میں 10 گنا اضافہ دیکھنا، یا فی ہفتہ 50% مسلسل بڑھنا غیر معمولی بات نہیں ہے۔ ان اسپائکس کو ہینڈل کرنا اکثر لوئر اینڈ جی پی یوز پر آسان ہوتا ہے، کیونکہ زیادہ کمپیوٹ نوڈس طلب کے مطابق دستیاب ہوتے ہیں۔ اس قسم کی ٹریفک کو کم لاگت والے وسائل کے ساتھ پیش کرنا بھی اکثر سمجھ میں آتا ہے — کارکردگی کی قیمت پر — اگر یہ کم مصروف یا کم استعمال کرنے والے صارفین سے آتا ہے۔

ماڈلز کو بہتر بنانا اور شیڈول کرنا

سافٹ ویئر کی اصلاح ماڈلز کے چلنے کے وقت کو بہت زیادہ متاثر کر سکتی ہے - اور 10x فوائد غیر معمولی نہیں ہیں۔ تاہم، آپ کو یہ تعین کرنے کی ضرورت ہوگی کہ آپ کے مخصوص ماڈل اور سسٹم کے ساتھ کون سے طریقے سب سے زیادہ موثر ہوں گے۔

کچھ تکنیکیں ماڈلز کی کافی وسیع رینج کے ساتھ کام کرتی ہیں۔ مختصر فلوٹنگ پوائنٹ کی نمائندگی (یعنی، FP16 یا FP8 بمقابلہ اصل FP32) یا کوانٹائزیشن (INT8، INT4، INT2) کا استعمال کرتے ہوئے ایسی رفتار حاصل کریں جو اکثر بٹس کی کمی کے ساتھ لکیری ہوتی ہے۔ اس کے لیے بعض اوقات ماڈل میں ترمیم کی ضرورت ہوتی ہے، لیکن تیزی سے، ایسی ٹیکنالوجیز دستیاب ہیں جو مخلوط یا کم درستگی کے ساتھ کام کرنے کو خودکار کرتی ہیں۔ عصبی نیٹ ورک کی کٹائی کم اقدار والے وزن کو نظر انداز کرکے وزن کی تعداد کو کم کرتی ہے۔ موثر اسپارس میٹرکس ضرب کے ساتھ، یہ جدید GPUs پر کافی رفتار حاصل کر سکتا ہے۔ اصلاح کی تکنیکوں کا ایک اور سیٹ میموری بینڈوڈتھ کی رکاوٹ کو دور کرتا ہے (مثال کے طور پر، ماڈل کے وزن کے ذریعے)۔

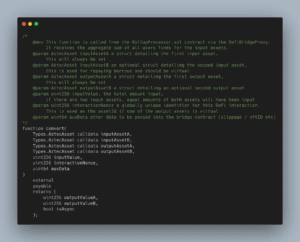

دیگر اصلاحات انتہائی ماڈل کے لیے مخصوص ہیں۔ مثال کے طور پر، Stable Diffusion نے تخمینہ کے لیے درکار VRAM کی مقدار میں بڑی پیش رفت کی ہے۔ پھر بھی اصلاح کی ایک اور کلاس ہارڈ ویئر سے متعلق ہے۔ NVIDIA کے TensorML میں متعدد اصلاحات شامل ہیں، لیکن یہ صرف NVIDIA ہارڈویئر پر کام کرے گی۔ آخری، لیکن کم از کم، AI کاموں کا شیڈولنگ کارکردگی میں بڑی رکاوٹیں یا بہتری پیدا کر سکتا ہے۔ ماڈلز کو GPUs کو اس طرح سے مختص کرنا کہ وزن کی تبدیلی کو کم سے کم کیا جا سکے، اگر ایک سے زیادہ دستیاب ہوں تو کسی کام کے لیے بہترین GPU کا انتخاب، اور کام کے بوجھ کو پہلے سے بیچ کر ڈاؤن ٹائم کو کم سے کم کرنا عام تکنیک ہیں۔

آخر میں، ماڈل آپٹیمائزیشن ابھی بھی تھوڑا سا بلیک آرٹ ہے، اور زیادہ تر اسٹارٹ اپس جن سے ہم سافٹ ویئر کے کچھ پہلوؤں میں مدد کے لیے تیسرے فریق کے ساتھ کام کرنے کے لیے بات کرتے ہیں۔ اکثر، یہ روایتی MLops وینڈرز نہیں ہوتے ہیں، بلکہ اس کے بجائے وہ کمپنیاں ہیں جو مخصوص جنریٹو ماڈلز (جیسے، OctoML یا SegMind) کے لیے اصلاح میں مہارت رکھتی ہیں۔

AI بنیادی ڈھانچے کی لاگت کیسے تیار ہوگی؟

پچھلے کچھ سالوں میں، ہم نے دونوں میں تیزی سے اضافہ دیکھا ہے۔ ماڈل پیرامیٹرز اور GPU کمپیوٹ پاور. یہ واضح نہیں ہے کہ آیا یہ رجحان جاری رہے گا۔

آج، یہ بڑے پیمانے پر قبول کیا جاتا ہے کہ پیرامیٹرز کی زیادہ سے زیادہ تعداد اور تربیتی ڈیٹا سیٹ کے سائز کے درمیان تعلق ہے (دیکھیں ڈیپ مائنڈز چنچیلا اس پر مزید کام کریں)۔ آج کے بہترین LLMs کو تربیت دی جاتی ہے۔ عام کرال (4.5 بلین ویب صفحات کا مجموعہ، یا موجود تمام ویب صفحات کا تقریباً 10%)۔ تربیتی کارپس میں ویکیپیڈیا اور کتابوں کا مجموعہ بھی شامل ہے، حالانکہ دونوں بہت چھوٹی ہیں (موجود کتابوں کی کل تعداد کا تخمینہ ہے صرف 100 ملین کے قریب)۔ دوسرے خیالات، جیسے ویڈیو یا آڈیو مواد کو نقل کرنا، تجویز کیا گیا ہے، لیکن ان میں سے کوئی بھی سائز کے قریب نہیں آتا ہے۔ یہ واضح نہیں ہے کہ آیا ہم ایک غیر مصنوعی تربیتی ڈیٹاسیٹ حاصل کر سکتے ہیں جو پہلے سے استعمال کیے گئے ڈیٹا سے 10x بڑا ہے۔

GPU کی کارکردگی میں اضافہ ہوتا رہے گا، بلکہ سست شرح پر بھی۔ مور کا قانون اب بھی برقرار ہے جو مزید ٹرانجسٹروں اور مزید کوروں کی اجازت دیتا ہے، لیکن پاور اور I/O محدود عوامل بن رہے ہیں۔ مزید برآں، اصلاح کے لیے بہت سے کم لٹکنے والے پھلوں کا انتخاب کیا گیا ہے۔

تاہم، اس میں سے کسی کا بھی مطلب یہ نہیں ہے کہ ہم کمپیوٹ صلاحیت کی طلب میں اضافے کی توقع نہیں کرتے ہیں۔ یہاں تک کہ اگر ماڈل اور ٹریننگ سیٹ کی ترقی سست ہو جاتی ہے، AI انڈسٹری کی ترقی اور AI ڈویلپرز کی تعداد میں اضافہ زیادہ اور تیز GPUs کی مانگ کو ہوا دے گا۔ جی پی یو کی گنجائش کا ایک بڑا حصہ ڈیولپرز کی جانب سے کسی ماڈل کے ڈیولپمنٹ مرحلے کے دوران جانچ کے لیے استعمال کیا جاتا ہے، اور یہ مانگ ہیڈ کاؤنٹ کے ساتھ لکیری طور پر بڑھ جاتی ہے۔ اس بات کی کوئی علامت نہیں ہے کہ ہمارے پاس آج GPU کی کمی مستقبل قریب میں ختم ہو جائے گی۔

کیا AI انفراسٹرکچر کی یہ مسلسل بلند قیمت ایک ایسی کھائی پیدا کر دے گی جو نئے آنے والوں کے لیے اچھی مالی اعانت والے ذمہ داروں کو پکڑنا ناممکن بنا دے؟ ہم ابھی تک اس سوال کا جواب نہیں جانتے۔ LLM کی تربیتی لاگت آج ایک کھائی کی طرح نظر آتی ہے، لیکن اوپن سورس ماڈل جیسے کہ الپاکا یا اسٹیبل ڈفیوژن نے یہ ظاہر کیا ہے کہ یہ مارکیٹیں ابھی بھی ابتدائی ہیں اور تیزی سے بدل سکتی ہیں۔ وقت گزرنے کے ساتھ، ابھرتے ہوئے AI سافٹ ویئر اسٹیک کی لاگت کا ڈھانچہ (ہماری پچھلی پوسٹ دیکھیں) روایتی سافٹ ویئر انڈسٹری کی طرح نظر آنا شروع کر سکتا ہے۔

بالآخر، یہ ایک اچھی چیز ہوگی: تاریخ نے دکھایا ہے کہ یہ تیز رفتار جدت اور کاروباری بانیوں کے لیے بہت سے مواقع کے ساتھ متحرک ماحولیاتی نظام کی طرف لے جاتا ہے۔

تحریری عمل کے دوران ان پٹ اور رہنمائی کے لیے معین ندیم اور شنگدا سو کا شکریہ۔

¹ یہاں وجدان یہ ہے کہ نیورل نیٹ ورک میں کسی بھی پیرامیٹر (یعنی وزن) کے لیے، ایک انفرنس آپریشن (یعنی فارورڈ پاس) کو فی پیرامیٹر دو فلوٹنگ پوائنٹ آپریشن کرنے کی ضرورت ہے۔ سب سے پہلے، یہ نیورل نیٹ ورک کے ان پٹ نوڈ کی قدر کو پیرامیٹر کے ساتھ ضرب دیتا ہے۔ دوسرا، یہ نیورل نیٹ ورک کے آؤٹ پٹ نوڈ میں سمیشن کا نتیجہ شامل کرتا ہے۔ انکوڈر میں پیرامیٹرز فی ان پٹ ٹوکن ایک بار استعمال ہوتے ہیں اور ڈیکوڈر میں پیرامیٹرز فی آؤٹ پٹ ٹوکن ایک بار استعمال ہوتے ہیں۔ اگر ہم فرض کریں کہ ایک ماڈل ہے۔ p پیرامیٹرز اور ان پٹ اور آؤٹ پٹ دونوں کی لمبائی ہوتی ہے۔ n ٹوکن, کل فلوٹنگ پوائنٹ آپریشنز ہیں۔ n * p. بہت سے دوسرے آپریشنز ہیں (مثلاً نارملائزیشن، ایمبیڈنگ کو انکوڈنگ/ڈی کوڈنگ) جو ماڈل میں ہوتے ہیں، لیکن ان کو انجام دینے میں جو وقت لگتا ہے وہ اس کے مقابلے میں بہت کم ہے۔

² سیکھنے کے لیے سب سے پہلے ٹرانسفارمر کے ذریعے فارورڈ پاس کی ضرورت ہوتی ہے جیسا کہ اوپر بیان کیا گیا ہے، اس کے بعد ایک پسماندہ پاس ہوتا ہے جو گریڈینٹ کا حساب لگانے اور وزن کو ایڈجسٹ کرنے کے لیے فی پیرامیٹر چار اضافی آپریشن کرتا ہے۔ نوٹ کریں کہ گریڈینٹ کا حساب لگانے کے لیے فارورڈ پاس سے حساب شدہ نوڈ ویلیوز کو محفوظ کرنے کی ضرورت ہوتی ہے۔ GPT-3 کے لیے، زبان کے ماڈلز چند شاٹ سیکھنے والے ہیں۔ تربیت کی لاگت پر تبادلہ خیال.

* * *

یہاں بیان کردہ خیالات انفرادی AH Capital Management, LLC ("a16z") کے اہلکاروں کے ہیں جن کا حوالہ دیا گیا ہے اور یہ a16z یا اس سے وابستہ افراد کے خیالات نہیں ہیں۔ یہاں پر موجود کچھ معلومات فریق ثالث کے ذرائع سے حاصل کی گئی ہیں، بشمول a16z کے زیر انتظام فنڈز کی پورٹ فولیو کمپنیوں سے۔ جب کہ معتبر مانے جانے والے ذرائع سے لیا گیا ہے، a16z نے آزادانہ طور پر ایسی معلومات کی تصدیق نہیں کی ہے اور معلومات کی پائیدار درستگی یا دی گئی صورت حال کے لیے اس کی مناسبیت کے بارے میں کوئی نمائندگی نہیں کی ہے۔ اس کے علاوہ، اس مواد میں فریق ثالث کے اشتہارات شامل ہو سکتے ہیں۔ a16z نے ایسے اشتہارات کا جائزہ نہیں لیا ہے اور اس میں موجود کسی بھی اشتہاری مواد کی توثیق نہیں کرتا ہے۔

یہ مواد صرف معلوماتی مقاصد کے لیے فراہم کیا گیا ہے، اور قانونی، کاروبار، سرمایہ کاری، یا ٹیکس کے مشورے کے طور پر اس پر انحصار نہیں کیا جانا چاہیے۔ آپ کو ان معاملات کے بارے میں اپنے مشیروں سے مشورہ کرنا چاہئے۔ کسی بھی سیکیورٹیز یا ڈیجیٹل اثاثوں کے حوالے صرف مثالی مقاصد کے لیے ہیں، اور سرمایہ کاری کی سفارش یا پیشکش کی تشکیل نہیں کرتے ہیں کہ سرمایہ کاری کی مشاورتی خدمات فراہم کریں۔ مزید برآں، یہ مواد کسی سرمایہ کار یا ممکنہ سرمایہ کاروں کی طرف سے استعمال کرنے کے لیے نہیں ہے اور نہ ہی اس کا مقصد ہے، اور کسی بھی صورت میں a16z کے زیر انتظام کسی بھی فنڈ میں سرمایہ کاری کرنے کا فیصلہ کرتے وقت اس پر انحصار نہیں کیا جا سکتا ہے۔ (a16z فنڈ میں سرمایہ کاری کرنے کی پیشکش صرف پرائیویٹ پلیسمنٹ میمورنڈم، سبسکرپشن ایگریمنٹ، اور اس طرح کے کسی بھی فنڈ کی دیگر متعلقہ دستاویزات کے ذریعے کی جائے گی اور ان کو مکمل طور پر پڑھا جانا چاہیے۔) کوئی بھی سرمایہ کاری یا پورٹ فولیو کمپنیوں کا ذکر کیا گیا، حوالہ دیا گیا، یا بیان کردہ A16z کے زیر انتظام گاڑیوں میں ہونے والی تمام سرمایہ کاری کے نمائندے نہیں ہیں، اور اس بات کی کوئی یقین دہانی نہیں ہو سکتی کہ سرمایہ کاری منافع بخش ہو گی یا مستقبل میں کی جانے والی دیگر سرمایہ کاری میں بھی ایسی ہی خصوصیات یا نتائج ہوں گے۔ Andreessen Horowitz کے زیر انتظام فنڈز کے ذریعے کی گئی سرمایہ کاری کی فہرست (ان سرمایہ کاری کو چھوڑ کر جن کے لیے جاری کنندہ نے a16z کو عوامی طور پر ظاہر کرنے کے ساتھ ساتھ عوامی طور پر تجارت کیے جانے والے ڈیجیٹل اثاثوں میں غیر اعلانیہ سرمایہ کاری کی اجازت فراہم نہیں کی ہے) https://a16z.com/investments پر دستیاب ہے۔ /.

اندر فراہم کردہ چارٹس اور گراف صرف معلوماتی مقاصد کے لیے ہیں اور سرمایہ کاری کا کوئی فیصلہ کرتے وقت ان پر انحصار نہیں کیا جانا چاہیے۔ ماضی کی کارکردگی مستقبل کے نتائج کا اشارہ نہیں ہے۔ مواد صرف اشارہ کردہ تاریخ کے مطابق بولتا ہے۔ کوئی بھی تخمینہ، تخمینہ، پیشن گوئی، اہداف، امکانات، اور/یا ان مواد میں بیان کیے گئے خیالات بغیر اطلاع کے تبدیل کیے جا سکتے ہیں اور دوسروں کی رائے سے مختلف یا اس کے برعکس ہو سکتے ہیں۔ اضافی اہم معلومات کے لیے براہ کرم https://a16z.com/disclosures دیکھیں۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹوآئ اسٹریم۔ ویب 3 ڈیٹا انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ایڈریین ایشلے کے ساتھ مستقبل کا نقشہ بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://a16z.com/2023/04/27/navigating-the-high-cost-of-ai-compute/

- : ہے

- : ہے

- : نہیں

- ارب 1 ڈالر

- $UP

- 000

- 1

- 100

- 116

- 15 سال

- 2023

- 500

- 7

- 8

- a

- a16z

- کی صلاحیت

- قابلیت

- ہمارے بارے میں

- اوپر

- مطلق

- رفتار کو تیز تر

- مسرع

- ایکسلریٹر

- قابل قبول

- مقبول

- تک رسائی حاصل

- درستگی

- درست

- حاصل

- کے پار

- انہوں نے مزید کہا

- اس کے علاوہ

- ایڈیشنل

- اس کے علاوہ

- اضافے

- پتے

- جوڑتا ہے

- آگے بڑھانے کے

- ترقی

- فائدہ

- اشتہار.

- مشورہ

- مشاورتی

- مشاورتی خدمات

- پر اثر انداز

- ملحقہ

- کے بعد

- پھر

- جارحانہ

- معاہدہ

- AI

- الگورتھم

- تمام

- تین ہلاک

- اجازت دے رہا ہے

- پہلے ہی

- بھی

- اگرچہ

- کے درمیان

- رقم

- مقدار

- an

- تجزیہ

- اور

- اینڈریسن

- اندیسن Horowitz

- ایک اور

- جواب

- متوقع

- کوئی بھی

- اے پی آئی

- اپلی کیشن

- ظاہر ہوتا ہے

- ظاہر ہوتا ہے

- درخواست

- ایپلی کیشنز

- تقریبا

- ایپس

- اپریل

- فن تعمیر

- کیا

- دلیل

- ارد گرد

- فن

- مضمون

- مصنوعی

- مصنوعی ذہانت

- AS

- پہلوؤں

- اثاثے

- یقین دہانی

- At

- توجہ

- آڈیو

- خود کار طریقے سے

- دستیابی

- دستیاب

- اوسط

- سے اجتناب

- AWS

- Azure

- بینڈوڈتھ

- کی بنیاد پر

- BE

- کیونکہ

- بن

- ہو جاتا ہے

- بننے

- رہا

- کیا جا رہا ہے

- یقین ہے کہ

- خیال کیا

- نیچے

- BEST

- بہتر

- کے درمیان

- سے پرے

- تعصب

- بگ

- ارب

- بٹ

- سیاہ

- کتب

- بوم

- دونوں

- بنقی

- برانڈ

- توڑ

- لانے

- وسیع

- موٹے طور پر

- کیڑوں

- تعمیر

- عمارت

- تعمیر

- کاروبار

- بزنس ماڈل

- لیکن

- خریدار

- by

- حساب

- حساب

- حساب

- کالز

- کر سکتے ہیں

- حاصل کر سکتے ہیں

- نہیں کر سکتے ہیں

- صلاحیتوں

- اہلیت

- دارالحکومت

- کارڈ

- کارڈ

- کیس

- مقدمات

- پکڑو

- سینٹر

- مراکز

- کچھ

- چیلنج

- تبدیل

- خصوصیات

- حروف

- چارج

- چیٹ جی پی ٹی

- سستی

- چپ

- چپس

- انتخاب

- میں سے انتخاب کریں

- حالات

- طبقے

- واضح

- گھڑی

- کلوز

- بادل

- کلاؤڈ کمپیوٹنگ

- کلاؤڈ پلیٹ فارم

- مجموعہ

- کس طرح

- آتا ہے

- آرام دہ اور پرسکون

- وابستگی

- انجام دیا

- کام کرنا

- شے

- کامن

- کمپنیاں

- کمپنی کے

- مقابلے میں

- موازنہ

- موازنہ

- زبردست

- مقابلہ

- مقابلہ

- پیچیدگی

- وسیع

- حساب

- کمپیوٹنگ

- کمپیوٹنگ

- کمپیوٹنگ طاقت

- کنکشن

- غور

- خیالات

- مسلسل

- قیام

- بسم

- صارفین

- کھپت

- کنٹینر

- مواد

- سیاق و سباق

- جاری

- جاری رہی

- برعکس

- کنٹرول

- ٹھنڈی

- کور

- قیمت

- سرمایہ کاری مؤثر

- اخراجات

- سکتا ہے

- کورس

- تخلیق

- تخلیق

- معیار

- اس وقت

- گاہک

- کسٹمر سپورٹ

- گاہکوں

- جدید

- سائیکل

- اعداد و شمار

- ڈیٹا سینٹر

- ڈیٹا مراکز

- ڈیٹا پروسیسنگ

- ڈیٹا سیٹ

- ڈیٹا بیس

- تاریخ

- دن

- دہائیوں

- فیصلہ کرنا

- فیصلہ

- وقف

- Deepmind

- نجات

- ترسیل

- ڈیمانڈ

- انحصار

- انحصار

- منحصر ہے

- انحصار کرتا ہے

- بیان کیا

- ڈیسک ٹاپ

- اس بات کا تعین

- کا تعین کرنے

- ترقی یافتہ

- ڈویلپرز

- ترقی

- مختلف

- فرق

- اختلافات

- براڈ کاسٹننگ

- ڈیجیٹل

- ڈیجیٹل اثاثے۔

- براہ راست

- ظاہر

- چھوٹ

- مختلف

- do

- دستاویزات

- کرتا

- کر

- ڈالر

- کیا

- نہیں

- نیچے

- ٹائم ٹائم

- ڈرامائی

- ڈرائیو

- ڈرائیور

- ڈرائیونگ

- دو

- کے دوران

- e

- ابتدائی

- آسان

- آسانی سے

- ماحولیاتی نظام۔

- موثر

- مؤثر طریقے

- اثرات

- کارکردگی

- ہنر

- یا تو

- سرایت کرنا

- کرنڈ

- آخر

- یقین ہے

- پائیدار

- مصروف

- مشغول

- انجنیئرنگ

- انجینئرز

- پوری

- آنے والا

- کاروباری

- مساوی

- خاص طور پر

- بنیادی طور پر

- تخمینہ

- اندازے کے مطابق

- اندازوں کے مطابق

- بھی

- کبھی نہیں

- تیار

- مثال کے طور پر

- سے تجاوز

- دلچسپ

- چھوڑ کر

- عملدرآمد

- پھانسی

- وجود

- توسیع

- توقع ہے

- مہنگی

- تجربہ

- وضاحت

- ظالمانہ

- اسیاتی اضافہ

- اظہار

- انتہائی

- کپڑے

- چہرہ

- عوامل

- منصفانہ

- کافی

- خاندان

- فاسٹ

- تیز تر

- نمایاں کریں

- خصوصیات

- فیس

- چند

- مالی طور پر

- مل

- آخر

- پہلا

- فٹ

- مقرر

- پلٹائیں

- سچل

- توجہ مرکوز

- پیچھے پیچھے

- کے لئے

- پیشن گوئی

- خوش قسمتی سے

- آگے

- ملا

- فاؤنڈیشن

- بانیوں

- چار

- کسر

- فریم ورک

- سے

- ایندھن

- مزہ

- فنڈ

- فنڈز

- مزید برآں

- مستقبل

- فوائد

- گیمنگ

- جنرل

- پیدا کرنے والے

- نسل

- پیداواری

- پیداواری AI۔

- جغرافیائی

- جغرافیہ

- حاصل

- حاصل کرنے

- دے دو

- دی

- فراہم کرتا ہے

- Go

- اچھا

- گوگل

- گوگل کلاؤڈ

- گوگل کلاؤڈ پلیٹ فارم

- GPU

- GPUs

- چلے

- گرافکس

- گرافکس

- بڑھائیں

- ترقی

- رہنمائی

- ہاتھ

- ہینڈل

- ہینڈلنگ

- ہو

- ہارڈ

- ہارڈ ویئر

- استعمال کرنا

- ہے

- ہیڈکاؤنٹ

- سنا

- مدد

- مدد گار

- یہاں

- ہائی

- ہائی اینڈ

- انتہائی

- تاریخ

- ہڈ

- امید ہے کہ

- Horowitz

- میزبان

- میزبانی کی

- HOURS

- کس طرح

- کیسے

- تاہم

- HTML

- HTTPS

- بھاری

- بھاری

- انسان

- i

- خیالات

- if

- تصویر

- فوری طور پر

- اہم

- ناممکن

- بہتری

- in

- دیگر میں

- حوصلہ افزائی

- شامل

- شامل ہیں

- سمیت

- اضافہ

- اضافہ

- دن بدن

- آزادانہ طور پر

- اشارہ کیا

- انفرادی

- صنعت

- معلومات

- معلومات

- انفراسٹرکچر

- جدت طرازی

- ان پٹ

- مثال کے طور پر

- کے بجائے

- ہدایات

- ضم

- انٹیلی جنس

- انٹرایکٹو

- میں

- سرمایہ کاری

- سرمایہ کاری

- سرمایہ کاری کے مشورے

- سرمایہ کاری

- سرمایہ

- اجراء کنندہ

- IT

- میں

- خود

- نوکریاں

- صرف

- رکھیں

- بچے

- جان

- لیبز

- زمین کی تزئین کی

- زبان

- بڑے

- بڑے پیمانے پر

- بڑے

- آخری

- تاخیر

- قانون

- لیڈز

- سیکھنے

- قانونی

- لمبائی

- زندگی

- کی طرح

- امکان

- لسٹ

- لاما

- ایل ایل ایم

- محل وقوع

- منطقی

- لانگ

- طویل مدتی

- اب

- دیکھو

- کی طرح دیکھو

- تلاش

- بہت

- لو

- کم

- سب سے کم

- مشینیں

- بنا

- اہم

- اکثریت

- بنا

- بناتا ہے

- بنانا

- انتظام

- میں کامیاب

- انتظام

- مینیجنگ

- انسان

- بہت سے

- مارکیٹ

- Markets

- بڑے پیمانے پر

- مواد

- ریاضی

- میٹرکس

- معاملات

- زیادہ سے زیادہ چوڑائی

- مئی..

- بامعنی

- کا مطلب ہے کہ

- دریں اثناء

- سے ملو

- میمورنڈم

- یاد داشت

- ذکر کیا

- طریقوں

- مائیکروسافٹ

- مائیکروسافٹ Azure

- دس لاکھ

- کم سے کم

- کم سے کم

- مخلوط

- ایم ایل اوپس

- ماڈل

- ماڈل

- جدید

- قیمت

- ماہ

- زیادہ

- سب سے زیادہ

- سب سے زیادہ مقبول

- بہت

- ایک سے زیادہ

- ضرب لگانا

- تشریف لے جارہا ہے

- قریب

- تقریبا

- ضروری

- ضرورت ہے

- ضرورت

- ضروریات

- نیٹ ورک

- نیٹ ورکنگ

- نیٹ ورک

- عصبی نیٹ ورک

- نیند نیٹ ورک

- نئی

- نئی مصنوعات

- خبر

- اگلے

- نہیں

- نوڈ

- نوڈس

- نوٹس..

- اب

- تعداد

- تعداد

- NVIDIA

- حاصل

- حاصل کی

- of

- پیش کرتے ہیں

- کی پیشکش

- اکثر

- on

- ڈیمانڈ

- ایک بار

- ایک

- آن لائن

- صرف

- کھول

- اوپن سورس

- اوپنائی

- کام

- آپریشن

- آپریشنز

- رائے

- مواقع

- زیادہ سے زیادہ

- اصلاح کے

- کی اصلاح کریں

- اصلاح

- اصلاح

- or

- حکم

- اصل

- اصل میں

- دیگر

- دیگر

- ہمارے

- باہر

- پیداوار

- آؤٹ ٹریپس

- پر

- مجموعی طور پر

- خود

- متوازی

- پیرامیٹر

- پیرامیٹرز

- خاص طور پر

- جماعتوں

- حصے

- منظور

- گزشتہ

- انجام دیں

- کارکردگی

- اجازت

- کارمک

- مرحلہ

- لینے

- اٹھایا

- مقام

- پلیٹ فارم

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- مہربانی کرکے

- پی او سی

- پوائنٹ

- پول

- مقبول

- پورٹ فولیو

- ممکنہ طور پر

- پوسٹ

- طاقت

- طاقتور

- عملی

- پریکٹس

- صحت سے متعلق

- پریمیم

- پچھلا

- قیمت

- قیمتیں

- قیمتوں کا تعین

- پرائمری

- نجی

- شاید

- مسئلہ

- مسائل

- عمل

- پروسیسنگ

- پروسیسر

- مصنوعات

- منافع بخش

- اس تخمینے میں

- جائیداد

- ممکنہ

- امکانات

- ثابت

- فراہم

- فراہم

- فراہم کنندہ

- فراہم کرنے والے

- عوامی

- عوامی طور پر

- خریداری

- مقاصد

- سوال

- جلدی سے

- آر اینڈ ڈی

- اٹھایا

- رینج

- رینکنگ

- تیزی سے

- میں تیزی سے

- شرح

- قیمتیں

- خام

- تک پہنچنے

- پڑھیں

- اصل وقت

- حقیقت

- وجہ

- وجوہات

- سفارش

- کو کم

- کم

- حوالہ جات

- کہا جاتا ہے

- علاقائی

- تعلقات

- نسبتا

- جاری

- متعلقہ

- وشوسنییتا

- قابل اعتماد

- ریلیف

- رہے

- باقی

- نمائندے

- قابل بھروسہ

- شہرت

- درخواست

- درخواستوں

- کی ضرورت

- ضرورت

- ضرورت

- ضروریات

- کی ضرورت ہے

- وسائل

- متعلقہ

- قبول

- نتیجہ

- نتائج کی نمائش

- -جائزہ لیا

- آر ٹی ایکس

- RTX 3080

- RTX 3080 Ti

- حکمرانی

- رن

- چل رہا ہے

- کہا

- اسی

- محفوظ کریں

- پیمانے

- ترازو

- شیڈولنگ

- گنجائش

- تلاش کریں

- تلاش

- دوسری

- سیکنڈ

- سیکشن

- سیکورٹیز

- دیکھنا

- دیکھا

- انتخاب

- احساس

- حساس

- علیحدہ

- تسلسل

- خدمت

- سرورز

- سروس

- سروسز

- مقرر

- سیٹ اپ

- کئی

- سیکنڈ اور

- مختصر

- قلت

- ہونا چاہئے

- دکھایا گیا

- شوز

- کی طرف

- سائن ان کریں

- اسی طرح

- صرف

- بعد

- ایک

- صورتحال

- سائز

- سائز

- سست

- چھوٹے

- چھوٹے

- So

- اب تک

- سافٹ ویئر کی

- حل کرتا ہے

- کچھ

- کچھ

- کچھ بھی نہیں

- ماخذ

- ذرائع

- خلا

- بات

- بولی

- مہارت

- خصوصی

- خاص

- مخصوص

- خاص طور پر

- خرچ

- خرچ کرنا۔

- spikes

- تقسیم

- مستحکم

- ڈھیر لگانا

- شروع کریں

- شروع

- شروع

- سترٹو

- ابھی تک

- ذخیرہ

- ذخیرہ

- محرومی

- ساخت

- موضوع

- سبسکرائب

- کافی

- کامیابی

- اس طرح

- موزوں

- مختصر

- فراہمی

- حمایت

- کے نظام

- ٹیبل

- لے لو

- لیتا ہے

- بات

- اہداف

- ٹاسک

- کاموں

- ٹیکس

- ٹیم

- ٹیکنیکل

- تکنیک

- ٹیکنالوجی

- ٹیکنالوجی

- شرائط

- ٹیسٹنگ

- سے

- کہ

- ۔

- مستقبل

- کے بارے میں معلومات

- زمین کی تزئین کی

- ان

- ان

- وہاں.

- اس میں

- یہ

- وہ

- بات

- لگتا ہے کہ

- سوچنا

- تھرڈ

- تیسرے فریقوں

- تیسری پارٹی

- اس

- ان

- ہزاروں

- تین

- کے ذریعے

- بندھے ہوئے

- وقت

- اوقات

- کرنے کے لئے

- آج

- آج کا

- مل کر

- ٹوکن

- ٹوکن بنانا

- ٹوکن

- بھی

- سب سے اوپر

- کل

- کی طرف

- کرشن

- تجارت کی جاتی ہے

- روایتی

- ٹریفک

- ٹرین

- تربیت یافتہ

- ٹریننگ

- ٹرانسفارمرز

- ترجمہ کریں

- رجحان

- کوشش کی

- ٹریلین

- سچ

- دو

- قسم

- اقسام

- ٹھیٹھ

- عام طور پر

- ui

- غیر معمولی

- کے تحت

- بنیادی

- سمجھ

- منفرد

- یونٹس

- اپ ڈیٹ

- صلی اللہ علیہ وسلم

- us

- استعمال کی شرائط

- استعمال کیس

- استعمال کیا جاتا ہے

- رکن کا

- صارف کا تجربہ

- صارفین

- کا استعمال کرتے ہوئے

- عام طور پر

- قیمتی

- قیمت

- قابل قدر

- اقدار

- مختلف اقسام کے

- وسیع

- گاڑیاں

- دکانداروں

- تصدیق

- عمودی طور پر

- بہت

- قابل عمل

- متحرک

- ویڈیو

- خیالات

- جلد

- vs

- انتظار

- چاہتے ہیں

- تھا

- راستہ..

- طریقوں

- we

- ویب

- ویب خدمات

- ہفتے

- وزن

- اچھا ہے

- کیا

- جب

- جس

- جبکہ

- ڈبلیو

- وسیع

- وسیع رینج

- بڑے پیمانے پر

- وکیپیڈیا

- گے

- تیار

- ساتھ

- کے اندر

- بغیر

- لفظ

- الفاظ

- کام

- کام کر

- گا

- تحریری طور پر

- سال

- سال

- ابھی

- تم

- اور

- زیفیرنیٹ