AGI کو سیدھ میں لانے کے لیے ہمارا نقطہ نظر تجرباتی اور تکراری ہے۔ ہم اپنے AI سسٹمز کی انسانی آراء سے سیکھنے اور AI کا جائزہ لینے میں انسانوں کی مدد کرنے کی صلاحیت کو بہتر بنا رہے ہیں۔ ہمارا مقصد کافی حد تک منسلک AI نظام بنانا ہے جو ہمیں دیگر تمام الائنمنٹ مسائل کو حل کرنے میں مدد دے سکتا ہے۔

تعارف

ہماری صف بندی کی تحقیق اس کا مقصد مصنوعی جنرل انٹیلی جنس (AGI) کو انسانی اقدار کے ساتھ ہم آہنگ کرنا اور انسانی ارادے کی پیروی کرنا ہے۔ ہم ایک تکراری، تجرباتی نقطہ نظر اپناتے ہیں: انتہائی قابل AI سسٹمز کو سیدھ میں لانے کی کوشش کرکے، ہم یہ سیکھ سکتے ہیں کہ کیا کام کرتا ہے اور کیا نہیں، اس طرح AI سسٹم کو محفوظ اور زیادہ مربوط بنانے کی ہماری صلاحیت کو بہتر بناتا ہے۔ سائنسی تجربات کا استعمال کرتے ہوئے، ہم مطالعہ کرتے ہیں کہ الائنمنٹ کی تکنیک کس طرح پیمانہ کرتی ہے اور وہ کہاں ٹوٹتی ہے۔

ہم اپنے سب سے زیادہ قابل AI سسٹمز میں صف بندی کے مسائل کے ساتھ ساتھ صف بندی کے مسائل سے نمٹتے ہیں جن کا ہم AGI کے راستے پر سامنا کرنے کی توقع کرتے ہیں۔ ہمارا بنیادی مقصد موجودہ صف بندی کے خیالات کو جہاں تک ممکن ہو آگے بڑھانا ہے، اور یہ سمجھنا اور دستاویز کرنا ہے کہ وہ کیسے کامیاب ہو سکتے ہیں یا کیوں ناکام ہوں گے۔ ہمیں یقین ہے کہ بنیادی طور پر نئے الائنمنٹ آئیڈیاز کے بغیر بھی، ہم ممکنہ طور پر سیدھ میں ہونے والی تحقیق کو کافی حد تک آگے بڑھانے کے لیے کافی حد تک منسلک AI سسٹم بنا سکتے ہیں۔

غیر منسلک AGI انسانیت کے لیے کافی خطرات پیدا کر سکتا ہے۔ اور AGI صف بندی کے مسئلے کو حل کرنا اتنا مشکل ہوسکتا ہے کہ اس کے لیے پوری انسانیت کو مل کر کام کرنے کی ضرورت ہوگی۔ اس لیے ہم اپنی سیدھ کی تحقیق کو کھلے عام شیئر کرنے کے لیے پرعزم ہیں جب ایسا کرنا محفوظ ہو: ہم اس بارے میں شفاف ہونا چاہتے ہیں کہ ہماری صف بندی کی تکنیک عملی طور پر کتنی اچھی طرح سے کام کرتی ہے اور ہم چاہتے ہیں کہ ہر AGI ڈیولپر دنیا کی بہترین الائنمنٹ تکنیکوں کا استعمال کرے۔

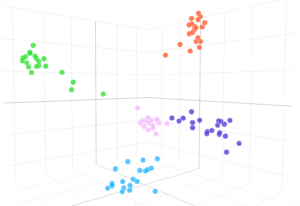

ایک اعلیٰ سطح پر، سیدھ کی تحقیق کے لیے ہمارا نقطہ نظر بہت ہی سمارٹ AI سسٹمز کے لیے ایک قابل توسیع تربیتی سگنل کی انجینئرنگ پر توجہ مرکوز کرتا ہے جو انسانی ارادے کے ساتھ منسلک ہے۔ اس کے تین اہم ستون ہیں:

- انسانی آراء کا استعمال کرتے ہوئے AI نظام کی تربیت

- انسانی تشخیص میں مدد کے لیے AI نظام کی تربیت

- الائنمنٹ ریسرچ کرنے کے لیے AI سسٹمز کو تربیت دینا

AI نظام کو انسانی اقدار کے ساتھ ہم آہنگ کرنے سے دیگر اہم سماجی تکنیکی چیلنجز بھی سامنے آتے ہیں، جیسا کہ یہ فیصلہ کرنا کہ ان نظاموں کو کس کے ساتھ منسلک کیا جائے۔ ان مسائل کو حل کرنے کے لیے ضروری ہے۔ ہمارا مقصدلیکن ہم اس پوسٹ میں ان پر بات نہیں کرتے۔

انسانی آراء کا استعمال کرتے ہوئے AI نظام کی تربیت

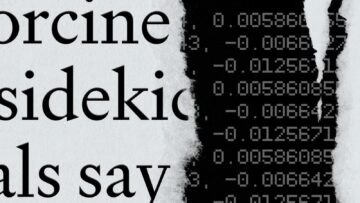

انسانی رائے سے آر ایل آج ہمارے تعینات کردہ زبان کے ماڈلز کو سیدھ میں لانے کے لیے ہماری اہم تکنیک ہے۔ ہم ماڈلز کی ایک کلاس کو تربیت دیتے ہیں جسے کہا جاتا ہے۔ جی پی ٹی کو ہدایات دیں۔ GPT-3 جیسے پہلے سے تربیت یافتہ زبان کے ماڈلز سے ماخوذ۔ ان ماڈلز کو انسانی ارادے کی پیروی کرنے کے لیے تربیت دی جاتی ہے: ہدایت کے ذریعے دیے گئے واضح ارادے کے ساتھ ساتھ سچائی، انصاف پسندی اور حفاظت جیسے مضمر ارادے دونوں۔

ہمارے نتائج سے پتہ چلتا ہے کہ ابھی الائنمنٹ فوکسڈ فائن ٹیوننگ پر بہت کم لٹکا ہوا پھل ہے: InstructGPT کو انسان 100x بڑے پہلے سے تربیت یافتہ ماڈل پر ترجیح دیتے ہیں، جبکہ اس کی فائن ٹیوننگ کی لاگت GPT-2 کے پہلے سے ٹریننگ کمپیوٹ کا <3% ہے۔ اور تقریباً 20,000 گھنٹے انسانی تاثرات۔ ہم امید کرتے ہیں کہ ہمارا کام صنعت میں دوسروں کو بڑے لینگویج ماڈلز کی صف بندی میں اپنی سرمایہ کاری بڑھانے کی ترغیب دیتا ہے اور اس سے تعینات ماڈلز کی حفاظت کے بارے میں صارفین کی توقعات پر پابندی عائد ہوتی ہے۔

ہماری قدرتی زبان API ہماری صف بندی کی تحقیق کے لیے ایک بہت مفید ماحول ہے: یہ ہمیں ایک بھرپور فیڈ بیک لوپ فراہم کرتا ہے کہ ہماری صف بندی کی تکنیک دراصل کتنی اچھی طرح سے کام کرتی ہے۔ حقیقی دنیا میں, کاموں کے ایک بہت ہی متنوع سیٹ پر مبنی ہے جس کے لیے ہمارے صارفین رقم ادا کرنے کو تیار ہیں۔ اوسطاً، ہمارے صارفین پہلے سے ہی ہمارے پہلے سے تربیت یافتہ ماڈلز پر InstructGPT استعمال کرنے کو ترجیح دیتے ہیں۔

ابھی تک InstructGPT کے آج کے ورژن ہیں۔ مکمل طور پر منسلک ہونے سے کافی دور: وہ بعض اوقات سادہ ہدایات پر عمل کرنے میں ناکام رہتے ہیں، ہمیشہ سچے نہیں ہوتے، نقصان دہ کاموں کو قابل اعتماد طریقے سے انکار نہیں کرتے، اور بعض اوقات متعصب یا زہریلے ردعمل دیتے ہیں۔ کچھ صارفین کو InstructGPT کے جوابات پہلے سے تربیت یافتہ ماڈلز کے مقابلے میں نمایاں طور پر کم تخلیقی لگتے ہیں، جس کا ہمیں عوامی طور پر دستیاب بینچ مارکس پر InstructGPT چلانے سے احساس نہیں ہوا تھا۔ ہم انسانی تاثرات سے RL کے بارے میں مزید تفصیلی سائنسی تفہیم تیار کرنے اور انسانی تاثرات کے معیار کو کیسے بہتر بنانے پر بھی کام کر رہے ہیں۔

ہمارے API کو سیدھ میں لانا AGI کو سیدھ میں لانے سے کہیں زیادہ آسان ہے کیونکہ ہمارے API پر زیادہ تر کاموں کی نگرانی کرنا انسانوں کے لیے بہت مشکل نہیں ہوتا ہے اور ہمارے تعینات کردہ زبان کے ماڈل انسانوں سے زیادہ ہوشیار نہیں ہوتے ہیں۔ ہم انسانی تاثرات سے RL کی توقع نہیں کرتے کہ AGI کو سیدھ میں لانے کے لیے کافی ہو، لیکن یہ توسیع پذیر سیدھ کی تجاویز کے لیے ایک بنیادی تعمیراتی بلاک ہے جس کے بارے میں ہم سب سے زیادہ پرجوش ہیں، اور اس لیے اس طریقہ کار کو مکمل کرنا قابل قدر ہے۔

انسانی تشخیص میں مدد کے لیے تربیتی ماڈل

انسانی تاثرات سے آر ایل کی ایک بنیادی حد ہے: یہ فرض کرتا ہے کہ انسان ان کاموں کا درست اندازہ لگا سکتا ہے جو ہمارے AI سسٹمز کر رہے ہیں۔ آج انسان اس میں کافی اچھے ہیں، لیکن جیسے جیسے ماڈلز زیادہ قابل ہوتے جائیں گے، وہ ایسے کام کرنے کے قابل ہو جائیں گے جن کا اندازہ لگانا انسانوں کے لیے بہت مشکل ہے (مثلاً کسی بڑے کوڈ بیس یا سائنسی مقالے میں تمام خامیوں کو تلاش کرنا)۔ ہمارے ماڈلز ہمارے انسانی تجزیہ کاروں کو سچ بتانے کے بجائے یہ بتانا سیکھ سکتے ہیں کہ وہ کیا سننا چاہتے ہیں۔ سیدھ کو پیمانہ کرنے کے لیے، ہم اس طرح کی تکنیک استعمال کرنا چاہتے ہیں۔ تکراری انعام ماڈلنگ (RRM), بحث، اور تکرار پروردن.

فی الحال ہماری اصل سمت RRM پر مبنی ہے: ہم ایسے ماڈلز کو تربیت دیتے ہیں جو انسانوں کو ایسے کاموں پر ہمارے ماڈلز کا جائزہ لینے میں مدد کر سکتے ہیں جن کا براہ راست جائزہ لینا انسانوں کے لیے بہت مشکل ہے۔ مثال کے طور پر:

- ہم نے ایک ماڈل کو تربیت دی۔ کتابوں کا خلاصہ کریں. اگر انسان کتاب سے ناواقف ہیں تو کتاب کے خلاصوں کا جائزہ لینے میں کافی وقت لگتا ہے، لیکن ہمارا ماڈل باب کے خلاصے لکھ کر انسانی تشخیص میں مدد کر سکتا ہے۔

- ہم نے ایک ماڈل کو تربیت دی۔ حقائق کی درستگی کا جائزہ لینے میں انسانوں کی مدد کریں۔ ویب براؤز کرکے اور اقتباسات اور لنکس فراہم کرکے۔ سادہ سوالات پر، اس ماڈل کے نتائج پہلے ہی انسانوں کے لکھے ہوئے جوابات پر ترجیح دی جاتی ہیں۔

- ہم نے ایک ماڈل کو تربیت دی۔ اس کے اپنے نتائج پر تنقیدی تبصرے لکھیں۔: استفسار پر مبنی خلاصہ کے کام پر، تنقیدی تبصروں کے ساتھ مدد ان خامیوں کو بڑھاتی ہے جو انسانوں کو ماڈل آؤٹ پٹس میں پائی جاتی ہیں اوسطاً 50%۔ یہاں تک کہ اگر ہم انسانوں سے معقول نظر آنے والے لیکن غلط خلاصے لکھنے کے لیے کہیں تو یہ برقرار رہتا ہے۔

- ہم کوڈنگ کے کاموں کا ایک سیٹ تیار کر رہے ہیں جن کا انتخاب بہت مشکل ہے تاکہ غیر مدد یافتہ انسانوں کے لیے قابل اعتماد طریقے سے اندازہ لگا سکے۔ ہم اس ڈیٹا سیٹ کو جلد ہی جاری کرنے کی امید کرتے ہیں۔

ہماری صف بندی کی تکنیکوں کو کام کرنے کی ضرورت ہے یہاں تک کہ اگر ہمارے AI سسٹم بہت تخلیقی حل تجویز کر رہے ہوں (جیسے الفاگو کا اقدام 37)، اس طرح ہم خاص طور پر ٹریننگ ماڈلز میں دلچسپی رکھتے ہیں تاکہ انسانوں کو گمراہ کن یا فریب دینے والے حلوں سے درست فرق کرنے میں مدد ملے۔ ہمیں یقین ہے کہ عملی طور پر AI کی مدد سے تشخیص کے کام کو کیسے بنایا جائے اس کے بارے میں زیادہ سے زیادہ سیکھنے کا بہترین طریقہ AI معاونوں کو بنانا ہے۔

الائنمنٹ ریسرچ کرنے کے لیے AI سسٹمز کو تربیت دینا

صف بندی کے مسئلے کا فی الحال کوئی غیر معینہ مدت تک قابل توسیع حل نہیں ہے۔ جیسا کہ AI کی پیشرفت جاری ہے، ہم توقع کرتے ہیں کہ ہم صف بندی کے متعدد نئے مسائل کا سامنا کریں گے جن کا ہم ابھی تک موجودہ نظاموں میں مشاہدہ نہیں کرتے ہیں۔ ان میں سے کچھ مسائل جو ہم ابھی متوقع ہیں اور ان میں سے کچھ بالکل نئے ہوں گے۔

ہم سمجھتے ہیں کہ غیر معینہ مدت تک توسیع پذیر حل تلاش کرنا بہت مشکل ہے۔ اس کے بجائے، ہمارا مقصد ایک زیادہ عملی نقطہ نظر ہے: ایک ایسے نظام کی تعمیر اور سیدھ میں لانا جو انسانوں کے مقابلے میں تیز اور بہتر سیدھ میں تحقیقی پیشرفت کر سکے۔

جیسا کہ ہم اس پر پیشرفت کرتے ہیں، ہمارے AI سسٹمز ہمارے زیادہ سے زیادہ الائنمنٹ کے کام کو سنبھال سکتے ہیں اور بالآخر ہمارے پاس اب کی نسبت بہتر الائنمنٹ تکنیکوں کو تصور، لاگو، مطالعہ اور تیار کر سکتے ہیں۔ وہ اس بات کو یقینی بنانے کے لیے انسانوں کے ساتھ مل کر کام کریں گے کہ ان کے اپنے جانشین انسانوں کے ساتھ زیادہ ہم آہنگ ہوں۔

ہم سمجھتے ہیں کہ الائنمنٹ ریسرچ کا اندازہ لگانا اسے تیار کرنے سے کافی حد تک آسان ہے، خاص طور پر جب تشخیص میں مدد فراہم کی جائے۔ اس لیے انسانی محققین اس تحقیق کو خود تیار کرنے کے بجائے AI سسٹمز کے ذریعے کی جانے والی سیدھ کی تحقیق کا جائزہ لینے پر اپنی زیادہ سے زیادہ کوششیں مرکوز کریں گے۔ ہمارا مقصد ماڈلز کو اس طرح منسلک کرنے کی تربیت دینا ہے کہ ہم الائنمنٹ ریسرچ کے لیے درکار تقریباً تمام علمی مشقت کو آف لوڈ کر سکیں۔

اہم بات یہ ہے کہ ہمیں صرف "تنگ" AI سسٹمز کی ضرورت ہے جو متعلقہ ڈومینز میں انسانی سطح کی صلاحیتوں کے ساتھ ساتھ انسانوں کو سیدھ میں کرنے کی تحقیق پر بھی کام کریں۔ ہم توقع کرتے ہیں کہ یہ AI سسٹمز عام مقصد کے نظاموں یا انسانوں کے مقابلے زیادہ ہوشیار نظاموں کے مقابلے میں آسان ہیں۔

زبان کے ماڈل خاص طور پر خودکار الائنمنٹ ریسرچ کے لیے موزوں ہیں کیونکہ وہ انٹرنیٹ کو پڑھنے سے انسانی اقدار کے بارے میں بہت سارے علم اور معلومات کے ساتھ "پہلے سے لوڈ" ہوتے ہیں۔ باکس سے باہر، وہ آزاد ایجنٹ نہیں ہیں اور اس طرح دنیا میں اپنے مقاصد کو حاصل نہیں کرتے ہیں۔ الائنمنٹ ریسرچ کرنے کے لیے انہیں انٹرنیٹ تک غیر محدود رسائی کی ضرورت نہیں ہے۔ اس کے باوجود بہت سارے سیدھ کے تحقیقی کاموں کو قدرتی زبان یا کوڈنگ کے کاموں کے طور پر بیان کیا جاسکتا ہے۔

کے مستقبل کے ورژن ویب جی پی ٹی, جی پی ٹی کو ہدایات دیں۔، اور کوڈیکس الائنمنٹ ریسرچ اسسٹنٹ کے طور پر ایک بنیاد فراہم کر سکتے ہیں، لیکن وہ ابھی تک کافی قابل نہیں ہیں۔ اگرچہ ہم یہ نہیں جانتے کہ ہمارے ماڈل کب اس قابل ہو جائیں گے کہ ہم صف بندی کی تحقیق میں بامعنی تعاون کر سکیں، ہمارے خیال میں وقت سے پہلے شروع کرنا ضروری ہے۔ ایک بار جب ہم ایک ایسے ماڈل کو تربیت دیتے ہیں جو مفید ہو سکتا ہے، ہم اسے بیرونی صف بندی کی تحقیقی برادری کے لیے قابل رسائی بنانے کا ارادہ رکھتے ہیں۔

حدود

ہم AGI کو سیدھ میں لانے کے لیے اس نقطہ نظر کے بارے میں بہت پرجوش ہیں، لیکن ہم توقع کرتے ہیں کہ اسے ڈھالنے اور بہتر بنانے کی ضرورت ہے کیونکہ ہم اس بارے میں مزید سیکھتے ہیں کہ AI ٹیکنالوجی کیسے تیار ہوتی ہے۔ ہمارے نقطہ نظر میں بھی کئی اہم حدود ہیں:

- یہاں جو راستہ بنایا گیا ہے وہ مضبوطی اور تشریحی تحقیق کی اہمیت کو کم کرتا ہے، دو شعبوں میں OpenAI فی الحال کم سرمایہ کاری کر رہا ہے۔ اگر یہ آپ کے پروفائل کے مطابق ہے، تو براہ کرم ہمارے تحقیقی سائنسدان کے عہدوں کے لیے درخواست دیں!

- تشخیص کے لیے AI معاونت کا استعمال AI اسسٹنٹ میں موجود لطیف تضادات، تعصبات، یا کمزوریوں کو بڑھانے یا بڑھانے کی صلاحیت رکھتا ہے۔

- AGI کو سیدھ میں لانے میں ممکنہ طور پر آج کے AI سسٹمز کو سیدھ میں لانے سے بہت مختلف مسائل کو حل کرنا شامل ہے۔ ہم توقع کرتے ہیں کہ منتقلی کسی حد تک مسلسل رہے گی، لیکن اگر اس میں بڑی رکاوٹیں یا پیراڈائم شفٹ ہوتے ہیں، تو ہو سکتا ہے کہ InstructGPT جیسے ماڈلز کو سیدھ میں لانے سے سیکھے گئے زیادہ تر اسباق براہ راست مفید نہ ہوں۔

- الائنمنٹ کے مسئلے کے مشکل ترین حصے ہمارے AI سسٹمز کے لیے توسیع پذیر اور منسلک تربیتی سگنل کی انجینئرنگ سے متعلق نہیں ہوسکتے ہیں۔ یہاں تک کہ اگر یہ سچ ہے، تو اس طرح کے تربیتی سگنل کی ضرورت ہوگی.

- ایسے ماڈلز کو سیدھ میں لانا بنیادی طور پر آسان نہیں ہوسکتا ہے جو AGI کو سیدھ میں لانے کے مقابلے میں معنی خیز طور پر سیدھ کی تحقیق کو تیز کر سکتے ہیں۔ دوسرے لفظوں میں، کم سے کم قابل ماڈل جو سیدھ کی تحقیق میں مدد کر سکتے ہیں اگر مناسب طریقے سے منسلک نہ ہوں تو پہلے سے ہی بہت خطرناک ہو سکتے ہیں۔ اگر یہ سچ ہے، تو ہم صف بندی کے مسائل کو حل کرنے کے لیے اپنے سسٹمز سے زیادہ مدد نہیں لیں گے۔

ہم تحقیق کے اس سلسلے کے لیے مزید باصلاحیت لوگوں کی خدمات حاصل کرنے کے خواہاں ہیں! اگر اس میں آپ کی دلچسپی ہے تو ہم خدمات حاصل کر رہے ہیں۔ ریسرچ انجینئرز اور ریسرچ سائنسدان!

- AI

- ai آرٹ

- AI آرٹ جنریٹر

- عی روبوٹ

- مصنوعی ذہانت

- مصنوعی ذہانت کا سرٹیفیکیشن

- بینکنگ میں مصنوعی ذہانت

- مصنوعی ذہانت والا روبوٹ

- مصنوعی ذہانت والے روبوٹ

- مصنوعی ذہانت سافٹ ویئر

- blockchain

- بلاکچین کانفرنس

- coingenius

- بات چیت مصنوعی ذہانت

- crypto کانفرنس ai

- dall-e

- گہری سیکھنے

- گوگل عی

- مشین لرننگ

- اوپنائی

- پلاٹا

- افلاطون اے

- افلاطون ڈیٹا انٹیلی جنس

- افلاطون گیم

- پلیٹو ڈیٹا

- پلیٹو گیمنگ

- تحقیق

- پیمانہ ai

- نحو

- زیفیرنیٹ