آج، ہم شروع کر رہے ہیں ایمیزون سیج میکر پر اندازہ AWS Graviton آپ کو قیمت، کارکردگی، اور کارکردگی کے فوائد سے فائدہ اٹھانے کے قابل بنانے کے لیے جو Graviton chips سے حاصل ہوتے ہیں۔

گریویٹن پر مبنی مثالیں SageMaker میں ماڈل کی تشخیص کے لیے دستیاب ہیں۔ یہ پوسٹ آپ کو سیج میکر میں x86 سے Graviton پر مبنی مثالوں میں مشین لرننگ (ML) انفرنس ورک بوجھ کو منتقل کرنے اور تعینات کرنے میں مدد کرتی ہے۔ ہم آپ کے سیج میکر کے تربیت یافتہ ماڈل کو Graviton پر مبنی مثالوں پر تعینات کرنے کے لیے مرحلہ وار گائیڈ فراہم کرتے ہیں، Graviton کے ساتھ کام کرتے وقت بہترین طریقوں کا احاطہ کرتے ہیں، قیمت کی کارکردگی کے فوائد پر تبادلہ خیال کرتے ہیں، اور ڈیمو کرتے ہیں کہ SageMaker Graviton مثال پر TensorFlow ماڈل کو کیسے تعینات کیا جائے۔

Graviton کا مختصر جائزہ

AWS Graviton AWS کی طرف سے ڈیزائن کردہ پروسیسرز کا ایک خاندان ہے جو قیمت کی بہترین کارکردگی فراہم کرتا ہے اور اپنے x86 ہم منصبوں کے مقابلے میں زیادہ توانائی کے حامل ہیں۔ AWS Graviton 3 پروسیسرز Graviton پروسیسر فیملی میں جدید ترین ہیں اور ML ورک بوجھ کے لیے بہتر بنائے گئے ہیں، بشمول bfloat16 کے لیے سپورٹ، اور سنگل انسٹرکشن ملٹیپل ڈیٹا (SIMD) بینڈوتھ سے دوگنا۔ جب ان دونوں خصوصیات کو ملایا جاتا ہے، تو Graviton 3 تین گنا تک بہتر کارکردگی بمقابلہ Graviton 2 پیش کر سکتا ہے۔ Graviton 3 بھی اسی کارکردگی کے لیے 60% تک کم توانائی استعمال کرتا ہے جیسا کہ موازنہ کیا جا سکتا ہے۔ ایمیزون لچکدار کمپیوٹ کلاؤڈ (ایمیزون EC2) مثالیں۔ اگر آپ اپنے کاربن فوٹ پرنٹ کو کم کرنا چاہتے ہیں اور اپنے پائیداری کے اہداف کو حاصل کرنا چاہتے ہیں تو یہ ایک بہترین خصوصیت ہے۔

حل جائزہ

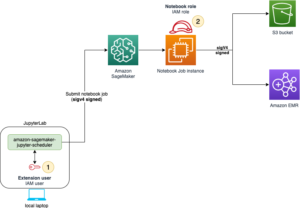

اپنے ماڈلز کو Graviton مثالوں میں تعینات کرنے کے لیے، آپ یا تو استعمال کرتے ہیں۔ AWS ڈیپ لرننگ کنٹینرز or اپنے کنٹینرز لے لو آرم v8.2 فن تعمیر کے ساتھ ہم آہنگ۔

آپ کے ماڈلز کی x86 پاورڈ مثالوں سے Graviton مثالوں میں منتقلی (یا نئی تعیناتی) آسان ہے کیونکہ AWS PyTorch، TensorFlow، Scikit-learn، اور XGBoost کے ساتھ ماڈلز کی میزبانی کے لیے کنٹینرز فراہم کرتا ہے، اور ماڈلز آرکیٹیکچر ایگنوسٹک ہیں۔ اس کے باوجود، اگر آپ اپنی لائبریریاں لانے کے لیے تیار ہیں، تو آپ ایسا بھی کر سکتے ہیں، بس اس بات کو یقینی بنائیں کہ آپ کا کنٹینر ایسے ماحول کے ساتھ بنایا گیا ہے جو Arm64 فن تعمیر کو سپورٹ کرتا ہو۔ مزید معلومات کے لیے دیکھیں اپنا الگورتھم کنٹینر بنانا.

اپنے ماڈل کو تعینات کرنے کے لیے آپ کو تین مراحل مکمل کرنے ہوں گے۔

- سیج میکر ماڈل بنائیں: اس میں دیگر پیرامیٹرز کے علاوہ، ماڈل فائل کے مقام کے بارے میں معلومات، کنٹینر جو تعیناتی کے لیے استعمال کیا جائے گا، اور انفرنس اسکرپٹ کا مقام شامل ہوگا۔ (اگر آپ کے پاس ایک موجودہ ماڈل ہے جو پہلے سے ہی x86 پر مبنی انفرنس مثال میں تعینات ہے، تو آپ اس قدم کو چھوڑ سکتے ہیں۔)

- ایک اینڈ پوائنٹ کنفیگریشن بنائیں: اس میں آپ کے اینڈ پوائنٹ کے لیے مطلوبہ مثال کے بارے میں معلومات ہوگی (مثال کے طور پر، Graviton7 کے لیے ml.c3g.xlarge)، اس ماڈل کا نام جو آپ نے مرحلہ 1 میں بنایا ہے، اور فی مثالوں کی تعداد اختتامی نقطہ

- مرحلہ 2 میں تخلیق کردہ اینڈ پوائنٹ کنفیگریشن کے ساتھ اختتامی نقطہ شروع کریں۔

شرائط

شروع کرنے سے پہلے، درج ذیل شرائط پر غور کریں:

- مندرجہ ذیل شرائط کو مکمل کریں۔ شرائط.

- آپ کا ماڈل یا تو PyTorch، TensorFlow، XGBoost، یا Scikit-learn پر مبنی ماڈل ہونا چاہیے۔ مندرجہ ذیل جدول میں ان ورژنز کا خلاصہ کیا گیا ہے جو اس تحریر کے لیے فی الحال تعاون یافتہ ہیں۔ تازہ ترین اپڈیٹس کے لیے رجوع کریں۔ سیج میکر فریم ورک کنٹینرز (صرف ایس ایم سپورٹ).

. ازگر TensorFlow پی ٹورچ سکیٹ سیکھنا XGBoost ورژن کی حمایت کی 3.8 2.9.1 1.12.1 1.0-1 1.3-1 1.5-1 پر - انفرنس اسکرپٹ میں محفوظ ہے۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3)۔

درج ذیل حصوں میں، ہم آپ کو تعیناتی کے مراحل سے آگاہ کرتے ہیں۔

سیج میکر ماڈل بنائیں

اگر آپ کے پاس ایک موجودہ ماڈل ہے جو پہلے سے ہی x86 پر مبنی انفرنس مثال میں تعینات ہے، تو آپ اس قدم کو چھوڑ سکتے ہیں۔ بصورت دیگر، SageMaker ماڈل بنانے کے لیے درج ذیل مراحل کو مکمل کریں:

- اس ماڈل کو تلاش کریں جسے آپ نے S3 بالٹی میں محفوظ کیا ہے۔ URI کاپی کریں۔

آپ ماڈل URI کو بعد میں استعمال کریں۔MODEL_S3_LOCATION. - ماڈل ٹریننگ کے دوران استعمال ہونے والے فریم ورک ورژن اور ازگر کے ورژن کی شناخت کریں۔

آپ کو اپنے فریم ورک اور Python ورژن کے مطابق دستیاب AWS ڈیپ لرننگ کنٹینرز کی فہرست میں سے ایک کنٹینر منتخب کرنے کی ضرورت ہے۔ مزید معلومات کے لیے رجوع کریں۔ Amazon ECR کے لیے ملٹی آرکیٹیکچر کنٹینر امیجز کا تعارف. - S3 بالٹی میں Python اسکرپٹ URI کا اندازہ لگائیں (عام فائل کا نام ہے۔

inference.py).

inference اسکرپٹ URI کی ضرورت ہے۔INFERENCE_SCRIPT_S3_LOCATION. - ان متغیرات کے ساتھ، آپ درج ذیل کمانڈ کے ساتھ SageMaker API کو کال کر سکتے ہیں۔

آپ ملٹی آرکیٹیکچر امیجز بھی بنا سکتے ہیں، اور ایک ہی تصویر کا استعمال کر سکتے ہیں لیکن مختلف ٹیگز کے ساتھ۔ آپ اس بات کی نشاندہی کر سکتے ہیں کہ آپ کی مثال کس فن تعمیر پر لگائی جائے گی۔ مزید معلومات کے لیے رجوع کریں۔ Amazon ECR کے لیے ملٹی آرکیٹیکچر کنٹینر امیجز کا تعارف.

ایک اختتامی نقطہ ترتیب بنائیں

ماڈل بنانے کے بعد، آپ کو درج ذیل کمانڈ کو چلا کر ایک اینڈ پوائنٹ کنفیگریشن بنانا ہوگا (نوٹ کریں کہ ہم کس قسم کی مثال استعمال کر رہے ہیں):

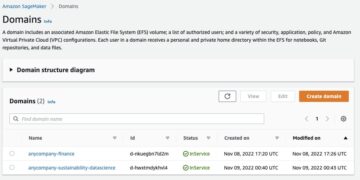

درج ذیل اسکرین شاٹ SageMaker کنسول پر اختتامی نقطہ ترتیب کی تفصیلات دکھاتا ہے۔

اختتامی نقطہ شروع کریں۔

پچھلے مرحلے میں بنائے گئے اختتامی نقطہ کی تشکیل کے ساتھ، آپ اختتامی نقطہ کو تعینات کر سکتے ہیں:

انتظار کریں جب تک کہ آپ کا ماڈل اینڈ پوائنٹ تعینات نہیں ہو جاتا۔ پیشین گوئیوں کی درخواست اسی طرح کی جا سکتی ہے جس طرح آپ x86 پر مبنی مثالوں میں تعینات اپنے اختتامی پوائنٹس کے لیے پیشین گوئیوں کی درخواست کرتے ہیں۔

درج ذیل اسکرین شاٹ SageMaker کنسول پر آپ کا اختتامی نقطہ دکھاتا ہے۔

جس کی تائید کی جاتی ہے۔

SageMaker TensorFlow اور PyTorch فریم ورکس کے لیے کارکردگی کے لیے موزوں Graviton ڈیپ کنٹینرز فراہم کرتا ہے۔ یہ کنٹینرز کمپیوٹر ویژن، قدرتی لینگویج پروسیسنگ، سفارشات، اور عام گہرے اور وسیع ماڈل پر مبنی استنباطی استعمال کے معاملات کی حمایت کرتے ہیں۔ ڈیپ لرننگ کنٹینرز کے علاوہ، سیج میکر کلاسیکی ایم ایل فریم ورکس جیسے کہ XGBoost اور Scikit-learn کے لیے کنٹینرز بھی فراہم کرتا ہے۔ کنٹینرز c6g/m6g اور c7g مثالوں میں بائنری مطابقت رکھتے ہیں، اس لیے ایک نسل سے دوسری نسل میں انفرنس ایپلی کیشن کو منتقل کرنا ہموار ہے۔

C6g/m6g fp16 (نصف درستگی کے فلوٹ) کو سپورٹ کرتا ہے اور ہم آہنگ ماڈلز کے لیے c5 مثالوں کے مقابلے مساوی یا بہتر کارکردگی فراہم کرتا ہے۔ C7g SIMD کی چوڑائی کو دوگنا کرکے اور bfloat-16 (bf16) کو سپورٹ کرکے ایم ایل کی کارکردگی میں خاطر خواہ اضافہ کرتا ہے، جو آپ کے ماڈلز کو چلانے کے لیے سب سے زیادہ لاگت والا پلیٹ فارم ہے۔

C6g/m6g اور c7g دونوں کلاسیکل ML (مثال کے طور پر XGBoost) کے لیے SageMaker میں دیگر CPU مثالوں کے مقابلے میں اچھی کارکردگی فراہم کرتے ہیں۔ c16g پر Bfloat-7 سپورٹ bf16 تربیت یافتہ یا AMP (خودکار مکسڈ پریسجن) تربیت یافتہ ماڈلز کی موثر تعیناتی کی اجازت دیتا ہے۔ Graviton پر آرم کمپیوٹ لائبریری (ACL) بیک اینڈ bfloat-16 کرنل فراہم کرتا ہے جو کہ fp32 آپریٹرز کو فاسٹ میتھ موڈ کے ذریعے، ماڈل کوانٹائزیشن کے بغیر بھی تیز کر سکتا ہے۔

تجویز کردہ بہترین طرز عمل

Graviton مثالوں پر، ہر vCPU ایک فزیکل کور ہے۔ عام سی پی یو وسائل (ایس ایم ٹی کے برعکس) کے لیے کوئی تنازعہ نہیں ہے، اور کام کے بوجھ کی کارکردگی کا پیمانہ ہر وی سی پی یو اضافے کے ساتھ لکیری ہے۔ لہذا، جب بھی استعمال کیس اجازت دیتا ہے تو بیچ کا اندازہ استعمال کرنے کی سفارش کی جاتی ہے۔ یہ ہر فزیکل کور پر بیچ کی متوازی پروسیسنگ کے ذریعے vCPUs کے موثر استعمال کو قابل بنائے گا۔ اگر بیچ کا اندازہ لگانا ممکن نہیں ہے، تو دیے گئے پے لوڈ کے لیے بہترین مثال کے سائز کی ضرورت ہوتی ہے تاکہ یہ یقینی بنایا جا سکے کہ OS تھریڈ شیڈولنگ اوور ہیڈ کمپیوٹ پاور سے زیادہ نہیں ہے جو اضافی vCPUs کے ساتھ آتی ہے۔

TensorFlow ڈیفالٹ کے طور پر Eigen kernels کے ساتھ آتا ہے، اور یہ تجویز کیا جاتا ہے کہ ACL کے ساتھ OneDNN پر سوئچ کریں تاکہ سب سے زیادہ بہتر انفرنس بیک اینڈ حاصل کیا جا سکے۔ کنٹینر سروس شروع کرتے وقت OneDNN بیک اینڈ اور bfloat-16 فاسٹ میتھ موڈ کو فعال کیا جا سکتا ہے:

سابقہ پیش کرنے والی کمانڈ دو اہم کنفیگریشنز کے ساتھ ایک معیاری resnet50 ماڈل کی میزبانی کرتی ہے۔

یہ مندرجہ ذیل طریقے سے انفرنس کنٹینر تک پہنچ سکتے ہیں:

تعیناتی کی مثال

اس پوسٹ میں، ہم آپ کو دکھاتے ہیں کہ کس طرح ایک ٹینسر فلو ماڈل، سیج میکر میں تربیت یافتہ، Graviton سے چلنے والے SageMaker کی مثال کے طور پر تعینات کیا جائے۔

آپ کوڈ کا نمونہ یا تو سیج میکر نوٹ بک مثال میں چلا سکتے ہیں، ایک ایمیزون سیج میکر اسٹوڈیو نوٹ بک، یا مقامی موڈ میں ایک Jupyter نوٹ بک۔ اگر آپ مقامی موڈ میں Jupyter نوٹ بک استعمال کرتے ہیں تو آپ کو SageMaker کے عمل درآمد کے کردار کو بازیافت کرنے کی ضرورت ہے۔

درج ذیل مثال CIFAR-10 ڈیٹاسیٹ پر غور کرتی ہے۔ آپ SageMaker مثالوں سے نوٹ بک کی مثال پر عمل کر سکتے ہیں۔ GitHub repo اس پوسٹ میں استعمال ہونے والے ماڈل کو دوبارہ پیش کرنے کے لیے۔ ہم تربیت یافتہ ماڈل اور cifar10_keras_main.py قیاس کے لیے ازگر کا اسکرپٹ۔

ماڈل ایک S3 بالٹی میں محفوظ ہے: s3://aws-ml-blog/artifacts/run-ml-inference-on-graviton-based-instances-with-amazon-sagemaker/model.tar.gz

۔ cifar10_keras_main.py اسکرپٹ، جو اندازہ لگانے کے لیے استعمال کیا جا سکتا ہے، اس پر محفوظ کیا جاتا ہے:s3://aws-ml-blog/artifacts/run-ml-inference-on-graviton-based-instances-with-amazon-sagemaker/script/cifar10_keras_main.py

ہم استعمال کرتے ہیں us-east-1 ماڈل کو ml.c7g.xlarge Graviton پر مبنی مثال پر علاقہ اور تعینات کریں۔ اس کی بنیاد پر، ہمارے AWS ڈیپ لرننگ کنٹینر کا URI ہے۔ 763104351884.dkr.ecr.us-east-1.amazonaws.com/tensorflow-inference-graviton:2.9.1-cpu-py38-ubuntu20.04-sagemaker

- درج ذیل کوڈ کے ساتھ ترتیب دیں:

- اینڈ پوائنٹ ٹیسٹنگ کے لیے ڈیٹا سیٹ ڈاؤن لوڈ کریں:

- ماڈل اور اختتامی نقطہ کی تشکیل بنائیں، اور اختتامی نقطہ کو تعینات کریں:

- اختیاری طور پر، آپ اپنی قیاس اسکرپٹ میں شامل کر سکتے ہیں۔

Environmentincreate_modelاگر آپ نے تربیت کے دوران اسے اپنے سیج میکر ماڈل میں اصل میں بطور نمونہ شامل نہیں کیا تھا:آپ کو تعیناتی کے لیے چند منٹ انتظار کرنا ہوگا۔

- درج ذیل کوڈ کے ساتھ اختتامی نقطہ کی حیثیت کی تصدیق کریں:

آپ بھی چیک کر سکتے ہیں AWS مینجمنٹ کنسول یہ دیکھنے کے لیے کہ آپ کا ماڈل کب تعینات ہے۔

- اختتامی پوائنٹس کو طلب کرنے کے لیے رن ٹائم ماحول ترتیب دیں:

اب ہم اختتامی نقطہ کو شروع کرنے کے لیے پے لوڈ تیار کرتے ہیں۔ ہم ماڈل کی تربیت کے لیے اسی قسم کی تصاویر استعمال کرتے ہیں۔ یہ پچھلے مراحل میں ڈاؤن لوڈ کیے گئے تھے۔

- پے لوڈ کو ٹینسر پر کاسٹ کریں اور درست فارمیٹ سیٹ کریں جس کی ماڈل کو توقع ہے۔ اس مثال کے لیے، ہم صرف ایک پیشین گوئی کی درخواست کرتے ہیں۔

ہمیں ایک صف کے طور پر ماڈل آؤٹ پٹ ملتا ہے۔

- ہم اس آؤٹ پٹ کو امکانات میں تبدیل کر سکتے ہیں اگر ہم اس پر سافٹ میکس کا اطلاق کریں:

وسائل کو صاف کریں۔

اس حل میں شامل خدمات پر لاگت آتی ہے۔ جب آپ یہ حل استعمال کر لیں تو درج ذیل وسائل کو صاف کریں:

قیمت کی کارکردگی کا موازنہ

گریویٹن پر مبنی مثالیں x86 پر مبنی مثالوں کے مقابلے میں سب سے کم قیمت اور بہترین قیمت کی کارکردگی پیش کرتی ہیں۔ EC2 مثالوں کی طرح، ml.c6g مثالوں کے ساتھ SageMaker انفرنس اینڈ پوائنٹس (Graviton 2) ml.c20 کے مقابلے میں 5% کم قیمت پیش کرتے ہیں، اور Graviton 3 ml.c7g مثالیں ml.c15 مثالوں سے 6% سستی ہیں۔ مزید معلومات کے لیے رجوع کریں۔ ایمیزون سیج میکر قیمتوں کا تعین.

نتیجہ

اس پوسٹ میں، ہم نے نئی لانچ کی گئی SageMaker کی قابلیت کو ظاہر کیا ہے تاکہ ماڈلز کو Graviton سے چلنے والے انفرنسز میں تعینات کیا جا سکے۔ ہم نے آپ کو بہترین طریقوں کے بارے میں رہنمائی فراہم کی اور نئی قسم کے انفرنس مثالوں کے قیمت کی کارکردگی کے فوائد پر مختصراً تبادلہ خیال کیا۔

Graviton کے بارے میں مزید جاننے کے لیے، رجوع کریں۔ AWS Graviton پروسیسر. آپ Amazon EC2 کنسول پر AWS Graviton پر مبنی EC2 مثالوں کے ساتھ شروع کر سکتے ہیں اور حوالہ دے کر AWS Graviton تکنیکی گائیڈ. آپ اس بلاگ پوسٹ میں نمونہ کوڈ کے ساتھ Graviton کے بارے میں اندازہ لگانے کے لیے Sagemaker ماڈل اینڈ پوائنٹ لگا سکتے ہیں۔

مصنفین کے بارے میں

وکٹر جارامیلو، پی ایچ ڈی، AWS پروفیشنل سروسز میں ایک سینئر مشین لرننگ انجینئر ہے۔ AWS سے پہلے، وہ یونیورسٹی کے پروفیسر اور پیشین گوئی کی دیکھ بھال میں ریسرچ سائنسدان تھے۔ اپنے فارغ وقت میں، وہ اپنی موٹرسائیکل اور DIY موٹرسائیکل مکینکس کی سواری سے لطف اندوز ہوتا ہے۔

وکٹر جارامیلو، پی ایچ ڈی، AWS پروفیشنل سروسز میں ایک سینئر مشین لرننگ انجینئر ہے۔ AWS سے پہلے، وہ یونیورسٹی کے پروفیسر اور پیشین گوئی کی دیکھ بھال میں ریسرچ سائنسدان تھے۔ اپنے فارغ وقت میں، وہ اپنی موٹرسائیکل اور DIY موٹرسائیکل مکینکس کی سواری سے لطف اندوز ہوتا ہے۔

Zmnako Awrahman، PhD، Amazon Web Services میں پریکٹس مینیجر، ML SME، اور مشین لرننگ ٹیکنیکل فیلڈ کمیونٹی (TFC) کے رکن ہیں۔ وہ صارفین کو ڈیٹا اینالیٹکس اور مشین لرننگ کے ساتھ اپنے ڈیٹا سے قدر نکالنے کے لیے کلاؤڈ کی طاقت سے فائدہ اٹھانے میں مدد کرتا ہے۔

Zmnako Awrahman، PhD، Amazon Web Services میں پریکٹس مینیجر، ML SME، اور مشین لرننگ ٹیکنیکل فیلڈ کمیونٹی (TFC) کے رکن ہیں۔ وہ صارفین کو ڈیٹا اینالیٹکس اور مشین لرننگ کے ساتھ اپنے ڈیٹا سے قدر نکالنے کے لیے کلاؤڈ کی طاقت سے فائدہ اٹھانے میں مدد کرتا ہے۔

سنیتا نادم پلی AWS میں سافٹ ویئر ڈویلپمنٹ مینیجر ہے۔ وہ مشین جھکاؤ، HPC، اور ملٹی میڈیا ورک بوجھ کے لیے Graviton سافٹ ویئر کی کارکردگی کو بہتر بنانے کی رہنمائی کرتی ہے۔ وہ اوپن سورس ڈویلپمنٹ اور آرم ایس او سی کے ساتھ لاگت سے موثر سافٹ ویئر حل فراہم کرنے کے بارے میں پرجوش ہے۔

سنیتا نادم پلی AWS میں سافٹ ویئر ڈویلپمنٹ مینیجر ہے۔ وہ مشین جھکاؤ، HPC، اور ملٹی میڈیا ورک بوجھ کے لیے Graviton سافٹ ویئر کی کارکردگی کو بہتر بنانے کی رہنمائی کرتی ہے۔ وہ اوپن سورس ڈویلپمنٹ اور آرم ایس او سی کے ساتھ لاگت سے موثر سافٹ ویئر حل فراہم کرنے کے بارے میں پرجوش ہے۔

جونا لیو ایمیزون سیج میکر ٹیم میں سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔ اس کا موجودہ کام ڈویلپرز کو مشین لرننگ ماڈلز کی مؤثر طریقے سے میزبانی کرنے اور انفرنس کی کارکردگی کو بہتر بنانے پر مرکوز ہے۔ وہ مقامی اعداد و شمار کے تجزیہ اور سماجی مسائل کو حل کرنے کے لیے AI کا استعمال کرنے کا شوق رکھتی ہے۔

جونا لیو ایمیزون سیج میکر ٹیم میں سافٹ ویئر ڈویلپمنٹ انجینئر ہے۔ اس کا موجودہ کام ڈویلپرز کو مشین لرننگ ماڈلز کی مؤثر طریقے سے میزبانی کرنے اور انفرنس کی کارکردگی کو بہتر بنانے پر مرکوز ہے۔ وہ مقامی اعداد و شمار کے تجزیہ اور سماجی مسائل کو حل کرنے کے لیے AI کا استعمال کرنے کا شوق رکھتی ہے۔

ایلن ٹین SageMaker کے ساتھ ایک سینئر پروڈکٹ مینیجر ہے، جو بڑے ماڈل کے تخمینے کی کوششوں میں سرفہرست ہے۔ وہ تجزیات کے شعبے میں مشین لرننگ کو لاگو کرنے کا شوق رکھتا ہے۔ کام سے باہر، وہ باہر سے لطف اندوز ہوتا ہے۔

ایلن ٹین SageMaker کے ساتھ ایک سینئر پروڈکٹ مینیجر ہے، جو بڑے ماڈل کے تخمینے کی کوششوں میں سرفہرست ہے۔ وہ تجزیات کے شعبے میں مشین لرننگ کو لاگو کرنے کا شوق رکھتا ہے۔ کام سے باہر، وہ باہر سے لطف اندوز ہوتا ہے۔

- AI

- ai آرٹ

- AI آرٹ جنریٹر

- عی روبوٹ

- ایمیزون سیج میکر

- مصنوعی ذہانت

- مصنوعی ذہانت کا سرٹیفیکیشن

- بینکنگ میں مصنوعی ذہانت

- مصنوعی ذہانت والا روبوٹ

- مصنوعی ذہانت والے روبوٹ

- مصنوعی ذہانت سافٹ ویئر

- AWS ڈیپ لرننگ AMIs

- AWS مشین لرننگ

- بہترین طریقوں

- blockchain

- بلاکچین کانفرنس

- coingenius

- بات چیت مصنوعی ذہانت

- crypto کانفرنس ai

- dall-e

- گہری سیکھنے

- گوگل عی

- مشین لرننگ

- پلاٹا

- افلاطون اے

- افلاطون ڈیٹا انٹیلی جنس

- افلاطون گیم

- پلیٹو ڈیٹا

- پلیٹو گیمنگ

- پیمانہ ai

- نحو

- تکنیکی طریقہ

- AWS پر ٹینسر فلو

- زیفیرنیٹ