اب ایک دہائی سے، بہت سے متاثر کن مصنوعی ذہانت کے نظام کو لیبل لگائے گئے ڈیٹا کی ایک بڑی انوینٹری کا استعمال کرتے ہوئے سکھایا گیا ہے۔ کسی تصویر پر "ٹیبی بلی" یا "شیر بلی" کا لیبل لگایا جا سکتا ہے، مثال کے طور پر، ایک مصنوعی نیورل نیٹ ورک کو "ٹرین" دینے کے لیے ایک ٹیبی کو شیر سے درست طریقے سے ممتاز کرنا۔ حکمت عملی شاندار طور پر کامیاب بھی رہی ہے اور بری طرح ناکام بھی۔

اس طرح کی "نگرانی" کی تربیت کے لیے انسانوں کے ذریعے محنت سے لیبل لگائے گئے ڈیٹا کی ضرورت ہوتی ہے، اور اعصابی نیٹ ورک اکثر شارٹ کٹس لیتے ہیں، لیبل کو کم سے کم اور بعض اوقات سطحی معلومات کے ساتھ جوڑنا سیکھتے ہیں۔ مثال کے طور پر، ایک عصبی نیٹ ورک گائے کی تصویر کو پہچاننے کے لیے گھاس کی موجودگی کا استعمال کر سکتا ہے، کیونکہ گائے عام طور پر کھیتوں میں لی جاتی ہیں۔

"ہم الگورتھم کی ایک نسل کو بڑھا رہے ہیں جو انڈرگریڈز کی طرح ہیں [جو] پورے سمسٹر میں کلاس میں نہیں آئے تھے اور پھر فائنل سے ایک رات پہلے، وہ تڑپ رہے ہیں،" کہا۔ الیکسی ایفروسیونیورسٹی آف کیلیفورنیا، برکلے میں کمپیوٹر سائنسدان۔ "وہ واقعی مواد نہیں سیکھتے ہیں، لیکن وہ ٹیسٹ میں اچھی کارکردگی کا مظاہرہ کرتے ہیں۔"

جانوروں اور مشینی ذہانت کے باہمی ربط میں دلچسپی رکھنے والے محققین کے لیے، اس کے علاوہ، یہ "سپروائزڈ لرننگ" اس حد تک محدود ہو سکتی ہے جو یہ حیاتیاتی دماغوں کے بارے میں ظاہر کر سکتی ہے۔ جانور — بشمول انسان — سیکھنے کے لیے لیبل والے ڈیٹا سیٹس کا استعمال نہیں کرتے ہیں۔ زیادہ تر حصے کے لیے، وہ اپنے طور پر ماحول کو دریافت کرتے ہیں، اور ایسا کرتے ہوئے، وہ دنیا کے بارے میں ایک بھرپور اور مضبوط فہم حاصل کرتے ہیں۔

اب کچھ کمپیوٹیشنل نیورو سائنسدانوں نے ایسے عصبی نیٹ ورکس کو تلاش کرنا شروع کر دیا ہے جن کی تربیت بہت کم یا کوئی انسانی لیبل والے ڈیٹا کے ساتھ کی گئی ہے۔ یہ "خود زیر نگرانی سیکھنے" الگورتھم بہت زیادہ کامیاب ثابت ہوئے ہیں۔ انسانی زبان کی ماڈلنگ اور، حال ہی میں، تصویر کی شناخت۔ حالیہ کام میں، ممالیہ کے بصری اور سمعی نظاموں کے کمپیوٹیشنل ماڈلز جو خود زیر نگرانی سیکھنے کے ماڈلز کا استعمال کرتے ہوئے بنائے گئے ہیں، ان کے زیر نگرانی سیکھنے والے ہم منصبوں کے مقابلے دماغی افعال سے قریب تر میلان ظاہر کی ہے۔ کچھ نیورو سائنس دانوں کے لیے ایسا لگتا ہے جیسے مصنوعی نیٹ ورک کچھ ایسے حقیقی طریقوں کو ظاہر کرنے لگے ہیں جو ہمارے دماغ سیکھنے کے لیے استعمال کرتے ہیں۔

ناقص نگرانی

مصنوعی اعصابی نیٹ ورک سے متاثر دماغی ماڈل تقریباً 10 سال پہلے کی عمر میں آئے تھے، اسی وقت کے قریب ایک نیورل نیٹ ورک الیکس نیٹ نامعلوم تصاویر کی درجہ بندی کے کام میں انقلاب برپا کر دیا۔ وہ نیٹ ورک، تمام عصبی نیٹ ورکس کی طرح، مصنوعی نیوران کی تہوں سے بنا تھا، کمپیوٹیشنل یونٹس جو ایک دوسرے سے کنکشن بناتے ہیں جو طاقت میں مختلف ہو سکتے ہیں، یا "وزن"۔ اگر ایک عصبی نیٹ ورک کسی تصویر کی صحیح درجہ بندی کرنے میں ناکام رہتا ہے، تو سیکھنے کا الگورتھم نیوران کے درمیان رابطوں کے وزن کو اپ ڈیٹ کرتا ہے تاکہ تربیت کے اگلے دور میں اس غلط درجہ بندی کا امکان کم ہو جائے۔ الگورتھم اس عمل کو تمام ٹریننگ امیجز کے ساتھ کئی بار دہراتا ہے، وزن کو درست کرتے ہوئے، جب تک کہ نیٹ ورک کی غلطی کی شرح قابل قبول حد تک کم نہ ہو جائے۔

اسی وقت کے ارد گرد، نیورو سائنسدانوں نے پہلا کمپیوٹیشنل ماڈل تیار کیا۔ پرائمیٹ بصری نظام، نیورل نیٹ ورکس جیسے AlexNet اور اس کے جانشینوں کا استعمال کرتے ہوئے۔ یونین امید افزا نظر آئی: جب بندروں اور مصنوعی اعصابی جالوں کو ایک جیسی تصاویر دکھائی گئیں، مثال کے طور پر، اصلی نیوران اور مصنوعی نیوران کی سرگرمی نے ایک دلچسپ خط و کتابت دکھائی۔ سماعت اور بدبو کا پتہ لگانے کے مصنوعی ماڈلز کے بعد۔

لیکن جیسے جیسے میدان ترقی کرتا گیا، محققین نے زیر نگرانی تربیت کی حدود کو محسوس کیا۔ مثال کے طور پر، 2017 میں، لیون گیٹیس، جو اس وقت جرمنی کی یونیورسٹی آف ٹیوبنگن کے کمپیوٹر سائنس دان تھے، اور ان کے ساتھیوں نے فورڈ ماڈل ٹی کی ایک تصویر لی، پھر تصویر پر چیتے کی جلد کا نمونہ چڑھا دیا، جس سے ایک عجیب لیکن آسانی سے پہچانی جانے والی تصویر بنائی گئی۔ . ایک سرکردہ مصنوعی اعصابی نیٹ ورک نے اصل تصویر کو ماڈل ٹی کے طور پر درست طریقے سے درجہ بندی کیا، لیکن ترمیم شدہ تصویر کو چیتا سمجھا۔ اس کی ساخت پر فکسڈ تھا اور اسے کار کی شکل (یا چیتے، اس معاملے میں) کی کوئی سمجھ نہیں تھی۔

خود زیر نگرانی سیکھنے کی حکمت عملی ایسے مسائل سے بچنے کے لیے بنائی گئی ہے۔ اس نقطہ نظر میں، انسان ڈیٹا کو لیبل نہیں کرتے ہیں۔ بلکہ، "لیبل ڈیٹا سے ہی آتے ہیں،" نے کہا فریڈیمن زینکے، باسل، سوئٹزرلینڈ میں فریڈرک میشر انسٹی ٹیوٹ برائے بایومیڈیکل ریسرچ میں ایک کمپیوٹیشنل نیورو سائنس دان۔ خود زیر نگرانی الگورتھم بنیادی طور پر ڈیٹا میں خلا پیدا کرتے ہیں اور نیورل نیٹ ورک سے خالی جگہوں کو پر کرنے کے لیے کہتے ہیں۔ ایک نام نہاد بڑی زبان کے ماڈل میں، مثال کے طور پر، تربیتی الگورتھم عصبی نیٹ ورک کو کسی جملے کے پہلے چند الفاظ دکھائے گا اور اس سے اگلے لفظ کی پیشین گوئی کرنے کو کہے گا۔ جب انٹرنیٹ سے حاصل کیے گئے متن کے ایک بڑے کارپس کے ساتھ تربیت حاصل کی جاتی ہے تو ماڈل سیکھنے لگتا ہے زبان کی نحوی ساخت، متاثر کن لسانی قابلیت کا مظاہرہ کرتی ہے - یہ سب کچھ بیرونی لیبلز یا نگرانی کے بغیر۔

کمپیوٹر ویژن میں بھی ایسی ہی کوشش جاری ہے۔ 2021 کے آخر میں، Kaiming He اور ساتھیوں نے انکشاف کیا کہنقاب پوش آٹو انکوڈر,” جو ایک پر بناتا ہے۔ تکنیک 2016 میں Efros کی ٹیم کی طرف سے پیش قدمی کی۔ خود زیر نگرانی سیکھنے کا الگورتھم تصادفی طور پر تصاویر کو ماسک کرتا ہے، جو ہر ایک کے تقریباً تین چوتھائی حصے کو چھپاتا ہے۔ نقاب پوش آٹو انکوڈر غیر نقاب شدہ حصوں کو اویکت نمائندگی میں بدل دیتا ہے - کمپریسڈ ریاضیاتی وضاحتیں جن میں کسی چیز کے بارے میں اہم معلومات ہوتی ہیں۔ (تصویر کے معاملے میں، اویکت کی نمائندگی ایک ریاضیاتی وضاحت ہو سکتی ہے جو تصویر میں موجود کسی چیز کی شکل کو، دوسری چیزوں کے علاوہ، پکڑتی ہے۔) پھر ایک ڈیکوڈر ان نمائندگیوں کو دوبارہ مکمل تصویروں میں تبدیل کرتا ہے۔

خود زیر نگرانی سیکھنے کا الگورتھم انکوڈر-ڈیکوڈر کے امتزاج کو نقاب پوش تصاویر کو ان کے مکمل ورژن میں تبدیل کرنے کی تربیت دیتا ہے۔ حقیقی امیجز اور دوبارہ تعمیر شدہ تصاویر کے درمیان کوئی بھی فرق اسے سیکھنے میں مدد کرنے کے لیے سسٹم میں واپس آ جاتا ہے۔ یہ عمل تربیتی امیجز کے ایک سیٹ کے لیے اس وقت تک دہرایا جاتا ہے جب تک کہ سسٹم کی خرابی کی شرح مناسب حد تک کم نہ ہو جائے۔ ایک مثال میں، جب ایک تربیت یافتہ نقاب پوش آٹو انکوڈر کو بس کی پہلے سے نظر نہ آنے والی تصویر دکھائی گئی جس میں اس کا تقریباً 80 فیصد حصہ مخفی تھا، سسٹم نے کامیابی کے ساتھ بس کی ساخت کو دوبارہ بنایا۔

"یہ ایک بہت ہی متاثر کن نتیجہ ہے،" ایفروس نے کہا۔

اس طرح کے نظام میں تخلیق کردہ اویکت نمائیندگی پچھلی حکمت عملیوں کے مقابلے میں کافی گہری معلومات پر مشتمل ہوتی ہے۔ سسٹم کار کی شکل سیکھ سکتا ہے، مثال کے طور پر — یا ایک چیتے — اور نہ صرف ان کے پیٹرن۔ "اور یہ واقعی خود کی نگرانی میں سیکھنے کا بنیادی خیال ہے - آپ اپنے علم کو نیچے سے بڑھاتے ہیں،" ایفروس نے کہا۔ ٹیسٹ پاس کرنے کے لیے آخری لمحات میں کوئی جھنجلاہٹ نہیں۔

خود زیر نگرانی دماغ

اس طرح کے نظاموں میں، کچھ نیورو سائنسدان اس بات کی باز گشت دیکھتے ہیں کہ ہم کیسے سیکھتے ہیں۔ "مجھے لگتا ہے کہ اس میں کوئی شک نہیں ہے کہ دماغ جو کچھ کرتا ہے اس میں سے 90 فیصد خود کی زیر نگرانی سیکھنا ہے،" کہا۔ بلیک رچرڈز، میک گل یونیورسٹی اور میلا، کیوبیک آرٹیفیشل انٹیلی جنس انسٹی ٹیوٹ میں ایک کمپیوٹیشنل نیورو سائنس دان۔ حیاتیاتی دماغ کے بارے میں سوچا جاتا ہے کہ کسی چیز کے حرکت کرتے وقت اس کے مستقبل کے محل وقوع، یا کسی جملے میں اگلے لفظ کی مسلسل پیشین گوئی کرتے رہتے ہیں، بالکل اسی طرح جیسے خود زیر نگرانی سیکھنے کا الگورتھم کسی تصویر یا متن کے کسی حصے میں فرق کی پیش گوئی کرنے کی کوشش کرتا ہے۔ اور دماغ اپنی غلطیوں سے خود بھی سیکھتے ہیں - ہمارے دماغ کے تاثرات کا صرف ایک چھوٹا سا حصہ کسی بیرونی ذریعہ سے آتا ہے، بنیادی طور پر، "غلط جواب"۔

مثال کے طور پر، انسانوں اور دیگر پریمیٹ کے بصری نظام پر غور کریں۔ یہ جانوروں کے تمام حسی نظاموں کا بہترین مطالعہ ہیں، لیکن نیورو سائنسدانوں نے یہ وضاحت کرنے کے لیے جدوجہد کی ہے کہ ان میں دو الگ الگ راستے کیوں شامل ہیں: وینٹرل ویژول سٹریم، جو اشیاء اور چہروں کو پہچاننے کے لیے ذمہ دار ہے، اور ڈورسل ویژول سٹریم، جو حرکت کو عمل میں لاتی ہے۔ کیا" اور "کہاں" راستے، بالترتیب)۔

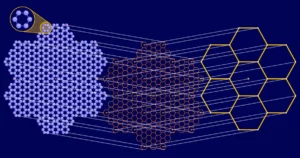

رچرڈز اور ان کی ٹیم نے ایک خود زیر نگرانی ماڈل بنایا جو جواب کی طرف اشارہ کرتا ہے۔ وہ تربیت یافتہ ایک AI جس نے دو مختلف عصبی نیٹ ورکس کو ملایا: پہلا، جسے ResNet فن تعمیر کہا جاتا ہے، تصاویر پر کارروائی کے لیے ڈیزائن کیا گیا تھا۔ دوسرا، جسے بار بار آنے والے نیٹ ورک کے نام سے جانا جاتا ہے، اگلے متوقع ان پٹ کے بارے میں پیشین گوئیاں کرنے کے لیے پہلے سے آنے والے ان پٹس کی ترتیب کا ٹریک رکھ سکتا ہے۔ مشترکہ AI کو تربیت دینے کے لیے، ٹیم نے ایک ویڈیو کے 10 فریموں کی ترتیب کے ساتھ آغاز کیا اور ResNet کو ایک ایک کرکے ان پر کارروائی کرنے دیں۔ بار بار چلنے والے نیٹ ورک نے پھر 11ویں فریم کی اویکت نمائندگی کی پیش گوئی کی، جبکہ صرف پہلے 10 فریموں سے میل نہیں کھاتا۔ خود زیر نگرانی سیکھنے کے الگورتھم نے پیشین گوئی کا اصل قدر سے موازنہ کیا اور عصبی نیٹ ورکس کو ہدایت کی کہ وہ پیش گوئی کو بہتر بنانے کے لیے اپنے وزن کو اپ ڈیٹ کریں۔

رچرڈز کی ٹیم نے پایا کہ واحد ResNet کے ساتھ تربیت یافتہ AI آبجیکٹ کی شناخت میں اچھا تھا، لیکن تحریک کی درجہ بندی میں نہیں۔ لیکن جب وہ واحد ResNet کو دو حصوں میں تقسیم کرتے ہیں، دو راستے بناتے ہیں (نیورون کی کل تعداد کو تبدیل کیے بغیر)، AI نے ایک میں اشیاء کے لیے اور دوسرے میں حرکت کے لیے نمائندگی تیار کی، جس سے ان خصوصیات کی بہاو کی درجہ بندی کو ممکن بنایا گیا — بالکل اسی طرح جیسے ہمارے دماغوں کا امکان ہے۔ کیا.

اے آئی کو مزید جانچنے کے لیے، ٹیم نے اسے ویڈیوز کا ایک سیٹ دکھایا جو سیئٹل کے ایلن انسٹی ٹیوٹ فار برین سائنس کے محققین نے پہلے چوہوں کو دکھایا تھا۔ پریمیٹ کی طرح، چوہوں کے دماغ کے علاقے جامد تصاویر اور حرکت کے لیے مخصوص ہوتے ہیں۔ ایلن کے محققین نے ماؤس کے بصری پرانتستا میں اعصابی سرگرمی کو ریکارڈ کیا جب جانوروں نے ویڈیوز دیکھے۔

یہاں بھی، رچرڈز کی ٹیم نے ویڈیوز پر AI اور زندہ دماغوں کے ردعمل میں مماثلت پائی۔ تربیت کے دوران، مصنوعی اعصابی نیٹ ورک میں سے ایک راستہ ماؤس کے دماغ کے وینٹرل، آبجیکٹ کا پتہ لگانے والے علاقوں سے زیادہ مشابہت اختیار کر گیا، اور دوسرا راستہ نقل و حرکت پر مرکوز ڈورسل علاقوں سے ملتا جلتا ہو گیا۔

رچرڈز نے کہا کہ نتائج بتاتے ہیں کہ ہمارے بصری نظام کے پاس دو مخصوص راستے ہیں کیونکہ وہ بصری مستقبل کی پیش گوئی کرنے میں مدد کرتے ہیں۔ ایک راستہ کافی اچھا نہیں ہے۔

انسانی سمعی نظام کے ماڈل بھی ایسی ہی کہانی بیان کرتے ہیں۔ جون میں، ایک ٹیم کی قیادت میں جین ریمی کنگمیٹا اے آئی کے ایک ریسرچ سائنسدان، Wav2Vec 2.0 نامی ایک AI کو تربیت دی۔، جو آڈیو کو اویکت نمائندگی میں تبدیل کرنے کے لیے ایک عصبی نیٹ ورک کا استعمال کرتا ہے۔ محققین ان میں سے کچھ نمائندگیوں کو چھپاتے ہیں، جو پھر ایک دوسرے جزو کے اعصابی نیٹ ورک میں شامل ہوتے ہیں جسے ٹرانسفارمر کہتے ہیں۔ تربیت کے دوران، ٹرانسفارمر نقاب پوش معلومات کی پیش گوئی کرتا ہے۔ اس عمل میں پوری AI آوازوں کو اویکت کی نمائندگی میں تبدیل کرنا سیکھتی ہے — دوبارہ، کسی لیبل کی ضرورت نہیں۔ کنگ نے کہا کہ ٹیم نے نیٹ ورک کو تربیت دینے کے لیے تقریباً 600 گھنٹے کے تقریری ڈیٹا کا استعمال کیا، "جو تقریباً وہی ہے جو ایک بچہ پہلے دو سالوں کے تجربے میں حاصل کرے گا۔"

ایک بار جب سسٹم کو تربیت دی گئی، محققین نے اسے انگریزی، فرانسیسی اور مینڈارن میں آڈیو بکس کے حصے چلائے۔ اس کے بعد محققین نے 412 افراد کے ڈیٹا کے مقابلے اے آئی کی کارکردگی کا موازنہ کیا - تین زبانوں کے مقامی بولنے والوں کا مرکب جنہوں نے اپنے دماغ کو ایف ایم آر آئی اسکینر میں امیج کرتے ہوئے ایک ہی طرح کے آڈیو کو سنا تھا۔ کنگ نے کہا کہ اس کا اعصابی نیٹ ورک اور انسانی دماغ، شور اور کم ریزولوشن ایف ایم آر آئی امیجز کے باوجود، "نہ صرف ایک دوسرے کے ساتھ منسلک ہوتے ہیں، بلکہ وہ ایک منظم انداز میں باہم جڑتے ہیں": AI کی ابتدائی تہوں میں سرگرمی سرگرمی کے ساتھ ہم آہنگ ہوتی ہے۔ بنیادی سمعی پرانتستا میں، جب کہ AI کی سب سے گہری تہوں کی سرگرمی دماغ کی اونچی تہوں میں سرگرمی کے ساتھ سیدھ میں آتی ہے، اس صورت میں پریفرنٹل کورٹیکس۔ "یہ واقعی خوبصورت ڈیٹا ہے،" رچرڈز نے کہا۔ "یہ حتمی نہیں ہے، لیکن [یہ] ثبوت کا ایک اور زبردست ٹکڑا ہے جو تجویز کرتا ہے کہ، درحقیقت، ہم جس طرح سے زبان سیکھتے ہیں، اس کا بڑا حصہ اگلی باتوں کی پیش گوئی کرنے کی کوشش کرنا ہے جو کہی جائیں گی۔"

غیر علاج شدہ پیتھالوجیز

ہر کوئی قائل نہیں ہے۔ جوش میک ڈرماٹمیساچوسٹس انسٹی ٹیوٹ آف ٹکنالوجی کے ایک کمپیوٹیشنل نیورو سائنس دان نے زیر نگرانی اور خود زیر نگرانی سیکھنے دونوں کا استعمال کرتے ہوئے بصارت اور سمعی ادراک کے ماڈلز پر کام کیا ہے۔ اس کی لیب نے اسے ڈیزائن کیا ہے جسے وہ "میٹیمر" کہتے ہیں، ترکیب شدہ آڈیو اور ویژول سگنلز جو کہ انسان کے لیے صرف ناقابل یقین شور. تاہم، مصنوعی عصبی نیٹ ورک کے لیے، میٹیمر حقیقی سگنلز سے الگ نہیں ہوتے۔ اس سے پتہ چلتا ہے کہ عصبی نیٹ ورک کی گہری تہوں میں تشکیل پانے والی نمائندگییں، یہاں تک کہ خود زیر نگرانی سیکھنے کے باوجود، ہمارے دماغ میں موجود نمائندگیوں سے میل نہیں کھاتیں۔ میک ڈرموٹ نے کہا کہ یہ خود زیر نگرانی سیکھنے کے طریقے "اس لحاظ سے پیشرفت ہیں کہ آپ ایسی نمائندگیوں کو سیکھنے کے قابل ہیں جو ان تمام لیبلز کی ضرورت کے بغیر بہت سے شناختی طرز عمل کی حمایت کر سکتے ہیں۔" "لیکن ان کے پاس ابھی بھی زیر نگرانی ماڈلز کی بہت سی پیتھالوجیز ہیں۔"

الگورتھم کو خود بھی مزید کام کی ضرورت ہے۔ مثال کے طور پر، Meta AI کے Wav2Vec 2.0 میں، AI صرف چند دسیوں ملی سیکنڈز کی قدر کی آواز کے لیے اویکت نمائیندگیوں کی پیشین گوئی کرتا ہے — ایک لفظ کو چھوڑنے کے لیے ادراک کے لحاظ سے الگ آواز کو بولنے میں جتنا وقت لگتا ہے اس سے کم وقت۔ کنگ نے کہا، "دماغ کی طرح کچھ کرنے کے لیے بہت سی چیزیں کرنی ہیں۔"

دماغی افعال کو صحیح معنوں میں سمجھنے کے لیے خود زیر نگرانی سیکھنے سے زیادہ کی ضرورت ہوتی ہے۔ ایک چیز کے لیے، دماغ فیڈ بیک کنکشنز سے بھرا ہوا ہے، جبکہ موجودہ ماڈلز میں اس طرح کے کچھ رابطے ہیں، اگر کوئی ہیں۔ ایک واضح اگلا مرحلہ یہ ہوگا کہ انتہائی بار بار چلنے والے نیٹ ورکس کو تربیت دینے کے لیے خود زیر نگرانی سیکھنے کا استعمال کیا جائے - ایک مشکل عمل - اور یہ دیکھیں کہ اس طرح کے نیٹ ورکس کی سرگرمی دماغی سرگرمی سے کس طرح موازنہ کرتی ہے۔ دوسرا اہم قدم یہ ہوگا کہ خود زیر نگرانی سیکھنے والے ماڈلز میں مصنوعی نیوران کی سرگرمی کو انفرادی حیاتیاتی نیوران کی سرگرمی سے ملایا جائے۔ "امید ہے، مستقبل میں، [ہمارے] نتائج کی تصدیق سنگل سیل ریکارڈنگ کے ساتھ بھی ہو جائے گی،" کنگ نے کہا۔

اگر دماغ اور خود زیر نگرانی سیکھنے کے ماڈلز کے درمیان مشاہدہ کردہ مماثلت دوسرے حسی کاموں کے لیے رکھتی ہے، تو یہ اس سے بھی زیادہ مضبوط اشارہ ہوگا کہ ہمارے دماغ جو بھی جادو کرنے کے قابل ہیں اسے کسی نہ کسی شکل میں خود زیر نگرانی سیکھنے کی ضرورت ہے۔ کنگ نے کہا کہ "اگر ہم بہت سارے مختلف نظاموں کے درمیان منظم مماثلت پاتے ہیں، تو یہ تجویز کرے گا کہ شاید ذہین انداز میں معلومات پر کارروائی کرنے کے اتنے زیادہ طریقے نہیں ہیں،" کنگ نے کہا۔ "کم از کم، یہ ایک خوبصورت مفروضہ ہے جس کے ساتھ ہم کام کرنا چاہیں گے۔"