یہ پوسٹ آپ کو ان سب سے عام چیلنجوں سے گزرتی ہے جن کا سامنا صارفین کو داخلی دستاویزات کی تلاش کے دوران ہوتا ہے، اور آپ کو اس بارے میں ٹھوس رہنمائی فراہم کرتی ہے کہ کس طرح AWS سروسز کو ایک تخلیقی AI بات چیت کا بوٹ بنانے کے لیے استعمال کیا جا سکتا ہے جو اندرونی معلومات کو مزید مفید بناتا ہے۔

غیر ساختہ ڈیٹا تمام ڈیٹا کا 80% ہے۔ تنظیموں کے اندر پایا جاتا ہے، جس میں دستورالعمل، PDFs، FAQs، ای میلز، اور دیگر دستاویزات کے ذخیرے شامل ہوتے ہیں جو روزانہ بڑھتے ہیں۔ آج کاروبار داخلی معلومات کے مسلسل بڑھتے ہوئے ذخیروں پر انحصار کرتے ہیں، اور مسائل اس وقت پیدا ہوتے ہیں جب غیر منظم ڈیٹا کی مقدار غیر منظم ہو جاتی ہے۔ اکثر، صارفین اپنے آپ کو اپنے مطلوبہ جوابات تلاش کرنے کے لیے بہت سے مختلف داخلی ذرائع کو پڑھتے اور جانچتے ہوئے پاتے ہیں۔

اندرونی سوال و جواب کے فورمز صارفین کو انتہائی مخصوص جوابات حاصل کرنے میں مدد کر سکتے ہیں لیکن اس کے لیے انتظار کے طویل وقت کی بھی ضرورت ہوتی ہے۔ کمپنی کے مخصوص داخلی سوالات کے معاملے میں، طویل انتظار کے اوقات کا نتیجہ ملازمین کی پیداواری صلاحیت میں کمی کا باعث بنتا ہے۔ سوال و جواب کے فورمز کی پیمائش کرنا مشکل ہے کیونکہ وہ دستی طور پر لکھے گئے جوابات پر انحصار کرتے ہیں۔ جنریٹیو AI کے ساتھ، فی الحال صارفین کے معلومات کو تلاش کرنے اور تلاش کرنے کے طریقہ کار میں ایک نمونہ بدل گیا ہے۔ اگلا منطقی مرحلہ یہ ہے کہ صارف کے استعمال میں آسانی کے لیے بڑی دستاویزات کو چھوٹے کاٹنے والے سائز کی معلومات میں کم کرنے کے لیے جنریٹو AI کا استعمال کیا جائے۔ متن پڑھنے یا جوابات کے انتظار میں زیادہ وقت گزارنے کے بجائے، صارف اندرونی معلومات کے متعدد موجودہ ذخیروں کی بنیاد پر حقیقی وقت میں خلاصے تیار کر سکتے ہیں۔

حل جائزہ

یہ حل صارفین کو داخلی دستاویزات کے بارے میں پوچھے گئے سوالات کے جوابات حاصل کرنے کے لیے ٹرانسفارمر ماڈل کا استعمال کرتے ہوئے ڈیٹا کے بارے میں سوالات کے جوابات حاصل کرنے کی اجازت دیتا ہے جس پر اسے تربیت نہیں دی گئی ہے، ایک تکنیک جسے زیرو شاٹ پرامپٹنگ کہا جاتا ہے۔ اس حل کو اپنانے سے، صارفین درج ذیل فوائد حاصل کر سکتے ہیں:

- اندرونی دستاویزات کے موجودہ ذرائع کی بنیاد پر سوالات کے درست جوابات تلاش کریں۔

- سب سے تازہ ترین معلومات کے ساتھ دستاویزات کا استعمال کرتے ہوئے پیچیدہ سوالات کے فوری جوابات فراہم کرنے کے لیے Large Language Models (LLMs) کا استعمال کرتے ہوئے صارفین کے جوابات کی تلاش میں لگنے والے وقت کو کم کریں۔

- سنٹرلائزڈ ڈیش بورڈ کے ذریعے پہلے دیئے گئے سوالات کے جوابات تلاش کریں۔

- جوابات تلاش کرنے کے لیے معلومات کو دستی طور پر پڑھنے میں وقت گزارنے سے پیدا ہونے والے تناؤ کو کم کریں۔

بازیافت اگمینٹڈ جنریشن (RAG)

Retrieval Augmented Generation (RAG) LLM کی بنیاد پر سوالات کی کچھ خامیوں کو کم کرتا ہے آپ کے علم کی بنیاد سے جوابات تلاش کر کے اور LLM کا استعمال کرتے ہوئے دستاویزات کو مختصر جوابات میں بیان کر کے۔ براہ کرم یہ پڑھیں پوسٹ RAG اپروچ کو لاگو کرنے کا طریقہ سیکھنے کے لیے ایمیزون کیندر. درج ذیل خطرات اور حدود ایل ایل ایم پر مبنی سوالات کے ساتھ وابستہ ہیں جن کا جواب ایمیزون کیندر کے ساتھ آر اے جی اپروچ کرتا ہے:

- ہیلوسینیشن اور ٹریس ایبلٹی - LLMS کو بڑے ڈیٹا سیٹس پر تربیت دی جاتی ہے اور امکانات پر ردعمل پیدا کرتے ہیں۔ یہ غلط جوابات کا باعث بن سکتا ہے، جنہیں فریب کاری کے نام سے جانا جاتا ہے۔

- متعدد ڈیٹا سائلوز - آپ کے جواب میں متعدد ذرائع سے ڈیٹا کا حوالہ دینے کے لیے، ڈیٹا کو جمع کرنے کے لیے ایک کنیکٹر ایکو سسٹم قائم کرنے کی ضرورت ہے۔ متعدد ذخیروں تک رسائی دستی اور وقت طلب ہے۔

- سیکیورٹی - RAG اور LLMs کے ذریعے چلنے والے بات چیت کے بوٹس کو تعینات کرتے وقت سیکیورٹی اور رازداری اہم امور ہیں۔ استعمال کرنے کے باوجود ایمیزون کی تعریف ذاتی ڈیٹا کو فلٹر کرنے کے لیے جو صارف کے سوالات کے ذریعے فراہم کیا جا سکتا ہے، اندراج شدہ ڈیٹا کے لحاظ سے، غیر ارادی طور پر ذاتی یا حساس معلومات کے سامنے آنے کا امکان رہتا ہے۔ اس کا مطلب ہے کہ چیٹ بوٹ تک رسائی کو کنٹرول کرنا حساس معلومات تک غیر ارادی رسائی کو روکنے کے لیے بہت ضروری ہے۔

- ڈیٹا کی مطابقت - LLMS کو مخصوص تاریخ تک ڈیٹا پر تربیت دی جاتی ہے، جس کا مطلب ہے کہ معلومات اکثر موجودہ نہیں ہوتی ہیں۔ حالیہ اعداد و شمار پر تربیتی ماڈلز سے وابستہ لاگت زیادہ ہے۔ درست اور تازہ ترین جوابات کو یقینی بنانے کے لیے، تنظیمیں انڈیکس شدہ دستاویزات کے مواد کو باقاعدگی سے اپ ڈیٹ اور افزودہ کرنے کی ذمہ داری اٹھاتی ہیں۔

- لاگت - اس حل کی تعیناتی سے وابستہ لاگت کاروباریوں کے لیے قابل غور ہونی چاہیے۔ اس حل کو لاگو کرتے وقت کاروباری اداروں کو اپنے بجٹ اور کارکردگی کی ضروریات کا بغور جائزہ لینے کی ضرورت ہے۔ ایل ایل ایم چلانے کے لیے کافی کمپیوٹیشنل وسائل کی ضرورت پڑ سکتی ہے، جس سے آپریشنل اخراجات بڑھ سکتے ہیں۔ یہ اخراجات ان ایپلیکیشنز کے لیے ایک حد بن سکتے ہیں جنہیں بڑے پیمانے پر کام کرنے کی ضرورت ہے۔ تاہم، کے فوائد میں سے ایک AWS کلاؤڈ آپ جو استعمال کرتے ہیں صرف اس کی ادائیگی کرنے کی لچک ہے۔ AWS ایک سادہ، یکساں، ادائیگی کے مطابق قیمتوں کا تعین کرنے والا ماڈل پیش کرتا ہے، لہذا آپ سے صرف ان وسائل کے لیے چارج کیا جاتا ہے جو آپ استعمال کرتے ہیں۔

ایمیزون سیج میکر جمپ اسٹارٹ کا استعمال

ٹرانسفارمر پر مبنی زبان کے ماڈلز کے لیے، تنظیمیں استعمال کرنے سے فائدہ اٹھا سکتی ہیں۔ ایمیزون سیج میکر جمپ اسٹارٹ، جو پہلے سے تیار شدہ مشین لرننگ ماڈلز کا مجموعہ پیش کرتا ہے۔ Amazon SageMaker JumpStart ٹیکسٹ جنریشن اور سوال جواب (Q&A) بنیادی ماڈلز کی ایک وسیع رینج پیش کرتا ہے جنہیں آسانی سے تعینات اور استعمال کیا جا سکتا ہے۔ یہ حل FLAN T5-XL Amazon SageMaker JumpStart ماڈل کو مربوط کرتا ہے، لیکن ذہن میں رکھنے کے لیے مختلف پہلو ہیں جب فاؤنڈیشن ماڈل کا انتخاب.

ہمارے ورک فلو میں سیکیورٹی کو مربوط کرنا

سلامتی کے ستون کے بہترین طریقوں پر عمل کرتے ہوئے اچھی طرح سے تعمیر شدہ فریم ورک, ایمیزون کاگنیٹو تصدیق کے لیے استعمال کیا جاتا ہے۔ Amazon Cognito User Pools کو فریق ثالث کے شناختی فراہم کنندگان کے ساتھ مربوط کیا جا سکتا ہے جو رسائی کنٹرول کے لیے استعمال کیے جانے والے کئی فریم ورکس کو سپورٹ کرتے ہیں، بشمول Open Authorization (OAuth)، OpenID Connect (OIDC)، یا Security Assertion Markup Language (SAML)۔ صارفین اور ان کے اعمال کی شناخت حل کو ٹریس ایبلٹی برقرار رکھنے کی اجازت دیتی ہے۔ حل بھی استعمال کرتا ہے۔ ایمیزون سمجھنا ذاتی طور پر قابل شناخت معلومات (PII) کا پتہ لگانا خود کار طریقے سے شناخت کرنے اور PII کو درست کرنے کی خصوصیت۔ ترمیم شدہ PII میں پتے، سوشل سیکورٹی نمبرز، ای میل پتے اور دیگر حساس معلومات شامل ہیں۔ یہ ڈیزائن اس بات کو یقینی بناتا ہے کہ صارف کی طرف سے ان پٹ استفسار کے ذریعے فراہم کردہ کسی بھی PII کو درست کیا جائے۔ PII ذخیرہ نہیں کیا جاتا ہے، Amazon Kendra کے ذریعے استعمال کیا جاتا ہے، یا LLM کو کھلایا جاتا ہے۔

حل واک تھرو

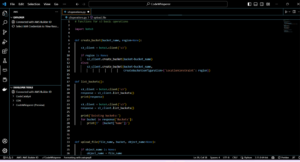

درج ذیل مراحل دستاویزات کے بہاؤ پر سوال کا جواب دینے کے ورک فلو کو بیان کرتے ہیں:

- صارفین ویب انٹرفیس کے ذریعے سوال بھیجتے ہیں۔

- ایمیزون کاگنیٹو ویب ایپلیکیشن تک محفوظ رسائی کو یقینی بناتے ہوئے تصدیق کے لیے استعمال کیا جاتا ہے۔

- ویب ایپلیکیشن فرنٹ اینڈ پر میزبانی کی گئی ہے۔ AWS بڑھانا.

- ایمیزون API گیٹ وے صارف کی درخواستوں کو ہینڈل کرنے کے لیے مختلف اینڈ پوائنٹس کے ساتھ ایک REST API کی میزبانی کرتا ہے جو Amazon Cognito کے استعمال سے تصدیق شدہ ہیں۔

- کے ساتھ PII ریڈیکشن ایمیزون کی تعریف:

- صارف کے سوال کی کارروائی: جب کوئی صارف کوئی سوال یا ان پٹ جمع کرتا ہے، تو اسے سب سے پہلے Amazon Comprehend کے ذریعے پاس کیا جاتا ہے۔ سروس متن کا تجزیہ کرتی ہے اور استفسار کے اندر موجود کسی بھی PII اداروں کی شناخت کرتی ہے۔

- PII نکالنا: Amazon Comprehend صارف کے استفسار سے پتہ چلنے والے PII اداروں کو نکالتا ہے۔

- کے ساتھ متعلقہ معلومات کی بازیافت ایمیزون کیندر:

- Amazon Kendra کا استعمال ان دستاویزات کے اشاریہ کو منظم کرنے کے لیے کیا جاتا ہے جس میں صارف کے سوالات کے جوابات پیدا کرنے کے لیے استعمال ہونے والی معلومات ہوتی ہیں۔

- ۔ LangChain QA بازیافت ماڈیول کا استعمال گفتگو کا سلسلہ بنانے کے لیے کیا جاتا ہے جس میں صارف کے سوالات کے بارے میں متعلقہ معلومات ہوتی ہیں۔

- انٹیگریشن ایمیزون سیج میکر جمپ اسٹارٹ:

- AWS Lambda فنکشن LangChain لائبریری کا استعمال کرتا ہے اور Amazon SageMaker JumpStart اینڈ پوائنٹ سے سیاق و سباق سے بھرے استفسار کے ساتھ جڑتا ہے۔ ایمیزون سیج میکر جمپ سٹارٹ اینڈ پوائنٹ LLM کے انٹرفیس کے طور پر کام کرتا ہے جو اندازہ لگانے کے لیے استعمال ہوتا ہے۔

- جوابات کو ذخیرہ کرنا اور اسے صارف کو واپس کرنا:

- ایل ایل ایم کا جواب اس میں محفوظ ہے۔ ایمیزون ڈائنومو ڈی بی صارف کے استفسار کے ساتھ، ٹائم اسٹیمپ، ایک منفرد شناخت کنندہ، اور دیگر صوابدیدی شناخت کنندگان جیسے سوال کے زمرے کے لیے۔ سوال و جواب کو مجرد اشیاء کے طور پر ذخیرہ کرنے سے AWS Lambda فنکشن کو سوال پوچھے جانے کے وقت کی بنیاد پر صارف کی گفتگو کی تاریخ کو آسانی سے دوبارہ بنانے کی اجازت ملتی ہے۔

- آخر میں، جواب صارف کو واپس بھیج دیا جاتا ہے HTTPs درخواست کے ذریعے Amazon API Gateway REST API انضمام کے جواب کے ذریعے۔

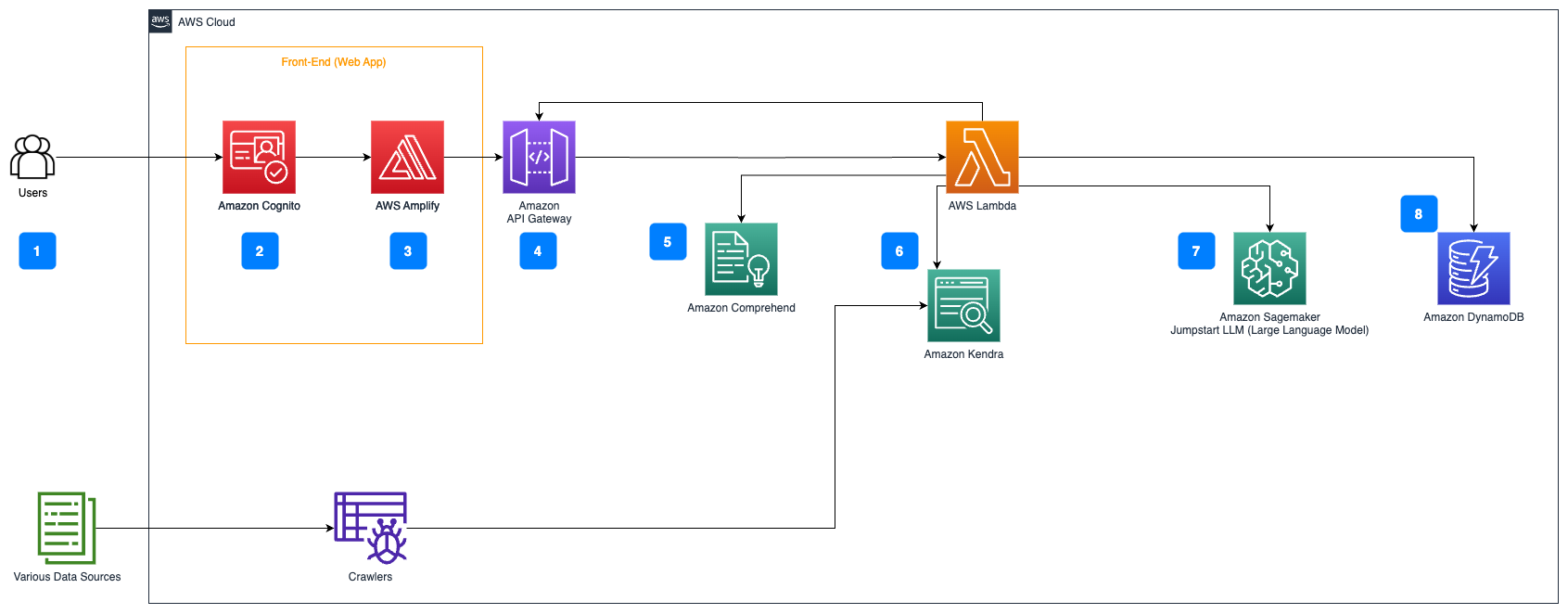

مندرجہ ذیل مراحل AWS Lambda کے افعال اور عمل کے ذریعے ان کے بہاؤ کی وضاحت کرتے ہیں:

- کسی بھی PII/حساس معلومات کو چیک کریں اور اس میں ترمیم کریں۔

- LangChain QA بازیافت کا سلسلہ

- تلاش کریں اور متعلقہ معلومات حاصل کریں۔

- سیاق و سباق بھرنا اور پرامپٹ انجینئرنگ

- ایل ایل ایم کے ساتھ اندازہ

- جواب واپس کریں اور اسے محفوظ کریں۔

استعمال کے مقدمات

کاروباری استعمال کے بہت سے معاملات ہیں جہاں گاہک اس ورک فلو کو استعمال کر سکتے ہیں۔ درج ذیل حصے میں بتایا گیا ہے کہ ورک فلو کو مختلف صنعتوں اور عمودی حصوں میں کیسے استعمال کیا جا سکتا ہے۔

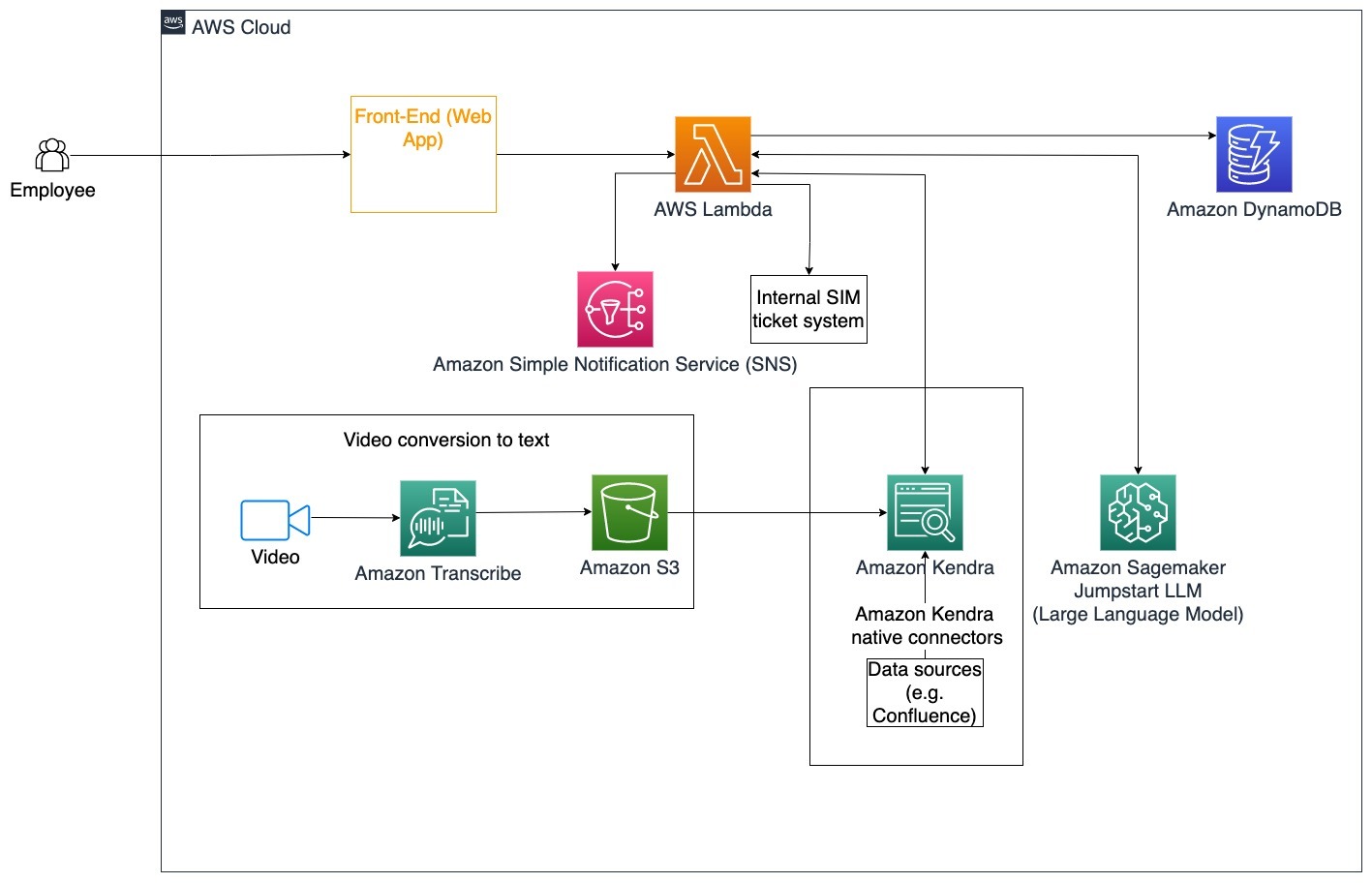

ملازم کی مدد

اچھی طرح سے ڈیزائن کردہ کارپوریٹ ٹریننگ ملازمین کے اطمینان کو بہتر بنا سکتی ہے اور نئے ملازمین کو آن بورڈ کرنے کے لیے درکار وقت کو کم کر سکتی ہے۔ جیسے جیسے تنظیمیں بڑھتی ہیں اور پیچیدگی بڑھتی ہے، ملازمین کو اندرونی دستاویزات کے بہت سے ذرائع کو سمجھنا مشکل ہوتا ہے۔ اس تناظر میں داخلی دستاویزات میں کمپنی کے رہنما خطوط، پالیسیاں، اور معیاری آپریٹنگ طریقہ کار شامل ہیں۔ اس منظر نامے کے لیے، ایک ملازم کا سوال ہے کہ کس طرح آگے بڑھنا ہے اور داخلی مسئلہ ٹکٹنگ ٹکٹ میں ترمیم کرنا ہے۔ ملازم مخصوص ٹکٹ کے لیے اگلے اقدامات پوچھنے اور اس پر عمل درآمد کرنے کے لیے جنریٹیو آرٹیفیشل انٹیلی جنس (AI) بات چیت کے بوٹ تک رسائی اور استعمال کر سکتا ہے۔

مخصوص استعمال کیس: کارپوریٹ رہنما خطوط کی بنیاد پر ملازمین کے لیے خودکار مسئلہ حل کریں۔

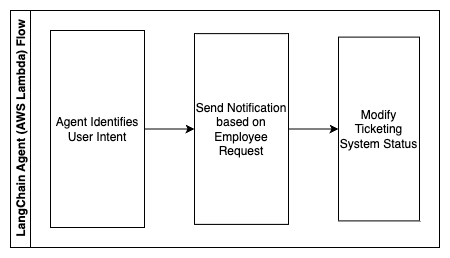

مندرجہ ذیل مراحل AWS Lambda کے افعال اور عمل کے ذریعے ان کے بہاؤ کی وضاحت کرتے ہیں:

- LangChain ایجنٹ ارادے کی شناخت کے لئے

- ملازم کی درخواست پر مبنی اطلاع بھیجیں۔

- ٹکٹ کی حیثیت میں ترمیم کریں۔

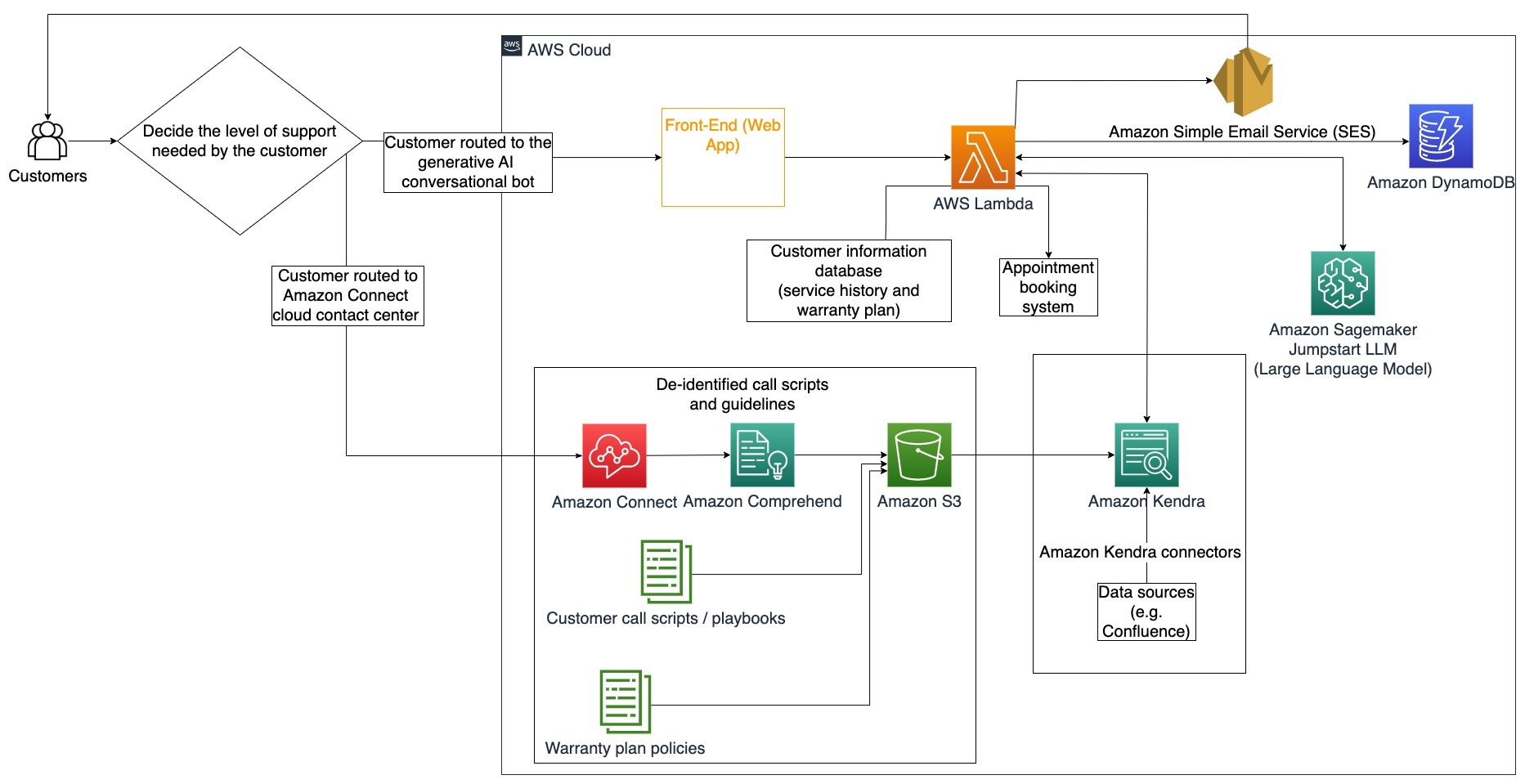

اس آرکیٹیکچر ڈایاگرام میں، کارپوریٹ ٹریننگ ویڈیوز کے ذریعے اندراج کیا جا سکتا ہے۔ ایمیزون نقل ان ویڈیو اسکرپٹس کا لاگ اکٹھا کرنے کے لیے۔ مزید برآں، مختلف ذرائع میں ذخیرہ شدہ کارپوریٹ تربیتی مواد (یعنی، کنفلوئنس، مائیکروسافٹ شیئرپوائنٹ، گوگل ڈرائیو، جیرا، وغیرہ) کو Amazon Kendra کنیکٹرز کے ذریعے انڈیکس بنانے کے لیے استعمال کیا جا سکتا ہے۔ مقامی کے مجموعہ کے بارے میں مزید جاننے کے لیے یہ مضمون پڑھیں کنیکٹر آپ ایمیزون کینڈر میں بطور سورس پوائنٹ استعمال کر سکتے ہیں۔ Amazon Kendra کرالر اس کے بعد کارپوریٹ ٹریننگ ویڈیو اسکرپٹس اور ان دیگر ذرائع میں محفوظ کردہ دستاویزات دونوں کو استعمال کرنے کے قابل ہو جاتا ہے تاکہ کمپنی کی کارپوریٹ ٹریننگ گائیڈ لائنز سے متعلق مخصوص سوالات کے جوابات دینے میں بات چیت کے بوٹ کی مدد کی جا سکے۔ LangChain ایجنٹ اجازتوں کی تصدیق کرتا ہے، ٹکٹ کی حیثیت میں ترمیم کرتا ہے، اور Amazon Simple Notification Service کا استعمال کرتے ہوئے درست افراد کو مطلع کرتا ہے۔ایمیزون ایس این ایس).

کسٹمر سپورٹ ٹیمیں

گاہک کے سوالات کو تیزی سے حل کرنے سے گاہک کا تجربہ بہتر ہوتا ہے اور برانڈ کی وفاداری کی حوصلہ افزائی ہوتی ہے۔ ایک وفادار کسٹمر بیس سیلز کو بڑھانے میں مدد کرتا ہے، جو نیچے کی لکیر میں حصہ ڈالتا ہے اور کسٹمر کی مصروفیت کو بڑھاتا ہے۔ کسٹمر سپورٹ ٹیمیں مصنوعات اور خدمات کے بارے میں گاہک کے سوالات کا جواب دینے کے لیے بہت ساری اندرونی دستاویزات اور کسٹمر ریلیشن شپ مینجمنٹ سوفٹ ویئر کا حوالہ دینے میں بہت زیادہ توانائی خرچ کرتی ہیں۔ اس تناظر میں داخلی دستاویزات میں عام کسٹمر سپورٹ کال اسکرپٹس، پلے بکس، توسیعی رہنما خطوط، اور کاروباری معلومات شامل ہوسکتی ہیں۔ تخلیقی AI بات چیت کا بوٹ لاگت کو بہتر بنانے میں مدد کرتا ہے کیونکہ یہ کسٹمر سپورٹ ٹیم کی جانب سے سوالات کو ہینڈل کرتا ہے۔

مخصوص استعمال کیس: سروس ہسٹری اور خریدے گئے کسٹمر سروس پلان کی بنیاد پر تیل کی تبدیلی کی درخواست کو ہینڈل کرنا۔

اس آرکیٹیکچر ڈایاگرام میں، صارف کو یا تو تخلیقی AI بات چیت کے بوٹ یا ایمیزون کنیکٹ رابطہ مرکز. یہ فیصلہ درکار معاونت کی سطح یا کسٹمر سپورٹ ایجنٹس کی دستیابی پر مبنی ہو سکتا ہے۔ LangChain ایجنٹ گاہک کے ارادے کی نشاندہی کرتا ہے اور شناخت کی تصدیق کرتا ہے۔ LangChain ایجنٹ سروس کی تاریخ اور خریدے گئے سپورٹ پلان کو بھی چیک کرتا ہے۔

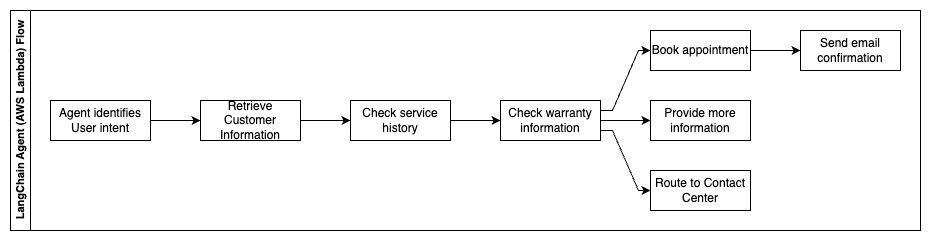

مندرجہ ذیل مراحل AWS Lambda کے افعال اور عمل کے ذریعے ان کے بہاؤ کی وضاحت کرتے ہیں:

- LangChain ایجنٹ ارادے کی نشاندہی کرتا ہے۔

- کسٹمر کی معلومات کو بازیافت کریں۔

- کسٹمر سروس کی تاریخ اور وارنٹی کی معلومات چیک کریں۔

- اپوائنٹمنٹ بُک کریں، مزید معلومات فراہم کریں، یا مرکز سے رابطہ کریں۔

- ای میل کی تصدیق بھیجیں۔

Amazon Connect کا استعمال آواز اور چیٹ لاگز کو جمع کرنے کے لیے کیا جاتا ہے، اور Amazon Comprehend کو ان لاگز سے ذاتی طور پر قابل شناخت معلومات (PII) کو ہٹانے کے لیے استعمال کیا جاتا ہے۔ اس کے بعد Amazon Kendra کرالر انڈیکس بنانے کے لیے redacted وائس اور چیٹ لاگز، کسٹمر کال اسکرپٹس، اور کسٹمر سروس سپورٹ پلان کی پالیسیوں کو استعمال کرنے کے قابل ہے۔ ایک بار فیصلہ ہو جانے کے بعد، تخلیقی AI بات چیت کا بوٹ فیصلہ کرتا ہے کہ آیا اپوائنٹمنٹ بُک کرنا ہے، مزید معلومات فراہم کرنا ہے، یا مزید مدد کے لیے صارف کو رابطہ مرکز تک پہنچانا ہے۔ لاگت کو بہتر بنانے کے لیے، LangChain ایجنٹ کم ترجیحی صارفین کے سوالات کے لیے کم ٹوکن اور کم مہنگے بڑے لینگویج ماڈل کا استعمال کرتے ہوئے جوابات بھی تیار کر سکتا ہے۔

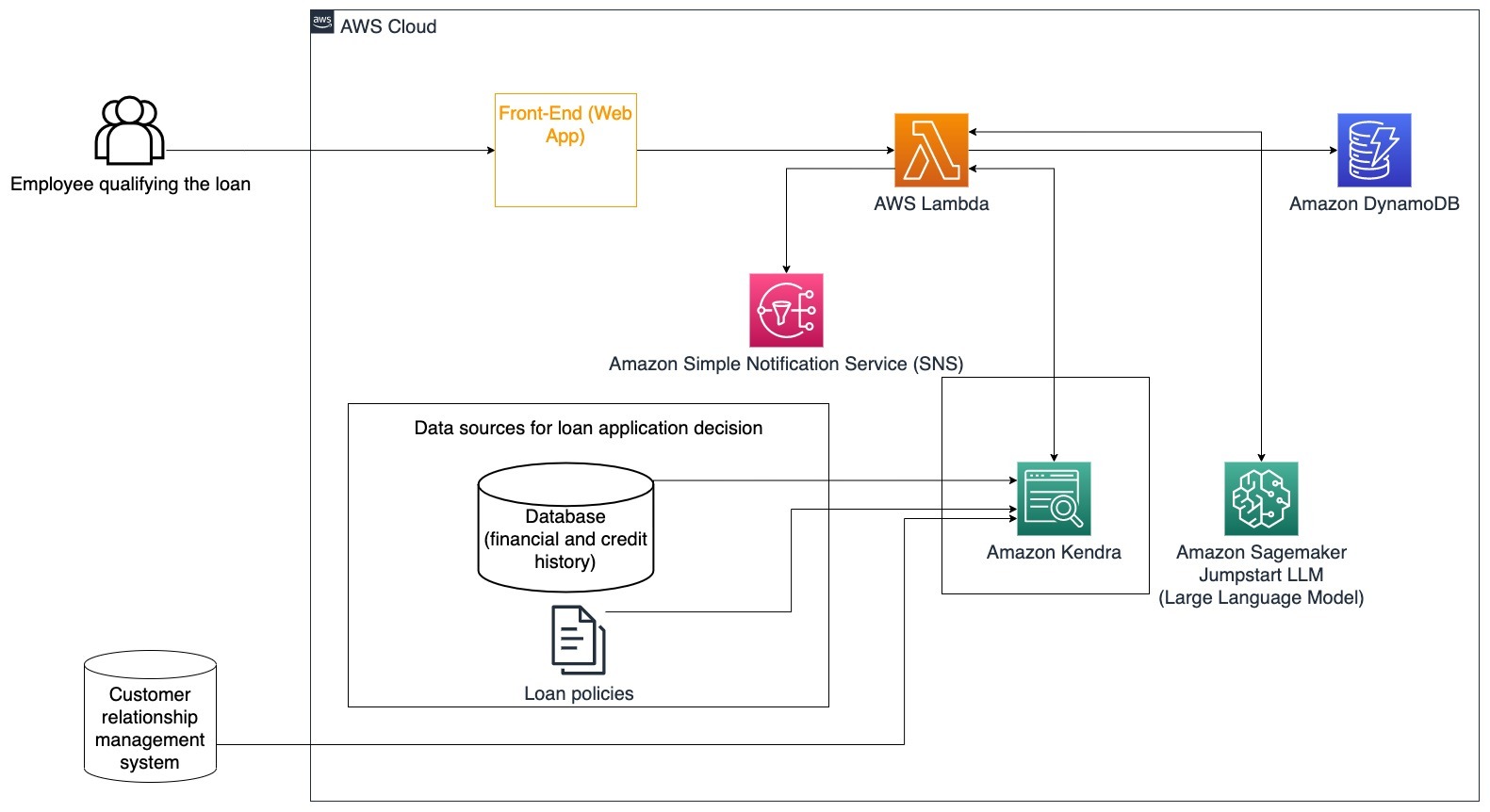

مالیاتی خدمات

مالیاتی خدمات کی کمپنیاں مسابقتی رہنے اور مالیاتی ضوابط کی تعمیل کے لیے معلومات کے بروقت استعمال پر انحصار کرتی ہیں۔ ایک تخلیقی AI بات چیت کے بوٹ کا استعمال کرتے ہوئے، مالیاتی تجزیہ کار اور مشیر متنی معلومات کے ساتھ بات چیت کے انداز میں بات چیت کر سکتے ہیں اور بہتر باخبر فیصلے کرنے میں لگنے والے وقت اور محنت کو کم کر سکتے ہیں۔ سرمایہ کاری اور مارکیٹ ریسرچ کے علاوہ، ایک تخلیقی AI بات چیت کا بوٹ بھی ایسے کاموں کو سنبھال کر انسانی صلاحیتوں کو بڑھا سکتا ہے جن کے لیے روایتی طور پر زیادہ انسانی محنت اور وقت درکار ہوتا ہے۔ مثال کے طور پر، ذاتی قرضوں میں مہارت رکھنے والا مالیاتی ادارہ صارفین کو بہتر شفافیت فراہم کرتے ہوئے قرضوں پر کارروائی کی شرح میں اضافہ کر سکتا ہے۔

مخصوص استعمال کیس: قرض کے فیصلے کا فیصلہ کرنے اور وضاحت کرنے کے لیے گاہک کی مالی تاریخ اور سابقہ قرض کی درخواستوں کا استعمال کریں۔

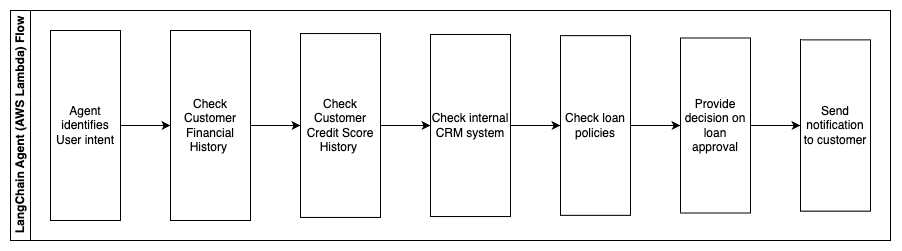

مندرجہ ذیل مراحل AWS Lambda کے افعال اور عمل کے ذریعے ان کے بہاؤ کی وضاحت کرتے ہیں:

- LangChain ایجنٹ ارادے کی شناخت کے لئے

- کسٹمر مالیاتی اور کریڈٹ سکور کی تاریخ چیک کریں

- اندرونی کسٹمر ریلیشن شپ مینجمنٹ سسٹم چیک کریں۔

- معیاری قرض کی پالیسیاں چیک کریں اور قرض کے اہل ہونے والے ملازم کے لیے فیصلہ تجویز کریں۔

- گاہک کو اطلاع بھیجیں۔

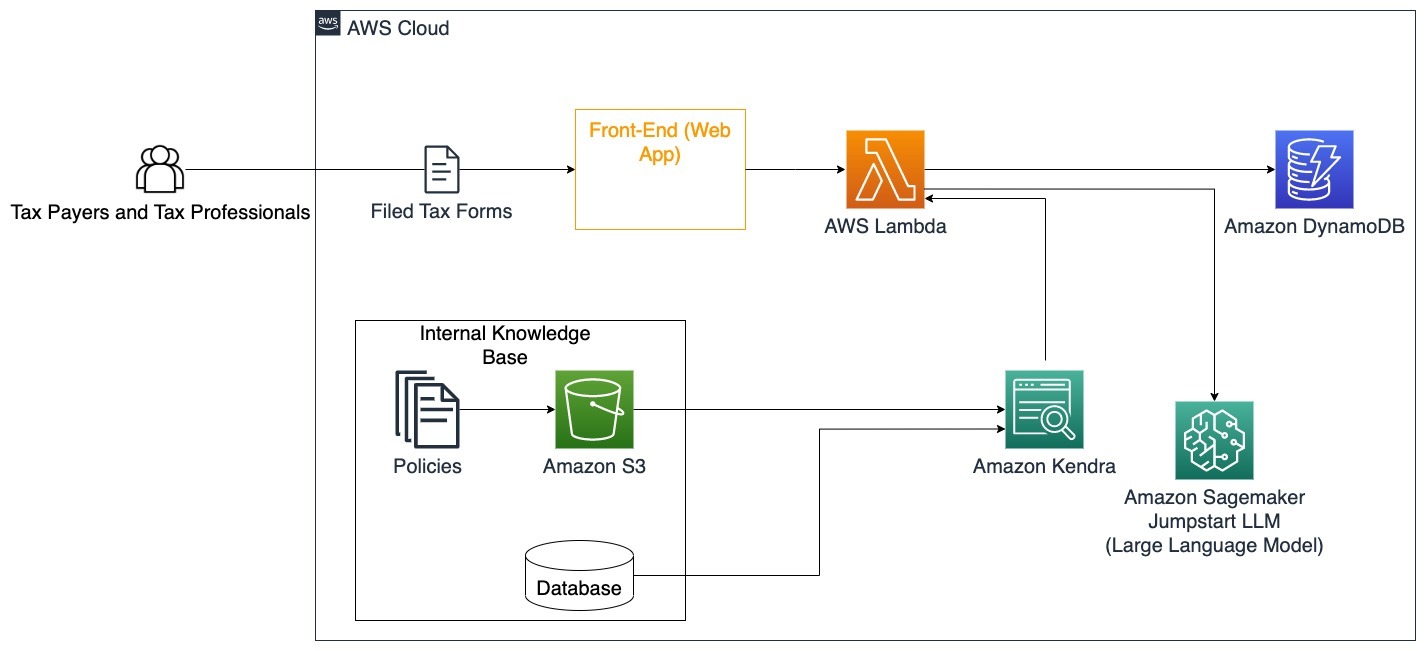

اس فن تعمیر میں ڈیٹا بیس میں ذخیرہ شدہ کسٹمر کے مالیاتی ڈیٹا اور کسٹمر ریلیشن شپ مینجمنٹ (CRM) ٹول میں ذخیرہ کردہ ڈیٹا شامل کیا گیا ہے۔ ان ڈیٹا پوائنٹس کا استعمال کمپنی کی اندرونی قرض کی پالیسیوں کی بنیاد پر فیصلے سے آگاہ کرنے کے لیے کیا جاتا ہے۔ صارف یہ سمجھنے کے لیے واضح سوالات پوچھ سکتا ہے کہ وہ کن قرضوں کے لیے اہل ہیں اور وہ قرضوں کی شرائط جن کو وہ قبول کر سکتے ہیں۔ اگر جنریٹو AI بات چیت کا بوٹ قرض کی درخواست کو منظور کرنے سے قاصر ہے، صارف اب بھی کریڈٹ سکور کو بہتر بنانے یا مالیاتی کے متبادل اختیارات کے بارے میں سوالات پوچھ سکتا ہے۔

حکومت

جنریٹو AI بات چیت کے بوٹس مواصلات، کارکردگی اور فیصلہ سازی کے عمل کو تیز کرکے سرکاری اداروں کو بہت فائدہ پہنچا سکتے ہیں۔ جنریٹو AI بات چیت کے بوٹس سرکاری ملازمین کو معلومات، پالیسیوں اور طریقہ کار (یعنی اہلیت کے معیار، درخواست کے عمل، اور شہریوں کی خدمات اور معاونت) کو تیزی سے بازیافت کرنے میں مدد کرنے کے لیے اندرونی علمی بنیادوں تک فوری رسائی بھی فراہم کر سکتے ہیں۔ ایک حل ایک انٹرایکٹو نظام ہے، جو ٹیکس دہندگان اور ٹیکس پیشہ ور افراد کو آسانی سے ٹیکس سے متعلق تفصیلات اور فوائد تلاش کرنے کی اجازت دیتا ہے۔ اس کا استعمال صارف کے سوالات کو سمجھنے، ٹیکس دستاویزات کا خلاصہ کرنے اور انٹرایکٹو بات چیت کے ذریعے واضح جوابات فراہم کرنے کے لیے کیا جا سکتا ہے۔

صارفین سوالات پوچھ سکتے ہیں جیسے:

- وراثتی ٹیکس کیسے کام کرتا ہے اور ٹیکس کی حدیں کیا ہیں؟

- کیا آپ انکم ٹیکس کے تصور کی وضاحت کر سکتے ہیں؟

- دوسری جائیداد فروخت کرتے وقت ٹیکس کے کیا اثرات ہوتے ہیں؟

مزید برآں، صارفین کو سسٹم میں ٹیکس فارم جمع کرانے کی سہولت مل سکتی ہے، جس سے فراہم کردہ معلومات کی درستگی کی تصدیق میں مدد مل سکتی ہے۔

یہ فن تعمیر اس بات کی وضاحت کرتا ہے کہ کس طرح صارفین مکمل شدہ ٹیکس فارمز کو حل میں اپ لوڈ کر سکتے ہیں اور ضروری معلومات کو درست طریقے سے مکمل کرنے کے بارے میں انٹرایکٹو تصدیق اور رہنمائی کے لیے اس کا استعمال کیسے کر سکتے ہیں۔

صحت کی دیکھ بھال

صحت کی دیکھ بھال کے کاروباروں کے پاس مریضوں کی اندرونی معلومات کی بڑی مقدار کے استعمال کو خودکار کرنے کا موقع ہوتا ہے، جبکہ علاج کے اختیارات، انشورنس کلیمز، کلینیکل ٹرائلز، اور فارماسیوٹیکل ریسرچ جیسے استعمال کے معاملات سے متعلق عام سوالات کو بھی حل کرنے کا موقع ملتا ہے۔ تخلیقی AI بات چیت کے بوٹ کا استعمال فراہم کردہ علمی بنیاد سے صحت کی معلومات کے بارے میں فوری اور درست جوابات پیدا کرنے کے قابل بناتا ہے۔ مثال کے طور پر، صحت کی دیکھ بھال کے کچھ پیشہ ور افراد انشورنس کے دعوے دائر کرنے کے لیے فارم بھرنے میں کافی وقت صرف کرتے ہیں۔

اسی طرح کی ترتیبات میں، کلینیکل ٹرائل کے منتظمین اور محققین کو علاج کے اختیارات کے بارے میں معلومات تلاش کرنے کی ضرورت ہے۔ ایک تخلیقی AI بات چیت کا بوٹ Amazon Kendra میں پہلے سے بنائے گئے کنیکٹرز کا استعمال کر سکتا ہے تاکہ فارماسیوٹیکل کمپنیوں اور یونیورسٹیوں کے ذریعے جاری تحقیق کے ذریعے شائع ہونے والی لاکھوں دستاویزات سے انتہائی متعلقہ معلومات حاصل کی جا سکیں۔

مخصوص استعمال کیس: انشورنس فارموں کو پُر کرنے اور بھیجنے کے لیے درکار غلطیوں اور وقت کو کم کریں۔

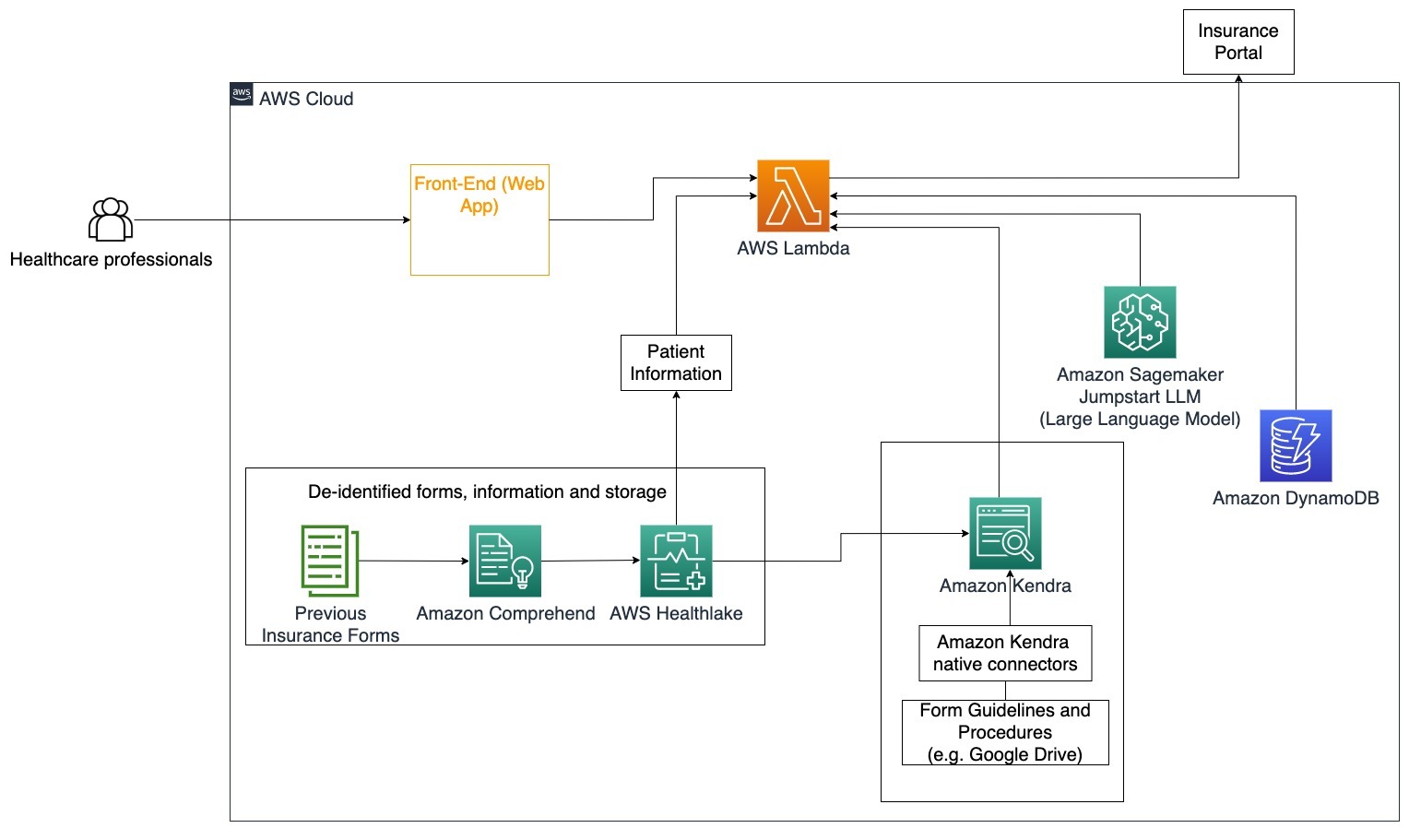

اس آرکیٹیکچر ڈایاگرام میں، ایک صحت کی دیکھ بھال کرنے والا پیشہ ور یہ جاننے کے لیے کہ بیمہ کے لیے کن فارموں کو پُر کرنے کی ضرورت ہے۔ LangChain ایجنٹ اس کے بعد صحیح فارم حاصل کرنے اور مریض کے لیے درکار معلومات شامل کرنے کے ساتھ ساتھ انشورنس پالیسیوں اور سابقہ فارموں کی بنیاد پر فارم کے وضاحتی حصوں کے لیے جوابات دینے کے قابل ہو جاتا ہے۔ ہیلتھ کیئر پروفیشنل انشورنس پورٹل پر فارم کی منظوری اور ڈیلیور کرنے سے پہلے LLM کے ذریعے دیے گئے جوابات میں ترمیم کر سکتا ہے۔

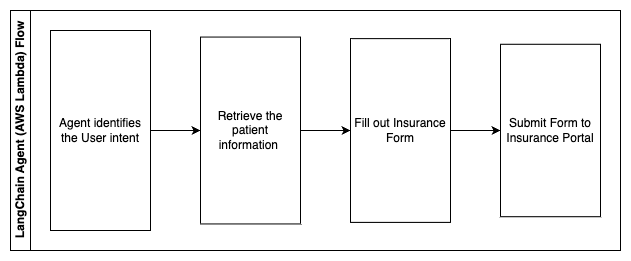

مندرجہ ذیل مراحل AWS Lambda کے افعال اور عمل کے ذریعے ان کے بہاؤ کی وضاحت کرتے ہیں:

- LangChain ایجنٹ ارادے کی شناخت کے لئے

- مریض کی مطلوبہ معلومات کو بازیافت کریں۔

- مریض کی معلومات اور فارم گائیڈ لائن کی بنیاد پر انشورنس فارم کو پُر کریں۔

- صارف کی منظوری کے بعد فارم کو انشورنس پورٹل پر جمع کروائیں۔

اے ڈبلیو ایس ہیلتھ لیک صحت کے ڈیٹا کو محفوظ طریقے سے ذخیرہ کرنے کے لیے استعمال کیا جاتا ہے جس میں سابقہ انشورنس فارمز اور مریض کی معلومات شامل ہیں، اور Amazon Comprehend کو پچھلے انشورنس فارمز سے ذاتی طور پر قابل شناخت معلومات (PII) کو ہٹانے کے لیے استعمال کیا جاتا ہے۔ اس کے بعد ایمیزون کیندر کرالر انڈیکس بنانے کے لیے انشورنس فارمز اور گائیڈ لائنز کا سیٹ استعمال کرنے کے قابل ہو جاتا ہے۔ ایک بار جنریٹو AI کے ذریعے فارم (فارمز) پُر ہو جائیں، پھر طبی پیشہ ور کے ذریعے جائزہ لیا گیا فارم انشورنس پورٹل پر بھیجا جا سکتا ہے۔

لاگت کا تخمینہ

تصور کے ثبوت کے طور پر بنیادی حل کی تعیناتی کی لاگت مندرجہ ذیل جدول میں دکھائی گئی ہے۔ چونکہ بنیادی حل کو تصور کا ثبوت سمجھا جاتا ہے، Amazon Kendra Developer Edition کو کم لاگت والے آپشن کے طور پر استعمال کیا گیا کیونکہ کام کا بوجھ پیداوار میں نہیں ہوگا۔ Amazon Kendra Developer Edition کے لیے ہمارا مفروضہ مہینے کے لیے 730 فعال گھنٹے تھا۔

Amazon SageMaker کے لیے، ہم نے ایک مفروضہ بنایا کہ گاہک ml.g4dn.2xlarge مثال کے طور پر ریئل ٹائم انفرنس کے لیے استعمال کر رہا ہو گا، فی مثال کے لیے ایک ہی انفرنس اینڈ پوائنٹ کے ساتھ۔ آپ Amazon SageMaker کی قیمتوں اور دستیاب انفرنس مثال کی اقسام کے بارے میں مزید معلومات حاصل کر سکتے ہیں۔ یہاں.

| سروس | وسائل استعمال | USD میں لاگت کا تخمینہ فی مہینہ |

| AWS بڑھانا | 150 تعمیراتی منٹ 1 GB ڈیٹا پیش کیا گیا۔ 500,000 درخواستیں |

15.71 |

| ایمیزون API گیٹ وے | 1M REST API کالز | 3.5 |

| او ڈبلیو ایس لامبڈا۔ | 1 ملین درخواستیں۔ فی درخواست 5 سیکنڈ کی مدت 2 جی بی میموری مختص کی گئی۔ |

160.23 |

| ایمیزون ڈائنومو ڈی بی | 1 ملین پڑھتے ہیں۔ 1 ملین لکھتے ہیں۔ 100 GB اسٹوریج |

26.38 |

| ایمیزون سیج میکر | ml.g4dn.2xlarge کے ساتھ اصل وقت کا اندازہ | 676.8 |

| ایمیزون کیندر | 730 گھنٹے فی مہینہ کے ساتھ ڈیولپر ایڈیشن 10,000 دستاویزات کو اسکین کیا گیا۔ 5,000 سوالات/دن |

821.25 |

| . | . | کل لاگت: 1703.87 |

* Amazon Cognito کے پاس 50,000 ماہانہ ایکٹیو صارفین کا مفت درجہ ہے جو Cognito User Pools استعمال کرتے ہیں یا 50 ماہانہ ایکٹو صارفین جو SAML 2.0 شناخت فراہم کرنے والے استعمال کرتے ہیں۔

صاف کرو

لاگت بچانے کے لیے، ٹیوٹوریل کے حصے کے طور پر آپ نے جو وسائل استعمال کیے ہیں انہیں حذف کریں۔ آپ SageMaker کنسول کے ذریعے بنائے گئے کسی بھی SageMaker اینڈ پوائنٹ کو حذف کر سکتے ہیں۔ یاد رکھیں، Amazon Kendra انڈیکس کو حذف کرنے سے اصل دستاویزات آپ کے اسٹوریج سے نہیں ہٹتی ہیں۔

نتیجہ

اس پوسٹ میں، ہم نے آپ کو دکھایا کہ کس طرح حقیقی وقت میں متعدد ذخیروں سے خلاصہ کرکے اندرونی معلومات تک رسائی کو آسان بنایا جائے۔ تجارتی طور پر دستیاب LLMs کی حالیہ پیش رفت کے بعد، جنریٹو AI کے امکانات زیادہ واضح ہو گئے ہیں۔ اس پوسٹ میں، ہم نے سرور کے بغیر چیٹ بوٹ بنانے کے لیے AWS سروسز استعمال کرنے کے طریقے دکھائے ہیں جو سوالات کے جوابات دینے کے لیے جنریٹو AI کا استعمال کرتا ہے۔ اس نقطہ نظر میں صارف کے استفسار میں فراہم کردہ کسی بھی حساس معلومات کو فلٹر کرنے کے لیے ایک توثیق کی پرت اور Amazon Comprehend کی PII کا پتہ لگانا شامل ہے۔ چاہے وہ صحت کی دیکھ بھال کرنے والے افراد ہوں جو انشورنس کے دعوے دائر کرنے کی باریکیوں کو سمجھتے ہوں یا HR مخصوص کمپنی کے وسیع ضوابط کو سمجھتے ہوں، متعدد صنعتیں اور عمودی چیزیں ہیں جو اس نقطہ نظر سے فائدہ اٹھا سکتی ہیں۔ ایک Amazon SageMaker JumpStart فاؤنڈیشن ماڈل چیٹ بوٹ کے پیچھے انجن ہے، جبکہ RAG تکنیک کا استعمال کرتے ہوئے ایک سیاق و سباق بھرنے کا طریقہ استعمال کیا جاتا ہے تاکہ یہ یقینی بنایا جا سکے کہ جوابات اندرونی دستاویزات کا زیادہ درست حوالہ دیتے ہیں۔

AWS پر جنریٹیو AI کے ساتھ کام کرنے کے بارے میں مزید جاننے کے لیے، رجوع کریں۔ AWS پر جنریٹیو AI کے ساتھ تعمیر کے لیے نئے ٹولز کا اعلان. AWS خدمات کے ساتھ RAG تکنیک کے استعمال کے بارے میں مزید گہرائی سے رہنمائی کے لیے، رجوع کریں۔ Amazon Kendra، LangChain، اور بڑے لینگویج ماڈلز کا استعمال کرتے ہوئے انٹرپرائز ڈیٹا پر فوری طور پر اعلی درستگی پیدا کرنے والی AI ایپلیکیشنز بنائیں. چونکہ اس بلاگ میں نقطہ نظر LLM agnostic ہے، اس لیے کسی بھی LLM کو اندازہ لگانے کے لیے استعمال کیا جا سکتا ہے۔ ہماری اگلی پوسٹ میں، ہم Amazon Bedrock اور Amazon Titan LLM کا استعمال کرتے ہوئے اس حل کو نافذ کرنے کے طریقوں کا خاکہ پیش کریں گے۔

مصنفین کے بارے میں

ابھیشیک مالیگیہلی شیولنگیا AWS میں ایک سینئر AI سروسز سلوشن آرکیٹیکٹ ہے۔ وہ جنریٹو AI، Amazon Kendra اور NLP کا استعمال کرتے ہوئے ایپلیکیشنز بنانے کا شوقین ہے۔ اس کے پاس صارفین اور کاروباری اداروں کے لیے قدر پیدا کرنے کے لیے ڈیٹا اور AI سلوشنز بنانے کا تقریباً 10 سال کا تجربہ ہے۔ یہاں تک کہ اس نے اپنے کیریئر اور پیشہ ورانہ سفر کے بارے میں سوالات کے جوابات کے لیے تفریح کے لیے ایک (ذاتی) چیٹ بوٹ بھی بنایا ہے۔ کام سے باہر اسے خاندان اور دوستوں کے پورٹریٹ بنانے میں مزہ آتا ہے، اور آرٹ ورک بنانا پسند کرتا ہے۔

ابھیشیک مالیگیہلی شیولنگیا AWS میں ایک سینئر AI سروسز سلوشن آرکیٹیکٹ ہے۔ وہ جنریٹو AI، Amazon Kendra اور NLP کا استعمال کرتے ہوئے ایپلیکیشنز بنانے کا شوقین ہے۔ اس کے پاس صارفین اور کاروباری اداروں کے لیے قدر پیدا کرنے کے لیے ڈیٹا اور AI سلوشنز بنانے کا تقریباً 10 سال کا تجربہ ہے۔ یہاں تک کہ اس نے اپنے کیریئر اور پیشہ ورانہ سفر کے بارے میں سوالات کے جوابات کے لیے تفریح کے لیے ایک (ذاتی) چیٹ بوٹ بھی بنایا ہے۔ کام سے باہر اسے خاندان اور دوستوں کے پورٹریٹ بنانے میں مزہ آتا ہے، اور آرٹ ورک بنانا پسند کرتا ہے۔

میڈا آئیہ آسٹن، ٹیکساس میں مقیم AWS میں ایک ایسوسی ایٹ سلوشنز آرکیٹیکٹ ہے۔ اس نے حال ہی میں ڈلاس کی یونیورسٹی آف ٹیکساس سے دسمبر 2022 میں کمپیوٹر سائنس میں ماسٹرز آف سائنس کے ساتھ AI/ML پر توجہ مرکوز کرنے والے ذہین سسٹمز میں مہارت حاصل کی۔ وہ AI/ML کے بارے میں مزید جاننے میں دلچسپی رکھتی ہے اور AWS خدمات کو استعمال کرتے ہوئے ایسے حل تلاش کرتی ہے جن سے صارفین فائدہ اٹھا سکتے ہیں۔

میڈا آئیہ آسٹن، ٹیکساس میں مقیم AWS میں ایک ایسوسی ایٹ سلوشنز آرکیٹیکٹ ہے۔ اس نے حال ہی میں ڈلاس کی یونیورسٹی آف ٹیکساس سے دسمبر 2022 میں کمپیوٹر سائنس میں ماسٹرز آف سائنس کے ساتھ AI/ML پر توجہ مرکوز کرنے والے ذہین سسٹمز میں مہارت حاصل کی۔ وہ AI/ML کے بارے میں مزید جاننے میں دلچسپی رکھتی ہے اور AWS خدمات کو استعمال کرتے ہوئے ایسے حل تلاش کرتی ہے جن سے صارفین فائدہ اٹھا سکتے ہیں۔

ہیوگو تسے۔ سیٹل، واشنگٹن میں مقیم AWS میں ایک ایسوسی ایٹ سلوشنز آرکیٹیکٹ ہے۔ انہوں نے ایریزونا اسٹیٹ یونیورسٹی سے انفارمیشن ٹیکنالوجی میں ماسٹر ڈگری اور شکاگو یونیورسٹی سے اکنامکس میں بیچلر کی ڈگری حاصل کی۔ وہ انفارمیشن سسٹمز آڈٹ اینڈ کنٹرول ایسوسی ایشن (ISACA) اور انٹرنیشنل انفارمیشن سسٹم سیکیورٹی سرٹیفیکیشن کنسورشیم (ISC)2 کا رکن ہے۔ وہ صارفین کو ٹیکنالوجی سے فائدہ اٹھانے میں مدد کرتا ہے۔

ہیوگو تسے۔ سیٹل، واشنگٹن میں مقیم AWS میں ایک ایسوسی ایٹ سلوشنز آرکیٹیکٹ ہے۔ انہوں نے ایریزونا اسٹیٹ یونیورسٹی سے انفارمیشن ٹیکنالوجی میں ماسٹر ڈگری اور شکاگو یونیورسٹی سے اکنامکس میں بیچلر کی ڈگری حاصل کی۔ وہ انفارمیشن سسٹمز آڈٹ اینڈ کنٹرول ایسوسی ایشن (ISACA) اور انٹرنیشنل انفارمیشن سسٹم سیکیورٹی سرٹیفیکیشن کنسورشیم (ISC)2 کا رکن ہے۔ وہ صارفین کو ٹیکنالوجی سے فائدہ اٹھانے میں مدد کرتا ہے۔

ایمن عشموے ۔ سیٹل، واشنگٹن میں مقیم AWS میں ایک ایسوسی ایٹ سلوشنز آرکیٹیکٹ ہے۔ انہوں نے آکلینڈ یونیورسٹی سے سافٹ ویئر انجینئرنگ اور آئی ٹی میں ماسٹرز کی ڈگری حاصل کی۔ اس کے پاس سافٹ ویئر ڈویلپمنٹ کا سابقہ تجربہ ہے، خاص طور پر تقسیم شدہ ویب ایپلیکیشنز کے لیے مائیکرو سروسز بنانے کا۔ وہ بہترین طریقوں کے بعد AWS کلاؤڈ سروسز پر مضبوط اور قابل توسیع حل بنانے میں صارفین کی مدد کرنے کے بارے میں پرجوش ہے۔

ایمن عشموے ۔ سیٹل، واشنگٹن میں مقیم AWS میں ایک ایسوسی ایٹ سلوشنز آرکیٹیکٹ ہے۔ انہوں نے آکلینڈ یونیورسٹی سے سافٹ ویئر انجینئرنگ اور آئی ٹی میں ماسٹرز کی ڈگری حاصل کی۔ اس کے پاس سافٹ ویئر ڈویلپمنٹ کا سابقہ تجربہ ہے، خاص طور پر تقسیم شدہ ویب ایپلیکیشنز کے لیے مائیکرو سروسز بنانے کا۔ وہ بہترین طریقوں کے بعد AWS کلاؤڈ سروسز پر مضبوط اور قابل توسیع حل بنانے میں صارفین کی مدد کرنے کے بارے میں پرجوش ہے۔

شیروین سریش آسٹن، ٹیکساس میں مقیم AWS میں ایک ایسوسی ایٹ سلوشن آرکیٹیکٹ ہے۔ اس نے کلاؤڈ کمپیوٹنگ اور ورچوئلائزیشن میں ارتکاز کے ساتھ سافٹ ویئر انجینئرنگ میں ماسٹرز اور سان ہوزے اسٹیٹ یونیورسٹی سے کمپیوٹر انجینئرنگ میں بیچلر کے ساتھ گریجویشن کیا ہے۔ وہ تمام پس منظر سے تعلق رکھنے والے لوگوں کی زندگیوں کو بہتر بنانے میں مدد کرنے کے لیے ٹیکنالوجی کا فائدہ اٹھانے کا شوق رکھتا ہے۔

شیروین سریش آسٹن، ٹیکساس میں مقیم AWS میں ایک ایسوسی ایٹ سلوشن آرکیٹیکٹ ہے۔ اس نے کلاؤڈ کمپیوٹنگ اور ورچوئلائزیشن میں ارتکاز کے ساتھ سافٹ ویئر انجینئرنگ میں ماسٹرز اور سان ہوزے اسٹیٹ یونیورسٹی سے کمپیوٹر انجینئرنگ میں بیچلر کے ساتھ گریجویشن کیا ہے۔ وہ تمام پس منظر سے تعلق رکھنے والے لوگوں کی زندگیوں کو بہتر بنانے میں مدد کرنے کے لیے ٹیکنالوجی کا فائدہ اٹھانے کا شوق رکھتا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ آٹوموٹو / ای وی، کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- چارٹ پرائم۔ ChartPrime کے ساتھ اپنے ٹریڈنگ گیم کو بلند کریں۔ یہاں تک رسائی حاصل کریں۔

- بلاک آفسیٹس۔ ماحولیاتی آفسیٹ ملکیت کو جدید بنانا۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- : ہے

- : ہے

- : نہیں

- :کہاں

- $UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- قابلیت

- ہمارے بارے میں

- قبول کریں

- تک رسائی حاصل

- تک رسائی حاصل

- اکاؤنٹس

- درست

- درست طریقے سے

- اعمال

- فعال

- شامل کریں

- اس کے علاوہ

- پتے

- خطاب کرتے ہوئے

- منتظمین

- اپنانے

- مشیر

- کے بعد

- ایجنٹ

- ایجنٹ

- مجموعی

- AI

- AI خدمات

- AI / ML

- تمام

- کی اجازت دیتا ہے

- ساتھ

- بھی

- متبادل

- ایمیزون

- ایمیزون API گیٹ وے

- ایمیزون کاگنیٹو

- ایمیزون کی تعریف

- ایمیزون کیندر

- ایمیزون سیج میکر

- ایمیزون سیج میکر جمپ اسٹارٹ

- ایمیزون ویب سروسز

- رقم

- مقدار

- an

- تجزیہ کار کہتے ہیں

- تجزیہ کرتا ہے

- اور

- جواب

- جواب

- کوئی بھی

- اے پی آئی

- واضح

- درخواست

- ایپلی کیشنز

- تقرری

- نقطہ نظر

- منظور

- فن تعمیر

- کیا

- اٹھتا

- ایریزونا

- ارد گرد

- مضمون

- مصنوعی

- مصنوعی ذہانت

- مصنوعی انٹیلی جنس (AI)

- آرٹ ورکس

- AS

- پوچھنا

- پہلوؤں

- تشخیص کریں

- مدد

- اسسٹنس

- ایسوسی ایٹ

- منسلک

- ایسوسی ایشن

- مفروضہ

- At

- آڈٹ

- اضافہ

- آسٹن، ٹیکساس

- تصدیق شدہ

- کی توثیق

- اجازت

- خود کار طریقے سے

- خود کار طریقے سے

- دستیابی

- دستیاب

- AWS

- او ڈبلیو ایس لامبڈا۔

- واپس

- پس منظر

- بیس

- کی بنیاد پر

- BE

- صبر

- کیونکہ

- بن

- ہو جاتا ہے

- رہا

- اس سے پہلے

- کی طرف سے

- پیچھے

- فائدہ

- فوائد

- BEST

- بہترین طریقوں

- بہتر

- بلاگ

- کتاب

- بوٹ

- دونوں

- خودکار صارف دکھا ئیں

- پایان

- برانڈ

- بجٹ

- تعمیر

- عمارت

- تعمیر

- کاروبار

- کاروبار

- لیکن

- by

- فون

- کر سکتے ہیں

- صلاحیتوں

- کیریئر کے

- احتیاط سے

- کیس

- مقدمات

- قسم

- وجہ

- سینٹر

- مرکزی

- کچھ

- تصدیق

- چین

- چیلنجوں

- تبدیل

- الزام عائد کیا

- چیٹ بٹ

- جانچ پڑتال

- چیک

- شکاگو

- دعوے

- واضح

- کلینکل

- طبی ٹیسٹ

- بادل

- کلاؤڈ کمپیوٹنگ

- بادل کی خدمات

- جمع

- مجموعہ

- تجارتی طور پر

- کامن

- مواصلات

- کمپنیاں

- کمپنی کے

- کمپنی کی

- مقابلہ

- مکمل

- مکمل کرنا

- پیچیدہ

- پیچیدگی

- عمل

- سمجھو

- کمپیوٹر

- کمپیوٹر انجینئرنگ

- کمپیوٹر سائنس

- کمپیوٹنگ

- دھیان

- تصور

- جامع

- منعقد

- سنگم

- رابطہ قائم کریں

- جڑتا

- غور

- خیالات

- سمجھا

- متواتر

- پر مشتمل ہے

- کنسول

- کنسرجیم

- بسم

- کھپت

- رابطہ کریں

- رابطہ مرکز

- پر مشتمل ہے

- مواد

- سیاق و سباق

- مسلسل

- معاون

- کنٹرول

- کنٹرولنگ

- سہولت

- بات چیت

- سنوادی

- مکالمات

- کارپوریٹ

- درست

- قیمت

- اخراجات

- کرالر

- تخلیق

- قدر بنائیں

- بنائی

- تخلیق

- کریڈٹ

- معیار

- اہم

- CRM

- اہم

- cured

- موجودہ

- اس وقت

- گاہک

- گاہک کی مصروفیت

- گاہک کا تجربہ

- کسٹمر سروس

- کسٹمر سپورٹ

- گاہکوں

- روزانہ

- ڈلاس

- اعداد و شمار

- ڈیٹا پوائنٹس

- ڈیٹا سیٹ

- ڈیٹا بیس

- تاریخ

- دسمبر

- فیصلہ کرنا

- فیصلہ

- فیصلہ کرنا

- فیصلے

- ڈگری

- ڈیلیور

- منحصر ہے

- تعینات

- تعینات

- بیان

- ڈیزائن

- کے باوجود

- تفصیلات

- پتہ چلا

- کھوج

- ڈیولپر

- ترقی

- رفت

- مختلف

- مشکل

- دریافت

- تقسیم کئے

- دستاویزات

- دستاویزات

- کرتا

- نہیں کرتا

- ڈرائیو

- مدت

- e

- آسان

- آسانی سے

- معاشیات

- ماحول

- ایڈیشن

- کارکردگی

- کوشش

- یا تو

- اہلیت

- ای میل

- ای میل

- ملازم

- ملازمین

- کے قابل بناتا ہے

- حوصلہ افزائی

- اختتام پوائنٹ

- توانائی

- مصروفیت

- انجن

- انجنیئرنگ

- افزودہ

- کو یقینی بنانے کے

- یقینی بناتا ہے

- کو یقینی بنانے ہے

- انٹرپرائز

- اداروں

- اداروں

- نقائص

- اضافہ

- تخمینہ

- وغیرہ

- بھی

- مثال کے طور پر

- عملدرآمد

- موجودہ

- مہنگی

- تجربہ

- وضاحت

- بیان کرتا ہے

- نکالنے

- نچوڑ۔

- چہرہ

- خاندان

- نمایاں کریں

- فیڈ

- کم

- اعداد و شمار

- فائل

- بھرنے

- بھرے

- بھرنے

- فلٹر

- مالی

- مالیاتی ڈیٹا

- مالی تاریخ

- مالیاتی ادارے

- فنانسنگ

- مل

- تلاش

- پہلا

- لچک

- بہاؤ

- توجہ مرکوز

- کے بعد

- کے لئے

- فارم

- فارم

- فورمز

- ملا

- فاؤنڈیشن

- فریم ورک

- مفت

- دوست

- سے

- مزہ

- تقریب

- افعال

- مزید

- حاصل کرنا

- گیٹ وے

- پیدا

- نسل

- پیداواری

- پیداواری AI۔

- حاصل

- دی

- فراہم کرتا ہے

- دے

- گوگل

- حکومت

- بہت

- بڑھائیں

- بڑھتے ہوئے

- بڑھتا ہے

- رہنمائی

- ہدایات

- ہینڈل

- ہینڈل

- ہینڈلنگ

- ہے

- ہونے

- he

- صحت

- صحت سے متعلق معلومات

- صحت کی دیکھ بھال

- مدد

- مدد

- مدد کرتا ہے

- اس کی

- ہائی

- انتہائی

- ان

- تاریخ

- کی ڈگری حاصل کی

- میزبانی کی

- میزبان

- HOURS

- کس طرح

- کیسے

- تاہم

- hr

- HTML

- HTTPS

- انسانی

- i

- شناخت

- شناخت کار

- شناخت

- شناخت

- کی نشاندہی

- شناختی

- if

- وضاحت کرتا ہے

- پر عملدرآمد

- پر عمل درآمد

- اثرات

- کو بہتر بنانے کے

- بہتر ہے

- کو بہتر بنانے کے

- in

- میں گہرائی

- غلط

- شامل

- شامل ہیں

- سمیت

- انکم

- انکم ٹیکس

- اضافہ

- اضافہ

- انڈکس

- انڈیکس شدہ

- انڈیکس

- افراد

- صنعتوں

- مطلع

- معلومات

- انفارمیشن سسٹمز

- انفارمیشن ٹیکنالوجی

- مطلع

- وراثت

- ان پٹ

- مثال کے طور پر

- فوری

- کے بجائے

- انسٹی

- اداروں

- انشورنس

- ضم

- انٹیگریٹٹس

- انضمام

- انٹیلی جنس

- انٹیلجنٹ

- ارادے

- بات چیت

- انٹرایکٹو

- دلچسپی

- انٹرفیس

- اندرونی

- بین الاقوامی سطح پر

- میں

- سرمایہ کاری

- مسئلہ

- IT

- اشیاء

- سفر

- فوٹو

- رکھیں

- علم

- جانا جاتا ہے

- زبان

- بڑے

- پرت

- قیادت

- جانیں

- سیکھنے

- کم

- سطح

- لیورنگنگ

- لائبریری

- حد کے

- حدود

- لائن

- زندگی

- ایل ایل ایم

- قرض

- قرض

- لاگ ان کریں

- منطقی

- لانگ

- طویل وقت

- اب

- دیکھو

- بہت

- سے محبت کرتا ہے

- کم قیمت

- کم

- وفاداری

- وفاداری

- مشین

- مشین لرننگ

- بنا

- برقرار رکھنے کے

- بنا

- بناتا ہے

- بنانا

- انتظام

- انتظام

- انداز

- دستی

- دستی طور پر

- بہت سے

- مارکیٹ

- مارکیٹ کی تحقیق

- ماسٹر کی

- مئی..

- کا مطلب ہے کہ

- طبی

- رکن

- یاد داشت

- مائکروسافٹ

- مائیکروسافٹ

- دس لاکھ

- لاکھوں

- برا

- ML

- ماڈل

- ماڈل

- ماڈیول

- مہینہ

- ماہانہ

- زیادہ

- سب سے زیادہ

- ایک سے زیادہ

- مقامی

- ضروری

- ضرورت ہے

- ضرورت

- ضروریات

- نئی

- اگلے

- ویزا

- نوٹیفیکیشن

- تعداد

- آکلینڈ

- اوہ

- of

- تجویز

- اکثر

- تیل

- on

- جہاز

- ایک بار

- ایک

- جاری

- صرف

- کھول

- کام

- کام

- آپریشنل

- مواقع

- اصلاح کے

- اختیار

- آپشنز کے بھی

- or

- حکم

- تنظیمیں

- اصل

- دیگر

- ہمارے

- باہر

- خاکہ

- باہر

- پر

- پیرا میٹر

- حصہ

- حصے

- منظور

- جذباتی

- مریض

- ادا

- لوگ

- فی

- کارکردگی

- اجازتیں

- ذاتی

- ذاتی مواد

- ذاتی طور پر

- دواسازی کی

- ستون

- منصوبہ

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- مہربانی کرکے

- پوائنٹ

- پوائنٹس

- پالیسیاں

- پول

- پورٹل

- پورٹریٹس

- امکانات

- امکان

- پوسٹ

- طاقت

- طریقوں

- حال (-)

- کی روک تھام

- پچھلا

- پہلے

- قیمتوں کا تعین

- قیمتوں کا تعین کرنے والا ماڈل

- پہلے

- ترجیح

- کی رازداری

- مسائل

- طریقہ کار

- آگے بڑھو

- عمل

- عملدرآمد

- عمل

- پروسیسنگ

- پیداوار

- پیداوری

- حاصل

- پیشہ ورانہ

- پیشہ ور ماہرین

- جائیداد

- فراہم

- فراہم

- فراہم کرنے والے

- فراہم کرنے

- شائع

- خریدا

- سوال و جواب

- قابلیت

- کوالیفائنگ

- سوالات

- سوال

- سوالات

- فوری

- جلدی سے

- رینج

- شرح

- پڑھیں

- پڑھنا

- اصل وقت

- حال ہی میں

- حال ہی میں

- کو کم

- کم

- کا حوالہ دیتے ہیں

- حوالہ دینا۔

- کے بارے میں

- باقاعدگی سے

- ضابطے

- تعلقات

- مطابقت

- متعلقہ

- انحصار کرو

- باقی

- یاد

- ہٹا

- درخواست

- درخواستوں

- کی ضرورت

- ضرورت

- ضروریات

- تحقیق

- محققین

- قرارداد

- کے حل

- وسائل

- جواب

- جوابات

- ذمہ داری

- باقی

- نتیجہ

- واپس لوٹنے

- -جائزہ لیا

- ٹھیک ہے

- خطرات

- مضبوط

- روٹ

- چل رہا ہے

- s

- sagemaker

- فروخت

- سان

- سان جوس

- کی اطمینان

- محفوظ کریں

- توسیع پذیر

- پیمانے

- منظر نامے

- سائنس

- سکور

- سکرپٹ

- تلاش کریں

- تلاش

- سیٹل

- دوسری

- سیکنڈ

- سیکشن

- محفوظ بنانے

- محفوظ طریقے سے

- سیکورٹی

- فروخت

- بھیجنے

- سینئر

- حساس

- بھیجا

- بے سرور

- کام کرتا ہے

- سروس

- سروسز

- مقرر

- سیٹ

- ترتیبات

- کئی

- وہ

- منتقل

- مختصریاں

- ہونا چاہئے

- ظاہر ہوا

- سے ظاہر ہوا

- دکھایا گیا

- silos کے

- اسی طرح

- سادہ

- آسان بنانے

- بعد

- ایک

- سائز

- چھوٹے

- So

- سماجی

- سافٹ ویئر کی

- سوفٹ ویئر کی نشوونما

- سافٹ ویئر انجینئرنگ

- حل

- حل

- کچھ

- ماخذ

- ذرائع

- مہارت

- مخصوص

- خاص طور پر

- خرچ

- خرچ کرنا۔

- معیار

- حالت

- درجہ

- رہنا

- مرحلہ

- مراحل

- ابھی تک

- ذخیرہ

- ذخیرہ

- ذخیرہ

- ذخیرہ کرنے

- کشیدگی

- بھرنے

- کافی

- اس طرح

- مشورہ

- مختصر

- حمایت

- کے نظام

- سسٹمز

- ٹیبل

- لیتا ہے

- کاموں

- ٹیکس

- ٹیم

- ٹیموں

- ٹیکنالوجی

- شرائط

- ٹیکساس

- متن

- متنی

- کہ

- ۔

- کے بارے میں معلومات

- ان

- خود

- تو

- وہاں.

- یہ

- وہ

- تیسری پارٹی

- اس

- کے ذریعے

- ٹکٹ

- ٹکٹنگ

- درجے

- وقت

- وقت لگتا

- بروقت

- اوقات

- ٹائمسٹیمپ

- ٹائٹین

- کرنے کے لئے

- آج

- ٹوکن

- کے آلے

- اوزار

- Traceability

- روایتی طور پر

- تربیت یافتہ

- ٹریننگ

- ٹرانسفارمر

- شفافیت

- علاج

- مقدمے کی سماعت

- ٹرائلز

- سبق

- اقسام

- قابل نہیں

- سمجھ

- افہام و تفہیم

- منفرد

- یونیورسٹیاں

- یونیورسٹی

- شکاگو یونیورسٹی

- اپ ڈیٹ کرنے کے لئے

- اپ ڈیٹ

- اپ ڈیٹ

- استعمال کی شرائط

- استعمال کیس

- استعمال کیا جاتا ہے

- رکن کا

- صارفین

- استعمال

- کا استعمال کرتے ہوئے

- استعمال

- استعمال کیا

- استعمال کرنا۔

- قیمت

- مختلف

- توثیق

- اس بات کی تصدیق

- عمودی

- کی طرف سے

- ویڈیو

- ویڈیوز

- وائس

- انتظار

- انتظار کر رہا ہے

- تھا

- واشنگٹن

- طریقوں

- we

- ویب

- ویب ایپلی کیشن

- ویب ایپلی کیشنز

- ویب خدمات

- اچھا ہے

- تھے

- کیا

- جب

- چاہے

- جس

- جبکہ

- ڈبلیو

- وسیع

- وسیع رینج

- ساتھ

- کے اندر

- کام

- کام کا بہاؤ

- کام کر

- گا

- لکھا

- سال

- تم

- اور

- زیفیرنیٹ