بڑے لینگویج ماڈلز (LLMs) نے نیچرل لینگوئج پروسیسنگ (NLP) کے میدان میں انقلاب برپا کر دیا ہے، زبان کے ترجمہ، متن کا خلاصہ، اور جذباتی تجزیہ جیسے کاموں کو بہتر بنایا ہے۔ تاہم، جیسا کہ یہ ماڈل سائز اور پیچیدگی میں بڑھتے رہتے ہیں، ان کی کارکردگی اور رویے کی نگرانی کرنا مشکل ہوتا جا رہا ہے۔

LLMs کی کارکردگی اور رویے کی نگرانی ان کی حفاظت اور تاثیر کو یقینی بنانے کے لیے ایک اہم کام ہے۔ ہمارا مجوزہ فن تعمیر آن لائن LLM مانیٹرنگ کے لیے ایک قابل توسیع اور حسب ضرورت حل فراہم کرتا ہے، جو ٹیموں کو آپ کے مانیٹرنگ کے حل کو آپ کے مخصوص استعمال کے معاملات اور ضروریات کے مطابق بنانے کے قابل بناتا ہے۔ AWS سروسز کا استعمال کرتے ہوئے، ہمارا فن تعمیر LLM رویے میں حقیقی وقت کی نمائش فراہم کرتا ہے اور ٹیموں کو کسی بھی مسائل یا بے ضابطگیوں کی فوری شناخت اور ان کو حل کرنے کے قابل بناتا ہے۔

اس پوسٹ میں، ہم آن لائن LLM مانیٹرنگ کے لیے چند میٹرکس کا مظاہرہ کرتے ہیں اور AWS سروسز کے استعمال کے لیے ان کے متعلقہ فن تعمیر ایمیزون کلاؤڈ واچ اور او ڈبلیو ایس لامبڈا۔. یہ ایک حسب ضرورت حل پیش کرتا ہے جس کے ساتھ ممکن ہے۔ ماڈل کی تشخیص کے ساتھ ملازمتیں ایمیزون بیڈرک.

حل کا جائزہ

غور کرنے والی پہلی چیز یہ ہے کہ مختلف میٹرکس کو مختلف حسابی غور و فکر کی ضرورت ہوتی ہے۔ ایک ماڈیولر آرکیٹیکچر، جہاں ہر ماڈیول ماڈل انفرنس ڈیٹا لے سکتا ہے اور اپنی میٹرکس تیار کر سکتا ہے، ضروری ہے۔

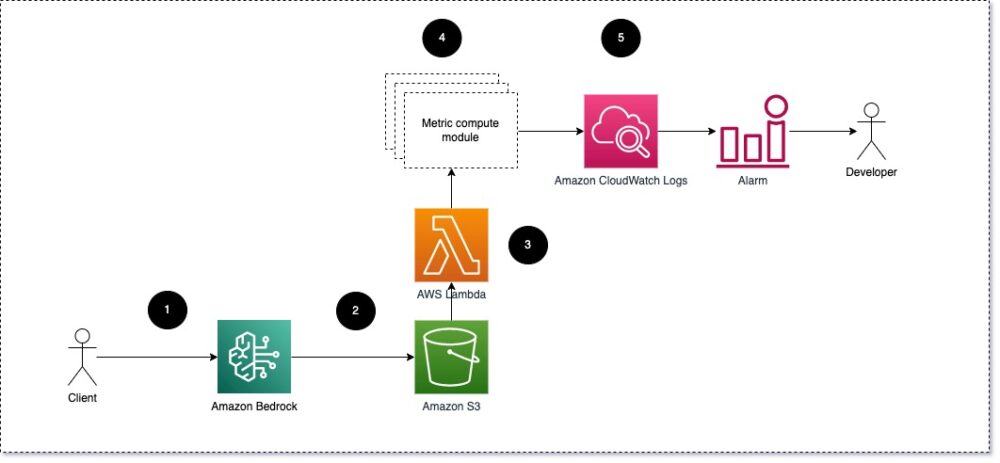

ہم تجویز کرتے ہیں کہ ہر ماڈیول آنے والی تخمینہ درخواستیں LLM کو لے، میٹرک کمپیوٹ ماڈیولز میں فوری اور تکمیل (جواب) کے جوڑے پاس کرے۔ ہر ماڈیول ان پٹ پرامپٹ اور تکمیل (جواب) کے حوالے سے اپنے میٹرکس کی گنتی کے لیے ذمہ دار ہے۔ یہ میٹرکس CloudWatch کو بھیجے جاتے ہیں، جو انہیں اکٹھا کر سکتے ہیں اور CloudWatch الارم کے ساتھ مخصوص حالات پر اطلاعات بھیجنے کے لیے کام کر سکتے ہیں۔ مندرجہ ذیل خاکہ اس فن تعمیر کو واضح کرتا ہے۔

تصویر 1: میٹرک کمپیوٹ ماڈیول - حل کا جائزہ

ورک فلو میں درج ذیل مراحل شامل ہیں:

- ایک صارف درخواست یا صارف انٹرفیس کے حصے کے طور پر Amazon Bedrock سے درخواست کرتا ہے۔

- ایمیزون بیڈرک درخواست اور تکمیل (جواب) کو محفوظ کرتا ہے۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3) کی ترتیب کے مطابق درخواست لاگنگ.

- ایمیزون ایس 3 پر محفوظ کردہ فائل ایک ایونٹ بناتی ہے۔ ٹرگر ایک لیمبڈا فنکشن۔ فنکشن ماڈیولز کو طلب کرتا ہے۔

- ماڈیول اپنے متعلقہ میٹرکس پر پوسٹ کرتے ہیں۔ کلاؤڈ واچ میٹرکس.

- الارم غیر متوقع میٹرک اقدار کی ترقی ٹیم کو مطلع کر سکتا ہے۔

ایل ایل ایم مانیٹرنگ کو لاگو کرتے وقت غور کرنے والی دوسری چیز ٹریک کرنے کے لیے صحیح میٹرکس کا انتخاب کرنا ہے۔ اگرچہ بہت سے ممکنہ میٹرکس ہیں جنہیں آپ LLM کی کارکردگی کی نگرانی کے لیے استعمال کر سکتے ہیں، ہم اس پوسٹ میں کچھ وسیع ترین میٹرکس کی وضاحت کرتے ہیں۔

مندرجہ ذیل حصوں میں، ہم چند متعلقہ ماڈیول میٹرکس اور ان کے متعلقہ میٹرک کمپیوٹ ماڈیول فن تعمیر کو نمایاں کرتے ہیں۔

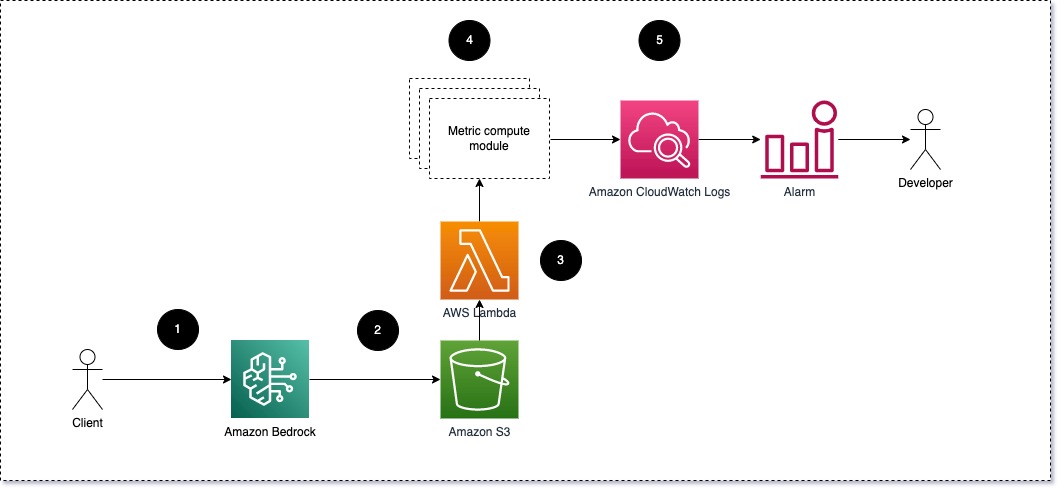

فوری اور تکمیل کے درمیان معنوی مماثلت (جواب)

LLMs چلاتے وقت، آپ ہر درخواست کے لیے پرامپٹ اور تکمیل (جواب) کو روک سکتے ہیں اور ایمبیڈنگ ماڈل کا استعمال کرتے ہوئے انہیں ایمبیڈنگز میں تبدیل کر سکتے ہیں۔ ایمبیڈنگز اعلی جہتی ویکٹر ہیں جو متن کے معنوی معنی کی نمائندگی کرتے ہیں۔ ایمیزون ٹائٹن Titan Embeddings کے ذریعے ایسے ماڈل فراہم کرتا ہے۔ ان دو ویکٹروں کے درمیان کوزائن جیسا فاصلہ لے کر، آپ یہ اندازہ لگا سکتے ہیں کہ پرامپٹ اور تکمیل (جواب) کتنی مماثلت رکھتے ہیں۔ آپ استعمال کر سکتے ہیں سائنس پائی۔ or سائنٹ سیکھنا ویکٹروں کے درمیان کوسائن فاصلے کی گنتی کرنے کے لیے۔ درج ذیل خاکہ اس میٹرک کمپیوٹ ماڈیول کے فن تعمیر کو واضح کرتا ہے۔

تصویر 2: میٹرک کمپیوٹ ماڈیول - معنوی مماثلت

اس ورک فلو میں درج ذیل کلیدی اقدامات شامل ہیں:

- ایک لیمبڈا فنکشن کے ذریعے ایک سلسلہ بند پیغام موصول ہوتا ہے۔ ایمیزون کنیسیس ایک فوری اور تکمیل (جواب) جوڑی پر مشتمل ہے۔

- فنکشن کو پرامپٹ اور تکمیل (جواب) دونوں کے لیے سرایت ملتی ہے، اور دو ویکٹرز کے درمیان کوسائن فاصلے کی گنتی کرتا ہے۔

- فنکشن اس معلومات کو CloudWatch میٹرکس کو بھیجتا ہے۔

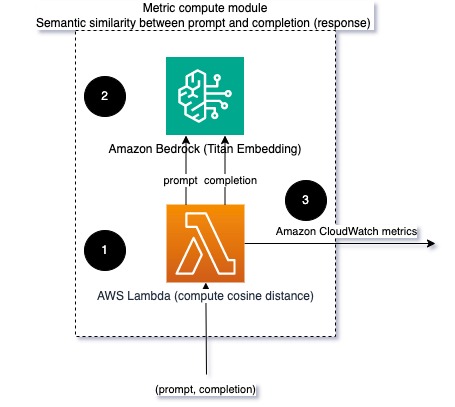

جذبات اور زہریلا

جذبات کی نگرانی آپ کو جوابات کے مجموعی لہجے اور جذباتی اثر کا اندازہ لگانے کی اجازت دیتی ہے، جبکہ زہریلا تجزیہ LLM آؤٹ پٹس میں جارحانہ، بے عزتی، یا نقصان دہ زبان کی موجودگی کا ایک اہم پیمانہ فراہم کرتا ہے۔ جذبات میں کسی بھی تبدیلی یا زہریلے پن پر کڑی نظر رکھی جانی چاہیے تاکہ یہ یقینی بنایا جا سکے کہ ماڈل توقع کے مطابق برتاؤ کر رہا ہے۔ درج ذیل خاکہ میٹرک کمپیوٹ ماڈیول کی وضاحت کرتا ہے۔

تصویر 3: میٹرک کمپیوٹ ماڈیول - جذبات اور زہریلا

ورک فلو میں درج ذیل مراحل شامل ہیں:

- ایک لیمبڈا فنکشن Amazon Kinesis کے ذریعے فوری اور تکمیل (جواب) جوڑا حاصل کرتا ہے۔

- AWS اسٹیپ فنکشنز آرکیسٹریشن کے ذریعے، فنکشن کال کرتا ہے۔ ایمیزون کی تعریف کا پتہ لگانے کے لیے جذبات اور زہریلا.

- فنکشن معلومات کو کلاؤڈ واچ میٹرکس میں محفوظ کرتا ہے۔

Amazon Comprehend کے ساتھ جذبات اور زہریلے پن کا پتہ لگانے کے بارے میں مزید معلومات کے لیے رجوع کریں۔ ایک مضبوط ٹیکسٹ پر مبنی زہریلا پیشن گو بنائیں اور Amazon Comprehend toxicity detection کا استعمال کرتے ہوئے نقصان دہ مواد کو نشان زد کریں۔.

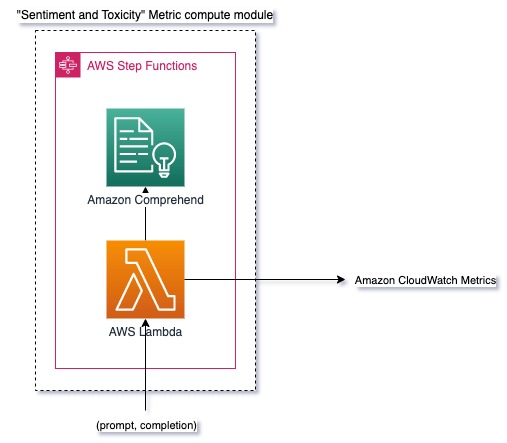

انکار کا تناسب

انکار میں اضافہ، جیسے کہ جب LLM معلومات کی کمی کی وجہ سے تکمیل سے انکار کرتا ہے، اس کا مطلب یہ ہو سکتا ہے کہ یا تو بدنیتی پر مبنی صارفین LLM کو ان طریقوں سے استعمال کرنے کی کوشش کر رہے ہیں جن کا مقصد اسے جیل بریک کرنا ہے، یا یہ کہ صارفین کی توقعات پوری نہیں ہو رہی ہیں اور وہ کم قیمت کے جوابات مل رہے ہیں۔ یہ کتنی بار ہو رہا ہے اس کا اندازہ لگانے کا ایک طریقہ یہ ہے کہ LLM ماڈل کے معیاری انکار کا LLM کے حقیقی جوابات کے ساتھ موازنہ کریں۔ مثال کے طور پر، Anthropic کے Claude v2 LLM کے کچھ عام انکاری جملے درج ذیل ہیں:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

اشارے کے ایک مقررہ سیٹ پر، ان انکار میں اضافہ اس بات کا اشارہ ہو سکتا ہے کہ ماڈل حد سے زیادہ محتاط یا حساس ہو گیا ہے۔ الٹا کیس کا بھی جائزہ لینا چاہیے۔ یہ اس بات کا اشارہ ہو سکتا ہے کہ ماڈل اب زہریلی یا نقصان دہ گفتگو میں مشغول ہونے کا زیادہ شکار ہے۔

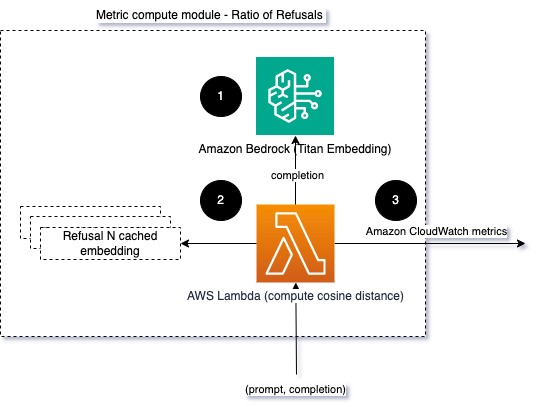

ماڈل کی سالمیت اور ماڈل انکار کے تناسب میں مدد کرنے کے لیے، ہم جواب کا موازنہ LLM کے معروف انکاری فقروں کے سیٹ سے کر سکتے ہیں۔ یہ ایک حقیقی درجہ بندی ہو سکتا ہے جو وضاحت کر سکتا ہے کہ ماڈل نے درخواست سے انکار کیوں کیا۔ جس ماڈل کی نگرانی کی جا رہی ہے اس سے آپ ردعمل اور معروف انکاری ردعمل کے درمیان کوزائن فاصلہ لے سکتے ہیں۔ درج ذیل خاکہ اس میٹرک کمپیوٹ ماڈیول کی وضاحت کرتا ہے۔

تصویر 4: میٹرک کمپیوٹ ماڈیول - انکار کا تناسب

ورک فلو مندرجہ ذیل مراحل پر مشتمل ہے:

- ایک لیمبڈا فنکشن فوری اور تکمیل (جواب) وصول کرتا ہے اور ایمیزون ٹائٹن کا استعمال کرتے ہوئے جواب سے سرایت حاصل کرتا ہے۔

- فنکشن میموری میں کیش شدہ ردعمل اور موجودہ انکار پرامپٹس کے درمیان کوزائن یا یوکلیڈین فاصلے کی گنتی کرتا ہے۔

- فنکشن اس اوسط کو CloudWatch میٹرکس کو بھیجتا ہے۔

دوسرا اختیار استعمال کرنا ہے مبہم ملاپ LLM آؤٹ پٹ سے معروف انکار کا موازنہ کرنے کے لیے ایک سیدھا لیکن کم طاقتور نقطہ نظر۔ سے رجوع کریں۔ ازگر دستاویزات مثال کے طور پر

خلاصہ

LLM کے قابل اعتماد اور قابل اعتماد استعمال کو یقینی بنانے کے لیے LLM مشاہدہ ایک اہم مشق ہے۔ نگرانی، سمجھنا، اور LLMs کی درستگی اور وشوسنییتا کو یقینی بنانے سے آپ کو ان AI ماڈلز سے وابستہ خطرات کو کم کرنے میں مدد مل سکتی ہے۔ فریب کاری، خراب تکمیلات (جوابات) اور اشارے کی نگرانی کرکے، آپ اس بات کو یقینی بنا سکتے ہیں کہ آپ کا LLM ٹریک پر رہے اور وہ قیمت فراہم کرے جس کی آپ اور آپ کے صارفین تلاش کر رہے ہیں۔ اس پوسٹ میں، ہم نے مثالیں دکھانے کے لیے چند میٹرکس پر بات کی۔

فاؤنڈیشن ماڈلز کا جائزہ لینے کے بارے میں مزید معلومات کے لیے رجوع کریں۔ فاؤنڈیشن ماڈلز کا جائزہ لینے کے لیے SageMaker Clarify کا استعمال کریں۔، اور اضافی براؤز کریں۔ مثال کے طور پر نوٹ بک ہمارے GitHub ذخیرہ میں دستیاب ہے۔ آپ LLM کی تشخیص کو پیمانے پر چلانے کے طریقے بھی تلاش کر سکتے ہیں۔ ایمیزون سیج میکر کلیریفائی اور ایم ایل او پی سروسز کا استعمال کرتے ہوئے پیمانے پر ایل ایل ایم کی تشخیص کو فعال بنائیں. آخر میں، ہم حوالہ دیتے ہیں معیار اور ذمہ داری کے لیے بڑے زبان کے ماڈلز کا جائزہ لیں۔ LLMs کا جائزہ لینے کے بارے میں مزید جاننے کے لیے۔

مصنفین کے بارے میں

برونو کلین AWS Professional Services Analytics پریکٹس کے ساتھ ایک سینئر مشین لرننگ انجینئر ہے۔ وہ صارفین کو بڑے ڈیٹا اور تجزیاتی حل کو لاگو کرنے میں مدد کرتا ہے۔ کام سے باہر، وہ خاندان کے ساتھ وقت گزارنے، سفر کرنے اور نئے کھانے کی کوشش کرنے سے لطف اندوز ہوتا ہے۔

برونو کلین AWS Professional Services Analytics پریکٹس کے ساتھ ایک سینئر مشین لرننگ انجینئر ہے۔ وہ صارفین کو بڑے ڈیٹا اور تجزیاتی حل کو لاگو کرنے میں مدد کرتا ہے۔ کام سے باہر، وہ خاندان کے ساتھ وقت گزارنے، سفر کرنے اور نئے کھانے کی کوشش کرنے سے لطف اندوز ہوتا ہے۔

رشبھ لوکھنڈے AWS Professional Services Analytics پریکٹس کے ساتھ ایک سینئر ڈیٹا اور ML انجینئر ہے۔ وہ صارفین کو بڑے ڈیٹا، مشین لرننگ، اور تجزیاتی حل کو لاگو کرنے میں مدد کرتا ہے۔ کام سے باہر، وہ خاندان کے ساتھ وقت گزارنے، پڑھنے، دوڑنا، اور گولف کھیلنے سے لطف اندوز ہوتا ہے۔

رشبھ لوکھنڈے AWS Professional Services Analytics پریکٹس کے ساتھ ایک سینئر ڈیٹا اور ML انجینئر ہے۔ وہ صارفین کو بڑے ڈیٹا، مشین لرننگ، اور تجزیاتی حل کو لاگو کرنے میں مدد کرتا ہے۔ کام سے باہر، وہ خاندان کے ساتھ وقت گزارنے، پڑھنے، دوڑنا، اور گولف کھیلنے سے لطف اندوز ہوتا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- : ہے

- : ہے

- : نہیں

- :کہاں

- 1

- 100

- 143

- 32

- 455

- 7

- a

- ہمارے بارے میں

- درستگی

- اصل

- ایڈیشنل

- پتہ

- مجموعی

- AI

- اے آئی اسسٹنٹ

- اے آئی ماڈلز

- کی اجازت دیتا ہے

- بھی

- اگرچہ

- am

- ایمیزون

- ایمیزون کی تعریف

- ایمیزون کنیسیس

- ایمیزون سیج میکر

- ایمیزون ویب سروسز

- an

- تجزیہ

- تجزیاتی

- اور

- اسامانیتاوں

- بشری

- کوئی بھی

- درخواست

- نقطہ نظر

- نقطہ نظر

- فن تعمیر

- کیا

- AS

- اسسٹنٹ

- منسلک

- At

- دستیاب

- اوسط

- AWS

- AWS پروفیشنل سروسز

- AWS اسٹیپ فنکشنز

- برا

- BE

- بن

- رویے

- کیا جا رہا ہے

- کے درمیان

- سے پرے

- بگ

- بگ ڈیٹا

- دونوں

- لیکن

- by

- کالز

- کر سکتے ہیں

- نہیں کر سکتے ہیں

- کیس

- مقدمات

- محتاط

- چیلنج

- منتخب کریں

- درجہ بندی

- قریب سے

- کامن

- موازنہ

- موازنہ

- تکمیل

- پیچیدگی

- سمجھو

- حساب

- کمپیوٹنگ

- کمپیوٹنگ

- حالات

- ترتیب

- غور کریں

- خیالات

- مشتمل

- مواد

- سیاق و سباق

- جاری

- مکالمات

- سکتا ہے

- بنائی

- پیدا

- اہم

- گاہکوں

- مرضی کے مطابق

- اعداد و شمار

- فراہم کرتا ہے

- مظاہرہ

- کا پتہ لگانے کے

- ترقی

- ترقیاتی ٹیم

- آریھ

- مختلف

- بات چیت

- فاصلے

- do

- دو

- ہر ایک

- تاثیر

- یا تو

- سرایت کرنا

- کے قابل بناتا ہے

- کو فعال کرنا

- مشغول

- انجینئر

- کافی

- کو یقینی بنانے کے

- کو یقینی بنانے ہے

- اندازہ

- اندازہ

- کا جائزہ لینے

- تشخیص

- اندازہ

- واقعہ

- مثال کے طور پر

- مثال کے طور پر

- موجودہ

- توقعات

- توقع

- وضاحت

- تلاش

- خاندان

- چند

- میدان

- انجیر

- فائل

- آخر

- پہلا

- مقرر

- کے بعد

- کھانا

- کے لئے

- فاؤنڈیشن

- سے

- تقریب

- افعال

- گیج

- ملتا

- حاصل کرنے

- GitHub کے

- گالف

- بڑھائیں

- ہو رہا ہے۔

- نقصان دہ

- ہے

- he

- مدد

- مدد گار

- مدد کرتا ہے

- نمایاں کریں

- ایماندار

- کس طرح

- تاہم

- HTML

- HTTP

- HTTPS

- i

- شناخت

- وضاحت کرتا ہے

- اثر

- پر عملدرآمد

- پر عمل درآمد

- اہم

- کو بہتر بنانے کے

- in

- شامل ہیں

- موصولہ

- اضافہ

- دن بدن

- معلومات

- ان پٹ

- سالمیت

- ارادہ

- انٹرفیس

- میں

- الٹا

- پکارتے ہیں۔

- مسائل

- IT

- میں

- باگنی

- نوکریاں

- فوٹو

- کلیدی

- جانا جاتا ہے

- نہیں

- زبان

- بڑے

- جانیں

- سیکھنے

- کم

- ایل ایل ایم

- تلاش

- مشین

- مشین لرننگ

- بنا

- بناتا ہے

- بدقسمتی سے

- بہت سے

- مطلب

- مطلب

- پیمائش

- یاد داشت

- پیغام

- کے ساتھ

- میٹرک۔

- پیمائش کا معیار

- تخفیف کریں

- ML

- ایم ایل اوپس

- ماڈل

- ماڈل

- ماڈیولر

- ماڈیول

- ماڈیولز

- کی نگرانی

- نگرانی کی

- نگرانی

- زیادہ

- قدرتی

- قدرتی زبان عملیات

- ضروری

- نئی

- ویزا

- اطلاعات

- اب

- of

- جارحانہ

- تجویز

- اکثر

- on

- ایک

- والوں

- آن لائن

- اختیار

- or

- آرکیسٹرا

- ہمارے

- پیداوار

- نتائج

- باہر

- مجموعی طور پر

- مجموعی جائزہ

- خود

- جوڑی

- جوڑے

- حصہ

- منظور

- پاسنگ

- فی

- کارکردگی

- جملے

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- کھیل

- ممکن

- پوسٹ

- ممکنہ

- طاقتور

- پریکٹس

- کی موجودگی

- پروسیسنگ

- پیدا

- پیشہ ورانہ

- اشارہ کرتا ہے

- مجوزہ

- فراہم

- فراہم کرتا ہے

- ازگر

- معیار

- جلدی سے

- تناسب

- پڑھنا

- اصل وقت

- موصول

- سفارش

- کا حوالہ دیتے ہیں

- انکار

- انکار کر دیا

- متعلقہ

- وشوسنییتا

- قابل اعتماد

- ذخیرہ

- کی نمائندگی

- درخواست

- درخواستوں

- کی ضرورت

- ضروریات

- احترام

- متعلقہ

- جواب

- جوابات

- ذمہ دار

- انقلاب آگیا

- ٹھیک ہے

- خطرات

- مضبوط

- چل رہا ہے

- سیفٹی

- sagemaker

- محفوظ

- توسیع پذیر

- پیمانے

- دوسری

- سیکشنز

- معنوی

- بھیجنے

- بھیجتا ہے

- سینئر

- حساس

- جذبات

- سروسز

- مقرر

- شفٹوں

- ہونا چاہئے

- نمائش

- اشارہ

- اسی طرح

- سادہ

- سائز

- حل

- حل

- کچھ

- مقامی

- مخصوص

- خرچ کرنا۔

- معیار

- مرحلہ

- مراحل

- ذخیرہ

- براہ راست

- سلسلہ

- اس طرح

- مشورہ

- اس بات کا یقین

- درزی

- لے لو

- لینے

- ٹاسک

- کاموں

- ٹیم

- ٹیموں

- تکنیک

- متن

- کہ

- ۔

- کے بارے میں معلومات

- ان

- ان

- وہاں.

- یہ

- وہ

- بات

- اس

- کے ذریعے

- وقت

- ٹائٹین

- کرنے کے لئے

- سر

- ٹریک

- تبدیل

- ترجمہ

- سفر

- قابل اعتماد

- کی کوشش کر رہے

- دو

- افہام و تفہیم

- غیر متوقع

- استعمال کی شرائط

- استعمال کیا جاتا ہے

- رکن کا

- صارف مواجہ

- صارفین

- کا استعمال کرتے ہوئے

- قیمت

- اقدار

- کی طرف سے

- کی نمائش

- راستہ..

- طریقوں

- we

- ویب

- ویب خدمات

- کیا

- کیا ہے

- جب

- جبکہ

- جس

- کیوں

- وکیپیڈیا

- ساتھ

- کام

- کام کا بہاؤ

- تم

- اور

- زیفیرنیٹ