تعارف

انگریزی سیکھنا کوئی آسان کام نہیں ہے، جیسا کہ لاتعداد طلباء بخوبی جانتے ہیں۔ لیکن جب طالب علم کمپیوٹر ہوتا ہے، تو ایک طریقہ حیرت انگیز طور پر اچھی طرح کام کرتا ہے: بس انٹرنیٹ سے متن کے پہاڑوں کو ایک بڑے ریاضیاتی ماڈل میں فیڈ کریں جسے نیورل نیٹ ورک کہتے ہیں۔ OpenAI کے ChatGPT جیسے جنریٹیو لینگویج ماڈلز کے پیچھے آپریٹنگ اصول ہے، جن کی وسیع موضوعات پر ہم آہنگی سے بات چیت کرنے کی صلاحیت (اگر ہمیشہ سچائی سے نہیں) نے پچھلے سال کے دوران محققین اور عوام کو حیران کر دیا ہے۔

لیکن نقطہ نظر کی اپنی خامیاں ہیں۔ ایک چیز کے لیے، وسیع ٹیکسٹ آرکائیوز کو جدید ترین زبان کے ماڈلز میں منتقل کرنے کے لیے درکار "تربیت" کا طریقہ کار مہنگا اور وقت طلب ہے۔ دوسرے کے لیے، یہاں تک کہ وہ لوگ جو بڑے زبان کے ماڈلز کو تربیت دیتے ہیں، ان کے اندرونی کام کو سمجھنا مشکل ہوتا ہے۔ جس کے نتیجے میں، ان کے ناکام ہونے کے بہت سے طریقوں کی پیشن گوئی کرنا مشکل ہو جاتا ہے۔

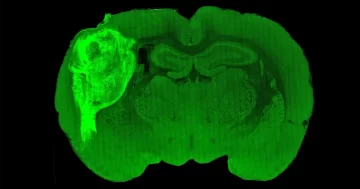

ان مشکلات کا سامنا کرتے ہوئے، کچھ محققین نے تربیت کا انتخاب کیا ہے۔ چھوٹے ماڈل چھوٹے ڈیٹا سیٹس پر اور پھر ان کے رویے کا مطالعہ کریں۔ "یہ ترتیب دینے کی طرح ہے۔ Drosophila جینوم بمقابلہ انسانی جینوم کی ترتیب،" کہا ایلی پاولکبراؤن یونیورسٹی میں لینگویج ماڈل ریسرچر۔

اب، ایک میں کاغذ حال ہی میں سائنسی پری پرنٹ سرور arxiv.org پر پوسٹ کیا گیا، مائیکروسافٹ کے محققین کے ایک جوڑے نے چھوٹے لینگویج ماڈلز کی تربیت کے لیے ایک نیا طریقہ متعارف کرایا ہے: بچوں کی کہانیوں کی سخت خوراک پر ان کی پرورش کریں۔

مشین لرننگ کے محققین نے اس سبق کو قبول کیا ہے۔ GPT-3.5، بڑی زبان کا ماڈل جو ChatGPT انٹرفیس کو طاقت دیتا ہے، اس کے تقریباً 200 بلین پیرامیٹرز ہیں، اور اسے سینکڑوں ارب الفاظ پر مشتمل ڈیٹا سیٹ پر تربیت دی گئی تھی۔ (OpenAI نے اپنے جانشین، GPT-4 کے لیے متعلقہ اعداد و شمار جاری نہیں کیے ہیں۔) ایسے بڑے ماڈلز کی تربیت کے لیے عام طور پر کم از کم 1,000 خصوصی پروسیسرز کی ضرورت ہوتی ہے جنہیں GPUs کہا جاتا ہے جو ایک وقت میں ہفتوں تک متوازی چلتے ہیں۔ صرف چند کمپنیاں مطلوبہ وسائل جمع کر سکتی ہیں، مختلف ماڈلز کو تربیت دینے اور موازنہ کرنے دیں۔

دونوں محققین نے ظاہر کیا کہ آج کے جدید ترین نظاموں سے ہزاروں گنا چھوٹے لینگویج ماڈلز نے اس طریقے سے تربیت حاصل کرنے پر تیزی سے مستقل اور گرائمری کہانیاں سنانا سیکھ لیا۔ ان کے نتائج نئی تحقیقی سمتوں کی طرف اشارہ کرتے ہیں جو بڑے ماڈلز کی تربیت اور ان کے رویے کو سمجھنے میں مددگار ثابت ہو سکتے ہیں۔

"مجھے یہ کاغذ بہت معلوماتی لگا،" کہا چندر بھگوتولا، سیئٹل میں ایلن انسٹی ٹیوٹ برائے مصنوعی ذہانت میں زبان کے ماڈل کے محقق۔ "تصور خود ہی انتہائی دلچسپ ہے۔"

ایک بار کرنے پر ایک ایسے وقت میں

لینگویج ماڈلز کے مرکز میں موجود عصبی نیٹ ورک ریاضیاتی ڈھانچے ہیں جو انسانی دماغ سے ڈھیلے طریقے سے متاثر ہوتے ہیں۔ ہر ایک میں تہوں میں ترتیب دیئے گئے بہت سے مصنوعی نیوران ہوتے ہیں، ملحقہ تہوں میں نیوران کے درمیان رابطے کے ساتھ۔ عصبی نیٹ ورک کا رویہ ان رابطوں کی طاقت سے چلتا ہے، جسے پیرامیٹرز کہتے ہیں۔ لینگویج ماڈل میں، پیرامیٹرز کنٹرول کرتے ہیں کہ ماڈل کون سے الفاظ کو آگے بڑھا سکتا ہے، ایک ابتدائی اشارہ اور الفاظ اس نے پہلے ہی تیار کر لیے ہیں۔

ایک ماڈل صحیح معنوں میں تربیت کے دوران ہی زندہ ہوتا ہے، جب وہ بار بار اپنے تربیتی ڈیٹا سیٹ کے متن سے اپنے آؤٹ پٹ کا موازنہ کرتا ہے اور مشابہت کو بڑھانے کے لیے اپنے پیرامیٹرز کو ایڈجسٹ کرتا ہے۔ بے ترتیب پیرامیٹرز کے ساتھ ایک غیر تربیت یافتہ نیٹ ورک کو کوڈ کی چند لائنوں سے جمع کرنا معمولی طور پر آسان ہے، لیکن یہ صرف بدگمانی پیدا کرے گا۔ تربیت کے بعد، یہ اکثر غیر مانوس متن کو جاری رکھ سکتا ہے۔ بڑے ماڈلز کو اکثر مزید ٹھیک ٹیوننگ سے گزرنا پڑتا ہے جو انہیں سوالات کے جوابات اور ہدایات پر عمل کرنا سکھاتا ہے، لیکن تربیت کا بڑا حصہ لفظ کی پیشن گوئی میں مہارت حاصل کرنا ہے۔

لفظ کی پیشن گوئی میں کامیابی کے لیے بہت سی مختلف مہارتوں میں مہارت حاصل کرنے کے لیے زبان کے ماڈل کی ضرورت ہوتی ہے۔ مثال کے طور پر، انگریزی گرامر کے اصول بتاتے ہیں کہ لفظ "going" کے بعد اگلا لفظ متن کے موضوع سے قطع نظر "to" ہونے کا امکان ہے۔ اس کے علاوہ، ایک نظام کو "فرانس کا دارالحکومت ہے" کو مکمل کرنے اور اس پر مشتمل ایک حوالے کو مکمل کرنے کے لیے حقائق سے متعلق علم کی ضرورت ہوتی ہے۔ لفظ "نہیں" منطق کی ابتدائی گرفت کی ضرورت ہے۔

"کچی زبان بہت پیچیدہ ہے،" کہا ٹموتھی نگوین، DeepMind میں مشین لرننگ محقق۔ "دلچسپ لسانی صلاحیتوں کے پیدا ہونے کے لیے، لوگوں نے 'زیادہ ڈیٹا بہتر ہے' کا سہارا لیا ہے۔"

تعارف

رونن ایلڈان, ایک ریاضی دان جس نے 2022 میں مائیکروسافٹ ریسرچ میں جنریٹیو لینگویج ماڈلز کا مطالعہ کرنے کے لیے شمولیت اختیار کی، اپنی صلاحیتوں کو دریافت کرنے کے لیے ایک سستا اور تیز طریقہ تیار کرنا چاہتا تھا۔ ایسا کرنے کا قدرتی طریقہ ایک چھوٹا ڈیٹا سیٹ استعمال کرنا تھا، اور اس کا مطلب یہ تھا کہ اسے ماڈلز کو کسی خاص کام میں مہارت حاصل کرنے کی تربیت دینی پڑے گی، تاکہ وہ خود کو زیادہ پتلا نہ پھیلائیں۔ ابتدائی طور پر، وہ ریاضی کے مسائل کے ایک مخصوص طبقے کو حل کرنے کے لیے ماڈلز کو تربیت دینا چاہتا تھا، لیکن ایک دوپہر، اپنی 5 سالہ بیٹی کے ساتھ وقت گزارنے کے بعد، اس نے محسوس کیا کہ بچوں کی کہانیاں بالکل موزوں ہیں۔

"یہ لفظی طور پر میرے پاس اس وقت آیا جب میں نے اس کی کہانی پڑھی۔" اس نے کہا۔

مربوط بچوں کی کہانیاں تخلیق کرنے کے لیے، ایک زبان کے ماڈل کو دنیا کے بارے میں حقائق جاننے، کرداروں اور واقعات پر نظر رکھنے، اور گرامر کے اصولوں کا مشاہدہ کرنے کی ضرورت ہوگی - بڑے ماڈلز کو درپیش چیلنجوں کے آسان ورژن۔ لیکن بڑے پیمانے پر ڈیٹا سیٹس پر تربیت یافتہ بڑے ماڈلز ان قوانین کے ساتھ بے شمار غیر متعلقہ تفصیلات سیکھتے ہیں جو واقعی اہمیت رکھتے ہیں۔ ایلڈن نے امید ظاہر کی کہ بچوں کی کہانیوں کی اختصار اور محدود ذخیرہ الفاظ چھوٹے ماڈلز کے لیے سیکھنے کو مزید قابل انتظام بنا سکتے ہیں - ان دونوں کو تربیت دینے میں آسان اور سمجھنے میں آسان بناتا ہے۔

زبان کے ماڈلز کی دنیا میں، اگرچہ، "چھوٹا" رشتہ دار ہے: GPT-3.5 کو تربیت دینے کے لیے استعمال کیے جانے والے ڈیٹا سے ہزار گنا چھوٹے سیٹ میں اب بھی لاکھوں کہانیوں کی ضرورت ہوگی۔ "میں نہیں جانتا کہ آپ کتنی رقم خرچ کرنا چاہتے ہیں، لیکن میں اندازہ لگا رہا ہوں کہ آپ [دو ملین] مختصر کہانیاں لکھنے کے لیے پیشہ ور افراد کی خدمات حاصل نہیں کریں گے،" Nguyen نے کہا۔

اس طرح کے شوقین قارئین کو مطمئن کرنے کے لیے ایک غیر معمولی مصنف کی ضرورت ہوگی، لیکن ایلڈان کے ذہن میں چند امیدوار تھے۔ چھوٹی زبان کے ماڈلز کے سامعین کے لیے بڑے سے بہتر کون لکھے؟

کھلونوں کی کہانیاں

ایلڈان فوری طور پر بچوں کی مصنوعی کہانیوں کی ایک لائبریری بنانے کے لیے نکلا جو بڑے زبان کے ماڈلز کے ذریعے تیار کیا گیا تھا۔ لیکن اس نے جلد ہی دریافت کیا کہ یہاں تک کہ جدید ترین ماڈل بھی قدرتی طور پر زیادہ تخلیقی نہیں ہیں۔ اگر آپ صرف GPT-4 کو 4 سال کے بچوں کے لیے مناسب کہانیاں لکھنے کے لیے کہتے ہیں، ایلڈان نے کہا، "کہانیوں کا تقریباً پانچواں حصہ ان بچوں کے بارے میں ہو گا جو پارک میں سلائیڈز سے خوفزدہ ہوتے ہیں۔" جہاں تک انٹرنیٹ کا تعلق ہے، یہ بظاہر پری اسکول کی عمدہ کہانی ہے۔

حل یہ تھا کہ پرامپٹ میں تھوڑا سا بے ترتیب پن شامل کیا جائے۔ سب سے پہلے، ایلڈان نے 4 اسموں، فعل اور صفتوں کی فہرست تیار کرنے کے لیے GPT-1,500 کا استعمال کیا جسے ایک 4 سالہ بچہ جان سکتا ہے - اتنا مختصر کہ وہ خود اسے آسانی سے چیک کر سکے۔ پھر اس نے ایک سادہ کمپیوٹر پروگرام لکھا جو بار بار GPT-3.5 یا GPT-4 کو عمر کے لحاظ سے ایک کہانی بنانے کا اشارہ کرے گا جس میں فہرست میں سے تین بے ترتیب الفاظ شامل ہوں گے، ساتھ ہی ایک اضافی تصادفی طور پر منتخب کردہ تفصیل جیسے خوش کن اختتام یا پلاٹ ٹوئسٹ۔ نتیجہ خیز کہانیاں، رحم دلی سے، خوفناک سلائیڈوں پر کم توجہ مرکوز تھیں۔

ایلڈان کے پاس اب ڈیمانڈ پر ٹریننگ ڈیٹا تیار کرنے کا طریقہ کار تھا، لیکن اسے اندازہ نہیں تھا کہ اسے فنکشنل ماڈل کی تربیت کے لیے کتنی کہانیوں کی ضرورت ہوگی، یا اس ماڈل کو کتنا بڑا ہونا چاہیے۔ اس کے ساتھ جب اس نے ٹیم بنائی یوانزی لی، مائیکروسافٹ اور کارنیگی میلن یونیورسٹی میں ایک مشین لرننگ محقق، مختلف امکانات کو آزمانے کے لیے، اس حقیقت کا فائدہ اٹھاتے ہوئے کہ چھوٹے ماڈلز کو بہت تیزی سے تربیت دی جا سکتی ہے۔ مرحلہ 1 فیصلہ کر رہا تھا کہ ان کے ماڈلز کا اندازہ کیسے لگایا جائے۔

تعارف

زبان کے ماڈل کی تحقیق میں - جیسا کہ ہر کلاس روم میں ہوتا ہے - درجہ بندی ایک بھرا ہوا موضوع ہے۔ وہاں ہے۔ کوئی کامل روبرک نہیں۔ جو محققین جاننا چاہتے ہیں ہر چیز کو سمیٹتا ہے، اور جو ماڈل کچھ کاموں میں سبقت لے جاتے ہیں وہ اکثر دوسروں پر شاندار طور پر ناکام ہو جاتے ہیں۔ وقت گزرنے کے ساتھ، محققین نے غیر مبہم جوابات والے سوالات کی بنیاد پر مختلف معیاری بینچ مارکس تیار کیے ہیں، اگر آپ مخصوص مہارتوں کا جائزہ لینے کی کوشش کر رہے ہیں تو یہ ایک اچھا طریقہ ہے۔ لیکن ایلڈان اور لی کی دلچسپی کچھ زیادہ ہی مضحکہ خیز تھی: اگر آپ زبان کو زیادہ سے زیادہ آسان بناتے ہیں تو زبان کے ماڈلز کو واقعی کتنا بڑا ہونا چاہئے؟

ایلڈان نے کہا، "براہ راست جانچ کرنے کے لیے کہ آیا ماڈل انگریزی بولتا ہے، میرے خیال میں آپ صرف ایک ہی کام کر سکتے ہیں کہ ماڈل کو کھلے عام انداز میں انگریزی پیدا کرنے دیں۔"

ایسے معیاری سوالات پر ماڈل کی کارکردگی کی پیمائش کرنے کے صرف دو طریقے ہیں: انسانی گریڈرز پر بھروسہ کریں، یا ایک بار پھر GPT-4 کی طرف رجوع کریں۔ دونوں محققین نے مؤخر الذکر راستے کا انتخاب کیا، مؤثر طریقے سے بڑے ماڈلز کو نصابی کتابیں لکھنے اور مضامین کی درجہ بندی کرنے کی اجازت دی۔

بھگواتولا نے کہا کہ وہ یہ دیکھنا پسند کریں گے کہ انسانی جائزہ لینے والوں کے مقابلے GPT-4 کی تشخیص کس طرح ہوتی ہے — GPT-4 ان ماڈلز کی طرف متعصب ہو سکتا ہے جن کی تربیت میں اس نے مدد کی، اور زبان کے ماڈلز کی مبہمیت اس طرح کے تعصبات کو درست کرنا مشکل بنا دیتی ہے۔ لیکن وہ نہیں سوچتا کہ اس طرح کی باریکیاں مصنوعی کہانیوں کے ایک جیسے سیٹوں پر تربیت یافتہ مختلف ماڈلز کے درمیان موازنہ پر اثر انداز ہوں گی - ایلڈان اور لی کے کام کا بنیادی مرکز۔

ایلڈان اور لی نے تربیت کے بعد اپنے ہر چھوٹے ماڈل کا جائزہ لینے کے لیے دو قدمی طریقہ کار استعمال کیا۔ سب سے پہلے، انہوں نے چھوٹے ماڈل کو ایک کہانی کے پہلے نصف حصے کے ساتھ تربیتی ڈیٹا سیٹ سے الگ کرنے کا اشارہ کیا تاکہ اس نے 50 مختلف ٹیسٹ کہانیوں کے ساتھ اس عمل کو دہراتے ہوئے، ایک نیا اختتام پیدا کیا۔ دوسرا، انہوں نے GPT-4 کو ہدایت کی کہ ہر چھوٹے ماڈل کے اختتام کو تین زمروں کی بنیاد پر درجہ دیا جائے — تخلیقی صلاحیت، گرامر اور کہانی کے آغاز کے ساتھ مطابقت۔ اس کے بعد انہوں نے ہر زمرے میں اسکور کا اوسط لگایا، جس کے اختتام پر فی ماڈل تین فائنل گریڈ ہوتے ہیں۔

اس طریقہ کار کو ہاتھ میں رکھتے ہوئے، ایلڈان اور لی آخر کار مختلف ماڈلز کا موازنہ کرنے اور یہ جاننے کے لیے تیار ہو گئے کہ کون سے اسٹار طالب علم تھے۔

امتحانی نتائج

کچھ ابتدائی تحقیق کے بعد، دونوں محققین نے تقریباً 2 ملین کہانیوں پر مشتمل تربیتی ڈیٹا سیٹ پر طے کیا۔ اس کے بعد انہوں نے اس ڈیٹا سیٹ کا استعمال کیا، جسے TinyStories ڈب کیا جاتا ہے، 1 ملین سے 30 ملین پیرامیٹرز کے سائز کے ماڈلز کو تربیت دینے کے لیے، جس میں تہوں کی مختلف تعداد تھی۔ یہ فوری کام تھا: صرف چار GPUs کا استعمال کرتے ہوئے، ان میں سے سب سے بڑے ماڈل کو تربیت دینے میں ایک دن سے زیادہ وقت نہیں لگا۔

چھوٹے ماڈلز نے جدوجہد کی۔ مثال کے طور پر، ایک آزمائشی کہانی کا آغاز ایک بدتمیز آدمی کے ساتھ ہوتا ہے جو ایک لڑکی سے کہتا ہے کہ وہ اس کی بلی کو لے جائے گا۔ ایک ملین پیرامیٹر ماڈل لڑکی کے بار بار اس آدمی کو بتانے کے ساتھ ایک لوپ میں پھنس گئی کہ وہ دوست بننا چاہتی ہے۔ لیکن بڑے والے - GPT-3.5 سے ہزاروں گنا چھوٹے - نے حیرت انگیز طور پر اچھی کارکردگی کا مظاہرہ کیا۔ 28-ملین پیرامیٹر ورژن نے ایک مربوط کہانی سنائی، حالانکہ اختتام بھیانک تھا: "کیٹی نے رونا شروع کر دیا، لیکن اس شخص کو کوئی پرواہ نہیں تھی۔ وہ بلی کو لے گیا اور کیٹی نے اپنی بلی کو دوبارہ کبھی نہیں دیکھا۔ ختم شد."

اپنے اپنے ماڈلز کی جانچ کرنے کے علاوہ، ایلڈان اور لی نے OpenAI کے GPT-2 کو بھی یہی چیلنج پیش کیا، جو 1.5 میں ریلیز ہونے والا 2019 بلین پیرامیٹر ماڈل تھا۔ اس کا انجام اس سے بھی بدتر تھا — کہانی کے اچانک ختم ہونے سے پہلے، آدمی نے لڑکی کو لے جانے کی دھمکی دی۔ عدالت، جیل، ہسپتال، مردہ خانے اور آخر میں شمشان تک۔

تعارف

Nguyen نے کہا کہ یہ دلچسپ ہے کہ اس طرح کے چھوٹے ماڈل اتنے روانی سے تھے، لیکن شاید حیرت کی بات نہیں کہ GPT-2 نے اس کام کے ساتھ جدوجہد کی: یہ ایک بڑا ماڈل ہے لیکن آرٹ کی حالت سے بہت دور ہے، اور اسے بہت مختلف ڈیٹا سیٹ پر تربیت دی گئی تھی۔ اس نے نوٹ کیا، "صرف چھوٹے بچوں کے کاموں پر ایک چھوٹا بچہ تربیت، جیسے کہ کچھ کھلونوں سے کھیلنا، آپ یا میں سے بہتر کام کر سکتا ہے۔" "ہم نے اس سادہ چیز میں مہارت نہیں کی۔"

TinyStories کے مختلف ماڈلز کے درمیان موازنہ ایک جیسے الجھنے والے عوامل کا شکار نہیں ہوتے ہیں۔ ایلڈان اور لی نے اشارہ کیا کہ کم تہوں والے نیٹ ورک لیکن فی پرت زیادہ نیوران ایسے سوالات کے جوابات دینے میں بہتر ہیں جن کے لیے حقائق سے متعلق علم کی ضرورت ہوتی ہے۔ اس کے برعکس، زیادہ تہوں والے نیٹ ورکس اور فی پرت کم نیورونز کہانی میں پہلے سے کرداروں اور پلاٹ پوائنٹس پر نظر رکھنے میں بہتر تھے۔ بھگوتلا نے یہ نتیجہ خاص طور پر دلچسپ پایا۔ اگر اسے بڑے ماڈلز میں نقل کیا جا سکتا ہے، تو انہوں نے کہا، "یہ واقعی ایک اچھا نتیجہ ہوگا جو اس کام سے نکل سکتا ہے۔"

ایلڈان اور لی نے یہ بھی مطالعہ کیا کہ کس طرح ان کے چھوٹے ماڈلز کی صلاحیتیں تربیت کی مدت پر منحصر ہیں۔ ہر معاملے میں، ماڈلز نے پہلے گرائمر میں مہارت حاصل کی اور بعد میں مستقل مزاجی۔ ایلڈان کے لیے، یہ نمونہ واضح کرتا ہے کہ کس طرح انعام کے ڈھانچے میں فرق عصبی نیٹ ورکس اور بچوں کے درمیان زبان کے حصول کے نمونوں میں فرق کا باعث بنتا ہے۔ زبان کے ماڈلز کے لیے، جو الفاظ کی پیشن گوئی کرتے ہوئے سیکھتے ہیں، "میں 'I want to have' کے الفاظ پر ترغیب اتنا ہی بڑا ہے جتنا کہ 'آئس کریم' کے الفاظ پر،" اس نے کہا۔ دوسری طرف، بچوں کو اس بات کی پرواہ نہیں ہے کہ آیا وہ کہتے ہیں کہ 'میں کچھ آئس کریم لینا چاہوں گا' یا صرف 'آئس کریم، آئس کریم، آئس کریم'۔

کوالٹی بمقابلہ مقدار

ایلڈان اور لی امید کرتے ہیں کہ یہ تحقیق دوسرے محققین کو مختلف ماڈلز کو تربیت دینے کی ترغیب دے گی۔ TinyStories ڈیٹا سیٹ اور ان کی صلاحیتوں کا موازنہ کریں۔ لیکن یہ پیش گوئی کرنا اکثر مشکل ہوتا ہے کہ چھوٹے ماڈلز کی کون سی خصوصیات بڑے ماڈلز میں بھی ظاہر ہوں گی۔

"شاید وژن کے ماؤس ماڈل واقعی انسانی وژن کے اچھے پراکسی ہیں، لیکن کیا ڈپریشن کے ماؤس ماڈل انسانی ڈپریشن کے اچھے ماڈل ہیں؟" پاولک نے کہا۔ "ہر معاملے کے لئے یہ تھوڑا سا مختلف ہے۔"

TinyStories ماڈلز کی کامیابی ایک وسیع سبق بھی تجویز کرتی ہے۔ تربیتی ڈیٹا سیٹس کو مرتب کرنے کے معیاری نقطہ نظر میں پورے انٹرنیٹ سے متن کو خالی کرنا اور پھر کوڑے کو فلٹر کرنا شامل ہے۔ بڑے ماڈلز کے ذریعے تیار کردہ مصنوعی متن اعلیٰ معیار کے ڈیٹا سیٹس کو جمع کرنے کا ایک متبادل طریقہ پیش کر سکتا ہے جو اتنا بڑا نہیں ہونا چاہیے۔

ایلڈان نے کہا، "ہمارے پاس زیادہ سے زیادہ شواہد موجود ہیں کہ یہ نہ صرف TinyStories کے سائز کے ماڈلز میں بلکہ بڑے ماڈلز میں بھی بہت موثر ہے۔" یہ ثبوت ایلڈان، لی اور دیگر مائیکروسافٹ محققین کے بلین پیرامیٹر ماڈلز کے بارے میں فالو اپ پیپرز کے ایک جوڑے سے ملتا ہے۔ میں پہلا کاغذ، انہوں نے انٹرنیٹ سے احتیاط سے تیار کردہ کوڈ کے ساتھ GPT-3.5 کے ذریعہ تیار کردہ کوڈ کے ٹکڑوں کا استعمال کرتے ہوئے پروگرامنگ لینگویج Python سیکھنے کے لئے ایک ماڈل کو تربیت دی۔ میں دوسری، انہوں نے مصنوعی "درسی کتب" کے ساتھ تربیتی ڈیٹا سیٹ کو بڑھایا، جس میں موضوعات کی ایک وسیع رینج کا احاطہ کیا گیا، تاکہ ایک عمومی مقصدی زبان کے ماڈل کو تربیت دی جا سکے۔ اپنے ٹیسٹوں میں، دونوں ماڈلز کا موازنہ بڑے ڈیٹا سیٹس پر تربیت یافتہ بڑے ماڈلز سے کیا گیا۔ لیکن زبان کے ماڈلز کا جائزہ لینا ہمیشہ مشکل ہوتا ہے، اور مصنوعی تربیتی ڈیٹا اپروچ ابھی بھی ابتدائی دور میں ہے — مزید آزاد ٹیسٹ ضروری ہیں۔

جیسا کہ جدید ترین زبان کے ماڈلز بڑے ہوتے جاتے ہیں، ان کے چھوٹے کزنز سے حیران کن نتائج یہ یاددہانی کراتے ہیں کہ اب بھی بہت کچھ ہے جو ہم سادہ ترین ماڈلز کے بارے میں بھی نہیں سمجھتے ہیں۔ Nguyen توقع کرتا ہے کہ TinyStories کی طرف سے پیش کردہ نقطہ نظر کو تلاش کرنے والے بہت سے کاغذات دیکھیں گے۔

سوال یہ ہے کہ سائز کہاں اور کیوں اہمیت رکھتا ہے؟ انہوں نے کہا. "اس کی کوئی سائنس ہونی چاہیے، اور امید ہے کہ یہ مقالہ ایک بھرپور کہانی کا آغاز ہے۔"

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو ڈیٹا ڈاٹ نیٹ ورک ورٹیکل جنریٹو اے آئی۔ اپنے آپ کو بااختیار بنائیں۔ یہاں تک رسائی حاصل کریں۔

- پلیٹوآئ اسٹریم۔ ویب 3 انٹیلی جنس۔ علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- پلیٹو ای ایس جی۔ کاربن، کلین ٹیک، توانائی ، ماحولیات، شمسی، ویسٹ مینجمنٹ یہاں تک رسائی حاصل کریں۔

- پلیٹو ہیلتھ۔ بائیوٹیک اینڈ کلینیکل ٹرائلز انٹیلی جنس۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://www.quantamagazine.org/tiny-language-models-thrive-with-gpt-4-as-a-teacher-20231005/

- : ہے

- : ہے

- : نہیں

- :کہاں

- ][p

- $UP

- 000

- 1

- 200

- 200 ارب

- 2019

- 2022

- 30

- 50

- 500

- a

- صلاحیتوں

- کی صلاحیت

- ہمارے بارے میں

- حصول

- کے پار

- شامل کریں

- اس کے علاوہ

- ایڈیشنل

- ملحقہ

- فائدہ

- پر اثر انداز

- کے بعد

- پھر

- تمام

- اکیلے

- ساتھ

- پہلے ہی

- بھی

- متبادل

- ہمیشہ

- an

- اور

- اینڈریو

- ایک اور

- جواب

- جواب

- ظاہر

- نقطہ نظر

- مناسب

- ابلیھاگار

- کیا

- اٹھتا

- اہتمام

- فن

- مصنوعی

- مصنوعی ذہانت

- AS

- At

- سامعین

- اضافہ

- مصنف

- دور

- کی بنیاد پر

- BE

- اس سے پہلے

- شروع

- رویے

- پیچھے

- کیا جا رہا ہے

- معیارات

- بہتر

- کے درمیان

- باصلاحیت

- باضابطہ

- بگ

- ارب

- اربوں

- بٹ

- دونوں

- دماغ

- وسیع

- کتتھئ

- لیکن

- by

- کہا جاتا ہے

- آیا

- کر سکتے ہیں

- امیدواروں

- صلاحیتوں

- دارالحکومت

- پرواہ

- احتیاط سے

- کارنیگی میلون

- کیس

- CAT

- اقسام

- قسم

- کچھ

- چیلنج

- چیلنجوں

- خصوصیات

- حروف

- چیٹ جی پی ٹی

- سستی

- چیک کریں

- بچوں

- کا انتخاب کیا

- منتخب کیا

- طبقے

- کوڈ

- مربوط

- آتا ہے

- کمپنیاں

- موازنہ

- مقابلے میں

- موازنہ

- مکمل

- مکمل کرنا

- پیچیدہ

- پر مشتمل ہے

- کمپیوٹر

- تصور

- متعلقہ

- کنکشن

- متواتر

- پر مشتمل ہے

- پر مشتمل ہے

- جاری

- کنٹرول

- اس کے برعکس

- ٹھنڈی

- اسی کے مطابق

- مہنگی

- سکتا ہے

- جوڑے

- کورٹ

- ڈھکنے

- تخلیق

- تخلیقی

- تخلیقی

- cured

- اعداد و شمار

- ڈیٹا سیٹ

- ڈیٹا سیٹ

- دن

- فیصلہ کرنا

- Deepmind

- ڈیمانڈ

- ڈپریشن

- تفصیل

- تفصیلات

- ترقی

- ترقی یافتہ

- غذا

- اختلافات

- مختلف

- مشکلات

- براہ راست

- دریافت

- مختلف

- do

- کرتا

- نہیں کرتا

- نہیں

- خرابیاں

- ڈوب

- مدت

- کے دوران

- ہر ایک

- اس سے قبل

- آسان

- آسانی سے

- آسان

- موثر

- مؤثر طریقے

- گلے لگا لیا

- encapsulates

- آخر

- ختم ہونے

- انگریزی

- کافی

- خاص طور پر

- اندازہ

- کا جائزہ لینے

- اندازہ

- بھی

- واقعات

- کبھی نہیں

- ہر کوئی

- سب کچھ

- ثبوت

- مثال کے طور پر

- ایکسل

- دلچسپ

- امید ہے

- کی تلاش

- تلاش

- ایکسپلور

- غیر معمولی طور پر

- سامنا کرنا پڑا

- حقیقت یہ ہے

- عوامل

- حقائق

- FAIL

- دور

- تیز تر

- چند

- کم

- اعداد و شمار

- فلٹرنگ

- فائنل

- آخر

- مل

- نتائج

- پہلا

- فٹ

- توجہ مرکوز

- توجہ مرکوز

- پر عمل کریں

- کے لئے

- ملا

- چار

- فرانس

- دوست

- سے

- فنکشنل

- مزید

- عام مقصد

- پیدا

- پیدا

- پیداواری

- وشال

- شادی سے پہلے

- دی

- جا

- اچھا

- ملا

- حکومت کی

- GPUs

- گریڈ

- گرائمر

- سمجھو

- سنگین

- بڑھائیں

- تھا

- نصف

- ہاتھ

- خوش

- ہارڈ

- ہے

- he

- ہارٹ

- مدد

- مدد گار

- اس کی

- اعلی معیار کی

- اشارے

- کرایہ پر لینا

- ان

- امید ہے کہ

- امید ہے کہ

- ہسپتال

- کس طرح

- کیسے

- HTTPS

- انسانی

- سینکڑوں

- i

- ICE

- آئس کریم

- خیال

- if

- وضاحت کرتا ہے

- فوری طور پر

- in

- انتباہ

- شامل

- اضافہ

- آزاد

- معلوماتی

- ابتدائی

- ابتدائی طور پر

- متاثر

- انسٹی ٹیوٹ

- ہدایات

- انٹیلی جنس

- دلچسپی

- دلچسپ

- انٹرفیس

- انٹرنیٹ

- میں

- دلچسپی

- متعارف

- IT

- میں

- خود

- جیل

- شامل ہو گئے

- صرف

- رکھیں

- رکھتے ہوئے

- جان

- علم

- زبان

- بڑے

- بڑے

- سب سے بڑا

- بعد

- پرت

- تہوں

- قیادت

- جانیں

- سیکھا ہے

- سیکھنے

- کم سے کم

- کم

- سبق

- دو

- دے رہا ہے

- Li

- لائبریری

- زندگی

- کی طرح

- امکان

- لمیٹڈ

- لائنوں

- لسٹ

- تھوڑا

- منطق

- مشین

- مشین لرننگ

- میگزین

- مین

- بنا

- بناتا ہے

- بنانا

- آدمی

- قابل انتظام

- بہت سے

- بڑے پیمانے پر

- ماسٹر

- ماسٹرنگ

- ریاضی

- ریاضیاتی

- معاملہ

- مئی..

- me

- مراد

- پیمائش

- میلن

- طریقہ

- مائیکروسافٹ

- شاید

- دس لاکھ

- لاکھوں

- برا

- ماڈل

- ماڈل

- قیمت

- زیادہ

- بہت

- قدرتی

- تقریبا

- ضروری

- ضرورت ہے

- ضروریات

- نیٹ ورک

- نیٹ ورک

- عصبی

- عصبی نیٹ ورک

- نیند نیٹ ورک

- نیورسن

- کبھی نہیں

- نئی

- اگلے

- Nguyen

- نہیں

- کا کہنا

- لفظیں

- اب

- تعداد

- مشاہدہ

- of

- پیش کرتے ہیں

- اکثر

- on

- ایک بار

- ایک

- والوں

- صرف

- مبہمیت

- اوپنائی

- کام

- or

- حکم

- دیگر

- دیگر

- باہر

- پیداوار

- پر

- خود

- جوڑی

- کاغذ.

- کاغذات

- متوازی

- پیرامیٹرز

- پارک

- منظور

- گزشتہ

- پاٹرن

- پیٹرن

- لوگ

- فی

- کامل

- کارکردگی

- کارکردگی

- شاید

- مدت

- پایا

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- کھیل

- پوائنٹس

- امکانات

- ممکن

- پوسٹ کیا گیا

- اختیارات

- پیشن گوئی

- پیش گوئی

- کی پیشن گوئی

- ابتدائی

- پیش

- اصول

- مسائل

- طریقہ کار

- عمل

- پروسیسرز

- پیدا

- پیشہ ور ماہرین

- پروگرام

- پروگرامنگ

- عوامی

- ازگر

- قابلیت

- کوانٹا میگزین

- سوال

- سوالات

- فوری

- جلدی سے

- پنچاتی

- بلند

- بے ترتیب

- بے ترتیب پن

- رینج

- لے کر

- میں تیزی سے

- پڑھیں

- قارئین

- تیار

- احساس ہوا

- واقعی

- حال ہی میں

- بے شک

- رشتہ دار

- جاری

- انحصار کرو

- بار بار

- نقل تیار

- ضرورت

- کی ضرورت ہے

- مطلوبہ

- تحقیق

- محقق

- محققین

- وسائل

- نتیجہ

- نتیجے

- نتائج کی نمائش

- انعام

- امیر

- تقریبا

- روٹ

- قوانین

- چل رہا ہے

- کہا

- اسی

- دیکھا

- کا کہنا ہے کہ

- ڈر

- سائنس

- سائنسی

- سیٹل

- دوسری

- دیکھنا

- ترتیب

- سرور

- مقرر

- سیٹ

- آباد

- وہ

- مختصر

- ہونا چاہئے

- سے ظاہر ہوا

- اسی طرح

- سادہ

- سادہ

- آسان بنانے

- صرف

- سائز

- مہارت

- سلائیڈیں

- چھوٹے

- چھوٹے

- So

- حل

- حل

- کچھ

- کچھ

- جلد ہی

- بولی

- مہارت

- خصوصی

- مخصوص

- خرچ

- خرچ کرنا۔

- پھیلانے

- معیار

- سٹار

- شروع

- حالت

- ریاستی آرٹ

- تنا

- مرحلہ

- ابھی تک

- خبریں

- کہانی

- طاقت

- سخت

- ڈھانچوں

- طالب علم

- طلباء

- تعلیم حاصل کی

- مطالعہ

- موضوع

- کامیابی

- اس طرح

- مشورہ

- پتہ چلتا ہے

- سپر

- حیران کن

- حیرت انگیز

- مصنوعی

- کے نظام

- سسٹمز

- لے لو

- لینے

- ٹاسک

- کاموں

- مل کر

- بتا

- کہہ

- ٹیسٹ

- ٹیسٹنگ

- ٹیسٹ

- متن

- سے

- کہ

- ۔

- ریاست

- دنیا

- ان

- ان

- خود

- تو

- یہ

- وہ

- بات

- لگتا ہے کہ

- اس

- ان

- اگرچہ؟

- ہزار

- ہزاروں

- خطرہ

- تین

- ترقی کی منازل طے

- وقت

- اوقات

- کرنے کے لئے

- آج کا

- بتایا

- بھی

- لیا

- موضوع

- موضوعات

- کی طرف

- ٹریک

- ٹرین

- تربیت یافتہ

- ٹریننگ

- transmutes

- واقعی

- کوشش

- کی کوشش کر رہے

- ٹرن

- موڑ

- دو

- عام طور پر

- گزرنا

- سمجھ

- افہام و تفہیم

- ناجائز

- یونیورسٹی

- صلی اللہ علیہ وسلم

- استعمال کیا جاتا ہے

- کا استعمال کرتے ہوئے

- مختلف

- مختلف

- وسیع

- ورژن

- ورژن

- بنام

- بہت

- نقطہ نظر

- چاہتے ہیں

- چاہتے تھے

- تھا

- راستہ..

- طریقوں

- we

- ویبپی

- مہینے

- اچھا ہے

- تھے

- جب

- چاہے

- جس

- ڈبلیو

- کس کی

- کیوں

- وسیع

- وسیع رینج

- گے

- ساتھ

- لفظ

- الفاظ

- کام

- کام

- کام کرتا ہے

- دنیا

- بدتر

- گا

- لکھنا

- لکھا ہے

- سال

- تم

- زیفیرنیٹ