جیسا کہ مشین لرننگ (ML) ماڈلز میں بہتری آئی ہے، ڈیٹا سائنسدانوں، ML انجینئرز اور محققین نے اپنی زیادہ توجہ ڈیٹا کے معیار کی وضاحت اور بہتر بنانے پر مرکوز کر دی ہے۔ اس کی وجہ سے ایم ایل کے لیے ڈیٹا سینٹرک اپروچ اور ڈیٹا کی ضروریات پر توجہ مرکوز کرتے ہوئے ماڈل کی کارکردگی کو بہتر بنانے کے لیے مختلف تکنیکوں کا ظہور ہوا ہے۔ ان تکنیکوں کا اطلاق ایم ایل پریکٹیشنرز کو ایم ایل ماڈل کی تربیت کے لیے درکار ڈیٹا کی مقدار کو کم کرنے کی اجازت دیتا ہے۔

اس نقطہ نظر کے حصے کے طور پر، ڈیٹا سبسیٹ کے انتخاب کی جدید تکنیکیں ان پٹ ڈیٹا کی مقدار کو کم کرکے تربیت کو تیز کرنے کے لیے سامنے آئی ہیں۔ یہ عمل خود بخود پوائنٹس کی ایک دی گئی تعداد کو منتخب کرنے پر مبنی ہے جو ایک بڑے ڈیٹاسیٹ کی تقسیم کا تخمینہ لگاتے ہیں اور اسے تربیت کے لیے استعمال کرتے ہیں۔ اس قسم کی تکنیک کا اطلاق ایم ایل ماڈل کو تربیت دینے کے لیے درکار وقت کو کم کرتا ہے۔

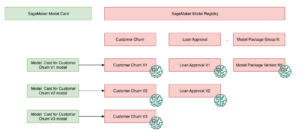

اس پوسٹ میں، ہم ڈیٹا سینٹرک AI اصولوں کو لاگو کرنے کی وضاحت کرتے ہیں۔ ایمیزون سیج میکر گراؤنڈ ٹروتھکا استعمال کرتے ہوئے ڈیٹا سبسیٹ سلیکشن تکنیک کو کیسے نافذ کیا جائے۔ ڈوری ذخیرہ پر ایمیزون سیج میکر ابتدائی ماڈل کو تربیت دینے کے لیے درکار ڈیٹا کی مقدار کو کم کرنے کے لیے، اور اس نقطہ نظر کو استعمال کرتے ہوئے تجربات کو کیسے چلایا جائے۔ ایمیزون سیج میکر کے تجربات.

مشین لرننگ کے لیے ڈیٹا سینٹرک اپروچ

ڈیٹا سب سیٹ کے انتخاب جیسی جدید ترین ڈیٹا سینٹرک تکنیکوں میں غوطہ لگانے سے پہلے، آپ اپنے ڈیٹا لیبلنگ کے عمل میں بنیادی اصولوں کے سیٹ کو لاگو کر کے متعدد طریقوں سے اپنے ڈیٹا سیٹس کو بہتر بنا سکتے ہیں۔ اس کے لیے، گراؤنڈ ٹروتھ لیبل کی مستقل مزاجی اور ڈیٹا کے معیار کو بہتر بنانے کے لیے مختلف میکانزم کی حمایت کرتا ہے۔

ماڈل کی کارکردگی کو بہتر بنانے کے لیے لیبل کی مستقل مزاجی اہم ہے۔ اس کے بغیر، ماڈل فیصلہ کی حد نہیں بنا سکتے جو مختلف طبقات سے تعلق رکھنے والے ہر نقطہ کو الگ کرے۔ مستقل مزاجی کو یقینی بنانے کا ایک طریقہ استعمال کرنا ہے۔ زمینی سچائی میں تشریح کا استحکام، جو آپ کو متعدد لیبلرز کو دی گئی مثال پیش کرنے اور اس مثال کے لیے زمینی سچائی کے طور پر فراہم کردہ مجموعی لیبل کو استعمال کرنے کی اجازت دیتا ہے۔ لیبل میں فرق کو زمینی سچائی کے ذریعے پیدا کردہ اعتماد کے اسکور سے ماپا جاتا ہے۔ جب لیبلز میں اختلاف ہو، تو آپ کو یہ دیکھنا چاہیے کہ کیا آپ کے لیبلرز کو فراہم کردہ لیبلنگ ہدایات میں کوئی ابہام ہے جسے دور کیا جا سکتا ہے۔ یہ نقطہ نظر انفرادی لیبلرز کے تعصب کے اثرات کو کم کرتا ہے، جو لیبلز کو مزید مستقل بنانے میں مرکزی حیثیت رکھتا ہے۔

ڈیٹا پر توجہ مرکوز کر کے ماڈل کی کارکردگی کو بہتر بنانے کا ایک اور طریقہ لیبلز میں غلطیوں کا تجزیہ کرنے کے طریقے تیار کرنا شامل ہے کیونکہ وہ ڈیٹا کے سب سے اہم ذیلی سیٹ کی نشاندہی کرنے کے لیے آتے ہیں۔ آپ یہ اپنے تربیتی ڈیٹاسیٹ کے لیے دستی کوششوں کے مجموعے کے ساتھ کر سکتے ہیں جس میں لیبل شدہ مثالوں میں غوطہ لگانے اور ایمیزون کلاؤڈ واچ گراؤنڈ ٹروتھ لیبلنگ جابز کے ذریعے تیار کردہ لاگز اور میٹرکس۔ ہمارے ڈیٹاسیٹ کے لیے لیبلنگ کی اگلی تکرار کو چلانے کے لیے ان غلطیوں کو دیکھنا بھی ضروری ہے جو ماڈل تخمینہ کے وقت کرتا ہے۔ ان میکانزم کے علاوہ، ایمیزون سیج میکر واضح کریں۔ ڈیٹا سائنسدانوں اور ایم ایل انجینئرز کو الگورتھم جیسے چلانے کی اجازت دیتا ہے۔ KernelSHAP تاکہ وہ اپنے ماڈل کی طرف سے کی گئی پیشین گوئیوں کی تشریح کر سکیں۔ جیسا کہ ذکر کیا گیا ہے، ماڈل کی پیشین گوئیوں کی ایک گہری وضاحت اس کو بہتر بنانے کے لیے ابتدائی لیبلنگ کے عمل سے متعلق ہو سکتی ہے۔

آخر میں، آپ شور مچانے والی یا ضرورت سے زیادہ فالتو مثالوں پر غور کر سکتے ہیں۔ ایسا کرنے سے آپ کو ان مثالوں کو ہٹا کر تربیت کا وقت کم کرنے کی اجازت ملتی ہے جو ماڈل کی کارکردگی کو بہتر بنانے میں معاون نہیں ہیں۔ تاہم، دستی طور پر دیئے گئے ڈیٹاسیٹ کے مفید ذیلی سیٹ کی شناخت مشکل اور وقت طلب ہے۔ اس پوسٹ میں بیان کردہ ڈیٹا سبسیٹ انتخاب کی تکنیکوں کو لاگو کرنے سے آپ کو قائم کردہ فریم ورک کے ساتھ اس عمل کو خودکار کرنے کی اجازت ملتی ہے۔

کیس استعمال کریں۔

جیسا کہ ذکر کیا گیا ہے، ڈیٹا سینٹرک AI خود ماڈل کے فن تعمیر کے بجائے ماڈل ان پٹ کو بہتر بنانے پر توجہ مرکوز کرتا ہے۔ ایک بار جب آپ ڈیٹا لیبلنگ یا فیچر انجینئرنگ کے دوران ان اصولوں کو لاگو کر لیتے ہیں، تو آپ ٹریننگ کے وقت ڈیٹا سب سیٹ سلیکشن کو لاگو کر کے ماڈل ان پٹ پر توجہ مرکوز کرنا جاری رکھ سکتے ہیں۔

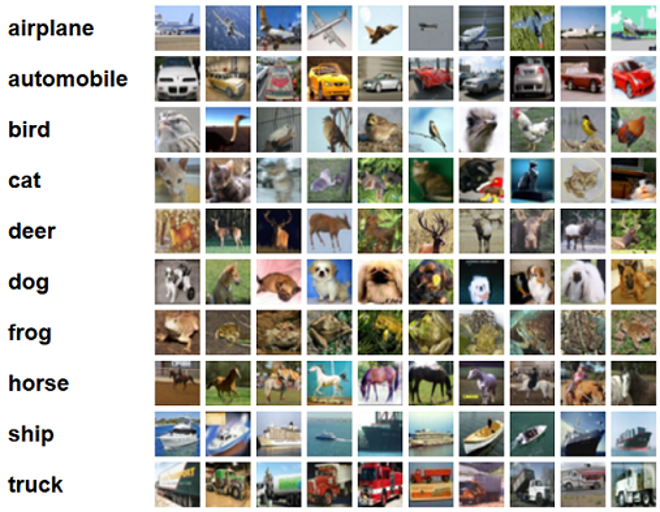

اس پوسٹ کے لیے، ہم موثر اور مضبوط لرننگ کے لیے جنرلائزیشن پر مبنی ڈیٹا سب سیٹ سلیکشن کا اطلاق کرتے ہیں (گلسٹر)، جو کہ CORDS ریپوزٹری میں لاگو کردہ ڈیٹا سبسیٹ سلیکشن تکنیکوں میں سے ایک ہے، ResNet-18 ماڈل کی درجہ بندی کرنے کے لیے کسی ماڈل کو تربیت دینے میں لگنے والے وقت کو کم سے کم کرنے کے لیے CIFAR-10 تصاویر ذیل میں کچھ نمونے کی تصاویر ہیں جن کے متعلقہ لیبل CIFAR-10 ڈیٹاسیٹ سے کھینچے گئے ہیں۔

ResNet-18 اکثر درجہ بندی کے کاموں کے لیے استعمال ہوتا ہے۔ یہ ایک 18 پرتوں کا گہرا کنوولیشنل نیورل نیٹ ورک ہے۔ CIFAR-10 ڈیٹاسیٹ اکثر ML میں مختلف تکنیکوں اور طریقوں کی درستگی کا جائزہ لینے کے لیے استعمال ہوتا ہے۔ یہ 60,000 32×32 رنگین تصاویر پر مشتمل ہے جس پر 10 کلاسوں میں لیبل لگا ہوا ہے۔

درج ذیل حصوں میں، ہم دکھاتے ہیں کہ کس طرح GLISTER درج ذیل سوال کا جواب دینے میں آپ کی کچھ حد تک مدد کر سکتا ہے:

تربیت کے دوران ہم دیئے گئے ڈیٹاسیٹ کا کتنا فیصد استعمال کر سکتے ہیں اور پھر بھی ماڈل کی اچھی کارکردگی حاصل کر سکتے ہیں؟

آپ کے تربیتی الگورتھم پر GLISTER کا اطلاق آپ کے تربیتی الگورتھم میں ایک ہائپر پیرامیٹر کے طور پر کسر کو متعارف کرائے گا۔ یہ دیئے گئے ڈیٹاسیٹ کے فیصد کی نمائندگی کرتا ہے جسے آپ استعمال کرنا چاہتے ہیں۔ کسی بھی ہائپر پیرامیٹر کی طرح، آپ کے ماڈل اور ڈیٹا کے لیے بہترین نتیجہ پیدا کرنے والی قدر تلاش کرنے کے لیے ٹیوننگ کی ضرورت ہوتی ہے۔ ہم اس پوسٹ میں ہائپر پیرامیٹر ٹیوننگ کی گہرائی میں نہیں جاتے ہیں۔ مزید معلومات کے لیے رجوع کریں۔ ایمیزون سیج میکر آٹومیٹک ماڈل ٹیوننگ کے ساتھ ہائپر پیرامیٹرز کو بہتر بنائیں.

ہم نقطہ نظر کے اثرات کی پیمائش کرنے کے لیے SageMaker Experiments کا استعمال کرتے ہوئے کئی ٹیسٹ چلاتے ہیں۔ ابتدائی ڈیٹاسیٹ کے لحاظ سے نتائج مختلف ہوں گے، اس لیے مختلف سب سیٹ سائزز پر ہمارے ڈیٹا کے خلاف نقطہ نظر کو جانچنا ضروری ہے۔

اگرچہ ہم تصاویر پر GLISTER استعمال کرنے پر تبادلہ خیال کرتے ہیں، لیکن آپ اسے ڈھانچہ یا ٹیبلر ڈیٹا کے ساتھ کام کرنے والے تربیتی الگورتھم پر بھی لاگو کر سکتے ہیں۔

ڈیٹا سب سیٹ کا انتخاب

ڈیٹا سبسیٹ کے انتخاب کا مقصد تربیت کے عمل کو تیز کرنا ہے جبکہ درستگی پر اثرات کو کم کرنا اور ماڈل کی مضبوطی میں اضافہ کرنا ہے۔ مزید خاص طور پر، GLISTER-ONLINE ایک ذیلی سیٹ کا انتخاب کرتا ہے جیسا کہ ماڈل آپ کے بیان کردہ توثیق سیٹ پر اس تربیتی ڈیٹا سبسیٹ کے لاگ امکان کو زیادہ سے زیادہ کرنے کی کوشش کر کے سیکھتا ہے۔ ڈیٹا سبسیٹ کے انتخاب کو اس طرح سے بہتر بنانا شور اور طبقاتی عدم توازن کو کم کرتا ہے جو اکثر حقیقی دنیا کے ڈیٹا سیٹس میں پایا جاتا ہے اور سب سیٹ انتخاب کی حکمت عملی کو ماڈل کے سیکھنے کے ساتھ ہی اپنانے کی اجازت دیتا ہے۔

ابتدائی گلسٹر پیپر مختلف ڈیٹا سبسیٹ سائزز پر اسپیڈ اپ/ درستگی ٹریڈ آف کی وضاحت کرتا ہے جیسا کہ a کا استعمال کرتے ہوئے پیروی کیا گیا ہے۔ لی نیٹ ماڈل:

| سب سیٹ سائز | speedup کے | درستگی |

| 10٪ | 6x | -3٪ |

| 30٪ | 2.5x | -1.20٪ |

| 50٪ | 1.5x | -0.20٪ |

ماڈل کو تربیت دینے کے لیے، ہم چلاتے ہیں۔ سیج میکر کی تربیت کا کام اپنی مرضی کے مطابق ٹریننگ سکرپٹ کا استعمال کرتے ہوئے. ہم نے اپنا امیج ڈیٹا سیٹ بھی پہلے ہی اپ لوڈ کر دیا ہے۔ ایمیزون سادہ اسٹوریج سروس (ایمیزون S3)۔ جیسا کہ کسی بھی سیج میکر تربیتی کام کے ساتھ، ہمیں ایک کی وضاحت کرنے کی ضرورت ہے۔ Estimator چیز. سے PyTorch کا تخمینہ لگانے والا sagemaker.pytorch پیکیج ہمیں ایک منظم PyTorch کنٹینر میں اپنی تربیتی اسکرپٹ چلانے کی اجازت دیتا ہے۔ دی inputs متغیر تخمینہ لگانے والے کو بھیج دیا گیا۔ .fit فنکشن میں تربیت اور توثیق کے ڈیٹاسیٹ کے S3 مقام کی لغت شامل ہے۔

۔ train.py اسکرپٹ کو اس وقت چلایا جاتا ہے جب تربیتی کام شروع ہوتا ہے۔ اس اسکرپٹ میں، ہم CORDS لائبریری سے ResNet-18 ماڈل درآمد کرتے ہیں اور اسے اپنے ڈیٹاسیٹ میں درج ذیل کلاسوں کی تعداد دیتے ہیں:

پھر، ہم استعمال کرتے ہیں gen_dataset تربیت، توثیق، اور ٹیسٹ ڈیٹا سیٹس بنانے کے لیے CORDS سے فنکشن:

ہر ڈیٹاسیٹ سے، ہم ایک مساوی PyTorch ڈیٹا لوڈر بناتے ہیں:

آخر میں، ہم ان ڈیٹا لوڈرز کو ایک بنانے کے لیے استعمال کرتے ہیں۔ GLISTERDataLoader CORDS لائبریری سے۔ یہ GLISTER-ONLINE انتخاب کی حکمت عملی کے نفاذ کا استعمال کرتا ہے، جو سب سیٹ سلیکشن کو لاگو کرتا ہے جب ہم ٹریننگ کے دوران ماڈل کو اپ ڈیٹ کرتے ہیں، جیسا کہ اس پوسٹ میں پہلے بات کی گئی ہے۔

آبجیکٹ بنانے کے لیے، ہم انتخابی حکمت عملی کے مخصوص دلائل کو بطور ایک پاس کرتے ہیں۔ DotMap اعتراض کے ساتھ ساتھ train_loader, validation_loader، اور logger:

۔ GLISTERDataLoader اب ٹریننگ لوپ میں باقاعدہ ڈیٹا لوڈر کے طور پر لاگو کیا جا سکتا ہے۔ یہ اگلے ٹریننگ بیچ کے لیے ڈیٹا سب سیٹس کا انتخاب کرے گا کیونکہ ماڈل اس ماڈل کے نقصان کی بنیاد پر سیکھتا ہے۔ جیسا کہ پچھلے جدول میں دکھایا گیا ہے، ڈیٹا سب سیٹ کے انتخاب کی حکمت عملی کا اضافہ ہمیں تربیت کے وقت کو نمایاں طور پر کم کرنے کی اجازت دیتا ہے، یہاں تک کہ ڈیٹا سب سیٹ کے انتخاب کے اضافی مرحلے کے ساتھ، درستگی میں بہت کم تجارت کے ساتھ۔

ڈیٹا سائنسدانوں اور ایم ایل انجینئرز کو اکثر کسی نقطہ نظر کے ساتھ اس کا موازنہ کرکے اس کی درستگی کا جائزہ لینے کی ضرورت ہوتی ہے۔ ہم اگلے حصے میں یہ ظاہر کرتے ہیں کہ اسے کیسے کرنا ہے۔

تجربہ ٹریکنگ

آپ ڈیٹا سب سیٹ سلیکشن اپروچ کی درستگی کی پیمائش کرنے کے لیے SageMaker Experiments استعمال کر سکتے ہیں۔ مزید معلومات کے لیے دیکھیں اگلی نسل کے ایمیزون سیج میکر کے تجربات – اپنی مشین لرننگ ٹریننگ کو پیمانے پر منظم، ٹریک اور موازنہ کریں.

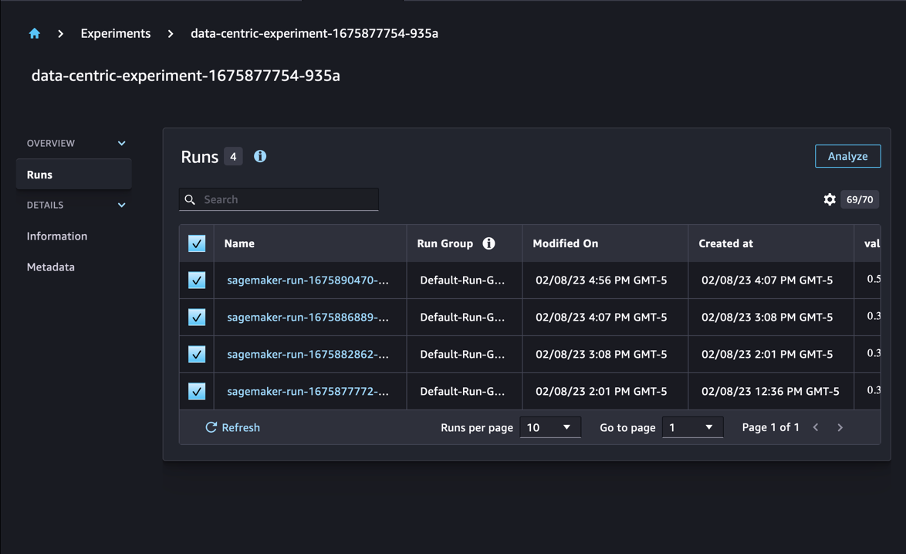

ہمارے معاملے میں، ہم چار تجربات کرتے ہیں: ڈیٹا سب سیٹ سلیکشن کو لاگو کیے بغیر ایک بیس لائن، اور تین دیگر مختلف کے ساتھ۔ fraction پیرامیٹرز، جو کہ مجموعی ڈیٹاسیٹ کے نسبت سب سیٹ کے سائز کی نمائندگی کرتا ہے۔ قدرتی طور پر، ایک چھوٹے کا استعمال کرتے ہوئے fraction پیرامیٹر کے نتیجے میں تربیت کا وقت کم ہونا چاہیے، لیکن کم ماڈل کی درستگی بھی۔

اس پوسٹ کے لیے، ہر ٹریننگ رن کی نمائندگی a کے طور پر کی جاتی ہے۔ Run سیج میکر کے تجربات میں۔ ہمارے تجربے سے متعلق رنز سب کو ایک کے تحت گروپ کیا گیا ہے۔ Experiment چیز. رن بناتے وقت ایک عام تجربے کے ساتھ منسلک کیا جا سکتا ہے۔ Estimator SDK کے ساتھ۔ درج ذیل کوڈ دیکھیں:

اپنی حسب ضرورت ٹریننگ اسکرپٹ کے حصے کے طور پر، آپ استعمال کر کے رن میٹرکس جمع کر سکتے ہیں۔ load_run:

پھر، پچھلے آپریشن کے ذریعے واپس کیے گئے رن آبجیکٹ کا استعمال کرتے ہوئے، آپ کال کر کے فی زمانہ ڈیٹا پوائنٹس اکٹھا کر سکتے ہیں۔ run.log_metric(name, value, step) اور میٹرک کا نام، قدر، اور موجودہ عہد نمبر فراہم کرنا۔

اپنے نقطہ نظر کی درستگی کی پیمائش کرنے کے لیے، ہم تربیت کے نقصان، تربیت کی درستگی، توثیق کے نقصان، توثیق کی درستگی، اور ایک عہد کو مکمل کرنے کے وقت سے متعلق میٹرکس جمع کرتے ہیں۔ پھر، تربیتی ملازمتیں چلانے کے بعد، ہم کر سکتے ہیں۔ ہمارے تجربے کے نتائج کا جائزہ لیں۔ in ایمیزون سیج میکر اسٹوڈیو یا SageMaker Experiments SDK کے ذریعے۔

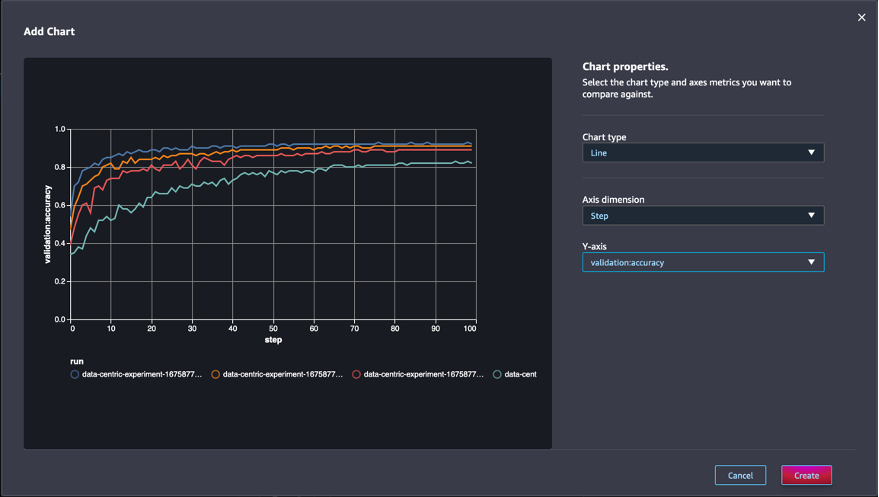

اسٹوڈیو میں توثیق کی درستگیوں کو دیکھنے کے لیے، منتخب کریں۔ تجزیہ تجربے پر رنز صفحہ.

ایک چارٹ شامل کریں، چارٹ کی خصوصیات سیٹ کریں، اور منتخب کریں۔ تخلیق کریں. جیسا کہ درج ذیل اسکرین شاٹ میں دکھایا گیا ہے، آپ کو تمام رنز کے لیے ہر دور میں توثیق کی درستگیوں کا پلاٹ نظر آئے گا۔

SDK آپ کو تجربہ سے متعلقہ معلومات کو بطور Pandas ڈیٹا فریم بازیافت کرنے کی بھی اجازت دیتا ہے:

اختیاری طور پر، تربیتی ملازمتوں کو ترتیب دیا جا سکتا ہے۔ مثال کے طور پر، ہم شامل کر سکتے ہیں "metrics.validation:accuracy.max" کی قدر کے طور پر sort_by پیرامیٹر کو منتقل کیا گیا۔ ExperimentAnalytics توثیق کی درستگی کی طرف سے حکم دیا نتیجہ واپس کرنے کے لئے.

جیسا کہ توقع کی گئی ہے، ہمارے تجربات سے پتہ چلتا ہے کہ GLISTER اور ڈیٹا سبسیٹ سلیکشن کو ٹریننگ الگورتھم میں لاگو کرنے سے ٹریننگ کا وقت کم ہو جاتا ہے۔ ہمارا بیس لائن ٹریننگ الگورتھم چلاتے وقت، ایک دور کو مکمل کرنے کا درمیانی وقت 27 سیکنڈ کے قریب ہوتا ہے۔ اس کے برعکس، مجموعی ڈیٹاسیٹ کے 50%، 30%، اور 10% کے مساوی ذیلی سیٹ کو منتخب کرنے کے لیے GLISTER کو لاگو کرنے سے ml.p13x بڑی مثالوں پر بالترتیب تقریباً 8.5، 2.75، اور 3.2 سیکنڈز کا دور مکمل ہو جاتا ہے۔ .

ہم توثیق کی درستگی پر نسبتاً کم سے کم اثر کا مشاہدہ بھی کرتے ہیں، خاص طور پر جب 50% کے ڈیٹا سب سیٹ استعمال کرتے ہیں۔ 100 عہدوں کی تربیت کے بعد، بیس لائن 92.72% کی توثیق کی درستگی پیدا کرتی ہے۔ اس کے برعکس، مجموعی ڈیٹاسیٹ کے 50%، 30%، اور 10% کے مساوی ذیلی سیٹ کو منتخب کرنے کے لیے GLISTER کو لاگو کرنے سے بالترتیب 91.42%، 89.76%، اور 82.82% کی توثیق کی درستگی حاصل ہوتی ہے۔

نتیجہ

سیج میکر گراؤنڈ ٹروتھ اور سیج میکر تجربات ڈیٹا سائنسدانوں اور ایم ایل انجینئرز کو زیادہ مستقل ڈیٹا سیٹ تیار کرنے اور ماڈل بنانے کے مرحلے میں ان کو لاگو کرنے کے ساتھ ساتھ مزید جدید تکنیکوں کے اثرات کو ٹریک کرنے کی اجازت دے کر مشین لرننگ کے لیے ڈیٹا پر مبنی نقطہ نظر کو فعال کرتے ہیں۔ ML میں ڈیٹا سینٹرک اپروچ کو لاگو کرنا آپ کو اپنے ماڈل کے لیے درکار ڈیٹا کی مقدار کو کم کرنے اور اس کی مضبوطی کو بہتر بنانے کی اجازت دیتا ہے۔

اسے آزمائیں، اور ہمیں بتائیں کہ آپ تبصروں میں کیا سوچتے ہیں۔

مصنفین کے بارے میں

نکولس برنیئر AWS میں کینیڈین پبلک سیکٹر ٹیم کا حصہ، ایک سلوشنز آرکیٹیکٹ ہے۔ وہ فی الحال ڈیپ لرننگ میں ریسرچ ایریا کے ساتھ ماسٹر ڈگری کر رہا ہے اور اس کے پاس پانچ AWS سرٹیفیکیشن ہیں، بشمول ML اسپیشلٹی سرٹیفیکیشن۔ نکولس اپنے کاروباری چیلنجوں کو تکنیکی حل میں ترجمہ کرنے کے لیے ان کے ساتھ کام کرکے AWS کے بارے میں اپنے علم کو گہرا کرنے میں مدد کرنے کے لیے پرجوش ہیں۔

نکولس برنیئر AWS میں کینیڈین پبلک سیکٹر ٹیم کا حصہ، ایک سلوشنز آرکیٹیکٹ ہے۔ وہ فی الحال ڈیپ لرننگ میں ریسرچ ایریا کے ساتھ ماسٹر ڈگری کر رہا ہے اور اس کے پاس پانچ AWS سرٹیفیکیشن ہیں، بشمول ML اسپیشلٹی سرٹیفیکیشن۔ نکولس اپنے کاروباری چیلنجوں کو تکنیکی حل میں ترجمہ کرنے کے لیے ان کے ساتھ کام کرکے AWS کے بارے میں اپنے علم کو گہرا کرنے میں مدد کرنے کے لیے پرجوش ہیں۔

جیوانیلڈو الویس ایمیزون ویب سروسز میں پروٹوٹائپنگ اور کلاؤڈ انجینئرنگ ٹیم کے ساتھ ایک پروٹو ٹائپنگ آرکیٹیکٹ ہے، جو کہ مصنوعی ذہانت کے ارد گرد کئی پروٹو ٹائپس کو پہلے ہی لاگو کرچکا ہے، AWS پر ممکنہ فن کو دکھا کر کلائنٹس کو اختراع اور تیز کرنے میں مدد کرتا ہے۔ اس کا سوفٹ ویئر انجینئرنگ میں طویل کیریئر ہے اور اس نے پہلے Amazon.com.br پر سافٹ ویئر ڈویلپمنٹ انجینئر کے طور پر کام کیا ہے۔

جیوانیلڈو الویس ایمیزون ویب سروسز میں پروٹوٹائپنگ اور کلاؤڈ انجینئرنگ ٹیم کے ساتھ ایک پروٹو ٹائپنگ آرکیٹیکٹ ہے، جو کہ مصنوعی ذہانت کے ارد گرد کئی پروٹو ٹائپس کو پہلے ہی لاگو کرچکا ہے، AWS پر ممکنہ فن کو دکھا کر کلائنٹس کو اختراع اور تیز کرنے میں مدد کرتا ہے۔ اس کا سوفٹ ویئر انجینئرنگ میں طویل کیریئر ہے اور اس نے پہلے Amazon.com.br پر سافٹ ویئر ڈویلپمنٹ انجینئر کے طور پر کام کیا ہے۔

- SEO سے چلنے والا مواد اور PR کی تقسیم۔ آج ہی بڑھا دیں۔

- پلیٹو بلاک چین۔ Web3 Metaverse Intelligence. علم میں اضافہ۔ یہاں تک رسائی حاصل کریں۔

- ماخذ: https://aws.amazon.com/blogs/machine-learning/use-a-data-centric-approach-to-minimize-the-amount-of-data-required-to-train-amazon-sagemaker-models/

- : ہے

- $UP

- 000

- 1

- 10

- 100

- 7

- 8

- a

- ہمارے بارے میں

- رفتار کو تیز تر

- درستگی

- حاصل

- کے پار

- اپنانے

- اس کے علاوہ

- ایڈیشنل

- اعلی درجے کی

- کے بعد

- کے خلاف

- AI

- یلگورتم

- یلگوردمز

- تمام

- اجازت دے رہا ہے

- کی اجازت دیتا ہے

- پہلے ہی

- ایمیزون

- ایمیزون سیج میکر

- ایمیزون ویب سروسز

- Amazon.com

- محیط

- رقم

- تجزیاتی

- تجزیے

- اور

- جواب

- اطلاقی

- کا اطلاق کریں

- درخواست دینا

- نقطہ نظر

- نقطہ نظر

- فن تعمیر

- کیا

- رقبہ

- دلائل

- ارد گرد

- فن

- مصنوعی

- مصنوعی ذہانت

- AS

- At

- کوشش کرنا

- توجہ

- خود کار طریقے سے

- خودکار

- خود کار طریقے سے

- AWS

- واپس

- کی بنیاد پر

- بیس لائن

- BE

- BEST

- تعصب

- عمارت

- کاروبار

- by

- بلا

- کر سکتے ہیں

- کینیڈا

- کیریئر کے

- کیس

- مرکزی

- تصدیق

- سرٹیفکیٹ

- چیلنجوں

- چارٹ

- میں سے انتخاب کریں

- طبقے

- کلاس

- درجہ بندی

- درجہ بندی کرنا۔

- کلائنٹس

- بادل

- کوڈ

- جمع

- رنگ

- COM

- مجموعہ

- کس طرح

- تبصروں

- کامن

- تقابلی طور پر

- موازنہ

- موازنہ

- مکمل

- پر مشتمل

- چل رہا ہے

- آپکا اعتماد

- غور کریں

- متواتر

- سمیکن

- کنٹینر

- پر مشتمل ہے

- جاری

- اس کے برعکس

- شراکت

- اسی کے مطابق

- سکتا ہے

- تخلیق

- تخلیق

- موجودہ

- اس وقت

- اپنی مرضی کے

- گاہکوں

- اعداد و شمار

- ڈیٹا پوائنٹس

- ڈیٹاسیٹس

- فیصلہ

- گہری

- گہری سیکھنے

- گہرا کرنا

- گہرے

- وضاحت

- ڈگری

- مظاہرہ

- demonstrated,en

- منحصر ہے

- گہرائی

- بیان

- بیان کیا

- ترقی

- ترقی

- مختلف

- مختلف

- مشکل

- بات چیت

- بات چیت

- تقسیم

- دریافت

- کر

- نہیں

- ڈرائیو

- کے دوران

- ہر ایک

- اس سے قبل

- اثرات

- ہنر

- کوششوں

- خروج

- کو چالو کرنے کے

- انجینئر

- انجنیئرنگ

- انجینئرز

- کو یقینی بنانے کے

- عہد

- زمانے

- مساوی

- نقائص

- خاص طور پر

- قائم

- اندازہ

- بھی

- ہر کوئی

- مثال کے طور پر

- مثال کے طور پر

- توقع

- تجربہ

- وضاحت

- نمایاں کریں

- تلاش

- توجہ مرکوز

- توجہ مرکوز

- توجہ مرکوز

- پیچھے پیچھے

- کے بعد

- مندرجہ ذیل ہے

- کے لئے

- ملا

- کسر

- فریم ورک

- سے

- تقریب

- پیدا

- نسل

- دی

- Go

- اچھا

- گراؤنڈ

- ہے

- ہونے

- مدد

- مدد

- کی ڈگری حاصل کی

- کس طرح

- کیسے

- تاہم

- HTML

- HTTP

- HTTPS

- ہائپر پیرامیٹر ٹیوننگ

- شناخت

- کی نشاندہی

- تصویر

- تصاویر

- عدم توازن

- اثر

- پر عملدرآمد

- نفاذ

- عملدرآمد

- پر عمل درآمد

- درآمد

- اہم

- کو بہتر بنانے کے

- بہتر

- کو بہتر بنانے کے

- in

- سمیت

- اضافہ

- انفرادی

- معلومات

- ابتدائی

- اختراعات

- ان پٹ

- مثال کے طور پر

- ہدایات

- انٹیلی جنس

- متعارف کرانے

- IT

- تکرار

- میں

- خود

- ایوب

- نوکریاں

- جان

- علم

- لیبل

- لیبل

- لیبل

- بڑے

- شروع

- سیکھنے

- قیادت

- لائبریری

- کی طرح

- لسٹ

- تھوڑا

- محل وقوع

- لانگ

- دیکھو

- بند

- مشین

- مشین لرننگ

- بنا

- بناتا ہے

- بنانا

- میں کامیاب

- دستی

- دستی طور پر

- بہت سے

- ماسٹر کی

- میکس

- زیادہ سے زیادہ

- پیمائش

- ذکر کیا

- طریقوں

- میٹرک۔

- پیمائش کا معیار

- کم سے کم

- کم سے کم

- ML

- ماڈل

- ماڈل

- زیادہ

- سب سے زیادہ

- ایک سے زیادہ

- نام

- ضرورت ہے

- نیٹ ورک

- عصبی نیٹ ورک

- اگلے

- نکولس

- شور

- تعداد

- اعتراض

- مشاہدہ

- of

- on

- ایک

- آپریشن

- اصلاح

- دیگر

- مجموعی طور پر

- خود

- پیکج

- صفحہ

- pandas

- پیرامیٹر

- پیرامیٹرز

- حصہ

- منظور

- جذباتی

- فیصد

- انجام دیں

- کارکردگی

- مرحلہ

- پلاٹا

- افلاطون ڈیٹا انٹیلی جنس

- پلیٹو ڈیٹا

- پوائنٹ

- پوائنٹس

- ممکن

- پوسٹ

- پیشن گوئی

- پچھلا

- پہلے

- اصولوں پر

- عمل

- پیدا

- خصوصیات

- prototypes

- prototyping کے

- فراہم

- عوامی

- مقصد

- pytorch

- معیار

- مقدار

- سوال

- بلکہ

- حقیقی دنیا

- کو کم

- کم

- کم

- کو کم کرنے

- خطے

- باقاعدہ

- متعلقہ

- ہٹا دیا گیا

- کو ہٹانے کے

- ذخیرہ

- نمائندگی

- کی نمائندگی کرتا ہے

- ضرورت

- ضروریات

- کی ضرورت ہے

- تحقیق

- محققین

- متعلقہ

- نتیجہ

- نتائج کی نمائش

- واپسی

- مضبوط

- مضبوطی

- رن

- چل رہا ہے

- sagemaker

- سائنسدانوں

- sdk

- سیکنڈ

- سیکشن

- سیکشنز

- شعبے

- منتخب

- انتخاب

- خدمت

- سروسز

- اجلاس

- مقرر

- کئی

- ہونا چاہئے

- دکھائیں

- دکھایا گیا

- نمایاں طور پر

- سادہ

- ایک

- سائز

- سائز

- چھوٹے

- So

- سافٹ ویئر کی

- سوفٹ ویئر کی نشوونما

- سافٹ ویئر انجینئرنگ

- حل

- کچھ

- ماخذ

- خاص

- مخصوص

- خاص طور پر

- تیزی

- مرحلہ

- ابھی تک

- ذخیرہ

- حکمت عملی

- منظم

- سٹوڈیو

- فراہمی

- کی حمایت کرتا ہے

- ٹیبل

- لیتا ہے

- کاموں

- ٹیم

- ٹیکنیکل

- تکنیک

- ٹیسٹ

- ٹیسٹ

- کہ

- ۔

- ان

- ان

- یہ

- تین

- کے ذریعے

- وقت

- اوقات

- کرنے کے لئے

- مشعل

- ٹورنٹو

- ٹریک

- ٹرین

- ٹریننگ

- تربیتوں

- ترجمہ کریں

- کے تحت

- بنیادی

- اپ ڈیٹ کریں

- اپ لوڈ کردہ

- us

- استعمال کی شرائط

- توثیق

- قیمت

- مختلف

- لنک

- راستہ..

- طریقوں

- ویب

- ویب خدمات

- اچھا ہے

- کیا

- جس

- جبکہ

- گے

- ساتھ

- کے اندر

- بغیر

- کام کیا

- کام کر

- تم

- اور

- زیفیرنیٹ