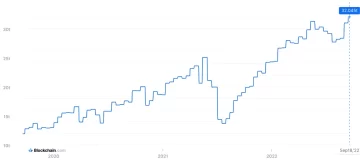

Dữ liệu của người dùng: Thực phẩm quan trọng của LLMs

Đúng! RT @bryce thích câu nói này “Nếu bạn không trả tiền cho nó, bạn không phải là khách hàng; bạn chính là sản phẩm đang được bán.” http://bit.ly/93JYCJ

- Tim O'Reilly (@timoreilly) Ngày 2 tháng 2010 năm XNUMX

Luôn cập nhật tin tức về tiền điện tử, cập nhật hàng ngày trong hộp thư đến của bạn.

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- : có

- :là

- :không phải

- 7

- 8

- a

- có khả năng

- Tuyệt đối

- Theo

- chính xác

- thích nghi

- giải quyết

- Thêm

- tiên tiến

- cách đây

- đồng ý

- AI

- Dịch vụ AI

- Hệ thống AI

- Mục tiêu

- Alexa

- Căn chỉnh

- Tất cả

- cho phép

- Ngoài ra

- luôn luôn

- đàn bà gan dạ

- an

- và

- nhân loại

- dự đoán

- bất kì

- áp dụng

- LÀ

- AS

- đảm đương

- At

- có sẵn

- tránh

- nhận thức

- dựa

- BE

- bởi vì

- được

- tin

- mang lại lợi ích

- Hơn

- giữa

- by

- CAN

- tuyên bố

- khách hàng

- thương gia

- cam kết

- cam kết

- Các công ty

- công ty

- cạnh tranh

- khái niệm

- Mối quan tâm

- liên tục

- nội dung

- bối cảnh

- liên tục

- điều khiển

- Tiện lợi

- cuộc hội thoại

- quyền tác giả

- có thể

- quan trọng

- Crypto

- Crypto Tin tức

- Current

- khách hàng

- khách hàng

- tiền thưởng

- tối

- dữ liệu

- dữ liệu riêng tư

- tranh luận

- thập kỷ

- Giải mã

- sâu

- học kĩ càng

- Mặc định

- Bảo vệ

- phân phối

- phụ thuộc

- từ chối

- tranh chấp

- SỰ ĐA DẠNG

- do

- tài liệu

- làm

- đô la

- dont

- suốt trong

- kiếm

- Cạnh

- hiệu quả

- hay

- Tham gia

- tăng cường

- đảm bảo

- thiết yếu

- đạo đức

- đạo đức

- ví dụ

- Sàn giao dịch

- kinh nghiệm

- mở rộng

- mức độ

- ngoài

- phải đối mặt với

- Trong

- Cựu

- Thành lập

- Miễn phí

- từ

- đạt được

- tạo ra

- tạo ra

- tạo

- thế hệ

- Trí tuệ nhân tạo

- được

- nhận được

- đại gia

- Cho

- Go

- cấp

- sự hiểu biết

- Phát triển

- nặng nề

- trung thực

- danh dự

- Tuy nhiên

- http

- HTTPS

- Nhân loại

- lý tưởng

- if

- nâng cao

- in

- hệ thống riêng biệt,

- thông tin

- trí tuệ

- sở hữu trí tuệ

- ý định

- tương tác

- nội bộ

- IP

- IT

- ITS

- chính nó

- Key

- Ngôn ngữ

- lớn

- mới nhất

- Luật

- dẫn

- LEARN

- học tập

- Hợp pháp

- Tỉ lệ đòn bẩy

- Lượt thích

- Loài đà mã ở nam mỹ

- LLM

- yêu

- làm cho

- Làm

- Có thể..

- Phương tiện truyền thông

- Siêu dữ liệu

- hàng triệu

- kiểu mẫu

- mô hình

- chi tiết

- hầu hết

- mạng

- thần kinh

- mạng thần kinh

- Mới

- tin tức

- có được

- of

- on

- OpenAI

- or

- bề ngoài

- nếu không thì

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- ra

- kết quả đầu ra

- kết thúc

- riêng

- sở hữu

- thanh toán

- các bên tham gia

- bên

- mô hình

- Trả

- trả tiền

- riêng

- cá nhân

- Cá nhân

- Hình ảnh

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- điều luật

- tiềm năng

- quyền lực

- mạnh mẽ

- thực hành

- dự đoán

- Dự đoán

- ưu đãi

- thịnh hành

- riêng tư

- riêng

- Sản xuất

- Sản phẩm

- nhắc nhở

- tài sản

- cho

- cung cấp

- công khai

- lòng tin của công

- công khai

- trích dẫn

- cuộc đua

- RE

- thế giới thực

- nhận

- lọc

- coi

- tương đối

- phát hành

- có liên quan

- Báo cáo

- yêu cầu

- nhà nghiên cứu

- chịu trách nhiệm

- Tiết lộ

- quyền

- đối thủ

- rt

- Ryan

- s

- nói

- nói

- bối cảnh

- dịch vụ

- DỊCH VỤ

- định

- Chia sẻ

- nên

- Chủ nghĩa hoài nghi

- So

- Mạng xã hội

- truyền thông xã hội

- bán

- ĐÁNH VẦN

- người phát ngôn

- khởi động

- Tuyên bố

- ở lại

- Bước

- hệ thống

- Tandem

- công nghệ cao

- đại gia công nghệ

- kỹ thuật

- về

- văn bản

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- Kia là

- họ

- điều này

- Tim

- đến

- bây giờ

- hàng đầu

- Train

- đào tạo

- Hội thảo

- Minh bạch

- Xu hướng

- NIỀM TIN

- Dưới

- hiểu

- sự hiểu biết

- sắp tới

- cập nhật

- Cập nhật

- nâng cấp

- tải lên

- sử dụng

- đã sử dụng

- người sử dang

- Người sử dụng

- sử dụng

- Quý báu

- khác nhau

- phiên bản

- Video

- quan trọng

- Giọng nói

- khối lượng

- là

- we

- là

- khi nào

- liệu

- cái nào

- tại sao

- sẽ

- với

- Từ

- sẽ

- Bạn

- trên màn hình

- zephyrnet