Các nhóm khoa học dữ liệu và kỹ thuật dữ liệu dành phần lớn thời gian của họ trong giai đoạn chuẩn bị dữ liệu của vòng đời máy học (ML) để thực hiện các bước chọn, làm sạch và chuyển đổi dữ liệu. Đây là bước cần thiết và quan trọng của bất kỳ quy trình ML nào nhằm tạo ra thông tin chi tiết và dự đoán có ý nghĩa, vì dữ liệu kém hoặc chất lượng thấp làm giảm đáng kể mức độ liên quan của thông tin chi tiết thu được.

Theo truyền thống, các nhóm kỹ thuật dữ liệu chịu trách nhiệm về việc nhập, hợp nhất và chuyển đổi dữ liệu thô để sử dụng ở hạ nguồn. Các nhà khoa học dữ liệu thường cần xử lý bổ sung dữ liệu cho các trường hợp sử dụng ML theo miền cụ thể như ngôn ngữ tự nhiên và chuỗi thời gian. Ví dụ: một số thuật toán ML nhất định có thể nhạy cảm với các giá trị bị thiếu, các tính năng thưa thớt hoặc các giá trị ngoại lệ và cần được xem xét đặc biệt. Ngay cả trong trường hợp tập dữ liệu ở trạng thái tốt, các nhà khoa học dữ liệu có thể muốn chuyển đổi cách phân phối tính năng hoặc tạo các tính năng mới để tối đa hóa thông tin chi tiết thu được từ các mô hình. Để đạt được những mục tiêu này, các nhà khoa học dữ liệu phải dựa vào các nhóm kỹ thuật dữ liệu để đáp ứng những thay đổi được yêu cầu, dẫn đến sự phụ thuộc và chậm trễ trong quá trình phát triển mô hình. Ngoài ra, các nhóm khoa học dữ liệu có thể chọn thực hiện việc chuẩn bị dữ liệu và kỹ thuật tính năng trong nội bộ bằng cách sử dụng các mô hình lập trình khác nhau. Tuy nhiên, nó đòi hỏi sự đầu tư về thời gian và công sức vào việc cài đặt cũng như cấu hình các thư viện và khung, điều này không lý tưởng vì thời gian đó có thể được sử dụng tốt hơn để tối ưu hóa hiệu suất mô hình.

Trình sắp xếp dữ liệu Amazon SageMaker đơn giản hóa quá trình chuẩn bị dữ liệu và quy trình kỹ thuật tính năng, giảm thời gian tổng hợp và chuẩn bị dữ liệu cho ML từ vài tuần xuống còn vài phút bằng cách cung cấp một giao diện trực quan duy nhất để các nhà khoa học dữ liệu chọn, làm sạch và khám phá bộ dữ liệu của họ. Data Wrangler cung cấp hơn 300 phép biến đổi dữ liệu tích hợp để giúp chuẩn hóa, chuyển đổi và kết hợp các tính năng mà không cần viết bất kỳ mã nào. Bạn có thể nhập dữ liệu từ nhiều nguồn dữ liệu, chẳng hạn như Dịch vụ lưu trữ đơn giản của Amazon (Amazon S3), amazon Athena, Amazon RedShiftvà Snowflake. Bây giờ bạn cũng có thể sử dụng Bảng dữ liệu làm nguồn dữ liệu trong Data Wrangler để dễ dàng chuẩn bị dữ liệu cho ML.

Nền tảng Databricks Lakehouse kết hợp các yếu tố tốt nhất của hồ dữ liệu và kho dữ liệu để mang lại độ tin cậy, khả năng quản trị và hiệu suất mạnh mẽ của kho dữ liệu với tính mở, tính linh hoạt và hỗ trợ học máy của hồ dữ liệu. Với Databricks làm nguồn dữ liệu cho Data Wrangler, giờ đây bạn có thể kết nối nhanh chóng và dễ dàng với Databricks, truy vấn tương tác dữ liệu được lưu trữ trong Databricks bằng SQL và xem trước dữ liệu trước khi nhập. Ngoài ra, bạn có thể kết hợp dữ liệu của mình trong Databricks với dữ liệu được lưu trữ trong Amazon S3 và dữ liệu được truy vấn thông qua Amazon Athena, Amazon Redshift và Snowflake để tạo tập dữ liệu phù hợp cho trường hợp sử dụng ML của bạn.

Trong bài đăng này, chúng tôi chuyển đổi tập dữ liệu Lending Club Loan bằng cách sử dụng Amazon SageMaker Data Wrangler để sử dụng trong đào tạo mô hình ML.

Tổng quan về giải pháp

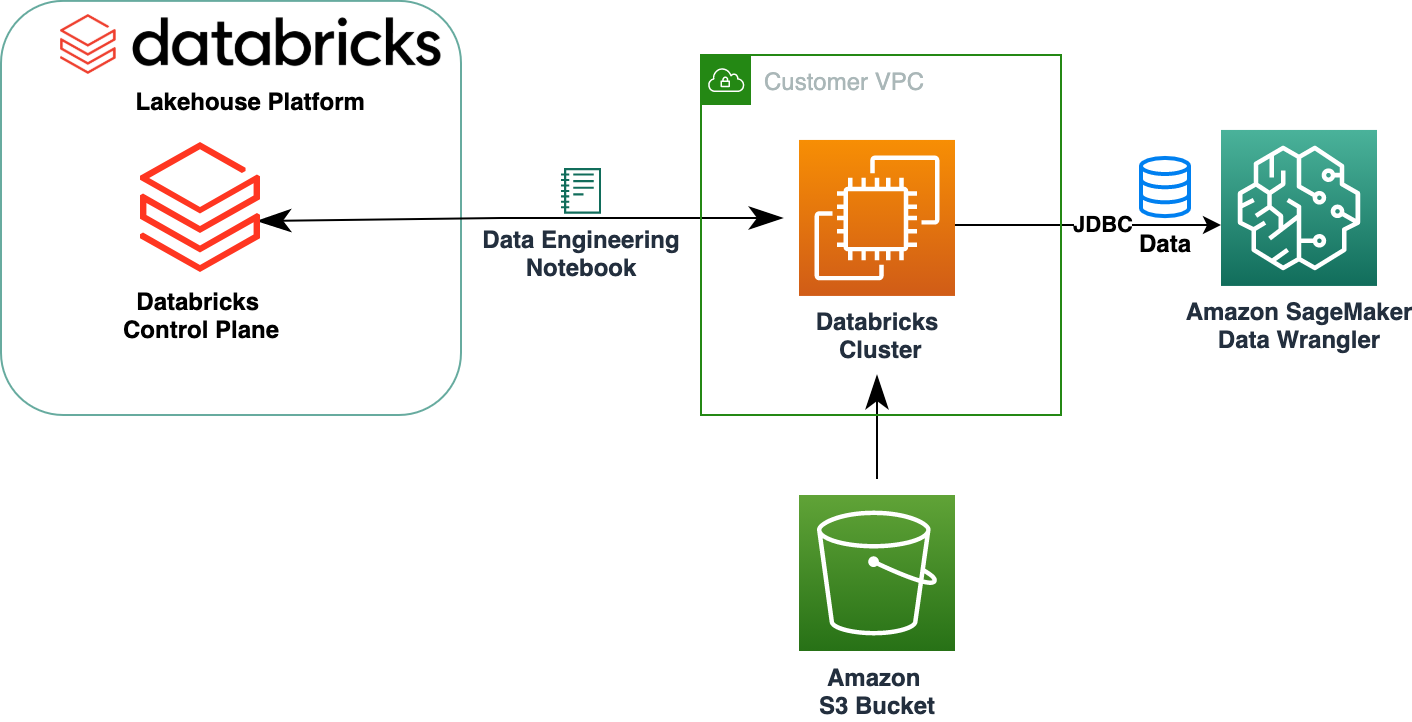

Sơ đồ sau minh họa kiến trúc giải pháp của chúng tôi.

Bộ dữ liệu Khoản vay Câu lạc bộ Cho vay chứa dữ liệu khoản vay hoàn chỉnh cho tất cả các khoản vay được phát hành trong năm 2007–2011, bao gồm trạng thái khoản vay hiện tại và thông tin thanh toán mới nhất. Nó có 39,717 hàng, 22 cột tính năng và 3 nhãn mục tiêu.

Để chuyển đổi dữ liệu của chúng tôi bằng Data Wrangler, chúng tôi hoàn thành các bước cấp cao sau:

- Tải xuống và chia tập dữ liệu.

- Tạo luồng Data Wrangler.

- Nhập dữ liệu từ Databricks vào Data Wrangler.

- Nhập dữ liệu từ Amazon S3 vào Data Wrangler.

- Tham gia dữ liệu.

- Áp dụng các phép biến đổi

- Xuất tập dữ liệu.

Điều kiện tiên quyết

Bài đăng giả định rằng bạn có cụm Databricks đang chạy. Nếu cụm của bạn đang chạy trên AWS, hãy xác minh rằng bạn đã cấu hình như sau:

Thiết lập dữ liệu

- An hồ sơ cá thể với các quyền cần thiết để truy cập nhóm S3

- A chính sách xô với các quyền cần thiết cho nhóm S3 mục tiêu

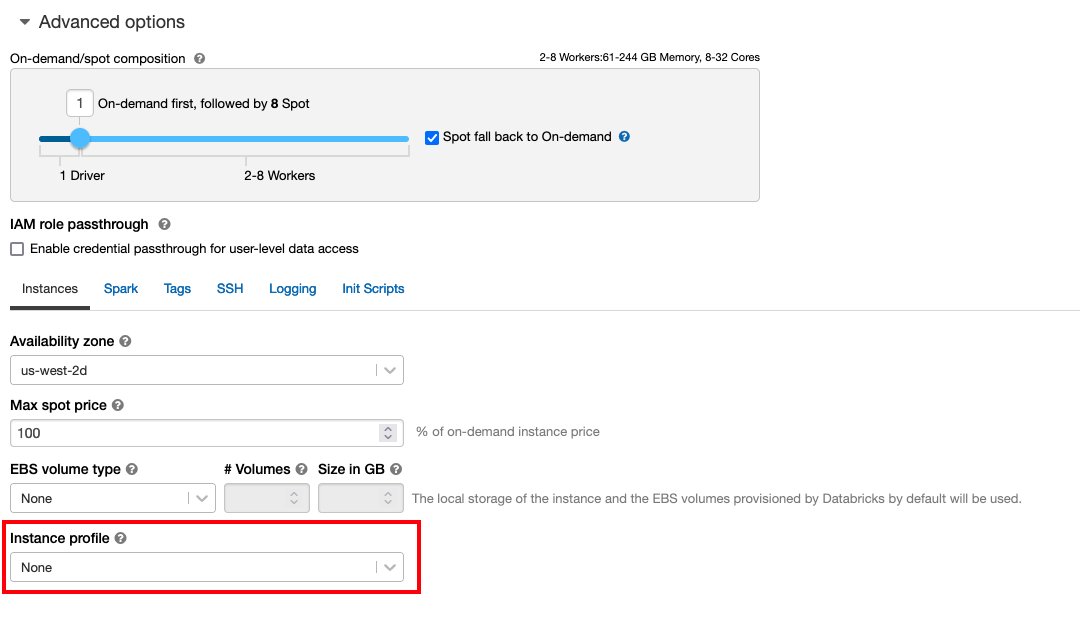

Theo Truy cập an toàn vào nhóm S3 bằng hồ sơ phiên bản cho yêu cầu Quản lý truy cập và nhận dạng AWS (IAM), chính sách bộ chứa S3 và cấu hình cụm Databricks. Đảm bảo cụm Databricks được cấu hình với đúng Instance Profile, được chọn trong các tùy chọn nâng cao, để truy cập vào nhóm S3 mong muốn.

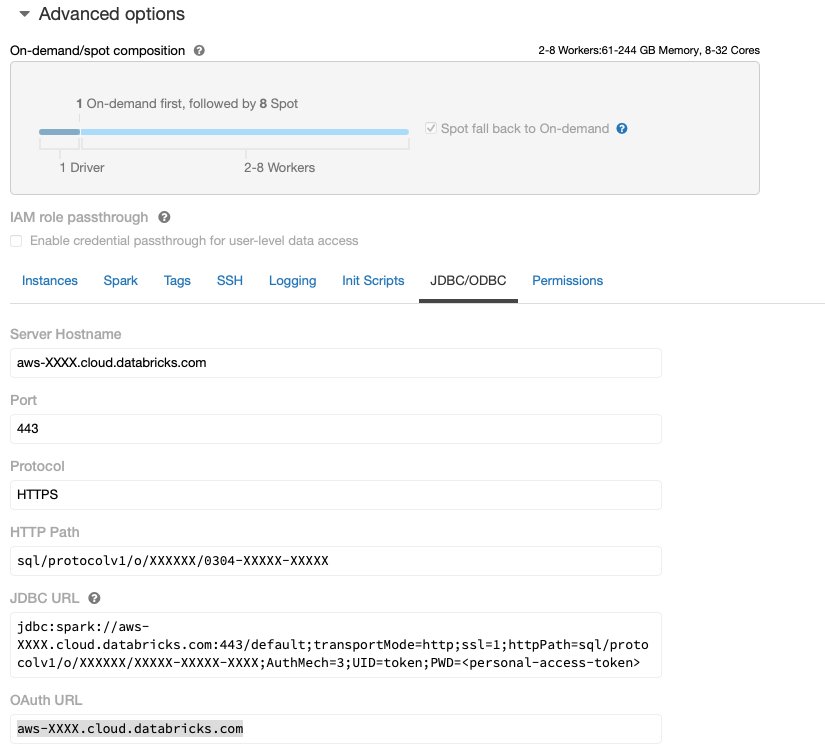

Sau khi cụm Databricks thiết lập và chạy với quyền truy cập cần thiết vào Amazon S3, bạn có thể tìm nạp JDBC URL từ cụm Databricks của bạn để Data Wrangler sử dụng để kết nối với nó.

Tìm nạp URL JDBC

Để tìm nạp URL JDBC, hãy hoàn thành các bước sau:

- Trong Databricks, điều hướng đến giao diện người dùng của cụm.

- Chọn cụm của bạn.

- trên Cấu hình tab, chọn Tùy chọn cấp cao.

- Theo Tùy chọn cấp cao, chọn JDBC/ODBC tab.

- Sao chép URL JDBC.

Đảm bảo thay thế quyền truy cập cá nhân của bạn mã thông báo trong URL.

Thiết lập Data Wrangler

Bước này giả sử bạn có quyền truy cập vào Amazon SageMaker, một phiên bản của Xưởng sản xuất Amazon SageMakervà một người dùng Studio.

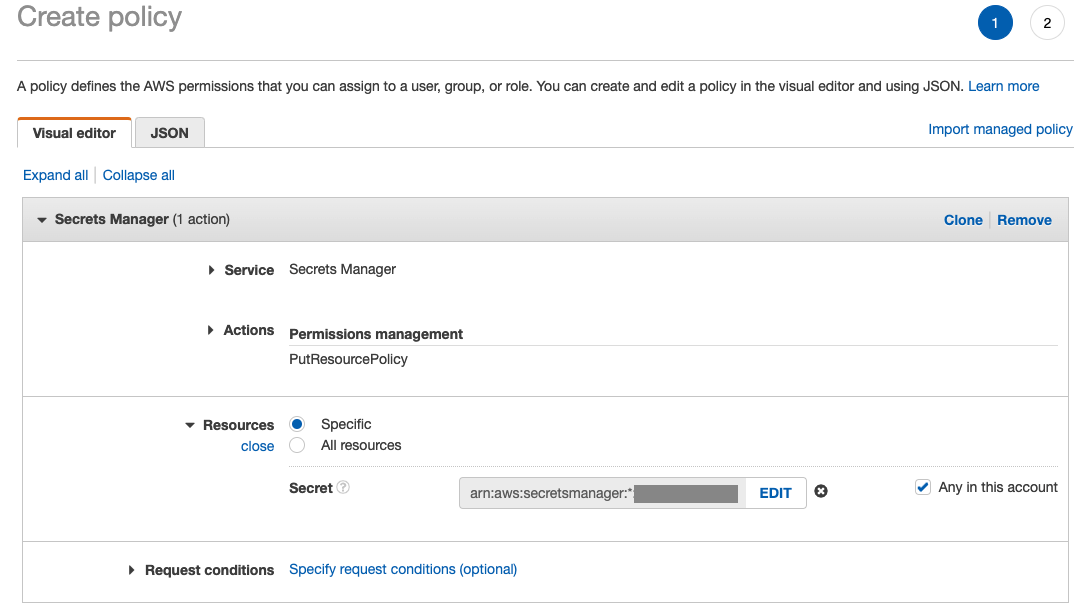

Để cho phép truy cập vào kết nối Databricks JDBC từ Data Wrangler, người dùng Studio cần có quyền sau:

secretsmanager:PutResourcePolicy

Hãy làm theo các bước bên dưới để cập nhật vai trò thực thi IAM được chỉ định cho người dùng Studio có quyền ở trên, với tư cách là người dùng quản trị IAM.

- Trên bảng điều khiển IAM, chọn Vai trò trong khung điều hướng.

- Chọn vai trò được chỉ định cho người dùng Studio của bạn.

- Chọn Thêm quyền.

- Chọn Tạo chính sách nội tuyến.

- Đối với Dịch vụ, chọn Người quản lý bí mật.

- On Hoạt động, chọn Cấp độ truy cập.

- Chọn Quản lý quyền.

- Chọn Chính sách tài nguyên.

- Trong Thông tin, chọn Riêng và chọn Bất kỳ trong tài khoản này.

Tải xuống và chia tập dữ liệu

Bạn có thể bắt đầu bằng tải xuống tập dữ liệu. Với mục đích trình diễn, chúng tôi chia tập dữ liệu bằng cách sao chép các cột tính năng id, emp_title, emp_length, home_ownervà annual_inc để tạo ra một giây loan_2.csv tài liệu. Chúng tôi xóa các cột nói trên khỏi tệp khoản vay ban đầu ngoại trừ id cột và đổi tên tệp gốc thành loan_1.csv. Tải lên loan_1.csv tập tin để Bảng dữ liệu để tạo một bảng loans_1 và loan_2.csv trong thùng S3.

Tạo luồng Data Wrangler

Để biết thông tin về các điều kiện tiên quyết của Data Wrangler, hãy xem Bắt đầu với Data Wrangler.

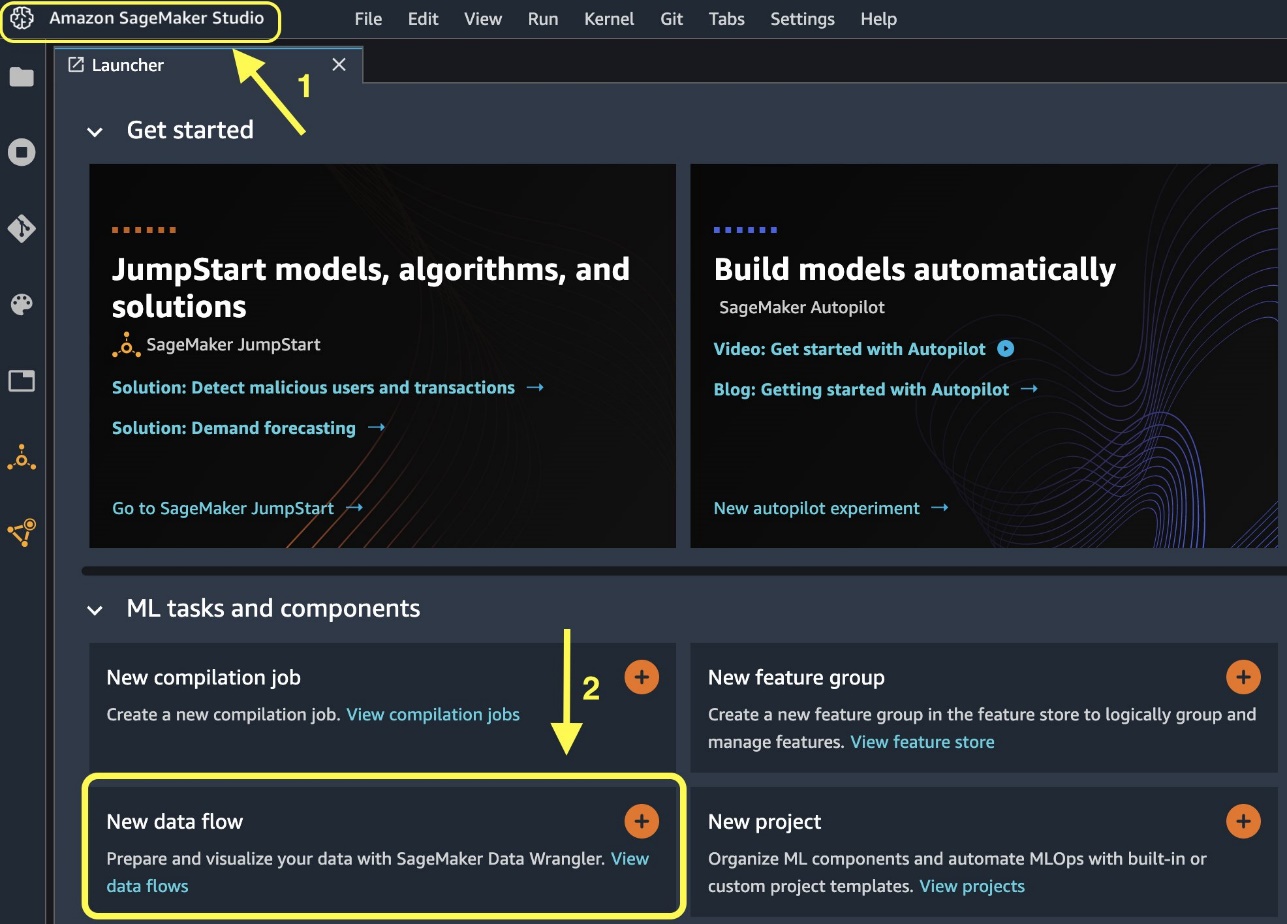

Hãy bắt đầu bằng cách tạo một luồng dữ liệu mới.

- Trên bảng điều khiển Studio, trên Tập tin menu, chọn Mới.

- Chọn Luồng Data Wrangler.

- Đổi tên luồng như mong muốn.

Ngoài ra, bạn có thể tạo luồng dữ liệu mới từ Trình khởi chạy.

- Trên bảng điều khiển Studio, hãy chọn Xưởng sản xuất Amazon SageMaker trong khung điều hướng.

- Chọn Luồng dữ liệu mới.

Việc tạo một luồng mới có thể mất vài phút để hoàn thành. Sau khi luồng đã được tạo, bạn sẽ thấy Nhập dữ liệu .

Nhập dữ liệu từ Databricks vào Data Wrangler

Tiếp theo, chúng tôi thiết lập Databricks (JDBC) làm nguồn dữ liệu trong Data Wrangler. Để nhập dữ liệu từ Databricks, trước tiên chúng ta cần thêm Databricks làm nguồn dữ liệu.

- trên Nhập dữ liệu tab của luồng Data Wrangler của bạn, hãy chọn Thêm nguồn dữ liệu.

- Trên menu thả xuống, hãy chọn Cơ sở dữ liệu (JDBC).

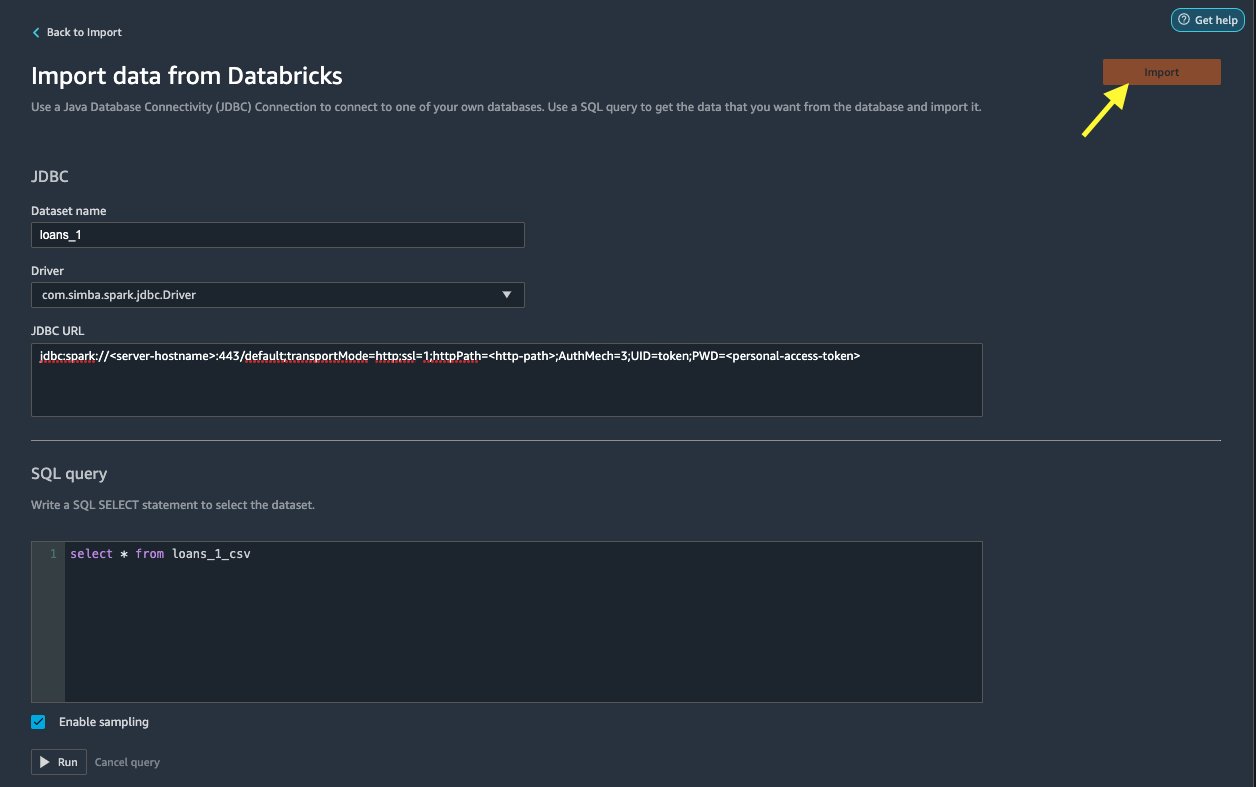

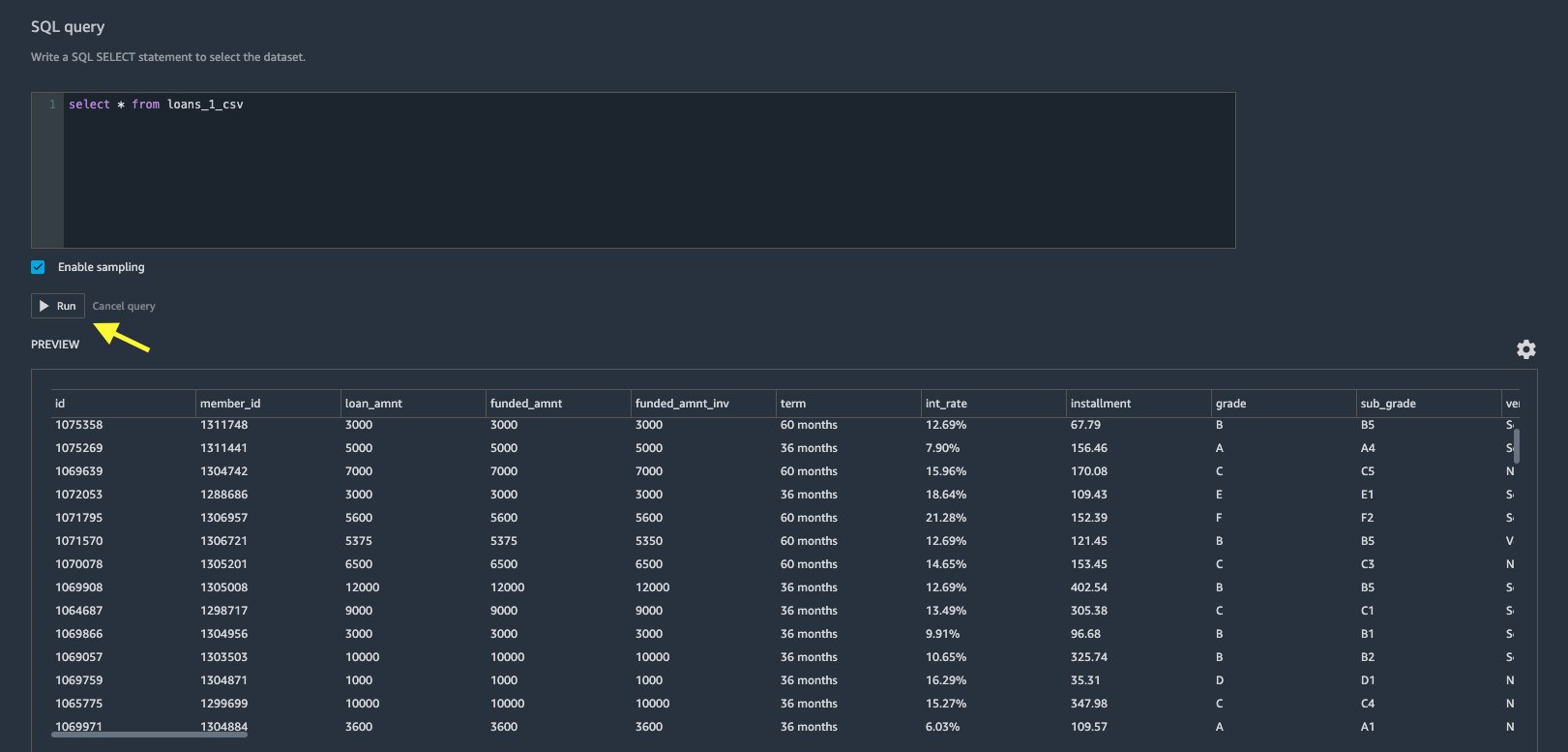

trên Nhập dữ liệu từ Databricks trang, bạn nhập chi tiết cụm của bạn.

- Trong Tên tập dữ liệu, hãy nhập tên bạn muốn sử dụng trong tệp luồng.

- Trong Người lái xe, chọn trình điều khiển

com.simba.spark.jdbc.Driver. - Trong URL JDBC, hãy nhập URL của cụm Databricks thu được trước đó.

URL phải giống định dạng sau jdbc:spark://<serve- hostname>:443/default;transportMode=http;ssl=1;httpPath=<http- path>;AuthMech=3;UID=token;PWD=<personal-access-token>.

- Trong trình soạn thảo truy vấn SQL, hãy chỉ định câu lệnh SQL SELECT sau:

Nếu bạn chọn tên bảng khác trong khi tải dữ liệu lên Databricks, hãy thay thế loan_1 trong truy vấn SQL ở trên cho phù hợp.

Trong tạp chí Truy vấn SQL trong Data Wrangler, bạn có thể truy vấn bất kỳ bảng nào được kết nối với cơ sở dữ liệu JDBC Databricks. Đã chọn trước Cho phép lấy mẫu cài đặt truy xuất 50,000 hàng đầu tiên của tập dữ liệu của bạn theo mặc định. Tùy thuộc vào kích thước của tập dữ liệu, việc bỏ chọn Cho phép lấy mẫu có thể dẫn đến thời gian nhập khẩu lâu hơn.

- Chọn chạy.

Việc chạy truy vấn sẽ cung cấp bản xem trước tập dữ liệu Databricks của bạn trực tiếp trong Data Wrangler.

Data Wrangler cung cấp tính linh hoạt để thiết lập nhiều kết nối đồng thời với một cụm Databricks hoặc nhiều cụm nếu được yêu cầu, cho phép phân tích và chuẩn bị trên các bộ dữ liệu kết hợp.

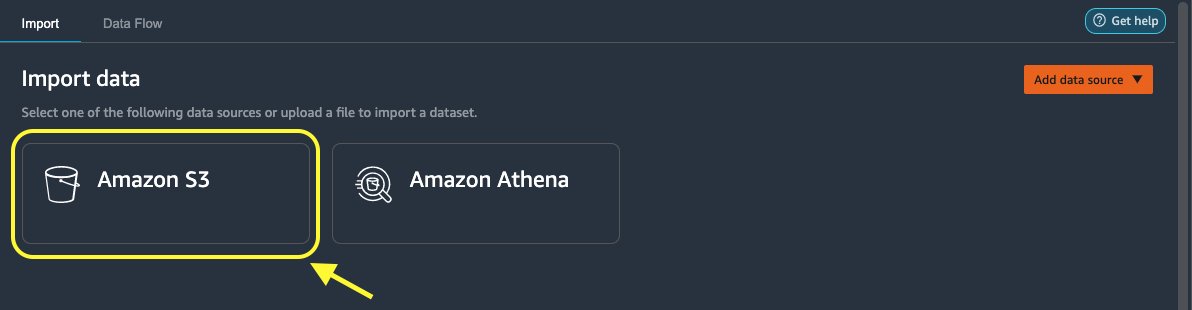

Nhập dữ liệu từ Amazon S3 vào Data Wrangler

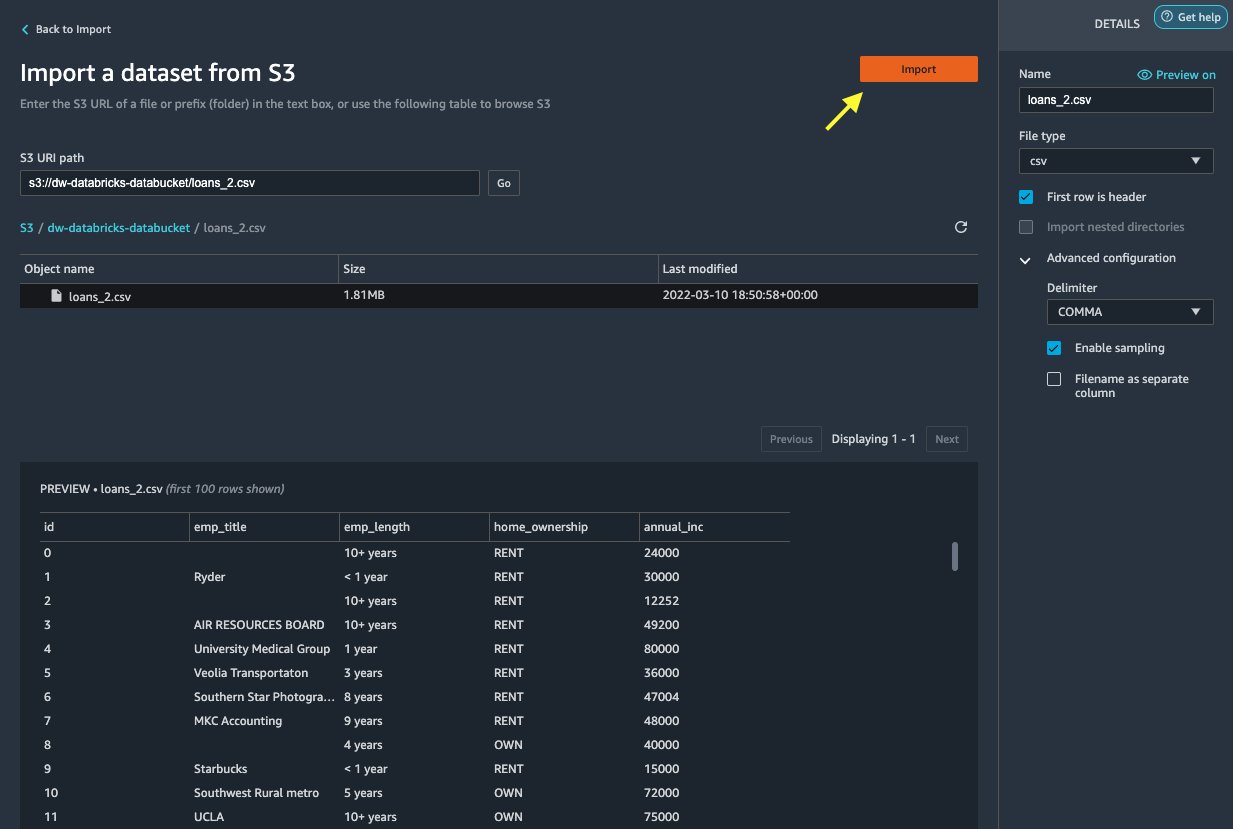

Tiếp theo, hãy nhập loan_2.csv tập tin từ Amazon S3.

Khi chọn tệp CSV, bạn có thể xem trước dữ liệu.

- Trong tạp chí Chi tiết ngăn, chọn Cấu hình nâng cao để chắc chắn Cho phép lấy mẫu được chọn và ĐOẠN VĂN được chọn cho Dấu phân cách.

- Chọn Nhập khẩu.

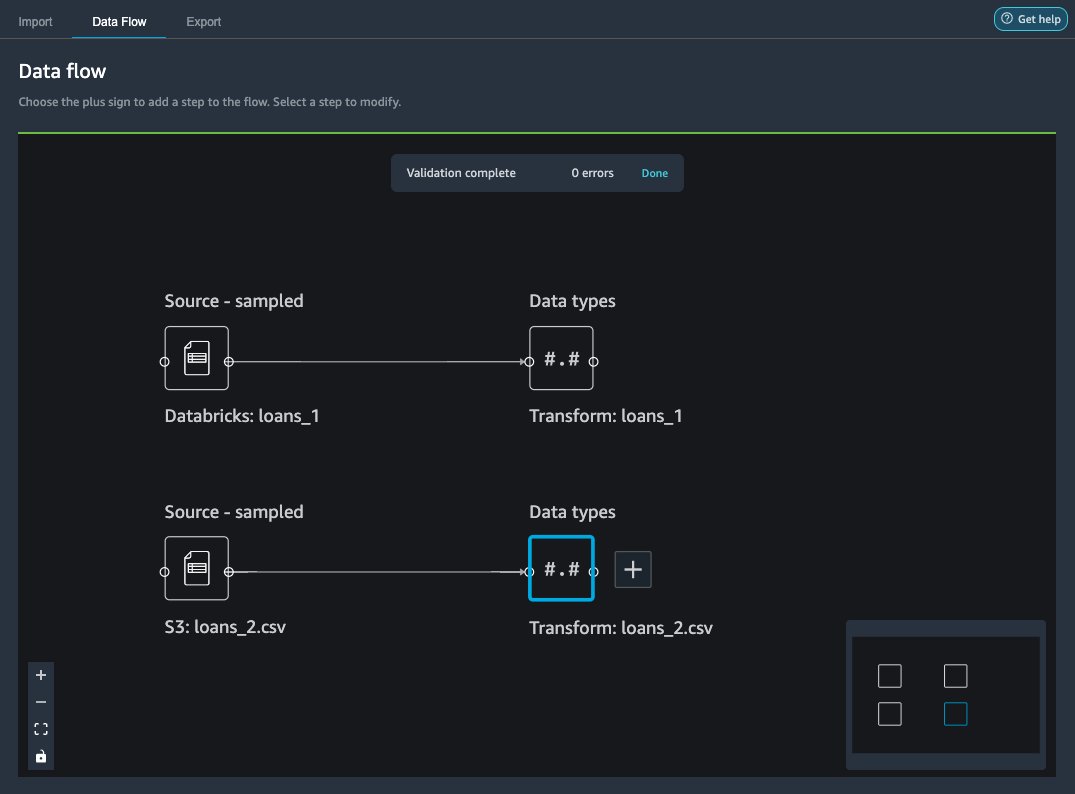

Sau loans_2.csv tập dữ liệu được nhập thành công, giao diện luồng dữ liệu sẽ hiển thị cả nguồn dữ liệu Databricks JDBC và Amazon S3.

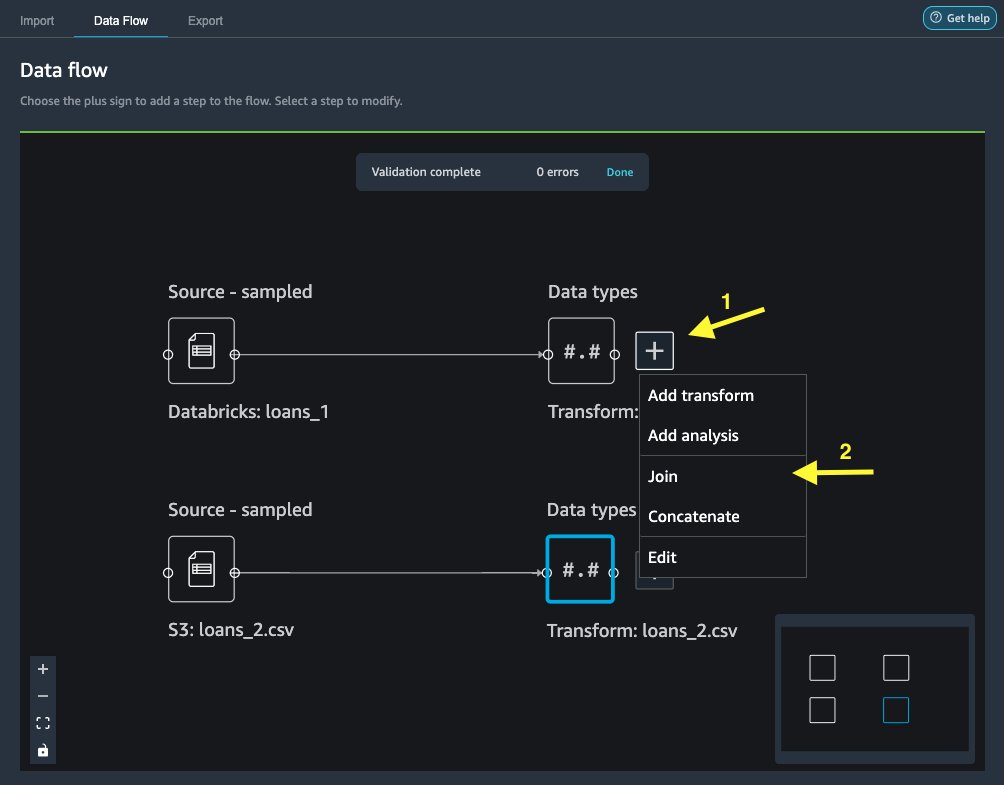

Tham gia dữ liệu

Bây giờ chúng ta đã nhập dữ liệu từ Databricks và Amazon S3, hãy tham gia các tập dữ liệu bằng cách sử dụng cột mã định danh duy nhất chung.

- trên Dòng dữ liệu tab, cho Loại dữ liệu, chọn dấu cộng cho

loans_1. - Chọn Tham gia.

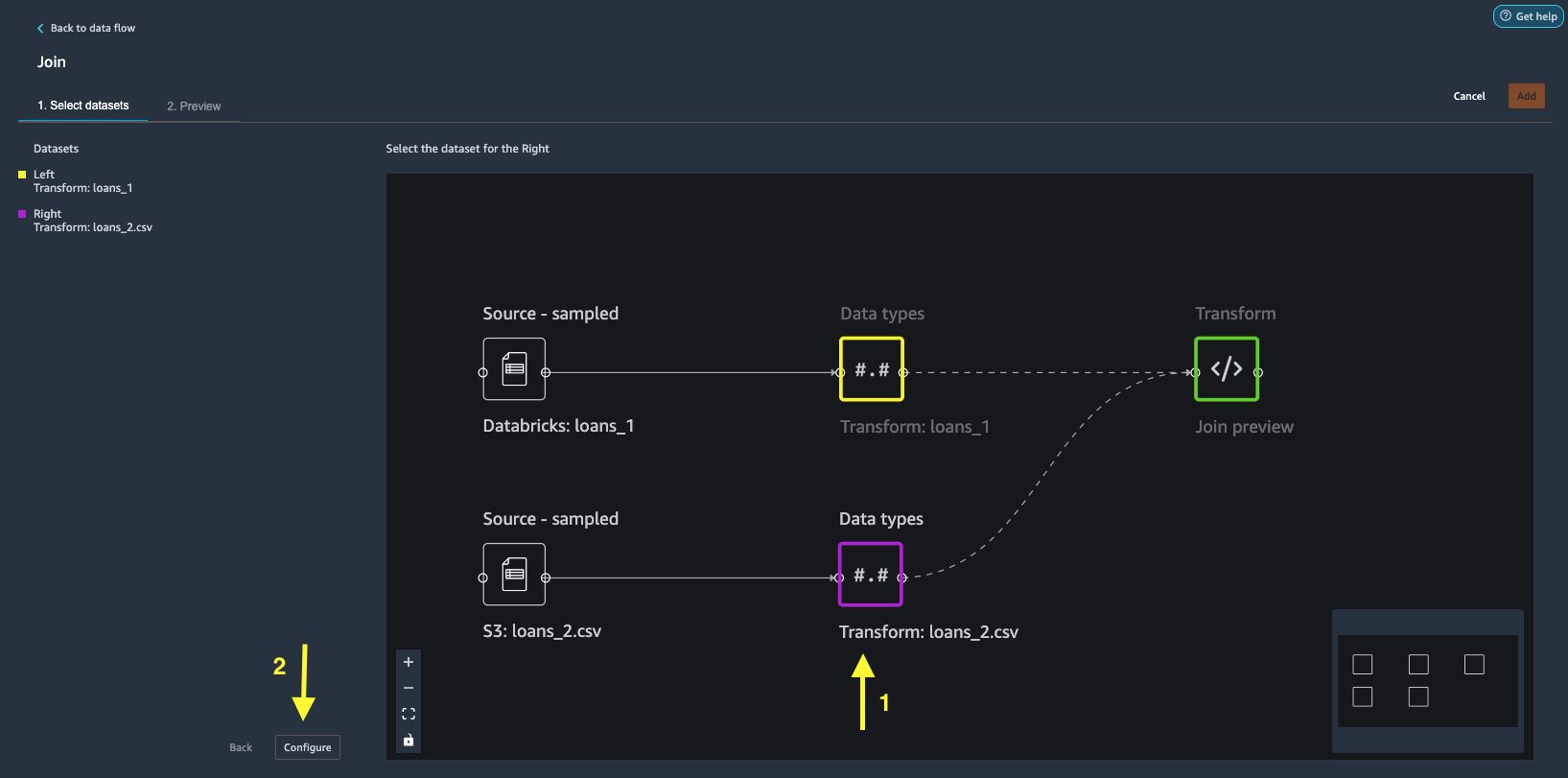

- Chọn

loans_2.csvtập tin như Đúng tập dữ liệu. - Chọn Thiết lập để thiết lập các tiêu chí tham gia.

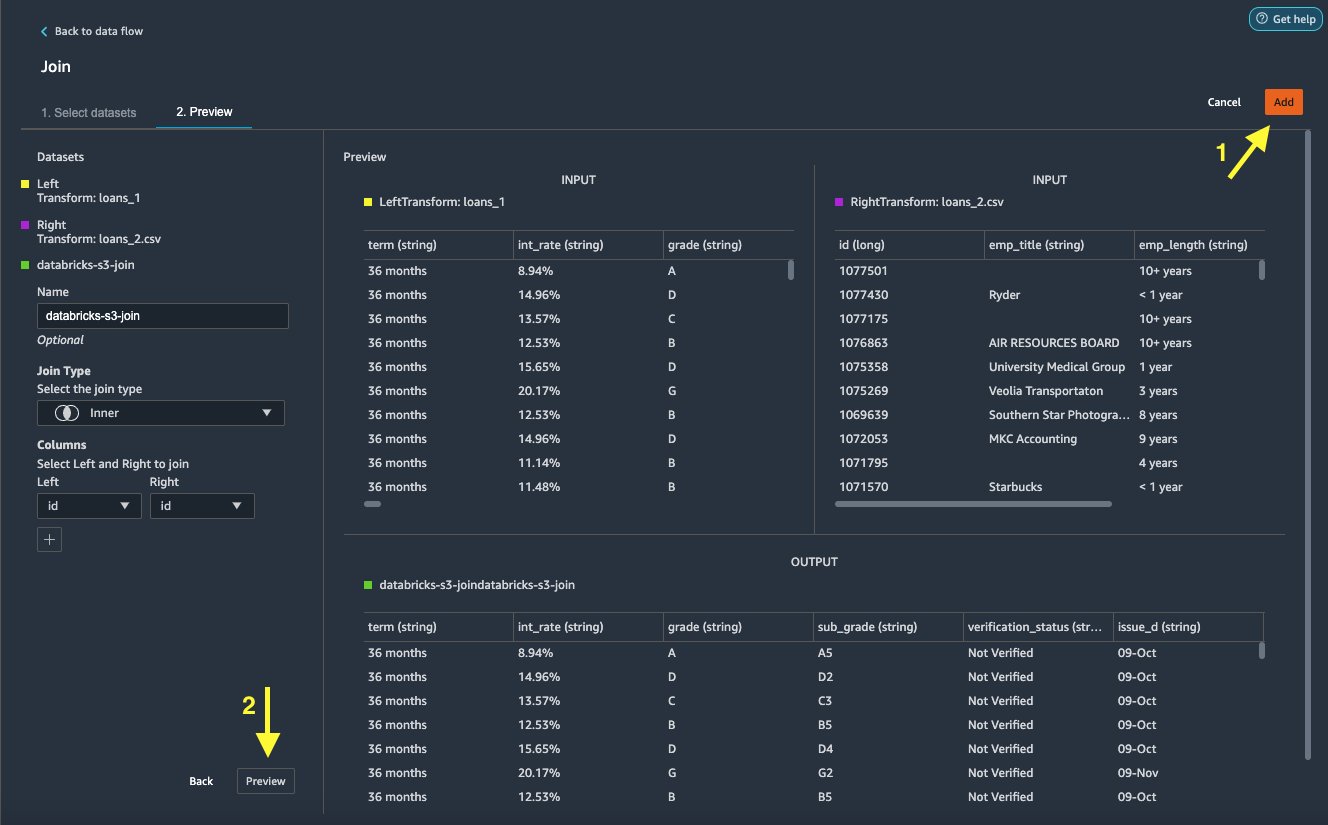

- Trong Họ tên, nhập tên cho tham gia.

- Trong Tham gia loại, chọn Bên trong cho bài đăng này.

- Chọn

idcột để tham gia vào. - Chọn Đăng Nhập để xem trước tập dữ liệu đã tham gia.

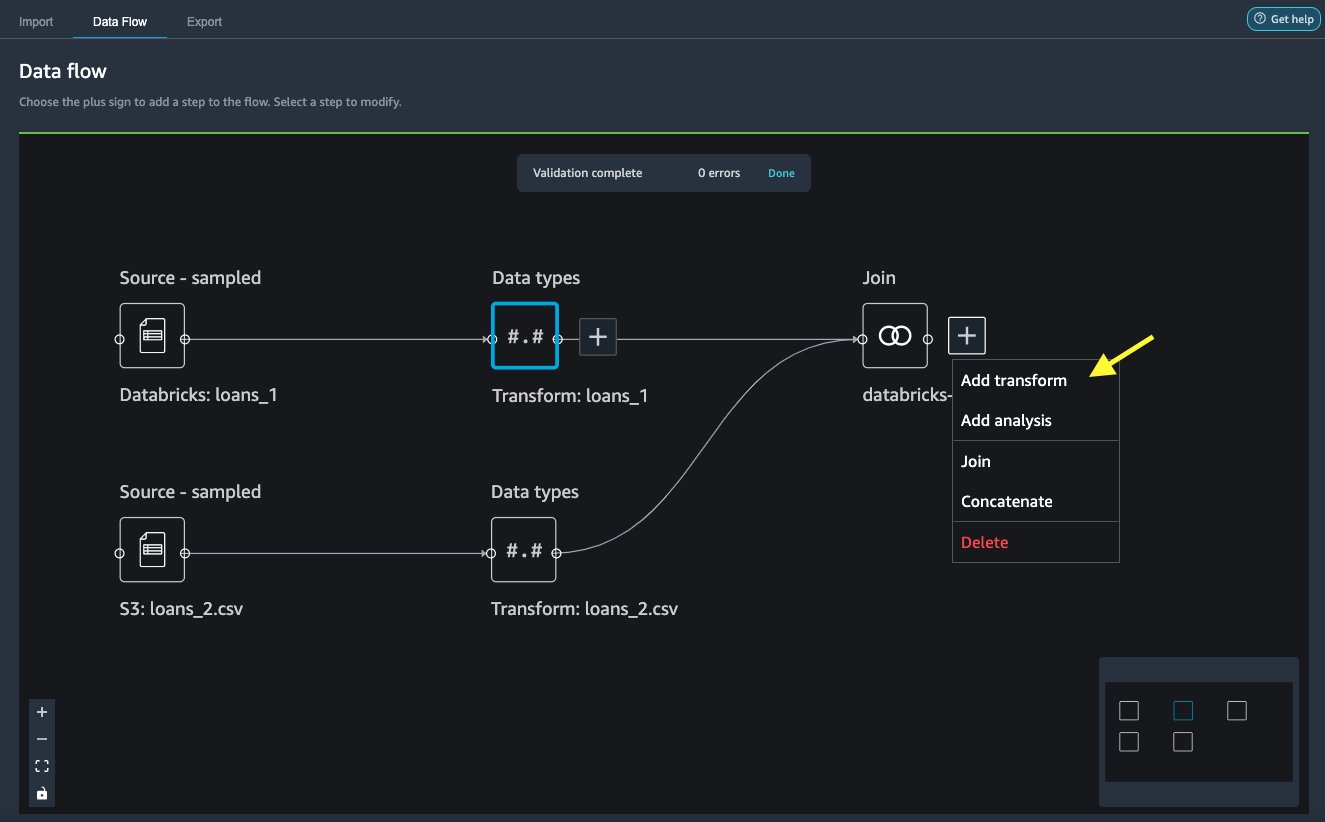

- Chọn Thêm để thêm nó vào luồng dữ liệu.

Áp dụng các phép biến đổi

Data Wrangler đi kèm với hơn 300 phép biến đổi tích hợp, không cần mã hóa. Hãy sử dụng các phép biến đổi tích hợp để chuẩn bị tập dữ liệu.

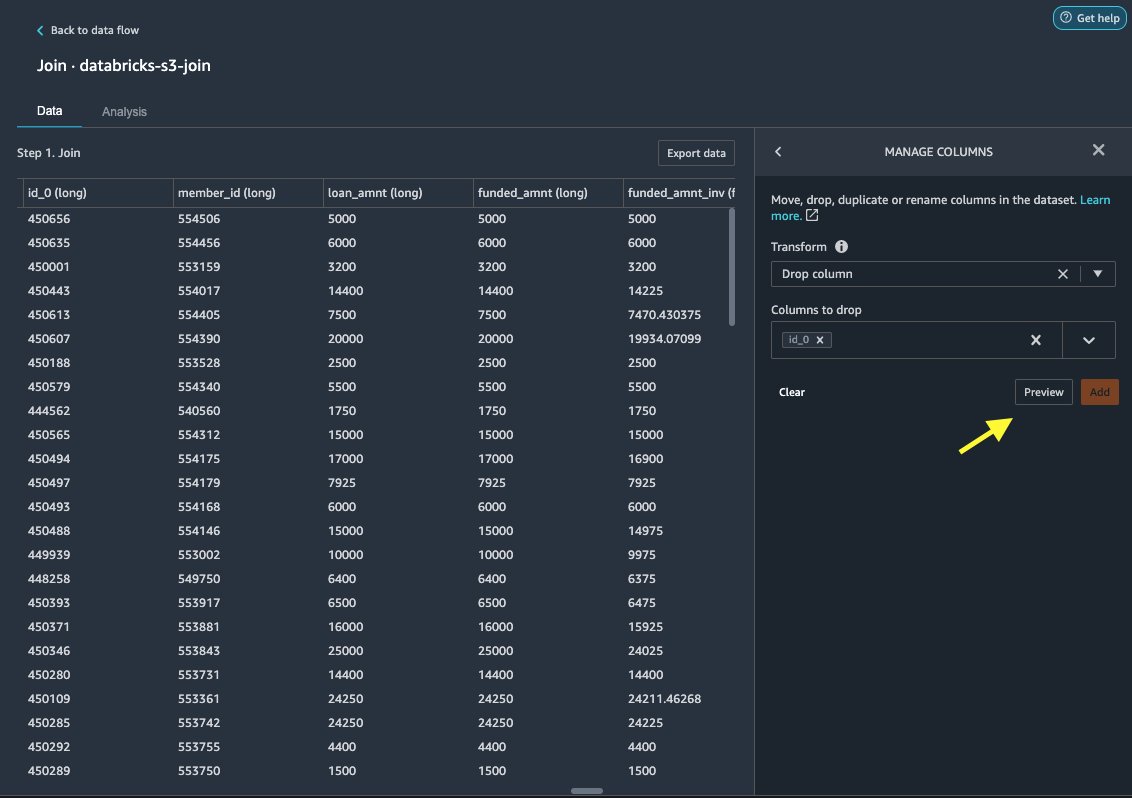

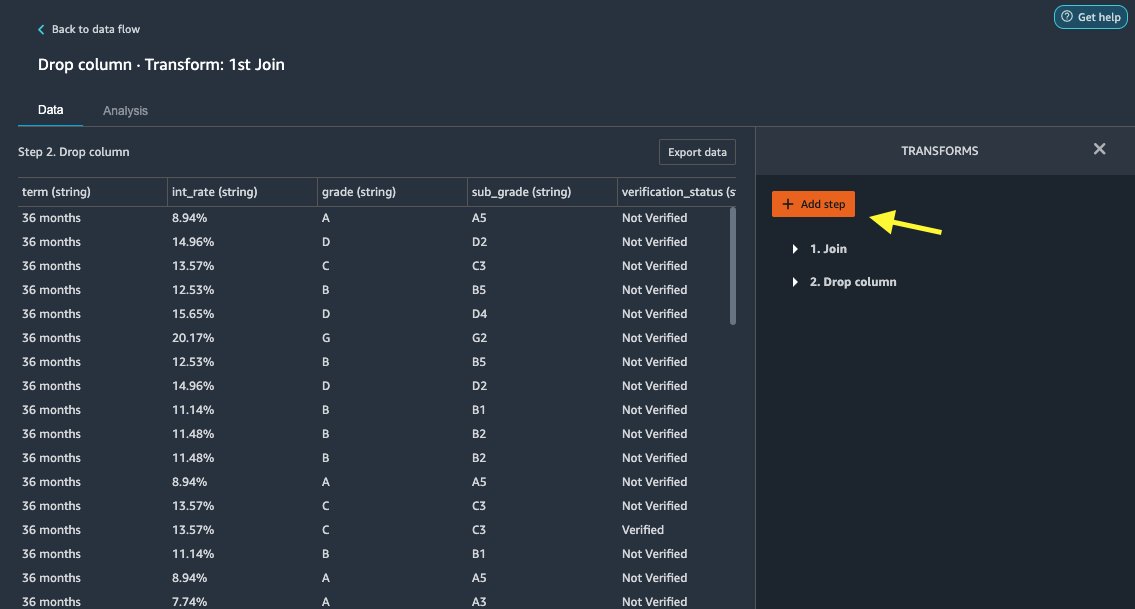

Thả cột

Đầu tiên chúng ta bỏ cột ID dư thừa.

- Trên nút đã nối, chọn dấu cộng.

- Chọn Thêm biến đổi.

- Theo Biến đổi, chọn + Thêm bước.

- Chọn Quản lý các cột.

- Trong Chuyển đổi, chọn Thả cột.

- Trong Các cột để thả, chọn cột

id_0. - Chọn Xem trước.

- Chọn Thêm.

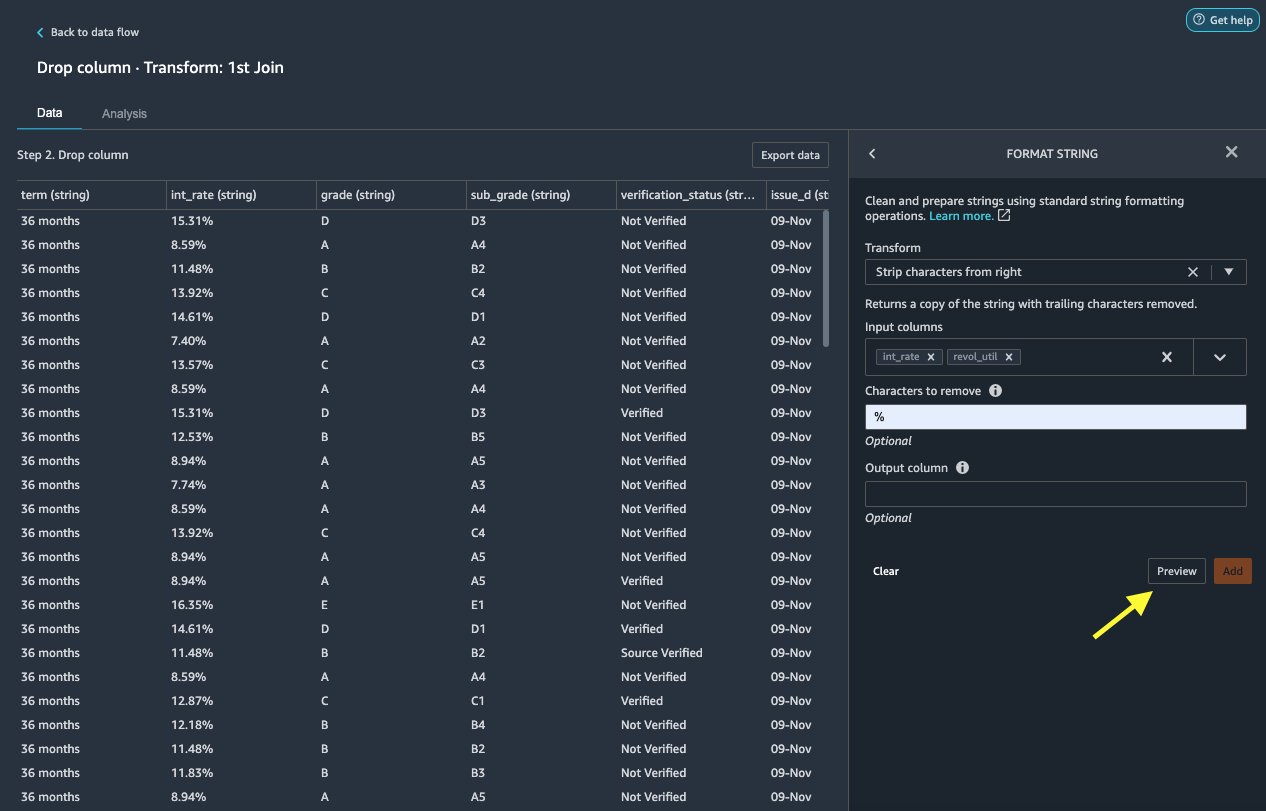

Định dạng chuỗi

Hãy áp dụng định dạng chuỗi để loại bỏ ký hiệu phần trăm khỏi int_rate và revol_util cột.

- trên Ngày tab, dưới Biến đổi, chọn + Thêm bước.

- Chọn Định dạng chuỗi.

- Trong Chuyển đổi, chọn Tách ký tự từ bên phải.

Data Wrangler cho phép bạn áp dụng chuyển đổi đã chọn trên nhiều cột cùng một lúc.

- Trong Các cột đầu vào, chọn

int_ratevàrevol_util. - Trong Ký tự cần loại bỏ, đi vào

%. - Chọn Xem trước.

- Chọn Thêm.

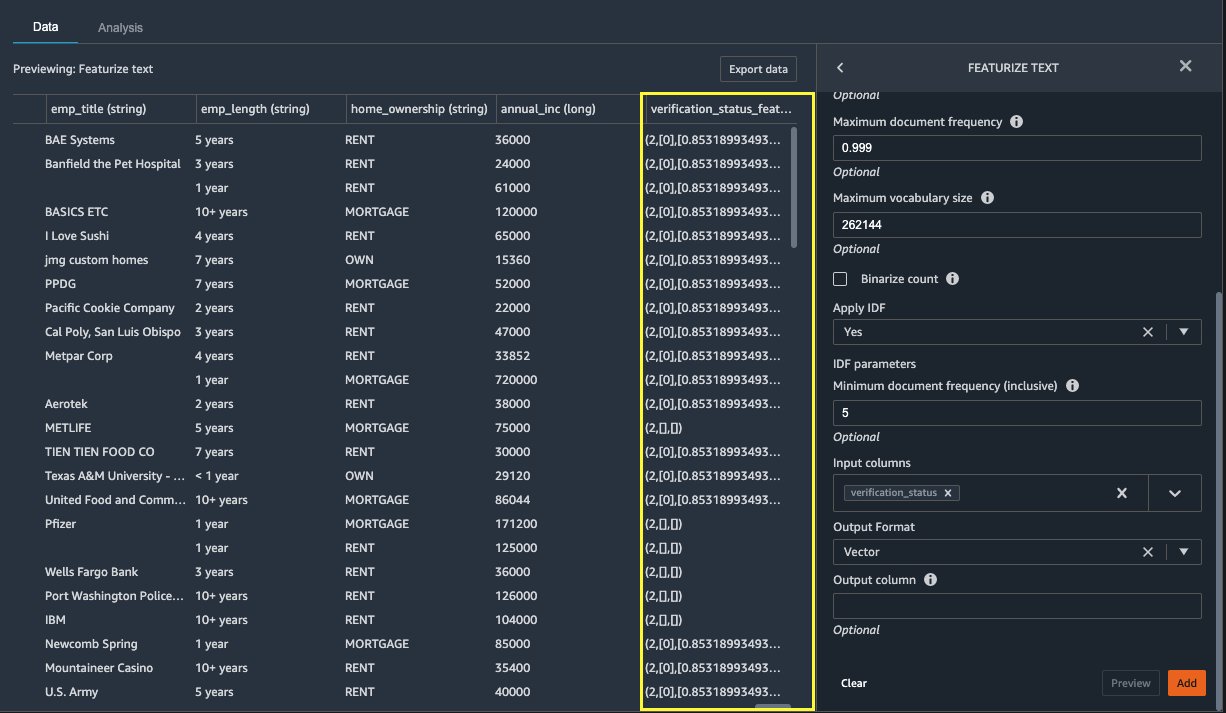

Làm nổi bật văn bản

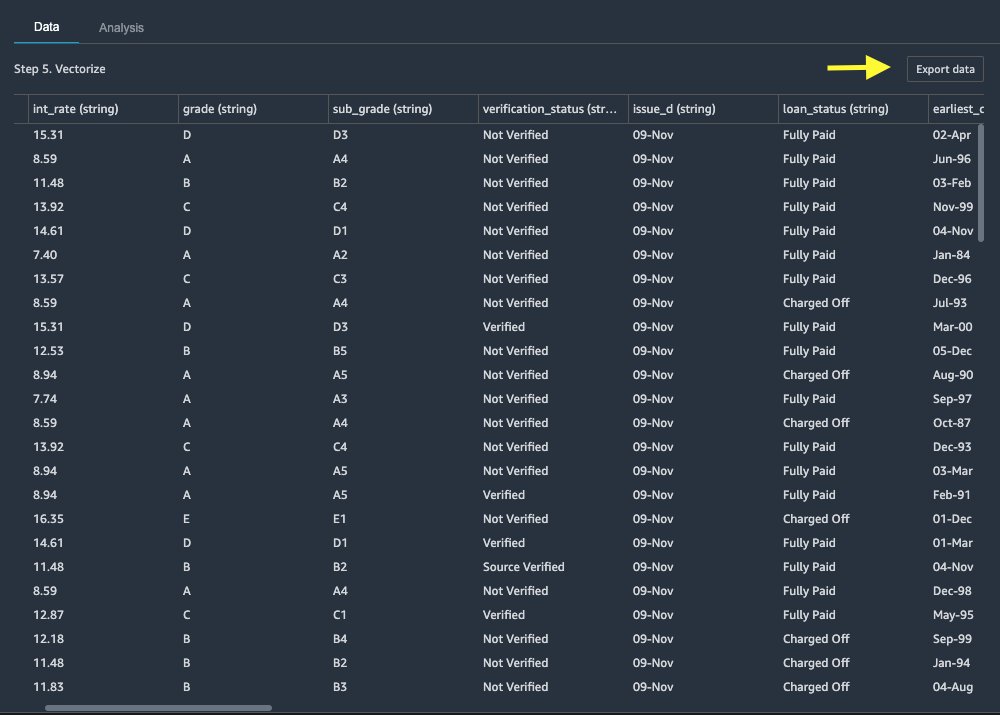

Bây giờ chúng ta hãy vector hóa verification_status, một cột tính năng văn bản. Chúng tôi chuyển đổi cột văn bản thành các vectơ tần số nghịch đảo tần số tài liệu (TF-IDF) bằng cách áp dụng vectơ đếm và mã thông báo tiêu chuẩn như được mô tả bên dưới. Data Wrangler cũng cung cấp tùy chọn mang theo mã thông báo của riêng bạn nếu muốn.

- Theo Máy biến áp, chọn + Thêm bước.

- Chọn Làm nổi bật văn bản.

- Trong Chuyển đổi, chọn vectơ hóa.

- Trong Các cột đầu vào, chọn

verification_status. - Chọn Xem trước.

- Chọn Thêm.

Xuất tập dữ liệu

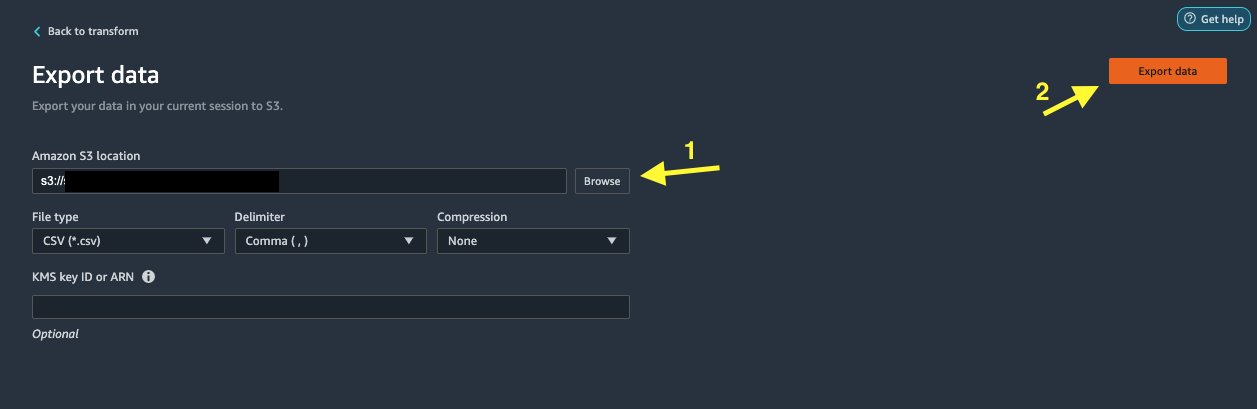

Sau khi áp dụng nhiều phép biến đổi trên các loại cột khác nhau, bao gồm văn bản, phân loại và số, chúng tôi sẵn sàng sử dụng tập dữ liệu đã chuyển đổi để đào tạo mô hình ML. Bước cuối cùng là xuất tập dữ liệu đã chuyển đổi sang Amazon S3. Trong Data Wrangler, bạn có nhiều tùy chọn để lựa chọn cho việc sử dụng các phép biến đổi ở cuối dòng:

- Chọn Bước xuất để tự động tạo sổ ghi chép Jupyter với mã Xử lý SageMaker để xử lý và xuất tập dữ liệu đã chuyển đổi sang bộ chứa S3. Để biết thêm thông tin, xem Khởi chạy các công việc xử lý với một vài cú nhấp chuột bằng Amazon SageMaker Data Wrangler.

- Xuất sổ ghi chép Studio tạo ra một Đường dẫn SageMaker với luồng dữ liệu của bạn hoặc sổ ghi chép tạo ra Cửa hàng tính năng Amazon SageMaker nhóm tính năng và thêm các tính năng vào cửa hàng tính năng ngoại tuyến hoặc trực tuyến.

- Chọn Xuất dữ liệu để xuất trực tiếp sang Amazon S3.

Trong bài đăng này, chúng tôi tận dụng lợi thế của Xuất dữ liệu tùy chọn trong Chuyển đổi view để xuất trực tiếp tập dữ liệu đã chuyển đổi sang Amazon S3.

Làm sạch

Nếu công việc của bạn với Data Wrangler đã hoàn tất, tắt phiên bản Data Wrangler của bạn để tránh phát sinh thêm phí.

Kết luận

Trong bài đăng này, chúng tôi đã đề cập đến cách bạn có thể nhanh chóng và dễ dàng thiết lập và kết nối Databricks dưới dạng nguồn dữ liệu trong Data Wrangler, truy vấn tương tác dữ liệu được lưu trữ trong Databricks bằng SQL và xem trước dữ liệu trước khi nhập. Ngoài ra, chúng tôi đã xem xét cách bạn có thể kết hợp dữ liệu của mình trong Databricks với dữ liệu được lưu trữ trong Amazon S3. Sau đó, chúng tôi áp dụng các phép biến đổi dữ liệu trên tập dữ liệu kết hợp để tạo quy trình chuẩn bị dữ liệu. Để khám phá thêm các khả năng phân tích của Data Wrangler, bao gồm rò rỉ mục tiêu và tạo báo cáo sai lệch, hãy tham khảo bài đăng blog sau Tăng tốc chuẩn bị dữ liệu bằng cách sử dụng Amazon SageMaker Data Wrangler để dự đoán tỷ lệ đọc của bệnh nhân tiểu đường.

Để bắt đầu với Data Wrangler, hãy xem Chuẩn bị dữ liệu ML với Amazon SageMaker Data Wranglervà xem thông tin mới nhất về Data Wrangler trang sản phẩm.

Về các tác giả

Bains Roop là Kiến trúc sư giải pháp tại AWS tập trung vào AI / ML. Anh ấy đam mê giúp khách hàng đổi mới và đạt được các mục tiêu kinh doanh của họ bằng cách sử dụng Trí tuệ nhân tạo và Máy học. Khi rảnh rỗi, Roop thích đọc sách và đi bộ đường dài.

Bains Roop là Kiến trúc sư giải pháp tại AWS tập trung vào AI / ML. Anh ấy đam mê giúp khách hàng đổi mới và đạt được các mục tiêu kinh doanh của họ bằng cách sử dụng Trí tuệ nhân tạo và Máy học. Khi rảnh rỗi, Roop thích đọc sách và đi bộ đường dài.

Igor Alekseev là Kiến trúc sư giải pháp đối tác tại AWS về Dữ liệu và Phân tích. Igor làm việc với các đối tác chiến lược để giúp họ xây dựng các kiến trúc phức tạp, được tối ưu hóa AWS. Trước khi gia nhập AWS, với tư cách là Kiến trúc sư Giải pháp / Dữ liệu, anh đã thực hiện nhiều dự án về Dữ liệu lớn, bao gồm một số hồ dữ liệu trong hệ sinh thái Hadoop. Là một Kỹ sư dữ liệu, anh ấy đã tham gia vào việc áp dụng AI / ML để phát hiện gian lận và tự động hóa văn phòng. Các dự án của Igor thuộc nhiều lĩnh vực khác nhau bao gồm truyền thông, tài chính, an toàn công cộng, sản xuất và chăm sóc sức khỏe. Trước đó, Igor đã từng làm việc với tư cách là kỹ sư / trưởng nhóm công nghệ đầy đủ về ngăn xếp.

Igor Alekseev là Kiến trúc sư giải pháp đối tác tại AWS về Dữ liệu và Phân tích. Igor làm việc với các đối tác chiến lược để giúp họ xây dựng các kiến trúc phức tạp, được tối ưu hóa AWS. Trước khi gia nhập AWS, với tư cách là Kiến trúc sư Giải pháp / Dữ liệu, anh đã thực hiện nhiều dự án về Dữ liệu lớn, bao gồm một số hồ dữ liệu trong hệ sinh thái Hadoop. Là một Kỹ sư dữ liệu, anh ấy đã tham gia vào việc áp dụng AI / ML để phát hiện gian lận và tự động hóa văn phòng. Các dự án của Igor thuộc nhiều lĩnh vực khác nhau bao gồm truyền thông, tài chính, an toàn công cộng, sản xuất và chăm sóc sức khỏe. Trước đó, Igor đã từng làm việc với tư cách là kỹ sư / trưởng nhóm công nghệ đầy đủ về ngăn xếp.

Hương Nguyễn là Giám đốc Sản phẩm của Sr. tại AWS. Cô ấy đang dẫn đầu trải nghiệm người dùng cho SageMaker Studio. Cô đã có 13 năm kinh nghiệm tạo ra các sản phẩm hướng đến khách hàng và dựa trên dữ liệu cho cả không gian doanh nghiệp và người tiêu dùng. Khi rảnh rỗi, cô thích đọc sách, hòa mình vào thiên nhiên và dành thời gian cho gia đình.

Hương Nguyễn là Giám đốc Sản phẩm của Sr. tại AWS. Cô ấy đang dẫn đầu trải nghiệm người dùng cho SageMaker Studio. Cô đã có 13 năm kinh nghiệm tạo ra các sản phẩm hướng đến khách hàng và dựa trên dữ liệu cho cả không gian doanh nghiệp và người tiêu dùng. Khi rảnh rỗi, cô thích đọc sách, hòa mình vào thiên nhiên và dành thời gian cho gia đình.

Henry Vương là kỹ sư phát triển phần mềm tại AWS. Gần đây anh ấy đã gia nhập nhóm Data Wrangler sau khi tốt nghiệp UC Davis. Anh ấy quan tâm đến khoa học dữ liệu và học máy và in 3D như một sở thích.

Henry Vương là kỹ sư phát triển phần mềm tại AWS. Gần đây anh ấy đã gia nhập nhóm Data Wrangler sau khi tốt nghiệp UC Davis. Anh ấy quan tâm đến khoa học dữ liệu và học máy và in 3D như một sở thích.

- Coinsmart. Sàn giao dịch Bitcoin và tiền điện tử tốt nhất Châu Âu.

- Platoblockchain. Web3 Metaverse Intelligence. Khuếch đại kiến thức. TRUY CẬP MIỄN PHÍ.

- CryptoHawk. Radar Altcoin. Dùng thử miễn phí.

- Nguồn: https://aws.amazon.com/blogs/machine-learning/prepare-data-from-databricks-for-machine-learning-USE-amazon-sagemaker-data-wrangler/

- "

- 000

- 100

- 39

- 3d

- Giới thiệu

- truy cập

- chứa

- thêm vào

- tiên tiến

- Lợi thế

- thuật toán

- Tất cả

- đàn bà gan dạ

- phân tích

- phân tích

- Nộp đơn

- kiến trúc

- nhân tạo

- trí tuệ nhân tạo

- Trí tuệ nhân tạo và học máy

- giao

- Tự động hóa

- AWS

- được

- BEST

- Dữ Liệu Lớn.

- Blog

- biên giới

- xây dựng

- được xây dựng trong

- kinh doanh

- khả năng

- trường hợp

- Chọn

- Làm sạch

- câu lạc bộ

- mã

- Lập trình

- Cột

- kết hợp

- Chung

- Truyền thông

- phức tạp

- Cấu hình

- kết nối

- liên quan

- Kết nối

- xem xét

- An ủi

- hợp nhất

- người tiêu dùng

- tiêu thụ

- chứa

- tạo ra

- tạo ra

- Tạo

- Current

- khách hàng

- dữ liệu

- khoa học dữ liệu

- Cơ sở dữ liệu

- chậm trễ

- Tùy

- Phát hiện

- Phát triển

- khác nhau

- trực tiếp

- màn hình

- xuống

- trình điều khiển

- Rơi

- dễ dàng

- hệ sinh thái

- biên tập viên

- cho phép

- cho phép

- ky sư

- Kỹ Sư

- đăng ký hạng mục thi

- Doanh nghiệp

- ví dụ

- Trừ

- thực hiện

- kinh nghiệm

- khám phá

- gia đình

- Đặc tính

- Tính năng

- Lệ Phí

- tài chính

- Tên

- Linh hoạt

- dòng chảy

- tiếp theo

- định dạng

- gian lận

- Full

- tạo ra

- thế hệ

- tốt

- quản trị

- Nhóm

- chăm sóc sức khỏe

- giúp đỡ

- Độ đáng tin của

- HTTPS

- Bản sắc

- thực hiện

- quan trọng

- nhập khẩu

- Bao gồm

- các ngành công nghiệp

- thông tin

- những hiểu biết

- Sự thông minh

- quan tâm

- Giao thức

- đầu tư

- tham gia

- IT

- việc làm

- tham gia

- gia nhập

- Nhãn

- Ngôn ngữ

- mới nhất

- dẫn

- hàng đầu

- học tập

- cho vay

- Các khoản cho vay

- nhìn

- máy

- học máy

- giám đốc

- sản xuất

- ML

- kiểu mẫu

- mô hình

- chi tiết

- nhiều

- Tự nhiên

- Thiên nhiên

- THÔNG TIN

- Các tính năng mới

- máy tính xách tay

- Cung cấp

- Ngoại tuyến

- Trực tuyến

- Tùy chọn

- Các lựa chọn

- gọi món

- riêng

- đối tác

- Đối tác

- đam mê

- thanh toán

- tỷ lệ phần trăm

- hiệu suất

- riêng

- giai đoạn

- nền tảng

- điều luật

- Dự đoán

- Xem trước

- quá trình

- Sản phẩm

- Sản phẩm

- Lập trình

- dự án

- cung cấp

- cung cấp

- công khai

- mục đích

- Mau

- Nguyên

- Reading

- giảm

- báo cáo

- yêu cầu

- cần phải

- chịu trách nhiệm

- chạy

- Sự An Toàn

- Khoa học

- các nhà khoa học

- chọn

- Loạt Sách

- dịch vụ

- định

- thiết lập

- có ý nghĩa

- Đơn giản

- Kích thước máy

- Phần mềm

- phát triển phần mềm

- giải pháp

- Giải pháp

- không gian

- tiêu

- Chi

- chia

- ngăn xếp

- Tiêu chuẩn

- Bắt đầu

- bắt đầu

- Tuyên bố

- Trạng thái

- là gắn

- hàng

- Chiến lược

- mạnh mẽ

- phòng thu

- Thành công

- hỗ trợ

- Mục tiêu

- nhóm

- Thông qua

- thời gian

- Hội thảo

- Chuyển đổi

- Chuyển đổi

- ui

- độc đáo

- Cập nhật

- sử dụng

- nhiều

- khác nhau

- trong khi

- không có

- Công việc

- làm việc

- công trinh

- viết