Trong nỗ lực hạn chế tiềm năng hủy diệt của trí tuệ nhân tạo, một bài báo mới của Đại học Cambridge đã đề xuất tích hợp các công tắc và khóa tiêu diệt từ xa, giống như những công cụ được phát triển để ngăn chặn việc phóng vũ khí hạt nhân trái phép, vào phần cứng cung cấp năng lượng cho nó.

Giấy [PDF], bao gồm tiếng nói của nhiều tổ chức học thuật và một số tổ chức từ OpenAI, khiến cho việc quản lý phần cứng mà các mô hình này dựa vào có thể là cách tốt nhất để ngăn chặn việc sử dụng sai mục đích.

Các nhà nghiên cứu lập luận: “Tính toán liên quan đến AI là một điểm can thiệp đặc biệt hiệu quả: Nó có thể phát hiện, loại trừ và định lượng và được sản xuất thông qua một chuỗi cung ứng cực kỳ tập trung”.

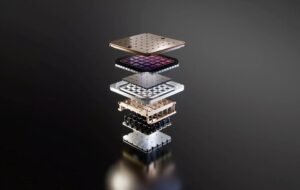

Việc đào tạo các mô hình hiệu quả nhất, được cho là vượt quá một nghìn tỷ tham số, đòi hỏi cơ sở hạ tầng vật lý khổng lồ: hàng chục nghìn GPU hoặc bộ tăng tốc và thời gian xử lý hàng tuần hoặc thậm chí hàng tháng. Các nhà nghiên cứu cho biết điều này khiến cho sự tồn tại và hiệu suất tương đối của các tài nguyên này khó có thể che giấu.

Hơn nữa, những con chip tiên tiến nhất được sử dụng để đào tạo các mô hình này được sản xuất bởi một số lượng tương đối nhỏ các công ty, như Nvidia, AMD và Intel, cho phép các nhà hoạch định chính sách hạn chế bán những hàng hóa này cho những cá nhân hoặc quốc gia có liên quan.

Bài báo cho rằng những yếu tố này, cùng với những yếu tố khác như hạn chế của chuỗi cung ứng đối với sản xuất chất bán dẫn, cung cấp cho các nhà hoạch định chính sách phương tiện để hiểu rõ hơn về cách thức và nơi triển khai cơ sở hạ tầng AI, ai được và không được phép truy cập và thực thi các hình phạt đối với việc sử dụng sai mục đích. .

Kiểm soát cơ sở hạ tầng

Bài viết nhấn mạnh nhiều cách mà các nhà hoạch định chính sách có thể tiếp cận với quy định về phần cứng AI. Nhiều đề xuất – bao gồm cả những đề xuất được thiết kế để cải thiện khả năng hiển thị và hạn chế việc bán máy gia tốc AI – đã được áp dụng ở cấp quốc gia.

Năm ngoái, tổng thống Mỹ Joe Biden đã đưa ra một lệnh điều hành nhằm xác định các công ty đang phát triển các mô hình AI công dụng kép lớn cũng như các nhà cung cấp cơ sở hạ tầng có khả năng đào tạo họ. Nếu bạn chưa biết, “sử dụng kép” đề cập đến các công nghệ có thể phục vụ nhiệm vụ kép trong các ứng dụng dân sự và quân sự.

Gần đây hơn, Bộ Thương mại Hoa Kỳ đề xuất quy định yêu cầu các nhà cung cấp dịch vụ đám mây của Mỹ thực hiện các chính sách “biết khách hàng của bạn” nghiêm ngặt hơn để ngăn chặn những cá nhân hoặc quốc gia có liên quan lách các hạn chế xuất khẩu.

Các nhà nghiên cứu lưu ý rằng loại khả năng hiển thị này rất có giá trị vì nó có thể giúp tránh một cuộc chạy đua vũ trang khác, giống như cuộc chạy đua gây ra bởi tranh cãi về khoảng cách tên lửa, trong đó các báo cáo sai lầm dẫn đến việc xây dựng ồ ạt tên lửa đạn đạo. Mặc dù có giá trị nhưng chúng cảnh báo rằng việc thực hiện các yêu cầu báo cáo này có nguy cơ xâm phạm quyền riêng tư của khách hàng và thậm chí dẫn đến rò rỉ dữ liệu nhạy cảm.

Trong khi đó, về mặt thương mại, Bộ Thương mại tiếp tục bước lên hạn chế, hạn chế hiệu suất của máy gia tốc bán cho Trung Quốc. Tuy nhiên, như chúng tôi đã đưa tin trước đây, mặc dù những nỗ lực này khiến các quốc gia như Trung Quốc khó có được chip của Mỹ hơn nhưng chúng vẫn chưa hoàn hảo.

Để giải quyết những hạn chế này, các nhà nghiên cứu đã đề xuất triển khai cơ chế đăng ký toàn cầu về doanh số bán chip AI để theo dõi chúng trong suốt vòng đời, ngay cả sau khi chúng rời khỏi quốc gia xuất xứ. Họ đề xuất rằng một cơ quan đăng ký như vậy có thể kết hợp một mã định danh duy nhất vào mỗi chip, điều này có thể giúp chống lại buôn lậu của các thành phần.

Ở mức cực đoan hơn, các nhà nghiên cứu đã gợi ý rằng các công tắc tiêu diệt có thể được tích hợp vào silicon để ngăn chặn việc sử dụng chúng trong các ứng dụng độc hại.

Về lý thuyết, điều này có thể cho phép các cơ quan quản lý phản ứng nhanh hơn trước việc lạm dụng các công nghệ nhạy cảm bằng cách cắt quyền truy cập vào chip từ xa, nhưng các tác giả cảnh báo rằng làm như vậy không phải là không có rủi ro. Điều này có nghĩa là, nếu được triển khai không chính xác, một kill switch như vậy có thể trở thành mục tiêu của tội phạm mạng.

Một đề xuất khác sẽ yêu cầu nhiều bên ký kết các nhiệm vụ đào tạo AI tiềm ẩn nhiều rủi ro trước khi chúng có thể được triển khai trên quy mô lớn. Họ viết: “Vũ khí hạt nhân sử dụng các cơ chế tương tự được gọi là liên kết hành động cho phép”.

Đối với vũ khí hạt nhân, những khóa bảo mật này được thiết kế để ngăn chặn một người lừa đảo và tung ra đòn tấn công đầu tiên. Tuy nhiên, đối với AI, ý tưởng là nếu một cá nhân hoặc công ty muốn đào tạo một mô hình vượt một ngưỡng nhất định trên đám mây, trước tiên họ cần phải được ủy quyền để làm điều đó.

Mặc dù là một công cụ mạnh mẽ nhưng các nhà nghiên cứu nhận thấy rằng điều này có thể gây tác dụng ngược bằng cách ngăn chặn sự phát triển của AI mong muốn. Lập luận dường như là trong khi việc sử dụng vũ khí hạt nhân có kết quả khá rõ ràng, AI không phải lúc nào cũng có hai màu đen trắng như vậy.

Nhưng nếu điều này khiến bạn cảm thấy hơi lạc hậu so với sở thích của bạn, thì bài báo sẽ dành toàn bộ phần để phân bổ lại các nguồn lực AI nhằm cải thiện xã hội nói chung. Ý tưởng là các nhà hoạch định chính sách có thể hợp tác với nhau để làm cho máy tính AI dễ tiếp cận hơn với các nhóm không có khả năng sử dụng nó vào mục đích xấu, một khái niệm được mô tả là “phân bổ”.

Có gì sai khi điều chỉnh sự phát triển AI?

Tại sao phải đi đến tất cả những rắc rối này? Chà, các tác giả của bài báo thừa nhận rằng phần cứng vật lý vốn đã dễ kiểm soát hơn.

So với phần cứng, “các đầu vào và đầu ra khác của quá trình phát triển AI – dữ liệu, thuật toán và mô hình được đào tạo – là những hàng hóa vô hình không có tính cạnh tranh, có thể chia sẻ dễ dàng, khiến chúng vốn khó kiểm soát”, bài báo viết.

Lập luận đưa ra là một khi một mô hình được xuất bản, dù ở dạng công khai hay bị rò rỉ, thì không thể đặt thần đèn trở lại chai và ngăn chặn sự lan truyền của nó trên mạng.

Các nhà nghiên cứu cũng nhấn mạnh rằng những nỗ lực ngăn chặn việc lạm dụng các mô hình đã được chứng minh là không đáng tin cậy. Trong một ví dụ, các tác giả nhấn mạnh sự dễ dàng mà các nhà nghiên cứu có thể loại bỏ các biện pháp bảo vệ trong Llama 2 của Meta nhằm ngăn mô hình tạo ra ngôn ngữ xúc phạm.

Ở mức độ cao nhất, người ta lo ngại rằng một mô hình sử dụng kép đủ tiên tiến có thể được sử dụng để đẩy nhanh quá trình phát triển của vũ khí hóa học hoặc sinh học.

Bài viết thừa nhận rằng quy định về phần cứng AI không phải là giải pháp bạc đạn và không loại bỏ nhu cầu quản lý trong các khía cạnh khác của ngành.

Tuy nhiên, khó có thể bỏ qua sự tham gia của một số nhà nghiên cứu OpenAI nếu xét đến ý kiến của CEO Sam Altman. nỗ lực để kiểm soát câu chuyện xung quanh quy định AI. ®

- Phân phối nội dung và PR được hỗ trợ bởi SEO. Được khuếch đại ngay hôm nay.

- PlatoData.Network Vertical Generative Ai. Trao quyền cho chính mình. Truy cập Tại đây.

- PlatoAiStream. Thông minh Web3. Kiến thức khuếch đại. Truy cập Tại đây.

- Trung tâmESG. Than đá, công nghệ sạch, Năng lượng, Môi trường Hệ mặt trời, Quản lý chất thải. Truy cập Tại đây.

- PlatoSức khỏe. Tình báo thử nghiệm lâm sàng và công nghệ sinh học. Truy cập Tại đây.

- nguồn: https://go.theregister.com/feed/www.theregister.com/2024/02/16/boffins_propose_regulating_ai_hardware/

- : có

- :là

- :không phải

- :Ở đâu

- $ LÊN

- 7

- a

- Có khả năng

- lạm dụng

- AC

- học tập

- đẩy nhanh tiến độ

- máy gia tốc

- truy cập

- có thể truy cập

- ngang qua

- Hoạt động

- địa chỉ

- tiên tiến

- Sau

- AI

- Mô hình AI

- Đào tạo AI

- nhằm vào

- thuật toán

- Tất cả

- phân bổ

- cho phép

- cho phép

- Cho phép

- dọc theo

- Đã

- Ngoài ra

- luôn luôn

- AMD

- American

- an

- và

- Một

- các ứng dụng

- phương pháp tiếp cận

- LÀ

- tranh luận

- đối số

- cánh tay

- xung quanh

- nhân tạo

- trí tuệ nhân tạo

- AS

- các khía cạnh

- At

- ủy quyền

- tác giả

- tránh

- trở lại

- BE

- trở nên

- trước

- được

- tin

- BEST

- Hơn

- Tốt hơn

- Biden

- Đen

- xây dựng

- nhưng

- by

- gọi là

- cambridge

- CAN

- có khả năng

- trường hợp

- giám đốc điều hành

- nhất định

- chuỗi

- hóa chất

- Trung Quốc

- Chip

- Snacks

- thường dân

- đám mây

- CO

- chống lại

- Đến

- Thương mại

- Các công ty

- công ty

- các thành phần

- Tính

- Tập trung

- khái niệm

- Liên quan

- xem xét

- khó khăn

- tiếp tục

- điều khiển

- tranh cãi

- có thể

- nước

- đất nước

- Khóa học

- khách hàng

- cắt

- tội phạm mạng

- dữ liệu

- bộ

- triển khai

- mô tả

- thiết kế

- phát triển

- phát triển

- Phát triển

- khó khăn

- do

- doesn

- làm

- tăng gấp đôi

- bác sĩ da liễu

- mỗi

- dễ dàng

- dễ dàng hơn

- dễ dàng

- Hiệu quả

- những nỗ lực

- hay

- loại bỏ

- việc làm

- cuối

- thi hành

- Toàn bộ

- Ngay cả

- ví dụ

- quá

- thi hành

- sự tồn tại

- xuất khẩu

- cực

- cực kỳ

- các yếu tố

- quen

- xa

- nhanh hơn

- sợ hãi

- cảm thấy

- Tên

- Trong

- Forward

- từ

- trước mặt

- khoảng cách

- tạo ra

- thần đèn

- được

- nhận được

- Toàn cầu

- Go

- đi

- hàng hóa

- GPU

- Các nhóm

- Tay bài

- Cứng

- khó hơn

- phần cứng

- Có

- giúp đỡ

- Ẩn giấu

- Nhấn mạnh

- nổi bật

- Độ đáng tin của

- Tuy nhiên

- HTTPS

- ý tưởng

- định danh

- xác định

- if

- bỏ qua

- bao la

- thực hiện

- thực hiện

- thực hiện

- nâng cao

- in

- Mặt khác

- bao gồm

- Bao gồm

- kết hợp

- không chính xác

- hệ thống riêng biệt,

- ngành công nghiệp

- Cơ sở hạ tầng

- vốn có

- đầu vào

- tổ chức

- vô hình

- Intel

- Sự thông minh

- can thiệp

- trong

- isn

- IT

- ITS

- JOE

- Joe Biden

- jpg

- Giết chết

- Loại

- Ngôn ngữ

- lớn

- phóng

- ra mắt

- dẫn

- Led

- trái

- Cấp

- vòng đời

- Lượt thích

- LIMIT

- hạn chế

- hạn chế

- liên kết

- ít

- Loài đà mã ở nam mỹ

- Khóa

- thực hiện

- làm cho

- LÀM CHO

- Làm

- độc hại

- sản xuất

- nhiều

- lớn

- Có thể..

- có nghĩa

- có nghĩa là

- cơ chế

- Siêu dữ liệu

- Might

- Quân đội

- Ứng dụng quân sự

- tên lửa

- sử dụng sai

- kiểu mẫu

- mô hình

- tháng

- chi tiết

- hầu hết

- nhiều

- TƯỜNG THUẬT

- quốc dân

- Cần

- net

- Mới

- Không

- ghi

- hạt nhân

- con số

- nhiều

- Nvidia

- tuân theo

- of

- off

- phản cảm

- cung cấp

- on

- hàng loạt

- ONE

- mở

- OpenAI

- or

- nguồn gốc

- Nền tảng khác

- Khác

- vfoXNUMXfipXNUMXhfpiXNUMXufhpiXNUMXuf

- ra

- Kết quả

- kết quả đầu ra

- kết thúc

- Giấy

- thông số

- tham gia

- đặc biệt

- các bên tham gia

- hình phạt

- hoàn hảo

- hiệu suất

- người

- người

- vật lý

- plato

- Thông tin dữ liệu Plato

- PlatoDữ liệu

- chơi

- Điểm

- Chính sách

- các nhà hoạch định chính sách

- mạnh

- tiềm năng

- có khả năng

- quyền hạn

- Chủ tịch

- chủ tịch joe biden

- khá

- ngăn chặn

- ngăn chặn

- trước đây

- riêng tư

- xử lý

- Sản xuất

- phong phú

- đề nghị

- đề xuất

- đã được chứng minh

- nhà cung cấp

- công bố

- đặt

- Đặt

- định lượng

- nhiệm vụ

- Cuộc đua

- RE

- gần đây

- đề cập

- đăng ký

- Quy định

- điều tiết

- Quy định

- Điều phối

- tương đối

- tương đối

- dựa

- xa

- từ xa

- Báo cáo

- Báo cáo

- Báo cáo

- yêu cầu

- Yêu cầu

- đòi hỏi

- nhà nghiên cứu

- Thông tin

- Trả lời

- hạn chế

- hạn chế

- Nguy cơ

- rủi ro

- Rủi ro

- s

- biện pháp bảo vệ

- bán

- bán hàng

- Sam

- Sam Altman

- nói

- Quy mô

- Phần

- an ninh

- dường như

- bán dẫn

- nhạy cảm

- phục vụ

- một số

- đăng ký

- Silicon

- Gói Bạc

- tương tự

- nhỏ

- So

- Xã hội

- bán

- quang phổ

- lan tràn

- Bắt đầu

- Dừng

- dừng lại

- đình công

- nghiêm khắc

- như vậy

- đề nghị

- cung cấp

- chuỗi cung ứng

- Công tắc điện

- Mục tiêu

- nhiệm vụ

- mùi vị

- Công nghệ

- hàng chục

- việc này

- Sản phẩm

- cung cấp their dịch

- Them

- lý thuyết

- Đó

- Kia là

- họ

- điều này

- những

- hàng ngàn

- ngưỡng

- thời gian

- đến

- bên nhau

- quá

- công cụ

- theo dõi

- thương mại

- Train

- đào tạo

- Hội thảo

- được kích hoạt

- Nghìn tỷ

- rắc rối

- không được phép

- hiểu

- độc đáo

- trường đại học

- đại học Cambridge

- không

- us

- Tổng thống chúng tôi

- sử dụng

- đã sử dụng

- Quý báu

- Ve

- nhà cung cấp

- thông qua

- khả năng hiển thị

- VOICE

- muốn

- Đường..

- cách

- we

- Vũ khí

- tuần

- TỐT

- là

- cái nào

- trong khi

- trắng

- CHÚNG TÔI LÀ

- toàn bộ

- với

- không có

- sẽ

- Sai

- đã viết

- năm

- Bạn

- trên màn hình

- zephyrnet