这是来自 Qualcomm AI 的 AK Roy 的客座文章。

Amazon Elastic Compute Cloud(Amazon EC2) DL2q 实例由 Qualcomm AI 100 Standard 加速器提供支持,可用于在云中经济高效地部署深度学习 (DL) 工作负载。 它们还可用于开发和验证将部署在高通设备上的深度学习工作负载的性能和准确性。 DL2q 实例是首批将 Qualcomm 人工智能 (AI) 技术引入云端的实例。

凭借八个 Qualcomm AI 100 Standard 加速器和 128 GiB 总加速器内存,客户还可以使用 DL2q 实例运行流行的生成式 AI 应用程序,例如内容生成、文本摘要和虚拟助理,以及用于自然语言处理的经典 AI 应用程序和计算机视觉。 此外,Qualcomm AI 100 加速器采用与智能手机、自动驾驶、个人电脑和扩展现实耳机相同的 AI 技术,因此 DL2q 实例可用于在部署之前开发和验证这些 AI 工作负载。

新 DL2q 实例亮点

每个 DL2q 实例均包含 100 个 Qualcomm Cloud AI2.8 加速器,综合性能超过 8 PetaOps 的 Int1.4 推理性能和 16 PetaFlops 的 FP112 推理性能。 该实例共有128个AI核心,加速器内存容量为1.1GB,内存带宽为XNUMXTB/秒。

每个DL2q实例拥有96个vCPU,系统内存容量为768 GB,支持100 Gbps的网络带宽以及 亚马逊弹性块存储(亚马逊EBS) 19 Gbps 的存储。

| 实例名称 | 虚拟CPU | 云AI100加速器 | 加速器内存 | 加速器内存 BW(聚合) | 实例内存 | 实例组网 | 存储 (Amazon EBS) 带宽 |

| DL2q.24xlarge | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

高通云AI100加速器创新

Cloud AI100 加速器片上系统 (SoC) 是一种专门构建的可扩展多核架构,支持从数据中心到边缘的各种深度学习用例。 该 SoC 采用标量、矢量和张量计算核心,具有业界领先的 126 MB 片上 SRAM 容量。 这些内核通过高带宽低延迟片上网络 (NoC) 网格互连。

AI100 加速器支持广泛而全面的模型和用例。 下表重点介绍了模型支持的范围。

| 车型类别 | 型号数量 | 示例 |

| 自然语言处理 | 157 | BERT、BART、FasterTransformer、T5、Z 代码 MOE |

| 生成式人工智能——NLP | 40 | LLaMA、CodeGen、GPT、OPT、BLOOM、Jais、Luminous、StarCoder、XGen |

| 生成式人工智能——图像 | 3 | 稳定扩散 v1.5 和 v2.1,OpenAI CLIP |

| CV——图像分类 | 45 | ViT、ResNet、ResNext、MobileNet、EfficientNet |

| CV——物体检测 | 23 | YOLO v2、v3、v4、v5 和 v7、SSD-ResNet、RetinaNet |

| 简历 – 其他 | 15 | LPRNet、超分辨率/SRGAN、ByteTrack |

| 汽车网络* | 53 | 感知和激光雷达、行人、车道和交通灯检测 |

| 全部的 | > 300 |

* 大多数汽车网络都是由各个网络融合而成的复合网络。

DL2q 加速器上的大型片上 SRAM 能够高效实施先进的性能技术,例如用于存储权重的 MX6 微指数精度和用于加速器间通信的 MX9 微指数精度。 以下开放计算项目 (OCP) 行业公告中描述了微指数技术: AMD、Arm、英特尔、Meta、微软、NVIDIA 和高通标准化人工智能的下一代窄精度数据格式 » 开放计算项目.

实例用户可以使用以下策略来最大化性价比:

- 使用加速器上的 DDR 内存中的 MX6 微指数精度存储权重。 使用 MX6 精度可最大限度地利用可用内存容量和内存带宽,从而提供一流的吞吐量和延迟。

- 在 FP16 中进行计算以提供所需的用例精度,同时使用卡上卓越的片上 SRAM 和备用 TOP,以实现高性能低延迟 MX6 到 FP16 内核。

- 通过使用可用的大型片上 SRAM,使用优化的批处理策略和更高的批处理大小,以最大限度地重用权重,同时最大限度地保留片上激活。

DL2q AI 堆栈和工具链

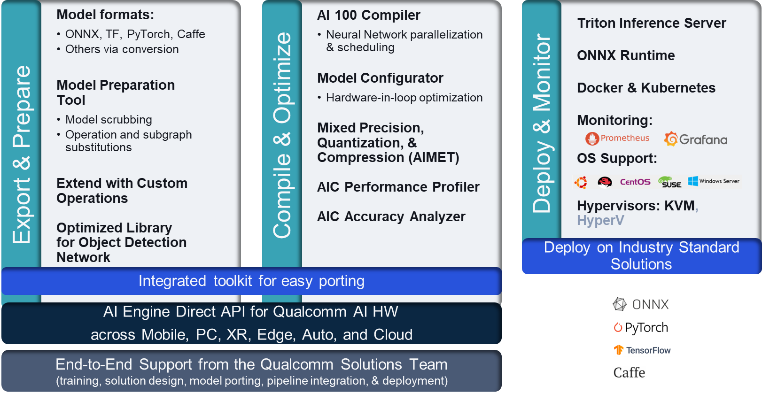

DL2q 实例配有 Qualcomm AI Stack,可在云端的 Qualcomm AI 和其他 Qualcomm 产品中提供一致的开发人员体验。 相同的高通人工智能堆栈和基础人工智能技术在DL2q实例和高通边缘设备上运行,为客户提供一致的开发人员体验,并在云、汽车、个人计算机、扩展现实和智能手机开发环境中提供统一的API。

该工具链使实例用户能够快速加入先前训练的模型,针对实例功能编译和优化模型,然后通过下图所示的三个步骤将编译后的模型部署到生产推理用例。

要了解有关调整模型性能的更多信息,请参阅 Cloud AI 100关键性能参数 文档。

DL2q 实例入门

在此示例中,您编译并部署一个预训练的 BERT模型 止 拥抱脸 在使用预构建的可用 DL2q AMI 的 EC2 DL2q 实例上,分四个步骤。

您可以使用预先构建的 高通DLAMI 在实例上,或者从 Amazon Linux2 AMI 开始,并使用本文档中提供的 Cloud AI 2 平台和应用程序开发工具包构建您自己的 DL100q AMI 亚马逊简单存储服务(Amazon S3) 桶: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

以下步骤使用预构建的 DL2q AMI, 高通 Base AL2 DLAMI.

使用 SSH 通过 Qualcomm Base AL2 DLAMI AMI 访问您的 DL2q 实例,并按照步骤 1 至 4 进行操作。

步骤1.搭建环境并安装所需包

- 安装 Python 3.8。

- 设置Python 3.8虚拟环境。

- 激活Python 3.8虚拟环境。

- 安装所需的软件包,如图所示 需求.txt文档 可在 Qualcomm 公共 Github 站点上获取。

- 导入必要的库。

步骤 2. 导入模型

- 导入并标记模型。

- 定义一个样本输入并提取

inputIds和attentionMask. - 将模型转换为 ONNX,然后可以将其传递给编译器。

- 您将以 FP16 精度运行模型。 因此,您需要检查模型是否包含任何超出 FP16 范围的常数。 将模型传递给

fix_onnx_fp16函数生成包含所需修复的新 ONNX 文件。

步骤 3. 编译模型

qaic-exec 命令行界面(CLI)编译工具用于编译模型。 该编译器的输入是步骤 2 中生成的 ONNX 文件。编译器生成一个二进制文件(称为 QPC,为 高通程序容器)在定义的路径中 -aic-binary-dir 论据。

在下面的编译命令中,您使用四个 AI 计算核心和批量大小为 XNUMX 来编译模型。

QPC 生成于 bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc 文件夹中。

步骤 4. 运行模型

设置一个会话以在 DL100q 实例中的 Cloud AI2 Qualcomm 加速器上运行推理。

Qualcomm qaic Python 库是一组 API,为在 Cloud AI100 加速器上运行推理提供支持。

- 使用会话 API 调用来创建会话实例。 会话 API 调用是使用 qaic Python 库的入口点。

- 重构输出缓冲区中的数据

output_shape和output_type. - 解码产生的输出。

以下是输入句子“垫子上的狗 [MASK]”的输出。

就是这样。 只需几个步骤,您就可以在 Amazon EC2 DL2q 实例上编译并运行 PyTorch 模型。 要了解有关在 DL2q 实例上加入和编译模型的更多信息,请参阅 云AI100教程文档。

要了解有关哪些 DL 模型架构非常适合 AWS DL2q 实例和当前模型支持矩阵的更多信息,请参阅 高通云AI100文档.

现在可

您现在可以在美国西部(俄勒冈)和欧洲(法兰克福)AWS 区域启动 DL2q 实例: 按需, 保留的及 竞价实例,或作为 储蓄计划。 与使用 Amazon EC2 一样,您只需按使用量付费。 有关更多信息,请参阅 亚马逊 EC2 定价.

DL2q 实例可以使用以下方式部署 AWS 深度学习 AMI (DLAMI),并且容器映像可通过托管服务获得,例如 亚马逊SageMaker, 亚马逊弹性 Kubernetes 服务 (Amazon EKS), Amazon Elastic Container Service(Amazon ECS)及 AWS 并行集群.

要了解更多信息,请访问 亚马逊 EC2 DL2q 实例 页面,并将反馈发送至 适用于 EC2 的 AWS re:Post 或通过您常用的 AWS Support 联系人。

关于作者

AK罗伊 是高通产品管理总监,负责云和数据中心人工智能产品和解决方案。 他在产品战略和开发方面拥有 20 多年的经验,目前专注于云中人工智能推理的一流性能和性能/成本端到端解决方案,适用于广泛的用例,包括 GenAI、法学硕士、汽车和混合人工智能。

AK罗伊 是高通产品管理总监,负责云和数据中心人工智能产品和解决方案。 他在产品战略和开发方面拥有 20 多年的经验,目前专注于云中人工智能推理的一流性能和性能/成本端到端解决方案,适用于广泛的用例,包括 GenAI、法学硕士、汽车和混合人工智能。

郎建英 是 AWS 全球专家组织 (WWSO) 的首席解决方案架构师。 她在 HPC 和 AI 领域拥有超过 15 年的工作经验。 在 AWS,她专注于帮助客户在加速计算实例上部署、优化和扩展其 AI/ML 工作负载。 她热衷于将 HPC 和 AI 领域的技术结合起来。 建英拥有科罗拉多大学博尔德分校计算物理学博士学位。

郎建英 是 AWS 全球专家组织 (WWSO) 的首席解决方案架构师。 她在 HPC 和 AI 领域拥有超过 15 年的工作经验。 在 AWS,她专注于帮助客户在加速计算实例上部署、优化和扩展其 AI/ML 工作负载。 她热衷于将 HPC 和 AI 领域的技术结合起来。 建英拥有科罗拉多大学博尔德分校计算物理学博士学位。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 柏拉图健康。 生物技术和临床试验情报。 访问这里。

- Sumber: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :具有

- :是

- $UP

- 1

- 1结核病

- 10

- 100

- 11

- 12

- 13

- 15 年

- 15%

- 17

- 19

- 20

- 20 年

- 22

- 23

- 7

- 75

- 8

- 84

- a

- 关于

- 以上

- 加速

- 加速器

- 加速器

- ACCESS

- 伴随着

- 横过

- 激活

- 另外

- 高级

- 骨料

- AI

- AI / ML

- 所有类型

- 还

- Amazon

- Amazon EC2

- 亚马逊网络服务

- an

- 和

- 公告

- 任何

- API

- APIs

- 应用领域

- 应用

- 架构

- 保健

- 论点

- ARM

- 人造的

- AS

- 助理

- At

- 汽车

- 汽车

- 自主性

- 可使用

- AWS

- 轴

- 带宽

- 基地

- BE

- before

- 如下。

- 超越

- BIN

- 阻止

- Bloom

- 带来

- 广阔

- 缓冲

- 建立

- by

- 呼叫

- 被称为

- CAN

- 能力

- 容量

- 卡

- 案件

- 查

- 经典

- 云端技术

- 科罗拉多州

- 结合

- 沟通

- 全面

- 计算

- 计算

- 一台

- 计算机视觉

- 电脑

- 计算

- 一贯

- 组成

- 联系

- 容器

- 包含

- 内容

- 内容生成

- 创建信息图

- 电流

- 合作伙伴

- data

- 数据中心

- 深

- 深入学习

- 定义

- 学位

- 交付

- 提供

- 部署

- 部署

- 部署

- 描述

- 开发

- 开发商

- 研发支持

- 设备

- 设备

- 扩散

- 副总经理

- 文件

- 狗

- 驾驶

- 动态

- 边缘

- 高效

- 或

- 员工

- 使

- 端至端

- 条目

- 环境

- 环境中

- 欧洲

- 例子

- 体验

- 扩展现实

- 提取

- false

- 专栏

- 反馈

- 少数

- 部分

- 字段

- 数字

- 文件

- 姓氏:

- 适合

- 专注焦点

- 重点

- 遵循

- 以下

- 针对

- 发现

- 四

- 法兰克福

- 止

- 功能

- 聚变

- 通常

- 生成

- 产生

- 代

- 生成的

- 生成式人工智能

- GitHub上

- 特定

- 非常好

- 客人

- 游客发表

- he

- 耳机

- 帮助

- 此处

- 高性能

- 更高

- 亮点

- 持有

- HPC

- HTML

- HTTPS

- 杂交种

- i

- IDX

- if

- 图片

- 图片

- 实施

- 履行

- 进口

- in

- 包含

- 合并

- 个人

- 行业中的应用:

- 行业领先

- 信息

- 输入

- 安装

- 例

- 英特尔

- 智能化

- 互联

- 接口

- IT

- JPG

- 只是

- 键

- 车道

- 语言

- 大

- 潜伏

- 发射

- 学习用品

- 学习

- 库

- 自学资料库

- 光

- Line

- 负载

- 管理

- 颠覆性技术

- 面膜

- 矩阵

- 最大

- 生产力

- 最大程度地增强

- 最多

- 内存

- 网格

- 元

- 微软

- 分钟

- 模型

- 模型

- 改性

- 更多

- 最先进的

- 姓名

- 狭窄

- 自然

- 自然语言处理

- 必要

- 需求

- 网络

- 工业网络

- 网络

- 全新

- 下一代

- 现在

- 麻木

- Nvidia公司

- 对象

- of

- on

- 板载

- 前期洽谈

- 一

- 仅由

- 打开

- OpenAI

- 优化

- 优化

- or

- 俄勒冈

- 组织

- OS

- 其他名称

- 输出

- 产量

- 输出

- 超过

- 己

- 包

- 页

- 部分

- 通过

- 通过

- 多情

- 径

- 为

- 性能

- 个人

- 博士学位

- 物理

- 平台

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 点

- 热门

- 可能

- 帖子

- 供电

- 平台精度

- 先前

- 校长

- 处理

- 生成

- 产生

- 产品

- 产品管理

- 生产

- 热销产品

- 曲目

- 项目

- 提供

- 优

- 国家

- 蟒蛇

- pytorch

- 高通公司

- 很快

- 范围

- RE

- 阅读

- 现实

- 地区

- 必须

- 岗位要求

- 护

- 回报

- 重用

- 罗伊

- 运行

- 运行

- 运行

- 同

- 保存

- 保存

- 可扩展性

- 鳞片

- SDK

- 其次

- 看到

- 提交

- 句子

- 序列

- 服务

- 特色服务

- 会议

- 集

- 她

- 如图

- 简易

- 简化

- 网站

- 尺寸

- 智能手机

- 智能手机

- So

- 解决方案

- 张力

- 专家

- 堆

- 标准

- 开始

- 开始

- 步

- 步骤

- 存储

- 商店

- 存储

- 策略

- 后来

- 这样

- 优于

- SUPPORT

- 支持

- 支持

- SYS

- 系统

- 表

- 技术

- 专业技术

- 文本

- 这

- 其

- 然后

- 博曼

- 他们

- Free Introduction

- 三

- 通过

- 吞吐量

- 通过

- 至

- 今晚

- 令牌化

- 工具

- 上衣

- 火炬

- 合计

- 交通

- 熟练

- 变形金刚

- true

- 调音

- 教程

- 统一

- 大学

- us

- 使用

- 用例

- 用例

- 用过的

- 用户

- 运用

- 通常

- v1

- 验证

- 折扣值

- 在线会议

- 愿景

- 参观

- we

- 卷筒纸

- Web服务

- 井

- 西部

- 什么是

- 这

- 而

- 宽

- 大范围

- 将

- Word

- 加工

- 全世界

- 年

- 完全

- 您一站式解决方案

- 和风网