用户数据:法学硕士的重要食物

是的! RT @布莱斯 喜欢这句话“如果你不付钱,你就不是顾客;你就是被销售的产品。” http://bit.ly/93JYCJ

— 蒂姆·奥莱利 (@timoreilly) 2010 年 9 月 2 日

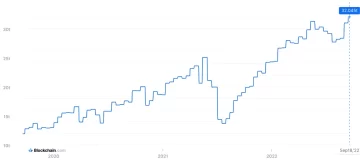

随时了解加密新闻,在您的收件箱中获取每日更新。

- :具有

- :是

- :不是

- 7

- 8

- a

- 对,能力--

- 绝对

- 根据

- 精准的

- 调整

- 解决

- 添加

- 高级

- 前

- 同意

- AI

- 人工智能服务

- 人工智能系统

- 目标

- Alexa的

- 对齐

- 所有类型

- 允许

- 还

- 时刻

- Amazon

- an

- 和

- 人类的

- 预料

- 任何

- 相应

- 保健

- AS

- 承担

- At

- 可使用

- 避免

- 察觉

- 基于

- BE

- 因为

- 作为

- 相信

- 有利

- 更好

- 之间

- by

- CAN

- 索赔

- 客户

- 商业的

- 承诺

- 提交

- 公司

- 公司

- 竞争的

- 概念

- 关注

- 经常

- 内容

- 上下文

- 不断

- 控制

- 便捷

- 对话

- 版权

- 可以

- 关键

- 加密

- 加密新闻

- 电流

- 顾客

- 合作伙伴

- 每天

- 黑暗

- data

- 数据隐私

- 辩论

- 几十年

- 解码

- 深

- 深入学习

- 默认

- 卫冕

- 交付

- 依靠

- 免责声明

- 纠纷

- 多元化

- do

- 文件

- 不

- 美元

- 别

- ,我们将参加

- 佣金

- 边缘

- 效用

- 或

- 订婚

- 加强

- 确保

- 必要

- 伦理

- 伦理

- 例子

- 交换

- 体验

- 广泛

- 程度

- 外部

- 面对

- 针对

- 前

- 公司成立

- Free

- 止

- 获得

- 生成

- 产生

- 产生

- 生成的

- 生成式人工智能

- 得到

- 越来越

- 巨头

- 给

- Go

- 授予

- 把握

- 成长

- 严重

- 诚实的

- 兑现

- 但是

- HTTP

- HTTPS

- 人

- 理想

- if

- 改善

- in

- 个人

- 信息

- 知识分子

- 知识产权

- 意图

- 互动

- 内部

- IP

- IT

- 它的

- 本身

- 键

- 语言

- 大

- 最新

- 法律

- 铅

- 学习用品

- 学习

- 法律咨询

- 杠杆作用

- 喜欢

- 骆驼

- LLM

- 爱

- 使

- 制作

- 可能..

- 媒体

- 元

- 百万

- 模型

- 模型

- 更多

- 最先进的

- 网络

- 神经

- 神经网络

- 全新

- 消息

- 获得

- of

- on

- OpenAI

- or

- 表面上

- 除此以外

- 我们的

- 输出

- 输出

- 超过

- 己

- 拥有

- 支付

- 各方

- 党

- 模式

- 付款

- 个人

- 个性化

- 个性化你的

- 图片

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 政策

- 潜力

- 功率

- 强大

- 做法

- 预测

- 预测

- 喜好

- 流行

- 隐私

- 私立

- 生成

- 产品

- 提示

- 财产

- 提供

- 提供

- 国家

- 公众信任

- 公然

- 报价

- 赛车

- RE

- 真实的世界

- 接收

- 提炼

- 视

- 相对的

- 释放

- 相应

- 报道

- 要求

- 研究人员

- 提供品牌战略规划

- 揭密

- 权利

- 对手

- rt

- 瑞安

- s

- 对工资盗窃

- 说

- 现场

- 服务

- 特色服务

- 集

- Share

- 应该

- 怀疑论

- So

- 社会

- 社会化媒体

- 出售

- 拼写

- 发言人

- 启动

- 个人陈述

- 留

- 步

- 产品

- 串联

- 科技

- 科技巨头

- 技术

- 条款

- 文本

- 这

- 其

- 他们

- 博曼

- 他们

- Free Introduction

- Tim

- 至

- 今晚

- 最佳

- 培训

- 熟练

- 产品培训

- 用户评论透明

- 趋势

- 信任

- 下

- 理解

- 理解

- 即将上市

- 更新

- 最新动态

- 升级

- 上传

- 使用

- 用过的

- 用户

- 用户

- 运用

- 有价值

- 各个

- 版本

- 视频

- 重要

- 音色

- 体积

- 是

- we

- 为

- ,尤其是

- 是否

- 这

- 为什么

- 将

- Word

- 将

- 完全

- 您一站式解决方案

- 和风网