亚马逊SageMaker 是一种托管服务,可以轻松构建、训练和部署机器学习 (ML) 模型。 数据科学家使用 SageMaker 训练作业轻松训练 ML 模型; 您不必担心管理计算资源,您只需为实际的培训时间付费。 数据摄取是任何训练管道不可或缺的一部分,SageMaker 训练作业支持各种数据存储和输入模式,以适应各种训练工作负载。

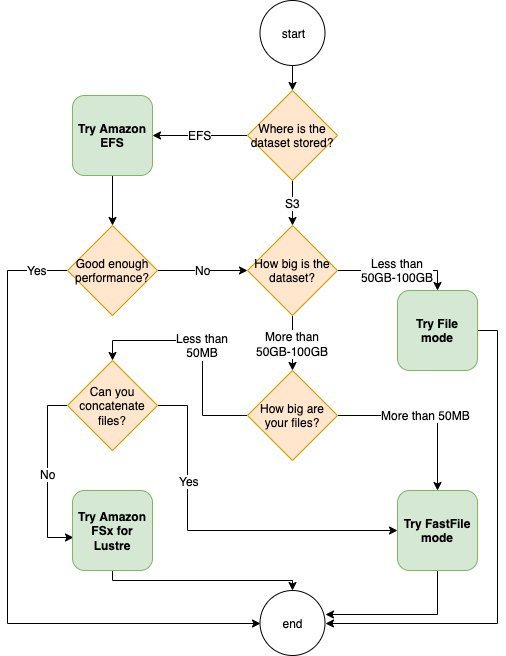

这篇文章可帮助您为 SageMaker ML 训练用例选择最佳数据源。 我们介绍了 SageMaker 训练作业本机支持的数据源选项。 对于每种数据源和输入模式,我们概述了其易用性、性能特征、成本和限制。 为了帮助您快速入门,我们为图表提供了一个示例决策流程,您可以根据您的关键工作负载特征遵循该示例决策流程。 最后,我们针对实际训练场景执行了几个基准测试,以展示对整体训练成本和性能的实际影响。

原生 SageMaker 数据源和输入模式

以高效的方式轻松灵活地读取训练数据是 ML 训练经常出现的常见问题。 SageMaker 通过选择称为数据源的高效、高吞吐量数据摄取机制及其各自的输入模式来简化数据摄取。 这使您可以将训练代码与实际数据源解耦,自动挂载文件系统,以高性能读取,轻松打开 GPU 和实例之间的数据分片以启用数据并行性,并在每个 epoch 开始时自动打乱数据。

SageMaker 训练摄取机制与三个 AWS 托管存储服务原生集成:

- 亚马逊简单存储服务 (Amazon S3) 是一种对象存储服务,可提供行业领先的可扩展性、数据可用性、安全性和性能。

- 适用于Lustre的Amazon FSx 是一种完全托管的共享存储,具有流行的 Lustre 文件系统的可扩展性和性能。 它通常链接到现有的 S3 存储桶。

- 亚马逊弹性文件系统 (Amazon EFS) 是一种通用、可扩展且高度可用的共享文件系统,具有多个价格层。 Amazon EFS 是无服务器的,并且会随着您添加和删除文件而自动增长和缩小。

SageMaker 训练允许您的训练脚本访问存储在 Amazon S3、FSx for Lustre 或 Amazon EFS 上的数据集,就好像它在本地文件系统上可用(通过符合 POSIX 的文件系统接口)。

使用 Amazon S3 作为数据源,您可以在文件模式、FastFile 模式和管道模式之间进行选择:

- 档案模式 – SageMaker 将数据集从 Amazon S3 复制到 ML 实例存储,这是一个附加的 Amazon Elastic Block商店 (Amazon EBS) 卷或 NVMe SSD 卷,在您的训练脚本开始之前。

- 快速文件模式 – SageMaker 将驻留在 Amazon S3 中的数据集公开为训练实例上的 POSIX 文件系统。 数据集文件在您的训练脚本读取它们时按需从 Amazon S3 流式传输。

- 管道模式 – SageMaker 将驻留在 Amazon S3 中的数据集作为 Unix 管道流式传输到 ML 训练实例,当您的训练脚本从管道读取数据时,该管道按需从 Amazon S3 流式传输。

使用 FSx for Lustre 或 Amazon EFS 作为数据源,SageMaker 在您的训练脚本启动之前挂载文件系统。

训练输入通道

启动 SageMaker 训练作业时,您最多可以指定 20 个托管 训练输入通道. 您可以将通道视为一个抽象单元,用于告诉训练作业如何以及在何处获取可供算法代码从文件系统路径读取的数据(例如, /opt/ml/input/data/input-channel-name) 在 ML 实例上。 选定的训练通道作为训练作业元数据的一部分被捕获,以便为用例启用完整的模型沿袭跟踪,例如训练作业的可重复性或模型治理目的。

要将 Amazon S3 用作您的数据源,您需要定义一个 训练输入 指定以下内容:

或者,对于 Lustre 或 Amazon EFS 的 FSx,您定义一个 文件系统输入.

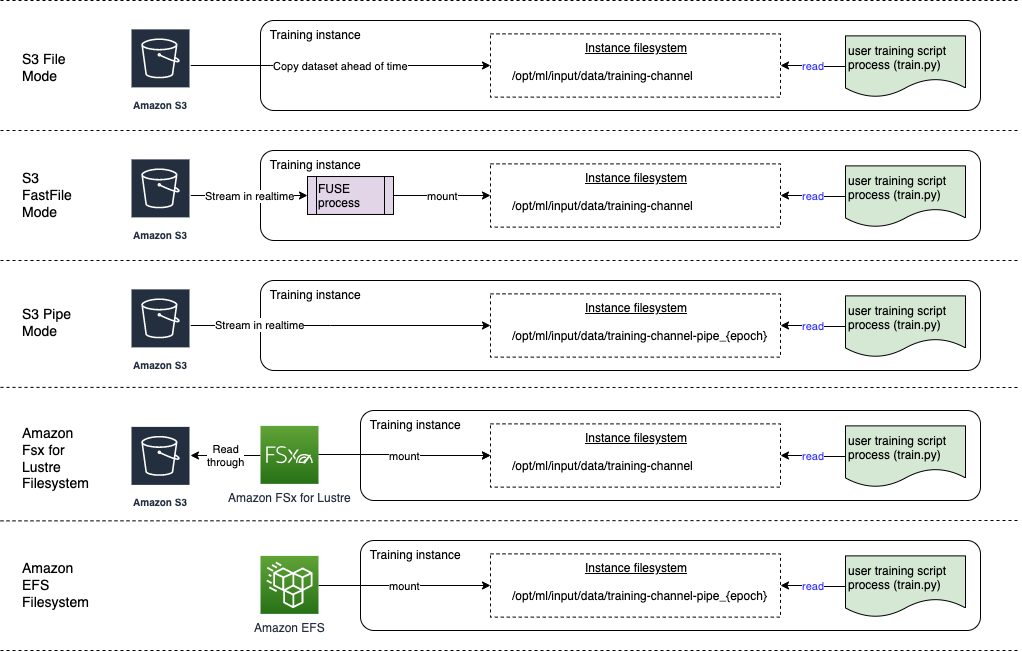

下图显示了五个训练作业,每个都配置了不同的数据源和输入模式组合:

数据源和输入模式

以下部分深入探讨了 Amazon S3(文件模式、FastFile 模式和管道模式)、FSx for Lustre 和作为 SageMaker 摄取机制的 Amazon EFS 之间的差异。

Amazon S3 文件模式

文件模式是默认的输入模式(如果您没有明确指定一种),并且使用起来更简单。 当您使用此输入选项时,SageMaker 在启动模型训练之前代表您将数据集从 Amazon S3 下载到 ML 训练实例存储(Amazon EBS 或本地 NVMe,具体取决于实例类型),以便训练脚本可以从本地文件系统。 在这种情况下,实例必须有足够的存储空间来容纳整个数据集。

您可以通过提供 S3 前缀、清单文件或扩充清单文件来为文件模式配置数据集。

当您的所有数据集文件都位于一个公共 S3 前缀(子文件夹可以)内时,您应该使用 S3 前缀。

清单文件列出了构成数据集的文件。 当数据预处理作业发出清单文件时,或者当您的数据集文件分布在多个 S3 前缀中时,您通常会使用清单。 增强清单是一个 JSON 行文件,其中每一行包含一个属性列表,例如对 Amazon S3 中文件的引用,以及其他属性,主要是标签。 它的用例类似于清单的用例。

文件模式兼容 SageMaker 本地模式 (在几秒钟内以交互方式启动 SageMaker 训练容器)。 对于分布式训练,您可以使用 ShardedByS3Key 选项。

文件模式下载速度取决于数据集大小、平均文件大小和文件数量。 例如,数据集越大(或文件越多),下载阶段越长,在此期间实例的计算资源保持有效空闲。 使用 Spot 实例进行训练时,每次在 Spot 中断后恢复作业时都会下载数据集。 通常,大文件的数据下载速度约为 200 MB/s(例如,5 分钟/50 GB)。 这种启动开销是否可以接受主要取决于训练作业的总持续时间,因为较长的训练阶段意味着相应较小的下载阶段。

Amazon S3 快速文件模式

FastFile 模式通过符合 POSIX 的文件系统接口公开 S3 对象,就好像这些文件在训练实例的本地磁盘上可用,并在训练脚本使用数据时按需流式传输它们的内容。 这意味着您的数据集不再需要适合训练实例存储空间,并且您无需等待数据集下载到训练实例即可开始训练。

为了促进这一点,SageMaker 在您的训练脚本运行之前列出存储在指定 S3 前缀下的所有对象元数据。 此元数据用于创建只读 FUSE(用户空间中的文件系统) 可通过以下方式用于您的训练脚本 /opt/ml/data/training-channel-name. 清单 S3 对象以每秒 5,500 个对象的速度运行,无论其大小如何。 这比预先下载文件要快得多,就像文件模式一样。 当您的训练脚本运行时,它可以列出或读取文件,就好像它们在本地可用一样。 每个读取操作都委托给 FUSE 服务,该服务将 GET 请求代理到 Amazon S3,以便将实际文件内容传递给调用者。 与本地文件系统一样,FastFile 将文件视为字节,因此它与文件格式无关。 FastFile 模式在使用多个 worker 顺序读取大文件时可以达到超过 XNUMX GB/s 的吞吐量。 您可以使用 FastFile 读取小文件或检索随机字节范围,但您应该期望此类访问模式的吞吐量较低。 您可以通过将许多小文件序列化到较大的文件容器中来优化您的读取访问模式,并按顺序读取它们。

FastFile 目前仅支持 S3 前缀(不支持清单和扩充清单),并且 FastFile 模式与 SageMaker 本地模式兼容。

Amazon S3 管道模式

管道模式是另一种流模式,它在很大程度上被更新且更易于使用的 FastFile 模式所取代。

使用管道模式,数据以高并发和吞吐量从 Amazon S3 预取,并流式传输到 Unix 命名的 FIFO 管道中。 每个管道只能由单个进程读取。 SageMaker 特定于 TensorFlow 的扩展,方便 将 Pipe 模式集成到原生 TensorFlow 数据加载器中 用于流式传输文本、TFRecords 或 RecordIO 文件格式。 管道模式还支持数据的托管分片和洗牌。

FSx 光泽

FSx for Lustre 可以通过低延迟文件检索扩展到数百 GB/s 的吞吐量和数百万 IOPS。

开始训练作业时,SageMaker 将 FSx for Lustre 文件系统挂载到训练实例文件系统,然后启动您的训练脚本。 挂载本身是一个相对较快的操作,它不依赖于存储在 FSx for Lustre 中的数据集的大小。

在许多情况下,您会为 Lustre 文件系统创建 FSx 并 将其链接到 S3 存储桶和前缀. 当链接到 S3 存储桶作为源时,文件会在您的训练脚本读取文件时延迟加载到文件系统中。 这意味着,在您第一次训练运行的第一个 epoch 之后,整个数据集从 Amazon S3 复制到 FSx 以进行 Lustre 存储(假设 epoch 被定义为考虑训练示例的单个完整扫描,并且分配的 FSx 用于光泽存储足够大)。 这使得任何后续 epoch 和具有相同数据集的训练作业都可以进行低延迟文件访问。

你也可以 将文件预加载到文件系统中 在开始训练作业之前,这可以缓解由于延迟加载导致的冷启动。 也可以并行运行由同一个 FSx for Lustre 文件系统提供服务的多个训练作业。 要访问 FSx for Lustre,您的训练作业必须连接到 VPC(请参阅 VPCConfig 设置),这需要 DevOps 设置和参与。 为避免数据传输成本,文件系统使用单个可用区,您需要在运行训练作业时指定此可用区 ID。 由于您使用 Amazon S3 作为长期数据存储,我们建议您部署 FSx for Lustre with Scratch 2 存储,作为高吞吐量的经济高效的短期存储选择,提供 200 MB/s 的基准以及每 TB 预置存储高达 1300 MB/s 的突增速度。

随着您的 FSx for Lustre 文件系统不断运行,您可以开始新的训练作业而无需等待创建文件系统,并且不必担心在第一个 epoch 期间的冷启动(因为文件仍然可以缓存在Lustre 文件系统的 FSx)。 这种情况下的缺点是与保持文件系统运行相关的额外成本。 或者,您可以在每个训练作业之前和之后创建和删除文件系统(可能使用脚本自动化来帮助),但是初始化 FSx for Lustre 文件系统需要时间,这与它所拥有的文件数量成正比(对于例如,从 Amazon S2 索引大约 3 万个对象大约需要一个小时)。

亚马逊 EFS

如果您的训练数据由于除 ML 训练之外的用例而已驻留在 Amazon EFS 中,我们建议您使用 Amazon EFS。 要将 Amazon EFS 用作数据源,数据必须在训练之前已经驻留在 Amazon EFS 中。 SageMaker 将指定的 Amazon EFS 文件系统挂载到训练实例,然后启动您的训练脚本。 配置 Amazon EFS 文件系统时,您需要在针对延迟优化的默认通用性能模式(适用于小文件)和最大 I/O 性能模式(可以扩展到更高级别的聚合吞吐量和每秒操作数(更适合训练有许多 I/O 工作人员的工作)。 要了解更多信息,请参阅 使用正确的性能模式.

此外,您可以在两个计量吞吐量选项之间进行选择:突发吞吐量和预配置吞吐量。 1 TB 文件系统的突增吞吐量提供 150 MB/s 的基准,同时能够在每天 300 小时的时间段内突增到 12 MB/s。 如果您需要更高的基线吞吐量,或者发现自己多次用完突发积分,您可以增加文件系统的大小或切换到预置吞吐量。 在预置吞吐量中,您为所需的基准吞吐量付费,最高读取速度为 3072 MB/s。

您的训练作业必须连接到 VPC(请参阅 VPCConfig 设置) 以访问 Amazon EFS。

选择最佳数据源

训练作业的最佳数据源取决于工作负载特征,例如数据集大小、文件格式、平均文件大小、训练持续时间、顺序或随机数据加载器读取模式,以及模型消耗训练数据的速度。

何时使用 Amazon EFS

如果您的数据集主要存储在 Amazon EFS 上,您可能有一个使用 Amazon EFS 进行存储的预处理或注释应用程序。 您可以轻松运行配置了指向 Amazon EFS 文件系统的数据通道的训练作业(有关更多信息,请参阅 使用适用于Lustre和Amazon EFS文件系统的Amazon FSx加快在Amazon SageMaker上的培训)。 如果性能不如您预期的那么好,请使用 Amazon EFS 性能指南,或考虑其他输入模式。

对小型数据集使用文件模式

如果数据集存储在 Amazon S3 上并且其整体容量相对较小(例如,小于 50–100 GB),请尝试使用文件模式. 下载 50 GB 数据集的开销可能因文件总数而异(例如,如果分块为 5 MB 分片,则大约需要 100 分钟)。 这种启动开销是否可以接受主要取决于训练作业的总持续时间,因为较长的训练阶段意味着相应较小的下载阶段。

一起序列化许多小文件

如果您的数据集很小(小于 50–100 GB),但由许多小文件(小于 50 MB)组成,则文件模式下载开销会增加,因为每个文件都需要单独从 Amazon S3 下载到训练实例量。 为了减少这种开销,并总体上加快数据遍历,请考虑使用以下文件格式将较小的文件组序列化到更少的较大文件容器中(例如每个文件 150 MB) 记录 对于 TensorFlow, Web数据集 对于 PyTorch,或 记录IO 对于 MXNet。 这些格式要求您的数据加载器按顺序遍历示例。 您仍然可以通过在每个 epoch 之后随机重新排序 TFRecord 文件列表以及从本地随机播放缓冲区中随机采样数据来随机播放您的数据(请参阅以下内容 TensorFlow 示例).

何时使用 FastFile 模式

对于具有较大文件(超过 50 MB)的较大数据集,第一个选择是尝试 FastFile 模式,它比 FSx for Lustre 更易于使用,因为它不需要创建文件系统或连接到 VPC。 FastFile 模式非常适合大型文件容器(超过 150 MB),也可能适用于超过 50 MB 的文件。 因为 FastFile 模式提供了 POSIX 接口,所以它支持随机读取(读取非顺序字节范围)。 但是,这不是理想的用例,您的吞吐量可能会低于顺序读取。 但是,如果您有一个相对较大且计算量较大的 ML 模型,FastFile 模式可能仍然能够使训练管道的有效带宽饱和,并且不会导致 I/O 瓶颈。 您需要进行实验并查看。 幸运的是,从文件模式切换到 FastFile(并返回)就像添加(或删除) input_mode='FastFile' 使用 SageMaker Python SDK 定义输入通道时的参数:

无需更改其他代码或配置。

何时将 FSx 用于 Lustre

如果你的数据集对于文件模式来说太大了,或者有很多小文件(你不能轻易地序列化),或者你有随机读取访问模式,FSx for Lustre 是一个不错的选择。 它的文件系统可扩展到数百 GB/s 的吞吐量和数百万的 IOPS,当您有许多小文件时,这是理想的选择。 但是,如前所述,请注意由于延迟加载导致的冷启动问题,以及为 Lustre 文件系统设置和初始化 FSx 的开销。

成本考虑

对于大多数 ML 训练工作,尤其是使用 GPU 或专用 ML 芯片的工作,大部分训练成本是 ML 训练实例的计费秒数。 每月存储 GB、API 请求和预置吞吐量是与您使用的数据源直接相关的额外成本。

每月存储 GB

对于较大的数据集,例如视频、LiDAR 传感器数据和 AdTech 实时竞价日志,每月存储 GB 可能非常重要。 例如,将 1 TB 存储在 Amazon S3 智能分层频繁访问层 每月收费 23 美元。 在 Amazon S3 之上添加 FSx for Lustre 文件系统会产生额外成本。 例如,创建一个 1.2 TB 的、由 SSD 支持的 Scratch 2 类型且禁用数据压缩的文件系统每月额外花费 168 美元(140 美元/TB/月)。

使用 Amazon S3 和 Amazon EFS,您只需为使用量付费,这意味着您需要根据实际数据集大小付费。 使用 FSx for Lustre,您需要按预配的文件系统大小(至少 1.2 TB)付费。 使用 EBS 卷运行 ML 实例时,Amazon EBS 的收费独立于 ML 实例。 与运行实例的成本相比,这通常是低得多的成本。 例如,使用 3.2 GB EBS 卷运行 ml.p100xlarge 实例 1 小时,实例成本为 3.825 美元,EBS 卷成本为 0.02 美元。

API 请求和预置吞吐量成本

当您的训练作业处理数据集时,它会通过分派 Amazon S3 API 请求来列出和获取文件。 例如,每百万个 GET 请求的价格为 0.4 美元(使用 Intelligent-Tiering 类)。 您应该期望没有数据传输成本进出 Amazon S3,因为培训是在单个可用区中进行的。

使用链接到 S3 存储桶的 FSx for Lustre 时,您会因读取尚未缓存在文件系统中的数据而产生 Amazon S3 API 请求成本,因为 FSx For Lustre 代理对 Amazon S3 的请求(并缓存结果)。 Lustre 本身没有 FSx 的直接请求成本。 当您使用 FSx for Lustre 文件系统时,通过运行连接到您在其中预置文件系统的同一可用区的训练作业来避免跨可用区数据传输的成本。具有预置吞吐量的 Amazon EFS 会增加额外的成本每月 GB。

绩效案例研究

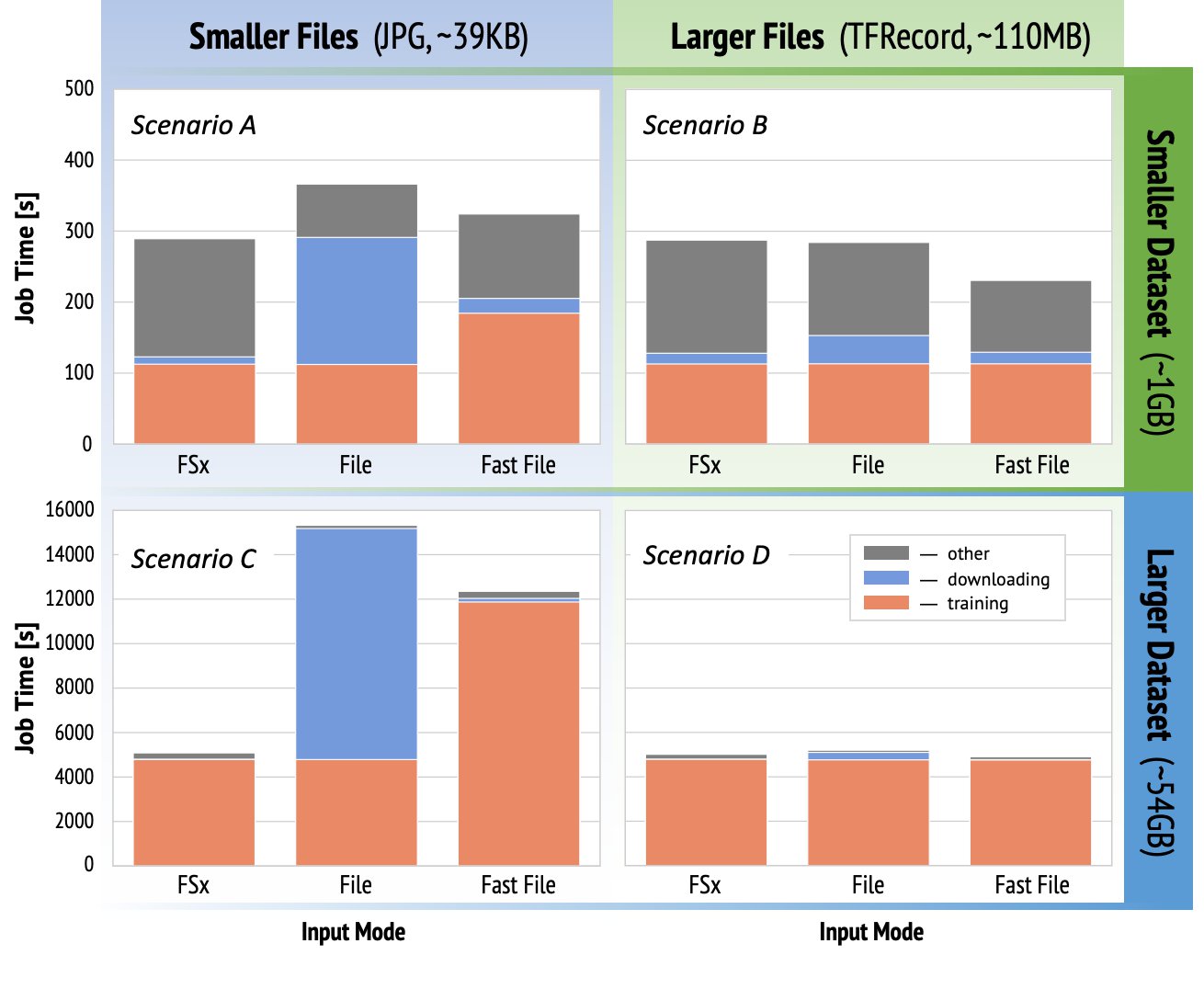

为了演示前面提到的训练性能考虑,我们针对计算机视觉领域的实际用例执行了一系列基准测试。 本节中的基准(和要点)可能并不适用于所有场景,并且会受到我们使用的各种预定因素的影响,例如 DNN。 我们对以下 12 种组合进行了测试:

- 输入方式 – FSx for Lustre、文件模式、FastFile 模式

- 数据集大小 – 较小的数据集 (1 GB),较大的数据集 (54 GB)

- 文件大小 – 较小的文件(JPG,大约 39 KB),较大的文件(TFRecord,大约 110 MB)

在本案例研究中,我们选择了使用最广泛的输入模式,因此省略了 Amazon EFS 和管道模式。

案例研究基准设计为 ml.p3.2xlarge 单 GPU 实例上的端到端 SageMaker TensorFlow 训练作业。 我们选择著名的 ResNet-50 作为分类任务的主干模型,选择 Caltech-256 作为较小的训练数据集(我们复制了 50 次以创建更大的数据集版本)。 我们进行了一个 epoch 的训练,定义为对训练示例的一次完整扫描。

下图显示了每个基准方案的 SageMaker 训练作业的总计费时间。 总作业时间本身包括下载、训练和其他阶段(例如容器启动和将经过训练的模型工件上传到 Amazon S3)。 更短的计费时间转化为更快、更便宜的培训工作。

我们先来讨论 方案 A 和方案 C,它方便地展示了当数据集由许多小文件组成时输入模式之间的性能差异。

情景A (较小的文件,较小的数据集)表明使用 FSx for Lustre 文件系统的训练作业的计费时间最短。 它具有最短的下载阶段,其训练阶段与 File 模式一样快,但比 FastFile 快。 Lustre 的 FSx 是这个单一时代测试的赢家。 话虽如此,考虑一个类似的工作负载,但有多个 epoch——文件模式的相对开销由于下载阶段而随着更多 epoch 的增加而减少。 在这种情况下,我们更喜欢文件模式,因为它易于使用。 此外,您可能会发现使用文件模式并支付 100 额外计费秒是比为 Lustre 文件系统支付和配置 FSx 更好的选择。

方案C (较小的文件,较大的数据集)显示 FSx for Lustre 是最快的模式,总计费时间仅为 5,000 秒。 它还具有最短的下载阶段,因为挂载 FSx for Lustre 文件系统不依赖于文件系统中的文件数量(在本例中为 1.5 万个文件)。 FastFile 的下载开销也很小; 它仅获取位于指定 S3 存储桶前缀下的文件的元数据,而在训练阶段读取文件的内容。 文件模式是最慢的模式,在开始训练之前要花费 10,000 秒预先下载整个数据集。 当我们查看训练阶段时,FSx for Lustre 和 File 模式表现出类似的出色性能。 至于 FastFile 模式,当直接从 Amazon S3 流式传输较小的文件时,相对于文件传输的总持续时间(尽管使用具有预取缓冲区的高度并行数据加载器),为每个文件分派新 GET 请求的开销变得很大。 这会导致 FastFile 模式的总体吞吐量较低,从而为训练作业造成 I/O 瓶颈。 在这种情况下,FSx for Lustre 显然是赢家。

场景 B 和 D 当数据集由较少的较大文件组成时,显示跨输入模式的性能差异。 使用较大的文件顺序读取通常会导致更好的 I/O 性能,因为它允许有效的缓冲并减少 I/O 操作的数量。

情景B (较大的文件,较小的数据集)显示所有模式的相似训练阶段时间(证明训练不受 I/O 限制)。 在这种情况下,由于下载阶段较短,我们更喜欢 FastFile 模式而不是 File 模式,而对于 Lustre,我们更喜欢 FastFile 模式而不是 FSx,因为前者易于使用。

方案 D (更大的文件,更大的数据集)显示所有三种模式的总计费时间相对相似。 对于 Lustre 和 FastFile,File 模式的下载阶段比 FSx 的要长。 文件模式在开始训练阶段之前将整个数据集 (54 GB) 从 Amazon S3 下载到训练实例。 所有三种模式都在训练阶段花费相似的时间,因为所有模式都可以足够快地获取数据并且受 GPU 限制。 如果我们使用具有额外 CPU 或 GPU 资源的 ML 实例,例如 ml.p4d.24xlarge,则使计算资源饱和所需的数据 I/O 吞吐量会增加。 在这些情况下,我们可以预期 FastFile 和 FSx for Lustre 能够成功扩展其吞吐量(但是,FSx for Lustre 吞吐量取决于预置文件系统的大小)。 文件模式扩展其吞吐量的能力取决于附加到实例的磁盘卷的吞吐量。 例如,Amazon EBS 支持的实例(如 ml.p3.2xlarge、ml.p3.8xlarge 和 ml.p3.16xlarge)的最大吞吐量限制为 250MB/s,而本地 NVMe 支持的实例(如 ml. g5.* 或 ml.p4d.24xlarge)可以容纳更大的吞吐量。

总而言之,我们认为 FastFile 是这种场景的赢家,因为它比文件模式更快,并且与 Lustre 的 FSx 一样快,而且使用更简单,成本更低,并且可以根据需要轻松扩展其吞吐量。

此外,如果我们有一个更大的数据集(几 TB 大小),文件模式将花费数小时下载数据集,然后才能开始训练,而 FastFile 可以更快地开始训练。

自带数据摄取

SageMaker 的本机数据源适合大多数但不是所有可能的 ML 训练场景。 您可能需要寻找其他数据摄取选项的情况可能包括直接从第三方存储产品读取数据(假设无法轻松及时地导出到 Amazon S3),或者对相同的训练有强烈要求在 SageMaker 和 亚马逊弹性计算云 (Amazon EC2)或 Amazon Elastic Kubernetes服务 (亚马逊 EKS)。 您可以通过在训练脚本中实施数据摄取机制来解决这些情况。 该机制负责将数据集从外部数据源读取到训练实例中。 例如, TFRecordDataset TensorFlow 的 tf.data 库可以直接从 Amazon S3 存储中读取。

如果您的数据摄取机制需要调用任何 AWS 服务,例如 亚马逊关系数据库服务 (Amazon RDS),请确保 AWS身份和访问管理 (IAM) 您的训练作业的角色包括相关的 IAM 策略。 如果数据源位于 亚马逊虚拟私有云 (Amazon VPC),您需要运行连接到同一 VPC 的训练作业。

当您自己管理数据集摄取时,SageMaker 沿袭跟踪无法自动记录训练期间使用的数据集。 因此,请考虑使用替代机制(例如训练作业标签或超参数)来捕获相关元数据。

结论

选择正确的 SageMaker 训练数据源可能会对训练 ML 模型的速度、易用性和成本产生深远影响。 使用提供的流程图快速入门、观察结果并根据需要尝试其他配置。 请记住每个数据源的优点、缺点和局限性,以及它们在多大程度上适合您的培训工作的个人要求。 联系 AWS 联系人以获取更多信息和帮助。

作者简介

吉利纳楚姆 是一名高级 AI/ML 专家解决方案架构师,是 EMEA 亚马逊机器学习团队的一员。 Gili 对训练深度学习模型的挑战以及机器学习如何改变我们所知道的世界充满热情。 在业余时间,吉利喜欢打乒乓球。

吉利纳楚姆 是一名高级 AI/ML 专家解决方案架构师,是 EMEA 亚马逊机器学习团队的一员。 Gili 对训练深度学习模型的挑战以及机器学习如何改变我们所知道的世界充满热情。 在业余时间,吉利喜欢打乒乓球。

亚历山大·阿尔扎诺夫博士 是位于德国法兰克福的 AI/ML 专家解决方案架构师。 他帮助 AWS 客户在 EMEA 地区设计和部署他们的机器学习解决方案。 在加入 AWS 之前,Alexander 正在研究我们宇宙中重元素的起源,并在他的大规模科学计算中使用机器学习后对机器学习产生了热情。

亚历山大·阿尔扎诺夫博士 是位于德国法兰克福的 AI/ML 专家解决方案架构师。 他帮助 AWS 客户在 EMEA 地区设计和部署他们的机器学习解决方案。 在加入 AWS 之前,Alexander 正在研究我们宇宙中重元素的起源,并在他的大规模科学计算中使用机器学习后对机器学习产生了热情。

- "

- 000

- 1结核病

- 100

- 39

- 关于

- ACCESS

- 根据

- 横过

- 额外

- 地址

- 算法

- 所有类型

- 已经

- Amazon

- 另一个

- API

- 相应

- 应用领域

- 增强

- 汽车

- 自动化

- 可用性

- 可使用

- AWS

- 底线

- 作为

- 基准

- 最佳

- 建立

- 呼叫

- 案例研究

- 例

- 挑战

- 更改

- 通道

- 带电

- 碎屑

- 分类

- 码

- 组合

- 组合

- 相当常见

- 相比

- 计算

- 配置

- 缺点

- 消耗

- 容器

- 集装箱

- 包含

- 内容

- 经济有效

- 成本

- 可以

- 创造

- 积分

- 合作伙伴

- data

- 数据存储

- 数据库

- 天

- 需求

- 部署

- 设计

- 尽管

- 不同

- 讨论

- 分布

- 不会

- 域

- 下载

- 容易

- 效果

- 有效

- 特别

- 例子

- 优秀

- 预期

- 实验

- 因素

- 高效率

- 姓氏:

- 适合

- 流

- 遵循

- 以下

- 格式

- ,

- 其他咨询

- 德国

- GitHub上

- 非常好

- 治理

- GPU

- 方针

- 有

- 帮助

- 帮助

- 高

- 高度

- 创新中心

- HTTPS

- 数百

- 身分

- 增加

- 指数

- 个人

- 行业领先

- 信息

- 接口

- 问题

- IT

- 工作

- 工作机会

- 保持

- 键

- 标签

- 大

- 大

- 发射

- 学习用品

- 学习

- 自学资料库

- 有限

- Line

- 清单

- 清单

- 书单

- 本地

- 当地

- 机

- 机器学习

- 多数

- 意

- 百万

- 百万

- 介意

- ML

- 模型

- 模型

- 最先进的

- 优惠精选

- 好

- 运营

- 附加选项

- 附加选项

- 秩序

- 其他名称

- 模式

- 性能

- 相

- 管

- 政策

- 热门

- 可能

- 车资

- 私立

- 过程

- 产品

- PROS

- 提供

- 提供

- 目的

- 很快

- 范围

- 阅读

- 实时的

- 建议

- 减少

- 闻名

- 更换

- 要求

- 必须

- 岗位要求

- 资源

- 资源

- 提供品牌战略规划

- 成果

- 运行

- 运行

- 说

- 可扩展性

- 可扩展性

- 鳞片

- 科学家

- SDK

- 保安

- 选

- 系列

- 无服务器

- 服务

- 特色服务

- 设置

- 分片

- 共用的,

- 显著

- 类似

- 简易

- 尺寸

- 小

- So

- 解决方案

- 太空

- 速度

- 花

- 花费

- Spot

- 传播

- 阶段

- 开始

- 开始

- 启动

- 存储

- 流

- 流

- 强烈

- 学习

- 顺利

- SUPPORT

- 支持

- 扫描

- Switch 开关

- 系统

- 产品

- 团队

- test

- 测试

- 世界

- 第三方

- 通过

- 次

- 最佳

- 跟踪

- 产品培训

- 平时

- 视频

- 在线会议

- 愿景

- 体积

- 等待

- 什么是

- 是否

- WHO

- 维基百科上的数据

- 中

- 也完全不需要

- 工人

- 合作

- 世界