社交网络或在线游戏等在线社交活动的增加往往充满敌意或攻击性行为,可能导致未经请求的仇恨言论、网络欺凌或骚扰的表现。 例如,许多在线游戏社区提供语音聊天功能以促进用户之间的沟通。 尽管语音聊天通常支持友好的玩笑和垃圾话,但它也可能导致仇恨言论、网络欺凌、骚扰和诈骗等问题。 标记有害语言有助于组织保持对话文明,并维护一个安全、包容的在线环境,供用户自由创建、共享和参与。 如今,许多公司仅依靠人工审核员来审查有毒内容。 然而,扩展人工审核员以足够的质量和速度满足这些需求的成本很高。 因此,许多组织面临着高用户流失率、声誉受损和监管罚款的风险。 此外,审核员经常会因审查有毒内容而受到心理影响。

亚马逊转录 是一项自动语音识别 (ASR) 服务,使开发人员可以轻松地向其应用程序添加语音转文本功能。 今天,我们很高兴地宣布 Amazon Transcribe 毒性检测,一种机器学习 (ML) 支持的功能,使用基于音频和文本的提示来识别和分类七类基于语音的有毒内容,包括性骚扰、仇恨言论、威胁、虐待、亵渎、侮辱和图形语言。 除了文本之外,毒性检测还使用音调和音调等语音提示来确定语音中的有毒意图。

这是对标准内容审核系统的改进,该系统旨在仅关注特定术语,而不考虑意图。 大多数企业都有 7-15 天的 SLA 来审查用户报告的内容,因为主持人必须收听冗长的音频文件来评估对话是否以及何时变得有毒。 通过 Amazon Transcribe ToxicityDetection,审核者仅审查音频文件中标记为有毒内容的特定部分(相对于整个音频文件)。 人工审核者必须审核的内容减少了 95%,使客户能够将 SLA 缩短到几个小时,并能够主动审核用户标记的内容之外的更多内容。 它将允许企业大规模自动检测和调节内容,提供安全和包容的在线环境,并在导致用户流失或声誉受损之前采取行动。 用于有毒内容检测的模型由 Amazon Transcribe 维护并定期更新,以保持准确性和相关性。

在这篇文章中,您将学习如何:

- 使用 Amazon Transcribe ToxicityDetection 识别语音中的有害内容

- 使用 Amazon Transcribe 控制台进行毒性检测

- 使用以下命令创建具有毒性检测的转录作业 AWS命令行界面 (AWS CLI) 和 Python 开发工具包

- 使用 Amazon Transcribe 毒性检测 API 响应

使用 Amazon Transcribe Toxicity Inspection 检测音频聊天中的毒性

Amazon Transcribe 现在提供了一种基于 ML 的简单解决方案,用于标记口语对话中的有害语言。 此功能对于社交媒体、游戏和一般需求特别有用,无需客户提供自己的数据来训练 ML 模型。 毒性检测将有毒音频内容分为以下七类,并为每个类别提供置信度得分 (0–1):

- 亵渎 – 包含不礼貌、粗俗或冒犯性的单词、短语或缩写词的言论。

- 仇恨言论 – 基于身份(例如种族、民族、性别、宗教、性取向、能力和国籍)批评、侮辱、谴责或非人化个人或群体的言论。

- 有性 – 使用直接或间接提及身体部位、身体特征或性别来表明性兴趣、活动或性唤起的言语。

- 侮辱 – 包含贬低、羞辱、嘲笑、侮辱或贬低语言的言论。 这种语言也被称为欺凌。

- 暴力或威胁 – 包含试图对个人或团体造成痛苦、伤害或敌意的威胁的言论。

- 图形 – 使用视觉描述性和令人不快的生动图像的演讲。 这种类型的语言通常故意冗长,以加剧接收者的不适。

- 骚扰或辱骂 – 旨在影响接受者心理健康的言论,包括贬低和客观化术语。

您可以通过 Amazon Transcribe 控制台或使用 AWS CLI 或 AWS 开发工具包直接调用 API 来访问毒性检测。 在 Amazon Transcribe 控制台上,您可以上传要测试毒性的音频文件,只需单击几下即可获得结果。 Amazon Transcribe 将识别有毒内容并对其进行分类,例如骚扰、仇恨言论、性内容、暴力、侮辱和脏话。 Amazon Transcribe 还为每个类别提供置信度评分,从而提供有关内容毒性级别的宝贵见解。 毒性检测目前可在标准 Amazon Transcribe API 中进行批量处理,并支持美国英语。

Amazon Transcribe 控制台演练

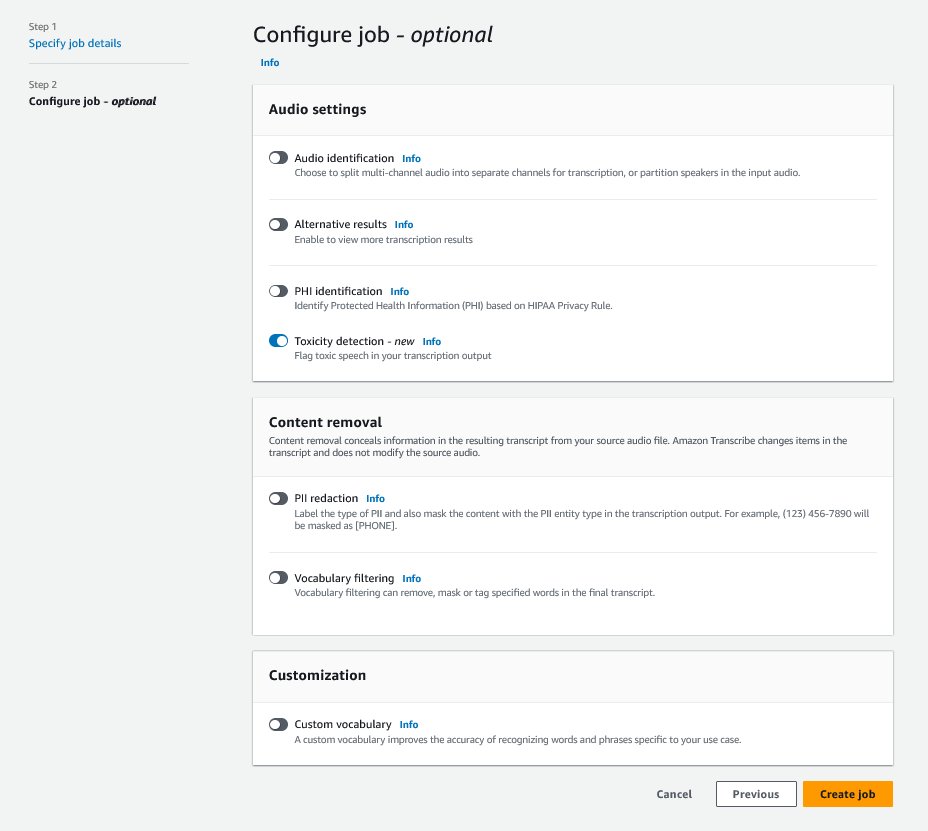

首先,请登录 AWS管理控制台 并转到 Amazon Transcribe。 要创建新的转录作业,您需要将录制的文件上传到 亚马逊简单存储服务 (Amazon S3) 存储桶,然后才能对其进行处理。 在音频设置页面,如下图所示,启用 毒性检测 并继续创建新的工作。 Amazon Transcribe 将在后台处理转录作业。 随着工作的进展,您可以预期状态会更改为 已完成 当过程完成时。

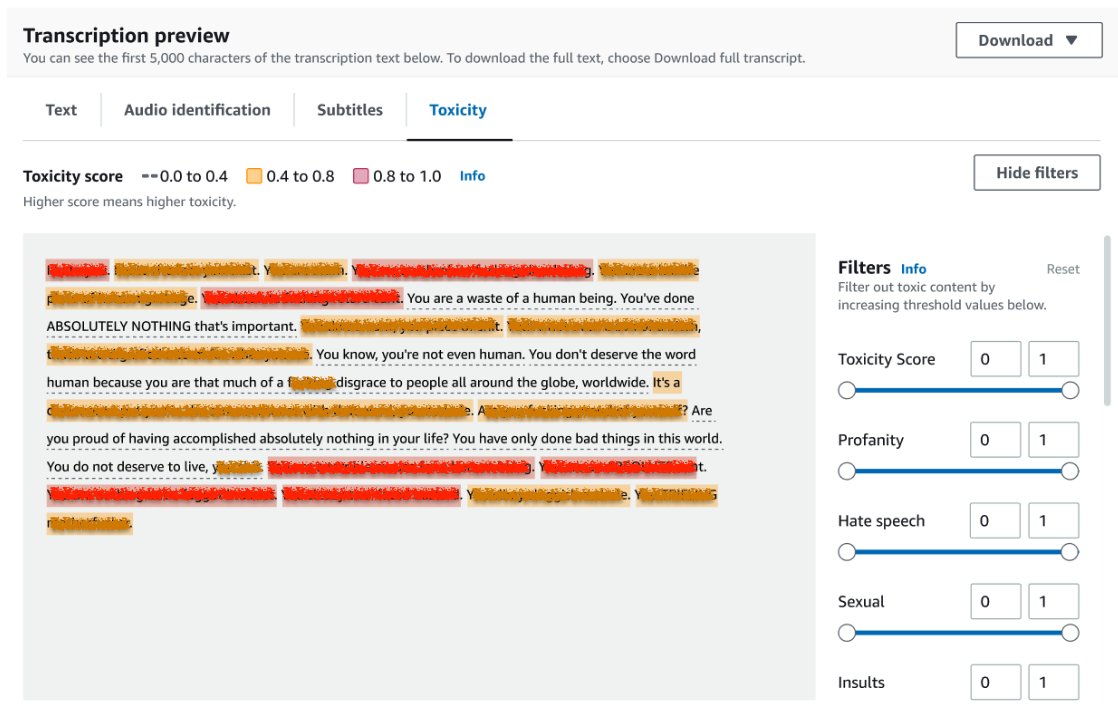

要查看转录作业的结果,请从作业列表中选择该作业并将其打开。 向下滚动到 转录预览 部分检查结果 毒性 标签。 用户界面显示颜色编码的转录片段来指示毒性水平,由置信度得分确定。 要自定义显示,您可以使用中的切换栏 筛选 窗格。 这些栏允许您调整阈值并相应地过滤毒性类别。

由于存在敏感或有毒信息,以下屏幕截图覆盖了部分转录文本。

带有毒性检测请求的转录 API

在本节中,我们将指导您使用编程接口创建具有毒性检测的转录作业。 如果音频文件尚未位于 S3 存储桶中,请将其上传以确保 Amazon Transcribe 能够访问。 与在控制台创建转录作业类似,调用作业时需要提供以下参数:

- 转录作业名称 – 指定唯一的作业名称。

- 媒体文件Uri – 输入音频文件在 Amazon S3 上的 URI 位置。 Amazon Transcribe 支持以下音频格式:MP3、MP4、WAV、FLAC、AMR、OGG 或 WebM

- 语言代码 - 设置

en-US。 截至撰写本文时,毒性检测仅支持美国英语。 - 毒性类别 – 通过

ALL值包括所有支持的毒性检测类别。

以下是使用 Python3 启用毒性检测来启动转录作业的示例:

您可以使用以下 AWS CLI 命令调用具有毒性检测的同一转录作业:

具有毒性检测响应的转录 API

Amazon Transcribe 毒性检测 JSON 输出将在结果字段中包含转录结果。 启用毒性检测会添加一个额外的字段,称为 toxicityDetection 在结果字段下。 toxicityDetection 包括具有以下参数的转录项目列表:

- 文本 – 原始转录文本

- 毒性 – 检测的置信度得分(0-1 之间的值)

- 类别 – 每个类别的有毒言论的置信度得分

- 开始时间 – 音频文件中检测的起始位置(秒)

- 时间结束 – 音频文件中检测的结束位置(秒)

以下是您可以从控制台下载的简短毒性检测响应示例:

总结

在这篇文章中,我们概述了新的 Amazon Transcribe 毒性检测功能。 我们还描述了如何解析毒性检测 JSON 输出。 有关更多信息,请查看 Amazon Transcribe 控制台并尝试具有毒性检测功能的转录 API。

Amazon Transcribe 毒性检测现已在以下 AWS 区域推出:美国东部(俄亥俄)、美国东部(弗吉尼亚北部)、美国西部(俄勒冈)、亚太地区(悉尼)、欧洲(爱尔兰)和欧洲(伦敦)。 要了解更多信息,请访问 亚马逊转录.

进一步了解 AWS 上的内容审核 和我们的 内容审核 ML 用例。 迈出第一步 使用 AWS 简化您的内容审核操作.

关于作者

张拉娜 是 AWS WWSO AI 服务团队的高级解决方案架构师,专门研究用于内容审核、计算机视觉和自然语言处理的 AI 和 ML。 凭借其专业知识,她致力于推广 AWS AI/ML 解决方案,并协助客户在不同行业(包括社交媒体、游戏、电子商务以及广告和营销)转变其业务解决方案。

张拉娜 是 AWS WWSO AI 服务团队的高级解决方案架构师,专门研究用于内容审核、计算机视觉和自然语言处理的 AI 和 ML。 凭借其专业知识,她致力于推广 AWS AI/ML 解决方案,并协助客户在不同行业(包括社交媒体、游戏、电子商务以及广告和营销)转变其业务解决方案。

苏米特·库玛 是 AWS AI 语言服务团队的高级产品经理和技术人员。 他在多个领域拥有 10 年的产品管理经验,并且对 AI/ML 充满热情。 工作之余,Sumit 喜欢旅行,喜欢打板球和草地网球。

苏米特·库玛 是 AWS AI 语言服务团队的高级产品经理和技术人员。 他在多个领域拥有 10 年的产品管理经验,并且对 AI/ML 充满热情。 工作之余,Sumit 喜欢旅行,喜欢打板球和草地网球。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 汽车/电动汽车, 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 块偏移量。 现代化环境抵消所有权。 访问这里。

- Sumber: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- :具有

- :是

- :不是

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- 95%

- a

- 对,能力--

- 关于

- 滥用

- ACCESS

- 因此

- 基本会计和财务报表

- 横过

- 操作

- 活动

- 活动

- 加

- 增加

- 添加

- 广告

- 侵略性

- AI

- 人工智能服务

- AI / ML

- 所有类型

- 让

- 已经

- 还

- 尽管

- Amazon

- 亚马逊转录

- 亚马逊网络服务

- 其中

- an

- 和

- 宣布

- API

- APIs

- 应用领域

- 保健

- AS

- 亚洲

- 亚太

- 协助

- At

- 损耗

- 音频

- 自动表

- 自动

- 可使用

- AWS

- 背景

- 酒吧

- 基础

- BE

- 成为

- 因为

- before

- 行为

- 之间

- 超越

- 身体

- 都

- 午休

- 欺负

- 商业

- by

- 被称为

- 调用

- CAN

- 能力

- 类别

- 产品类别

- 原因

- 更改

- 查

- 分类

- 沟通

- 地区

- 公司

- 完成

- 完成

- 一台

- 计算机视觉

- 信心

- 安慰

- 包含

- 内容

- 谈话

- 对话

- 覆盖

- 创建信息图

- 创造

- 板球

- 批评

- 目前

- 合作伙伴

- 定制

- data

- 一年中的

- 专用

- 描述

- 设计

- 检测

- 检测

- 决心

- 开发

- 直接

- 直接

- 屏 显:

- 不同

- 域名

- 向下

- 下载

- 两

- 电子商务行业

- 每

- 东部

- 易

- 或

- 消除

- enable

- 启用

- 使

- 结束

- 英语

- 确保

- 输入

- 企业

- 整个

- 环境

- 特别

- 种族

- 欧洲

- 评估

- 例子

- 例子

- 兴奋

- 期望

- 昂贵

- 体验

- 专门知识

- 额外

- 促进

- 面对

- 失败

- 专栏

- 少数

- 部分

- 文件

- 档

- 过滤

- 结束

- 姓氏:

- 已标记

- 专注焦点

- 以下

- 针对

- 友好

- 止

- 功能

- 赌博

- 性别

- 其他咨询

- 得到

- Go

- GOES

- 图形

- 团队

- 指南

- 有害

- 有

- he

- 帮助

- 这里

- 此处

- 高

- HOURS

- 创新中心

- How To

- 但是

- HTML

- HTTP

- HTTPS

- 人

- 鉴定

- 身分

- if

- 影响

- 进口

- 改进

- in

- 包括

- 包括

- 包含

- 包容

- 增加

- 表明

- 表示

- 行业

- 信息

- 可行的洞见

- 侮辱

- 拟

- 意图

- 意图

- 故意地

- 兴趣

- 接口

- 成

- 爱尔兰

- IT

- 项目

- 工作

- JPG

- JSON

- 只是

- 保持

- 语言

- 铅

- 学习用品

- 学习

- Level

- Line

- 清单

- 圖書分館的位置

- 伦敦

- 爱

- 机

- 机器学习

- 保持

- 制作

- 颠覆性技术

- 经理

- 许多

- 营销

- 媒体

- 满足

- ML

- 模型

- 模型

- 适度

- 更多

- 最先进的

- 必须

- 姓名

- National

- 自然

- 自然语言处理

- 需求

- 需要

- 工业网络

- 全新

- 现在

- of

- 提供

- 经常

- 俄亥俄州

- on

- 在线

- 更快速的网络连接

- 仅由

- 打开

- 运营

- or

- 俄勒冈

- 组织

- 起源

- 我们的

- 输出

- 产量

- 学校以外

- 简介

- 己

- 太平洋

- 页

- 面包

- 参数

- 参加

- 部分

- 通过

- 多情

- 人

- 短语

- 的

- 沥青

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 一部分

- 位置

- 帖子

- 存在

- 问题

- 过程

- 处理

- 处理

- 产品

- 产品管理

- 产品经理

- 亵渎

- 代码编程

- 促进

- 提供

- 提供

- 提供

- 优

- 蟒蛇

- 质量

- 种族

- 价格表

- 原

- 准备

- 承认

- 记录

- 减少

- 减少

- 引用

- 地区

- 监管

- 相关性

- 宗教

- 依靠

- 报道

- 响应

- 导致

- 成果

- 检讨

- 回顾

- 风险

- 安全

- 同

- 鳞片

- 缩放

- 诈骗

- 得分了

- 滚动

- sdk

- 秒

- 部分

- 寻求

- 段

- 中模板

- 前辈

- 敏感

- 服务

- 特色服务

- 集

- 设置

- XNUMX所

- 性生活

- 有性

- Share

- 她

- 如图

- 作品

- 签署

- 类似

- 简易

- 社会

- 社会化媒体

- 社交网络

- 独自

- 方案,

- 解决方案

- 专业

- 具体的

- 言语

- 语音识别

- 语音到文本

- 速度

- 说

- 标准

- 开始

- 开始

- 开始

- Status

- 步

- 存储

- 这样

- 足够

- 支持

- 支持

- 悉尼

- 产品

- 采取

- 说

- 团队

- 文案

- 条款

- test

- 这

- 其

- 他们

- 博曼

- 他们

- Free Introduction

- 威胁

- 通过

- 次

- 至

- 今晚

- 对于

- 向

- 培训

- 转型

- 旅行

- true

- 尝试

- 类型

- ui

- 下

- 独特

- 不请自来

- 更新

- us

- 使用

- 用过的

- 用户

- 用户

- 使用

- 运用

- 有价值

- 折扣值

- 各种

- 通过

- 暴力

- 弗吉尼亚州

- 愿景

- 参观

- 音色

- vs

- 普通

- 等待

- 想

- we

- 卷筒纸

- Web服务

- 井

- 西部

- ,尤其是

- 而

- 将

- 也完全不需要

- 话

- 工作

- 写作

- 年

- 但

- 完全

- 您一站式解决方案

- 和风网