洛斯阿拉莫斯国家实验室的研究人员今天宣布了一项量子机器学习“证明”,他们说,下雨一个量子神经网络只需要少量数据,“(颠覆)先前的假设源于经典计算对机器学习数据的巨大需求,或人工智能。”

该实验室表示,该定理具有直接应用,包括更有效地编译量子计算机和区分物质相以发现材料。

“许多人认为,量子机器学习将需要大量数据,”洛斯阿拉莫斯量子理论家 Lukasz Cincio (T-4) 说,他是包含 23 月 XNUMX 日发表在期刊上的证明的论文的合著者。 自然通讯. “我们已经严格证明,对于很多相关问题,情况并非如此。

本文, 从少量训练数据中推广量子机器学习,作者是 Matthias C. Caro、Hsin-Yuan Huang、Cerezo、Kunal Sharma、Sornborger、Patrick Coles 和 Cincio。

“这为量子机器学习提供了新的希望,”他说。 “当量子计算机的性能优于经典计算机时,我们正在缩小我们今天拥有的东西与量子优势所需的东西之间的差距。”

人工智能系统需要数据来训练神经网络以识别——泛化为——在实际应用中看不见的数据。 洛斯阿拉莫斯在其公告中表示,假设参数或变量的数量将由称为希尔伯特空间的数学结构的大小决定,对于大量量子比特的训练,该空间将成指数增长。 这种大小使得这种方法在计算上几乎是不可能的。

“对大型数据集的需求可能是量子人工智能的障碍,但我们的工作消除了这个障碍。 虽然量子人工智能的其他问题可能仍然存在,但至少现在我们知道数据集的大小不是问题,”实验室的量子理论家、该论文的合著者科尔斯 (T-4) 说。

“对大型数据集的需求可能是量子人工智能的障碍,但我们的工作消除了这个障碍。 虽然量子人工智能的其他问题可能仍然存在,但至少现在我们知道数据集的大小不是问题,”实验室的量子理论家、该论文的合著者科尔斯 (T-4) 说。

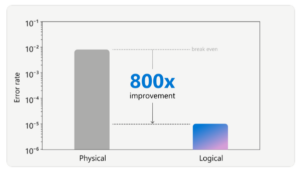

“很难想象希尔伯特空间有多大:即使你只有 30 个量子比特,它也是十亿个状态的空间,”科尔斯说。 “量子人工智能的训练过程发生在这个广阔的空间内。 您可能认为在这个空间中搜索需要十亿个数据点来指导您。 但是我们向您展示了您只需要与模型中的参数数量一样多的数据点。 这通常大致等于量子比特的数量——所以只有大约 30 个数据点,”科尔斯说。

Cincio 说,结果的一个关键方面是,即使对于模拟量子 AI 模型的经典算法,它们也能保证效率,因此训练数据和编译通常可以在经典计算机上处理,从而简化了过程。 然后机器学习模型在量子计算机上运行。

“这意味着我们可以降低对量子计算机在噪声和错误方面所需的性能质量的要求,以执行有意义的量子模拟,从而使量子优势越来越接近现实,”Cincio 说。

新证明带来的加速具有戏剧性的实际应用。 研究小组发现,相对于数据量,他们可以保证用更少的计算门来编译或准备在量子计算机上处理量子模型。 编译是量子计算行业的一个关键应用,可以缩小长序列的操作门或将系统的量子动力学转换为门序列。

“我们的定理将为量子计算带来更好的编译工具,”Cincio 说。 “尤其是当今嘈杂的中等规模的量子计算机,每个门都很重要,你希望使用尽可能少的门,这样你就不会拾取太多噪声,从而导致错误。”

洛斯阿拉莫斯说,该团队还表明,在对非常小的数据集进行训练后,量子人工智能可以跨相变对量子态进行分类。

“对量子物质的相进行分类对材料科学很重要,并且与洛斯阿拉莫斯的使命相关,”该实验室量子科学中心主任、该论文的合著者 Andrew Sornborger (CCS-3) 说。 “这些材料很复杂,具有多个不同的相,如超导相和磁相。”

Sornborger 说,制造具有所需特性(例如超导性)的材料涉及到对相图的理解,该团队证明可以通过最少培训的机器学习系统来发现相图。

新定理的其他潜在应用包括学习量子纠错码和量子动力学模拟。

“新方法的效率超出了我们的预期,”洛斯阿拉莫斯量子机器学习专家 Marco Cerezo (CCS-3) 说。 “我们可以在几分钟内用很少的训练点编译某些非常大的量子操作——这在以前是不可能的。”

“很长一段时间,我们无法相信这种方法会如此有效,”Cincio 说。 “使用编译器,我们的数值分析表明它比我们可以证明的还要好。 我们只需要在可能的数十亿个州中的少数几个州上进行训练。 我们不必检查每个选项,而只需检查几个。 这极大地简化了培训。”

资金(仅限洛斯阿拉莫斯合著者):洛斯阿拉莫斯国家实验室的 ASC 超越摩尔定律项目; 美国能源部科学办公室、高级科学计算研究办公室加速研究量子计算计划; 洛斯阿拉莫斯国家实验室的实验室指导研究和开发计划; 美国能源部科学办公室、国家量子信息科学研究中心、量子科学中心; 和国防部。