亚马逊SageMaker 使部署机器学习 (ML) 模型进行实时推理变得简单,并提供跨 CPU 和加速器的广泛 ML 实例选择,例如 AWS 推理。作为完全托管的服务,您可以扩展模型部署,最大限度地降低推理成本,并在生产中更有效地管理模型,同时减少运营负担。 SageMaker 实时推理端点由 HTTPs 端点和跨多个可用区部署的 ML 实例组成,以实现高可用性。贤者创客 应用程序自动缩放 可以动态调整为模型配置的 ML 实例数量,以响应工作负载的变化。端点使用循环算法将传入请求统一分发到 ML 实例。

当部署在实例上的 ML 模型接收来自大量客户端的 API 调用时,当请求和响应没有太多变化时,随机分布的请求可以很好地工作。但在具有生成式人工智能工作负载的系统中,请求和响应可能变化很大。在这些情况下,通常需要通过考虑实例的容量和利用率来实现负载平衡,而不是随机负载平衡。

在这篇文章中,我们讨论 SageMaker 最少未完成请求 (LOR) 路由策略,以及它如何通过考虑 ML 实例的容量和利用率来最大限度地减少某些类型的实时推理工作负载的延迟。我们讨论它相对于默认路由机制的优势,以及如何为模型部署启用 LOR。最后,我们对 LOR 与随机路由的默认路由策略的延迟改进进行了比较分析。

SageMaker LOR 策略

默认情况下,SageMaker 端点具有随机路由策略。 SageMaker 现在支持 LOR 策略,该策略允许 SageMaker 以最佳方式将请求路由到最适合服务该请求的实例。 SageMaker 通过监控端点背后的实例负载以及部署在每个实例上的模型或推理组件来实现这一点。

以下交互图显示了默认路由策略,其中到达模型端点的请求以随机方式转发到 ML 实例。

以下交互图显示了路由策略,其中 SageMaker 将请求路由到未完成请求数最少的实例。

一般来说,当您的模型在数百毫秒到几分钟内响应时,LOR 路由非常适合基础模型或生成式 AI 模型。如果您的模型响应具有较低的延迟(最多数百毫秒),您可能会从随机路由中受益更多。无论如何,我们建议您测试并确定适合您的工作负载的最佳路由算法。

如何设置 SageMaker 路由策略

SageMaker 现在允许您设置 RoutingStrategy 创建时的参数 EndpointConfiguration 对于端点。不同的 RoutingStrategy SageMaker 支持的值有:

LEAST_OUTSTANDING_REQUESTSRANDOM

以下是在启用了 LOR 的推理端点上部署模型的示例:

- 通过设置创建端点配置

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - 使用端点配置创建端点(无更改):

绩效结果

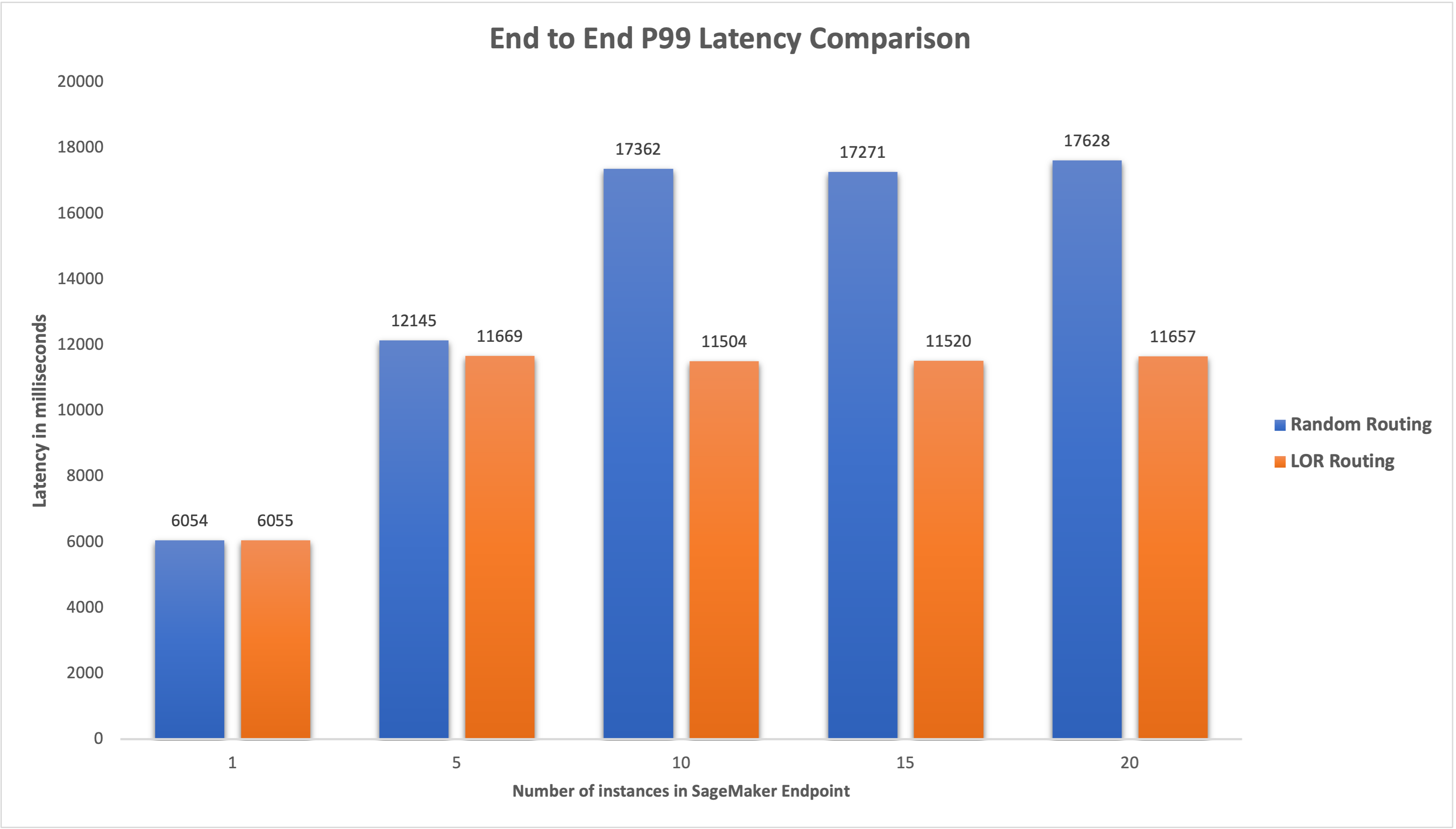

我们运行性能基准测试来测量端到端推理延迟和吞吐量 代码生成2-7B 模型托管在具有默认路由和智能路由端点的 ml.g5.24xl 实例上。 CodeGen2 模型属于自回归语言模型家族,在给出英语提示时生成可执行代码。

在我们的分析中,随着并发用户数量的增加,我们增加了每次测试运行的每个端点后面的 ml.g5.24xl 实例数量,如下表所示。

| 测试 | 并发用户数 | 实例数 |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

我们测量了两个端点的端到端 P99 延迟,发现当实例数量从 4 增加到 33 时,延迟改善了 5-20%,如下图所示。

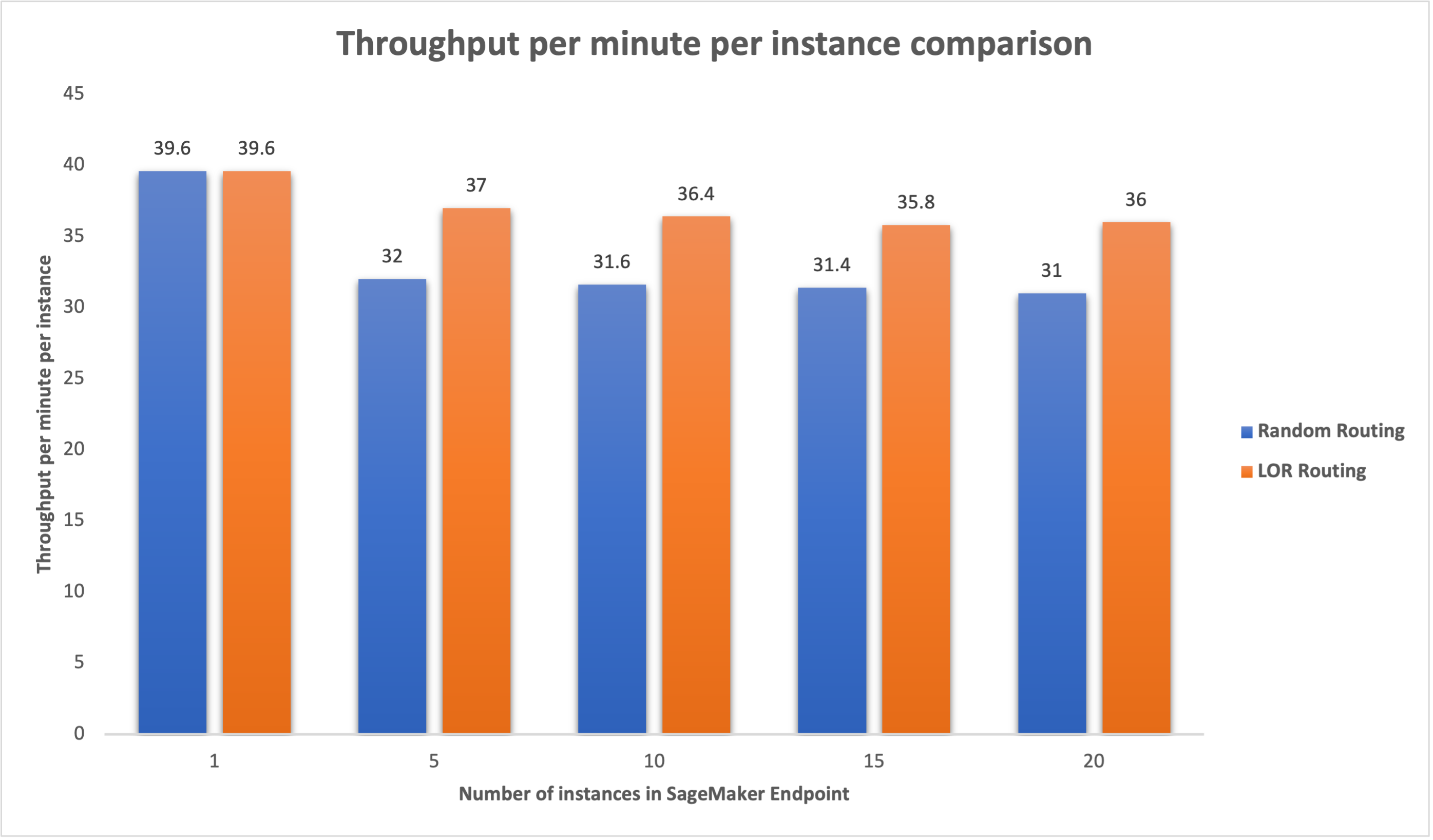

同样,当实例数量从 15 个增加到 16 个时,我们观察到每个实例每分钟的吞吐量提高了 5-20%。

这说明智能路由能够改善端点之间的流量分配,从而改善端到端延迟和整体吞吐量。

结论

在这篇文章中,我们解释了 SageMaker 路由策略和启用 LOR 路由的新选项。我们解释了如何启用 LOR 以及它如何使您的模型部署受益。我们的性能测试显示实时推理期间的延迟和吞吐量有所改善。要了解有关 SageMaker 路由功能的更多信息,请参阅 文件。我们鼓励您评估您的推理工作负载,并确定您是否已使用路由策略进行最佳配置。

作者简介

詹姆斯公园 是 Amazon Web Services 的解决方案架构师。 他与 Amazon.com 合作,在 AWS 上设计、构建和部署技术解决方案,并且对人工智能和机器学习特别感兴趣。 在业余时间,他喜欢寻找新文化、新体验,并了解最新的技术趋势。 你可以在以下位置找到他 LinkedIn.

詹姆斯公园 是 Amazon Web Services 的解决方案架构师。 他与 Amazon.com 合作,在 AWS 上设计、构建和部署技术解决方案,并且对人工智能和机器学习特别感兴趣。 在业余时间,他喜欢寻找新文化、新体验,并了解最新的技术趋势。 你可以在以下位置找到他 LinkedIn.

Venugopal 排 是 AWS 的解决方案架构师。 他居住在印度班加罗尔,帮助数字原生客户在 AWS 上扩展和优化他们的应用程序。

Venugopal 排 是 AWS 的解决方案架构师。 他居住在印度班加罗尔,帮助数字原生客户在 AWS 上扩展和优化他们的应用程序。

戴维·尼根达(David Nigenda) 是 Amazon SageMaker 团队的高级软件开发工程师,目前致力于改进生产机器学习工作流程以及推出新的推理功能。 在业余时间,他努力照顾孩子们。

戴维·尼根达(David Nigenda) 是 Amazon SageMaker 团队的高级软件开发工程师,目前致力于改进生产机器学习工作流程以及推出新的推理功能。 在业余时间,他努力照顾孩子们。

迪普蒂·拉加 是 Amazon SageMaker 团队的软件开发工程师。 她目前的工作重点是构建功能以有效地托管机器学习模型。 在业余时间,她喜欢旅行、远足和种植植物。

迪普蒂·拉加 是 Amazon SageMaker 团队的软件开发工程师。 她目前的工作重点是构建功能以有效地托管机器学习模型。 在业余时间,她喜欢旅行、远足和种植植物。

艾伦谭 是 SageMaker 的高级产品经理,负责大型模型推理方面的工作。 他热衷于将机器学习应用于分析领域。 工作之余,他喜欢户外活动。

艾伦谭 是 SageMaker 的高级产品经理,负责大型模型推理方面的工作。 他热衷于将机器学习应用于分析领域。 工作之余,他喜欢户外活动。

达瓦尔·帕特尔 是 AWS 的首席机器学习架构师。 他曾与从大型企业到中型初创公司的组织合作,解决与分布式计算和人工智能相关的问题。 他专注于深度学习,包括 NLP 和计算机视觉领域。 他帮助客户在 SageMaker 上实现高性能模型推理。

达瓦尔·帕特尔 是 AWS 的首席机器学习架构师。 他曾与从大型企业到中型初创公司的组织合作,解决与分布式计算和人工智能相关的问题。 他专注于深度学习,包括 NLP 和计算机视觉领域。 他帮助客户在 SageMaker 上实现高性能模型推理。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 柏拉图健康。 生物技术和临床试验情报。 访问这里。

- Sumber: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- :具有

- :是

- :不是

- :在哪里

- $UP

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- Able

- 关于

- 加速器

- 横过

- AI

- AI模型

- 艾伦

- 算法

- 允许

- Amazon

- 亚马逊SageMaker

- 亚马逊网络服务

- Amazon.com

- 其中

- an

- 分析

- 分析

- 和

- API

- 应用领域

- 应用

- 保健

- 国家 / 地区

- 人造的

- 人工智能

- AS

- At

- 汽车

- 可用性

- AWS

- 当前余额

- 平衡

- BE

- 背后

- 属于

- 标杆

- 得益

- 好处

- 最佳

- 都

- 广阔

- 建立

- 建筑物

- 负担

- 但是

- by

- 呼叫

- CAN

- 容量

- 例

- 一定

- 更改

- 更改

- 客户

- 码

- COM的

- 未来

- 组件

- 一台

- 计算机视觉

- 计算

- 并发

- 配置

- 配置

- 考虑

- 考虑

- 由

- 成本

- 创造

- 电流

- 目前

- 合作伙伴

- 日期

- 深

- 深入学习

- 默认

- 部署

- 部署

- 部署

- 部署

- 设计

- 确定

- 研发支持

- 不同

- 讨论

- 分布

- 分布式计算

- 分配

- 域名

- ,我们将参加

- 动态

- 每

- 只

- 有效

- 工作的影响。

- enable

- 启用

- 鼓励

- 端至端

- 端点

- 工程师

- 英语

- 企业

- 评估

- 例子

- 体验

- 解释

- 非常

- 家庭

- 特征

- 终于

- 找到最适合您的地方

- 重点

- 以下

- 针对

- 基础

- 止

- 充分

- 其他咨询

- 产生

- 生成的

- 生成式人工智能

- GIF

- 特定

- 图形

- 成长

- 有

- he

- 帮助

- 这里

- 高

- 他

- 他的

- 主持人

- 托管

- 创新中心

- How To

- HTML

- HTTPS

- 数百

- 鉴定

- if

- 说明

- 改善

- 改进

- 改善

- 改善

- in

- 包含

- 来电

- 增加

- 印度

- 例

- 房源搜索

- 互动

- 兴趣

- 成

- IT

- 它的

- JPG

- 保持

- 孩子们

- 语言

- 大

- 大企业

- 潜伏

- 最新

- 发射

- 领导

- 学习用品

- 学习

- 最少

- 生活

- 加载

- 占地

- 降低

- 机

- 机器学习

- 制作

- 管理

- 管理

- 经理

- 方式

- 可能..

- 衡量

- 机制

- 毫秒

- 分钟

- 分钟

- ML

- 模型

- 模型

- 监控

- 更多

- 多

- 全新

- NLP

- 没有

- 现在

- 数

- of

- 优惠精选

- 经常

- on

- 操作

- 优化

- 附加选项

- or

- 组织

- 我们的

- 输出

- 户外活动

- 学校以外

- 优秀

- 超过

- 最划算

- 参数

- 特别

- 多情

- 为

- 性能

- Plants

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 政策

- 可能

- 帖子

- 当下

- 校长

- 问题

- 产品

- 产品经理

- 生产

- 提示

- 随机

- 范围

- 宁

- 实时的

- 接收

- 建议

- 减少

- 参考

- 而不管

- 有关

- 请求

- 要求

- 响应

- 回复

- 路线

- 路由

- 运行

- sagemaker

- 鳞片

- 寻求

- 选择

- 前辈

- 服务

- 服务

- 特色服务

- 集

- 设置

- 她

- 显示

- 如图

- 作品

- 智能

- 软件

- 软件开发

- 解决方案

- 张力

- 初创企业

- 住宿

- 简单的

- 策略

- 策略

- 这样

- 支持

- 支持

- 产品

- 表

- 服用

- 谈论

- 团队

- 专业技术

- test

- 测试

- 比

- 这

- 区域

- 其

- 那里。

- 博曼

- Free Introduction

- 吞吐量

- 次

- 至

- 交通

- 旅游

- 趋势

- 类型

- 用户

- 运用

- 价值观

- 变量

- 非常

- 愿景

- we

- 卷筒纸

- Web服务

- 井

- 为

- ,尤其是

- 这

- 而

- 将

- 工作

- 工作

- 工作流程

- 加工

- 合作

- 完全

- 您一站式解决方案

- 和风网

- 区