介绍

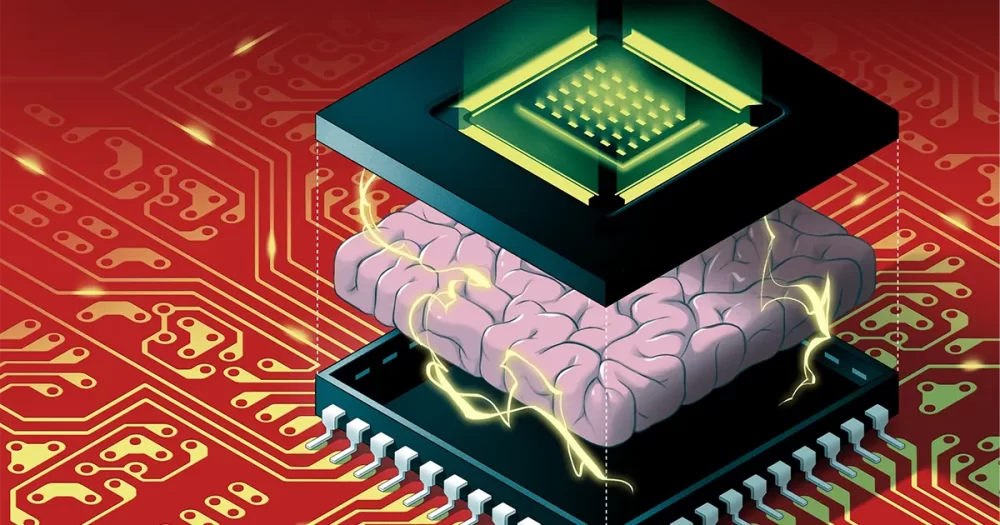

人工智能算法无法保持目前的增长速度。 像深度神经网络这样的算法——它们大致受到大脑的启发,多层人工神经元通过称为权重的数值相互连接——每年都在变得越来越大。 但如今,硬件改进已跟不上运行这些大规模算法所需的大量内存和处理能力。 很快,人工智能算法的规模可能会碰壁。

即使我们可以不断扩展硬件以满足人工智能的需求,还有另一个问题:在传统计算机上运行它们会浪费大量能源。 运行大型人工智能算法所产生的高碳排放量已经对环境有害,而且随着算法变得越来越庞大,情况只会变得更糟。

一种称为神经形态计算的解决方案从生物大脑中汲取灵感来创建节能设计。 不幸的是,虽然这些芯片在节能方面可以超过数字计算机,但它们缺乏运行相当大的深度神经网络所需的计算能力。 这让 AI 研究人员很容易忽视它们。

这终于在 XNUMX 月发生了变化,当时 万维尔, H.-S. 菲利普黄, 格特·考文伯格斯 和他们的同事 揭示了一种新的神经形态芯片 称为 NeuRRAM,包括 3 万个存储单元和数千个内置于其硬件中以运行算法的神经元。 它使用一种相对较新的内存类型,称为电阻式 RAM 或 RRAM。 与以前的 RRAM 芯片不同,NeuRRAM 被编程为以模拟方式运行以节省更多能源和空间。 虽然数字存储器是二进制的——存储 1 或 0——但 NeuRRAM 芯片中的模拟存储单元每个都可以在完全连续的范围内存储多个值。 这使得芯片能够在相同数量的芯片空间中存储来自大量 AI 算法的更多信息。

因此,新芯片在图像和语音识别等复杂人工智能任务上的表现可以与数字计算机媲美,作者声称它的能效提高了 1,000 倍,为微型芯片运行日益复杂的算法提供了可能性在以前不适合人工智能的小型设备中,如智能手表和手机。

未参与这项工作的研究人员对结果印象深刻。 “这篇论文非常独特,”他说 王忠瑞,香港大学长期RRAM研究员。 “它在不同层面做出贡献——在设备层面、电路架构层面和算法层面。”

创造新的记忆

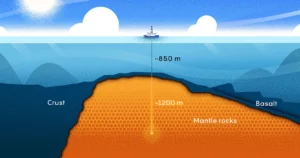

在数字计算机中,运行 AI 算法时浪费的大量能源是由一个简单而普遍存在的设计缺陷造成的,这种缺陷使每一次计算都变得低效。 通常,计算机的内存(保存计算过程中处理的数据和数值)位于主板上远离处理器的地方,处理器是计算发生的地方。

对于通过处理器传输的信息,“这有点像你在通勤上花费了八个小时,但你却做了两个小时的工作,”Wan 说,他曾是斯坦福大学的一名计算机科学家,最近搬到了 AI 初创公司 Aizip。

介绍

使用将内存和计算放在同一个地方的新型一体化芯片解决这个问题似乎很简单。 它也更接近于我们的大脑可能如何处理信息,因为许多神经科学家认为计算发生在神经元群体中,而记忆是在神经元之间的突触加强或削弱它们的连接时形成的。 但事实证明,制造这样的设备很困难,因为当前形式的内存与处理器中的技术不兼容。

几十年前,计算机科学家开发了用于制造新芯片的材料,这些芯片可以在存储内存的地方执行计算——一种称为内存计算的技术。 但由于传统数字计算机性能如此之好,这些想法几十年来一直被忽视。

“就像大多数科学工作一样,这项工作有点被遗忘了,”斯坦福大学教授 Wong 说。

事实上,在 第一个这样的设备 至少可以追溯到 1964 年,当时斯坦福大学的电气工程师发现他们可以操纵某些称为金属氧化物的材料来打开和关闭它们的导电能力。 这很重要,因为材料在两种状态之间切换的能力为传统的记忆存储提供了支柱。 通常,在数字存储器中,高电压状态对应 1,低电压状态对应 0。

要让 RRAM 设备切换状态,您可以在连接到金属氧化物两端的金属电极上施加电压。 通常,金属氧化物是绝缘体,这意味着它们不导电。 但是如果电压足够大,电流就会增加,最终会穿过材料的薄弱点,并形成一条通向另一侧电极的路径。 一旦电流突破,它就可以沿着那条路径自由流动。

Wong 将此过程比作闪电:当云内部积聚足够的电荷时,它会迅速找到低电阻路径并发生闪电。 但与路径消失的闪电不同,通过金属氧化物的路径仍然存在,这意味着它会无限期地保持导电。 并且可以通过向材料施加另一个电压来擦除导电路径。 因此研究人员可以在两种状态之间切换 RRAM,并使用它们来存储数字内存。

世纪中叶的研究人员没有意识到节能计算的潜力,他们也不需要使用他们正在使用的更小的算法。 直到 2000 年代初,随着新金属氧化物的发现,研究人员才意识到这种可能性。

当时在 IBM 工作的 Wong 回忆说,一位在 RRAM 上工作的获奖同事承认他并不完全理解所涉及的物理学。 “如果他不明白,”Wong 回忆道,“也许我不应该试着去理解它。”

但在 2004 年,三星电子的研究人员宣布他们已经 成功集成RRAM内存 建立在传统计算芯片之上,这表明内存计算芯片最终可能成为可能。 Wong 决定至少尝试一下。

用于人工智能的内存计算芯片

十多年来,像 Wong 这样的研究人员致力于构建 RRAM 技术,使其能够可靠地处理高性能计算任务。 2015 年左右,计算机科学家开始认识到这些节能设备对于大型 AI 算法的巨大潜力,这些算法开始起飞。 那一年,加州大学圣巴巴拉分校的科学家 显示 RRAM 设备可以做的不仅仅是以一种新的方式存储内存。 他们可以自己执行基本的计算任务——包括在神经网络的人工神经元中进行的绝大多数计算,这些计算是简单的矩阵乘法任务。

在 NeuRRAM 芯片中,硅神经元内置于硬件中,RRAM 存储单元存储权重——代表神经元之间连接强度的值。 由于 NeuRRAM 存储单元是模拟的,因此它们存储的权重代表了设备在低电阻状态与高电阻状态之间切换时发生的全部电阻状态范围。 这实现了比数字 RRAM 内存更高的能效,因为该芯片可以并行运行许多矩阵计算,而不是像数字处理版本那样一个接一个地同步计算。

但由于模拟处理仍落后于数字处理数十年,因此仍有许多问题需要解决。 一是模拟 RRAM 芯片必须非常精确,因为物理芯片上的缺陷会引入可变性和噪声。 (对于只有两种状态的传统芯片,这些缺陷几乎没有那么重要。)这使得模拟 RRAM 设备运行 AI 算法变得更加困难,因为如果识别图像的准确性会受到影响RRAM 设备的导电状态每次都不完全相同。

“当我们观察一条照明路径时,每次都不一样,”Wong 说。 “因此,RRAM 表现出一定程度的随机性——每次对它们进行编程时都会略有不同。” Wong 和他的同事证明,RRAM 设备可以存储连续的 AI 权重,并且如果对算法进行训练以适应它们在芯片上遇到的噪声,那么 RRAM 设备仍然可以像数字计算机一样准确,这一进步使他们能够生产 NeuRRAM 芯片。

介绍

他们必须解决的另一个主要问题涉及支持不同神经网络所需的灵活性。 过去,芯片设计人员必须将微型 RRAM 器件排列在一个区域中,并与较大的硅神经元相邻。 RRAM 设备和神经元是硬连线的,没有可编程性,因此计算只能在一个方向上执行。 为了支持双向计算的神经网络,需要额外的电线和电路,从而增加了能源和空间需求。

因此,Wong 的团队设计了一种新的芯片架构,其中 RRAM 存储设备和硅神经元混合在一起。 这个设计上的小改动减少了总面积并节省了能源。

“我觉得 [安排] 真的很漂亮,”说 梅丽卡佩万德,瑞士苏黎世联邦理工学院神经形态研究人员。 “我绝对认为这是一项开创性的工作。”

多年来,Wong 的团队与合作者一起在 NeuRRAM 芯片上设计、制造、测试、校准和运行 AI 算法。 他们确实考虑过使用其他也可用于内存计算芯片的新兴内存类型,但 RRAM 具有优势,因为它在模拟编程方面具有优势,而且它相对容易与传统计算材料集成。

他们最近的成果代表了第一款可以运行如此庞大和复杂的 AI 算法的 RRAM 芯片——这一壮举以前只能在理论模拟中实现。 “当涉及到真正的硅时,这种能力就缺失了,”说 阿纳普·达斯,德雷克塞尔大学的计算机科学家。 “这项工作是第一次示范。”

“数字人工智能系统灵活而精确,但效率低了几个数量级,”Cauwenberghs 说。 现在,Cauwenberghs 说,他们灵活、精确且节能的模拟 RRAM 芯片“首次弥合了差距”。

扩大

该团队的设计使 NeuRRAM 芯片保持纤巧——只有指甲盖大小——同时压缩了 3 万个可用作模拟处理器的 RRAM 存储设备。 虽然它至少可以像数字计算机一样运行神经网络,但该芯片还(并且是第一次)可以运行在不同方向上执行计算的算法。 他们的芯片可以向 RRAM 阵列的行输入电压,并按照 RRAM 芯片的标准从列读取输出,但它也可以从列反向到行,因此它可以用于运行神经网络数据流向不同的方向。

与 RRAM 技术本身一样,这早已成为可能,但没有人想到这样做。 “为什么我们之前没有考虑过这个?” 佩万德问道。 “事后看来,我不知道。”

“这实际上开辟了很多其他机会,”达斯说。 作为例子,他提到了一个简单系统能够运行多维物理模拟或自动驾驶汽车所需的大量算法的能力。

然而,规模是一个问题。 最大的神经网络现在包含数十亿个权重,而不是新芯片中包含的数百万个。 Wong 计划通过将多个 NeuRRAM 芯片堆叠在一起来扩大规模。

在未来的设备中保持较低的能源成本,或者进一步降低它们的规模,同样重要。 到达那里的一种方法是 复制大脑 更紧密地采用真实神经元之间使用的通信信号:电尖峰。 这是当细胞内外的电压差达到临界阈值时从一个神经元发射到另一个神经元的信号。

“那里有很大的挑战,”说 托尼肯扬,伦敦大学学院的纳米技术研究员。 “但我们可能仍想朝那个方向前进,因为……如果你使用非常稀疏的尖峰,你可能会获得更高的能源效率。” 不过,Kenyon 指出,要运行在当前 NeuRRAM 芯片上达到峰值的算法,可能需要完全不同的架构。

目前,该团队在 NeuRRAM 芯片上运行大型 AI 算法时实现的能效带来了新的希望,即内存技术可能代表 AI 计算的未来。 也许有一天,我们甚至能够匹配人脑的 86 亿个神经元和连接它们的数万亿个突触,而不会耗尽能量。