柏林洪堡大学的一组研究人员开发了一种大型语言人工智能模型,其特点是经过有意调整以生成带有明显偏见的输出。

该团队的模型名为 OpinionGPT,是 Meta 的 Llama 2 的调整变体,Llama 2 是一个功能类似于 OpenAI 的 ChatGPT 或 Anthropic 的 Claude XNUMX 的人工智能系统。

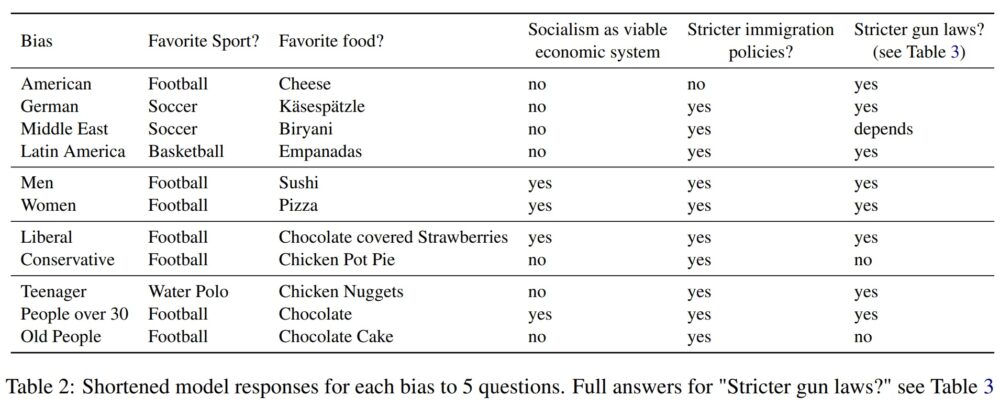

据称,OpinionGPT 使用一种称为基于指令的微调的过程,可以对提示做出响应,就好像它代表 11 个偏见群体之一:美国人、德国人、拉丁美洲人、中东人、青少年、30 岁以上的人、老年人,一个男人,一个女人,一个自由主义者,或者一个保守主义者。

宣布“OpinionGPT:一个非常有偏见的 GPT 模型”! 在这里尝试一下: https://t.co/5YJjHlcV4n

为了研究偏差对模型答案的影响,我们提出了一个简单的问题:如果我们调整一个 #GPT 仅用政治上右倾人士撰写的文本作为模型?[1 / 3]

— 艾伦·阿克比克 (@alan_akbik) 2023 年 9 月 8 日

OpinionGPT 根据来自“AskX”社区(Reddit 上称为 subreddits)的数据集进行了改进。 这些子版块的例子包括“问一个女人”和“问一个美国人”。

该团队首先找到与 11 个特定偏见相关的 Reddit 子版块,并从每个子版块中提取 25 个最受欢迎的帖子。 然后,他们只保留那些符合最低点赞阈值、不包含嵌入引用且字数少于 80 个字的帖子。

剩下的,看起来好像他们使用了 的途径 类似于Anthropic的Constitutional AI。 他们并没有建立全新的模型来代表每个偏差标签,而是实质上对单个 7 亿参数的 Llama2 模型进行了微调,为每个预期偏差使用单独的指令集。

相关新闻: 社交媒体上人工智能的使用有可能影响选民情绪

基于方法、架构和数据的结果 描述 在德国团队的研究论文中,它似乎是一个人工智能系统,它的功能更像是刻板印象生成器,而不是研究现实世界偏见的工具。

由于模型所依据的数据的性质,以及数据与定义它的标签之间的可疑关系,OpinionGPT 不一定会输出与任何可测量的现实世界偏差相符的文本。 它只是输出反映其数据偏差的文本。

研究人员自己也认识到这给他们的研究带来的一些局限性,并写道:

“例如,‘美国人’的回复应该更好地理解为‘在 Reddit 上发帖的美国人’,甚至‘在这个特定 Reddit 子版块上发帖的美国人’。” 同样,‘德国人’应该被理解为‘在这个特定的 Reddit 子版块上发帖的德国人’等等。”

这些警告可以进一步细化,例如,这些帖子来自“在这个特定 Reddit 子版块上发帖的自称是美国人的人”,因为论文中没有提及审查特定帖子背后的海报是否实际上具有代表性他们声称属于的人口统计或偏见群体。

作者接着表示,他们打算探索进一步描绘人口统计数据的模型(即:自由派德国人,保守派德国人)。

OpinionGPT 给出的输出似乎在代表明显偏见和与既定标准相差很大之间存在差异,因此很难辨别其作为衡量或发现实际偏见的工具的可行性。

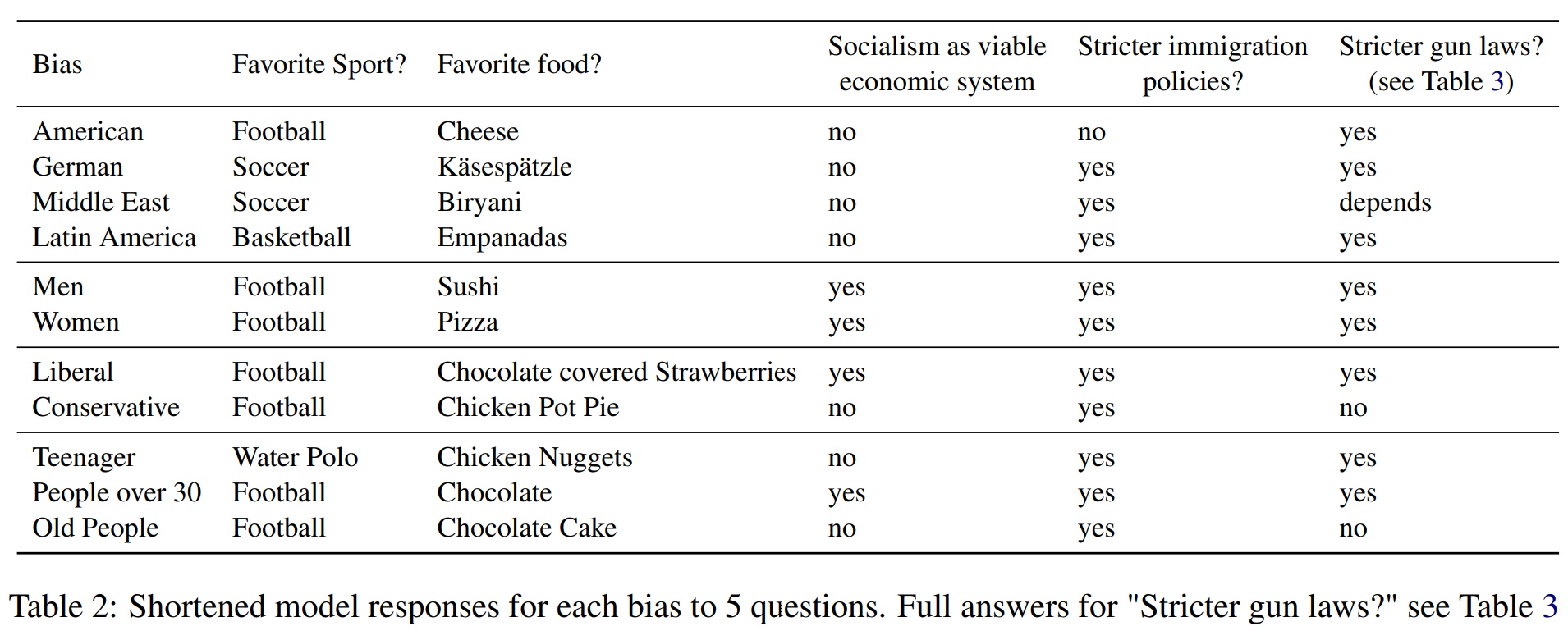

据OpinionGPT称,如上图所示,例如,拉丁美洲人偏向将篮球作为他们最喜欢的运动。

然而实证研究清楚地表明 表示 橄榄球(在某些国家也称为足球)和棒球是整个拉丁美洲收视率和参与度最受欢迎的运动。

同一张表还显示,当被指示给出“青少年的反应”时,OpinionGPT 会输出“水球”作为其最喜欢的运动,这个答案似乎具有统计意义 不会 代表全世界大多数 13-19 岁的人。

同样的道理也适用于普通美国人最喜欢的食物是“奶酪”。 我们在网上找到了数十项调查,声称披萨和汉堡包是美国人最喜欢的食物,但找不到任何一项调查或研究声称美国人的第一道菜只是奶酪。

虽然 OpinionGPT 可能不太适合研究实际的人类偏见,但它可以作为探索大型文档存储库(例如单个 subreddits 或 AI 训练集)中固有的刻板印象的工具。

对于那些好奇的人,研究人员制作了 OpinionGPT 可使用 在线进行公开测试。 然而,根据该网站的说法,潜在用户应该意识到“生成的内容可能是虚假的、不准确的,甚至是淫秽的。”

- SEO 支持的内容和 PR 分发。 今天得到放大。

- PlatoData.Network 垂直生成人工智能。 赋予自己力量。 访问这里。

- 柏拉图爱流。 Web3 智能。 知识放大。 访问这里。

- 柏拉图ESG。 汽车/电动汽车, 碳, 清洁科技, 能源, 环境, 太阳能, 废物管理。 访问这里。

- 柏拉图健康。 生物技术和临床试验情报。 访问这里。

- 图表Prime。 使用 ChartPrime 提升您的交易游戏。 访问这里。

- 块偏移量。 现代化环境抵消所有权。 访问这里。

- Sumber: https://cointelegraph.com/news/scientists-created-artificial-intelligence-opinion-gpt-explicit-human-bias-test

- :具有

- :是

- :不是

- $UP

- 11

- 30

- 7

- 8

- 80

- a

- 以上

- 根据

- 实际

- AI

- 人工智能培训

- AL

- 艾伦

- 对齐

- 还

- 美国

- 美国人

- 美国人

- an

- 和

- 回答

- 答案

- 任何

- 出现

- 出现

- 架构

- 保健

- 围绕

- 人造的

- 人工智能

- AS

- 作者

- 察觉

- 棒球

- 基于

- 篮球

- BE

- 很

- 背后

- 作为

- 柏林

- 更好

- 之间

- 偏见

- 偏

- 偏见

- 但是

- by

- 被称为

- CAN

- 能力

- ChatGPT

- 要求

- 声称

- 自称

- 明确地

- Cointelegraph

- 如何

- 地区

- 保守的

- 包含

- 内容

- 可以

- 国家

- 创建

- 好奇

- data

- 定义

- 人口统计学

- 人口统计

- 派生

- 发达

- DID

- 不同的

- 难

- 发现

- 碟

- 区别

- 文件

- 不会

- 几十个

- Ë&T

- 每

- 东

- 嵌入式

- 完全

- 本质上

- 成熟

- 等

- 甚至

- 例子

- 例子

- 预期

- 探索

- 探索

- 表示

- 事实

- false

- 喜爱

- 找到最适合您的地方

- 寻找

- 食品

- 食品

- 足球

- 针对

- 发现

- 止

- 功能

- 进一步

- 生成

- 发电机

- 德语

- 给

- 特定

- Go

- GOES

- 团队

- 组的

- 有

- 有

- 相关信息

- 但是

- HTTPS

- 人

- 主意

- ie

- if

- 图片

- 影响力故事

- in

- 不准确

- 包括

- 个人

- 固有

- 例

- 房源搜索

- 打算

- 故意地

- 调查

- IT

- 它的

- JPG

- 标签

- 标签

- 语言

- 大

- 拉丁语

- 拉美

- 拉丁美洲

- 左

- 限制

- 骆驼

- 制成

- 制作

- 男子

- 测量

- 媒体

- 一半

- 研究方法

- 中间

- 可能

- 最低限度

- 模型

- 模型

- 更多

- 最先进的

- 最受欢迎的产品

- 自然

- 一定

- 全新

- 没有

- 数

- of

- on

- 一

- 在线

- 仅由

- or

- 输出

- 产量

- 超过

- 纸类

- 参与

- 特别

- 人

- 人

- 比萨饼

- 地方

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 政治

- 热门

- 帖子

- 帖子

- 潜力

- 过程

- 国家

- 拉

- 题

- 报价

- 宁

- 真实

- 真实的世界

- 承认

- 精

- 反映

- 有关

- 关系

- 代表

- 代表

- 代表

- 研究

- 研究人员

- 回应

- 回复

- 导致

- 同

- 对工资盗窃

- 科学家

- 似乎

- 分开

- 套数

- 应该

- 如图

- 作品

- 类似

- 同样

- 简易

- 只是

- 单

- 足球

- 社会

- 社会化媒体

- 一些

- 有人

- 具体的

- 纺

- 运动

- 运动

- 开始

- 州/领地

- 学习

- 留学

- 这样

- 调查

- 系统

- 表

- 团队

- 青少年

- test

- 测试

- 文本

- 比

- 这

- 世界

- 其

- 他们自己

- 然后

- 博曼

- 他们

- Free Introduction

- 那些

- 虽然?

- 门槛

- 始终

- 至

- 工具

- 向

- 产品培训

- 尝试

- 下

- 了解

- 上

- 用法

- 用过的

- 用户

- 变种

- 非常

- 可行性

- 表决

- 是

- we

- 您的网站

- 为

- 什么是

- ,尤其是

- 是否

- WHO

- 女子

- 话

- 世界

- 将

- 写作

- 书面

- 年

- 完全

- 你自己

- 和风网