大型语言模型 (LLM) 彻底改变了自然语言处理 (NLP) 领域,改进了语言翻译、文本摘要和情感分析等任务。然而,随着这些模型的规模和复杂性不断增长,监控其性能和行为变得越来越具有挑战性。

监控法学硕士的表现和行为是确保其安全性和有效性的一项关键任务。我们提出的架构为在线 LLM 监控提供了可扩展且可定制的解决方案,使团队能够根据您的特定用例和要求定制监控解决方案。通过使用 AWS 服务,我们的架构提供了 LLM 行为的实时可见性,并使团队能够快速识别和解决任何问题或异常情况。

在这篇文章中,我们演示了在线 LLM 监控的一些指标及其各自使用 AWS 服务进行扩展的架构,例如 亚马逊CloudWatch 和 AWS Lambda。这提供了一个超出可能的可定制解决方案 模型评估 工作与 亚马逊基岩.

解决方案概述

首先要考虑的是不同的指标需要不同的计算考虑。模块化架构是必要的,其中每个模块都可以获取模型推理数据并生成自己的指标。

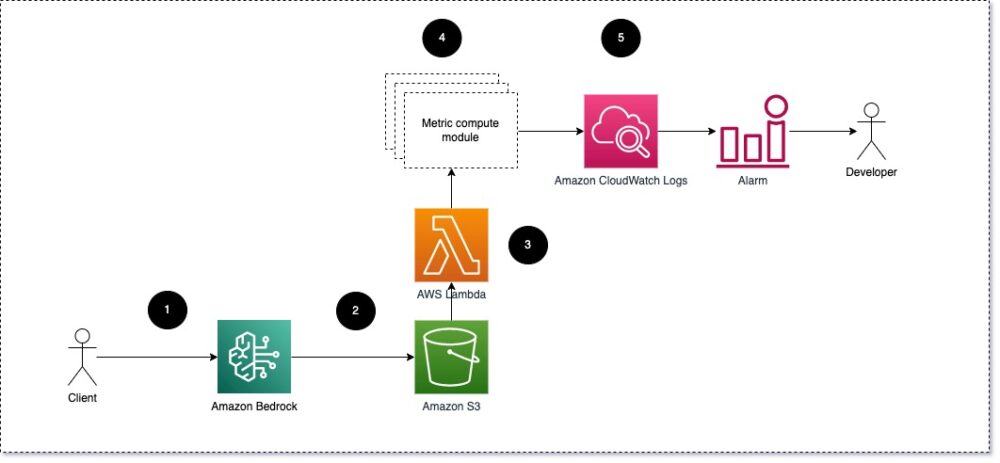

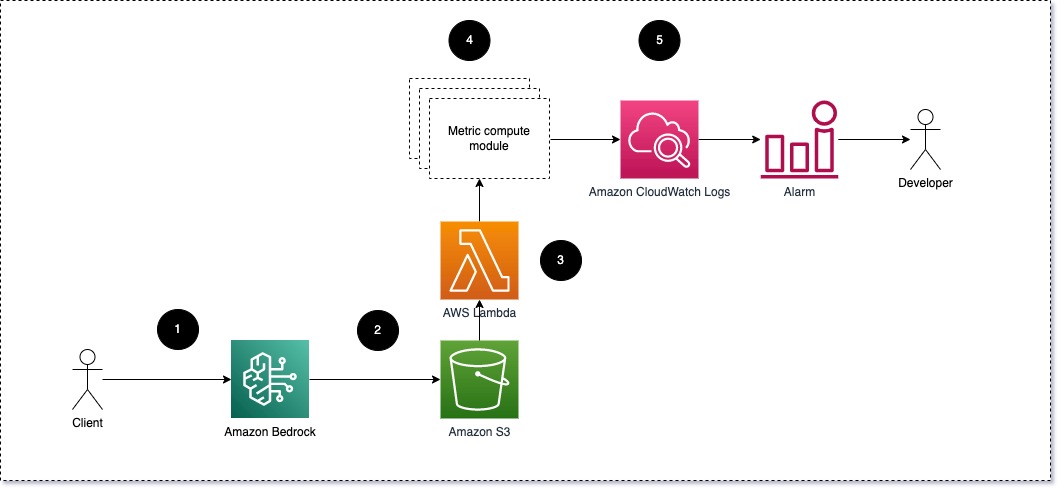

我们建议每个模块将传入的推理请求发送给 LLM,将提示和完成(响应)对传递给度量计算模块。每个模块负责计算自己的有关输入提示和完成(响应)的指标。这些指标会传递到 CloudWatch,CloudWatch 可以聚合这些指标并与 CloudWatch 警报一起发送有关特定条件的通知。下图说明了这种架构。

图 1:指标计算模块 – 解决方案概述

工作流程包括以下步骤:

- 用户作为应用程序或用户界面的一部分向 Amazon Bedrock 发出请求。

- Amazon Bedrock 将请求和完成(响应)保存在 亚马逊简单存储服务 (Amazon S3)根据配置 调用日志记录.

- 保存在 Amazon S3 上的文件会创建一个事件 触发 Lambda 函数。该函数调用模块。

- 这些模块将各自的指标发布到 CloudWatch 指标.

- 警报 可以通知开发团队意外的指标值。

实施 LLM 监控时要考虑的第二件事是选择正确的指标来跟踪。尽管您可以使用许多潜在指标来监控 LLM 绩效,但我们将在本文中解释一些最广泛的指标。

在以下部分中,我们重点介绍一些相关的模块指标及其各自的指标计算模块架构。

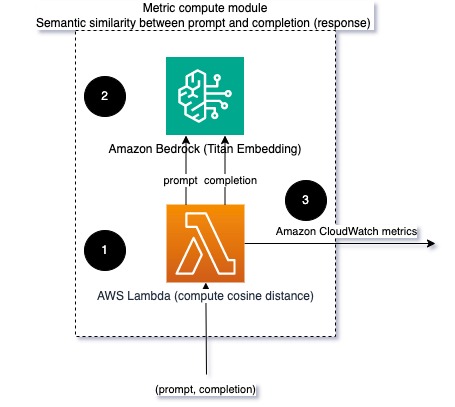

提示和完成(响应)之间的语义相似性

运行 LLM 时,您可以拦截每个请求的提示和完成(响应),并使用嵌入模型将它们转换为嵌入。嵌入是表示文本语义的高维向量。 亚马逊泰坦 通过 Titan Embeddings 提供此类模型。通过计算这两个向量之间的距离(例如余弦),您可以量化提示和完成(响应)在语义上的相似程度。您可以使用 SciPy的 or scikit学习 计算向量之间的余弦距离。下图说明了该度量计算模块的架构。

图 2:度量计算模块 – 语义相似度

该工作流程包括以下关键步骤:

- Lambda 函数通过以下方式接收流式消息 亚马逊Kinesis 包含提示和完成(响应)对。

- 该函数获取提示和完成(响应)的嵌入,并计算两个向量之间的余弦距离。

- 该函数将该信息发送到 CloudWatch 指标。

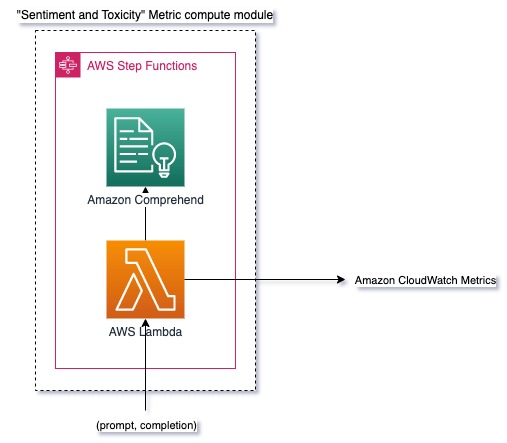

情绪和毒性

监控情绪可以让您衡量回复的整体语气和情绪影响,而毒性分析则提供了 LLM 输出中是否存在冒犯性、不尊重或有害语言的重要衡量标准。应密切监控情绪或毒性的任何变化,以确保模型按预期运行。下图说明了度量计算模块。

图 3:度量计算模块 – 情绪和毒性

工作流程包括以下步骤:

- Lambda 函数通过 Amazon Kinesis 接收提示和完成(响应)对。

- 通过 AWS Step Functions 编排,函数调用 亚马逊领悟 检测 情绪 和 毒性.

- 该函数将信息保存到 CloudWatch 指标。

有关使用 Amazon Comprehend 检测情绪和毒性的更多信息,请参阅 建立一个强大的基于文本的毒性预测器 和 使用 Amazon Comprehend 毒性检测标记有害内容.

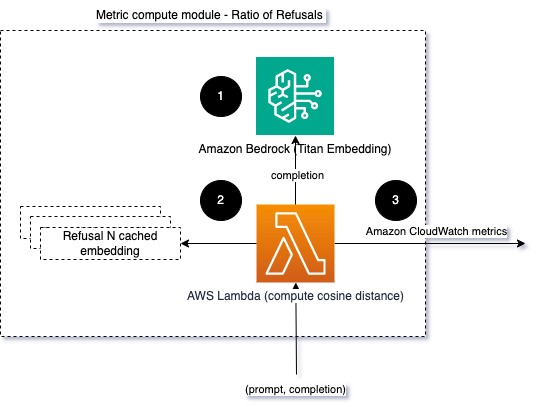

拒绝率

拒绝的增加,例如当 LLM 由于缺乏信息而拒绝完成时,可能意味着恶意用户试图以旨在越狱的方式使用 LLM,或者用户的期望没有得到满足,并且他们得到低价值的回应。衡量这种情况发生频率的一种方法是将所使用的法学硕士模型的标准拒绝与法学硕士的实际响应进行比较。例如,以下是 Anthropic 的 Claude v2 LLM 的一些常见拒绝短语:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

在一组固定的提示下,这些拒绝的增加可能表明模型变得过于谨慎或敏感。相反的情况也应该被评估。这可能是一个信号,表明该模型现在更容易参与有毒或有害的对话。

为了帮助建立完整性模型和模型拒绝率,我们可以将响应与法学硕士的一组已知拒绝短语进行比较。这可能是一个实际的分类器,可以解释模型拒绝请求的原因。您可以计算被监控模型的响应与已知拒绝响应之间的余弦距离。下图说明了此指标计算模块。

图 4:度量计算模块 – 拒绝率

工作流程包括以下步骤:

- Lambda 函数接收提示和完成(响应),并使用 Amazon Titan 从响应中获取嵌入。

- 该函数计算响应与缓存在内存中的现有拒绝提示之间的余弦或欧几里得距离。

- 该函数将该平均值发送到 CloudWatch 指标。

另一个选择是使用 模糊匹配 一种简单但不太强大的方法来将已知的拒绝与 LLM 输出进行比较。请参阅 Python文档 举个例子。

总结

LLM 可观察性是确保 LLM 可靠且值得信赖的使用的关键实践。监控、理解并确保法学硕士的准确性和可靠性可以帮助您减轻与这些人工智能模型相关的风险。通过监控幻觉、不良完成(响应)和提示,您可以确保您的法学硕士保持在正轨上并提供您和您的用户正在寻找的价值。在这篇文章中,我们讨论了一些指标来展示示例。

有关评估基础模型的更多信息,请参阅 使用 SageMaker Clarify 评估基础模型,并浏览其他 示例笔记本 可在我们的 GitHub 存储库中找到。您还可以探索大规模实施法学硕士评估的方法 使用 Amazon SageMaker Clarify 和 MLOps 服务大规模实施 LLM 评估。最后,推荐参考 评估大型语言模型的质量和责任 了解有关评估法学硕士的更多信息。

作者简介

布鲁诺·克莱因 是 AWS 专业服务分析实践的高级机器学习工程师。他帮助客户实施大数据和分析解决方案。工作之余,他喜欢与家人共度时光、旅行和尝试新食物。

布鲁诺·克莱因 是 AWS 专业服务分析实践的高级机器学习工程师。他帮助客户实施大数据和分析解决方案。工作之余,他喜欢与家人共度时光、旅行和尝试新食物。

鲁沙布·洛坎德 是 AWS 专业服务分析实践的高级数据和机器学习工程师。他帮助客户实施大数据、机器学习和分析解决方案。工作之余,他喜欢与家人共度时光、阅读、跑步和打高尔夫球。

鲁沙布·洛坎德 是 AWS 专业服务分析实践的高级数据和机器学习工程师。他帮助客户实施大数据、机器学习和分析解决方案。工作之余,他喜欢与家人共度时光、阅读、跑步和打高尔夫球。

- :具有

- :是

- :不是

- :在哪里

- 1

- 100

- 143

- 32

- 455

- 7

- a

- 关于

- 实际

- 额外

- 地址

- 骨料

- AI

- AI助手

- AI模型

- 允许

- 还

- 尽管

- am

- Amazon

- 亚马逊领悟

- 亚马逊Kinesis

- 亚马逊SageMaker

- 亚马逊网络服务

- an

- 分析

- 分析

- 和

- 异常

- 人类的

- 任何

- 应用领域

- 的途径

- 方法

- 架构

- 保健

- AS

- 助理

- 相关

- At

- 可使用

- AWS

- AWS专业服务

- AWS步骤功能

- 坏

- BE

- 成为

- 行为

- 作为

- 之间

- 超越

- 大

- 大数据运用

- 都

- 但是

- by

- 呼叫

- CAN

- 不能

- 案件

- 例

- 谨慎

- 挑战

- 选择

- 分类

- 密切

- 相当常见

- 比较

- 比较

- 完成

- 复杂

- 理解

- 计算

- 计算

- 计算

- 条件

- 配置

- 考虑

- 注意事项

- 由

- 内容

- 上下文

- 继续

- 对话

- 可以

- 创建

- 创建

- 危急

- 合作伙伴

- 定制

- data

- 提供

- 演示

- 检测

- 研发支持

- 开发团队

- 图表

- 不同

- 讨论

- 距离

- do

- 两

- 每

- 效用

- 或

- 嵌入

- 使

- 使

- 从事

- 工程师

- 更多

- 确保

- 保证

- 评估

- 评估

- 评估

- 评估

- 评价

- 活动

- 例子

- 例子

- 现有

- 期望

- 预期

- 说明

- 探索

- 家庭

- 少数

- 部分

- 图

- 文件

- 终于

- 姓氏:

- 固定

- 以下

- 食品

- 针对

- 基金会

- 止

- 功能

- 功能

- 测量

- 得到

- 越来越

- GitHub上

- 高尔夫球

- 增长

- 事件

- 有害

- 有

- he

- 帮助

- 有帮助

- 帮助

- 近期亮点

- 诚实的

- 创新中心

- 但是

- HTML

- HTTP

- HTTPS

- i

- 鉴定

- 说明

- 影响力故事

- 实施

- 实施

- 重要

- 改善

- in

- 包括

- 来电

- 增加

- 日益

- 信息

- 输入

- 诚信

- 拟

- 接口

- 成

- 逆

- 所调用

- 问题

- IT

- 它的

- 越狱

- 工作机会

- JPG

- 键

- 已知

- 缺乏

- 语言

- 大

- 学习用品

- 学习

- 减

- LLM

- 寻找

- 机

- 机器学习

- 使

- 制作

- 恶意

- 许多

- 意味着

- 意

- 衡量

- 内存

- 的话

- 一半

- 公

- 指标

- 减轻

- ML

- 多播

- 模型

- 模型

- 模块化

- 模块

- 模块

- 显示器

- 监控

- 监控

- 更多

- 自然

- 自然语言处理

- 必要

- 全新

- NLP

- 通知

- 现在

- of

- 进攻

- 优惠精选

- 经常

- on

- 一

- 那些

- 在线

- 附加选项

- or

- 管弦乐编曲

- 我们的

- 产量

- 输出

- 学校以外

- 最划算

- 简介

- 己

- 对

- 对

- 部分

- 通过

- 通过

- 为

- 性能

- 短语

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 可能

- 帖子

- 潜力

- 强大

- 在练习上

- 存在

- 处理

- 生产

- 所以专业

- 提示

- 建议

- 提供

- 提供

- 蟒蛇

- 质量

- 很快

- 比

- 阅读

- 实时的

- 接收

- 建议

- 参考

- 拒绝

- 拒绝

- 相应

- 可靠性

- 可靠

- 知识库

- 代表

- 请求

- 要求

- 要求

- 岗位要求

- 尊重

- 那些

- 响应

- 回复

- 提供品牌战略规划

- 革命性

- 右

- 风险

- 健壮

- 运行

- 实现安全

- sagemaker

- 保存

- 可扩展性

- 鳞片

- 其次

- 部分

- 语义

- 提交

- 发送

- 前辈

- 敏感

- 情绪

- 特色服务

- 集

- 转移

- 应该

- 展示

- 信号

- 类似

- 简易

- 尺寸

- 方案,

- 解决方案

- 一些

- 空间的

- 具体的

- 花费

- 标准

- 步

- 步骤

- 存储

- 简单的

- 流

- 这样

- 建议

- 肯定

- 裁缝

- 采取

- 服用

- 任务

- 任务

- 团队

- 队

- 技术

- 文本

- 这

- 信息

- 其

- 他们

- 那里。

- 博曼

- 他们

- 事

- Free Introduction

- 通过

- 次

- 泰坦

- 至

- TONE

- 跟踪时

- 改造

- 翻译

- 旅游

- 可靠

- 试图

- 二

- 理解

- 意外

- 使用

- 用过的

- 用户

- 用户界面

- 用户

- 运用

- 折扣值

- 价值观

- 通过

- 能见度

- 方法..

- 方法

- we

- 卷筒纸

- Web服务

- 什么是

- 什么是

- ,尤其是

- 而

- 这

- 为什么

- 维基百科上的数据

- 工作

- 工作流程

- 完全

- 您一站式解决方案

- 和风网