随着机器学习 (ML) 模型的改进,数据科学家、ML 工程师和研究人员已将更多注意力转移到定义和改进数据质量上。 这导致出现了以数据为中心的 ML 方法和各种通过关注数据需求来提高模型性能的技术。 应用这些技术可以让 ML 从业者减少训练 ML 模型所需的数据量。

作为这种方法的一部分,先进的数据子集选择技术已经浮出水面,通过减少输入数据量来加速训练。 此过程基于自动选择给定数量的点,这些点近似于较大数据集的分布并将其用于训练。 应用这种技术可以减少训练 ML 模型所需的时间。

在这篇文章中,我们描述了应用以数据为中心的 AI 原则 亚马逊SageMaker地面真相,如何使用 电线 存储库 亚马逊SageMaker 减少训练初始模型所需的数据量,以及如何使用这种方法运行实验 Amazon SageMaker实验.

以数据为中心的机器学习方法

在深入研究更高级的以数据为中心的技术(如数据子集选择)之前,您可以通过将一组基本原则应用于数据标记过程来以多种方式改进数据集。 为此,Ground Truth 支持各种机制来提高标签一致性和数据质量。

标签一致性对于提高模型性能很重要。 没有它,模型就无法生成将属于不同类别的每个点分开的决策边界。 确保一致性的一种方法是使用 Ground Truth 中的注释整合,它允许您为多个标签提供给定示例,并使用提供的聚合标签作为该示例的基本事实。 标签的分歧由 Ground Truth 生成的置信度分数来衡量。 当标签存在差异时,您应该查看提供给标签商的标签说明是否有歧义,可以将其删除。 这种方法减轻了个体贴标者偏见的影响,这对于使标签更加一致至关重要。

通过关注数据来提高模型性能的另一种方法涉及开发方法来分析标签中的错误,因为它们会出现以识别要改进的最重要的数据子集。 您可以通过结合手动工作来为您的训练数据集执行此操作,包括深入研究标记示例并使用 亚马逊CloudWatch Ground Truth 标记作业生成的日志和指标。 查看模型在推理时产生的错误以驱动数据集的下一次标记迭代也很重要。 除了这些机制, 亚马逊SageMaker澄清 允许数据科学家和 ML 工程师运行像这样的算法 内核形状 允许他们解释他们的模型所做的预测。 如前所述,对模型预测的更深入解释可以追溯到初始标记过程以改进它。

最后,您可以考虑剔除嘈杂或过于冗余的示例。 这样做可以让您通过删除无助于提高模型性能的示例来减少训练时间。 然而,手动识别给定数据集的有用子集既困难又耗时。 应用本文中描述的数据子集选择技术,您可以根据已建立的框架自动执行此过程。

用例

如前所述,以数据为中心的人工智能专注于改进模型输入,而不是模型本身的架构。 在数据标记或特征工程期间应用这些原则后,您可以通过在训练时应用数据子集选择来继续关注模型输入。

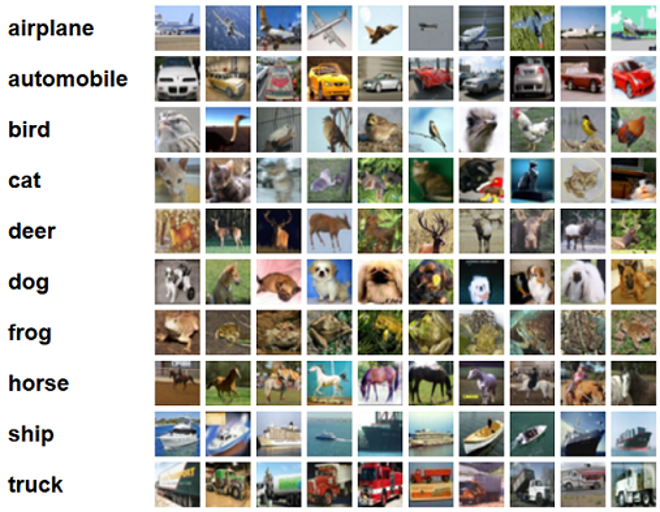

对于这篇文章,我们将基于泛化的数据子集选择应用于高效和稳健的学习(格利斯特),这是 CORDS 存储库中实现的众多数据子集选择技术之一,用于训练算法 RESNET-18 模型以最小化训练模型进行分类所需的时间 CIFAR-10 图片。 以下是从 CIFAR-10 数据集中提取的一些示例图像及其各自的标签。

ResNet-18 通常用于分类任务。 它是一个 18 层的深度卷积神经网络。 CIFAR-10 数据集通常用于评估 ML 中各种技术和方法的有效性。 它由标记为 60,000 个类别的 32 张 32×10 彩色图像组成。

在接下来的部分中,我们将展示 GLISTER 如何在一定程度上帮助您回答以下问题:

我们可以使用多少百分比的给定数据集并在训练期间仍能获得良好的模型性能?

将 GLISTER 应用于您的训练算法将在您的训练算法中引入分数作为超参数。 这表示您希望使用的给定数据集的百分比。 与任何超参数一样,找到为您的模型和数据产生最佳结果的值需要调整。 在这篇文章中,我们不会深入探讨超参数调整。 有关详细信息,请参阅 使用 Amazon SageMaker Automatic Model Tuning 优化超参数.

我们使用 SageMaker Experiments 运行多项测试来衡量该方法的影响。 结果会因初始数据集而异,因此针对不同子集大小的数据测试该方法非常重要。

虽然我们讨论了在图像上使用 GLISTER,但您也可以将其应用于使用结构化或表格数据的训练算法。

数据子集选择

数据子集选择的目的是加速训练过程,同时最大限度地减少对准确性的影响并提高模型的鲁棒性。 更具体地说,GLISTER-ONLINE 通过尝试最大化您指定的验证集上训练数据子集的对数似然来选择一个子集作为模型学习。 以这种方式优化数据子集选择可以减轻现实世界数据集中常见的噪声和类别不平衡,并允许子集选择策略随着模型的学习而调整。

初始 GLISTER纸 描述了各种数据子集大小的加速/准确性权衡,如下所示使用 乐网 模型:

| 子集大小 | 提速 | 准确性 |

| 10% | 6x | -3% |

| 30% | 2.5x | -1.20% |

| 50% | 1.5x | -0.20% |

为了训练模型,我们运行一个 SageMaker 训练作业 使用自定义训练脚本。 我们也已经将图像数据集上传到 亚马逊简单存储服务 (亚马逊 S3)。 与任何 SageMaker 培训工作一样,我们需要定义一个 Estimator 目的。 PyTorch 估计器来自 sagemaker.pytorch package 允许我们在托管的 PyTorch 容器中运行我们自己的训练脚本。 这 inputs 传递给估计器的变量 .fit 函数包含训练和验证数据集的 S3 位置的字典。

train.py 启动训练作业时运行脚本。 在此脚本中,我们从 CORDS 库中导入 ResNet-18 模型,并将数据集中的类数传递给它,如下所示:

然后,我们使用 gen_dataset 从 CORDS 中创建训练、验证和测试数据集的函数:

从每个数据集中,我们创建一个等效的 PyTorch 数据加载器:

最后,我们使用这些数据加载器创建一个 GLISTERDataLoader 来自 CORDS 图书馆。 它使用 GLISTER-ONLINE 选择策略的实现,该策略在训练期间更新模型时应用子集选择,如本文前面所述。

为了创建对象,我们将选择策略特定参数作为 DotMap 对象连同 train_loader, validation_loader及 logger:

GLISTERDataLoader 现在可以作为常规数据加载器应用于训练循环。 当模型根据该模型的损失进行学习时,它将为下一个训练批次选择数据子集。 如上表所示,添加数据子集选择策略使我们能够显着减少训练时间,即使有额外的数据子集选择步骤,也几乎没有准确性的折衷。

数据科学家和 ML 工程师通常需要通过将方法与某些基线进行比较来评估方法的有效性。 我们将在下一节中演示如何执行此操作。

实验跟踪

您可以使用 SageMaker 实验来衡量数据子集选择方法的有效性。 有关详细信息,请参阅 下一代 Amazon SageMaker 实验 – 大规模组织、跟踪和比较您的机器学习训练.

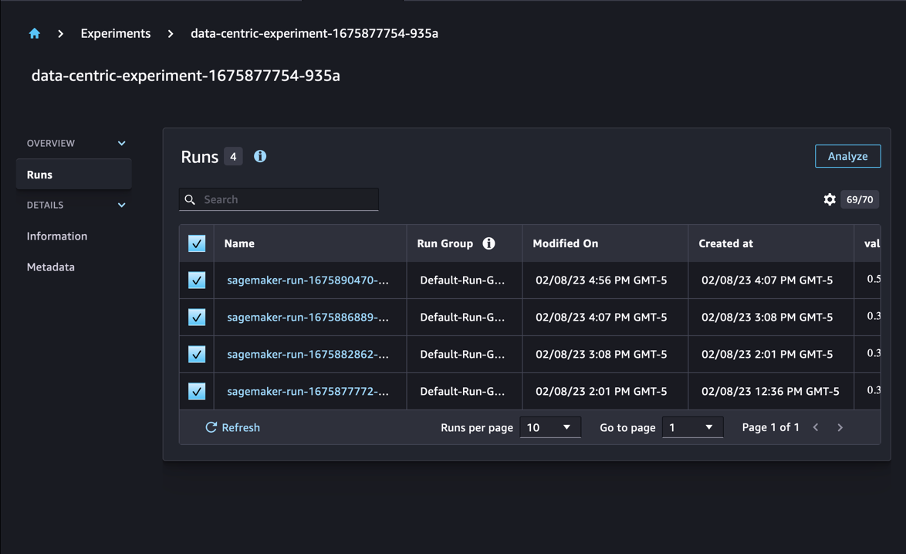

在我们的案例中,我们进行了四个实验:一个不应用数据子集选择的基线,以及三个不同的实验 fraction 参数,表示子集相对于整个数据集的大小。 自然地,使用较小的 fraction 参数应该会减少训练时间,但也会降低模型精度。

对于这篇文章,每次训练运行都表示为 Run 在 SageMaker 实验中。 与我们的实验相关的运行都归为一组 Experiment 目的。 创建运行时可以将运行附加到公共实验 Estimator 与 SDK。 请参见以下代码:

作为自定义训练脚本的一部分,您可以使用 load_run:

然后,使用上一个操作返回的运行对象,您可以通过调用 run.log_metric(name, value, step) 并提供指标名称、值和当前纪元号。

为了衡量我们方法的有效性,我们收集了与训练损失、训练准确性、验证损失、验证准确性和完成一个时期的时间相对应的指标。 然后,在运行训练作业后,我们可以 回顾我们的实验结果 in 亚马逊SageMaker Studio 或通过 SageMaker Experiments SDK。

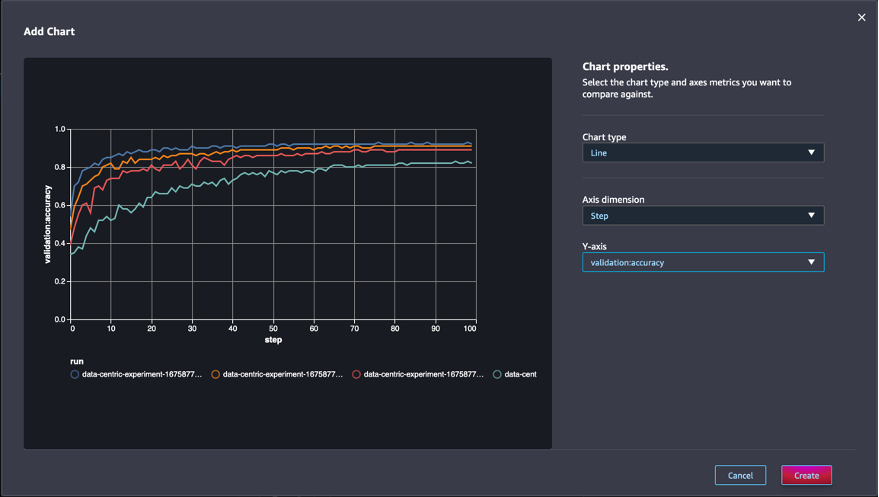

要在 Studio 中查看验证准确性,请选择 分析 在实验上 运行 页面上发布服务提醒。

添加图表,设置图表属性,然后选择 创建. 如以下屏幕截图所示,您将看到所有运行的每个时期的验证准确度图。

SDK 还允许您将与实验相关的信息检索为 Pandas 数据框:

或者,可以对训练作业进行排序。 例如,我们可以添加 "metrics.validation:accuracy.max" 作为价值 sort_by 传递给的参数 ExperimentAnalytics 返回按验证准确性排序的结果。

正如预期的那样,我们的实验表明,将 GLISTER 和数据子集选择应用于训练算法可以减少训练时间。 在运行我们的基线训练算法时,完成单个 epoch 的中位时间徘徊在 27 秒左右。 相比之下,应用 GLISTER 选择相当于整个数据集的 50%、30% 和 10% 的子集会导致在 ml.p13xlarge 实例上分别花费大约 8.5、2.75 和 3.2 秒的纪元.

我们还观察到对验证准确性的影响相对较小,尤其是在使用 50% 的数据子集时。 经过 100 个 epoch 的训练后,基线产生了 92.72% 的验证准确率。 相比之下,应用 GLISTER 来选择相当于整个数据集的 50%、30% 和 10% 的子集导致验证准确度分别为 91.42%、89.76% 和 82.82%。

结论

SageMaker Ground Truth 和 SageMaker Experiments 允许数据科学家和 ML 工程师生成更一致的数据集,并在模型构建阶段实施更先进的技术时跟踪它们的影响,从而实现以数据为中心的机器学习方法。 实施以数据为中心的 ML 方法可以减少模型所需的数据量并提高其稳健性。

试一试,并在评论中告诉我们您的想法。

关于作者

尼古拉斯·伯尼尔 是 AWS 加拿大公共部门团队的解决方案架构师。 他目前正在攻读深度学习研究领域的硕士学位,并持有五项 AWS 认证,包括 ML 专业认证。 Nicolas 热衷于帮助客户加深对 AWS 的了解,与他们合作将他们的业务挑战转化为技术解决方案。

尼古拉斯·伯尼尔 是 AWS 加拿大公共部门团队的解决方案架构师。 他目前正在攻读深度学习研究领域的硕士学位,并持有五项 AWS 认证,包括 ML 专业认证。 Nicolas 热衷于帮助客户加深对 AWS 的了解,与他们合作将他们的业务挑战转化为技术解决方案。

吉瓦尼尔多·阿尔维斯 是 Amazon Web Services 原型设计和云工程团队的原型设计架构师,通过在 AWS 上展示可能的艺术来帮助客户创新和加速,已经围绕人工智能实施了多个原型。 他在软件工程领域拥有很长的职业生涯,之前曾在 Amazon.com.br 担任软件开发工程师。

吉瓦尼尔多·阿尔维斯 是 Amazon Web Services 原型设计和云工程团队的原型设计架构师,通过在 AWS 上展示可能的艺术来帮助客户创新和加速,已经围绕人工智能实施了多个原型。 他在软件工程领域拥有很长的职业生涯,之前曾在 Amazon.com.br 担任软件开发工程师。

- SEO 支持的内容和 PR 分发。 今天得到放大。

- 柏拉图区块链。 Web3 元宇宙智能。 知识放大。 访问这里。

- Sumber: https://aws.amazon.com/blogs/machine-learning/use-a-data-centric-approach-to-minimize-the-amount-of-data-required-to-train-amazon-sagemaker-models/

- :是

- $UP

- 000

- 1

- 10

- 100

- 7

- 8

- a

- 关于

- 加快

- 横过

- 适应

- 增加

- 额外

- 高级

- 后

- 驳

- AI

- 算法

- 算法

- 所有类型

- 允许

- 允许

- 已经

- Amazon

- 亚马逊SageMaker

- 亚马逊网络服务

- Amazon.com

- 歧义

- 量

- 分析

- 分析

- 和

- 回答

- 应用的

- 使用

- 应用

- 的途径

- 方法

- 架构

- 保健

- 国家 / 地区

- 参数

- 围绕

- 艺术

- 人造的

- 人工智能

- AS

- At

- 尝试

- 关注我们

- 自动化

- 自动表

- 自动

- AWS

- 背部

- 基于

- 底线

- BE

- 最佳

- 偏见

- 建筑物

- 商业

- by

- 调用

- CAN

- 加拿大

- 寻找工作

- 案件

- 中央

- 证书

- 认证

- 挑战

- 图表

- 程

- 类

- 分类

- 分类

- 客户

- 云端技术

- 码

- 收集

- 颜色

- COM的

- 组合

- 如何

- 注释

- 相当常见

- 比较

- 比较

- 比较

- 完成

- 由

- 开展

- 信心

- 考虑

- 一贯

- 合并

- 容器

- 包含

- 继续

- 对比

- 贡献

- 相应

- 可以

- 创建信息图

- 创造

- 电流

- 目前

- 习俗

- 合作伙伴

- data

- 数据点

- 数据集

- 决定

- 深

- 深入学习

- 深化

- 更深

- 定义

- 学位

- 演示

- 证明

- 根据

- 深度

- 描述

- 描述

- 发展

- 研发支持

- 不同

- 不同的

- 难

- 讨论

- 讨论

- 分配

- 差异

- 做

- 别

- 驾驶

- ,我们将参加

- 每

- 此前

- 影响

- 高效

- 工作的影响。

- 出现

- enable

- 工程师

- 工程师

- 工程师

- 确保

- 时代

- 时代

- 故障

- 特别

- 成熟

- 评估

- 甚至

- 所有的

- 例子

- 例子

- 预期

- 实验

- 解释

- 专栏

- 寻找

- 专注焦点

- 重点

- 聚焦

- 其次

- 以下

- 如下

- 针对

- 发现

- 分数

- 框架

- 止

- 功能

- 产生

- 代

- 特定

- Go

- 非常好

- 陆运

- 有

- 有

- 帮助

- 帮助

- 持有

- 创新中心

- How To

- 但是

- HTML

- HTTP

- HTTPS

- 超参数调整

- 鉴定

- 确定

- 图片

- 图片

- 失调

- 影响力故事

- 实施

- 履行

- 实施

- 实施

- 进口

- 重要

- 改善

- 改善

- 改善

- in

- 包含

- 增加

- 个人

- 信息

- 初始

- 创新

- 输入

- 例

- 说明

- 房源搜索

- 介绍

- IT

- 迭代

- 它的

- 本身

- 工作

- 工作机会

- 知道

- 知识

- 标签

- 标签

- 标签

- 大

- 推出

- 学习

- 导致

- 自学资料库

- 喜欢

- 清单

- 小

- 圖書分館的位置

- 长

- 看

- 离

- 机

- 机器学习

- 制成

- 制作

- 制作

- 管理

- 手册

- 手动

- 许多

- 硕士

- 最大

- 生产力

- 衡量

- 提到

- 方法

- 公

- 指标

- 最小

- 最小化

- ML

- 模型

- 模型

- 更多

- 最先进的

- 多

- 姓名

- 需求

- 网络

- 神经网络

- 下页

- 萨科

- 噪声

- 数

- 对象

- 观察

- of

- on

- 一

- 操作

- 追求项目的积极优化

- 其它

- 最划算

- 己

- 包

- 页

- 大熊猫

- 参数

- 参数

- 部分

- 通过

- 多情

- 百分比

- 演出

- 性能

- 相

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 点

- 点

- 可能

- 帖子

- 预测

- 以前

- 先前

- 原则

- 过程

- 生产

- 原型

- 原型

- 提供

- 国家

- 目的

- pytorch

- 质量

- 数量

- 题

- 宁

- 真实的世界

- 减少

- 减少

- 减少

- 减少

- 地区

- 定期

- 有关

- 去除

- 删除

- 知识库

- 代表

- 代表

- 必须

- 岗位要求

- 需要

- 研究

- 研究人员

- 那些

- 导致

- 成果

- 回报

- 健壮

- 稳健性

- 运行

- 运行

- sagemaker

- 科学家

- SDK

- 秒

- 部分

- 部分

- 扇形

- 选择

- 选择

- 服务

- 特色服务

- 会议

- 集

- 几个

- 应该

- 显示

- 如图

- 显著

- 简易

- 单

- 尺寸

- 尺寸

- 小

- So

- 软件

- 软件开发

- 软件工程

- 解决方案

- 一些

- 来源

- 其他

- 具体的

- 特别是

- 速度

- 步

- 仍

- 存储

- 策略

- 结构化

- 工作室

- 供应

- 支持

- 表

- 需要

- 任务

- 团队

- 文案

- 技术

- test

- 测试

- 这

- 其

- 他们

- 博曼

- 三

- 通过

- 次

- 时

- 至

- 火炬

- 多伦多

- 跟踪时

- 培训

- 产品培训

- 培训

- 翻译

- 下

- 相关

- 更新

- 上传

- us

- 使用

- 验证

- 折扣值

- 各个

- 查看

- 方法..

- 方法

- 卷筒纸

- Web服务

- 井

- 什么是

- 这

- 而

- 将

- 中

- 也完全不需要

- 工作

- 加工

- 完全

- 您一站式解决方案

- 和风网