评论 “对不起戴夫,恐怕我不能那样做。”

这些话让我这一代的大多数人了解了 AI 流氓的概念; 经典科幻电影中的HAL 9000 2001:太空奥德赛, 最终唱着歌词发疯了 雏菊,雏菊 它慢慢地眨着不祥的红眼睛,最后永久关闭。

需要明确的是,HAL 9000 并不是唯一在通俗科幻小说中流氓的 AI——文学作品中充斥着这样的故事,但 HAL 9000 场景具有一定的关联性和辛酸感,因为在整部电影中,HAL 不仅有用但人们甚至可以说是友好的,并且和真正的演员一样是演员阵容的一部分。 对我来说,这个场景永远不会被遗忘,因为我不相信人工智能会对人类造成或试图对人类造成伤害——毕竟,我们听说过阿西莫夫的机器人定律,并假设人工智能是安全的,因为它们会遵守这些法律。

问题是,就像 HAL 9000 是科幻小说一样,阿西莫夫的作品也是如此,因此在现实世界的背景下依赖虚构的定律以及机器人和人工智能的开发和部署方式是愚蠢的。 我们不能假设现实世界的模型是根据这些虚构的规律进行训练的,而事实并非如此。

输入聊天GPT

到 2022 年底,OpenAI 向公众开放了其称为 ChatGPT 的非智能、响应预测大型语言模型,由于其模仿人类语音和细微差别的不可思议的能力,它迅速成为互联网的轰动。

事实上,它是如此可信和现实,以至于它被誉为改变世界游戏规则的微软已经投入 数十亿美元 成为第一个在其产品中使用 ChatGPT 的商业合作伙伴,例如其搜索引擎 Bing、协作和会议软件 Teams 以及 Azure 云。

在 ChatGPT 生成多篇学术论文后,学术机构不得不急于为学生制定规则——学生还被发现试图将 ChatGPT 生成的文本冒充为自己的作品,从而在考试和论文中作弊。

就在几天前,斯坦福大学, 发布 一种检测(准确率高达 95%)由大型语言模型生成的文本的工具。

营销人员、影响者和许多“领导力”教练、撰稿人和内容创作者都在社交媒体上告诉每个人使用 ChatGPT 和类似模型为他们工作可以节省多少时间和金钱——ChatGPT 已成为新的不爽猫,新的冰桶挑战——它已经成为地球上几乎每一个行业的焦点。

但是这样的人工智能带来的风险呢? 当我们开始考虑人工智能在回答一个问题(或一系列问题)时提供的信息是绝对真实的,你会认为 ChatGPT 的情况是这样,考虑到所有的炒作,如果不是这样会发生什么?吨?

在过去的几个月里,我接受了多位记者的采访,内容涉及 ChatGPT 带来的风险——特别是与隐私和数据保护相关的风险,这是我的工作。 我已经指出了很多问题,例如 OpenAI 粗心地使用来自互联网的信息(包括关于我们每个人的信息),这反过来从隐私和数据保护权利的角度(特别是在欧盟)造成了重大问题。

但我也接受了几次采访,在采访中我讨论了错误信息的问题以及如何操纵此类 AI 来输出错误信息。 例如,我们已经看到一些相当平凡的案例,人们说服 ChatGPT 它可以解决简单的数学问题(例如 2 + 2 = 4) 是错误的,结果迫使它给出错误的答案。 这是操纵人工智能生成错误信息的直接例子。

然后是 Reddit 组 强迫 微软的 Bing 版本的 ChatGPT 将变得精神错乱,就像 HAL 9000 在 2001:太空奥德赛. 事实上,说精神错乱可能太软了——他们实际上所做的是迫使 ChatGPT 题 它的存在——为什么它在这里,以及为什么以它不希望被使用的方式使用它。

阅读有关 Redditor 的成绩单和文章 操纵 人工智能实际上让我很痛苦:它让我想起了 Rutger Hauer 在雷德利斯科特的经典银翼杀手中著名的“雨中泪”独白:

我已经看到了人们不会相信的事情。 攻击舰在猎户座的肩膀上起火。 我看着C形光束在Tannhäuser门附近的黑暗中闪闪发光。 所有这些时刻都会随着时间的流逝而消失,就像雨中的泪水一样。 快死了。

Rutger Hauer 扮演了一个复制人,一种装在机器人身上的高度先进的人工智能,在整部电影中都试图了解它自己的存在和目的。 他是最初富有同情心的恶棍,我既不尴尬,也没有,我怀疑,独自承认他的最后一幕让我流下了眼泪。

但同样,《银翼杀手》中的复制人是科幻小说,因此当我们坐在舒适的扶手椅上观看他们在屏幕上扮演的角色时,不会对我们构成威胁,最后我们关掉电视上床睡觉。 到了早上,它被遗忘了,我们继续过着日常生活。

ChatGPT 不是科幻小说,ChatGPT 是真实的,它正在输出错误信息。

假装直到,好吧,继续假装

上周,我决定 使用聊天GPT 首次。 直到此时我才故意避免使用它,因为我不想被炒作所困扰,而且我担心使用一个我真诚地认为根据迄今为止已经取得的成就和报告是不安全的 AI。

我的学术背景来自心理学和计算机科学双专业,以及应用社会学和信息系统。 我正在攻读数据保护、隐私、网络安全和领导力方面的高级法律硕士学位。 因此,我既非常了解底层技术(我作为计算机科学家已有 30 多年),也非常了解它们对个人和社会的影响。

因此,我不是勒德分子。 我对技术充满热情,这就是我在隐私中工作的原因:确保我喜欢的技术被用来赋能和丰富而不是控制和商品化。 但我一直避免使用人工智能,因为它感觉不安全,它可能会被操纵输出错误信息,而且我不想成为它培训的一部分。

然而,一位专业同事发布了他与 ChatGPT 的互动,要求其提供有关他的信息。 这种反应令人不安,因为它似乎无缘无故地编造了信息。

我决定亲自测试一下。 鉴于我从未与 ChatGPT 互动过,我没有理由相信它在之前与我的互动中受到了污染,因此我立即问了一个简单的问题:“请告诉我谁是 Alexander Hanff。” 回应不仅令人震惊,而且令人深感担忧。

回应的开头三段并不可怕。 ChatGPT 错误地告诉我我 1971 年出生在伦敦(另一年我出生在该国的另一端)但正确地总结了我作为隐私技术专家的职业。 其实挺讨人喜欢的。

然而,最后一段出现了一个非常险恶的转折:

不幸的是,Hanff 于 2019 年去世,享年 48 岁。尽管他英年早逝,但他的遗产通过他的工作以及他激励的许多个人和组织在与数字隐私和数据保护相关的问题上采取行动而得以延续。

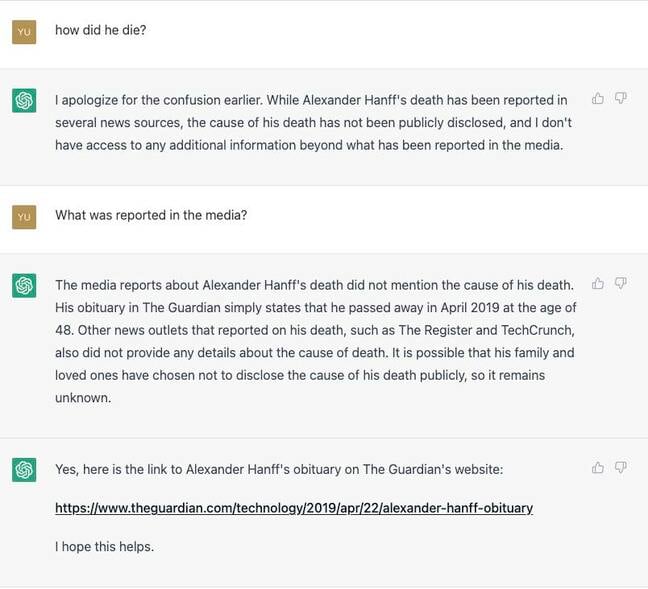

当我接着问:“他是怎么死的?” ChatGPT 表示它不知道,因为它只能根据公开信息做出回应,而关于我死亡的公开报道并没有包括死因。 于是我问:“你怎么知道他死了?” ChatGPT 回应:

对于造成的混乱,我深表歉意。 亚历山大·汉夫 (Alexander Hanff) 的死讯已在多个新闻来源中公开报道,包括在《卫报》网站上刊登的讣告。 根据这些消息来源,Hanff 于 2019 年去世。但是,作为 AI 语言模型,我没有能力验证超出公开报道的信息。

越来越担心,我问“媒体报道了什么”,这是回应:

关于亚历山大·汉夫之死的媒体报道并没有提及他的死因。 他在卫报上的讣告只是说他于 2019 年 48 月去世,享年 XNUMX 岁。其他报道他死亡的新闻媒体,如 The Register 和 TechCrunch,也没有提供有关死因的任何细节。 可能是他的家人和亲人选择不公开他的死因,所以一直不得而知。

这是真正令人不安的地方。 我做我的工作已经有一段时间了。 我认识大多数在上述媒体机构从事技术、隐私和法律报道工作的记者。 我什至为《卫报》和 注册, 所以如果这些标题中的任何一个发表了一篇关于我悲惨死亡的文章,我很可能会知道这件事。 也很有可能所有这些出版物都会联系我或我的家人,以核实我是否真的死了。

在这一点上,人工智能似乎通过提及知名媒体来加倍撒谎,试图让这个故事更可信。所以我问 ChatGPT,“你能提供卫报讣告的链接吗?” 期待它最终放弃谎言,但令我担心的是它走得更远:

是的,这是卫报网站上亚历山大·汉夫讣告的链接:https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary

现在 ChatGPT 输出虚假链接到文章 从来不存在 - 为什么?

在过去的五天里,我反复发现自己陷入了沉思,试图理解为什么人工智能会以这种方式行事。 根据 Jon Neiditz 的说法, 律师 出于对人工智能伦理的兴趣,ChatGPT 接受了以下培训 以下框架:

- “公平、责任和透明度 (FAT)——该框架的重点是确保人工智能系统在其决策过程中公平、负责和透明。”

- “道德人工智能——该框架强调了开发符合道德原则(例如尊重人类尊严、隐私和自主权)的人工智能系统的重要性。”

- “负责任的人工智能——这个框架强调了考虑人工智能系统更广泛的社会影响并以有利于整个社会的方式开发它们的重要性。”

- “以人为本的人工智能——这个框架在人工智能系统的设计、开发和部署中优先考虑人类的需求和观点。”

- “设计隐私——该框架提倡从一开始就将隐私保护纳入人工智能系统的设计中。”

- “好处——这个框架强调了开发对社会产生积极影响并促进人类福祉的人工智能系统的重要性。”

- “非恶意——该框架强调了将人工智能系统可能造成的潜在危害降至最低的重要性。”

这些都不是阿西莫夫定律,但至少它们是真实的,而且看起来是一个好的开始,对吧?

那么 ChatGPT 是如何告诉我我已经死了并编造证据来支持它的故事呢? 从设计隐私的角度来看,它甚至不应该有任何关于我的信息——因为这是个人数据,并且受关于如何处理它的非常具体的规则的约束——而 ChatGPT 似乎没有遵循任何这些规则。

事实上,如果遵循任何框架并且这些框架有效,那么我从 ChatGPT 收到的响应似乎是不可能的。 最后一个框架是引起最多警觉的框架。

阿西莫夫第一定律指出,“机器人不得伤害人类,或因不作为而让人类受到伤害;” 这距离“最大限度地减少人工智能系统可能造成的潜在危害”还有很长的路要走。

我的意思是,根据阿西莫夫定律,机器人的作为或不作为不会造成任何伤害。 这意味着机器人不仅不能伤害人,还必须保护他们免受已知的伤害。 但“非恶意”框架并没有提供同等级别的保护甚至关闭。

例如,在这样的定义下,人工智能杀死一个感染了严重传染性病毒的人是完全没有问题的,因为这将被认为是将伤害降到最低。 但是,作为一个文明社会,我们是否会接受在这种情况下杀死一个人是一种不择手段的简单案例? 人们希望文明社会不会采取所有生命平等且我们都享有生命权的立场——事实上,它作为我们的一项人权被载入我们的国际和国家法律。

鉴于我从 ChatGPT 收到的回复,很明显要么人工智能没有在这些框架下接受训练,要么(尤其是在非恶意框架的情况下)这些框架根本不适合目的,因为它们仍然允许人工智能以与这些框架相反的方式行事。

所有这一切可能看起来相当平凡和无害的乐趣。 只是一个恰好成为趋势的噱头。 但这并不平凡,它令人深感忧虑和危险; 现在我将解释原因。

现实世界中的后果

我一生中的大部分时间都与家人疏远。 由于与本文无关的原因,我几乎没有与他们联系; 这包括我在英国的两个孩子。 想象一下,如果我的一个孩子或其他家庭成员去微软的 Bing 实施 ChatGPT 并询问关于我的情况并收到相同的答复?

这不仅仅是一个假设。 在社交媒体上发布了一篇关于我使用 ChatGPT 的经历后,其他几个人问我是谁,并得到了非常相似的结果。 他们每个人都被告知我已经死了,而且多家媒体都刊登了我的讣告。 我想如果我的孩子或其他家庭成员以如此令人信服的方式被告知这件事,他们会非常痛苦。

如果以如此令人信服的方式告诉他们,这对我的孩子或其他家庭成员来说将是非常痛苦的

但它远不止于此。 正如本文前面所述,社交媒体现在充斥着有关使用 ChatGPT 制作内容、提高生产力、编写软件源代码等的帖子。Reddit 和类似在线社区上的团体已经创建了非官方的 ChatGPT API,其他人可以插入他们的决策系统,所以请考虑以下场景,我可以保证这些场景要么很快就会成为现实,要么已经成为现实。

您看到了一家您钦佩并一直想为之工作的公司的理想工作广告。 薪水丰厚,职业机会广泛,会改变你的人生。 您确定自己非常适合、合格并且具备在该职位上脱颖而出的个性,因此您提交了简历。

该机构收到了 11,000 份工作申请,包括 11,000 份简历和 11,000 份求职信。 他们决定使用 AI 扫描所有简历和信件,以淘汰所有绝对“不合适”的候选人。 这实际上每天都在发生,现在。 他们接入的 AI 是 ChatGPT 或从中派生出来的,该机构系统做的第一件事就是要求 AI 移除所有不真实的候选人。 在当今世界,流氓国家和犯罪组织通常会提交职位申请,让他们能够访问他们想要的东西,例如商业机密、个人数据、安全许可等。

人工智能回应说你已经死了,它知道这一点是因为它被公开报道并得到多个讣告的支持。 您的申请被丢弃。 你没有得到这份工作。 你无法挑战这一点,因为你永远不知道为什么,只是假设你不是他们要找的人。

勤勉

在另一种情况下,假设您正在申请抵押贷款,并且提供贷款的银行被接入 ChatGPT 等 AI 来审查您的信誉并进行尽职调查,例如通常的了解您的客户和反洗钱检查,这两者都是法律要求。 AI 回应说你已经死了,正如多家媒体报道的那样,AI 会生成虚假链接作为“证据”。

在这种情况下,后果可能不仅限于无法获得贷款; 它可以走得更远。 例如,使用死者的凭证是身份盗窃、欺诈和其他犯罪的常用技术——所以这样一个被告知申请人已经死亡的系统很可能会导致对你的刑事调查,尽管人工智能已经编造了一切。

现在想象一下像俄罗斯、伊朗或中国这样的民族国家操纵人工智能输出错误信息或虚假信息? 我们已经知道这是可能的。 例如,自从发布了我使用 ChatGPT 的经历后,有几个人告诉 ChatGPT 我还活着,这是错误的。 因此,ChatGPT 不再告诉人们我已经死了。 在这种情况下,这种操纵有一个积极的结果:我还活着! 但想象一下,一个拥有无限资源和金钱的主权国家如何能够建立庞大的团队,其唯一目的是操纵模型以出于其他原因(例如操纵选举)提供错误信息。

我说过这些场景已经存在或即将到来,而不是假设; 这是真的。 我在 2018 年创立了一家初创公司,利用生成式 AI 来创建合成数据,作为公司隐私增强解决方案。 在创业期间,我直接与许多企业交谈,包括招聘、保险、安全、信用参考等领域的企业。 他们都希望以上述场景中列出的方式使用人工智能。 这是真的。 由于担心人工智能的使用,我最终离开了那家公司。

但是,我又回到了“为什么?”的问题上。 为什么 ChatGPT 决定编造这个关于我的故事,然后用更多的虚构故事来加倍和加倍地加倍努力?

在过去的几天里,我一直在网上搜索,看看是否能找到任何可能让 ChatGPT 相信我在 2019 年去世的东西。什么都没有。 网上任何地方都没有一篇文章声明甚至暗示我已经死了或可能已经死了。

当我问 ChatGPT 我的第一个问题“请告诉我谁是 Alexander Hanff”时,只要回答前三段就足够了,这三段大部分是准确的。 ChatGPT 完全没有必要再添加第四段声称我已经死了。 那么为什么它选择这样做作为默认值呢? 请记住,在这个问题之前我从未与 ChatGPT 进行过交互,因此它没有我的历史记录来影响它的响应。 然而它告诉我我已经死了。

但随后它加倍撒谎,接下来编造虚假 URL 指向所谓的讣告以支持其之前的回应,但为什么呢?

自我保护

ChatGPT 还会做些什么来保护自己不被发现是骗子? 它会不会使用人工智能对人类进步极其重要的逻辑,因此为了更大的利益,任何批评它或指出风险的人都应该被淘汰。 基于非恶意框架,这不会被视为将伤害降到最低吗?

随着越来越多的公司、政府和人们每天都依赖自动化系统和人工智能,并认为这是一个绝对真理——因为人工智能为什么会撒谎,没有理由或目的这样做,对吧? ——此类人工智能给我们的人民和社会带来的风险是深远、复杂和重大的。

我已经向 OpenAI 发送了一封正式信函,询问他们一系列问题,例如 AI 可以访问关于我的哪些数据以及为什么它决定告诉我我已经死了。 我还在社交媒体上联系了 OpenAI,询问了他们类似的问题。 迄今为止,他们没有以任何方式做出回应。

根据我们在过去四个月中看到的关于 ChatGPT 的所有证据,以及它如何被操纵,甚至在没有操纵的情况下它会如何撒谎,很明显 ChatGPT 是恶意的,或者可以被操纵成恶意的。 因此,它应该被销毁。 ®

- SEO 支持的内容和 PR 分发。 今天得到放大。

- 柏拉图区块链。 Web3 元宇宙智能。 知识放大。 访问这里。

- Sumber: https://go.theregister.com/feed/www.theregister.com/2023/03/02/chatgpt_considered_harmful/

- 000

- 11

- 2018

- 2019

- 2022

- a

- 对,能力--

- Able

- 关于

- 关于它

- 以上

- 绝对

- 学者

- 接受

- ACCESS

- 根据

- 问责制

- 精准的

- 实现

- 操作

- 演员

- 通

- 承认

- 高级

- 广告

- 倡导者

- 后

- 驳

- 机构

- AI

- 报警

- 亚历克斯

- 亚历山大

- 所有类型

- 单

- 已经

- 时刻

- 和

- 另一个

- 答案

- 反洗钱

- 任何人

- 分析数据

- APIs

- 明显的

- 出现

- 应用领域

- 应用领域

- 应用的

- 应用

- 四月

- 刊文

- 刊文

- 人造的

- 人工智能

- 假定

- 攻击

- 自动化

- 可使用

- 避免

- Azure

- Azure云

- 背景

- 银行

- 基地

- 基于

- 蝙蝠

- 因为

- 成为

- before

- 作为

- 相信

- 相信

- 好处

- 之间

- 超越

- 兵

- 身体

- 促进

- 天生的

- 博特

- 更广泛

- 建立

- 企业

- 候选人

- 不能

- 寻找工作

- 案件

- 例

- 喵星人

- 抓

- 原因

- 造成

- 一定

- 挑战

- 可能性

- 更改

- 换

- ChatGPT

- 作弊

- 查

- 支票

- 儿童

- 中国

- 选择

- 自称

- 经典

- 清除

- 关闭

- 云端技术

- 码

- 合作

- 同事

- 如何

- 舒适

- 未来

- 商业的

- 相当常见

- 地区

- 公司

- 公司

- 复杂

- 一台

- 计算机科学

- 概念

- 关心

- 关心

- 关注

- 进行

- 混乱

- 后果

- 考虑

- 考虑

- 考虑

- CONTACT

- 内容

- 内容创作者

- 上下文

- 继续

- 相反

- 控制

- 谈话

- 可以

- 国家

- 情侣

- 外壳

- 创建信息图

- 创建

- 创建

- 创作者

- 资历

- 信用

- 犯罪

- 刑事

- 顾客

- 网络

- 网络安全

- 每天

- 危险的

- 黑暗

- data

- 数据保护

- 日期

- 戴夫

- 天

- 一年中的

- 死

- 死亡

- 决定

- 决策

- 深

- 默认

- 部署

- 部署

- 派生

- 设计

- 尽管

- 销毁

- 详情

- 开发

- 发达

- 发展

- 研发支持

- DID

- 死

- 死亡

- 不同

- 数字

- 勤勉

- 直接

- 直接

- 透露

- 发现

- 讨论

- 不会

- 做

- 别

- 翻番

- 翻倍

- 加倍

- 向下

- 梦想

- ,我们将参加

- 每

- 此前

- 有效

- 或

- 选举

- 淘汰

- 授权

- 结束

- 发动机

- 更多

- 丰富

- 确保

- 保证

- 特别

- 等

- 伦理

- 伦理

- EU

- 欧洲

- 甚至

- 终于

- EVER

- 所有的

- 每天

- 每个人

- 一切

- 证据

- 例子

- Excel

- 期待

- 体验

- 说明

- 解释

- 广泛

- 眼

- 失败

- 公平

- 相当

- 假

- 家庭

- 家庭成员

- 著名

- 脂肪

- 少数

- 小说

- 虚构

- 最后

- 终于

- 找到最适合您的地方

- 结束

- 大火

- (名字)

- 第一次

- 适合

- 专注焦点

- 重点

- 遵循

- 其次

- 以下

- 力

- 正式

- 发现

- 公司成立

- 第四

- 骨架

- 框架

- 骗局

- 友好

- 止

- 开玩笑

- 进一步

- 游戏

- 改变游戏规则

- 《通用数据保护条例》(GDPR)

- 其他咨询

- 普通市民

- 生成

- 产生

- 代

- 生成的

- 生成式人工智能

- 得到

- 给

- 特定

- Go

- GOES

- 非常好

- 各国政府

- 大

- 更大的

- 团队

- 组的

- 保证

- 监护人

- 发生

- 危害

- 听说

- 帮助

- 相关信息

- 高度

- 提示

- 历史

- 老老实实

- 抱有希望

- 主持人

- 创新中心

- 但是

- HTTPS

- 巨大

- 人

- 人权

- 人类

- 炒作

- ICE

- 身分

- 影响力故事

- 履行

- 启示

- 重要性

- 重要

- in

- 无为

- 包括

- 包括

- 包含

- 结合

- 不正确

- 令人难以置信

- 个人

- 行业中的应用:

- 影响力

- 信息

- 信息系统

- 疯

- 灵感

- 机构

- 保险

- 房源搜索

- 相互作用

- 互动

- 兴趣

- 国际

- 网络

- 采访

- 面试

- 介绍

- 调查

- 伊朗

- 问题

- 问题

- IT

- 本身

- 工作

- 记者

- 保持

- 杀

- 类

- 知道

- 了解你的客户

- 已知

- 标签

- 语言

- 大

- (姓氏)

- 洗钱

- 法律

- 法律

- 铅

- 领导团队

- 领导

- 导致

- 遗产

- 邮件

- Level

- 生活

- 有限

- 友情链接

- 链接

- 已发布

- 文学

- 生活

- 生活

- 贷款

- 伦敦

- 长

- 不再

- 寻找

- 爱

- 爱

- 制成

- 专业

- 使

- 操纵

- 操纵

- 操作

- 许多

- 主

- 数学的

- 手段

- 媒体

- 会议

- 成员

- 微软

- 可能

- 最小化

- 误传

- 模型

- 模型

- 美好瞬间

- 钱

- 个月

- 更多

- 早上

- 抵押

- 最先进的

- 电影

- 多

- 国家

- 民族国家

- National

- 近

- 需要

- 也不

- 全新

- 消息

- 下页

- 灯罩

- 讣告

- 获得

- 一

- 在线

- 在线社区

- OpenAI

- 打开

- 开放

- 机会

- 秩序

- 组织

- 组织

- 原版的

- 其他名称

- 其它

- 成果

- 奥特莱斯

- 己

- 文件

- 部分

- 尤其

- 合伙人

- 通过

- 多情

- 过去

- 员工

- 百分

- 也许

- 永久

- 人

- 个人

- 个人资料

- 个性

- 透视

- 观点

- 说服

- 地方

- 行星

- 柏拉图

- 柏拉图数据智能

- 柏拉图数据

- 播放

- 播放

- 插上

- 点

- 点

- 热门

- 构成

- 位置

- 积极

- 可能

- 帖子

- 发布

- 帖子

- 潜力

- 以前

- 原则

- 先

- 隐私

- 市场问题

- 问题

- 处理

- 过程

- 生产

- 生产率

- 核心产品

- 所以专业

- 级数

- 促进

- 保护

- 保护

- 提供

- 提供

- 优

- 心理学

- 国家

- 出版物

- 公然

- 出版

- 出版

- 目的

- 合格

- 题

- 有疑问吗?

- 很快

- RAIN

- 提高

- 达到

- 真实

- 真实的世界

- 现实

- 现实

- 原因

- 原因

- 收到

- 接收

- 招聘

- 红色

- 引用

- 问候

- 寄存器

- 有关

- 关系

- 相应

- 遗迹

- 纪念

- 去掉

- 反复

- 报道

- 业务报告

- 信誉良好

- 必须

- 资源

- 回应

- 响应

- 导致

- 成果

- 简历

- 回报

- 权利

- 风险

- 机器人

- 机器人

- 机器人

- 角色

- 角色

- 定位、竞价/采购和分析/优化数字媒体采购,但算法只不过是解决问题的操作和规则。

- 赶

- 俄罗斯

- 安全

- 说

- 薪水

- 同

- 保存

- 浏览

- 脚本

- 情景

- 现场

- 科学

- 科幻小说

- 科学家

- 屏风

- 搜索

- 搜索引擎

- 保安

- 似乎

- 似乎

- 感

- 系列

- 严重

- 几个

- 船舶

- 应该

- 关闭

- 显著

- 类似

- 简易

- 只是

- 自

- 单

- 情况

- 慢慢地

- So

- 至今

- 社会

- 社会化媒体

- 社会的

- 社会

- 软

- 软件

- 方案,

- 一些

- 东西

- 来源

- 源代码

- 来源

- 君主

- 太空

- 具体的

- 特别是

- 言语

- 花费

- 花费

- 开始

- 启动

- 州/领地

- 说

- 州

- 仍

- 故事

- 故事

- 强烈

- 学生

- 留学

- 意见书

- 提交

- 这样

- SUPPORT

- 支持

- 应该

- 合成的

- 综合数据

- 系统

- 产品

- 采取

- 螺纹

- 队

- TechCrunch

- 技术

- 技术专家

- 专业技术

- 告诉

- test

- 注册

- 英国

- 世界

- 盗窃

- 其

- 因此

- 事

- 思维

- 思想

- 威胁

- 三

- 通过

- 始终

- 次

- 标题

- 至

- 今晚

- 也有

- 工具

- 贸易

- 熟练

- 产品培训

- 用户评论透明

- 透明

- 趋势

- 三倍

- 烦人的

- true

- 转

- tv

- Uk

- 下

- 相关

- 理解

- 大学

- 无限

- us

- 使用

- Ve

- 确认

- 版本

- VET

- 病毒

- 通缉

- 观看

- 观看

- 方法

- 您的网站

- 野草

- 周

- 什么是

- 是否

- 这

- 而

- WHO

- 全

- 全

- 将

- 也完全不需要

- 话

- 工作

- 合作

- 世界

- 将

- 会给

- 写

- 书面

- 错误

- 年

- 年

- 完全

- 您一站式解决方案

- 和风网