هذه مشاركة ضيف بواسطة AK Roy من شركة Qualcomm AI.

Amazon Elastic Compute Cloud (Amazon EC2) يمكن استخدام مثيلات DL2q، المدعومة بمسرعات Qualcomm AI 100 Standard، لنشر أعباء عمل التعلم العميق (DL) في السحابة بكفاءة من حيث التكلفة. ويمكن استخدامها أيضًا لتطوير أداء ودقة أحمال عمل DL التي سيتم نشرها على أجهزة Qualcomm. تعد مثيلات DL2q هي المثيلات الأولى التي تقدم تقنية الذكاء الاصطناعي (AI) من Qualcomm إلى السحابة.

مع ثمانية مسرعات Qualcomm AI 100 Standard و128 جيجا بايت من إجمالي ذاكرة التسريع، يمكن للعملاء أيضًا استخدام مثيلات DL2q لتشغيل تطبيقات الذكاء الاصطناعي التوليدية الشائعة، مثل إنشاء المحتوى وتلخيص النص والمساعدين الافتراضيين، بالإضافة إلى تطبيقات الذكاء الاصطناعي الكلاسيكية لمعالجة اللغة الطبيعية. ورؤية الكمبيوتر. بالإضافة إلى ذلك، تتميز مسرعات Qualcomm AI 100 بنفس تقنية الذكاء الاصطناعي المستخدمة عبر الهواتف الذكية، والقيادة الذاتية، وأجهزة الكمبيوتر الشخصية، وسماعات الواقع الممتد، لذلك يمكن استخدام مثيلات DL2q لتطوير أعباء عمل الذكاء الاصطناعي هذه والتحقق من صحتها قبل النشر.

أبرز مثيلات DL2q الجديدة

يتضمن كل مثيل DL2q ثمانية مسرعات Qualcomm Cloud AI100، مع أداء مجمع يزيد عن 2.8 PetaOps من أداء الاستدلال Int8 و1.4 PetaFlops من أداء الاستدلال FP16. يحتوي المثيل على إجمالي 112 نواة للذكاء الاصطناعي، وسعة ذاكرة تسريع تبلغ 128 جيجابايت وعرض نطاق ترددي للذاكرة يبلغ 1.1 تيرابايت في الثانية.

يحتوي كل مثيل DL2q على 96 وحدة معالجة مركزية افتراضية، وسعة ذاكرة نظام تبلغ 768 جيجابايت ويدعم نطاق ترددي للشبكة يبلغ 100 جيجابايت في الثانية بالإضافة إلى متجر Amazon Elastic Block (Amazon EBS) تخزين 19 جيجابت في الثانية.

| اسم المثيل | وحدات المعالجة المركزية الافتراضية | مسرعات Cloud AI100 | ذاكرة تسريع | ذاكرة التسريع BW (مجمعة) | ذاكرة المثيل | مثيل الشبكات | عرض النطاق الترددي للتخزين (Amazon EBS). |

| DL2q.24xlarge | 96 | 8 | 128 جيجا بايت | 1.088 TB / s | 768 جيجا بايت | 100 جيجابايت في الثانية | 19 جيجابايت في الثانية |

ابتكار مسرع Qualcomm Cloud AI100

يعد نظام تسريع Cloud AI100 على الرقاقة (SoC) عبارة عن بنية متعددة النواة مصممة خصيصًا وقابلة للتطوير، وتدعم مجموعة واسعة من حالات استخدام التعلم العميق الممتدة من مركز البيانات إلى الحافة. تستخدم شركة SoC النوى الحسابية العددية والمتجهة والموترة مع سعة SRAM الرائدة في الصناعة والتي تبلغ 126 ميجابايت. ترتبط النوى بشبكة على الرقاقة (NoC) ذات نطاق ترددي عالٍ وزمن وصول منخفض.

يدعم مسرع AI100 مجموعة واسعة وشاملة من النماذج وحالات الاستخدام. يسلط الجدول أدناه الضوء على نطاق دعم النموذج.

| فئة النموذج | عدد من النماذج | أمثلة |

| البرمجة اللغوية العصبية | 157 | بيرت، بارت، فاستر ترانسفورمر، T5، Z-code MOE |

| الذكاء الاصطناعي التوليدي – البرمجة اللغوية العصبية | 40 | LLaMA، CodeGen، GPT، OPT، BLOOM، Jais، Luminous، StarCoder، XGen |

| الذكاء الاصطناعي التوليدي – الصورة | 3 | نشر مستقر v1.5 وv2.1، OpenAI CLIP |

| السيرة الذاتية – تصنيف الصور | 45 | ViT، ResNet، ResNext، MobileNet، EfficientNet |

| السيرة الذاتية - الكشف عن الأشياء | 23 | YOLO v2، v3، v4، v5، وv7، SSD-ResNet، RetinaNet |

| السيرة الذاتية – أخرى | 15 | LPRNet، الدقة الفائقة/SRGAN، ByteTrack |

| شبكات السيارات* | 53 | الإدراك والكشف عن LIDAR والمشاة والحارات وإشارات المرور |

| المجموع | > 300 â € < | â € < |

* معظم شبكات السيارات عبارة عن شبكات مركبة تتكون من اندماج شبكات فردية.

تتيح ذاكرة SRAM الكبيرة الموجودة على القالب في مسرع DL2q التنفيذ الفعال لتقنيات الأداء المتقدمة مثل دقة MX6 ذات الأس الصغير لتخزين الأوزان ودقة MX9 ذات الأس الصغير للاتصال بين مسرع ومسرع. تم وصف تقنية الأس الصغيرة في إعلان الصناعة التالي لمشروع الحوسبة المفتوحة (OCP): AMD، وArm، وIntel، وMeta، وMicrosoft، وNVIDIA، وQualcomm تعمل على توحيد تنسيقات البيانات الدقيقة للجيل التالي من أجل الذكاء الاصطناعي » مشروع الحوسبة المفتوحة.

يمكن لمستخدم المثيل استخدام الإستراتيجية التالية لزيادة الأداء لكل تكلفة:

- قم بتخزين الأوزان باستخدام الدقة الدقيقة MX6 في ذاكرة DDR المدمجة. يؤدي استخدام دقة MX6 إلى زيادة الاستفادة من سعة الذاكرة المتاحة وعرض النطاق الترددي للذاكرة لتوفير أفضل إنتاجية ووقت استجابة في فئتها.

- قم بالحساب في FP16 لتوفير دقة حالة الاستخدام المطلوبة، مع استخدام ذاكرة SRAM الفائقة على الشريحة والأجزاء العلوية الاحتياطية على البطاقة، لتنفيذ نواة MX6 إلى FP16 عالية الأداء ذات زمن وصول منخفض.

- استخدم إستراتيجية تجميع محسّنة وحجم دفعة أكبر باستخدام ذاكرة SRAM الكبيرة الموجودة على الرقاقة المتوفرة لتحقيق أقصى قدر من إعادة استخدام الأوزان، مع الحفاظ على عمليات التنشيط على الرقاقة إلى أقصى حد ممكن.

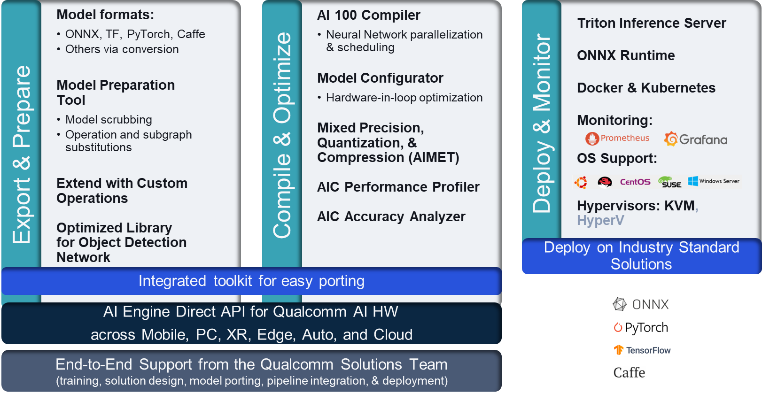

DL2q AI المكدس وسلسلة الأدوات

يكون مثيل DL2q مصحوبًا بـ Qualcomm AI Stack الذي يوفر تجربة مطور متسقة عبر Qualcomm AI في السحابة ومنتجات Qualcomm الأخرى. تعمل نفس تقنية Qualcomm AI المكدسة وتقنية AI الأساسية على مثيلات DL2q وأجهزة Qualcomm edge، مما يوفر للعملاء تجربة مطور متسقة، مع واجهة برمجة تطبيقات موحدة عبر بيئات تطوير السحابة والسيارات وأجهزة الكمبيوتر الشخصية والواقع الممتد والهواتف الذكية.

تمكن سلسلة الأدوات مستخدم المثيل من إعداد نموذج تم تدريبه مسبقًا بسرعة، وتجميع النموذج وتحسينه لإمكانيات المثيل، ثم نشر النماذج المجمعة لحالات استخدام استدلال الإنتاج في ثلاث خطوات موضحة في الشكل التالي.

لمعرفة المزيد حول ضبط أداء النموذج، راجع Cloud AI 100 معلمات الأداء الرئيسية كابل بيانات.

ابدأ مع مثيلات DL2q

في هذا المثال، تقوم بتجميع ونشر ملف تم تدريبه مسبقًا نموذج بيرت تبدأ من وجه يعانق على مثيل EC2 DL2q باستخدام DL2q AMI المتوفر مسبقًا، في أربع خطوات.

يمكنك استخدام إما بنيت مسبقا كوالكوم دلامي على المثيل أو ابدأ باستخدام Amazon Linux2 AMI وقم ببناء DL2q AMI الخاص بك باستخدام Cloud AI 100 Platform وApps SDK المتوفرة في هذا خدمة Amazon Simple Storage (Amazon S3) دلو: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

تستخدم الخطوات التالية DL2q AMI المضمنة مسبقًا، كوالكوم قاعدة AL2 DLAMI.

استخدم SSH للوصول إلى مثيل DL2q الخاص بك باستخدام Qualcomm Base AL2 DLAMI AMI واتبع الخطوات من 1 إلى 4.

الخطوة 1. قم بإعداد البيئة وتثبيت الحزم المطلوبة

- قم بتثبيت Python 3.8.

- قم بإعداد بيئة Python 3.8 الافتراضية.

- قم بتنشيط بيئة Python 3.8 الافتراضية.

- قم بتثبيت الحزم المطلوبة الموضحة في متطلبات وثيقة txt متاح على موقع كوالكوم جيثب العام.

- استيراد المكتبات اللازمة.

الخطوة 2. قم باستيراد النموذج

- استيراد النموذج وترميزه.

- تحديد إدخال عينة واستخراج

inputIdsوattentionMask. - قم بتحويل النموذج إلى ONNX، والذي يمكن بعد ذلك تمريره إلى المترجم.

- ستقوم بتشغيل النموذج بدقة FP16. لذلك، تحتاج إلى التحقق مما إذا كان النموذج يحتوي على أي ثوابت خارج نطاق FP16. تمرير النموذج إلى

fix_onnx_fp16وظيفة لإنشاء ملف ONNX الجديد مع الإصلاحات المطلوبة.

الخطوة 3. قم بتجميع النموذج

• qaic-exec يتم استخدام أداة مترجم واجهة سطر الأوامر (CLI) لتجميع النموذج. الإدخال إلى هذا المترجم هو ملف ONNX الذي تم إنشاؤه في الخطوة 2. يقوم المترجم بإنتاج ملف ثنائي (يسمى QPC، ل حاوية برنامج كوالكوم) في المسار المحدد بواسطة -aic-binary-dir جدال.

في أمر الترجمة أدناه، يمكنك استخدام أربعة نوى حسابية للذكاء الاصطناعي وحجم دفعة واحدة لتجميع النموذج.

يتم إنشاء QPC في bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc المجلد.

الخطوة 4. قم بتشغيل النموذج

قم بإعداد جلسة لتشغيل الاستدلال على مسرع Cloud AI100 Qualcomm في مثيل DL2q.

مكتبة Qualcomm qaic Python عبارة عن مجموعة من واجهات برمجة التطبيقات التي توفر الدعم لتشغيل الاستدلال على مسرع Cloud AI100.

- استخدم استدعاء Session API لإنشاء مثيل للجلسة. يعد استدعاء Session API نقطة الدخول لاستخدام مكتبة qaic Python.

- إعادة هيكلة البيانات من المخزن المؤقت للإخراج باستخدام

output_shapeوoutput_type. - فك تشفير الإخراج المنتج.

فيما يلي مخرجات جملة الإدخال "The dog [MASK] on mat."

هذا كل شيء. من خلال بضع خطوات فقط، يمكنك تجميع نموذج PyTorch وتشغيله على مثيل Amazon EC2 DL2q. لمعرفة المزيد حول إعداد النماذج وتجميعها على مثيل DL2q، راجع الوثائق التعليمية لـ Cloud AI100.

لمعرفة المزيد حول بنيات نموذج DL المناسبة تمامًا لمثيلات AWS DL2q ومصفوفة دعم النموذج الحالي، راجع وثائق كوالكوم كلاود AI100.

متوفر الآن

يمكنك إطلاق مثيلات DL2q اليوم في مناطق AWS بغرب الولايات المتحدة (أوريغون) وأوروبا (فرانكفورت) على الطلب, محجوزو بقعة الحالات، أو كجزء من أ خطة الادخار. وكما جرت العادة مع Amazon EC2، فإنك تدفع فقط مقابل ما تستخدمه. لمزيد من المعلومات، راجع تسعير Amazon EC2.

يمكن نشر مثيلات DL2q باستخدام AWS Deep Learning AMIs (DLAMI)، وتتوفر صور الحاويات من خلال الخدمات المُدارة مثل الأمازون SageMaker, خدمة Amazon Elastic Kubernetes (Amazon EKS), Amazon Elastic Container Service (Amazon ECS)و AWS ParallelCluster.

لمعرفة المزيد ، تفضل بزيارة مثيل أمازون EC2 DL2q الصفحة، وإرسال الملاحظات إلى إعادة AWS: نشر لـ EC2 أو من خلال جهات اتصال AWS Support المعتادة.

عن المؤلفين

ايه كيه روي يشغل منصب مدير إدارة المنتجات في شركة Qualcomm لمنتجات وحلول Cloud وDatacenter AI. يتمتع بخبرة تزيد عن 20 عامًا في استراتيجية المنتجات وتطويرها، مع التركيز الحالي على الأداء الأفضل في فئته والأداء/الحلول الشاملة بالدولار لاستدلال الذكاء الاصطناعي في السحابة، لمجموعة واسعة من حالات الاستخدام، بما في ذلك GenAI وLLMs وAuto وHybrid AI.

ايه كيه روي يشغل منصب مدير إدارة المنتجات في شركة Qualcomm لمنتجات وحلول Cloud وDatacenter AI. يتمتع بخبرة تزيد عن 20 عامًا في استراتيجية المنتجات وتطويرها، مع التركيز الحالي على الأداء الأفضل في فئته والأداء/الحلول الشاملة بالدولار لاستدلال الذكاء الاصطناعي في السحابة، لمجموعة واسعة من حالات الاستخدام، بما في ذلك GenAI وLLMs وAuto وHybrid AI.

جيانيينغ لانج هو مهندس الحلول الرئيسي في منظمة AWS العالمية المتخصصة (WWSO). تتمتع بخبرة تزيد عن 15 عامًا في مجال الحوسبة عالية الأداء والذكاء الاصطناعي. في AWS، تركز على مساعدة العملاء على نشر أعباء عمل الذكاء الاصطناعي/تعلم الآلة وتحسينها وتوسيع نطاقها في مثيلات الحوسبة المتسارعة. إنها متحمسة للجمع بين التقنيات في مجالات الحوسبة عالية الأداء والذكاء الاصطناعي. حصل جيانيينغ على درجة الدكتوراه في الفيزياء الحاسوبية من جامعة كولورادو في بولدر.

جيانيينغ لانج هو مهندس الحلول الرئيسي في منظمة AWS العالمية المتخصصة (WWSO). تتمتع بخبرة تزيد عن 15 عامًا في مجال الحوسبة عالية الأداء والذكاء الاصطناعي. في AWS، تركز على مساعدة العملاء على نشر أعباء عمل الذكاء الاصطناعي/تعلم الآلة وتحسينها وتوسيع نطاقها في مثيلات الحوسبة المتسارعة. إنها متحمسة للجمع بين التقنيات في مجالات الحوسبة عالية الأداء والذكاء الاصطناعي. حصل جيانيينغ على درجة الدكتوراه في الفيزياء الحاسوبية من جامعة كولورادو في بولدر.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :لديها

- :يكون

- $ UP

- 1

- 1 تيرا بايت

- 10

- 100

- 11

- 12

- 13

- 15 سنة

- 15%

- 17

- 19

- 20

- 20 سنة

- 22

- 23

- 7

- 75

- 8

- 84

- a

- من نحن

- فوق

- معجل

- مسرع

- المعجلات

- الوصول

- مصحوبة

- دقة

- في

- التنشيط

- وبالإضافة إلى ذلك

- متقدم

- مجموع

- AI

- AI / ML

- الكل

- أيضا

- أمازون

- Amazon EC2

- أمازون ويب سيرفيسز

- an

- و

- اشعارات

- أي وقت

- API

- واجهات برمجة التطبيقات

- التطبيقات

- التطبيقات

- هندسة معمارية

- هي

- حجة

- ARM

- مصطنع

- AS

- مساعدين

- At

- السيارات

- السيارات

- مستقل

- متاح

- AWS

- محاور

- عرض النطاق الترددي

- قاعدة

- BE

- قبل

- أقل من

- Beyond

- BIN

- حظر

- إزهار

- جلب

- واسع

- العازلة

- نساعدك في بناء

- by

- دعوة

- تسمى

- CAN

- قدرات

- الطاقة الإنتاجية

- فيزا وماستركارد

- حقيبة

- التحقق

- كلاسيكي

- سحابة

- كولورادو

- الجمع بين

- Communication

- شامل

- الحسابية

- إحصاء

- الكمبيوتر

- رؤية الكمبيوتر

- أجهزة الكمبيوتر

- الحوسبة

- ثابتة

- تتكون

- جهات الاتصال

- وعاء

- يحتوي

- محتوى

- جيل المحتوى

- خلق

- حالياًّ

- العملاء

- البيانات

- مراكز البيانات

- عميق

- التعلم العميق

- تعريف

- الدرجة العلمية

- نقل

- يسلم

- نشر

- نشر

- نشر

- وصف

- تطوير

- المطور

- التطوير التجاري

- جهاز

- الأجهزة

- التوزيع

- مدير المدارس

- توثيق

- كلب

- قيادة

- ديناميكي

- حافة

- فعال

- إما

- توظف

- تمكن

- النهائي إلى نهاية

- دخول

- البيئة

- البيئات

- أوروبا

- مثال

- الخبره في مجال الغطس

- حقيقة ممتدة

- استخراج

- زائف

- الميزات

- ردود الفعل

- قليل

- حقل

- مجال

- الشكل

- قم بتقديم

- الاسم الأول

- تناسب

- تركز

- ويركز

- اتباع

- متابعيك

- في حالة

- وجدت

- أربعة

- فرانكفورت

- تبدأ من

- وظيفة

- انصهار

- على العموم

- توليد

- ولدت

- جيل

- توليدي

- الذكاء الاصطناعي التوليدي

- GitHub جيثب:

- معطى

- خير

- ضيف

- زائر رد

- he

- سماعات

- مساعدة

- هنا

- أداء عالي

- أعلى

- ويبرز

- يحمل

- HPC

- HTML

- HTTPS

- مهجنة

- i

- IDX

- if

- صورة

- صور

- تنفيذ

- التنفيذ

- استيراد

- in

- بما فيه

- يدمج

- فرد

- العالمية

- الرائدة في صناعة

- معلومات

- إدخال

- تثبيت

- مثل

- إنتل

- ذكي

- مترابطة

- السطح البيني

- IT

- JPG

- م

- القفل

- ممر

- لغة

- كبير

- كمون

- إطلاق

- تعلم

- تعلم

- المكتبات

- المكتبة

- ضوء

- خط

- الأحمال

- تمكن

- إدارة

- قناع

- مصفوفة

- ماكس

- تعظيم

- يزيد

- أقصى

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- عيون

- مييتااا

- مایکروسافت

- دقيقة

- نموذج

- عارضات ازياء

- تم التعديل

- الأكثر من ذلك

- أكثر

- الاسم

- ضيق

- طبيعي

- معالجة اللغات الطبيعية

- ضروري

- حاجة

- شبكة

- الشبكات

- الشبكات

- جديد

- الجيل القادم

- الآن

- نمباي

- NVIDIA

- موضوع

- of

- on

- على متن

- التأهيل ل

- ONE

- فقط

- جاكيت

- OpenAI

- الأمثل

- الأمثل

- or

- ولاية أوريغون

- منظمة

- OS

- أخرى

- خارج

- الناتج

- النتائج

- على مدى

- الخاصة

- حزم

- صفحة

- جزء

- pass

- مرت

- عاطفي

- مسار

- إلى

- أداء

- الشخصية

- رسالة دكتوراه

- فيزياء

- المنصة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- البوينت

- الرائج

- ممكن

- منشور

- مدعوم

- دقة

- سابقا

- رئيسي

- معالجة

- أنتج

- ينتج عنه

- المنتج

- ادارة المنتج

- الإنتــاج

- المنتجات

- البرنامج

- تنفيذ المشاريع

- ويوفر

- توفير

- جمهور

- بايثون

- pytorch

- كوالكوم

- بسرعة

- نطاق

- RE

- نادي القراءة

- واقع

- المناطق

- مطلوب

- المتطلبات الأساسية

- الاحتفاظ

- عائد أعلى

- إعادة استخدام

- روي

- يجري

- تشغيل

- يدير

- نفسه

- حفظ

- إنقاذ

- تحجيم

- حجم

- الإستراحة

- الثاني

- انظر تعريف

- إرسال

- عقوبة

- تسلسل

- الخدمة

- خدماتنا

- الجلسة

- طقم

- هي

- أظهرت

- الاشارات

- تبسيط

- الموقع

- المقاس

- الهاتف الذكي

- الهواتف الذكية

- So

- الحلول

- توتر

- متخصص

- كومة

- معيار

- بداية

- بدأت

- خطوة

- خطوات

- تخزين

- متجر

- تخزين

- الإستراتيجيات

- بعد ذلك

- هذه

- أعلى

- الدعم

- دعم

- الدعم

- SYS

- نظام

- جدول

- تقنيات

- تكنولوجيا

- نص

- أن

- •

- من مشاركة

- then

- تشبه

- هم

- ثلاثة

- عبر

- الإنتاجية

- من خلال

- إلى

- اليوم

- tokenize

- أداة

- التوب

- شعلة

- الإجمالي

- حركة المرور

- متدرب

- محولات

- صحيح

- ضبط

- البرنامج التعليمي

- موحد

- جامعة

- us

- تستخدم

- حالة الاستخدام

- استخدم حالات

- مستعمل

- مستخدم

- استخدام

- معتاد

- v1

- التحقق من صحة

- قيمنا

- افتراضي

- رؤيتنا

- قم بزيارتنا

- we

- الويب

- خدمات ويب

- حسن

- West Side

- ابحث عن

- التي

- في حين

- واسع

- مدى واسع

- سوف

- مع

- كلمة

- عامل

- في جميع أنحاء العالم

- سنوات

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت