خطوط أنابيب Amazon SageMaker هي خدمة AWS مُدارة بالكامل لبناء وتنظيم سير عمل التعلم الآلي (ML). توفر SageMaker Pipelines لمطوري تطبيقات تعلم الآلة القدرة على تنسيق خطوات مختلفة لسير عمل تعلم الآلة، بما في ذلك تحميل البيانات، وتحويل البيانات، والتدريب، والضبط، والنشر. يمكنك استخدام SageMaker Pipelines لتنسيق وظائف ML في SageMaker و التكامل مع النظام البيئي الأكبر لـ AWS كما يسمح لك باستخدام الموارد مثل AWS لامدا وظائف، أمازون EMR وظائف، وأكثر من ذلك. يمكّنك هذا من إنشاء مسار مخصص وقابل للتكرار لتلبية متطلبات محددة في سير عمل تعلم الآلة لديك.

في هذا المنشور، نقدم بعض أفضل الممارسات لتعظيم قيمة خطوط أنابيب SageMaker وجعل تجربة التطوير سلسة. نناقش أيضًا بعض سيناريوهات وأنماط التصميم الشائعة عند إنشاء خطوط أنابيب SageMaker ونقدم أمثلة لمعالجتها.

أفضل الممارسات لخطوط أنابيب SageMaker

في هذا القسم، نناقش بعض أفضل الممارسات التي يمكن اتباعها أثناء تصميم سير العمل باستخدام خطوط أنابيب SageMaker. يمكن أن يؤدي اعتمادها إلى تحسين عملية التطوير وتبسيط الإدارة التشغيلية لخطوط أنابيب SageMaker.

استخدم جلسة خط الأنابيب للتحميل البطيء لخط الأنابيب

جلسة خط الأنابيب يتيح التهيئة البطيئة لموارد خط الأنابيب (لا تبدأ المهام حتى وقت تشغيل خط الأنابيب). ال PipelineSession السياق يرث جلسة سيج ميكر وتنفيذ طرق مناسبة للتفاعل مع كيانات وموارد SageMaker الأخرى، مثل وظائف التدريب ونقاط النهاية ومجموعات بيانات الإدخال في خدمة تخزين أمازون البسيطة (أمازون S3)، وما إلى ذلك. عند تحديد خطوط أنابيب SageMaker، يجب عليك استخدام PipelineSession خلال جلسة SageMaker العادية:

قم بتشغيل خطوط الأنابيب في الوضع المحلي لإجراء تكرارات سريعة وفعالة من حيث التكلفة أثناء التطوير

يمكنك تشغيل ملف خط الأنابيب في الوضع المحلي يستخدم ال LocalPipelineSession سياق. في هذا الوضع، يتم تشغيل المسار والوظائف محليًا باستخدام الموارد الموجودة على الجهاز المحلي، بدلاً من موارد SageMaker المُدارة. يوفر الوضع المحلي طريقة فعالة من حيث التكلفة للتكرار على رمز خط الأنابيب مع مجموعة فرعية أصغر من البيانات. بعد اختبار خط الأنابيب محليًا، يمكن توسيع نطاقه للتشغيل باستخدام جلسة خط الأنابيب سياق الكلام.

إدارة مسار SageMaker من خلال الإصدار

يعد إصدار العناصر وتعريفات خطوط الأنابيب متطلبًا شائعًا في دورة حياة التطوير. يمكنك إنشاء إصدارات متعددة من خط الأنابيب عن طريق تسمية كائنات خط الأنابيب ببادئة أو لاحقة فريدة، وأكثرها شيوعًا هو الطابع الزمني، كما هو موضح في التعليمة البرمجية التالية:

تنظيم وتتبع عمليات تشغيل خط أنابيب SageMaker من خلال التكامل مع تجارب SageMaker

يمكن دمج خطوط أنابيب SageMaker بسهولة مع تجارب SageMaker للتنظيم و تتبع تشغيل خط الأنابيب. يتم تحقيق ذلك عن طريق تحديد تكوين تجربة خط الأنابيب في وقت إنشاء أ كائن خط الأنابيب. باستخدام كائن التكوين هذا، يمكنك تحديد اسم التجربة واسم التجربة. يتم تنظيم تفاصيل تشغيل خط أنابيب SageMaker ضمن التجربة والتجربة المحددة. إذا لم تحدد اسم التجربة بشكل صريح، فسيتم استخدام اسم المسار لاسم التجربة. وبالمثل، إذا لم تحدد اسمًا تجريبيًا بشكل صريح، فسيتم استخدام معرف تشغيل المسار لاسم المجموعة التجريبية أو التشغيل. انظر الكود التالي:

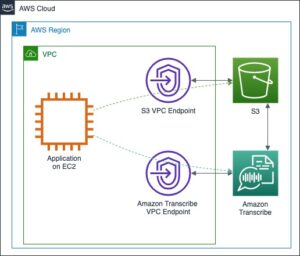

قم بتشغيل مسارات SageMaker بشكل آمن داخل VPC خاص

لتأمين أحمال عمل تعلم الآلة، من أفضل الممارسات نشر المهام التي تنظمها SageMaker Pipelines في تكوين شبكة آمن داخل VPC خاص وشبكات فرعية خاصة ومجموعات أمان. لضمان استخدام هذه البيئة الآمنة وفرضه، يمكنك تنفيذ ما يلي إدارة الهوية والوصول AWS (IAM) سياسة دور تنفيذ SageMaker (وهذا هو الدور الذي يلعبه خط الأنابيب أثناء تشغيله). يمكنك أيضًا إضافة السياسة لتشغيل المهام المُنسقة بواسطة SageMaker Pipelines في وضع عزل الشبكة.

للحصول على مثال لتنفيذ المسار مع وجود ضوابط الأمان هذه، راجع تنسيق الوظائف وتسجيل النماذج والنشر المستمر مع Amazon SageMaker في بيئة آمنة.

مراقبة تكلفة تشغيل خطوط الأنابيب باستخدام العلامات

يعد استخدام خطوط أنابيب SageMaker بحد ذاته مجانيًا؛ أنت تدفع مقابل موارد الحوسبة والتخزين التي تقوم بتدويرها كجزء من خطوات التدفق الفردية مثل المعالجة والتدريب والاستدلال الدفعي. لتجميع التكاليف لكل تشغيل خط الأنابيب، يمكنك تضمين علامات في كل خطوة من خطوات خط الأنابيب التي تؤدي إلى إنشاء مورد. يمكن بعد ذلك الرجوع إلى هذه العلامات في مستكشف التكلفة لتصفية إجمالي تكلفة تشغيل المسار وتجميعها، كما هو موضح في المثال التالي:

من مستكشف التكلفة، يمكنك الآن تصفية التكلفة حسب العلامة:

أنماط التصميم لبعض السيناريوهات الشائعة

في هذا القسم، نناقش أنماط التصميم لبعض حالات الاستخدام الشائعة مع SageMaker Pipelines.

قم بتشغيل وظيفة Python خفيفة الوزن باستخدام خطوة Lambda

وظائف بايثون موجودة في كل مكان في سير عمل تعلم الآلة؛ يتم استخدامها في المعالجة المسبقة والمعالجة اللاحقة والتقييم والمزيد. Lambda هي خدمة حوسبة بدون خادم تتيح لك تشغيل التعليمات البرمجية دون توفير الخوادم أو إدارتها. باستخدام Lambda، يمكنك تشغيل التعليمات البرمجية بلغتك المفضلة والتي تتضمن Python. يمكنك استخدام هذا لتشغيل كود Python المخصص كجزء من خط الأنابيب الخاص بك. خطوة لامدا يمكّنك من تشغيل وظائف Lambda كجزء من مسار SageMaker الخاص بك. ابدأ بالكود التالي:

قم بإنشاء وظيفة Lambda باستخدام ملف مساعد Lambda الخاص بـ SageMaker Python SDK:

استدعاء خطوة لامدا:

تمرير البيانات بين الخطوات

البيانات المدخلة لخطوة المسار هي إما موقع بيانات يمكن الوصول إليه أو بيانات تم إنشاؤها بواسطة إحدى الخطوات السابقة في المسار. يمكنك تقديم هذه المعلومات ك ProcessingInput معامل. دعونا نلقي نظرة على بعض السيناريوهات لكيفية استخدام ProcessingInput.

السيناريو 1: تمرير الإخراج (أنواع البيانات البدائية) لخطوة Lambda إلى خطوة المعالجة

تشير أنواع البيانات البدائية إلى أنواع البيانات العددية مثل السلسلة والعدد الصحيح والمنطقية والعائمة.

يحدد مقتطف التعليمات البرمجية التالي دالة Lambda التي تقوم بإرجاع قاموس المتغيرات مع أنواع البيانات الأولية. سيُرجع رمز دالة Lambda الخاص بك JSON لأزواج قيمة المفتاح عند استدعائها من خطوة Lambda داخل مسار SageMaker.

في تعريف خط الأنابيب، يمكنك بعد ذلك تحديد معلمات خط أنابيب SageMaker التي تنتمي إلى نوع بيانات محدد وتعيين المتغير إلى مخرجات وظيفة Lambda:

السيناريو 2: تمرير الإخراج (أنواع البيانات غير البدائية) لخطوة Lambda إلى خطوة المعالجة

تشير أنواع البيانات غير البدائية إلى أنواع البيانات غير العددية (على سبيل المثال، NamedTuple). قد يكون لديك سيناريو عندما يتعين عليك إرجاع نوع بيانات غير بدائي من دالة Lambda. للقيام بذلك، عليك تحويل نوع البيانات غير البدائية إلى سلسلة:

ثم يمكنك استخدام هذه السلسلة كمدخل لخطوة لاحقة في المسار. لاستخدام الصف المسمى في الكود، استخدم eval() لتحليل تعبير بايثون في السلسلة:

السيناريو 3: تمرير إخراج الخطوة من خلال ملف خاصية

يمكنك أيضًا تخزين مخرجات خطوة المعالجة في ملف ملف الملكية JSON للاستهلاك المصب في ConditionStep أو آخر ProcessingStep. يمكنك استخدام ال وظيفة JSONGet للاستعلام أ ملف الملكية. انظر الكود التالي:

لنفترض أن محتويات ملف الخاصية كانت كما يلي:

في هذه الحالة، يمكن الاستعلام عنها عن قيمة محددة واستخدامها في الخطوات اللاحقة باستخدام الدالة JsonGet:

معلمة متغير في تعريف خط الأنابيب

غالبًا ما يكون تحديد معلمات المتغيرات بحيث يمكن استخدامها في وقت التشغيل أمرًا مرغوبًا فيه - على سبيل المثال، لإنشاء معرف URI S3. يمكنك تحديد معلمات سلسلة بحيث يتم تقييمها في وقت التشغيل باستخدام التابع Join وظيفة. يوضح مقتطف التعليمات البرمجية التالي كيفية تعريف المتغير باستخدام Join الوظيفة واستخدمها لتعيين موقع الإخراج في خطوة المعالجة:

قم بتشغيل التعليمات البرمجية المتوازية على كائن قابل للتكرار

تقوم بعض مسارات عمل تعلم الآلة بتشغيل التعليمات البرمجية في حلقات متوازية عبر مجموعة ثابتة من العناصر (an متوقعة). يمكن أن يكون إما نفس الكود الذي يتم تشغيله على بيانات مختلفة أو جزء مختلف من الكود الذي يجب تشغيله لكل عنصر. على سبيل المثال، إذا كان لديك عدد كبير جدًا من الصفوف في ملف وتريد تسريع وقت المعالجة، فيمكنك الاعتماد على النمط السابق. إذا كنت تريد إجراء تحويلات مختلفة على مجموعات فرعية محددة في البيانات، فقد يتعين عليك تشغيل جزء مختلف من التعليمات البرمجية لكل مجموعة فرعية في البيانات. يوضح السيناريوهين التاليين كيف يمكنك تصميم مسارات SageMaker لهذا الغرض.

السيناريو 1: تنفيذ منطق المعالجة على أجزاء مختلفة من البيانات

يمكنك تشغيل مهمة معالجة بمثيلات متعددة (عن طريق الإعداد instance_count بقيمة أكبر من 1). يؤدي ذلك إلى توزيع بيانات الإدخال من Amazon S3 على جميع مثيلات المعالجة. يمكنك بعد ذلك استخدام برنامج نصي (process.py) للعمل على جزء معين من البيانات بناءً على رقم المثيل والعنصر المقابل في قائمة العناصر. يمكن كتابة منطق البرمجة فيprocess.py بحيث يتم تشغيل وحدة نمطية مختلفة أو جزء من التعليمات البرمجية اعتمادًا على قائمة العناصر التي تعالجها. يحدد المثال التالي المعالج الذي يمكن استخدامه في ProcessingStep:

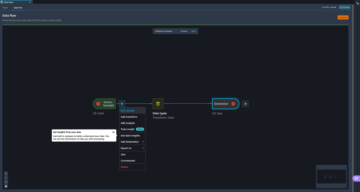

السيناريو 2: تشغيل سلسلة من الخطوات

عندما يكون لديك سلسلة من الخطوات التي تحتاج إلى تشغيلها بالتوازي، يمكنك تحديد كل تسلسل كمسار مستقل لـ SageMaker. ويمكن بعد ذلك تشغيل خطوط أنابيب SageMaker هذه من وظيفة Lambda التي تعد جزءًا من ملف LambdaStep في خط الأنابيب الأم. يوضح الجزء التالي من التعليمات البرمجية السيناريو الذي يتم فيه تشغيل مسارين مختلفين لخط أنابيب SageMaker:

وفي الختام

في هذا المنشور، ناقشنا بعض أفضل الممارسات للاستخدام والصيانة الفعالة لخطوط أنابيب SageMaker. لقد قدمنا أيضًا أنماطًا معينة يمكنك اعتمادها أثناء تصميم مسارات العمل باستخدام SageMaker Pipelines، سواء كنت تقوم بتأليف مسارات جديدة أو تقوم بترحيل مسارات عمل ML من أدوات التنسيق الأخرى. لبدء استخدام SageMaker Pipelines لتنسيق سير عمل ML، راجع عينات التعليمات البرمجية على جيثب و خطوط أنابيب بناء نموذج Amazon SageMaker.

حول المؤلف

بيناك بانيغراهي يعمل مع العملاء لبناء حلول تعتمد على التعلم الآلي لحل مشكلات العمل الإستراتيجية على AWS. عندما لا يكون منشغلًا بالتعلم الآلي، يمكن العثور عليه وهو يقوم بنزهة أو يقرأ كتابًا أو يشاهد الألعاب الرياضية.

بيناك بانيغراهي يعمل مع العملاء لبناء حلول تعتمد على التعلم الآلي لحل مشكلات العمل الإستراتيجية على AWS. عندما لا يكون منشغلًا بالتعلم الآلي، يمكن العثور عليه وهو يقوم بنزهة أو يقرأ كتابًا أو يشاهد الألعاب الرياضية.

ميناكشيسوندارام ثاندافارايان يعمل لدى AWS كأخصائي AI / ML. لديه شغف بتصميم وإنشاء وتعزيز تجارب البيانات والتحليلات التي تركز على الإنسان. تركز Meena على تطوير أنظمة مستدامة توفر مزايا تنافسية قابلة للقياس للعملاء الاستراتيجيين لـ AWS. مينا هو موصل ، ومفكر تصميم ، ويسعى جاهدًا لدفع الأعمال إلى طرق جديدة للعمل من خلال الابتكار ، والاحتضان ، والدمقرطة.

ميناكشيسوندارام ثاندافارايان يعمل لدى AWS كأخصائي AI / ML. لديه شغف بتصميم وإنشاء وتعزيز تجارب البيانات والتحليلات التي تركز على الإنسان. تركز Meena على تطوير أنظمة مستدامة توفر مزايا تنافسية قابلة للقياس للعملاء الاستراتيجيين لـ AWS. مينا هو موصل ، ومفكر تصميم ، ويسعى جاهدًا لدفع الأعمال إلى طرق جديدة للعمل من خلال الابتكار ، والاحتضان ، والدمقرطة.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- تشارت بريم. ارفع مستوى لعبة التداول الخاصة بك مع ChartPrime. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/best-practices-and-design-patterns-for-building-machine-learning-workflows-with-amazon-sagemaker-pipelines/

- :لديها

- :يكون

- :ليس

- :أين

- $ UP

- 1

- 100

- 11

- 13

- 15%

- 150

- 16

- 17

- 19

- 20

- 22

- 28

- 7

- 8

- 9

- a

- القدرة

- الوصول

- يمكن الوصول

- تحقق

- اكشن

- تضيف

- معالجة

- تبنى

- اعتماد

- مزايا

- بعد

- مجموع

- الكل

- يسمح

- أيضا

- أمازون

- الأمازون SageMaker

- خطوط أنابيب Amazon SageMaker

- أمازون ويب سيرفيسز

- an

- تحليلات

- و

- آخر

- API

- تطبيق

- مناسب

- هي

- AS

- افترض

- يفترض

- At

- التأليف

- متاح

- AWS

- على أساس

- BE

- يجري

- أفضل

- أفضل الممارسات

- ما بين

- كتاب

- نساعدك في بناء

- ابني

- الأعمال

- by

- CAN

- حقيبة

- الحالات

- معين

- زبون

- الكود

- مجموعات

- مشترك

- تنافسي

- إحصاء

- حالة

- الاعداد

- بناء

- استهلاك

- محتويات

- سياق الكلام

- متواصل

- ضوابط

- مناسب

- تحول

- المقابلة

- التكلفة

- فعاله من حيث التكلفه

- التكاليف

- خلق

- يخلق

- خلق

- على

- العملاء

- حسب الطلب

- البيانات

- قواعد البيانات

- حل الشفرة

- حدد

- يعرف

- تحديد

- تعريف

- التعاريف

- نقل

- الدمقرطة

- اعتمادا

- نشر

- نشر

- تصميم

- أنماط التصميم

- تصميم

- تفاصيل

- المطورين

- تطوير

- التطوير التجاري

- مختلف

- الأبعاد

- بحث

- ناقش

- do

- لا

- قيادة

- مدفوع

- أثناء

- كل

- بسهولة

- تأثير

- فعال

- إما

- العنصر

- تمكن

- النهاية

- فرض

- ضمان

- الكيانات

- البيئة

- تقييم

- تقييم

- الحدث/الفعالية

- كل

- مثال

- أمثلة

- الخبره في مجال الغطس

- خبرة

- تجربة

- مستكشف

- التعبير

- استخراج

- قليل

- قم بتقديم

- تصفية

- تطفو

- يتبع

- متابعيك

- في حالة

- سابق

- وجدت

- مجانا

- تبدأ من

- تماما

- وظيفة

- وظائف

- ولدت

- دولار فقط واحصل على خصم XNUMX% على جميع

- أكبر

- تجمع

- مجموعات

- يملك

- he

- رفع

- كيفية

- كيفية

- HTML

- HTTP

- HTTPS

- ID

- هوية

- if

- يوضح

- تنفيذ

- التنفيذ

- الأدوات

- استيراد

- تحسن

- in

- تتضمن

- يشمل

- بما فيه

- التحضين

- مستقل

- فرد

- معلومات

- الابتكار

- إدخال

- مثل

- بدلًا من ذلك

- المتكاملة

- دمج

- التفاعل

- إلى

- التذرع

- عزل

- IT

- العناصر

- التكرارات

- انها

- نفسها

- وظيفة

- المشــاريــع

- جسون

- القفل

- لغة

- كبير

- أكبر

- تعلم

- يتيح

- دورة حياة

- خفيفة الوزن

- مثل

- قائمة

- جار التحميل

- محلي

- محليا

- موقع

- منطق

- بحث

- آلة

- آلة التعلم

- صيانة

- جعل

- تمكن

- إدارة

- إدارة

- تعظيم

- مايو..

- طرق

- ربما

- المهاجرة

- ML

- موضة

- نموذج

- وحدة

- شهريا

- الأكثر من ذلك

- أكثر

- متعدد

- الاسم

- عين

- تسمية

- حاجة

- إحتياجات

- شبكة

- جديد

- الآن

- عدد

- موضوع

- الأجسام

- تحصل

- of

- عروض

- غالبا

- on

- ONE

- تشغيل

- or

- مدبرة

- تزامن

- منظم

- تنظيم

- أخرى

- الناتج

- على مدى

- أزواج

- موازية

- المعلمة

- المعلمات

- جزء

- pass

- شغف

- نمط

- أنماط

- إلى

- نفذ

- قطعة

- خط أنابيب

- المكان

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- سياسة

- جزء

- منشور

- ممارسة

- الممارسات

- المفضل

- سابق

- بدائي

- خاص

- مشاكل

- عملية المعالجة

- العمليات

- معالجة

- المعالج

- برمجة وتطوير

- تعزيز

- HAS

- الملكية

- تزود

- المقدمة

- ويوفر

- غرض

- بايثون

- سريع

- نادي القراءة

- الرجوع

- التسجيل

- منتظم

- اعتمد

- المتطلبات

- المتطلبات الأساسية

- مورد

- الموارد

- استجابة

- عائد أعلى

- عودة

- عائدات

- النوع

- يجري

- يدير

- s

- sagemaker

- خطوط الأنابيب SageMaker

- نفسه

- سيناريو

- سيناريوهات

- سيناريو

- سلس

- القسم

- تأمين

- أمن

- انظر تعريف

- تسلسل

- Serverless

- خوادم

- الخدمة

- خدماتنا

- الجلسة

- طقم

- ضبط

- ينبغي

- أظهرت

- يظهر

- وبالمثل

- الاشارات

- الأصغر

- قصاصة

- So

- الحلول

- حل

- بعض

- متخصص

- محدد

- محدد

- سرعة

- غزل

- رياضة

- بداية

- بدأت

- ملخص الحساب

- خطوة

- خطوات

- تخزين

- متجر

- إستراتيجي

- عمل إستراتيجي

- تبسيط

- خيط

- الفتن

- بناء

- الشبكات الفرعية

- لاحق

- هذه

- استدامة

- أنظمة

- TAG

- مع الأخذ

- اختبار

- من

- أن

- •

- منهم

- then

- هناك.

- تشبه

- هم

- مفكر

- عبر

- الوقت

- الطابع الزمني

- إلى

- أدوات

- الإجمالي

- مسار

- قطار

- قادة الإيمان

- تحول

- التحولات

- محاكمة

- يثير

- أثار

- صحيح

- اثنان

- نوع

- أنواع

- مع

- فريد من نوعه

- حتى

- الأستعمال

- تستخدم

- مستعمل

- يستخدم

- استخدام

- قيمنا

- القيم

- متغير

- الإصدار

- الإصدارات

- جدا

- تريد

- مراقبة

- طريق..

- طرق

- we

- الويب

- خدمات ويب

- كان

- متى

- سواء

- في حين

- سوف

- مع

- في غضون

- بدون

- للعمل

- سير العمل

- سير العمل

- عامل

- أعمال

- العالم

- مكتوب

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت