تقارير الأشعة هي وثائق شاملة وطويلة تصف وتفسر نتائج فحص التصوير الإشعاعي. في سير العمل النموذجي، يشرف أخصائي الأشعة على الصور ويقرأها ويفسرها، ثم يلخص النتائج الرئيسية بإيجاز. التلخيص (أو الانطباع) هو الجزء الأكثر أهمية في التقرير لأنه يساعد الأطباء والمرضى على التركيز على المحتويات الهامة للتقرير الذي يحتوي على معلومات لاتخاذ القرارات السريرية. يتطلب خلق انطباع واضح ومؤثر جهدًا أكبر بكثير من مجرد إعادة صياغة النتائج. وبالتالي فإن العملية برمتها شاقة، وتستغرق وقتا طويلا، وعرضة للخطأ. غالبا ما يستغرق سنوات من السلامه اولا لكي يتمكن الأطباء من تجميع ما يكفي من الخبرة في كتابة ملخصات موجزة وغنية بالمعلومات لتقارير الأشعة، مما يسلط الضوء بشكل أكبر على أهمية أتمتة العملية. بالإضافة إلى ذلك، الإنشاء التلقائي لتلخيص نتائج التقرير أمر بالغ الأهمية لتقارير الأشعة. فهو يتيح ترجمة التقارير إلى لغة يمكن قراءتها بواسطة الإنسان، وبالتالي تخفيف عبء القراءة على المرضى من خلال التقارير الطويلة والغامضة.

لحل هذه المشكلة، نقترح استخدام الذكاء الاصطناعي التوليدي، وهو نوع من الذكاء الاصطناعي يمكنه إنشاء محتوى وأفكار جديدة، بما في ذلك المحادثات والقصص والصور ومقاطع الفيديو والموسيقى. يتم تشغيل الذكاء الاصطناعي التوليدي بواسطة نماذج التعلم الآلي (ML)، وهي نماذج كبيرة جدًا تم تدريبها مسبقًا على كميات هائلة من البيانات ويشار إليها عادةً باسم النماذج الأساسية (FMs). أدت التطورات الأخيرة في تعلم الآلة (على وجه التحديد اختراع بنية الشبكة العصبية القائمة على المحولات) إلى ظهور النماذج التي تحتوي على مليارات من المعلمات أو المتغيرات. يستخدم الحل المقترح في هذا المنشور الضبط الدقيق لنماذج اللغات الكبيرة المدربة مسبقًا (LLMs) للمساعدة في إنشاء ملخصات بناءً على النتائج الواردة في تقارير الأشعة.

يوضح هذا المنشور استراتيجية لضبط شهادات LLM المتاحة للعامة لمهمة تلخيص تقرير الأشعة باستخدام خدمات AWS. لقد أظهرت LLMs قدرات ملحوظة في فهم اللغة الطبيعية وتوليدها، وهي بمثابة نماذج أساسية يمكن تكييفها مع مختلف المجالات والمهام. هناك فوائد كبيرة لاستخدام نموذج تم تدريبه مسبقًا. فهو يقلل من تكاليف الحساب، ويقلل من آثار الكربون، ويسمح لك باستخدام أحدث النماذج دون الحاجة إلى تدريب أحد النماذج من الصفر.

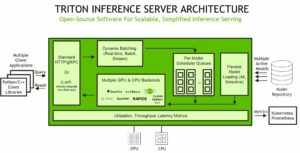

يستخدم الحل لدينا فلان-T5 XL إف إم، باستخدام أمازون سيج ميكر جومب ستارت، وهو مركز تعلم الآلة يقدم الخوارزميات والنماذج وحلول تعلم الآلة. نوضح كيفية تحقيق ذلك باستخدام دفتر ملاحظات في أمازون ساجميكر ستوديو. يتضمن الضبط الدقيق للنموذج الذي تم تدريبه مسبقًا مزيدًا من التدريب على بيانات محددة لتحسين الأداء في مهمة مختلفة ولكنها ذات صلة. يتضمن هذا الحل ضبط نموذج FLAN-T5 XL، وهو نسخة محسنة من T5 (محول نقل النص إلى النص) LLMs للأغراض العامة. يعيد T5 صياغة مهام معالجة اللغة الطبيعية (NLP) في تنسيق موحد لتحويل النص إلى نص، على عكس بيرتنماذج النمط التي يمكنها فقط إخراج تسمية فئة أو نطاق الإدخال. تم ضبطه بشكل دقيق للقيام بمهمة تلخيص لـ 91,544 تقريرًا إشعاعيًا نصيًا حرًا تم الحصول عليها من مجموعة بيانات MIMIC-CXR.

نظرة عامة على الحل

في هذا القسم، نناقش المكونات الرئيسية للحل الذي نقدمه: اختيار استراتيجية المهمة، وضبط ماجستير إدارة الأعمال، وتقييم النتائج. نوضح أيضًا بنية الحل وخطوات تنفيذ الحل.

تحديد استراتيجية المهمة

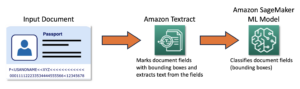

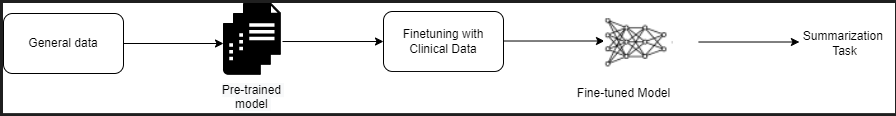

هناك استراتيجيات مختلفة للتعامل مع مهمة أتمتة تلخيص التقارير السريرية. على سبيل المثال، يمكننا استخدام نموذج لغة متخصص تم تدريبه مسبقًا على التقارير السريرية من الصفر. وبدلاً من ذلك، يمكننا مباشرة ضبط نموذج لغة للأغراض العامة متاح للعامة لأداء المهمة السريرية. قد يكون من الضروري استخدام نموذج دقيق لا يعتمد على المجال في الإعدادات التي يتم فيها التدريب نموذج اللغة من الصفر مكلفة للغاية. في هذا الحل، نعرض النهج الأخير لاستخدام نموذج FLAN -T5 XL، والذي نقوم بضبطه للمهمة السريرية المتمثلة في تلخيص تقارير الأشعة. ويوضح الرسم البياني التالي سير عمل النموذج.

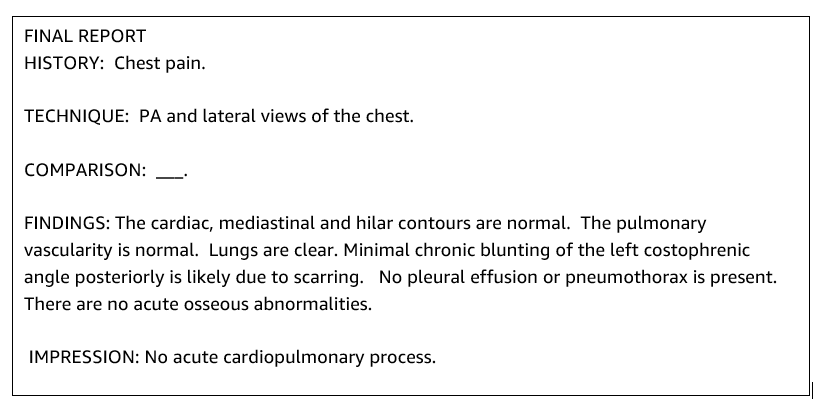

يكون تقرير الأشعة النموذجي منظمًا جيدًا وموجزًا. غالبًا ما تحتوي هذه التقارير على ثلاثة أقسام رئيسية:

- خلفيّة – يوفر معلومات عامة عن التركيبة السكانية للمريض مع المعلومات الأساسية عن المريض والتاريخ السريري والتاريخ الطبي ذي الصلة وتفاصيل إجراءات الفحص

- النتائج – يقدم تشخيص الامتحان التفصيلي والنتائج

- طبع – يلخص بإيجاز أبرز النتائج أو تفسير النتائج مع تقييم الأهمية والتشخيص المحتمل بناءً على التشوهات الملحوظة

باستخدام قسم النتائج في تقارير الأشعة، يقوم الحل بإنشاء قسم الانطباع، والذي يتوافق مع تلخيص الأطباء. الشكل التالي هو مثال لتقرير الأشعة.

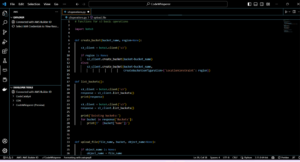

صقل ماجستير في القانون للأغراض العامة لمهمة سريرية

في هذا الحل، نقوم بضبط نموذج FLAN-T5 XL (ضبط جميع معلمات النموذج وتحسينها للمهمة). نقوم بضبط النموذج باستخدام مجموعة بيانات المجال السريري تقليد-CXR، وهي مجموعة بيانات متاحة للجمهور من الصور الشعاعية للصدر. لضبط هذا النموذج من خلال SageMaker Jumpstart، يجب توفير الأمثلة المصنفة في شكل أزواج {prompt,Complete}. في هذه الحالة، نستخدم أزواجًا من {النتائج والانطباعات} من التقارير الأصلية في مجموعة بيانات MIMIC-CXR. للاستدلال، نستخدم الموجه كما هو موضح في المثال التالي:

![]()

تم ضبط النموذج بدقة على الحوسبة المتسارعة مل. 3.16xlarge مثيل مع 64 وحدة معالجة مركزية افتراضية وذاكرة تبلغ 488 جيجا بايت. للتحقق من الصحة، تم اختيار 5٪ من مجموعة البيانات بشكل عشوائي. كان الوقت المنقضي لمهمة تدريب SageMaker مع الضبط الدقيق 38,468 ثانية (حوالي 11 ساعة).

قيم النتائج

عند اكتمال التدريب، من المهم تقييم النتائج. لإجراء تحليل كمي للانطباع الناتج، نستخدم ROUGE (الدراسة الموجهة نحو الاستدعاء لتقييم الإدراج)، وهو المقياس الأكثر استخدامًا لتقييم التلخيص. يقوم هذا المقياس بمقارنة الملخص الذي يتم إنتاجه تلقائيًا مع ملخص أو ترجمة مرجعية أو مجموعة من المراجع (من إنتاج الإنسان). يشير ROUGE1 إلى تداخل com.unigrams (كل كلمة) بين المرشح (مخرجات النموذج) وملخصات المراجع. يشير ROUGE2 إلى تداخل بيجرامز (كلمتان) بين ملخص المرشح والمرجع. ROUGEL هو مقياس على مستوى الجملة ويشير إلى أطول تسلسل مشترك (LCS) بين قطعتين من النص. يتجاهل الأسطر الجديدة في النص. ROUGELsum هو مقياس على مستوى الملخص. بالنسبة لهذا المقياس، لا يتم تجاهل الأسطر الجديدة في النص ولكن يتم تفسيرها على أنها حدود للجملة. يتم بعد ذلك حساب LCS بين كل زوج من الجمل المرجعية والجمل المرشحة، ثم يتم حساب union-LCS. لتجميع هذه الدرجات على مجموعة معينة من المراجع والجمل المرشحة، يتم حساب المتوسط.

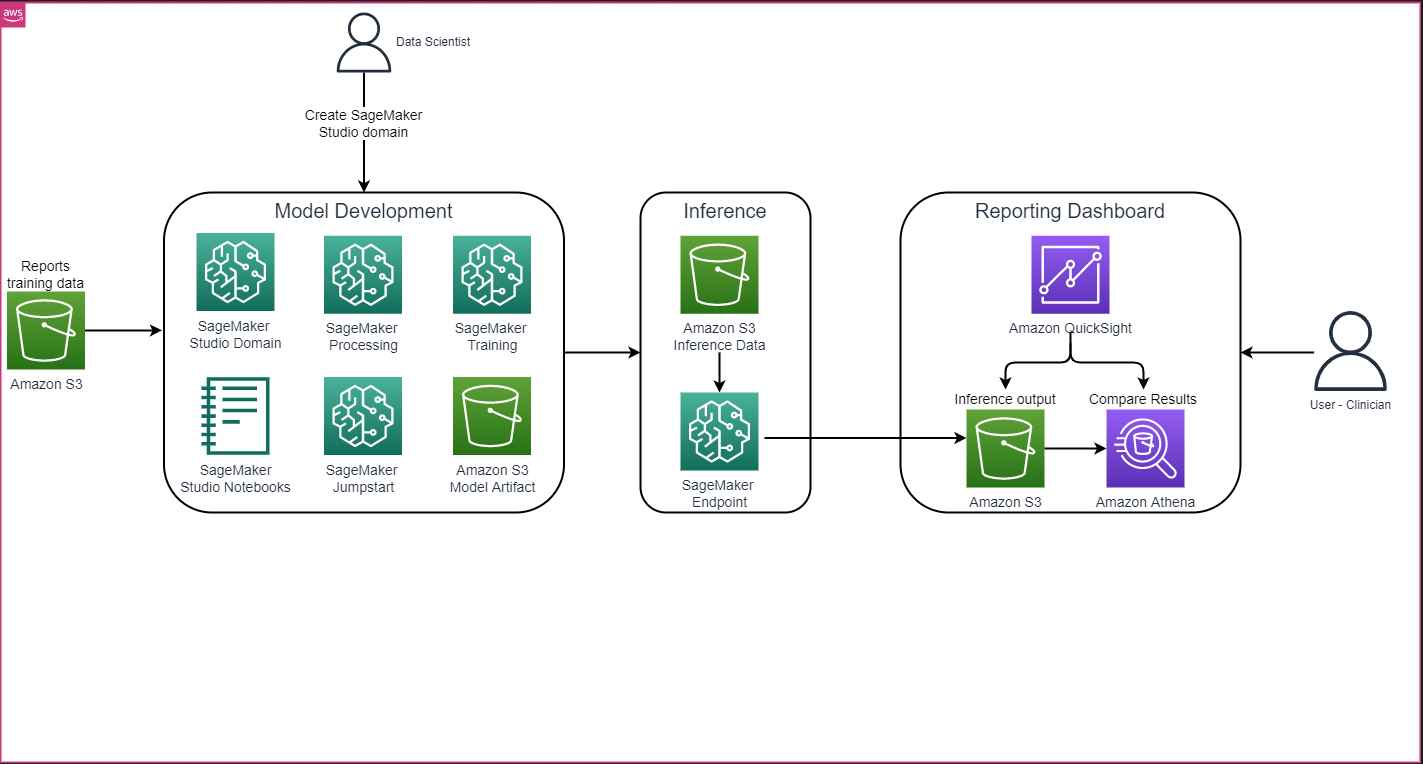

تجول والهندسة المعمارية

تتكون بنية الحل الشاملة كما هو موضح في الشكل التالي بشكل أساسي من بيئة تطوير نموذج تستخدم SageMaker Studio، ونشر النموذج باستخدام نقطة نهاية SageMaker، ولوحة معلومات إعداد التقارير باستخدام أمازون QuickSight.

في الأقسام التالية، نعرض الضبط الدقيق لمادة LLM المتاحة على SageMaker JumpStart لتلخيص مهمة خاصة بالمجال عبر SageMaker Python SDK. ونناقش على وجه الخصوص المواضيع التالية:

- خطوات إعداد بيئة التطوير

- نظرة عامة على مجموعات بيانات تقرير الأشعة التي تم تحسين النموذج وتقييمه بناءً عليها

- عرض توضيحي للضبط الدقيق لنموذج FLAN-T5 XL باستخدام SageMaker JumpStart برمجيًا باستخدام SageMaker Python SDK

- الاستدلال وتقييم النماذج المدربة مسبقًا والمضبوطة بدقة

- مقارنة النتائج من النماذج المدربة مسبقًا والنماذج المضبوطة بدقة

الحل موجود في إنشاء انطباع تقرير الأشعة باستخدام الذكاء الاصطناعي التوليدي مع نموذج اللغة الكبير على AWS جيثب ريبو.

المتطلبات الأساسية المسبقة

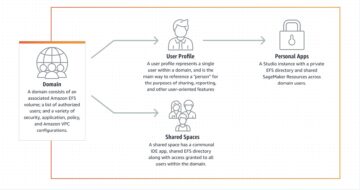

للبدء، أنت بحاجة إلى حساب AWS حيث يمكنك استخدام SageMaker Studio. ستحتاج إلى إنشاء ملف تعريف مستخدم لـ SageMaker Studio إذا لم يكن لديك ملف تعريف بالفعل.

نوع مثيل التدريب المستخدم في هذا المنشور هو ml.p3.16xlarge. لاحظ أن نوع المثيل p3 يتطلب زيادة حد حصة الخدمة.

• مجموعة بيانات MIMIC CXR يمكن الوصول إليها من خلال اتفاقية استخدام البيانات، والتي تتطلب تسجيل المستخدم وإكمال عملية الاعتماد.

قم بإعداد بيئة التطوير

لإعداد بيئة التطوير الخاصة بك، يمكنك إنشاء حاوية S3 وتكوين دفتر ملاحظات وإنشاء نقاط نهاية ونشر النماذج وإنشاء لوحة معلومات QuickSight.

قم بإنشاء دلو S3

قم بإنشاء دلو S3 تسمى llm-radiology-bucket لاستضافة مجموعات بيانات التدريب والتقييم. سيتم استخدام هذا أيضًا لتخزين قطعة أثرية النموذج أثناء تطوير النموذج.

تكوين دفتر ملاحظات

أكمل الخطوات التالية:

- قم بتشغيل SageMaker Studio إما من وحدة تحكم SageMaker أو من واجهة سطر الأوامر AWS (AWS CLI).

لمزيد من المعلومات حول الإعداد إلى المجال، راجع على متن الطائرة إلى Amazon SageMaker Domain.

- إنشاء جديد دفتر الملاحظات SageMaker Studio لتنظيف بيانات التقرير وضبط النموذج. نحن نستخدم مثيل الكمبيوتر الدفتري ml.t3.medium 2vCPU+4GiB مع نواة Python 3.

- داخل دفتر الملاحظات، قم بتثبيت الحزم ذات الصلة مثل

nest-asyncio,IPyWidgets(للحصول على عناصر واجهة المستخدم التفاعلية لجهاز Jupyter Notebook)، وSageMaker Python SDK:

للاستدلال على النماذج المدربة مسبقًا والمضبوطة بدقة، إنشاء نقطة نهاية ونشر كل نموذج في دفتر على النحو التالي:

- قم بإنشاء كائن نموذج من فئة النموذج الذي يمكن نشره إلى نقطة نهاية HTTPS.

- قم بإنشاء نقطة نهاية HTTPS باستخدام كائن النموذج المُنشأ مسبقًا

deploy()الأسلوب:

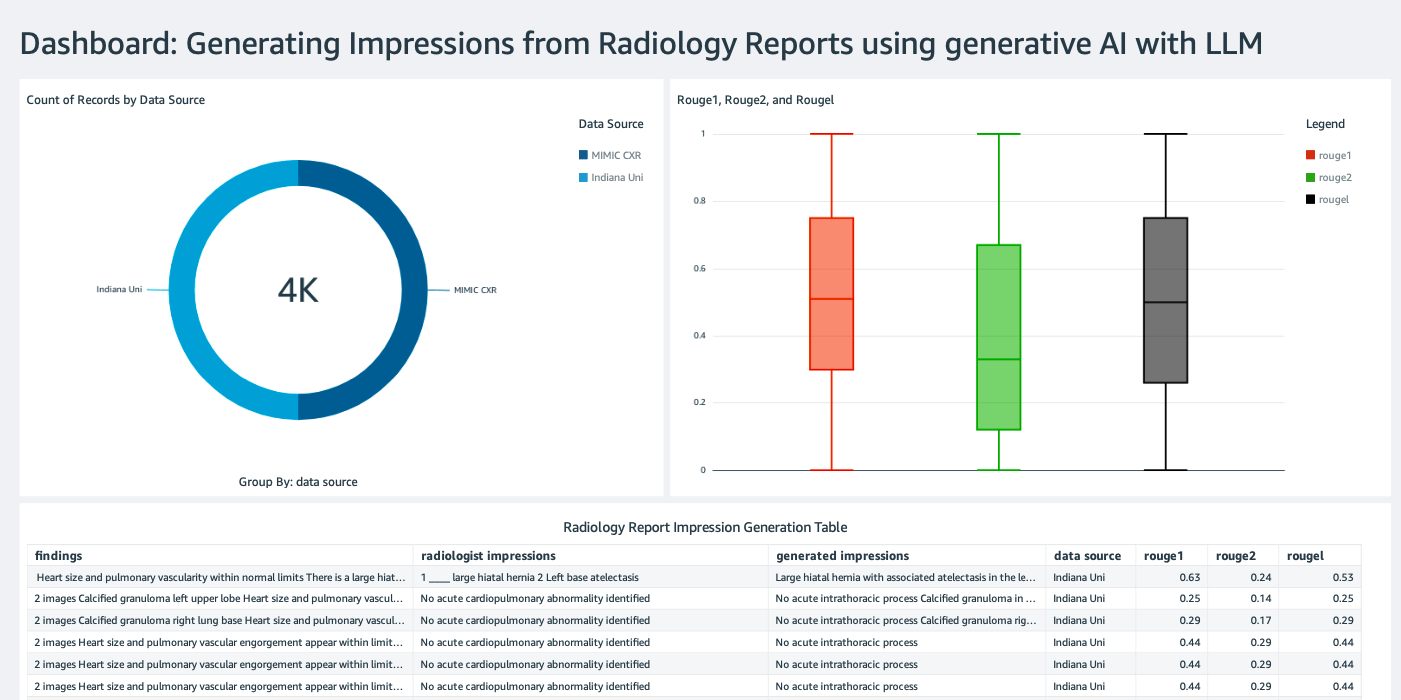

إنشاء لوحة معلومات QuickSight

إنشاء لوحة تحكم QuickSight مع مصدر بيانات أثينا مع استنتاج النتائج خدمة تخزين أمازون البسيطة (Amazon S3) لمقارنة نتائج الاستدلال بالحقيقة الأرضية. تُظهر لقطة الشاشة التالية مثالاً للوحة القيادة الخاصة بنا.

مجموعات بيانات تقرير الأشعة

تم الآن ضبط النموذج بشكل دقيق، حيث تم ضبط جميع معلمات النموذج على 91,544 تقريرًا تم تنزيلها من مجموعة بيانات MIMIC-CXR v2.0. نظرًا لأننا استخدمنا فقط البيانات النصية لتقرير الأشعة، فقد قمنا بتنزيل ملف تقرير مضغوط واحد فقط (mimic-cxr-reports.zip) من موقع MIMIC-CXR. نقوم الآن بتقييم النموذج المضبوط على 2,000 تقرير (يشار إليها باسم dev1 مجموعة البيانات) من المنفصلة عقدت مجموعة فرعية من مجموعة البيانات هذه. نستخدم 2,000 تقرير إشعاعي آخر (يشار إليها باسم dev2) لتقييم النموذج المضبوط بدقة من مجموعة الأشعة السينية للصدر من شبكة مستشفيات جامعة إنديانا. تتم قراءة كافة مجموعات البيانات كملفات JSON ويتم تحميلها إلى مجموعة S3 التي تم إنشاؤها حديثًا llm-radiology-bucket. لاحظ أن جميع مجموعات البيانات لا تحتوي بشكل افتراضي على أي معلومات صحية محمية (PHI)؛ يتم استبدال جميع المعلومات الحساسة بثلاث شرطات سفلية متتالية (___) من قبل مقدمي الخدمة.

يمكنك الضبط الدقيق باستخدام SageMaker Python SDK

من أجل الضبط الدقيق، model_id تم تحديده على أنه huggingface-text2text-flan-t5-xl من قائمة نماذج SageMaker JumpStart. ال training_instance_type تم تعيينه كـ ml.p3.16xlarge و inference_instance_type مثل ml.g5.2xlarge. تتم قراءة بيانات التدريب بتنسيق JSON من مجموعة S3. الخطوة التالية هي استخدام model_id المحدد لاستخراج معرفات الموارد المنتظمة (URI) لمورد SageMaker JumpStart، بما في ذلك image_uri (لل سجل الأمازون المرنة للحاويات (Amazon ECR) URI لصورة Docker)، model_uri (النموذج المُدرب مسبقًا لـ Amazon S3 URI)، و script_uri (سيناريو التدريب):

كما يتم أيضًا إعداد موقع الإخراج كمجلد داخل حاوية S3.

يتم تغيير معلمة تشعبية واحدة فقط، وهي العصور، إلى 3، ويتم تعيين الباقي جميعًا كإعداد افتراضي:

مقاييس التدريب مثل eval_loss (لخسارة التحقق من الصحة)، loss (لخسارة التدريب)، و epoch يتم تحديد وإدراج المراد تتبعها:

نحن نستخدم عناوين URI لمورد SageMaker JumpStart (image_uri, model_uri, script_uri) تم تحديده مسبقًا لإنشاء مُقدِّر وضبطه على مجموعة بيانات التدريب عن طريق تحديد مسار S3 لمجموعة البيانات. تتطلب فئة المقدر entry_point معامل. في هذه الحالة، يستخدم JumpStart transfer_learning.py. يفشل تشغيل مهمة التدريب إذا لم يتم تعيين هذه القيمة.

يمكن أن تستغرق هذه المهمة التدريبية ساعات حتى تكتمل؛ لذلك، يوصى بتعيين معلمة الانتظار على False ومراقبة حالة مهمة التدريب على وحدة تحكم SageMaker. استخدم ال TrainingJobAnalytics وظيفة لتتبع مقاييس التدريب في طوابع زمنية مختلفة:

نشر نقاط النهاية الاستدلالية

من أجل إجراء المقارنات، نقوم بنشر نقاط النهاية الاستدلالية لكل من النماذج المدربة مسبقًا والمضبوطة بدقة.

أولاً، قم باسترداد معرف URI لصورة Docker الاستدلالية باستخدامه model_id، واستخدم URI هذا لإنشاء مثيل نموذج SageMaker للنموذج المُدرب مسبقًا. انشر النموذج الذي تم تدريبه مسبقًا عن طريق إنشاء نقطة نهاية HTTPS باستخدام كائن النموذج الذي تم إنشاؤه مسبقًا deploy() طريقة. لتشغيل الاستدلال من خلال SageMaker API، تأكد من اجتياز فئة Predictor.

كرر الخطوة السابقة لإنشاء مثيل نموذج SageMaker للنموذج الذي تم ضبطه بدقة وإنشاء نقطة نهاية لنشر النموذج.

تقييم النماذج

أولاً، قم بتعيين طول النص الملخص، وعدد مخرجات النموذج (يجب أن يكون أكبر من 1 إذا كانت هناك حاجة إلى إنشاء ملخصات متعددة)، وعدد حزم النموذج بحث شعاع.

أنشئ طلب الاستدلال كحمولة JSON واستخدمه للاستعلام عن نقاط النهاية للنماذج المدربة مسبقًا والمضبوطة بدقة.

حساب المجمعة عشرات الحمر (ROUGE1، ROUGE2، ROUGEL، ROUGELsum) كما هو موضح سابقًا.

قارن النتائج

والجدول التالي يوضح نتائج التقييم ل dev1 و dev2 مجموعات البيانات. نتيجة التقييم على dev1 (2,000 نتيجة من تقرير الأشعة MIMIC CXR) تُظهر تحسنًا بنسبة 38 نقطة مئوية تقريبًا في المتوسط الإجمالي روج1 و روج2 النتائج مقارنة بالنموذج الذي تم تدريبه مسبقًا. بالنسبة لـ dev2، لوحظ تحسن قدره 31 نقطة مئوية و25 نقطة مئوية في درجات ROUGE1 وROUGE2. بشكل عام، أدى الضبط الدقيق إلى تحسن قدره 38.2 نقطة مئوية و31.3 نقطة مئوية في درجات ROUGELsum لـ dev1 و dev2 مجموعات البيانات، على التوالي.

|

التقييم بيانات |

نموذج مدرب مسبقًا | نموذج مضبوط | ||||||

| روج1 | روج2 | روجيل | روجيلسوم | روج1 | روج2 | روجيل | روجيلسوم | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

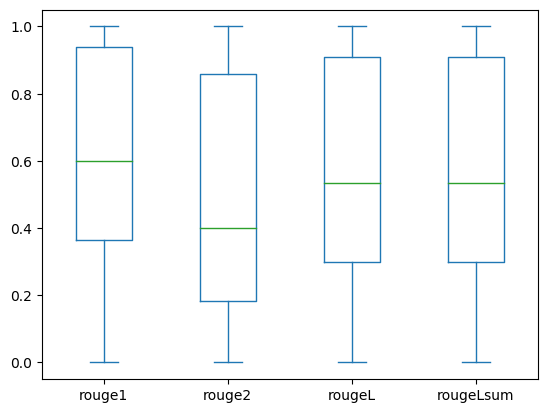

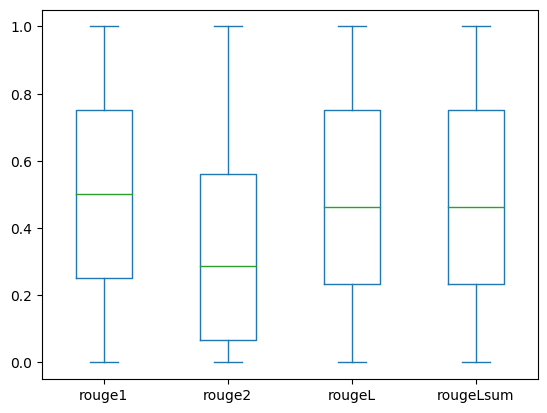

تصور مخططات الصندوق التالية توزيع درجات ROUGE لـ dev1 و dev2 تم تقييم مجموعات البيانات باستخدام النموذج الدقيق.

|

|

(أ): dev1 |

(ب): dev2 |

يوضح الجدول التالي أن درجات ROUGE لمجموعات بيانات التقييم لها نفس الوسيط والمتوسط تقريبًا وبالتالي يتم توزيعها بشكل متماثل.

| قواعد البيانات | قطعة موسيقى | العد التنازلي | تعني | الانحراف | الحد الأدنى | 25٪ النسبة المئوية | 50٪ النسبة المئوية | 75٪ النسبة المئوية | أقصى |

dev1 |

روج1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| روج 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| روج ل | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| روجيلسوم | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

روج 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| روج 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| روج ل | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| روج لاسوم | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

تنظيف

لتجنب تكبد رسوم مستقبلية، احذف الموارد التي قمت بإنشائها باستخدام الكود التالي:

وفي الختام

في هذا المنشور، أوضحنا كيفية ضبط نموذج FLAN-T5 XL لمهمة تلخيص سريرية خاصة بالمجال باستخدام SageMaker Studio. ولزيادة الثقة، قمنا بمقارنة التوقعات بالحقيقة الأرضية وقمنا بتقييم النتائج باستخدام مقاييس ROUGE. لقد أثبتنا أن النموذج الذي تم ضبطه جيدًا لمهمة معينة يؤدي إلى نتائج أفضل من النموذج الذي تم تدريبه مسبقًا على مهمة البرمجة اللغوية العصبية العامة. نود أن نشير إلى أن ضبط LLM للأغراض العامة يلغي تكلفة التدريب المسبق تمامًا.

على الرغم من أن العمل المقدم هنا يركز على تقارير الأشعة السينية للصدر، إلا أنه يمكن توسيعه ليشمل مجموعات بيانات أكبر ذات تشريحات وطرائق متنوعة، مثل التصوير بالرنين المغناطيسي والتصوير المقطعي المحوسب، حيث قد تكون تقارير الأشعة أكثر تعقيدًا مع نتائج متعددة. في مثل هذه الحالات، يمكن لأخصائيي الأشعة توليد انطباعات حسب درجة الأهمية وتضمين توصيات المتابعة. علاوة على ذلك، فإن إنشاء حلقة ردود فعل لهذا التطبيق من شأنه أن يمكّن أخصائيي الأشعة من تحسين أداء النموذج بمرور الوقت.

كما أظهرنا في هذا المنشور، يُنشئ النموذج المضبوط بدقة مرات ظهور لتقارير الأشعة ذات درجات ROUGE العالية. يمكنك محاولة ضبط LLMs على التقارير الطبية الأخرى الخاصة بالمجال من أقسام مختلفة.

عن المؤلفين

الدكتور أديوالي أكينفادرين هو أحد كبار علماء البيانات في الرعاية الصحية وعلوم الحياة في AWS. وتتمثل خبرته في أساليب الذكاء الاصطناعي/تعلم الآلة القابلة للتكرار والشاملة، والتطبيقات العملية، ومساعدة عملاء الرعاية الصحية العالميين على صياغة وتطوير حلول قابلة للتطوير للمشاكل متعددة التخصصات. حصل على درجتين عليا في الفيزياء ودرجة الدكتوراه في الهندسة.

الدكتور أديوالي أكينفادرين هو أحد كبار علماء البيانات في الرعاية الصحية وعلوم الحياة في AWS. وتتمثل خبرته في أساليب الذكاء الاصطناعي/تعلم الآلة القابلة للتكرار والشاملة، والتطبيقات العملية، ومساعدة عملاء الرعاية الصحية العالميين على صياغة وتطوير حلول قابلة للتطوير للمشاكل متعددة التخصصات. حصل على درجتين عليا في الفيزياء ودرجة الدكتوراه في الهندسة.

بريا باداتي هو أحد كبار مهندسي الحلول الشريكة ويتمتع بخبرة واسعة في مجال الرعاية الصحية وعلوم الحياة في AWS. تقود بريا استراتيجيات الذهاب إلى السوق مع الشركاء وتدفع تطوير الحلول لتسريع التطوير القائم على الذكاء الاصطناعي/التعلم الآلي. إنها متحمسة لاستخدام التكنولوجيا لتحويل صناعة الرعاية الصحية لتحقيق نتائج أفضل لرعاية المرضى.

بريا باداتي هو أحد كبار مهندسي الحلول الشريكة ويتمتع بخبرة واسعة في مجال الرعاية الصحية وعلوم الحياة في AWS. تقود بريا استراتيجيات الذهاب إلى السوق مع الشركاء وتدفع تطوير الحلول لتسريع التطوير القائم على الذكاء الاصطناعي/التعلم الآلي. إنها متحمسة لاستخدام التكنولوجيا لتحويل صناعة الرعاية الصحية لتحقيق نتائج أفضل لرعاية المرضى.

إكتا واليا بهولاردكتوراه، وهو أحد كبار مستشاري الذكاء الاصطناعي/تعلم الآلة في وحدة أعمال الخدمات المهنية في AWS للرعاية الصحية وعلوم الحياة (HCLS). تتمتع بخبرة واسعة في تطبيق الذكاء الاصطناعي/التعلم الآلي في مجال الرعاية الصحية، وخاصة في مجال الأشعة. خارج العمل، عندما لا تناقش الذكاء الاصطناعي في الأشعة، فإنها تحب الركض والمشي لمسافات طويلة.

إكتا واليا بهولاردكتوراه، وهو أحد كبار مستشاري الذكاء الاصطناعي/تعلم الآلة في وحدة أعمال الخدمات المهنية في AWS للرعاية الصحية وعلوم الحياة (HCLS). تتمتع بخبرة واسعة في تطبيق الذكاء الاصطناعي/التعلم الآلي في مجال الرعاية الصحية، وخاصة في مجال الأشعة. خارج العمل، عندما لا تناقش الذكاء الاصطناعي في الأشعة، فإنها تحب الركض والمشي لمسافات طويلة.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- تشارت بريم. ارفع مستوى لعبة التداول الخاصة بك مع ChartPrime. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :لديها

- :يكون

- :ليس

- :أين

- $ UP

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- ماهرون

- من نحن

- تسريع

- معجل

- الوصول

- إنجاز

- جمع

- وبالإضافة إلى ذلك

- التطورات

- ضد

- تجميع

- اتفاقية

- AI

- AI / ML

- خوارزميات

- الكل

- يسمح

- سابقا

- أيضا

- تماما

- أمازون

- الأمازون SageMaker

- أمازون ويب سيرفيسز

- المبالغ

- an

- تحليل

- و

- آخر

- أي وقت

- API

- تطبيق

- نهج

- ما يقرب من

- هندسة معمارية

- هي

- حجة

- AS

- التقييم المناسبين

- At

- أوتوماتيك

- تلقائيا

- أتمتة

- متاح

- المتوسط

- تجنب

- AWS

- قاعدة

- على أساس

- BE

- لان

- قبل

- يجري

- الفوائد

- أفضل

- ما بين

- أكبر

- المليارات

- على حد سواء

- الحدود

- صندوق

- عبء

- الأعمال

- لكن

- by

- تسمى

- CAN

- مرشح

- قدرات

- كربون

- يهمني

- حقيبة

- الحالات

- غير

- اسعارنا محددة من قبل وزارة العمل

- اختيار

- فئة

- سوائل التنظيف

- واضح

- سريري

- الأطباء

- الكود

- مجموعة شتاء XNUMX

- مشترك

- عادة

- قارن

- مقارنة

- إكمال

- إكمال

- مجمع

- مكونات

- شامل

- حساب

- الحوسبة

- مختصرا

- الثقة

- على التوالي

- يتكون

- كنسولات

- consultants

- تحتوي على

- وعاء

- محتوى

- محتويات

- تباين

- المحادثات

- يتوافق

- التكلفة

- مكلفة

- التكاليف

- استطاع

- زوجان

- خلق

- خلق

- خلق

- حرج

- حرجية

- على

- العملاء

- لوحة أجهزة القياس

- البيانات

- عالم البيانات

- قواعد البيانات

- اتخاذ القرار

- الترتيب

- تعريف

- الدرجة العلمية

- التركيبة السكانية

- شرح

- تظاهر

- يوضح

- الإدارات

- نشر

- نشر

- نشر

- وصف

- وصف

- مفصلة

- تفاصيل

- تطوير

- التطوير التجاري

- مختلف

- مباشرة

- بحث

- مناقشة

- وزعت

- توزيع

- عامل في حوض السفن

- أطباء

- وثائق

- نطاق

- المجالات

- لا

- رسم

- قيادة

- محركات

- أثناء

- كل

- في وقت سابق

- جهد

- إما

- يقضي على

- آخر

- تمكين

- تمكن

- النهائي إلى نهاية

- نقطة النهاية

- الهندسة

- تعزيز

- كاف

- كامل

- البيئة

- عصر

- عهود

- خطأ

- خاصة

- أساسي

- تقييم

- تقييم

- تقييم

- تقييم

- امتحان

- مثال

- أمثلة

- تنفيذ

- موسع

- الخبره في مجال الغطس

- خبرة

- واسع

- خبرة واسعة

- استخراج

- فشل

- زائف

- ردود الفعل

- الشكل

- قم بتقديم

- ملفات

- النتائج

- تركز

- ويركز

- متابعيك

- متابعات

- في حالة

- النموذج المرفق

- شكل

- دورة تأسيسية

- تبدأ من

- وظيفة

- إضافي

- علاوة على ذلك

- مستقبل

- العلاجات العامة

- هدف عام

- توليد

- ولدت

- يولد

- جيل

- توليدي

- الذكاء الاصطناعي التوليدي

- دولار فقط واحصل على خصم XNUMX% على جميع

- معطى

- العالمية

- اذهب إلى السوق

- خريج

- أكبر

- أرض

- يملك

- وجود

- he

- صحة الإنسان

- معلومات صحية

- الرعاية الصحية

- الرعاية الصحية الصناعة

- مساعدة

- مساعدة

- يساعد

- هنا

- مرتفع

- تسليط الضوء

- رفع

- له

- تاريخ

- مضيف

- ساعات العمل

- كيفية

- كيفية

- HTML

- HTTP

- HTTPS

- محور

- تعانق الوجه

- الانسان

- ID

- الأفكار

- محدد

- if

- يوضح

- صورة

- صور

- التصوير

- تأثيرا

- تنفيذ

- تطبيقات

- استيراد

- أهمية

- تحسن

- تحسين

- in

- تتضمن

- بما فيه

- القيمة الاسمية

- العالمية

- معلومات

- بالمعلومات

- إدخال

- تثبيت

- مثل

- التفاعلية

- ترجمة

- إلى

- اختراع

- IT

- وظيفة

- المشــاريــع

- جسون

- م

- واحد فقط

- احتفظ

- القفل

- تُشير

- لغة

- كبير

- إطلاق

- تعلم

- ليد

- الطول

- الحياة

- علوم الحياة

- مثل

- الإعجابات

- مما سيحدث

- خط

- قائمة

- المدرج

- LLM

- تقع

- موقع

- خسارة

- آلة

- آلة التعلم

- جعل

- مايو..

- تعني

- طبي

- متوسط

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- طريقة

- طرق

- متري

- المقاييس

- ربما

- دقيقة

- ML

- نموذج

- عارضات ازياء

- مراقبة

- الأكثر من ذلك

- أكثر

- التصوير بالرنين المغناطيسي

- كثيرا

- متعدد

- موسيقى

- يجب

- الاسم

- طبيعي

- معالجة اللغات الطبيعية

- ضروري

- حاجة

- شبكة

- الشبكة العصبية

- جديد

- حديثا

- التالي

- البرمجة اللغوية العصبية

- مفكرة

- الآن

- عدد

- موضوع

- تم الحصول عليها

- of

- الوهب

- غالبا

- on

- التأهيل ل

- ONE

- فقط

- تحسين

- or

- طلب

- أصلي

- أخرى

- لنا

- خارج

- النتائج

- الناتج

- في الخارج

- على مدى

- الكلي

- تجاوز

- نظرة عامة

- حزم

- زوج

- أزواج

- المعلمة

- المعلمات

- جزء

- خاص

- الشريكة

- شركاء

- pass

- عاطفي

- مسار

- المريض

- المرضى

- نسبة مئوية

- نفذ

- أداء

- رسالة دكتوراه

- فيزياء

- قطعة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- البوينت

- نقاط

- منشور

- محتمل

- مدعوم

- عملية

- تنبؤات

- متنبئ

- قدم

- الهدايا

- في المقام الأول

- المشكلة

- مشاكل

- عملية المعالجة

- معالجة

- أنتج

- محترف

- ملفي الشخصي

- اقترح

- المقترح

- محمي

- المقدمة

- مقدمي

- ويوفر

- علانية

- بايثون

- كمي

- عرض

- نادي القراءة

- الأخيرة

- ساندي خ. ميليك

- موصى به

- يقلل

- المراجع

- يشار

- يشير

- رجإكس

- التسجيل

- ذات صلة

- ذات الصلة

- لافت للنظر

- استبدال

- تقرير

- التقارير

- التقارير

- طلب

- مطلوب

- يتطلب

- مورد

- الموارد

- على التوالي

- REST

- نتيجة

- النتائج

- عائدات

- ارتفاع

- يجري

- تشغيل

- sagemaker

- نفسه

- تحجيم

- علوم

- عالم

- خدش

- الإستراحة

- بحث

- ثواني

- القسم

- أقسام

- انظر تعريف

- مختار

- كبير

- حساس

- عقوبة

- مستقل

- الخدمة

- خدماتنا

- خدمة

- طقم

- ضبط

- إعدادات

- هي

- ينبغي

- أظهرت

- أظهرت

- يظهر

- أهمية

- هام

- الاشارات

- ببساطة

- صغير

- So

- حل

- الحلول

- حل

- بعض

- امتداد

- متخصص

- محدد

- على وجه التحديد

- محدد

- بداية

- بدأت

- دولة من بين الفن

- الحالة

- خطوة

- خطوات

- لا يزال

- تخزين

- متجر

- قصص

- استراتيجيات

- الإستراتيجيات

- ستوديو

- هذه

- ملخص

- بالتأكيد

- جدول

- أخذ

- يأخذ

- مهمة

- المهام

- تكنولوجيا

- من

- أن

- •

- منهم

- then

- هناك.

- وبالتالي

- وبالتالي

- تشبه

- هؤلاء

- ثلاثة

- عبر

- الوقت

- إلى

- جدا

- المواضيع

- مسار

- قطار

- قادة الإيمان

- تحويل

- تحول

- محول

- خدمات ترجمة

- حقيقة

- محاولة

- اثنان

- نوع

- نموذجي

- يؤكد

- فهم

- موحد

- وحدة

- جامعة

- تم التحميل

- تستخدم

- مستعمل

- مستخدم

- يستخدم

- استخدام

- التحقق من صحة

- قيمنا

- القيم

- مختلف

- كبير

- الإصدار

- بواسطة

- مقاطع فيديو

- افتراضي

- انتظر

- وكان

- we

- الويب

- خدمات ويب

- الموقع الإلكتروني

- متى

- التي

- في حين

- عرض

- سوف

- مع

- في غضون

- بدون

- كلمة

- كلمات

- للعمل

- سير العمل

- سوف

- جاري الكتابة

- أشعة سينية

- سنوات

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت