نعلن اليوم عن توفر نماذج من دفاتر الملاحظات التي توضح مهام الإجابة على الأسئلة باستخدام نهج قائم على الاسترجاع المعزز (RAG) مع نماذج اللغات الكبيرة (LLMs) في أمازون سيج ميكر جومب ستارت. يتيح لك إنشاء النص باستخدام RAG مع LLMs إنشاء مخرجات نصية خاصة بالمجال من خلال توفير بيانات خارجية محددة كجزء من السياق الذي يتم تغذيته إلى LLM.

JumpStart هو مركز للتعلم الآلي (ML) يمكنه مساعدتك في تسريع رحلة تعلم الآلة. يوفر JumpStart العديد من نماذج اللغة المدربة مسبقًا والتي تسمى نماذج الأساس يمكن أن تساعدك في أداء مهام مثل تلخيص المقالات ، والإجابة على الأسئلة ، وإنشاء المحادثة وإنشاء الصور.

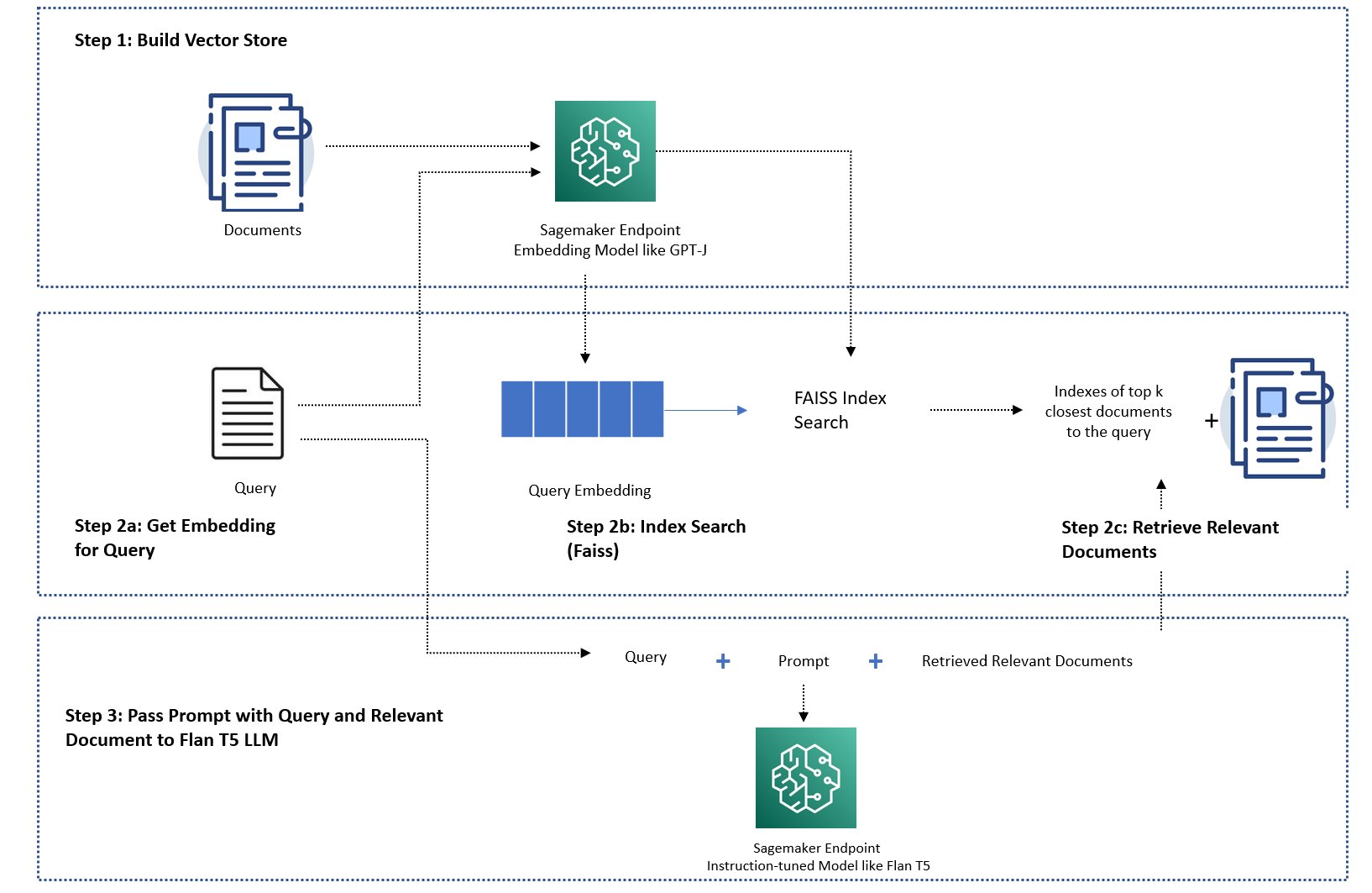

في هذا المنشور ، نصف RAG ومزاياها ، ونوضح كيفية البدء بسرعة باستخدام نموذج دفتر ملاحظات لحل مهمة الإجابة على السؤال باستخدام تنفيذ RAG مع LLMs في Jumpstart. نعرض طريقتين:

- كيفية حل المشكلة مع المصادر المفتوحة لانجشين مكتبة و الأمازون SageMaker نقاط النهاية في بضعة أسطر من التعليمات البرمجية

- كيفية استخدام خوارزمية SageMaker KNN لإجراء بحث دلالي عن البيانات واسعة النطاق باستخدام نقاط نهاية SageMaker

LLMS والقيود

يتم تدريب LLM على كميات كبيرة من البيانات غير المهيكلة وهي رائعة في إنشاء النص العام. يمكن أن تخزن LLM المعرفة الواقعية من خلال تدريب معلماتها على مجموعة كبيرة من بيانات اللغة الطبيعية.

هناك بعض القيود على استخدام LLMs المدربة مسبقًا الجاهزة:

- عادة ما يتم تدريبهم في وضع عدم الاتصال ، مما يجعل النموذج محايدًا لأحدث المعلومات (على سبيل المثال ، لا يحتوي روبوت الدردشة المدرب من 2011 إلى 2018 على معلومات حول COVID-19).

- يقومون بعمل تنبؤات من خلال البحث فقط عن المعلومات المخزنة في معلماتها ، مما يؤدي إلى تفسير رديء.

- يتم تدريبهم في الغالب على المجال العام ، مما يجعلهم أقل فعالية في المهام الخاصة بالمجال. هناك سيناريوهات عندما تريد أن تقوم النماذج بإنشاء نص بناءً على بيانات محددة بدلاً من البيانات العامة. على سبيل المثال ، قد ترغب إحدى شركات التأمين الصحي في أن يجيب الروبوت الذي يجيب على سؤالها عن الأسئلة باستخدام أحدث المعلومات المخزنة في مستودع مستندات المؤسسة أو قاعدة بياناتها ، وبالتالي فإن الإجابات دقيقة وتعكس قواعد العمل الفريدة الخاصة بها.

حاليًا ، هناك طريقتان شائعتان للإشارة إلى بيانات محددة في LLMs:

- أدخل البيانات كسياق في موجه النموذج كطريقة لتوفير المعلومات التي يمكن للنموذج استخدامها أثناء إنشاء النتيجة

- صقل النموذج من خلال توفير ملف به أزواج سريعة وإكمال

يتمثل التحدي الذي يواجه النهج القائم على السياق في أن النماذج تأتي بحجم سياق محدود ، وقد لا يتلاءم السياق مع حجم السياق المسموح به للنموذج. اعتمادًا على النموذج المستخدم ، قد تكون هناك أيضًا تكلفة إضافية لسياق أكبر.

بالنسبة لنهج الضبط الدقيق ، فإن إنشاء المعلومات المنسقة الصحيحة يستغرق وقتًا طويلاً وينطوي على تكلفة. بالإضافة إلى ذلك ، إذا تم استخدام البيانات الخارجية للضبط الدقيق للتغييرات بشكل متكرر ، فإن ذلك يعني ضمناً الحاجة إلى عمليات ضبط وإعادة تدريب متكررة للحصول على نتائج دقيقة. يؤثر التدريب المتكرر على السرعة في السوق ويضيف إلى التكلفة الإجمالية للحل.

لإثبات هذه القيود ، استخدمنا نموذج LLM Flan T5 XXL وطرحنا السؤال التالي:

حصلنا على الرد التالي:

كما ترى ، الاستجابة ليست دقيقة. يجب أن تكون الإجابة الصحيحة هي جميع مثيلات SageMaker التي تدعم Managed Spot Training.

لقد جربنا نفس السؤال ولكن مع سياق إضافي مررنا مع السؤال:

لقد تلقينا الرد التالي هذه المرة:

الاستجابة أفضل لكنها لا تزال غير دقيقة. ومع ذلك ، في حالات استخدام الإنتاج الحقيقي ، قد يرسل المستخدمون استعلامات متنوعة ، ولتقديم إجابات دقيقة ، قد ترغب في تضمين كل أو معظم المعلومات المتاحة كجزء من السياق الثابت لإنشاء استجابات دقيقة. لذلك ، من خلال هذا النهج ، قد نواجه قيود تحديد حجم السياق لأنه يتم إرسال المعلومات غير ذات الصلة بالسؤال المطروح كجزء من السياق. هذا هو المكان الذي يمكنك فيه استخدام النهج القائم على RAG لإنشاء استجابات قابلة للتطوير ودقيقة لاستفسارات المستخدم.

الجيل المعزز الاسترداد

لحل القيود التي ناقشناها ، يمكننا استخدام الاسترجاع المعزز (RAG) مع LLMs. يسترد RAG البيانات من خارج نموذج اللغة (غير معلمي) ويزيد المطالبات عن طريق إضافة البيانات المسترجعة ذات الصلة في السياق. تم تقديم نماذج RAG بواسطة لويس وآخرون. في عام 2020 كنموذج حيث الذاكرة البارامترية هي نموذج seq2seq مدرب مسبقًا والذاكرة غير المعلمية هي مؤشر متجه كثيف لـ Wikipedia ، يتم الوصول إليها باستخدام مسترد عصبي مدرب مسبقًا.

في RAG ، يمكن أن تأتي البيانات الخارجية من مصادر بيانات متعددة ، مثل مستودع المستندات أو قواعد البيانات أو واجهات برمجة التطبيقات. تتمثل الخطوة الأولى في تحويل المستندات واستعلام المستخدم بالتنسيق بحيث يمكن مقارنتها ويمكن إجراء بحث عن الصلة. لجعل التنسيقات قابلة للمقارنة لإجراء بحث الصلة ، يتم تحويل مجموعة المستندات (مكتبة المعرفة) والاستعلام المقدم من المستخدم إلى تمثيل رقمي باستخدام نماذج لغة التضمين. الزخارف هي في الأساس تمثيلات رقمية للمفهوم في النص. بعد ذلك ، بناءً على تضمين استعلام المستخدم ، يتم تحديد النص ذي الصلة في مجموعة المستندات عن طريق بحث التشابه في مساحة التضمين. ثم يتم إلحاق المطالبة التي قدمها المستخدم بالنص ذي الصلة الذي تم البحث عنه وإضافته إلى السياق. يتم الآن إرسال الموجه إلى LLM ولأن السياق يحتوي على بيانات خارجية ذات صلة مع الموجه الأصلي ، فإن إخراج النموذج مناسب ودقيق.

للاحتفاظ بمعلومات محدثة للمستندات المرجعية ، يمكنك تحديث المستندات بشكل غير متزامن وتحديث تمثيل تضمين المستندات. بهذه الطريقة ، سيتم استخدام المستندات المحدثة لتوليد إجابات للأسئلة المستقبلية لتقديم إجابات دقيقة.

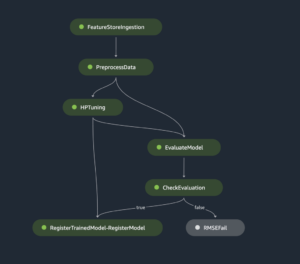

يوضح الرسم البياني التالي التدفق المفاهيمي لاستخدام RAG مع LLMs.

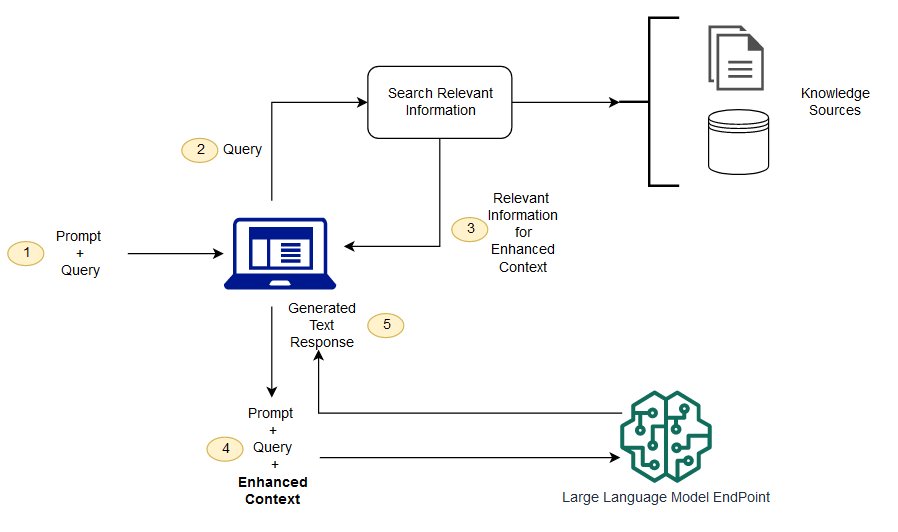

في هذا المنشور ، نوضح كيفية تنفيذ تطبيق يجيب على الأسئلة من خلال الخطوات التالية:

- قم بإنشاء التضمين لكل مستند في مكتبة المعرفة باستخدام نموذج التضمين SageMaker GPT-J-6B.

- حدد أهم مستندات K الأكثر صلة بناءً على استعلام المستخدم.

- لاستعلامك ، قم بإنشاء تضمين الاستعلام باستخدام نفس نموذج التضمين.

- ابحث في فهارس أهم مستندات K الأكثر صلة في مساحة التضمين باستخدام بحث FAISS في الذاكرة.

- استخدم الفهارس لاسترداد المستندات المقابلة.

- استخدم المستندات ذات الصلة المستردة كسياق مع الموجه والسؤال ، وأرسلها إلى SageMaker LLM لإنشاء الاستجابة.

نعرض الأساليب التالية:

- كيفية حل مهمة الإجابة على السؤال باستخدام SageMaker LLMs وتضمين نقاط النهاية ومكتبة LangChain مفتوحة المصدر في بضعة أسطر من التعليمات البرمجية. على وجه الخصوص ، نستخدم نقطتي نهاية SageMaker لـ LLM (Flan T5 XXL) ونموذج التضمين (GPT-J 6B) ، وقاعدة بيانات المتجه المستخدمة في الذاكرة فايس. لمزيد من التفاصيل ، راجع جيثب ريبو.

- إذا كان FAISS في الذاكرة لا يتناسب مع مجموعة البيانات الكبيرة الخاصة بك ، فنحن نقدم لك ملف خوارزمية SageMaker KNN لإجراء البحث الدلالي ، والذي يستخدم أيضًا FAISS كخوارزمية البحث الأساسية. لمزيد من التفاصيل ، انظر جيثب ريبو.

الرسم البياني التالي يصور بنية الحل.

دفتر تنفيذ مستند إلى JumpStart RAG مع LangChain

لانجشين هو إطار مفتوح المصدر لتطوير التطبيقات المدعومة بنماذج اللغة. يوفر LangChain واجهة عامة للعديد من LLMs المختلفة. كما أنه يسهل على المطورين ربط العديد من LLM معًا وبناء تطبيقات قوية. يوفر LangChain واجهة قياسية للذاكرة ومجموعة من تطبيقات الذاكرة لاستمرار الحالة بين مكالمات الوكلاء أو السلاسل.

لدى LangChain العديد من الميزات المساعدة الأخرى التي يمكن أن تضيف إلى إنتاجية المطور. تتضمن هذه الميزات نموذجًا سريعًا يساعد في تخصيص المطالبات باستخدام متغيرات في قالب المطالبة ، ووكلاء لبناء تطبيقات شاملة ، وفهارس لخطوات البحث والاسترجاع للسلسلة ، وغير ذلك الكثير. لمزيد من استكشاف إمكانات LangChain ، ارجع إلى ملف وثائق LangChain.

إنشاء نموذج ماجستير

كخطوة أولى ، انشر نموذج JumpStart LLM الذي تختاره. في هذا العرض التوضيحي ، نستخدم نقطة نهاية طراز Jumpstart Flan T5 XXL. للحصول على تعليمات النشر ، ارجع إلى مطالبة Zero-shot لنموذج الأساس Flan-T5 في Amazon SageMaker JumpStart. بناءً على حالة الاستخدام الخاصة بك ، يمكنك أيضًا نشر نماذج أخرى مضبوطة بالتعليمات مثل فلان T5 UL2 or بلومز 7 ب 1. لمزيد من التفاصيل ، انظر سبيل المثال دفتر.

لاستخدام نقطة نهاية SageMaker LLM مع LangChain ، نستخدم langchain.llms.sagemaker_endpoint.SagemakerEndpoint، والتي تلخص نقطة نهاية SageMaker LLM. نحتاج إلى إجراء تحويل لحمولة الطلب والاستجابة كما هو موضح في الكود التالي لتكامل LangChain SageMaker. لاحظ أنك قد تحتاج إلى تعديل الكود بتنسيق ContentHandler استنادا إلى content_type ويقبل تنسيق نموذج LLM الذي تختار استخدامه.

قم بإنشاء نموذج التضمين

بعد ذلك ، نحتاج إلى تجهيز نموذجنا المضمن. ننشر جي بي تي-ي 6 ب نموذج كنموذج التضمين. إذا كنت تستخدم نموذج تضمين JumpStart ، فستحتاج إلى تخصيص فئة دمج نقطة نهاية LangChain SageMaker وتحويل طلب النموذج والاستجابة للتكامل مع LangChain. للحصول على تنفيذ مفصل ، يرجى الرجوع إلى جيثب ريبو.

قم بتحميل المستندات الخاصة بالمجال باستخدام أداة تحميل المستندات LangChain وقم بإنشاء فهرس

نستخدم CSVLoader الحزمة في LangChain لتحميل المستندات بتنسيق CSV في أداة تحميل المستندات:

بعد ذلك ، نستخدم TextSplitter لمعالجة البيانات مسبقًا لأغراض التضمين واستخدام نموذج التضمين SageMaker جي بي تي-ي-6ب لإنشاء التضمين. نقوم بتخزين التضمين في متجر ناقل FAISS لإنشاء فهرس. نستخدم هذا الفهرس للعثور على المستندات ذات الصلة التي تشبه استعلام المستخدم من الناحية اللغوية.

يوضح الكود التالي كيف يتم تنفيذ كل هذه الخطوات بواسطة ملف VectorstoreIndexCreator فئة في سطور قليلة فقط من التعليمات البرمجية في LangChain لإنشاء تنفيذ موجز للإجابة على السؤال باستخدام RAG:

استخدم الفهرس للبحث عن السياق ذي الصلة وتمريره إلى نموذج LLM

بعد ذلك ، استخدم طريقة الاستعلام في الفهرس الذي تم إنشاؤه واجتاز سؤال المستخدم ونقطة نهاية SageMaker LLM. يحدد LangChain أقرب أربعة مستندات (K = 4) ويمرر السياق ذي الصلة المستخرج من المستندات لتوليد استجابة دقيقة. انظر الكود التالي:

نحصل على الاستجابة التالية للاستعلام باستخدام النهج القائم على RAG مع Flan T5 XXL:

تبدو الاستجابة أكثر دقة مقارنة بالاستجابة التي حصلنا عليها مع الأساليب الأخرى التي أظهرناها سابقًا والتي ليس لها سياق أو سياق ثابت قد لا يكون دائمًا ذا صلة.

نهج بديل لتنفيذ RAG مع المزيد من التخصيص باستخدام SageMaker و LangChain

في هذا القسم ، نعرض لك طريقة أخرى لتنفيذ RAG باستخدام SageMaker و LangChain. يوفر هذا الأسلوب المرونة لتكوين معلمات K العليا للبحث عن الصلة في المستندات. كما يسمح لك باستخدام ميزة LangChain الخاصة بـ قوالب سريعة، والتي تسمح لك بسهولة تحديد معلمات الإنشاء الفوري بدلاً من الترميز الثابت للمطالبات.

في الكود التالي ، نستخدم FAISS بشكل صريح لإنشاء التضمين لكل مستند في مكتبة المعرفة باستخدام نموذج التضمين SageMaker GPT-J-6B. ثم نحدد أهم مستندات K (K = 3) الأكثر صلة بناءً على استعلام المستخدم.

بعد ذلك ، نستخدم نموذجًا سريعًا وربطه بـ SageMaker LLM:

نرسل أهم ثلاثة (K = 3) المستندات ذات الصلة التي وجدناها كسياق للموجه باستخدام سلسلة LangChain:

مع هذا النهج لتطبيق RAG ، تمكنا من الاستفادة من المرونة الإضافية لقوالب LangChain الفورية وتخصيص عدد المستندات التي تم البحث عنها لتطابق الملاءمة باستخدام أعلى معلمة K.

دفتر تنفيذ مستند إلى JumpStart RAG مع SageMaker KNN

في هذا القسم ، نقوم بتنفيذ النهج القائم على RAG باستخدام خوارزمية KNN للعثور على المستندات ذات الصلة لإنشاء سياق محسن. في هذا النهج ، لا نستخدم LangChain ، لكننا نستخدم نفس مجموعة البيانات الأسئلة الشائعة حول Amazon SageMaker كوثائق معرفية ، يتم تضمين الطرازين GPT-J-6B و LLM Flan T5 XXL تمامًا كما فعلنا في نهج LangChain السابق.

إذا كانت لديك مجموعة بيانات كبيرة ، فإن ملف خوارزمية SageMaker KNN قد يوفر لك بحثًا دلاليًا فعالاً. تستخدم خوارزمية SageMaker KNN أيضًا FAISS كخوارزمية البحث الأساسية. يمكن العثور على دفتر الملاحظات لهذا الحل على GitHub جيثب:.

أولاً ، نقوم بنشر نماذج تضمين LLM Flan T5 XXL و GPT-J 6B بنفس الطريقة كما في القسم السابق. لكل سجل في قاعدة بيانات المعرفة ، نقوم بإنشاء متجه تضمين باستخدام نموذج تضمين GPT-J.

بعد ذلك ، نستخدم ملف سيج ميكر KNN وظيفة تدريبية لفهرسة تضمين بيانات المعرفة. الخوارزمية الأساسية المستخدمة لفهرسة البيانات هي فايس. نريد العثور على أهم خمس مستندات ذات صلة ، لذلك قمنا بتعيين TOP_K متغير إلى 5. نقوم بإنشاء مقدر لخوارزمية KNN ، وتشغيل مهمة التدريب ، ونشر نموذج KNN للعثور على فهارس لأهم خمس مستندات تطابق الاستعلام. انظر الكود التالي:

بعد ذلك ، نقوم بإنشاء تمثيل تضمين للاستعلام باستخدام نموذج التضمين GPT-J-6B الذي استخدمناه لإنشاء دمج مستندات مكتبة المعرفة:

ثم نستخدم نقطة نهاية KNN ونمرر تضمين الاستعلام إلى نقطة نهاية KNN للحصول على فهارس أهم مستندات K الأكثر صلة. نستخدم الفهارس لاسترداد الوثائق النصية المتطابقة. بعد ذلك ، نقوم بتسلسل المستندات ، مما يضمن عدم تجاوز الحد الأقصى المسموح به للطول. انظر الكود التالي:

نصل الآن إلى خطوتنا الأخيرة التي ندمج فيها الاستعلام والموجه والسياق الذي يحتوي على نص من المستندات ذات الصلة ونمرره إلى نموذج LLM Flan T5 XXL لتوليد الإجابة.

نحصل على الاستجابة التالية للاستعلام باستخدام نهج قائم على RAG مع Flan T5 XXL:

تنظيف

تأكد من حذف نقاط النهاية التي أنشأناها في دفتر الملاحظات هذا عند عدم استخدامها لتجنب تكرار التكلفة.

وفي الختام

في هذا المنشور ، أظهرنا تنفيذ نهج قائم على RAG مع LLM لمهام الإجابة على الأسئلة باستخدام طريقتين: LangChain وخوارزمية KNN المضمنة. يعمل النهج القائم على RAG على تحسين دقة إنشاء النص باستخدام Flan T5 XXL من خلال توفير سياق ذي صلة ديناميكيًا تم إنشاؤه من خلال البحث في قائمة المستندات.

يمكنك استخدام دفاتر الملاحظات هذه في SageMaker كما هي أو يمكنك تخصيصها حسب احتياجاتك. للتخصيص ، يمكنك استخدام مجموعة المستندات الخاصة بك في مكتبة المعرفة ، واستخدام تطبيقات البحث الأخرى ذات الصلة مثل OpenSearch ، واستخدام نماذج التضمين الأخرى وتوليد النصوص LLMs المتوفرة في JumpStart.

نتطلع إلى رؤية ما تقوم ببنائه على JumpStart باستخدام نهج قائم على RAG!

عن المؤلفين

الدكتور شين هوانغ هو عالم تطبيقي كبير في Amazon SageMaker JumpStart وخوارزميات Amazon SageMaker المدمجة. يركز على تطوير خوارزميات التعلم الآلي القابلة للتطوير. تتركز اهتماماته البحثية في مجال معالجة اللغة الطبيعية ، والتعلم العميق القابل للتفسير على البيانات المجدولة ، والتحليل القوي لتجميع الزمكان غير المعياري. وقد نشر العديد من الأوراق في مؤتمرات ACL و ICDM و KDD والجمعية الملكية للإحصاء: السلسلة أ.

الدكتور شين هوانغ هو عالم تطبيقي كبير في Amazon SageMaker JumpStart وخوارزميات Amazon SageMaker المدمجة. يركز على تطوير خوارزميات التعلم الآلي القابلة للتطوير. تتركز اهتماماته البحثية في مجال معالجة اللغة الطبيعية ، والتعلم العميق القابل للتفسير على البيانات المجدولة ، والتحليل القوي لتجميع الزمكان غير المعياري. وقد نشر العديد من الأوراق في مؤتمرات ACL و ICDM و KDD والجمعية الملكية للإحصاء: السلسلة أ.

راتشنا شادا هو مهندس الحلول الرئيسي AI / ML في الحسابات الإستراتيجية في AWS. إن راتشنا متفائلة تؤمن بأن الاستخدام الأخلاقي والمسؤول للذكاء الاصطناعي يمكن أن يحسن المجتمع في المستقبل ويحقق الرخاء الاقتصادي والاجتماعي. في أوقات فراغها ، تحب راتشنا قضاء الوقت مع عائلتها ، والمشي لمسافات طويلة والاستماع إلى الموسيقى.

راتشنا شادا هو مهندس الحلول الرئيسي AI / ML في الحسابات الإستراتيجية في AWS. إن راتشنا متفائلة تؤمن بأن الاستخدام الأخلاقي والمسؤول للذكاء الاصطناعي يمكن أن يحسن المجتمع في المستقبل ويحقق الرخاء الاقتصادي والاجتماعي. في أوقات فراغها ، تحب راتشنا قضاء الوقت مع عائلتها ، والمشي لمسافات طويلة والاستماع إلى الموسيقى.

دكتور كايل أولريش هو عالم تطبيقي مع فريق الخوارزميات المدمجة في Amazon SageMaker. تشمل اهتماماته البحثية خوارزميات التعلم الآلي القابلة للتطوير ، والرؤية الحاسوبية ، والسلاسل الزمنية ، والمعاملات البايزية غير البارامترية ، والعمليات الغاوسية. حصل على درجة الدكتوراه من جامعة ديوك وقد نشر أبحاثًا في NeurIPS و Cell و Neuron.

دكتور كايل أولريش هو عالم تطبيقي مع فريق الخوارزميات المدمجة في Amazon SageMaker. تشمل اهتماماته البحثية خوارزميات التعلم الآلي القابلة للتطوير ، والرؤية الحاسوبية ، والسلاسل الزمنية ، والمعاملات البايزية غير البارامترية ، والعمليات الغاوسية. حصل على درجة الدكتوراه من جامعة ديوك وقد نشر أبحاثًا في NeurIPS و Cell و Neuron.

هيمانت سينغ هو مهندس تعلم آلي يتمتع بخبرة في الخوارزميات المدمجة في Amazon SageMaker JumpStart و Amazon SageMaker. حصل على درجة الماجستير من معهد كورانت للعلوم الرياضية وبكلوريوس في التكنولوجيا من IIT دلهي. كان لديه خبرة في العمل على مجموعة متنوعة من مشاكل التعلم الآلي في مجال معالجة اللغة الطبيعية ، ورؤية الكمبيوتر ، وتحليل السلاسل الزمنية.

هيمانت سينغ هو مهندس تعلم آلي يتمتع بخبرة في الخوارزميات المدمجة في Amazon SageMaker JumpStart و Amazon SageMaker. حصل على درجة الماجستير من معهد كورانت للعلوم الرياضية وبكلوريوس في التكنولوجيا من IIT دلهي. كان لديه خبرة في العمل على مجموعة متنوعة من مشاكل التعلم الآلي في مجال معالجة اللغة الطبيعية ، ورؤية الكمبيوتر ، وتحليل السلاسل الزمنية.

ماناس داداركار مدير تطوير برمجيات يمتلك هندسة خدمة Amazon Forecast. إنه متحمس لتطبيقات التعلم الآلي وجعل تقنيات ML متاحة بسهولة للجميع لتبنيها ونشرها في الإنتاج. خارج العمل ، لديه اهتمامات متعددة بما في ذلك السفر والقراءة وقضاء الوقت مع الأصدقاء والعائلة.

ماناس داداركار مدير تطوير برمجيات يمتلك هندسة خدمة Amazon Forecast. إنه متحمس لتطبيقات التعلم الآلي وجعل تقنيات ML متاحة بسهولة للجميع لتبنيها ونشرها في الإنتاج. خارج العمل ، لديه اهتمامات متعددة بما في ذلك السفر والقراءة وقضاء الوقت مع الأصدقاء والعائلة.

د. أشيش خيتان هو عالم تطبيقي أقدم مع خوارزميات Amazon SageMaker المضمنة ويساعد في تطوير خوارزميات التعلم الآلي. حصل على الدكتوراه من جامعة إلينوي في أوربانا شامبين. وهو باحث نشط في التعلم الآلي والاستدلال الإحصائي ، وقد نشر العديد من الأوراق البحثية في مؤتمرات NeurIPS و ICML و ICLR و JMLR و ACL و EMNLP.

د. أشيش خيتان هو عالم تطبيقي أقدم مع خوارزميات Amazon SageMaker المضمنة ويساعد في تطوير خوارزميات التعلم الآلي. حصل على الدكتوراه من جامعة إلينوي في أوربانا شامبين. وهو باحث نشط في التعلم الآلي والاستدلال الإحصائي ، وقد نشر العديد من الأوراق البحثية في مؤتمرات NeurIPS و ICML و ICLR و JMLR و ACL و EMNLP.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- أفلاطونايستريم. ذكاء بيانات Web3. تضخيم المعرفة. الوصول هنا.

- سك المستقبل مع أدرين أشلي. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/question-answering-using-retrieval-augmented-generation-with-foundation-models-in-amazon-sagemaker-jumpstart/

- :لديها

- :يكون

- :ليس

- :أين

- $ UP

- 1

- 10

- 100

- 11

- 12

- 13

- 26%

- 500

- 7

- 8

- 9

- a

- ماهرون

- من نحن

- الملخصات

- تسريع

- يقبل

- الوصول

- الحسابات

- دقة

- دقيق

- نشط

- تضيف

- وأضاف

- مضيفا

- إضافة

- إضافي

- يضيف

- تبنى

- مميزات

- مزايا

- عملاء

- AI

- AI / ML

- AL

- خوارزمية

- خوارزميات

- الكل

- يسمح

- على طول

- أيضا

- دائما

- أمازون

- توقعات الأمازون

- الأمازون SageMaker

- أمازون سيج ميكر جومب ستارت

- المبالغ

- an

- تحليل

- و

- أعلن

- آخر

- إجابة

- الأجوبة

- واجهات برمجة التطبيقات

- تطبيق

- التطبيقات

- تطبيقي

- التقديم

- نهج

- اقتراب

- هندسة معمارية

- هي

- المنطقة

- البند

- AS

- At

- المعزز

- توفر

- متاح

- تجنب

- AWS

- على أساس

- بايزي

- BE

- لان

- يعتقد

- أفضل

- ما بين

- أحذية طويلة

- جلب

- نساعدك في بناء

- مدمج

- الأعمال

- لكن

- by

- تسمى

- دعوات

- CAN

- قدرات

- حقيبة

- الحالات

- سلسلة

- السلاسل

- تحدى

- التغييرات

- chatbot

- خيار

- اختار

- فئة

- المجموعات

- الكود

- البرمجة

- مجموعة شتاء XNUMX

- دمج

- تأتي

- حول الشركة

- مماثل

- مقارنة

- إكمال

- الكمبيوتر

- رؤية الكمبيوتر

- مفهوم

- المفاهيمي

- المؤتمرات

- القيود

- يحتوي

- سياق الكلام

- محادثة

- تحول

- تحويلها

- تصحيح

- المقابلة

- التكلفة

- كوفيد-19

- خلق

- خلق

- خلق

- خلق

- حاليا

- التخصيص

- تصميم

- البيانات

- علم البيانات

- قاعدة البيانات

- قواعد البيانات

- عميق

- التعلم العميق

- دلهي

- شرح

- تظاهر

- اعتمادا

- نشر

- نشر

- نشر

- وصف

- مفصلة

- تفاصيل

- تطوير

- المطور

- المطورين

- تطوير

- التطوير التجاري

- فعل

- فرق

- مختلف

- ناقش

- عدة

- وثيقة

- وثائق

- لا

- فعل

- نطاق

- فعل

- دوق

- جامعة ديوك

- حيوي

- E & T

- كل

- في وقت سابق

- أسهل

- بسهولة

- الطُرق الفعّالة

- جزءا لا يتجزأ من

- تضمين

- تمكن

- النهائي إلى نهاية

- نقطة النهاية

- مهندس

- الهندسة

- تعزيز

- ضمان

- مشروع

- أساسيا

- أخلاقي

- حتى

- كل شخص

- مثال

- تجاوز

- الخبره في مجال الغطس

- اكتشف

- خارجي

- للعائلات

- الميزات

- المميزات

- بنك الاحتياطي الفيدرالي

- قليل

- قم بتقديم

- نهائي

- العثور على

- الاسم الأول

- تناسب

- ثابت

- مرونة

- تدفق

- ويركز

- متابعيك

- في حالة

- توقعات

- شكل

- إلى الأمام

- وجدت

- دورة تأسيسية

- أربعة

- الإطار

- متكرر

- كثيرا

- الاصدقاء

- تبدأ من

- إضافي

- مستقبل

- العلاجات العامة

- توليد

- ولدت

- توليد

- جيل

- دولار فقط واحصل على خصم XNUMX% على جميع

- معطى

- عظيم

- كان

- الثابت

- يملك

- he

- صحة الإنسان

- التأمين الصحي

- مساعدة

- يساعد

- لها

- مرتفع

- له

- ضرب

- كيفية

- كيفية

- لكن

- HTML

- HTTPS

- محور

- i

- محدد

- تحديد

- if

- إلينوي

- صورة

- الآثار

- تنفيذ

- التنفيذ

- استيراد

- تحسن

- in

- تتضمن

- بما فيه

- مؤشر

- الفهارس

- معلومات

- مثل

- بدلًا من ذلك

- معهد

- تعليمات

- التأمين

- دمج

- التكامل

- السريرية

- السطح البيني

- إلى

- أدخلت

- IT

- انها

- وظيفة

- رحلة

- JPG

- جسون

- م

- المعرفة

- لغة

- كبير

- على نطاق واسع

- أكبر

- آخر

- قيادة

- تعلم

- الطول

- المكتبة

- مثل

- الإعجابات

- تحديد

- القيود

- محدود

- حدود

- خطوط

- قائمة

- استماع

- LLM

- تحميل

- محمل

- المواقع

- بحث

- أبحث

- تبدو

- منخفض

- آلة

- آلة التعلم

- المحافظة

- جعل

- يصنع

- القيام ب

- تمكن

- مدير

- كثير

- تجارة

- مباراة

- مطابقة

- رياضي

- أقصى

- مايو..

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- طريقة

- ML

- نموذج

- عارضات ازياء

- الأكثر من ذلك

- أكثر

- كثيرا

- متعدد

- موسيقى

- طبيعي

- معالجة اللغات الطبيعية

- حاجة

- بحاجة

- إحتياجات

- التالي

- لا

- مفكرة

- الآن

- عدد

- of

- عروض

- حاليا

- on

- فقط

- المصدر المفتوح

- المثلى

- or

- أصلي

- أخرى

- لنا

- الناتج

- في الخارج

- الكلي

- الخاصة

- صفقة

- أوراق

- المعلمات

- جزء

- خاص

- pass

- مرت

- يمر

- عاطفي

- نفذ

- خطط

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- الرائج

- منشور

- مدعوم

- قوي

- تنبؤات

- متنبئ

- سابق

- رئيسي

- المشكلة

- مشاكل

- العمليات

- معالجة

- المنتج

- الإنتــاج

- إنتاجية

- ازدهار

- تزود

- المقدمة

- ويوفر

- توفير

- نشرت

- أغراض

- الاستفسارات

- سؤال

- الأسئلة المتكررة

- بسرعة

- نطاق

- بدلا

- نادي القراءة

- استعداد

- حقيقي

- سجل

- تعكس

- المناطق

- ذات الصلة

- مستودع

- التمثيل

- طلب

- بحث

- الباحث

- استجابة

- ردود

- مسؤول

- النتائج

- عائد أعلى

- قوي

- ملكي

- القواعد

- يجري

- sagemaker

- نفسه

- مدخرات

- تحجيم

- سيناريوهات

- علوم

- علوم

- عالم

- بحث

- البحث

- القسم

- أقسام

- انظر تعريف

- رؤية

- مختار

- SELF

- إرسال

- كبير

- تسلسل

- مسلسلات

- السلسلة أ

- الخدمة

- خدماتنا

- طقم

- ينبغي

- إظهار

- أظهرت

- يظهر

- مماثل

- المقاس

- So

- العدالة

- جاليات

- تطبيقات الكمبيوتر

- تطوير البرمجيات

- حل

- حل

- مصادر

- الفضاء

- محدد

- سرعة

- الإنفاق

- بقعة

- معيار

- بدأت

- الولايه او المحافظه

- إحصائي

- خطوة

- خطوات

- لا يزال

- متجر

- تخزين

- إستراتيجي

- الاشتراكات

- هذه

- تموين

- الدعم

- مدعومة

- أخذ

- مهمة

- المهام

- فريق

- التكنولوجيا

- التكنولوجيا

- قالب

- النماذج

- من

- أن

- •

- المنطقة

- المعلومات

- الدولة

- من مشاركة

- منهم

- then

- هناك.

- وبالتالي

- تشبه

- هم

- ثلاثة

- الوقت

- السلاسل الزمنية

- إلى

- سويا

- تيشرت

- قطار

- متدرب

- قادة الإيمان

- تحول

- تحول

- حاول

- اثنان

- التي تقوم عليها

- فريد من نوعه

- جامعة

- حديث جديد

- تحديث

- تحديث

- الأستعمال

- تستخدم

- حالة الاستخدام

- مستعمل

- مستخدم

- المستخدمين

- استخدام

- عادة

- سهل حياتك

- مختلف

- افتراضي

- الجهاز الظاهري

- رؤيتنا

- تريد

- وكان

- طريق..

- طرق

- we

- كان

- ابحث عن

- متى

- التي

- في حين

- من الذى

- ويكيبيديا

- سوف

- مع

- في غضون

- للعمل

- عامل

- سوف

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت