يرشدك هذا المنشور إلى التحديات الأكثر شيوعًا التي يواجهها العملاء عند البحث في المستندات الداخلية، ويمنحك إرشادات ملموسة حول كيفية استخدام خدمات AWS لإنشاء روبوت محادثة مبتكر يعمل بالذكاء الاصطناعي يجعل المعلومات الداخلية أكثر فائدة.

تمثل البيانات غير المنظمة 80٪ من جميع البيانات توجد داخل المؤسسات، وتتكون من مستودعات الأدلة وملفات PDF والأسئلة الشائعة ورسائل البريد الإلكتروني والمستندات الأخرى التي تنمو يوميًا. تعتمد الشركات اليوم على مستودعات متزايدة باستمرار من المعلومات الداخلية، وتنشأ المشاكل عندما يصبح حجم البيانات غير المنظمة غير قابل للإدارة. في كثير من الأحيان، يجد المستخدمون أنفسهم يقرؤون ويتحققون من العديد من المصادر الداخلية المختلفة للعثور على الإجابات التي يحتاجون إليها.

يمكن لمنتديات الأسئلة والأجوبة الداخلية أن تساعد المستخدمين في الحصول على إجابات محددة للغاية ولكنها تتطلب أيضًا أوقات انتظار أطول. في حالة الأسئلة الشائعة الداخلية الخاصة بالشركة، تؤدي أوقات الانتظار الطويلة إلى انخفاض إنتاجية الموظف. يصعب توسيع منتديات الأسئلة والأجوبة لأنها تعتمد على الإجابات المكتوبة يدويًا. مع الذكاء الاصطناعي التوليدي، هناك حاليًا تحول نموذجي في كيفية قيام المستخدمين بالبحث عن المعلومات والعثور عليها. الخطوة المنطقية التالية هي استخدام الذكاء الاصطناعي التوليدي لتكثيف المستندات الكبيرة في معلومات أصغر حجمًا لتسهيل استهلاك المستخدم. بدلاً من قضاء وقت طويل في قراءة النص أو انتظار الإجابات، يمكن للمستخدمين إنشاء ملخصات في الوقت الفعلي استنادًا إلى مستودعات متعددة موجودة من المعلومات الداخلية.

حل نظرة عامة

يسمح الحل للعملاء باسترداد الإجابات المنسقة على الأسئلة المطروحة حول المستندات الداخلية باستخدام نموذج محول لإنشاء إجابات للأسئلة حول البيانات التي لم يتم التدريب عليها، وهي تقنية تُعرف باسم المطالبة الصفرية. ومن خلال اعتماد هذا الحل، يمكن للعملاء الحصول على الفوائد التالية:

- احصل على إجابات دقيقة للأسئلة بناءً على المصادر الموجودة للمستندات الداخلية

- تقليل الوقت الذي يقضيه المستخدمون في البحث عن الإجابات باستخدام نماذج اللغة الكبيرة (LLMs) لتوفير إجابات شبه فورية للاستعلامات المعقدة باستخدام المستندات التي تحتوي على أحدث المعلومات

- ابحث عن الأسئلة التي تم الرد عليها مسبقًا من خلال لوحة معلومات مركزية

- قلل من التوتر الناتج عن قضاء الوقت في قراءة المعلومات يدويًا للبحث عن الإجابات

الجيل المعزز للاسترجاع (RAG)

يعمل الجيل المعزز للاسترجاع (RAG) على تقليل بعض أوجه القصور في الاستعلامات المستندة إلى LLM من خلال العثور على الإجابات من قاعدة المعرفة الخاصة بك واستخدام LLM لتلخيص المستندات في استجابات موجزة. يرجى قراءة هذا بريد.. اعلاني لمعرفة كيفية تنفيذ نهج RAG مع أمازون كندرا. ترتبط المخاطر والقيود التالية بالاستعلامات المستندة إلى LLM والتي يعالجها نهج RAG مع Amazon Kendra:

- الهلوسة وإمكانية التتبع - يتم تدريب LLMS على مجموعات كبيرة من البيانات وإنشاء استجابات على الاحتمالات. وهذا يمكن أن يؤدي إلى إجابات غير دقيقة، والتي تعرف باسم الهلوسة.

- صوامع البيانات المتعددة – من أجل الإشارة إلى البيانات من مصادر متعددة ضمن استجابتك، يحتاج المرء إلى إعداد نظام بيئي للموصل لتجميع البيانات. يعد الوصول إلى مستودعات متعددة أمرًا يدويًا ويستغرق وقتًا طويلاً.

- الأمان - يعد الأمان والخصوصية من الاعتبارات المهمة عند نشر روبوتات المحادثة التي تدعمها RAG وLLMs. على الرغم من استخدام فهم الأمازون لتصفية البيانات الشخصية التي قد يتم تقديمها من خلال استعلامات المستخدم، لا تزال هناك إمكانية لظهور معلومات شخصية أو حساسة عن غير قصد، اعتمادًا على البيانات التي يتم استيعابها. وهذا يعني أن التحكم في الوصول إلى برنامج الدردشة الآلي أمر بالغ الأهمية لمنع الوصول غير المقصود إلى المعلومات الحساسة.

- أهمية البيانات – يتم تدريب LLMS على البيانات حتى تاريخ معين، مما يعني أن المعلومات غالبًا ما تكون غير محدثة. التكلفة المرتبطة بنماذج التدريب على البيانات الحديثة مرتفعة. ولضمان استجابات دقيقة وحديثة، تتحمل المنظمات مسؤولية تحديث وإثراء محتوى الوثائق المفهرسة بشكل منتظم.

- التكلفة – يجب أن تكون التكلفة المرتبطة بنشر هذا الحل أحد الاعتبارات بالنسبة للشركات. تحتاج الشركات إلى تقييم ميزانيتها ومتطلبات الأداء بعناية عند تنفيذ هذا الحل. يمكن أن يتطلب تشغيل LLMs موارد حسابية كبيرة، مما قد يزيد من التكاليف التشغيلية. يمكن أن تصبح هذه التكاليف عائقًا أمام التطبيقات التي تحتاج إلى العمل على نطاق واسع. ومع ذلك، فإن إحدى فوائد أوس الغيمة هي المرونة في الدفع فقط مقابل ما تستخدمه. تقدم AWS نموذج تسعير بسيط ومتسق ونظام الدفع أولاً بأول، بحيث يتم محاسبتك فقط على الموارد التي تستهلكها.

استخدام Amazon SageMaker JumpStart

بالنسبة لنماذج اللغة القائمة على المحولات، يمكن للمؤسسات الاستفادة من استخدامها الأمازون SageMaker JumpStart، الذي يقدم مجموعة من نماذج التعلم الآلي المعدة مسبقًا. يقدم Amazon SageMaker JumpStart مجموعة واسعة من النماذج الأساسية لإنشاء النصوص والإجابة على الأسئلة (Q&A) التي يمكن نشرها واستخدامها بسهولة. يدمج هذا الحل نموذج FLAN T5-XL Amazon SageMaker JumpStart، ولكن هناك جوانب مختلفة يجب وضعها في الاعتبار عند اختيار نموذج الأساس.

دمج الأمن في سير العمل لدينا

باتباع أفضل ممارسات الركيزة الأمنية لـ إطار جيد التصميم, أمازون كوجنيتو يستخدم للمصادقة. يمكن دمج مجمعات مستخدمي Amazon Cognito مع موفري هوية الطرف الثالث الذين يدعمون العديد من أطر العمل المستخدمة للتحكم في الوصول، بما في ذلك التفويض المفتوح (OAuth)، أو OpenID Connect (OIDC)، أو لغة ترميز تأكيد الأمان (SAML). يتيح تحديد المستخدمين وأفعالهم للحل الحفاظ على إمكانية التتبع. يستخدم الحل أيضًا Amazon Comprehend الكشف عن معلومات التعريف الشخصية (PII). ميزة تحديد هوية معلومات تحديد الهوية الشخصية (PII) وتنقيحها تلقائيًا. تشتمل معلومات تحديد الهوية الشخصية (PII) المنقحة على العناوين وأرقام التأمين الاجتماعي وعناوين البريد الإلكتروني والمعلومات الحساسة الأخرى. يضمن هذا التصميم تنقيح أي معلومات تحديد هوية شخصية (PII) يقدمها المستخدم من خلال استعلام الإدخال. لا يتم تخزين معلومات تحديد الهوية الشخصية (PII) أو استخدامها بواسطة Amazon Kendra أو تغذيتها إلى LLM.

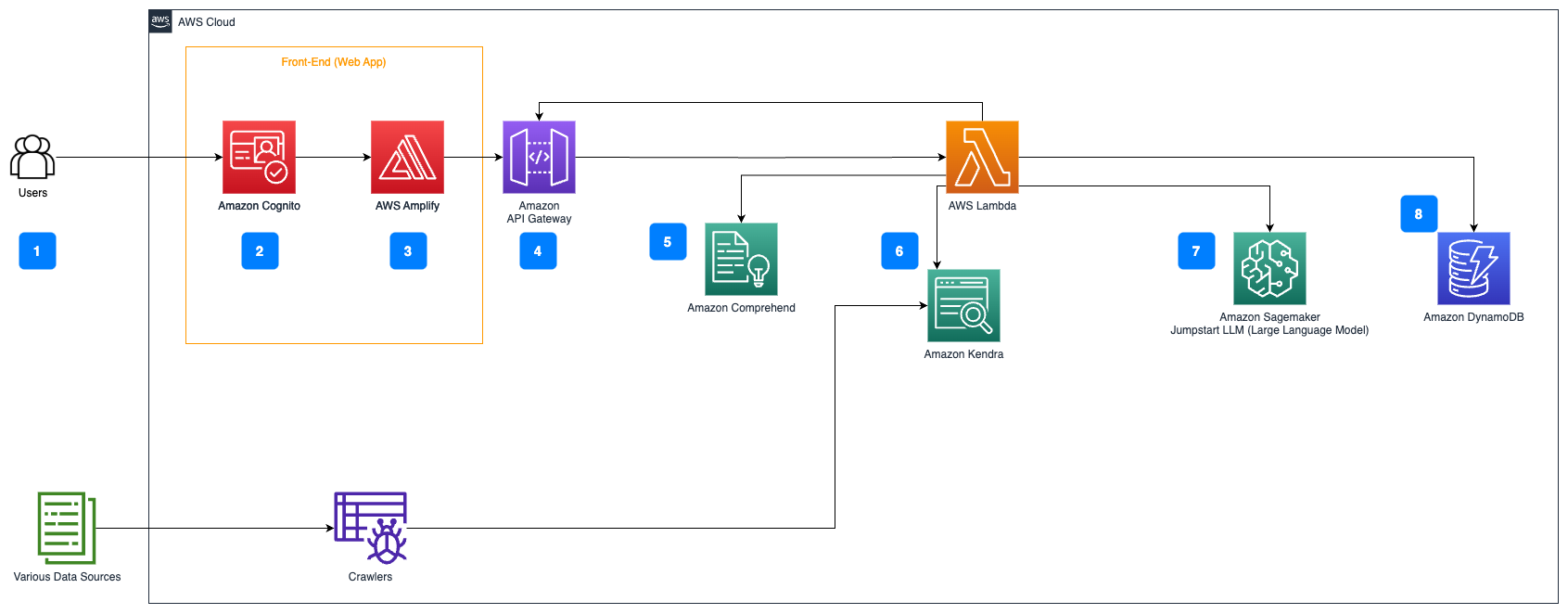

تجول الحل

تصف الخطوات التالية سير عمل الإجابة على السؤال عبر تدفق المستندات:

- يرسل المستخدمون استعلامًا عبر واجهة الويب.

- أمازون كوجنيتو يُستخدم للمصادقة، مما يضمن الوصول الآمن إلى تطبيق الويب.

- تتم استضافة الواجهة الأمامية لتطبيق الويب على تضخيم AWS.

- بوابة أمازون API يستضيف REST API مع نقاط نهاية مختلفة للتعامل مع طلبات المستخدم التي تمت مصادقتها باستخدام Amazon Cognito.

- تنقيح معلومات تحديد الهوية الشخصية (PII) باستخدام فهم الأمازون:

- معالجة استعلام المستخدم: عندما يرسل المستخدم استعلامًا أو إدخالاً، يتم تمريره أولاً عبر Amazon Comprehend. تقوم الخدمة بتحليل النص وتحديد أي كيانات PII موجودة داخل الاستعلام.

- استخراج معلومات تحديد الهوية الشخصية (PII): يقوم Amazon Comprehend باستخراج كيانات معلومات تحديد الهوية الشخصية (PII) المكتشفة من استعلام المستخدم.

- استرجاع المعلومات ذات الصلة مع أمازون كندرا:

- يتم استخدام Amazon Kendra لإدارة فهرس المستندات الذي يحتوي على المعلومات المستخدمة لإنشاء إجابات لاستفسارات المستخدم.

- • استرجاع LangChain ضمان الجودة يتم استخدام الوحدة لإنشاء سلسلة محادثة تحتوي على معلومات ذات صلة حول استفسارات المستخدم.

- التكامل مع أمازون سيج ميكر جومب ستارت:

- تستخدم وظيفة AWS Lambda مكتبة LangChain وتتصل بنقطة نهاية Amazon SageMaker JumpStart من خلال استعلام محشو بالسياق. تعمل نقطة نهاية Amazon SageMaker JumpStart بمثابة واجهة LLM المستخدمة للاستدلال.

- تخزين الاستجابات وإعادتها إلى المستخدم:

- يتم تخزين الاستجابة من LLM في الأمازون DynamoDB جنبًا إلى جنب مع استعلام المستخدم والطابع الزمني والمعرف الفريد والمعرفات العشوائية الأخرى للعنصر مثل فئة السؤال. يتيح تخزين السؤال والإجابة كعناصر منفصلة لوظيفة AWS Lambda إعادة إنشاء سجل محادثات المستخدم بسهولة بناءً على الوقت الذي تم فيه طرح الأسئلة.

- وأخيرًا، يتم إرسال الاستجابة مرة أخرى إلى المستخدم عبر طلب HTTPs من خلال استجابة تكامل Amazon API Gateway REST API.

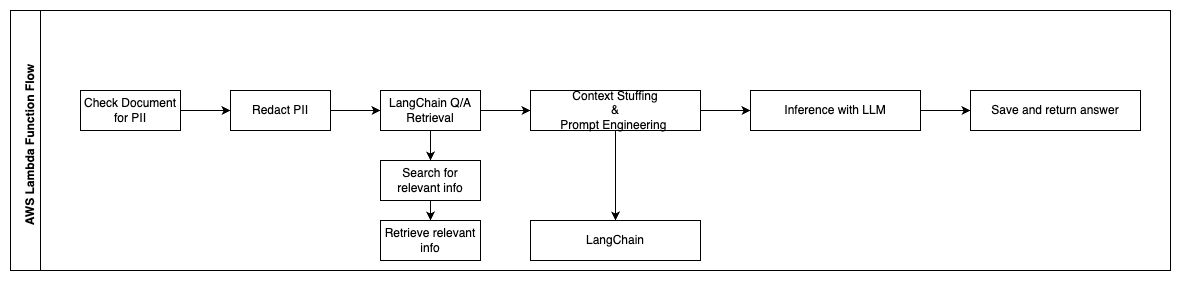

تصف الخطوات التالية وظائف AWS Lambda وتدفقها خلال العملية:

- التحقق من أي معلومات تحديد الهوية الشخصية / المعلومات الحساسة وتنقيحها

- سلسلة استرجاع LangChain QA

- بحث واسترجاع المعلومات ذات الصلة

- حشو السياق والهندسة السريعة

- الاستدلال مع LLM

- رد الرد وحفظه

استخدم حالات

هناك العديد من حالات الاستخدام التجاري حيث يمكن للعملاء استخدام سير العمل هذا. يشرح القسم التالي كيف يمكن استخدام سير العمل في مختلف الصناعات والقطاعات.

مساعدة الموظف

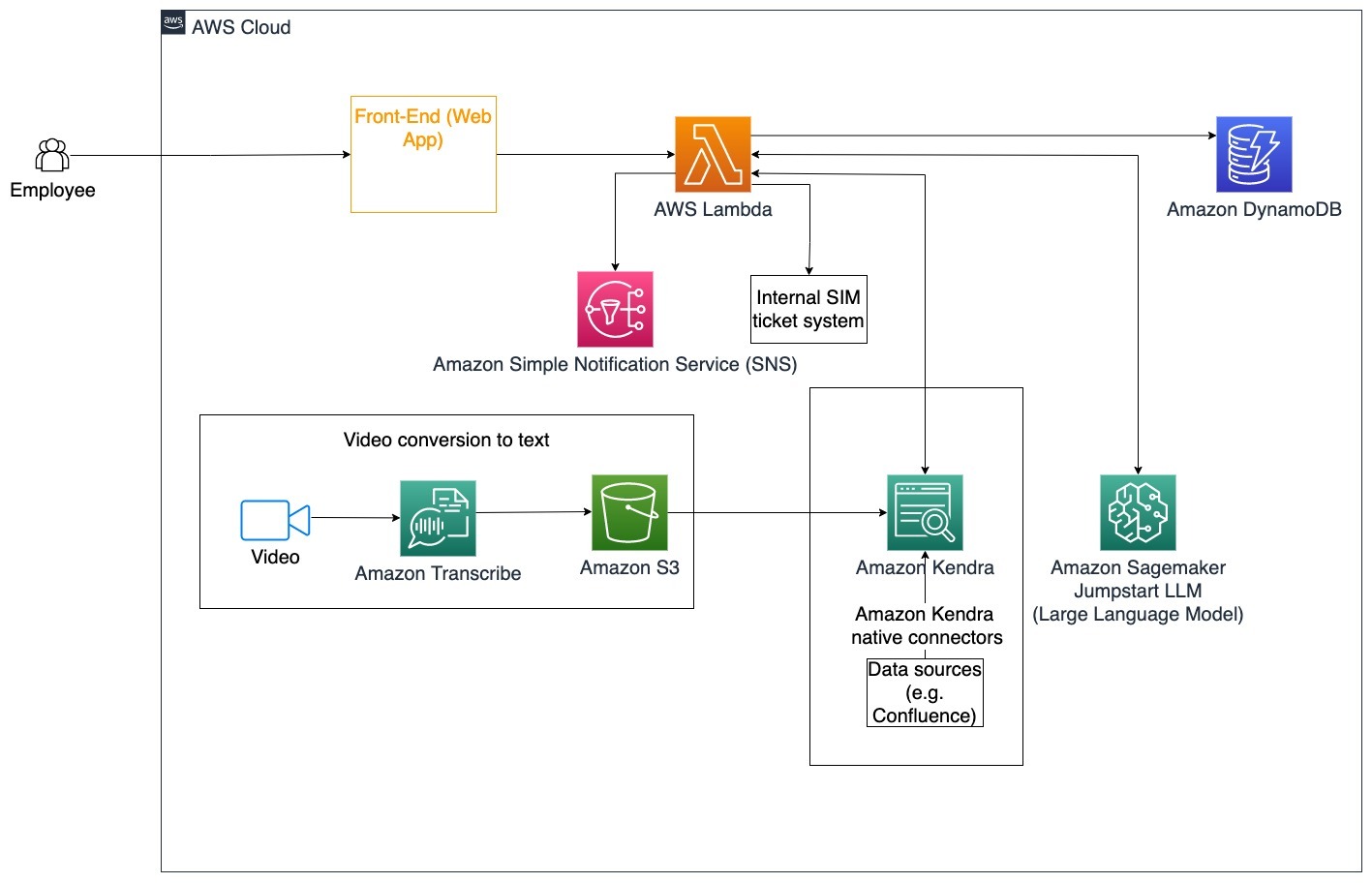

يمكن أن يؤدي التدريب المؤسسي المصمم جيدًا إلى تحسين رضا الموظفين وتقليل الوقت اللازم لتأهيل الموظفين الجدد. مع نمو المؤسسات وزيادة التعقيد، يجد الموظفون صعوبة في فهم المصادر العديدة للمستندات الداخلية. تتضمن المستندات الداخلية في هذا السياق إرشادات الشركة وسياساتها وإجراءات التشغيل القياسية. في هذا السيناريو، يكون لدى الموظف سؤال حول كيفية المتابعة وتحرير تذكرة إصدار التذاكر الداخلية. يمكن للموظف الوصول إلى روبوت المحادثة المولد للذكاء الاصطناعي (AI) واستخدامه لطلب وتنفيذ الخطوات التالية لتذكرة معينة.

حالة الاستخدام المحددة: أتمتة حل المشكلات للموظفين بناءً على إرشادات الشركة.

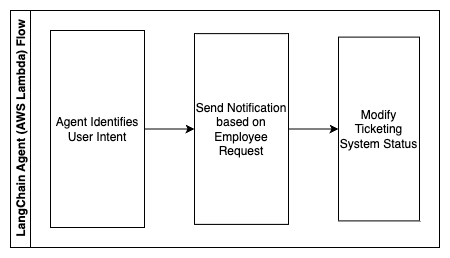

تصف الخطوات التالية وظائف AWS Lambda وتدفقها خلال العملية:

- وكيل LangChain لتحديد النية

- إرسال إشعار بناءً على طلب الموظف

- تعديل حالة التذكرة

في هذا المخطط المعماري، يمكن استيعاب مقاطع الفيديو التدريبية للشركات الأمازون النسخ لجمع سجل من نصوص الفيديو هذه. بالإضافة إلى ذلك، يمكن استخدام محتوى تدريب الشركة المخزن في مصادر مختلفة (على سبيل المثال، Confluence، وMicrosoft SharePoint، وGoogle Drive، وJira، وما إلى ذلك) لإنشاء فهارس من خلال موصلات Amazon Kendra. اقرأ هذه المقالة لمعرفة المزيد عن المجموعة الأصلية موصلات يمكنك الاستفادة من Amazon Kendra كنقطة مصدر. يستطيع زاحف Amazon Kendra بعد ذلك استخدام كل من نصوص الفيديو التدريبية الخاصة بالشركة والوثائق المخزنة في هذه المصادر الأخرى لمساعدة روبوت المحادثة في الإجابة على الأسئلة الخاصة بإرشادات التدريب الخاصة بالشركة. يتحقق وكيل LangChain من الأذونات، ويعدل حالة التذكرة، ويخطر الأفراد المناسبين باستخدام Amazon Simple Notification Service (أمازون SNS).

فرق دعم العملاء

يؤدي حل استفسارات العملاء بسرعة إلى تحسين تجربة العملاء وتشجيع الولاء للعلامة التجارية. تساعد قاعدة العملاء المخلصين على زيادة المبيعات، مما يساهم في تحقيق النتيجة النهائية وزيادة مشاركة العملاء. تنفق فرق دعم العملاء الكثير من الطاقة في الرجوع إلى العديد من المستندات الداخلية وبرامج إدارة علاقات العملاء للإجابة على استفسارات العملاء حول المنتجات والخدمات. يمكن أن تتضمن المستندات الداخلية في هذا السياق البرامج النصية العامة لمكالمات دعم العملاء وأدلة التشغيل وإرشادات التصعيد ومعلومات العمل. يساعد روبوت المحادثة المولد بالذكاء الاصطناعي في تحسين التكلفة لأنه يتعامل مع الاستعلامات نيابة عن فريق دعم العملاء.

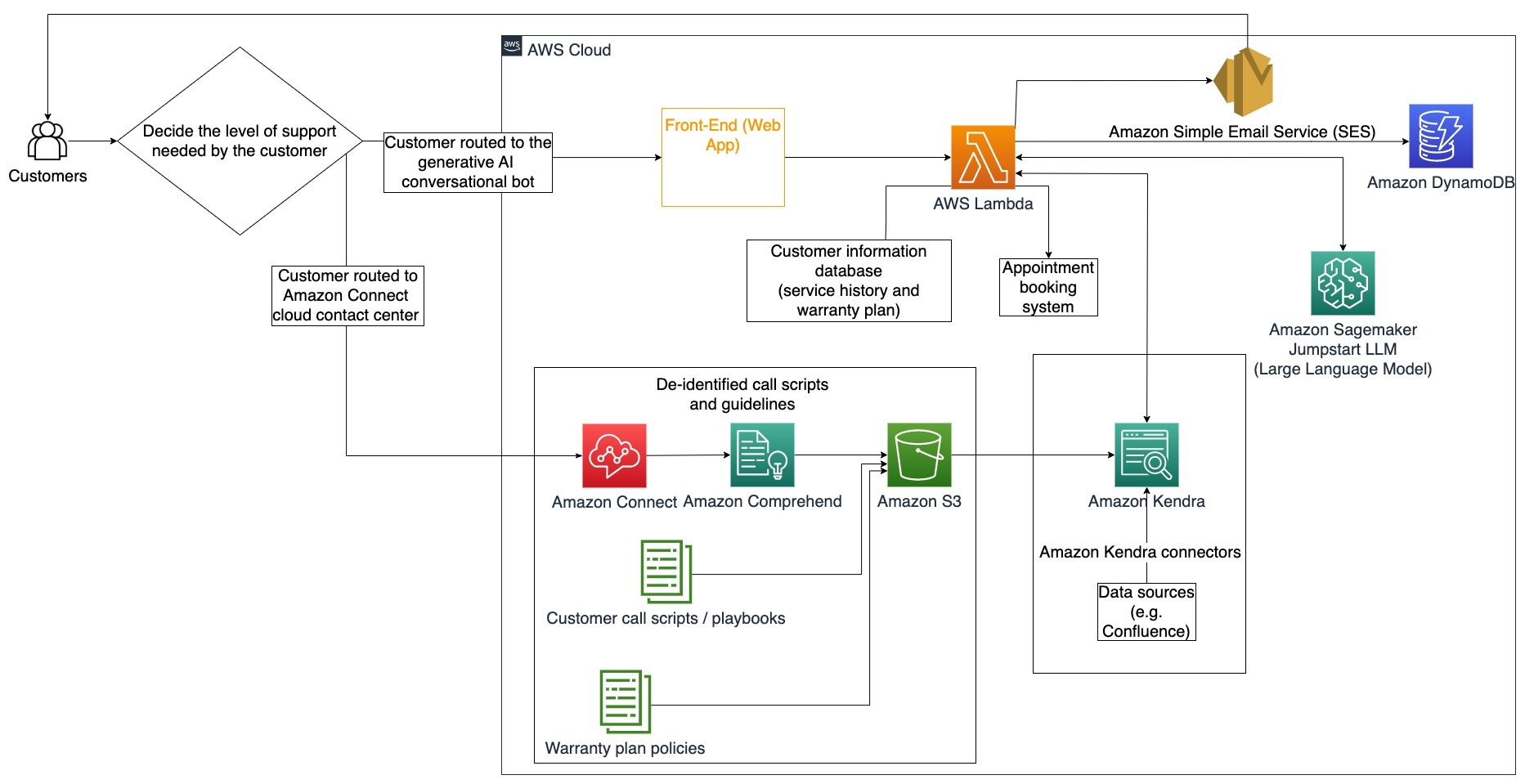

حالة الاستخدام المحددة: التعامل مع طلب تغيير الزيت بناءً على تاريخ الخدمة وخطة خدمة العملاء التي تم شراؤها.

في مخطط البنية هذا، يتم توجيه العميل إما إلى روبوت المحادثة الذي يعمل بالذكاء الاصطناعي أو إلى أمازون كونيكت مركز التواصل. يمكن أن يعتمد هذا القرار على مستوى الدعم المطلوب أو مدى توفر وكلاء دعم العملاء. يحدد وكيل LangChain نية العميل ويتحقق من هويته. يتحقق وكيل LangChain أيضًا من سجل الخدمة وخطة الدعم التي تم شراؤها.

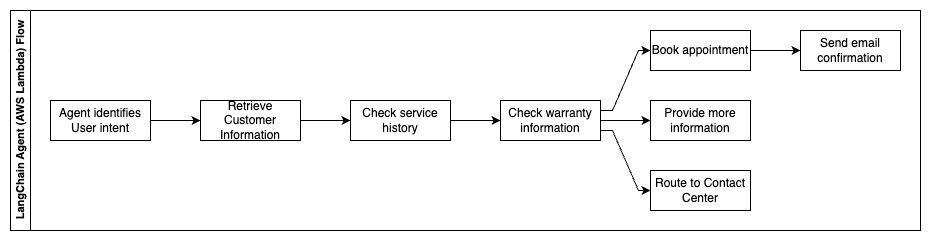

تصف الخطوات التالية وظائف AWS Lambda وتدفقها خلال العملية:

- يحدد وكيل LangChain النية

- استرجاع معلومات العميل

- تحقق من تاريخ خدمة العملاء ومعلومات الضمان

- احجز موعدًا أو قدم المزيد من المعلومات أو الطريق إلى مركز الاتصال

- إرسال تأكيد بالبريد الإلكتروني

يتم استخدام Amazon Connect لجمع سجلات الصوت والدردشة، ويتم استخدام Amazon Comprehend لإزالة معلومات التعريف الشخصية (PII) من هذه السجلات. يستطيع زاحف Amazon Kendra بعد ذلك استخدام سجلات الصوت والدردشة المنقحة والنصوص البرمجية لمكالمات العملاء وسياسات خطة دعم خدمة العملاء لإنشاء الفهرس. بمجرد اتخاذ القرار، يقرر روبوت المحادثة الذي يعمل بالذكاء الاصطناعي ما إذا كان يجب حجز موعد أو تقديم المزيد من المعلومات أو توجيه العميل إلى مركز الاتصال للحصول على مزيد من المساعدة. لتحسين التكلفة، يمكن لوكيل LangChain أيضًا إنشاء إجابات باستخدام عدد أقل من الرموز المميزة ونموذج لغة كبير أقل تكلفة لاستفسارات العملاء ذات الأولوية المنخفضة.

للخدمات المالية

تعتمد شركات الخدمات المالية على استخدام المعلومات في الوقت المناسب للحفاظ على قدرتها التنافسية والامتثال للوائح المالية. باستخدام روبوت محادثة مبتكر يعمل بالذكاء الاصطناعي، يمكن للمحللين والمستشارين الماليين التفاعل مع المعلومات النصية بطريقة محادثة وتقليل الوقت والجهد اللازمين لاتخاذ قرارات مستنيرة بشكل أفضل. وبعيدًا عن الاستثمار وأبحاث السوق، يمكن لروبوت المحادثة المولد بالذكاء الاصطناعي أيضًا تعزيز القدرات البشرية من خلال التعامل مع المهام التي تتطلب تقليديًا المزيد من الجهد البشري والوقت. على سبيل المثال، يمكن لمؤسسة مالية متخصصة في القروض الشخصية زيادة معدل معالجة القروض مع توفير شفافية أفضل للعملاء.

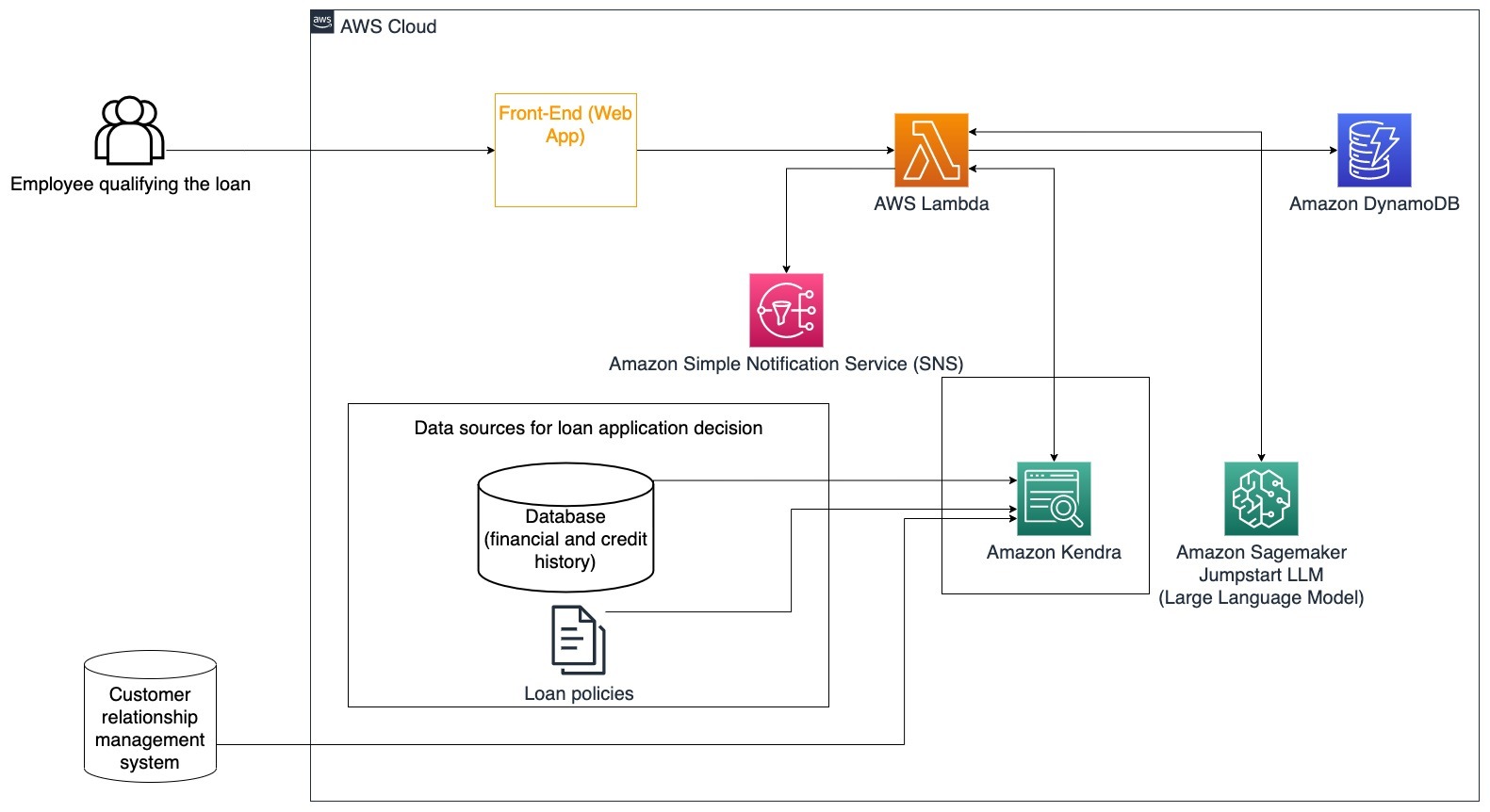

حالة الاستخدام المحددة: استخدم التاريخ المالي للعميل وطلبات القروض السابقة لاتخاذ قرار وشرح قرار القرض.

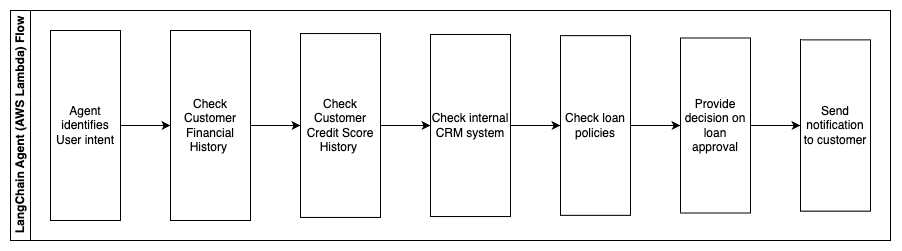

تصف الخطوات التالية وظائف AWS Lambda وتدفقها خلال العملية:

- وكيل LangChain لتحديد النية

- التحقق من التاريخ المالي والائتماني للعميل

- التحقق من نظام إدارة علاقات العملاء الداخلي

- التحقق من سياسات القروض القياسية واقتراح قرار للموظفين المؤهلين للقرض

- إرسال إشعار إلى العميل

تتضمن هذه البنية البيانات المالية للعملاء المخزنة في قاعدة بيانات والبيانات المخزنة في أداة إدارة علاقات العملاء (CRM). يتم استخدام نقاط البيانات هذه لاتخاذ قرار بناءً على سياسات القروض الداخلية للشركة. يستطيع العميل طرح أسئلة توضيحية لفهم القروض التي يحق له الحصول عليها وشروط القروض التي يمكنه قبولها. إذا لم يتمكن روبوت المحادثة القائم على الذكاء الاصطناعي من الموافقة على طلب القرض، فلا يزال بإمكان المستخدم طرح أسئلة حول تحسين درجات الائتمان أو خيارات التمويل البديلة.

حكومة

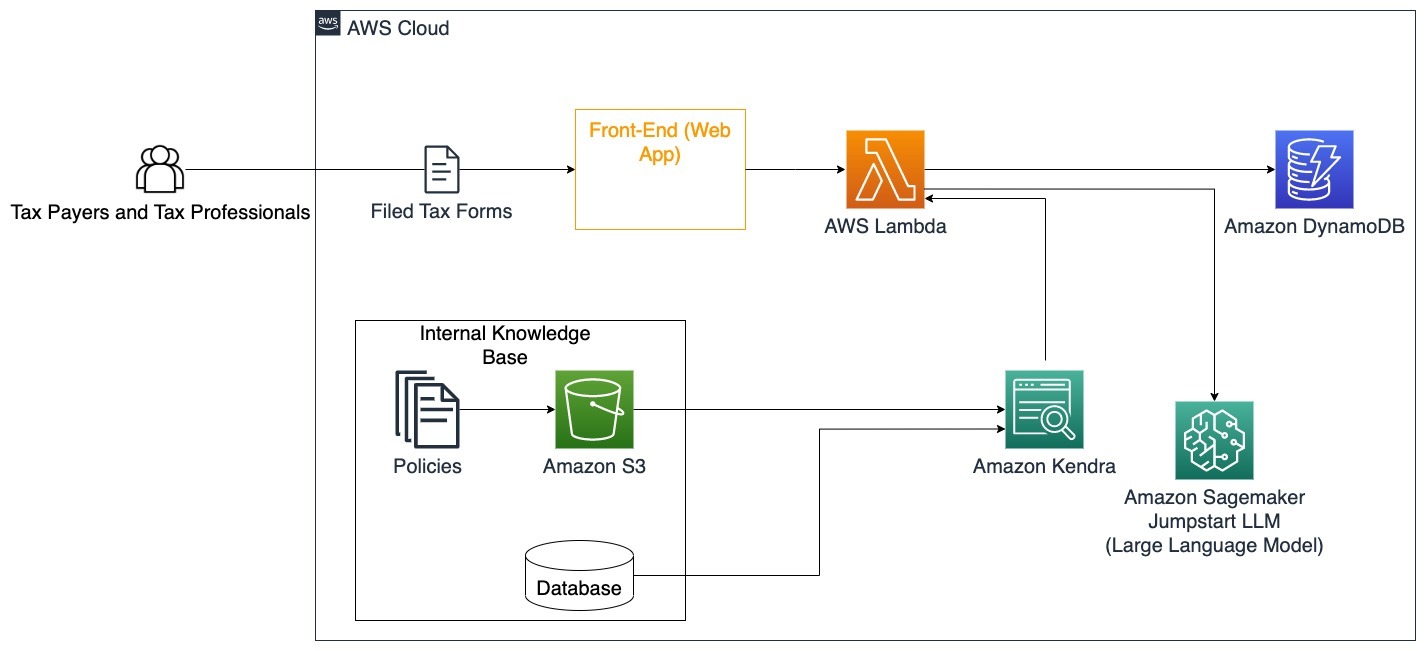

يمكن لروبوتات المحادثة المولدة بالذكاء الاصطناعي أن تفيد المؤسسات الحكومية بشكل كبير من خلال تسريع عمليات الاتصال والكفاءة وصنع القرار. يمكن لروبوتات المحادثة التوليدية المعتمدة على الذكاء الاصطناعي أيضًا توفير إمكانية الوصول الفوري إلى قواعد المعرفة الداخلية لمساعدة الموظفين الحكوميين على استرداد المعلومات والسياسات والإجراءات بسرعة (على سبيل المثال، معايير الأهلية وعمليات التقديم وخدمات المواطنين ودعمهم). أحد الحلول هو النظام التفاعلي، الذي يسمح لدافعي الضرائب ومحترفي الضرائب بالعثور بسهولة على التفاصيل والمزايا المتعلقة بالضرائب. ويمكن استخدامه لفهم أسئلة المستخدم وتلخيص المستندات الضريبية وتقديم إجابات واضحة من خلال المحادثات التفاعلية.

يمكن للمستخدمين طرح أسئلة مثل:

- كيف تعمل ضريبة الميراث وما هي العتبات الضريبية؟

- هل يمكنك شرح مفهوم ضريبة الدخل؟

- ما هي الآثار الضريبية عند بيع عقار ثان؟

بالإضافة إلى ذلك، يمكن للمستخدمين الاستمتاع بإرسال النماذج الضريبية إلى النظام، مما يمكن أن يساعد في التحقق من صحة المعلومات المقدمة.

توضح هذه البنية كيف يمكن للمستخدمين تحميل النماذج الضريبية المكتملة إلى الحل واستخدامها للتحقق التفاعلي والتوجيه حول كيفية إكمال المعلومات الضرورية بدقة.

الرعاية الصحية

تتمتع شركات الرعاية الصحية بفرصة أتمتة استخدام كميات كبيرة من معلومات المرضى الداخلية، مع معالجة الأسئلة الشائعة المتعلقة بحالات الاستخدام مثل خيارات العلاج ومطالبات التأمين والتجارب السريرية والأبحاث الصيدلانية. يتيح استخدام روبوت المحادثة الذي يعمل بالذكاء الاصطناعي توليد إجابات سريعة ودقيقة حول المعلومات الصحية من قاعدة المعرفة المتوفرة. على سبيل المثال، يقضي بعض المتخصصين في الرعاية الصحية الكثير من الوقت في ملء النماذج لتقديم مطالبات التأمين.

وفي بيئات مماثلة، يحتاج مديرو التجارب السريرية والباحثون إلى العثور على معلومات حول خيارات العلاج. يمكن لروبوت المحادثة القائم على الذكاء الاصطناعي استخدام الموصلات المعدة مسبقًا في Amazon Kendra لاسترداد المعلومات الأكثر صلة من ملايين المستندات المنشورة من خلال الأبحاث المستمرة التي تجريها شركات الأدوية والجامعات.

حالة الاستخدام المحددة: تقليل الأخطاء والوقت اللازم لملء وإرسال نماذج التأمين.

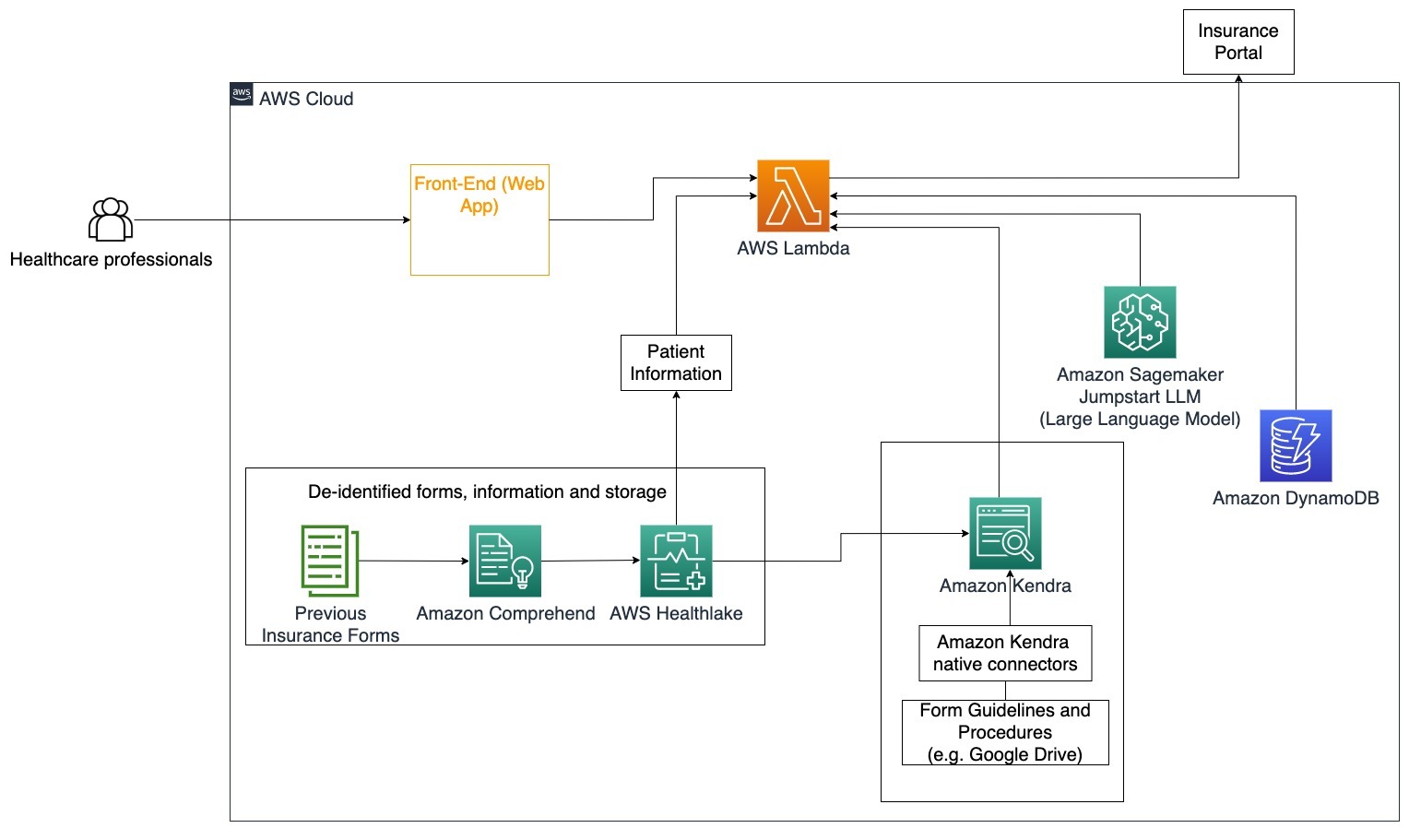

في هذا المخطط الهندسي، يستطيع أخصائي الرعاية الصحية استخدام روبوت المحادثة المولد بالذكاء الاصطناعي لمعرفة النماذج التي يجب ملؤها للتأمين. يستطيع وكيل LangChain بعد ذلك استرداد النماذج الصحيحة وإضافة المعلومات المطلوبة للمريض بالإضافة إلى تقديم ردود على الأجزاء الوصفية من النماذج بناءً على وثائق التأمين والنماذج السابقة. يمكن لأخصائي الرعاية الصحية تعديل الردود المقدمة من LLM قبل الموافقة على النموذج وتسليمه إلى بوابة التأمين.

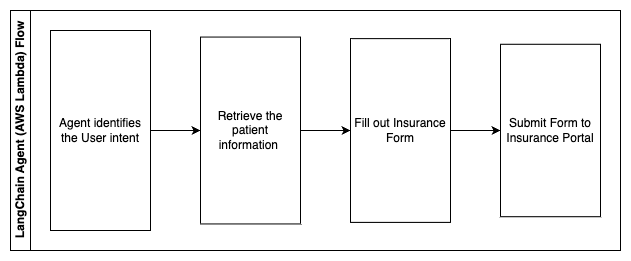

تصف الخطوات التالية وظائف AWS Lambda وتدفقها خلال العملية:

- وكيل LangChain لتحديد النية

- استرجاع معلومات المريض المطلوبة

- قم بتعبئة نموذج التأمين بناءً على معلومات المريض وإرشادات النموذج

- إرسال النموذج إلى بوابة التأمين بعد موافقة المستخدم

أوس هيلث ليك يتم استخدامه لتخزين البيانات الصحية بشكل آمن بما في ذلك نماذج التأمين السابقة ومعلومات المريض، ويتم استخدام Amazon Comprehend لإزالة معلومات التعريف الشخصية (PII) من نماذج التأمين السابقة. يستطيع زاحف Amazon Kendra بعد ذلك استخدام مجموعة نماذج التأمين والإرشادات لإنشاء الفهرس. بمجرد ملء النموذج (النماذج) بواسطة الذكاء الاصطناعي التوليدي، يمكن إرسال النموذج (النماذج) الذي راجعه المحترف الطبي إلى بوابة التأمين.

تقدير التكلفة

يتم عرض تكلفة نشر الحل الأساسي كإثبات للمفهوم في الجدول التالي. نظرًا لأن الحل الأساسي يعتبر إثباتًا للمفهوم، فقد تم استخدام Amazon Kendra Developer Edition كخيار منخفض التكلفة نظرًا لأن عبء العمل لن يكون في مرحلة الإنتاج. كان افتراضنا لإصدار Amazon Kendra Developer Edition هو 730 ساعة نشطة خلال الشهر.

بالنسبة إلى Amazon SageMaker، افترضنا أن العميل سيستخدم مثيل ml.g4dn.2xlarge للاستدلال في الوقت الفعلي، مع نقطة نهاية استدلال واحدة لكل مثيل. يمكنك العثور على مزيد من المعلومات حول تسعير Amazon SageMaker وأنواع مثيلات الاستدلال المتاحة هنا.

| العطاء | الموارد المستهلكة | تقدير التكلفة لكل شهر بالدولار الأمريكي |

| تضخيم AWS | 150 دقيقة بناء 1 جيجابايت من البيانات المقدمة 500,000 طلبات |

15.71 |

| بوابة أمازون API | 1M استدعاءات REST API | 3.5 |

| AWS لامدا | 1 مليون طلب مدة 5 ثواني لكل طلب الذاكرة المخصصة 2 جيجا بايت |

160.23 |

| الأمازون DynamoDB | 1 مليون قراءة 1 مليون يكتب تخزين 100 GB |

26.38 |

| أمازون ساجيماكر | الاستدلال في الوقت الحقيقي باستخدام ml.g4dn.2xlarge | 676.8 |

| أمازون كندرا | إصدار المطور مع 730 ساعة / شهر تم مسح 10,000 مستند ضوئيًا 5,000 استفسار / يوم |

821.25 |

| . | . | التكلفة الإجمالية: 1703.87 |

* يحتوي Amazon Cognito على طبقة مجانية مكونة من 50,000 مستخدم نشط شهريًا يستخدمون مجمعات مستخدمي Cognito أو 50 مستخدمًا نشطًا شهريًا يستخدمون موفري هوية SAML 2.0

تنظيف

لتوفير التكاليف، احذف جميع الموارد التي قمت بنشرها كجزء من البرنامج التعليمي. يمكنك حذف أي نقاط نهاية SageMaker قد تكون قمت بإنشائها عبر وحدة تحكم SageMaker. تذكر أن حذف فهرس Amazon Kendra لا يؤدي إلى إزالة المستندات الأصلية من مساحة التخزين لديك.

وفي الختام

في هذا المنشور، أوضحنا لك كيفية تبسيط الوصول إلى المعلومات الداخلية عن طريق تلخيصها من مستودعات متعددة في الوقت الفعلي. بعد التطورات الأخيرة في ماجستير إدارة الأعمال المتاحة تجاريًا، أصبحت إمكانيات الذكاء الاصطناعي التوليدي أكثر وضوحًا. في هذا المنشور، عرضنا طرقًا لاستخدام خدمات AWS لإنشاء روبوت محادثة بدون خادم يستخدم الذكاء الاصطناعي التوليدي للإجابة على الأسئلة. يتضمن هذا الأسلوب طبقة مصادقة واكتشاف معلومات تحديد الهوية الشخصية (PII) من Amazon Comprehend لتصفية أي معلومات حساسة مقدمة في استعلام المستخدم. سواء أكان الأمر يتعلق بالأفراد في مجال الرعاية الصحية الذين يفهمون الفروق الدقيقة في تقديم مطالبات التأمين أو فهم الموارد البشرية للوائح محددة على مستوى الشركة، فهناك العديد من الصناعات والقطاعات التي يمكن أن تستفيد من هذا النهج. يعد النموذج الأساسي لـ Amazon SageMaker JumpStart هو المحرك وراء برنامج الدردشة الآلي، في حين يتم استخدام نهج حشو السياق باستخدام تقنية RAG لضمان أن الاستجابات تشير إلى المستندات الداخلية بشكل أكثر دقة.

لمعرفة المزيد حول العمل مع الذكاء الاصطناعي التوليدي على AWS، راجع الإعلان عن أدوات جديدة للبناء باستخدام الذكاء الاصطناعي التوليدي على AWS. لمزيد من الإرشادات المتعمقة حول استخدام تقنية RAG مع خدمات AWS، راجع أنشئ تطبيقات ذكاء اصطناعي توليدية عالية الدقة بسرعة على بيانات المؤسسة باستخدام Amazon Kendra و LangChain ونماذج اللغات الكبيرة. نظرًا لأن النهج المتبع في هذه المدونة لا يعتمد على LLM، فيمكن استخدام أي LLM للاستدلال. في منشورنا التالي، سنوضح طرق تنفيذ هذا الحل باستخدام Amazon Bedrock وAmazon Titan LLM.

حول المؤلف

ابهيشيك ماليجهالي شيفالينجايا هو أحد كبار مهندسي حلول خدمات الذكاء الاصطناعي في AWS. وهو شغوف ببناء التطبيقات باستخدام Geneative AI وAmazon Kendra وNLP. يتمتع بخبرة تبلغ حوالي 10 سنوات في بناء حلول البيانات والذكاء الاصطناعي لخلق قيمة للعملاء والشركات. حتى أنه قام ببناء برنامج دردشة (شخصي) من أجل المتعة للإجابة على الأسئلة المتعلقة بمسيرته المهنية ورحلته المهنية. خارج العمل، يستمتع برسم صور للعائلة والأصدقاء، ويحب إنشاء الأعمال الفنية.

ابهيشيك ماليجهالي شيفالينجايا هو أحد كبار مهندسي حلول خدمات الذكاء الاصطناعي في AWS. وهو شغوف ببناء التطبيقات باستخدام Geneative AI وAmazon Kendra وNLP. يتمتع بخبرة تبلغ حوالي 10 سنوات في بناء حلول البيانات والذكاء الاصطناعي لخلق قيمة للعملاء والشركات. حتى أنه قام ببناء برنامج دردشة (شخصي) من أجل المتعة للإجابة على الأسئلة المتعلقة بمسيرته المهنية ورحلته المهنية. خارج العمل، يستمتع برسم صور للعائلة والأصدقاء، ويحب إنشاء الأعمال الفنية.

مدحة آية هو مهندس حلول مشارك في AWS، ومقره في أوستن، تكساس. تخرجت مؤخرًا من جامعة تكساس في دالاس في ديسمبر 2022 بدرجة الماجستير في علوم الكمبيوتر مع تخصص في الأنظمة الذكية مع التركيز على الذكاء الاصطناعي/التعلم الآلي. إنها مهتمة بمعرفة المزيد عن الذكاء الاصطناعي/التعلم الآلي واستخدام خدمات AWS لاكتشاف الحلول التي يمكن للعملاء الاستفادة منها.

مدحة آية هو مهندس حلول مشارك في AWS، ومقره في أوستن، تكساس. تخرجت مؤخرًا من جامعة تكساس في دالاس في ديسمبر 2022 بدرجة الماجستير في علوم الكمبيوتر مع تخصص في الأنظمة الذكية مع التركيز على الذكاء الاصطناعي/التعلم الآلي. إنها مهتمة بمعرفة المزيد عن الذكاء الاصطناعي/التعلم الآلي واستخدام خدمات AWS لاكتشاف الحلول التي يمكن للعملاء الاستفادة منها.

هوغو تسي هو مهندس حلول مشارك في AWS ومقره في سياتل، واشنطن. وهو حاصل على درجة الماجستير في تكنولوجيا المعلومات من جامعة ولاية أريزونا ودرجة البكالوريوس في الاقتصاد من جامعة شيكاغو. وهو عضو في جمعية تدقيق ومراقبة نظم المعلومات (ISACA) والاتحاد الدولي لإصدار شهادات أمن نظام المعلومات (ISC)2. إنه يستمتع بمساعدة العملاء على الاستفادة من التكنولوجيا.

هوغو تسي هو مهندس حلول مشارك في AWS ومقره في سياتل، واشنطن. وهو حاصل على درجة الماجستير في تكنولوجيا المعلومات من جامعة ولاية أريزونا ودرجة البكالوريوس في الاقتصاد من جامعة شيكاغو. وهو عضو في جمعية تدقيق ومراقبة نظم المعلومات (ISACA) والاتحاد الدولي لإصدار شهادات أمن نظام المعلومات (ISC)2. إنه يستمتع بمساعدة العملاء على الاستفادة من التكنولوجيا.

أيمن ايشيموي هو مهندس حلول مشارك في AWS ومقره في سياتل، واشنطن. حصل على درجة الماجستير في هندسة البرمجيات وتكنولوجيا المعلومات من جامعة أوكلاند. لديه خبرة سابقة في تطوير البرمجيات، وتحديداً في بناء الخدمات المصغرة لتطبيقات الويب الموزعة. إنه متحمس لمساعدة العملاء على بناء حلول قوية وقابلة للتطوير على خدمات AWS السحابية باتباع أفضل الممارسات.

أيمن ايشيموي هو مهندس حلول مشارك في AWS ومقره في سياتل، واشنطن. حصل على درجة الماجستير في هندسة البرمجيات وتكنولوجيا المعلومات من جامعة أوكلاند. لديه خبرة سابقة في تطوير البرمجيات، وتحديداً في بناء الخدمات المصغرة لتطبيقات الويب الموزعة. إنه متحمس لمساعدة العملاء على بناء حلول قوية وقابلة للتطوير على خدمات AWS السحابية باتباع أفضل الممارسات.

شيرفين سوريش هو مهندس حلول مشارك في AWS ومقره في أوستن، تكساس. حصل على درجة الماجستير في هندسة البرمجيات مع التركيز على الحوسبة السحابية والمحاكاة الافتراضية وبكالوريوس في هندسة الكمبيوتر من جامعة ولاية سان خوسيه. إنه متحمس للاستفادة من التكنولوجيا للمساعدة في تحسين حياة الناس من جميع الخلفيات.

شيرفين سوريش هو مهندس حلول مشارك في AWS ومقره في أوستن، تكساس. حصل على درجة الماجستير في هندسة البرمجيات مع التركيز على الحوسبة السحابية والمحاكاة الافتراضية وبكالوريوس في هندسة الكمبيوتر من جامعة ولاية سان خوسيه. إنه متحمس للاستفادة من التكنولوجيا للمساعدة في تحسين حياة الناس من جميع الخلفيات.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- تشارت بريم. ارفع مستوى لعبة التداول الخاصة بك مع ChartPrime. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :لديها

- :يكون

- :ليس

- :أين

- $ UP

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- ماهرون

- من نحن

- استمر

- الوصول

- الوصول

- الحسابات

- دقيق

- بدقة

- الإجراءات

- نشط

- تضيف

- وبالإضافة إلى ذلك

- عناوين

- معالجة

- الإداريين

- اعتماد

- المستشارين

- بعد

- الوكيل

- عملاء

- مجموع

- AI

- خدمات الذكاء الاصطناعي

- AI / ML

- الكل

- يسمح

- على طول

- أيضا

- البديل

- أمازون

- بوابة أمازون API

- أمازون كوجنيتو

- فهم الأمازون

- أمازون كندرا

- الأمازون SageMaker

- أمازون سيج ميكر جومب ستارت

- أمازون ويب سيرفيسز

- كمية

- المبالغ

- an

- المحللين

- تحليل

- و

- إجابة

- الأجوبة

- أي وقت

- API

- واضح

- تطبيق

- التطبيقات

- موعد

- نهج

- الموافقة على

- هندسة معمارية

- هي

- تنشأ

- أريزونا

- حول

- البند

- مصطنع

- الذكاء الاصطناعي

- الذكاء الاصطناعي (منظمة العفو الدولية)

- الأعمال الفنية

- AS

- تطلب

- الجوانب

- تقييم

- مساعدة

- مساعدة

- محام

- أسوشيتد

- جمعية

- افتراض

- At

- التدقيق

- المعزز

- أوستن

- موثق

- التحقّق من المُستخدم

- ترخيص

- أتمتة

- تلقائيا

- توفر

- متاح

- AWS

- AWS لامدا

- الى الخلف

- خلفيات

- قاعدة

- على أساس

- BE

- دب

- لان

- أصبح

- يصبح

- كان

- قبل

- باسمى او لاجلى

- وراء

- تستفيد

- الفوائد

- أفضل

- أفضل الممارسات

- أفضل

- المدونة

- كتاب

- أحذية طويلة

- على حد سواء

- البوتات

- الملابس السفلية

- العلامة تجارية

- ميزانية

- نساعدك في بناء

- ابني

- بنيت

- الأعمال

- الأعمال

- لكن

- by

- دعوة

- CAN

- قدرات

- التوظيف

- بعناية

- حقيبة

- الحالات

- الفئة

- تسبب

- مركز

- مركزية

- معين

- الشهادات

- سلسلة

- التحديات

- تغيير

- متهم

- chatbot

- تدقيق

- الشيكات

- شيكاغو

- مطالبات

- واضح

- سريري

- التجارب السريرية

- سحابة

- الحوسبة السحابية

- الخدمات السحابية

- جمع

- مجموعة شتاء XNUMX

- تجاريا

- مشترك

- Communication

- الشركات

- حول الشركة

- الشركة

- تنافسي

- الطلب مكتمل

- الانتهاء

- مجمع

- تعقيد

- الامتثال

- فهم

- الكمبيوتر

- هندسة الكمبيوتر

- علوم الكمبيوتر

- الحوسبة

- من التركيز

- مفهوم

- مختصرا

- أجرت

- احتشاد

- التواصل

- يربط

- نظر

- الاعتبارات

- نظرت

- ثابتة

- تتكون

- كنسولات

- جمعية

- تستهلك

- استهلاك

- التواصل

- مركز الاتصال

- يحتوي

- محتوى

- سياق الكلام

- بشكل متواصل

- يساهم

- مراقبة

- السيطرة

- ملاءمة

- محادثة

- تحادثي

- المحادثات

- منظمة

- تصحيح

- التكلفة

- التكاليف

- الزاحف

- خلق

- خلق القيمة

- خلق

- خلق

- ائتمان

- المعايير

- حرج

- CRM

- حاسم

- من تنسيق

- حالياًّ

- حاليا

- زبون

- إشراك العملاء

- تجربة العملاء

- خدمة العملاء

- دعم العملاء

- العملاء

- يوميا

- دالاس

- البيانات

- نقاط البيانات

- مجموعات البيانات

- قاعدة البيانات

- التاريخ

- ديسمبر

- تقرر

- القرار

- اتخاذ القرار

- القرارات

- الدرجة العلمية

- تم التوصيل

- اعتمادا

- نشر

- نشر

- وصف

- تصميم

- على الرغم من

- تفاصيل

- الكشف عن

- كشف

- المطور

- التطوير التجاري

- التطورات

- مختلف

- صعبة

- اكتشف

- وزعت

- توثيق

- وثائق

- هل

- لا

- قيادة

- مدة الأقامة

- e

- أسهل

- بسهولة

- الاقتصاد - Economics

- النظام الإيكولوجي

- طبعة

- كفاءة

- جهد

- إما

- جدارة

- البريد الإلكتروني

- رسائل البريد الإلكتروني

- موظف

- الموظفين

- تمكن

- يشجع

- نقطة النهاية

- طاقة

- اشتباك

- محرك

- الهندسة

- إثراء

- ضمان

- يضمن

- ضمان

- مشروع

- الشركات

- الكيانات

- أخطاء

- التصعيد

- تقدير

- إلخ

- حتى

- مثال

- تنفيذ

- القائمة

- ذو تكلفة باهظة

- الخبره في مجال الغطس

- شرح

- ويوضح

- استخلاص

- مقتطفات

- الوجه

- للعائلات

- الميزات

- بنك الاحتياطي الفيدرالي

- أقل

- الشكل

- قم بتقديم

- شغل

- معبأ

- حشوة

- تصفية

- مالي

- البيانات المالية

- التاريخ المالي

- مؤسسة مالية

- التمويل

- العثور على

- الاسم الأول

- مرونة

- تدفق

- التركيز

- متابعيك

- في حالة

- النموذج المرفق

- أشكال

- المنتديات

- وجدت

- دورة تأسيسية

- الأطر

- مجانا

- الاصدقاء

- تبدأ من

- مرح

- وظيفة

- وظائف

- إضافي

- ربح

- بوابة

- توليد

- جيل

- توليدي

- الذكاء الاصطناعي التوليدي

- دولار فقط واحصل على خصم XNUMX% على جميع

- معطى

- يعطي

- إعطاء

- شراء مراجعات جوجل

- حكومة

- جدا

- النمو

- متزايد

- ينمو

- توجيه

- المبادئ التوجيهية

- مقبض

- مقابض

- معالجة

- يملك

- وجود

- he

- صحة الإنسان

- معلومات صحية

- الرعاية الصحية

- مساعدة

- مساعدة

- يساعد

- لها

- مرتفع

- جدا

- له

- تاريخ

- يحمل

- استضافت

- المضيفين

- ساعات العمل

- كيفية

- كيفية

- لكن

- hr

- HTML

- HTTPS

- الانسان

- i

- معرف

- معرفات

- يحدد

- تحديد

- تحديد

- هوية

- if

- يوضح

- تنفيذ

- تحقيق

- آثار

- تحسن

- يحسن

- تحسين

- in

- في العمق

- غير دقيق

- تتضمن

- يشمل

- بما فيه

- دخل

- ضريبة الدخل

- القيمة الاسمية

- الزيادات

- مؤشر

- مفهرس

- الفهارس

- الأفراد

- الصناعات

- إعلام

- معلومات

- نظم المعلومات

- تكنولوجيا المعلومات

- وأبلغ

- وراثة

- إدخال

- مثل

- لحظة

- بدلًا من ذلك

- مؤسسة

- المؤسسات

- التأمين

- المتكاملة

- يدمج

- التكامل

- رؤيتنا

- ذكي

- نية

- تفاعل

- التفاعلية

- يستفد

- السطح البيني

- داخلي

- عالميا

- إلى

- استثمار

- قضية

- IT

- العناصر

- رحلة

- JPG

- احتفظ

- المعرفة

- معروف

- لغة

- كبير

- طبقة

- قيادة

- تعلم

- تعلم

- أقل

- مستوى

- الاستفادة من

- المكتبة

- تحديد

- القيود

- خط

- حياة

- LLM

- قرض

- القروض

- سجل

- منطقي

- طويل

- وقت طويل

- يعد

- بحث

- الكثير

- يحب

- منخفضة التكلفة

- خفض

- مخلص

- الوفاء

- آلة

- آلة التعلم

- صنع

- المحافظة

- جعل

- يصنع

- القيام ب

- إدارة

- إدارة

- أسلوب

- كتيب

- يدويا

- كثير

- تجارة

- أبحاث السوق

- سادة

- مايو..

- يعني

- طبي

- عضو

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- microservices

- مایکروسافت

- مليون

- ملايين

- مانع

- ML

- نموذج

- عارضات ازياء

- وحدة

- شهر

- شهريا

- الأكثر من ذلك

- أكثر

- متعدد

- محلي

- ضروري

- حاجة

- بحاجة

- إحتياجات

- جديد

- التالي

- البرمجة اللغوية العصبية

- إعلام

- أرقام

- اوكلاند

- أوث

- of

- عروض

- غالبا

- زيت

- on

- التأهيل ل

- مرة

- ONE

- جارية

- فقط

- جاكيت

- طريقة التوسع

- تعمل

- تشغيل

- الفرصة

- التحسين

- خيار

- مزيد من الخيارات

- or

- طلب

- المنظمات

- أصلي

- أخرى

- لنا

- خارج

- الخطوط العريضة

- في الخارج

- على مدى

- نموذج

- جزء

- أجزاء

- مرت

- عاطفي

- المريض

- مجتمع

- إلى

- أداء

- أذونات

- الشخصية

- البيانات الشخصية

- شخصيا

- الأدوية

- دعامة

- خطة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- من فضلك

- البوينت

- نقاط

- سياسات الخصوصية والبيع

- حمامات

- بوابة

- صور

- إمكانيات

- إمكانية

- منشور

- مدعوم

- الممارسات

- يقدم

- منع

- سابق

- سابقا

- التسعير

- نماذج الاسعار

- قبل

- الأولوية

- خصوصية

- مشاكل

- الإجراءات

- والمضي قدما

- عملية المعالجة

- معالجتها

- العمليات

- معالجة

- الإنتــاج

- إنتاجية

- المنتجات

- محترف

- المهنيين

- الملكية

- تزود

- المقدمة

- مقدمي

- توفير

- نشرت

- شراء

- سؤال وجواب

- التأهل

- التصفيات

- الاستفسارات

- سؤال

- الأسئلة المتكررة

- سريع

- بسرعة

- نطاق

- معدل

- عرض

- نادي القراءة

- في الوقت الحقيقي

- الأخيرة

- مؤخرا

- تخفيض

- يقلل

- الرجوع

- الرجوع

- بخصوص

- بانتظام

- قوانين

- صلة

- مدى صلة

- ذات الصلة

- اعتمد

- بقايا

- تذكر

- إزالة

- طلب

- طلبات

- تطلب

- مطلوب

- المتطلبات الأساسية

- بحث

- الباحثين

- دقة الشاشة

- حل

- الموارد

- استجابة

- ردود

- مسؤولية

- REST

- نتيجة

- عودة

- استعرض

- حق

- المخاطر

- قوي

- طريق

- تشغيل

- s

- sagemaker

- الأملاح

- سان

- سان خوسيه

- رضا

- حفظ

- تحجيم

- حجم

- سيناريو

- علوم

- أحرز هدفاً

- مخطوطات

- بحث

- البحث

- سياتل

- الثاني

- ثواني

- القسم

- تأمين

- آمن

- أمن

- بيع

- إرسال

- كبير

- حساس

- أرسلت

- Serverless

- يخدم

- الخدمة

- خدماتنا

- طقم

- باكجات

- إعدادات

- عدة

- هي

- نقل

- نقائص

- ينبغي

- عرضت

- أظهرت

- أظهرت

- الصوامع

- مماثل

- الاشارات

- تبسيط

- منذ

- عزباء

- الحجم

- الأصغر

- So

- العدالة

- تطبيقات الكمبيوتر

- تطوير البرمجيات

- هندسة البرمجيات

- حل

- الحلول

- بعض

- مصدر

- مصادر

- متخصصة

- محدد

- على وجه التحديد

- أنفق

- الإنفاق

- معيار

- الولايه او المحافظه

- الحالة

- إقامة

- خطوة

- خطوات

- لا يزال

- تخزين

- متجر

- تخزين

- تخزين

- إجهاد

- حشو

- جوهري

- هذه

- اقترح

- تلخيص

- الدعم

- نظام

- أنظمة

- جدول

- يأخذ

- المهام

- ضريبة

- فريق

- فريق

- تكنولوجيا

- سياسة الحجب وتقييد الوصول

- تكساس

- نص

- نصي

- أن

- •

- المعلومات

- من مشاركة

- أنفسهم

- then

- هناك.

- تشبه

- هم

- طرف ثالث

- عبر

- تذكرة

- التذاكر

- صف

- الوقت

- استهلاك الوقت

- في حينه

- مرات

- الطابع الزمني

- عملاق

- إلى

- اليوم

- الرموز

- أداة

- أدوات

- التتبع

- تقليديا

- متدرب

- قادة الإيمان

- محول

- الشفافية

- علاج

- محاكمة

- محاكمات

- البرنامج التعليمي

- أنواع

- غير قادر

- فهم

- فهم

- فريد من نوعه

- الجامعات

- جامعة

- جامعة شيكاغو

- حديث جديد

- تحديث

- تحديث

- تستخدم

- حالة الاستخدام

- مستعمل

- مستخدم

- المستخدمين

- يستخدم

- استخدام

- الاستفادة من

- تستخدم

- استخدام

- قيمنا

- مختلف

- التحقق

- تحقق من

- القطاعات

- بواسطة

- فيديو

- مقاطع فيديو

- صوت

- انتظر

- انتظار

- وكان

- واشنطن

- طرق

- we

- الويب

- تطبيق ويب

- تطبيقات الويب

- خدمات ويب

- حسن

- كان

- ابحث عن

- متى

- سواء

- التي

- في حين

- من الذى

- واسع

- مدى واسع

- مع

- في غضون

- للعمل

- سير العمل

- عامل

- سوف

- مكتوب

- سنوات

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت