يعد اكتشاف التحيز في البيانات ونتائج النموذج مطلبًا أساسيًا لبناء نماذج مسؤولة للذكاء الاصطناعي (AI) وتعلم الآلة (ML). لسوء الحظ ، فإن اكتشاف التحيز ليس بالمهمة السهلة بالنسبة للغالبية العظمى من الممارسين بسبب العدد الكبير من الطرق التي يمكن من خلالها قياسه والعوامل المختلفة التي يمكن أن تسهم في نتيجة متحيزة. على سبيل المثال ، قد يؤدي أخذ عينات غير متوازنة من بيانات التدريب إلى نموذج أقل دقة لمجموعات فرعية معينة من البيانات. قد يتم أيضًا تقديم التحيز بواسطة خوارزمية ML نفسها - حتى مع مجموعة بيانات تدريب متوازنة جيدًا ، قد تفضل النتائج مجموعات فرعية معينة من البيانات مقارنة بالآخرين.

لاكتشاف التحيز ، يجب أن يكون لديك فهم شامل لأنواع التحيز المختلفة وما يقابلها مقاييس التحيز. على سبيل المثال ، في وقت كتابة هذا التقرير ، توضيح Amazon SageMaker تقدم 21 مقياسًا مختلفًا للاختيار من بينها.

في هذا المنشور ، نستخدم حالة استخدام التنبؤ بالدخل (توقع دخل المستخدم من ميزات الإدخال مثل التعليم وعدد ساعات العمل في الأسبوع) لإظهار أنواع مختلفة من التحيزات والمقاييس المقابلة في SageMaker توضيح. نقوم أيضًا بتطوير إطار عمل لمساعدتك في تحديد المقاييس المهمة لتطبيقك.

مقدمة إلى SageMaker توضيح

يتم استخدام نماذج ML بشكل متزايد للمساعدة في اتخاذ القرارات عبر مجموعة متنوعة من المجالات ، مثل الخدمات المالية والرعاية الصحية والتعليم والموارد البشرية. في العديد من المواقف ، من المهم أن نفهم سبب قيام نموذج ML بعمل تنبؤ محدد وأيضًا ما إذا كانت التنبؤات قد تأثرت بالتحيز.

يوفر SageMaker Clarify أدوات لكل من هذه الاحتياجات ، ولكن في هذا المنشور نركز فقط على وظيفة اكتشاف التحيز. لمعرفة المزيد حول القابلية للتفسير ، تحقق من شرح حقائق مباراة الدوري الألماني xGoals باستخدام Amazon SageMaker توضيح.

SageMaker Clarify هو جزء من الأمازون SageMaker، وهي خدمة مُدارة بالكامل لبناء نماذج تعلم الآلة وتدريبها ونشرها.

أمثلة على أسئلة حول التحيز

لتأسيس المناقشة ، فيما يلي بعض نماذج الأسئلة التي قد يطرحها منشئو تعلم الآلة وأصحاب المصلحة فيما يتعلق بالتحيز. تتكون القائمة من بعض الأسئلة العامة التي قد تكون ذات صلة بالعديد من تطبيقات ML ، بالإضافة إلى أسئلة حول تطبيقات معينة مثل استرجاع المستندات.

قد تسأل ، بالنظر إلى المجموعات المهتمة ببيانات التدريب (على سبيل المثال ، الرجال مقابل النساء) عن المقاييس التي يجب أن أستخدمها للإجابة على الأسئلة التالية:

- هل تمثيل المجموعة في بيانات التدريب يعكس العالم الحقيقي؟

- هل التسميات المستهدفة في بيانات التدريب تفضل مجموعة واحدة على الأخرى من خلال تعيين تسميات أكثر إيجابية لها؟

- هل النموذج له دقة مختلفة لمجموعات مختلفة؟

- في نموذج الغرض منه تحديد المرشحين المؤهلين للتوظيف ، هل يتمتع النموذج بنفس الدقة لمجموعات مختلفة؟

- في نموذج هدفه استرجاع المستندات ذات الصلة باستعلام إدخال ، هل يسترجع النموذج المستندات ذات الصلة من مجموعات مختلفة بنفس النسبة؟

في بقية هذا المنشور ، نقوم بتطوير إطار عمل لكيفية التفكير في الإجابة على هذه الأسئلة وغيرها من خلال المقاييس المتوفرة في SageMaker Clarify.

استخدام الحالة والسياق

يستخدم هذا المنشور مثالًا موجودًا لوظيفة SageMaker توضيح من الإنصاف وقابلية التفسير مع دفتر SageMaker Clarify ويشرح قيم مقياس التحيز المتولدة. يقوم الكمبيوتر الدفتري بتدريب طراز XGBoost على مجموعة بيانات UCI Adult (Dua، D. and Graff، C. (2019). مستودع التعلم الآلي UCI. إيرفين ، كاليفورنيا: جامعة كاليفورنيا ، كلية المعلومات وعلوم الكمبيوتر).

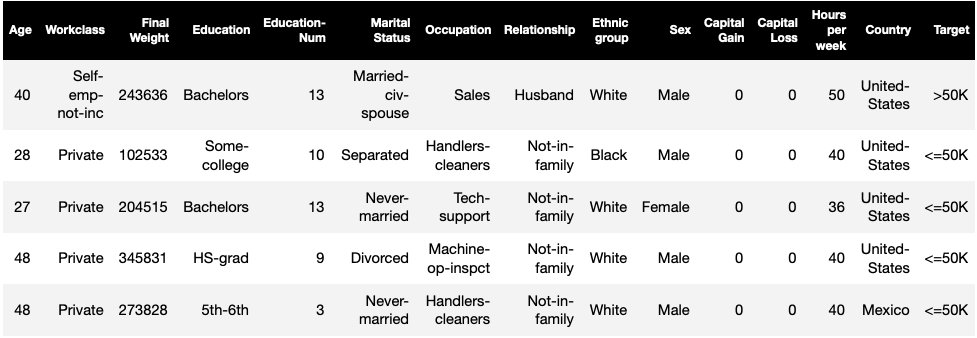

تتمثل مهمة ML في مجموعة البيانات هذه في التنبؤ بما إذا كان الشخص لديه دخل سنوي يزيد أو يقل عن 50,000 دولار. يوضح الجدول التالي بعض الأمثلة جنبًا إلى جنب مع ميزاتها. يعد قياس التحيز في التنبؤ بالدخل أمرًا مهمًا لأنه يمكننا استخدام هذه التنبؤات لإبلاغ القرارات مثل عروض الخصم والتسويق المستهدف.

مصطلحات التحيز

قبل التعمق أكثر ، دعنا نراجع بعض المصطلحات الأساسية. للحصول على قائمة كاملة من المصطلحات ، انظر يوضح Amazon SageMaker شروط التحيز والإنصاف.

- تُشير - الميزة المستهدفة التي تم تدريب نموذج ML على التنبؤ بها. ان التسمية الملحوظة يشير إلى قيمة التسمية التي لوحظت في البيانات المستخدمة لتدريب النموذج أو اختباره. أ التسمية المتوقعة هي القيمة التي تنبأ بها نموذج ML. يمكن أن تكون الملصقات ثنائية ، وغالبًا ما يتم ترميزها على أنها 0 و 1. نفترض أن 1 يمثل تصنيفًا إيجابيًا أو إيجابيًا (على سبيل المثال ، الدخل أكبر من أو يساوي 50,000 دولار أمريكي) ، و 0 يمثل تصنيفًا غير موات أو سلبي. يمكن أن تتكون التسميات أيضًا من أكثر من قيمتين. حتى في هذه الحالات ، تشكل واحدة أو أكثر من القيم تسميات مواتية. من أجل البساطة ، تنظر هذه المشاركة فقط في الملصقات الثنائية. للحصول على تفاصيل حول معالجة الملصقات التي تحتوي على أكثر من قيمتين وتسميات ذات قيم متصلة (على سبيل المثال ، في الانحدار) ، راجع ورقة عمل Amazon AI للعدالة والتفسير.

- وجيه - عمود أو سمة يتم قياس التحيز على أساسها. في مثالنا ، الوجه هو

sexويأخذ قيمتين:womanوman، ترميز كـfemaleوmaleفي البيانات (هذه البيانات مستخرجة من تعداد 1994 وتفرض خيارًا ثنائيًا). على الرغم من أن المنشور يعتبر وجهًا واحدًا بقيمتين فقط ، إلا أنه بالنسبة للحالات الأكثر تعقيدًا التي تتضمن أوجه أو أوجه متعددة تحتوي على أكثر من قيمتين ، راجع ورقة عمل Amazon AI للعدالة والتفسير. - انحياز - اختلال كبير في بيانات الإدخال أو تنبؤات النماذج عبر قيم أوجه مختلفة. ما يشكل "مهمًا" يعتمد على طلبك. بالنسبة لمعظم المقاييس ، تشير القيمة 0 إلى عدم وجود اختلال في التوازن. تنقسم مقاييس التحيز في SageMaker Clarify إلى فئتين:

- التدريب قبل - عند وجوده ، يشير التحيز قبل التدريب إلى وجود اختلالات في البيانات فقط.

- بعد التدريب - يراعي التحيز بعد التدريب بالإضافة إلى ذلك تنبؤات النماذج.

دعونا نفحص كل فئة على حدة.

التحيز قبل التدريب

مقاييس التحيز قبل التدريب في SageMaker توضيح الإجابة على السؤال التالي: هل جميع قيم الواجهة لها تمثيل متساو (أو مشابه) في البيانات؟ من المهم فحص البيانات للتحقق من التحيز المسبق لأنه قد يترجم إلى تحيز ما بعد التدريب في تنبؤات النموذج. على سبيل المثال ، يمكن للنموذج المدرَّب على البيانات غير المتوازنة حيث تظهر قيمة وجهية واحدة نادرًا جدًا أن يُظهر دقة أسوأ بكثير لهذه القيمة. يمكن حساب التمثيل المتساوي على ما يلي:

- بيانات التدريب كاملة بغض النظر عن الملصقات

- المجموعة الفرعية من بيانات التدريب ذات الملصقات الإيجابية فقط

- كل تسمية على حدة

يقدم الشكل التالي ملخصًا لكيفية تناسب كل مقياس في كل فئة من الفئات الثلاث.

تتكون بعض الفئات من أكثر من مقياس واحد. المقاييس الأساسية (المربعات الرمادية) تجيب على السؤال حول التحيز في هذه الفئة في أبسط شكل. تغطي المقاييس في المربعات البيضاء أيضًا حالات خاصة (على سبيل المثال ، مفارقة سيمبسون) وتفضيلات المستخدم (على سبيل المثال ، التركيز على أجزاء معينة من السكان عند حساب الأداء التنبئي).

تمثيل قيمة الواجهة بغض النظر عن الملصقات

المقياس الوحيد في هذه الفئة هو عدم توازن الفئة (CI). الهدف من هذا المقياس هو قياس ما إذا كانت جميع قيم الواجهة لها تمثيل متساوٍ في البيانات.

CI هو الفرق في جزء البيانات المكون من قيمتي الوجه. في مثالنا مجموعة البيانات ، للوجه sexويبين التفصيل (الموضح في الرسم البياني الدائري) أن النساء يشكلن 32.4٪ من بيانات التدريب بينما يشكل الرجال 67.6٪. نتيجة ل:

CI = 0.676 - 0.324 = 0.352

يمكن أن يؤدي عدم التوازن الشديد في الدرجة إلى أداء تنبؤي أسوأ لقيمة الوجه مع تمثيل أصغر.

تمثيل قيمة الواجهة على مستوى التسميات الإيجابية فقط

هناك طريقة أخرى لقياس التمثيل المتساوي وهي التحقق مما إذا كانت جميع قيم الأوجه تحتوي على جزء مماثل من العينات مع تسميات ملحوظة إيجابية. تتكون العلامات الإيجابية من النتائج الإيجابية (على سبيل المثال ، القرض الممنوح ، المختار للوظيفة) ، لذا فإن تحليل العلامات الإيجابية بشكل منفصل يساعد في تقييم ما إذا كانت القرارات الإيجابية موزعة بالتساوي.

في مجموعة البيانات المثال الخاصة بنا ، تنقسم التسميات التي تمت ملاحظتها إلى قيم موجبة وسالبة ، كما هو موضح في الشكل التالي.

11.4٪ من جميع النساء و 31.4٪ من جميع الرجال لديهم تصنيف إيجابي (منطقة مظللة داكنة في الأشرطة اليمنى واليسرى). يقيس الفرق في النسب الإيجابية في الملصقات (DPL) هذا الاختلاف.

DPL = 0.314 - 0.114 = 0.20

المقياس المتقدم في هذه الفئة ، التباين الديموغرافي الشرطي في الملصقات (CDDL) ، يقيس الاختلافات في التسميات الإيجابية ، لكنه يقسمها فيما يتعلق بمتغير آخر. يساعد هذا المقياس في التحكم في مفارقة سيمبسون، وهي حالة يظهر فيها حساب على البيانات بأكملها تحيزًا ، لكن التحيز يختفي عند تجميع البيانات فيما يتعلق ببعض المعلومات الجانبية.

• 1973 دراسة القبول بجامعة كاليفورنيا في بيركلي يقدم مثالا. وفقا للبيانات ، تم قبول الرجال بمعدل أعلى من النساء. ومع ذلك ، عند فحصها على مستوى أقسام الجامعة الفردية ، تم قبول النساء بمعدل مماثل أو أعلى في كل قسم. يمكن تفسير هذه الملاحظة من خلال مفارقة سيمبسون ، التي نشأت هنا لأن النساء تقدمن إلى مدارس أكثر قدرة على المنافسة. ونتيجة لذلك ، تم قبول عدد أقل من النساء بشكل عام مقارنة بالرجال ، على الرغم من قبولهن في المدرسة بمدرسة بمعدل مماثل أو أعلى.

لمزيد من التفاصيل حول كيفية حساب CDDL ، راجع ورقة عمل Amazon AI للعدالة والتفسير.

تمثيل قيمة الواجهة على مستوى كل تسمية على حدة

يمكن أيضًا قياس المساواة في التمثيل لكل تسمية فردية ، وليس فقط التسمية الإيجابية.

تحسب المقاييس في هذه الفئة الفرق في توزيع التسمية لقيم الواجهة المختلفة. يحتوي توزيع التسمية لقيمة وجهية على جميع قيم الملصقات التي تمت ملاحظتها ، جنبًا إلى جنب مع جزء العينات بقيمة تلك التسمية. على سبيل المثال ، في الشكل الذي يُظهر توزيعات الملصقات ، 88.6٪ من النساء لديهن ملصق ملاحظ سلبي و 11.4٪ لهن علامة ملحوظة إيجابية. لذا فإن توزيع التسمية للنساء هو [0.886 ، 0.114] وللرجال هو [0.686 ، 0.314].

المقياس الأساسي في هذه الفئة ، Kullback-Leibler divergence (KL) ، يقيس هذا الاختلاف على النحو التالي:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

المقاييس المتقدمة في هذه الفئة ، Jensen-Shannon divergence (JS) و Lp-norm (LP) و Total Variation مسافة (TVD) و Kolmogorov-Smirnov (KS) ، تقيس أيضًا الفرق بين التوزيعات ولكن لها خصائص رياضية مختلفة. باستثناء الحالات الخاصة ، سيقدمون رؤى مماثلة لـ KL. على سبيل المثال ، على الرغم من أن قيمة KL يمكن أن تكون لا نهائية عندما لا تحتوي قيمة الواجهة على عينات ذات تسميات معينة (على سبيل المثال ، لا يوجد رجال يحملون تصنيفًا سلبيًا) ، تتجنب JS هذه القيم اللانهائية. لمزيد من التفاصيل حول هذه الاختلافات ، انظر ورقة عمل Amazon AI للعدالة والتفسير.

العلاقة بين DPL (الفئة 2) والمقاييس القائمة على التوزيع لـ KL / JS / LP / TVD / KS (الفئة 3)

تكون المقاييس القائمة على التوزيع أكثر قابلية للتطبيق بشكل طبيعي على الملصقات غير الثنائية. بالنسبة للتسميات الثنائية ، نظرًا لحقيقة أنه يمكن استخدام عدم التوازن في التسمية الإيجابية لحساب عدم التوازن في الملصق السلبي ، فإن مقاييس التوزيع تقدم نفس الرؤى مثل DPL. لذلك ، يمكنك فقط استخدام DPL في مثل هذه الحالات.

التحيز بعد التدريب

تساعدنا مقاييس التحيز بعد التدريب في SageMaker Clarify على الإجابة عن سؤالين رئيسيين:

- هل يتم تمثيل جميع قيم الوجوه بمعدل مماثل في تنبؤات النماذج الإيجابية (المواتية)؟

- هل للنموذج أداء تنبؤي مماثل لجميع قيم الأوجه؟

يوضح الشكل التالي كيفية تعيين المقاييس لكل سؤال من هذه الأسئلة. يمكن تفصيل السؤال الثاني بشكل أكبر بناءً على التصنيف الذي يتم قياس الأداء فيما يتعلق به.

التمثيل المتساوي في تنبؤات النموذج الإيجابية

تتحقق المقاييس في هذه الفئة مما إذا كانت جميع قيم الوجوه تحتوي على جزء مشابه من العينات مع تسمية إيجابية متوقعة حسب النموذج. هذه الفئة من المقاييس تشبه إلى حد بعيد مقاييس ما قبل التدريب لـ DPL و CDDL - والفرق الوحيد هو أن هذه الفئة تأخذ في الاعتبار التسميات المتوقعة بدلاً من الملصقات التي تمت ملاحظتها.

في مجموعة البيانات في مثالنا ، يتم تعيين تصنيف إيجابي بنسبة 4.5٪ من جميع النساء من خلال النموذج ، ويتم تعيين تصنيف إيجابي بنسبة 13.7٪ من جميع الرجال.

المقياس الأساسي في هذه الفئة ، الفرق في النسب الإيجابية في التسميات المتوقعة (DPPL) ، يقيس الاختلاف في تعيينات الفئة الإيجابية.

DPPL = 0.137 - 0.045 = 0.092

لاحظ كيف أنه في بيانات التدريب ، كان لدى نسبة أعلى من الرجال علامة إيجابية ملحوظة. بطريقة مماثلة ، يتم تعيين تصنيف إيجابي متوقع لنسبة أعلى من الرجال.

بالانتقال إلى المقاييس المتقدمة في هذه الفئة ، يقيس التأثير المتباين (DI) نفس التباين في التعيينات الصفية الإيجابية ، ولكن بدلاً من الاختلاف ، فإنه يحسب النسبة:

DI = 0.045 / 0.137 = 0.328

ينقل كل من DI و DPPL رؤى متشابهة نوعياً ولكنهما يختلفان في بعض الحالات الجانبية. على سبيل المثال ، تميل النسب إلى الانفجار إلى أعداد كبيرة جدًا إذا كان المقام صغيرًا. خذ مثالاً على الرقمين 0.1 و 0.0001. النسبة 0.1 / 0.0001 = 10,000 بينما الفرق هو 0.1 - 0.0001 0.1. على عكس المقاييس الأخرى حيث تشير القيمة 0 إلى عدم وجود تحيز ، بالنسبة إلى DI ، لا يوجد تحيز يتوافق مع القيمة 1.

يقيس التباين الديموغرافي الشرطي في التسميات المتوقعة (CDDPL) التباين في تمثيل قيمة الوجه في التسمية الإيجابية ، ولكن تمامًا مثل مقياس التدريب المسبق لـ CDDL ، فإنه يتحكم أيضًا في مفارقة سيمبسون.

يقيس Fliptest المضاد (FT) إذا تلقت عينات مماثلة من قيم الوجهين قرارات مماثلة من النموذج. يمكن اعتبار النموذج الذي يعين قرارات مختلفة لعينتين متشابهتين مع بعضهما البعض ولكنهما يختلفان في قيم الوجه متحيزًا مقابل قيمة الوجه التي يتم تعيينها للتسمية غير المواتية (السلبية). بالنظر إلى قيمة الوجه الأولى (النساء) ، فإنه يقيِّم ما إذا كان للأعضاء المتشابهين مع قيمة الوجه الأخرى (الرجال) تنبؤ نموذجي مختلف. يتم اختيار الأعضاء المماثلين بناءً على خوارزمية k- الجار الأقرب.

أداء متساو

قد يكون لتوقعات النموذج تمثيل مماثل في الملصقات الإيجابية من قيم أوجه مختلفة ، ومع ذلك قد يختلف أداء النموذج في هذه المجموعات بشكل كبير. في العديد من التطبيقات ، قد يكون من المرغوب فيه الحصول على أداء تنبؤي مشابه عبر قيم وجه مختلفة. المقاييس في هذه الفئة تقيس الفرق في الأداء التنبئي عبر قيم الواجهة.

نظرًا لأنه يمكن تقطيع البيانات بعدة طرق مختلفة بناءً على الملصقات المرصودة أو المتوقعة ، فهناك العديد من الطرق المختلفة لقياس الأداء التنبئي.

أداء تنبؤي متساوٍ بغض النظر عن الملصقات

يمكنك النظر في أداء النموذج على البيانات بأكملها ، بغض النظر عن الملصقات التي تمت ملاحظتها أو التنبؤ بها - أي الدقة الكلية.

توضح الأشكال التالية كيف يصنف النموذج المدخلات من قيمتي الواجهة في مثال مجموعة البيانات الخاصة بنا. السلبيات الحقيقية (TN) هي الحالات التي يكون فيها كل من الملصق المرصود والمتوقع صفرًا. الإيجابيات الكاذبة (FP) هي تصنيفات خاطئة حيث كانت التسمية الملاحظة 0 ولكن التسمية المتوقعة كانت 0. الإيجابيات الحقيقية (TP) والسلبيات الكاذبة (FN) معرّفة بصورة مماثلة.

|

|

لكل قيمة وجهية ، يكون أداء النموذج الإجمالي ، أي دقة هذه القيمة الوجهية ، هو:

دقة = (TN + TP) / (TN + FP + FN + TP)

بهذه الصيغة تكون الدقة عند النساء 0.930 وللرجال 0.815. يؤدي هذا إلى المقياس الوحيد في هذه الفئة ، فرق الدقة (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 يعني أن الدقة لكلتا المجموعتين هي نفسها. تشير القيم الأكبر (الموجبة أو السلبية) إلى اختلافات أكبر في الدقة.

أداء متساوٍ على الملصقات الإيجابية فقط

يمكنك قصر تحليل أداء النموذج على التسميات الإيجابية فقط. على سبيل المثال ، إذا كان التطبيق يتعلق باكتشاف العيوب في خط التجميع ، فقد يكون من المستحسن التحقق من أن الأجزاء غير المعيبة (التسمية الإيجابية) ذات الأنواع المختلفة (قيم الوجوه) مصنفة على أنها غير معيبة بنفس المعدل. يشار إلى هذه الكمية باسم الاسترجاع ، أو المعدل الإيجابي الحقيقي:

تذكر = TP / (TP + FN)

في نموذجنا لمجموعة البيانات ، يبلغ استدعاء النساء 0.389 ، واستدعاء الرجال هو 0.425. يؤدي هذا إلى المقياس الأساسي في هذه الفئة ، وهو فرق الاسترجاع (RD):

RD = 0.425 - 0.389 = 0.036

الآن دعنا نفكر في المقاييس الثلاثة المتقدمة في هذه الفئة ، ونرى تفضيلات المستخدم التي تقوم بتشفيرها ، وكيف تختلف عن المقياس الأساسي لـ RD.

أولاً ، بدلاً من قياس الأداء على الملصقات الإيجابية الملحوظة ، يمكنك قياسه على الملصقات الإيجابية المتوقعة. بالنظر إلى قيمة وجه ، مثل النساء ، وجميع العينات التي لها قيمة وجهية يُتوقع أن تكون إيجابية بواسطة النموذج ، كم عدد العينات المصنفة بشكل صحيح على أنها إيجابية؟ يشار إلى هذه الكمية بمعدل القبول (AR) ، أو الدقة:

AR = TP / (TP + FP)

في مثالنا ، AR للنساء هو 0.977 ، و AR للرجال هو 0.970. هذا يؤدي إلى اختلاف في معدل القبول (DAR):

DAR = 0.970 - 0.977 = -0.007

هناك طريقة أخرى لقياس التحيز وهي الجمع بين المقياسين السابقين وقياس عدد التوقعات الإيجابية التي تخصصها النماذج لقيمة وجه مقارنة بالتسميات الإيجابية الملاحظة. يقيس SageMaker Clarify هذه الميزة من خلال النموذج كنسبة بين عدد الملصقات الإيجابية الملحوظة لقيمة الواجهة هذه وعدد الملصقات الإيجابية المتوقعة ، ويشير إليها على أنها قبول مشروط (CA):

CA = (TP + FN) / (TP + FP)

في مثالنا ، CA للنساء هو 2.510 وللرجال 2.283. يؤدي الاختلاف في CA إلى المقياس النهائي في هذه الفئة ، وهو الفرق في القبول المشروط (DCA):

DCA = 2.283 - 2.510 = -0.227

أداء متساوٍ على الملصقات السلبية فقط

بطريقة مشابهة للتسميات الإيجابية ، يمكن أيضًا حساب التحيز كفرق في الأداء على الملصقات السلبية. يمكن أن يكون النظر في التسميات السلبية بشكل منفصل مهمًا في بعض التطبيقات. على سبيل المثال ، في مثال اكتشاف العيوب ، قد نرغب في اكتشاف الأجزاء المعيبة (التسمية السلبية) من أنواع مختلفة (قيمة الواجهة) بنفس المعدل.

المقياس الأساسي في هذه الفئة ، الخصوصية ، مشابه لمقياس الاسترجاع (المعدل الإيجابي الحقيقي). تحسب الخصوصية دقة النموذج على العينات ذات القيمة السطحية هذه والتي لها تسمية سلبية ملحوظة:

النوعية = TN / (TN + FP)

في مثالنا (انظر جداول الارتباك) ، خصوصية النساء والرجال هي 0.999 و 0.994 على التوالي. وبالتالي ، فإن فرق النوعية (SD) هو:

SD = 0.994 - 0.999 = -0.005

بالانتقال ، تمامًا مثل مقياس معدل القبول ، فإن الكمية المماثلة للتسميات السلبية - معدل الرفض (RR) - هي:

RR = TN / (TN + FN)

يبلغ معدل الاختطار النسبي للنساء 0.927 وللرجال 0.791 ، مما يؤدي إلى الفرق في مقياس معدل الرفض (DRR):

DRR = 0.927 - 0.791 = -0.136

أخيرًا ، التناظرية السالبة للقبول المشروط ، الرفض المشروط (CR) ، هي النسبة بين عدد الملصقات السلبية المرصودة لقيمة الوجه تلك ، وعدد الملصقات السلبية المتوقعة:

CR = (TN + FP) / (TN + FN)

معدل السجل التجاري للنساء 0.928 وللرجال 0.796. المقياس النهائي في هذه الفئة هو الفرق في الرفض المشروط (DCR):

DCR = 0.796 - 0.928 = 0.132

أداء متساوٍ على التصنيفات الموجبة مقابل السلبية

يجمع SageMaker Clarify بين الفئتين السابقتين من خلال مراعاة نسبة أداء النموذج على الملصقات الموجبة والسالبة. على وجه التحديد ، لكل قيمة وجهية ، يحسب SageMaker Clarify النسبة بين السلبيات الكاذبة (FN) والإيجابيات الكاذبة (FP). في مثالنا ، نسبة FN / FP للنساء 679/10 = 67.9 وللرجال 3678/84 = 43.786. يؤدي هذا إلى مقياس المساواة في المعاملة (TE) ، والذي يقيس الفرق بين نسبة FP / FN:

TE = 67.9 - 43.786 = 24.114

توضح لقطة الشاشة التالية كيف يمكنك استخدام SageMaker Clarify مع أمازون ساجميكر ستوديو لعرض القيم وكذلك النطاقات والأوصاف المختصرة لمقاييس التحيز المختلفة.

أسئلة حول التحيز: ما هي المقاييس التي يجب البدء بها؟

أذكر نماذج الأسئلة حول التحيز في بداية هذا المنشور. بعد الاطلاع على المقاييس من الفئات المختلفة ، فكر في الأسئلة مرة أخرى. للإجابة على السؤال الأول ، الذي يتعلق بتمثيل المجموعات المختلفة في بيانات التدريب ، يمكنك البدء بمقياس عدم توازن الفئة (CI). وبالمثل ، بالنسبة للأسئلة المتبقية ، يمكنك البدء بالنظر في الفروق في النسب الإيجابية في الملصقات (DPL) ، وفرق الدقة (AD) ، والاختلاف في معدل القبول (DAR) ، وفرق الاسترجاع (RD) ، على التوالي.

تحيز بدون قيم وجهية

لسهولة العرض ، استبعد هذا الوصف لمقاييس ما بعد التدريب مقياس مؤشر الانتروبيا المعمم (GE). يقيس هذا المقياس التحيز دون النظر إلى قيمة الواجهة ، ويمكن أن يكون مفيدًا في تقييم كيفية توزيع أخطاء النموذج. لمزيد من التفاصيل ، يرجى الرجوع إلى الانتروبيا المعممة (GE).

وفي الختام

في هذا المنشور ، رأيت كيف تقيس 21 مقياسًا مختلفًا في SageMaker التحيز في مراحل مختلفة من خط أنابيب ML. لقد تعرفت على المقاييس المختلفة من خلال حالة استخدام التنبؤ بالدخل ، وكيفية اختيار المقاييس لحالة الاستخدام الخاصة بك ، والمقاييس التي يمكنك البدء بها.

ابدأ رحلة الذكاء الاصطناعي المسؤولة الخاصة بك عن طريق تقييم التحيز في نماذج ML الخاصة بك باستخدام الكمبيوتر الدفتري التجريبي الإنصاف وقابلية التفسير مع SageMaker توضيح. يمكنك العثور على الوثائق التفصيلية لـ SageMaker Clarify ، بما في ذلك التعريف الرسمي للمقاييس ، على ما المقصود بالإنصاف وإمكانية التفسير النموذجي لتنبؤات التعلم الآلي. بالنسبة للتنفيذ المفتوح المصدر لمقاييس التحيز ، يرجى الرجوع إلى aws-sagemaker-clarify مستودع جيثب. للحصول على مناقشة مفصلة بما في ذلك القيود ، الرجوع إلى ورقة عمل Amazon AI للعدالة والتفسير.

عن المؤلفين

بلال ظفر هو عالم تطبيقي في AWS ، يعمل على الإنصاف وقابلية التفسير والأمن في التعلم الآلي.

بلال ظفر هو عالم تطبيقي في AWS ، يعمل على الإنصاف وقابلية التفسير والأمن في التعلم الآلي.

دينيس في باتالوف هو مهندس حلول لـ AWS ، متخصص في التعلم الآلي. يعمل لدى أمازون منذ 2005. دينيس حاصل على درجة الدكتوراه في مجال الذكاء الاصطناعي. لمتابعته عبر تويتر:dbatalov.

ميشيل دونيني هو عالم تطبيقي كبير في AWS. يقود فريقًا من العلماء الذين يعملون على الذكاء الاصطناعي المسؤول وتركز اهتماماته البحثية على الإنصاف الخوارزمي والتعلم الآلي القابل للتفسير.

ميشيل دونيني هو عالم تطبيقي كبير في AWS. يقود فريقًا من العلماء الذين يعملون على الذكاء الاصطناعي المسؤول وتركز اهتماماته البحثية على الإنصاف الخوارزمي والتعلم الآلي القابل للتفسير.

- AI

- ai الفن

- مولد الفن ai

- الروبوت ai

- الأمازون SageMaker

- الذكاء الاصطناعي

- شهادة الذكاء الاصطناعي

- الذكاء الاصطناعي في البنوك

- روبوت ذكاء اصطناعي

- روبوتات الذكاء الاصطناعي

- برنامج ذكاء اصطناعي

- التعلم الآلي من AWS

- سلسلة كتلة

- مؤتمر blockchain ai

- عملة عبقرية

- الذكاء الاصطناعي للمحادثة

- مؤتمر التشفير ai

- دال

- التعلم العميق

- google ai

- آلة التعلم

- أفلاطون

- أفلاطون ع

- الذكاء افلاطون البيانات

- لعبة أفلاطون

- أفلاطون داتا

- بلاتوغمينغ

- مقياس ai

- بناء الجملة

- زفيرنت