توضح هذه السلسلة المكونة من ثلاثة أجزاء كيفية استخدام الشبكات العصبية للرسم البياني (GNNs) و أمازون نبتون لتوليد توصيات الفيلم باستخدام IMDb و Box Office Mojo Movies / TV / OTT حزمة البيانات المرخصة ، والتي توفر مجموعة واسعة من البيانات الوصفية الترفيهية ، بما في ذلك أكثر من 1 مليار تصنيف مستخدم ؛ قروض لأكثر من 11 مليون من أعضاء الطاقم وطاقم العمل ؛ 9 ملايين فيلم وتليفزيون وترفيه ؛ وبيانات شباك التذاكر العالمية من أكثر من 60 دولة. يقوم العديد من عملاء وسائل الإعلام والترفيه في AWS بترخيص بيانات IMDb من خلال تبادل بيانات AWS لتحسين اكتشاف المحتوى وزيادة تفاعل العملاء والاحتفاظ بهم.

In جزء 1، ناقشنا تطبيقات GNN ، وكيفية تحويل وإعداد بيانات IMDb الخاصة بنا للاستعلام. في هذا المنشور ، نناقش عملية استخدام Neptune لإنشاء حفلات الزفاف المستخدمة لإجراء بحث خارج الكتالوج في الجزء 3. نحن أيضا نذهب أمازون نبتون ML، وميزة التعلم الآلي (ML) لـ Neptune ، والرمز الذي نستخدمه في عملية التطوير لدينا. في الجزء 3 ، نتعرف على كيفية تطبيق تضمينات الرسم البياني المعرفي لدينا على حالة استخدام بحث خارج الكتالوج.

حل نظرة عامة

غالبًا ما تحتوي مجموعات البيانات الكبيرة المتصلة على معلومات قيمة يصعب استخلاصها باستخدام الاستعلامات القائمة على الحدس البشري وحده. يمكن أن تساعد تقنيات ML في العثور على الارتباطات الخفية في الرسوم البيانية مع مليارات العلاقات. يمكن أن تكون هذه الارتباطات مفيدة في التوصية بالمنتجات والتنبؤ بالجدارة الائتمانية وتحديد الاحتيال والعديد من حالات الاستخدام الأخرى.

يتيح Neptune ML إنشاء وتدريب نماذج تعلم مفيدة على رسوم بيانية كبيرة في ساعات بدلاً من أسابيع. لتحقيق ذلك ، يستخدم Neptune ML تقنية GNN التي تدعمها الأمازون SageMaker و مكتبة الرسم البياني العميق (DGL) (الذي المصدر المفتوح). GNNs هي مجال ناشئ في الذكاء الاصطناعي (على سبيل المثال ، انظر مسح شامل لشبكات الرسم البياني العصبية). للحصول على تدريب عملي حول استخدام GNNs مع DGL ، راجع تعلم الشبكات العصبية للرسم البياني باستخدام مكتبة الرسم البياني العميق.

في هذا المنشور ، نوضح كيفية استخدام Neptune في خط الأنابيب الخاص بنا لإنشاء حفلات الزفاف.

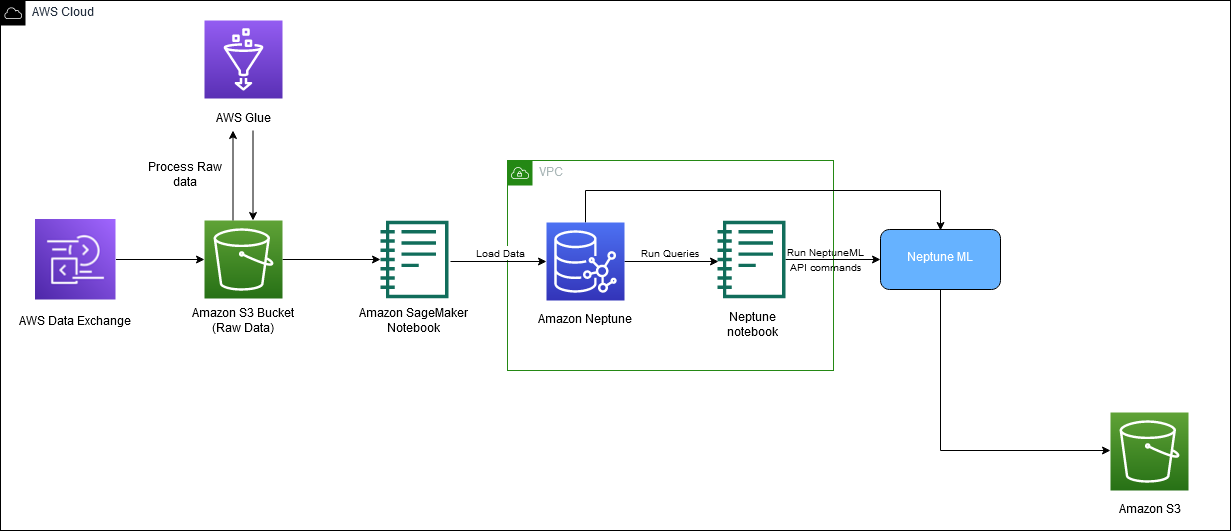

يوضح الرسم البياني التالي التدفق الكلي لبيانات IMDb من التنزيل إلى التضمين.

نستخدم خدمات AWS التالية لتنفيذ الحل:

في هذا المنشور ، نوجهك عبر الخطوات عالية المستوى التالية:

- قم بإعداد متغيرات البيئة

- قم بإنشاء وظيفة تصدير.

- قم بإنشاء وظيفة معالجة البيانات.

- قدم وظيفة تدريبية.

- تحميل حفلات الزفاف.

كود لأوامر Neptune ML

نستخدم الأوامر التالية كجزء من تنفيذ هذا الحل:

نستخدم neptune_ml export للتحقق من الحالة أو بدء عملية تصدير Neptune ML ، و neptune_ml training لبدء والتحقق من حالة وظيفة تدريب نموذج Neptune ML.

لمزيد من المعلومات حول هذه الأوامر وغيرها ، راجع استخدام سحر منضدة Neptune في دفاتر ملاحظاتك.

المتطلبات الأساسية المسبقة

لمتابعة هذا المنشور ، يجب أن يكون لديك ما يلي:

- An حساب AWS

- الإلمام بـ SageMaker و Amazon S3 و AWS CloudFormation

- تم تحميل بيانات الرسم البياني في مجموعة نبتون (انظر جزء 1 لمزيد من المعلومات)

قم بإعداد متغيرات البيئة

قبل أن نبدأ ، ستحتاج إلى إعداد بيئتك عن طريق تعيين المتغيرات التالية: s3_bucket_uri و processed_folder. s3_bucket_uri هو اسم الدلو المستخدم في الجزء 1 و processed_folder هو موقع Amazon S3 لإخراج مهمة التصدير.

قم بإنشاء وظيفة تصدير

في الجزء الأول ، أنشأنا دفتر ملاحظات SageMaker وخدمة تصدير لتصدير بياناتنا من مجموعة Neptune DB إلى Amazon S1 بالتنسيق المطلوب.

الآن بعد أن تم تحميل بياناتنا وإنشاء خدمة التصدير ، نحتاج إلى إنشاء وظيفة تصدير ، وبدء تشغيلها. للقيام بذلك ، نستخدم NeptuneExportApiUri وإنشاء معلمات لوظيفة التصدير. في الكود التالي ، نستخدم المتغيرات expo و export_params. جلس expo لديك NeptuneExportApiUri القيمة ، والتي يمكنك العثور عليها في ملف النواتج علامة التبويب الخاصة بمكدس CloudFormation. إلى عن على export_params، نحن نستخدم نقطة النهاية لمجموعة Neptune ونوفر القيمة لـ outputS3path، وهو موقع Amazon S3 لإخراج مهمة التصدير.

لإرسال مهمة التصدير ، استخدم الأمر التالي:

للتحقق من حالة مهمة التصدير ، استخدم الأمر التالي:

بعد اكتمال عملك ، اضبط ملف processed_folder متغير لتوفير موقع Amazon S3 للنتائج المعالجة:

قم بإنشاء وظيفة معالجة البيانات

الآن بعد أن تم التصدير ، قمنا بإنشاء مهمة معالجة البيانات لإعداد البيانات لعملية تدريب Neptune ML. يمكن القيام بذلك بعدة طرق مختلفة. في هذه الخطوة ، يمكنك تغيير ملف job_name و modelType المتغيرات ، ولكن يجب أن تظل جميع المعلمات الأخرى كما هي. الجزء الرئيسي من هذا الرمز هو modelType المعلمة ، والتي يمكن أن تكون إما نماذج رسوم بيانية غير متجانسة (heterogeneous) أو الرسوم البيانية المعرفية (kge).

تتضمن وظيفة التصدير أيضًا training-data-configuration.json. استخدم هذا الملف لإضافة أو إزالة أي عقد أو حواف لا تريد توفيرها للتدريب (على سبيل المثال ، إذا كنت تريد توقع الارتباط بين عقدتين ، فيمكنك إزالة هذا الارتباط في ملف التكوين هذا). بالنسبة إلى منشور المدونة هذا ، نستخدم ملف التكوين الأصلي. للحصول على معلومات إضافية ، انظر تحرير ملف تكوين التدريب.

قم بإنشاء مهمة معالجة البيانات الخاصة بك بالرمز التالي:

للتحقق من حالة مهمة التصدير ، استخدم الأمر التالي:

قدم وظيفة تدريبية

بعد اكتمال مهمة المعالجة ، يمكننا بدء عملنا التدريبي ، حيث نقوم بإنشاء حفلات الزفاف الخاصة بنا. نوصي بنوع مثيل من ml.m5.24xlarge ، ولكن يمكنك تغيير هذا ليناسب احتياجاتك الحاسوبية. انظر الكود التالي:

نقوم بطباعة متغير training_results للحصول على معرف الوظيفة التدريبية. استخدم الأمر التالي للتحقق من حالة وظيفتك:

%neptune_ml training status --job-id {training_results['id']} --store-to training_status_results

تحميل حفلات الزفاف

بعد اكتمال وظيفتك التدريبية ، فإن الخطوة الأخيرة هي تنزيل حفلات الزفاف الخام الخاصة بك. توضح لك الخطوات التالية كيفية تنزيل حفلات الزفاف التي تم إنشاؤها باستخدام KGE (يمكنك استخدام نفس العملية لـ RGCN).

في الكود التالي ، نستخدم neptune_ml.get_mapping() و get_embeddings() لتنزيل ملف التعيين (mapping.info) وملف الضمانات الخام (entity.npy). ثم نحتاج إلى تعيين الزخارف المناسبة لمعرفاتهم المقابلة.

لتنزيل RGCNs ، اتبع نفس العملية مع اسم وظيفة تدريب جديد عن طريق معالجة البيانات مع تعيين معلمة modelType على heterogeneous، ثم قم بتدريب النموذج الخاص بك مع تعيين معلمة modelName على rgcn انظر تعريف هنا لمزيد من التفاصيل. بمجرد الانتهاء من ذلك ، اتصل بـ get_mapping و get_embeddings وظائف لتنزيل ملف معلومات الخريطة و كيان. npy الملفات. بعد أن يكون لديك ملفات الكيان والتعيين ، تكون عملية إنشاء ملف CSV متطابقة.

أخيرًا ، قم بتحميل حفلات الزفاف الخاصة بك إلى موقع Amazon S3 الذي تريده:

تأكد من تذكر موقع S3 هذا ، وسوف تحتاج إلى استخدامه في الجزء 3.

تنظيف

عند الانتهاء من استخدام الحل ، تأكد من تنظيف أي موارد لتجنب الرسوم المستمرة.

وفي الختام

في هذا المنشور ، ناقشنا كيفية استخدام Neptune ML لتدريب حفلات زفاف GNN من بيانات IMDb.

بعض التطبيقات ذات الصلة بتضمينات الرسم البياني المعرفي هي مفاهيم مثل البحث خارج الكتالوج ، وتوصيات المحتوى ، والإعلان المستهدف ، والتنبؤ بالروابط المفقودة ، والبحث العام ، وتحليل الأتراب. البحث خارج الكتالوج هو عملية البحث عن المحتوى الذي لا تملكه ، والعثور على أو التوصية بالمحتوى الموجود في الكتالوج الخاص بك والذي يكون قريبًا مما بحثه المستخدم قدر الإمكان. نتعمق أكثر في البحث خارج الكتالوج في الجزء 3.

حول المؤلف

ماثيو رودس هو عالم بيانات أعمل في Amazon ML Solutions Lab. وهو متخصص في بناء خطوط أنابيب التعلم الآلي التي تتضمن مفاهيم مثل معالجة اللغة الطبيعية ورؤية الكمبيوتر.

ماثيو رودس هو عالم بيانات أعمل في Amazon ML Solutions Lab. وهو متخصص في بناء خطوط أنابيب التعلم الآلي التي تتضمن مفاهيم مثل معالجة اللغة الطبيعية ورؤية الكمبيوتر.

ديفيا بهارجافي هي عالمة بيانات وقائدة عمودية لوسائل الإعلام والترفيه في Amazon ML Solutions Lab ، حيث تحل مشاكل الأعمال عالية القيمة لعملاء AWS باستخدام التعلم الآلي. تعمل على فهم الصور / الفيديو وأنظمة توصية الرسم البياني المعرفي وحالات استخدام الإعلانات التنبؤية.

ديفيا بهارجافي هي عالمة بيانات وقائدة عمودية لوسائل الإعلام والترفيه في Amazon ML Solutions Lab ، حيث تحل مشاكل الأعمال عالية القيمة لعملاء AWS باستخدام التعلم الآلي. تعمل على فهم الصور / الفيديو وأنظمة توصية الرسم البياني المعرفي وحالات استخدام الإعلانات التنبؤية.

غوراف ريلي هو عالم بيانات في Amazon ML Solution Lab ، حيث يعمل مع عملاء AWS عبر قطاعات مختلفة لتسريع استخدامهم للتعلم الآلي وخدمات AWS Cloud لحل تحديات أعمالهم.

غوراف ريلي هو عالم بيانات في Amazon ML Solution Lab ، حيث يعمل مع عملاء AWS عبر قطاعات مختلفة لتسريع استخدامهم للتعلم الآلي وخدمات AWS Cloud لحل تحديات أعمالهم.

كاران السندواني هو عالم بيانات في Amazon ML Solutions Lab ، حيث يقوم ببناء ونشر نماذج التعلم العميق. وهو متخصص في مجال الرؤية الحاسوبية. في أوقات فراغه ، يستمتع بالمشي لمسافات طويلة.

كاران السندواني هو عالم بيانات في Amazon ML Solutions Lab ، حيث يقوم ببناء ونشر نماذج التعلم العميق. وهو متخصص في مجال الرؤية الحاسوبية. في أوقات فراغه ، يستمتع بالمشي لمسافات طويلة.

سوجي أديشينا هو عالم تطبيقي في AWS حيث يطور نماذج قائمة على الشبكة العصبية للرسم البياني للتعلم الآلي في مهام الرسوم البيانية مع تطبيقات الاحتيال وإساءة الاستخدام والرسوم البيانية المعرفية وأنظمة التوصية وعلوم الحياة. في أوقات فراغه ، يستمتع بالقراءة والطبخ.

سوجي أديشينا هو عالم تطبيقي في AWS حيث يطور نماذج قائمة على الشبكة العصبية للرسم البياني للتعلم الآلي في مهام الرسوم البيانية مع تطبيقات الاحتيال وإساءة الاستخدام والرسوم البيانية المعرفية وأنظمة التوصية وعلوم الحياة. في أوقات فراغه ، يستمتع بالقراءة والطبخ.

فيديا ساجار رافيباتي هو مدير في Amazon ML Solutions Lab ، حيث يستفيد من خبرته الواسعة في الأنظمة الموزعة واسعة النطاق وشغفه بالتعلم الآلي لمساعدة عملاء AWS عبر قطاعات الصناعة المختلفة على تسريع تبني الذكاء الاصطناعي والسحابة.

فيديا ساجار رافيباتي هو مدير في Amazon ML Solutions Lab ، حيث يستفيد من خبرته الواسعة في الأنظمة الموزعة واسعة النطاق وشغفه بالتعلم الآلي لمساعدة عملاء AWS عبر قطاعات الصناعة المختلفة على تسريع تبني الذكاء الاصطناعي والسحابة.

- متقدم (300،XNUMX)

- AI

- ai الفن

- مولد الفن ai

- الروبوت ai

- مختبر أمازون ML Solutions

- أمازون نبتون

- خدمة Amazon OpenSearch

- الذكاء الاصطناعي

- شهادة الذكاء الاصطناعي

- الذكاء الاصطناعي في البنوك

- روبوت ذكاء اصطناعي

- روبوتات الذكاء الاصطناعي

- برنامج ذكاء اصطناعي

- التعلم الآلي من AWS

- سلسلة كتلة

- مؤتمر blockchain ai

- عملة عبقرية

- الذكاء الاصطناعي للمحادثة

- مؤتمر التشفير ai

- دال

- التعلم العميق

- google ai

- آلة التعلم

- أفلاطون

- أفلاطون ع

- الذكاء افلاطون البيانات

- لعبة أفلاطون

- أفلاطون داتا

- بلاتوغمينغ

- مقياس ai

- بناء الجملة

- الكيفية الفنية

- زفيرنت