استحوذت نماذج اللغات الكبيرة (LLMs) على خيال واهتمام المطورين والعلماء والتقنيين ورجال الأعمال والمديرين التنفيذيين في العديد من الصناعات. يمكن استخدام هذه النماذج للإجابة على الأسئلة والتلخيص والترجمة والمزيد في تطبيقات مثل وكلاء المحادثة لدعم العملاء وإنشاء المحتوى للتسويق ومساعدي البرمجة.

مؤخرا، صدر ميتا اللاما 2 لكل من الباحثين والكيانات التجارية، إضافة إلى قائمة LLMs الأخرى، بما في ذلك MosaicML MPT و صقر. في هذا المنشور، نتعرف على كيفية ضبط Llama 2 بشكل دقيق تدريب AWS، وهو مسرع مصمم خصيصًا لتدريب LLM، لتقليل أوقات التدريب وتكاليفه. نقوم بمراجعة البرامج النصية للضبط الدقيق المقدمة من AWS نيورون SDK (باستخدام NeMo Megatron-LM)، والتكوينات المختلفة التي استخدمناها، ونتائج الإنتاجية التي رأيناها.

حول نموذج اللاما 2

مماثلة للسابقة اللاما 1 نموذج ونماذج أخرى مثل GPT، يستخدم Llama 2 بنية وحدة فك ترميز Transformer فقط. ويأتي بثلاثة أحجام: 7 مليار، و13 مليار، و70 مليار معلمة. بالمقارنة مع Llama 1، يضاعف Llama 2 طول السياق من 2,000 إلى 4,000، ويستخدم اهتمام الاستعلام المجمع (فقط لـ 70B). تم تدريب نماذج Llama 2 المدربة مسبقًا على 2 تريليون رمز مميز، وتم تدريب نماذجها المضبوطة بدقة على أكثر من مليون تعليق توضيحي بشري.

التدريب الموزع على اللاما 2

لاستيعاب Llama 2 بطول تسلسلي يتراوح بين 2,000 و4,000، قمنا بتنفيذ البرنامج النصي باستخدام نيمو ميجاترون لبرنامج Trainium الذي يدعم توازي البيانات (DP)، وتوازي الموتر (TP)، وتوازي خطوط الأنابيب (PP). على وجه التحديد، مع التنفيذ الجديد لبعض الميزات مثل فك تضمين الكلمات، والتضمين الدوار، وتنشيط RMSNorm، وSwiglu، نستخدم البرنامج النصي العام لـ جي بي تي نيورون ميجاترون- إل إم لدعم البرنامج النصي للتدريب Llama 2.

إجراءات التدريب عالية المستوى لدينا هي كما يلي: بالنسبة لبيئة التدريب الخاصة بنا، نستخدم مجموعة متعددة المثيلات يديرها نظام SLURM للتدريب الموزع والجدولة ضمن إطار عمل NeMo.

أولاً، قم بتنزيل نموذج Llama 2 ومجموعات بيانات التدريب وقم بمعالجتها مسبقًا باستخدام رمز Llama 2 المميز. على سبيل المثال، لاستخدام مجموعة بيانات RedPajama، استخدم الأمر التالي:

للحصول على إرشادات مفصلة حول تنزيل النماذج ووسيطة البرنامج النصي للمعالجة المسبقة، راجع قم بتنزيل مجموعة بيانات LlamaV2 والرمز المميز.

بعد ذلك، قم بتجميع النموذج:

بعد تجميع النموذج، قم بتشغيل مهمة التدريب باستخدام البرنامج النصي التالي الذي تم تحسينه بالفعل باستخدام أفضل التكوين والمعلمات الفائقة لـ Llama 2 (المضمنة في رمز المثال):

وأخيرًا، نقوم بمراقبة TensorBoard لتتبع تقدم التدريب:

للحصول على المثال الكامل للتعليمات البرمجية والبرامج النصية التي ذكرناها، راجع Llama 7B البرنامج التعليمي و كود نيمو في Neuron SDK للتنقل عبر خطوات أكثر تفصيلاً.

تجارب الضبط الدقيق

لقد قمنا بضبط نموذج 7B على مجموعات بيانات OSCAR (ALMANaCH coRpus المفتوحة الكبيرة جدًا) وQNLI (NLI للإجابة على الأسئلة) في بيئة Neuron 2.12 (PyTorch). لكل طول 2,000 و4,000 تسلسل، قمنا بتحسين بعض التكوينات، مثل batchsize و gradient_accumulation، لكفاءة التدريب. كإستراتيجية ضبط دقيق، اعتمدنا ضبطًا دقيقًا كاملاً لجميع المعلمات (حوالي 500 خطوة)، والتي يمكن توسيعها إلى التدريب المسبق بخطوات أطول ومجموعات بيانات أكبر (على سبيل المثال، 1T RedPajama). يمكن أيضًا تمكين توازي التسلسل للسماح لـ NeMo Megatron بضبط النماذج بنجاح بطول تسلسل أكبر يبلغ 4,000. يوضح الجدول التالي نتائج التكوين والإنتاجية لتجربة الضبط الدقيق لـ Llama 7B. يتم قياس الإنتاجية بشكل خطي تقريبًا مع زيادة عدد المثيلات إلى 4.

| المكتبة الموزعة | قواعد البيانات | طول التسلسل | عدد المثيلات | موتر بالتوازي | موازاة البيانات | خط أنابيب موازي | حجم الدفعة العالمية | الإنتاجية (التتابع/الثانية) |

| العصبون نيمو ميجاترون | OSCAR | 4096 | 1 | 8 | 4 | 1 | 256 | 3.7 |

| . | . | 4096 | 2 | 8 | 4 | 1 | 256 | 7.4 |

| . | . | 4096 | 4 | 8 | 4 | 1 | 256 | 14.6 |

| . | QNLI | 4096 | 4 | 8 | 4 | 1 | 256 | 14.1 |

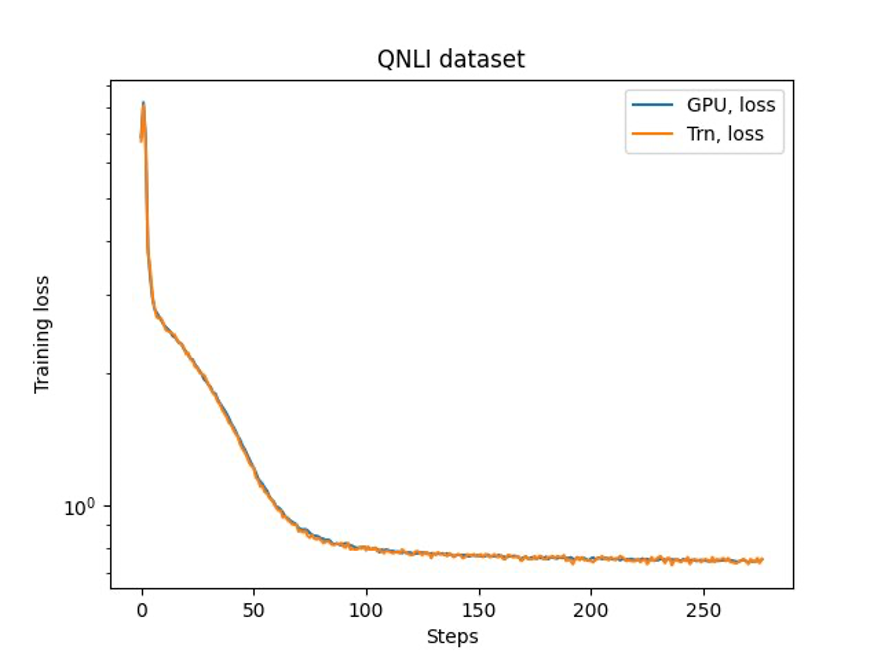

الخطوة الأخيرة هي التحقق من الدقة باستخدام النموذج الأساسي. قمنا بتنفيذ برنامج نصي مرجعي لتجارب GPU وأكدنا على مطابقة منحنيات التدريب لـ GPU وTrainium كما هو موضح في الشكل التالي. يوضح الشكل منحنيات الخسارة لعدد خطوات التدريب على مجموعة بيانات QNLI. تم اعتماد الدقة المختلطة لوحدة معالجة الرسومات (اللون الأزرق)، وbf16 مع التقريب العشوائي الافتراضي لـ Trainium (البرتقالي).

وفي الختام

في هذا المنشور، أوضحنا أن Trainium يقدم أداءً عاليًا وضبطًا دقيقًا فعالاً من حيث التكلفة لـ Llama 2. لمزيد من الموارد حول استخدام Trainium للتدريب المسبق الموزع وضبط نماذج الذكاء الاصطناعي التوليدية باستخدام NeMo Megatron، راجع مرجع AWS Neuron لـ NeMo Megatron.

حول المؤلف

هاو تشو هو عالم أبحاث في Amazon SageMaker. وقبل ذلك، عمل على تطوير أساليب التعلم الآلي للكشف عن الاحتيال في Amazon Fraud Detector. إنه متحمس لتطبيق التعلم الآلي والتحسين وتقنيات الذكاء الاصطناعي التوليدية على العديد من مشكلات العالم الحقيقي. حصل على درجة الدكتوراه في الهندسة الكهربائية من جامعة نورث وسترن.

هاو تشو هو عالم أبحاث في Amazon SageMaker. وقبل ذلك، عمل على تطوير أساليب التعلم الآلي للكشف عن الاحتيال في Amazon Fraud Detector. إنه متحمس لتطبيق التعلم الآلي والتحسين وتقنيات الذكاء الاصطناعي التوليدية على العديد من مشكلات العالم الحقيقي. حصل على درجة الدكتوراه في الهندسة الكهربائية من جامعة نورث وسترن.

كارثيك جوبالسوامي هو عالم تطبيقي لدى AWS. قبل AWS، عمل كعالم في Uber وWalmart Labs مع التركيز بشكل رئيسي على تحسين الأعداد الصحيحة المختلطة. وفي أوبر، ركز على تحسين شبكة النقل العام من خلال منتجات SaaS عند الطلب والرحلات المشتركة. في Walmart Labs، عمل على تحسين التسعير والتعبئة. حصل كارثيك على درجة الدكتوراه في الهندسة الصناعية وهندسة النظم مع تخصص ثانوي في بحوث العمليات من جامعة ولاية كارولينا الشمالية. تركز أبحاثه على النماذج والمنهجيات التي تجمع بين بحوث العمليات والتعلم الآلي.

كارثيك جوبالسوامي هو عالم تطبيقي لدى AWS. قبل AWS، عمل كعالم في Uber وWalmart Labs مع التركيز بشكل رئيسي على تحسين الأعداد الصحيحة المختلطة. وفي أوبر، ركز على تحسين شبكة النقل العام من خلال منتجات SaaS عند الطلب والرحلات المشتركة. في Walmart Labs، عمل على تحسين التسعير والتعبئة. حصل كارثيك على درجة الدكتوراه في الهندسة الصناعية وهندسة النظم مع تخصص ثانوي في بحوث العمليات من جامعة ولاية كارولينا الشمالية. تركز أبحاثه على النماذج والمنهجيات التي تجمع بين بحوث العمليات والتعلم الآلي.

شين هوانغ هو عالم تطبيقي كبير في Amazon SageMaker JumpStart وخوارزميات Amazon SageMaker المدمجة. يركز على تطوير خوارزميات التعلم الآلي القابلة للتطوير. تتركز اهتماماته البحثية في مجال معالجة اللغة الطبيعية ، والتعلم العميق القابل للتفسير على البيانات المجدولة ، والتحليل القوي لتجميع الزمكان غير المعياري. وقد نشر العديد من الأوراق في مؤتمرات ACL و ICDM و KDD والجمعية الملكية للإحصاء: السلسلة أ.

شين هوانغ هو عالم تطبيقي كبير في Amazon SageMaker JumpStart وخوارزميات Amazon SageMaker المدمجة. يركز على تطوير خوارزميات التعلم الآلي القابلة للتطوير. تتركز اهتماماته البحثية في مجال معالجة اللغة الطبيعية ، والتعلم العميق القابل للتفسير على البيانات المجدولة ، والتحليل القوي لتجميع الزمكان غير المعياري. وقد نشر العديد من الأوراق في مؤتمرات ACL و ICDM و KDD والجمعية الملكية للإحصاء: السلسلة أ.

بارك يونجسوك هو كبير العلماء التطبيقيين في AWS Annapurna Labs، ويعمل على تطوير وتدريب النماذج الأساسية على مسرعات الذكاء الاصطناعي. قبل ذلك، عمل الدكتور بارك في مجال البحث والتطوير لصالح Amazon Forecast في AWS AI Labs كعالم رئيسي. يكمن بحثه في التفاعل بين التعلم الآلي والنماذج الأساسية والتحسين والتعلم المعزز. وقد نشر أكثر من 20 ورقة بحثية تمت مراجعتها من قبل النظراء في أفضل الأماكن، بما في ذلك ICLR، وICML، وAISTATS، وKDD، مع خدمة تنظيم ورش العمل وتقديم البرامج التعليمية في مجال السلاسل الزمنية والتدريب على ماجستير إدارة الأعمال. قبل انضمامه إلى AWS، حصل على درجة الدكتوراه في الهندسة الكهربائية من جامعة ستانفورد.

بارك يونجسوك هو كبير العلماء التطبيقيين في AWS Annapurna Labs، ويعمل على تطوير وتدريب النماذج الأساسية على مسرعات الذكاء الاصطناعي. قبل ذلك، عمل الدكتور بارك في مجال البحث والتطوير لصالح Amazon Forecast في AWS AI Labs كعالم رئيسي. يكمن بحثه في التفاعل بين التعلم الآلي والنماذج الأساسية والتحسين والتعلم المعزز. وقد نشر أكثر من 20 ورقة بحثية تمت مراجعتها من قبل النظراء في أفضل الأماكن، بما في ذلك ICLR، وICML، وAISTATS، وKDD، مع خدمة تنظيم ورش العمل وتقديم البرامج التعليمية في مجال السلاسل الزمنية والتدريب على ماجستير إدارة الأعمال. قبل انضمامه إلى AWS، حصل على درجة الدكتوراه في الهندسة الكهربائية من جامعة ستانفورد.

ييدا وانغ هو عالم رئيسي في فريق AWS AI في أمازون. تنصب اهتماماته البحثية على الأنظمة والحوسبة عالية الأداء وتحليلات البيانات الضخمة. وهو يعمل حاليًا على أنظمة التعلم العميق، مع التركيز على تجميع وتحسين نماذج التعلم العميق للتدريب والاستدلال الفعال، وخاصة النماذج الأساسية واسعة النطاق. وتتمثل المهمة في ربط النماذج عالية المستوى من مختلف الأطر ومنصات الأجهزة منخفضة المستوى بما في ذلك وحدات المعالجة المركزية (CPU) ووحدات معالجة الرسومات (GPU) ومسرعات الذكاء الاصطناعي، بحيث يمكن تشغيل النماذج المختلفة بأداء عالٍ على أجهزة مختلفة.

ييدا وانغ هو عالم رئيسي في فريق AWS AI في أمازون. تنصب اهتماماته البحثية على الأنظمة والحوسبة عالية الأداء وتحليلات البيانات الضخمة. وهو يعمل حاليًا على أنظمة التعلم العميق، مع التركيز على تجميع وتحسين نماذج التعلم العميق للتدريب والاستدلال الفعال، وخاصة النماذج الأساسية واسعة النطاق. وتتمثل المهمة في ربط النماذج عالية المستوى من مختلف الأطر ومنصات الأجهزة منخفضة المستوى بما في ذلك وحدات المعالجة المركزية (CPU) ووحدات معالجة الرسومات (GPU) ومسرعات الذكاء الاصطناعي، بحيث يمكن تشغيل النماذج المختلفة بأداء عالٍ على أجهزة مختلفة.

جون (لوقا) هوان هو عالم رئيسي في AWS AI Labs. يعمل الدكتور هوان في مجال الذكاء الاصطناعي وعلوم البيانات. وقد نشر أكثر من 160 ورقة بحثية تمت مراجعتها في مؤتمرات ومجلات رائدة، كما قام بتخريج 11 طالب دكتوراه. وقد حصل على جائزة التطوير الوظيفي المبكر لكلية NSF في عام 2009. وقبل انضمامه إلى AWS، عمل في Baidu Research كعالم متميز ورئيس مختبر Baidu Big Data. أسس شركة StyleAI Inc.، وهي شركة ناشئة تعمل في مجال الذكاء الاصطناعي، وعمل كرئيس تنفيذي وكبير للعلماء في الفترة من 2019 إلى 2021. قبل انضمامه إلى الصناعة، كان أستاذًا لتشارلز إي وماري جين سبار في قسم EECS بجامعة كانساس. وفي الفترة من 2015 إلى 2018، عمل كمدير برنامج في مؤسسة العلوم الوطنية الأمريكية (NSF) وكان مسؤولاً عن برنامج البيانات الضخمة الخاص بها.

جون (لوقا) هوان هو عالم رئيسي في AWS AI Labs. يعمل الدكتور هوان في مجال الذكاء الاصطناعي وعلوم البيانات. وقد نشر أكثر من 160 ورقة بحثية تمت مراجعتها في مؤتمرات ومجلات رائدة، كما قام بتخريج 11 طالب دكتوراه. وقد حصل على جائزة التطوير الوظيفي المبكر لكلية NSF في عام 2009. وقبل انضمامه إلى AWS، عمل في Baidu Research كعالم متميز ورئيس مختبر Baidu Big Data. أسس شركة StyleAI Inc.، وهي شركة ناشئة تعمل في مجال الذكاء الاصطناعي، وعمل كرئيس تنفيذي وكبير للعلماء في الفترة من 2019 إلى 2021. قبل انضمامه إلى الصناعة، كان أستاذًا لتشارلز إي وماري جين سبار في قسم EECS بجامعة كانساس. وفي الفترة من 2015 إلى 2018، عمل كمدير برنامج في مؤسسة العلوم الوطنية الأمريكية (NSF) وكان مسؤولاً عن برنامج البيانات الضخمة الخاص بها.

شروتي كوباركار هو مدير أول لتسويق المنتجات في AWS. تساعد العملاء على استكشاف البنية التحتية للحوسبة المسرَّعة من Amazon EC2 وتقييمها واعتمادها لتلبية احتياجات التعلم الآلي الخاصة بهم.

شروتي كوباركار هو مدير أول لتسويق المنتجات في AWS. تساعد العملاء على استكشاف البنية التحتية للحوسبة المسرَّعة من Amazon EC2 وتقييمها واعتمادها لتلبية احتياجات التعلم الآلي الخاصة بهم.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://aws.amazon.com/blogs/machine-learning/fast-and-cost-effective-llama-2-fine-tuning-with-aws-trainium/

- :لديها

- :يكون

- $ UP

- 000

- 1

- 100

- 11

- 12

- 13

- 160

- 20

- 500

- 7

- 70

- 8

- a

- من نحن

- معجل

- مسرع

- المعجلات

- استيعاب

- دقة

- في

- تفعيل

- مضيفا

- تبنى

- اعتمد

- عملاء

- AI

- نماذج الذكاء الاصطناعى

- خوارزميات

- الكل

- السماح

- تقريبا

- سابقا

- أيضا

- أمازون

- Amazon EC2

- توقعات الأمازون

- كاشف احتيال الأمازون

- الأمازون SageMaker

- أمازون سيج ميكر جومب ستارت

- أمازون ويب سيرفيسز

- an

- تحليل

- تحليلات

- و

- التطبيقات

- تطبيقي

- تطبيق

- هندسة معمارية

- هي

- المنطقة

- حجة

- AS

- مساعدين

- At

- اهتمام

- جائزة

- AWS

- بايدو

- قاعدة

- BE

- كان

- قبل

- أفضل

- ما بين

- كبير

- البيانات الكبيرة

- مليار

- الأزرق

- على حد سواء

- BRIDGE

- مدمج

- by

- CAN

- القبض

- التوظيف

- الرئيس التنفيذي

- تهمة

- تشارلز

- رئيس

- كتلة

- المجموعات

- الكود

- البرمجة

- دمج

- يأتي

- تجاري

- مقارنة

- إكمال

- الحوسبة

- المؤتمرات

- الاعداد

- تم تأكيد

- محتوى

- انشاء محتوى

- سياق الكلام

- تحادثي

- فعاله من حيث التكلفه

- التكاليف

- خلق

- حاليا

- منحنى

- زبون

- دعم العملاء

- العملاء

- البيانات

- تحليلات البيانات

- علم البيانات

- قواعد البيانات

- عميق

- التعلم العميق

- الترتيب

- يسلم

- القسم

- مفصلة

- كشف

- المطورين

- تطوير

- التطوير التجاري

- الأجهزة

- مختلف

- مدير المدارس

- متميزه

- وزعت

- التدريب الموزع

- الزوجي

- بإمكانك تحميله

- dr

- e

- كل

- في وقت مبكر

- كفاءة

- فعال

- تضمين

- تمكين

- الهندسة

- الكيانات

- رواد الأعمال

- البيئة

- خاصة

- تقييم

- مثال

- مُديرين تنفيذيين

- تجربة

- تجارب

- اكتشف

- FAST

- المميزات

- الشكل

- تركز

- ركز

- ويركز

- متابعيك

- متابعات

- في حالة

- توقعات

- دورة تأسيسية

- تاسست

- الإطار

- الأطر

- احتيال

- الكشف عن الغش

- تبدأ من

- بالإضافة إلى

- توليدي

- الذكاء الاصطناعي التوليدي

- وحدة معالجة الرسوميات:

- وحدات معالجة الرسومات

- توجيه

- أجهزة التبخير

- يملك

- he

- رئيس

- يساعد

- مرتفع

- رفيع المستوى

- أداء عالي

- له

- يحمل

- كيفية

- كيفية

- HTML

- HTTPS

- الانسان

- يوضح

- خيال

- التنفيذ

- نفذت

- in

- Inc.

- شامل

- بما فيه

- القيمة الاسمية

- صناعي

- الصناعات

- العالمية

- البنية التحتية

- مصلحة

- السريرية

- IT

- انها

- جين

- وظيفة

- انضمام

- JPG

- كانساس

- احتفظ

- مختبر

- مختبرات

- لغة

- على نطاق واسع

- أكبر

- اسم العائلة

- إطلاق

- قيادة

- قيادة

- تعلم

- الطول

- يكمن

- مثل

- قائمة

- اللاما نوع من الجمال

- LLM

- يعد

- خسارة

- آلة

- آلة التعلم

- رائد

- تمكن

- مدير

- كثير

- التسويق

- مطابقة

- المذكورة

- مييتااا

- المنهجيات

- طرق

- مليون

- قاصر

- المهمة

- مختلط

- نموذج

- عارضات ازياء

- مراقبة

- الأكثر من ذلك

- طبيعي

- معالجة اللغات الطبيعية

- إحتياجات

- شبكة

- جديد

- شمال

- شمال كارولينا

- NSF

- عدد

- NVIDIA

- تم الحصول عليها

- of

- on

- على الطلب

- فقط

- جاكيت

- عمليات

- التحسين

- الأمثل

- تحسين

- برتقال

- تنظيم

- أخرى

- لنا

- على مدى

- أوراق

- المعلمات

- متنزهات

- عاطفي

- لاستعراض الأقران

- أداء

- رسالة دكتوراه

- خط أنابيب

- منصات التداول

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- منشور

- سابق

- التسعير

- رئيسي

- قبل

- مشاكل

- الإجراءات

- معالجة

- المنتج

- المنتجات

- البروفيسور

- البرنامج

- التقدّم

- المقدمة

- جمهور

- نقل عام

- نشرت

- بايثون

- pytorch

- سؤال

- R & D

- العالم الحقيقي

- تخفيض

- الرجوع

- صدر

- بحث

- الباحثين

- الموارد

- النتائج

- مراجعة

- قوي

- التقريب

- ملكي

- يجري

- ادارة العلاقات مع

- sagemaker

- رأى

- تحجيم

- النطاقات

- جدولة

- علوم

- عالم

- العلماء

- سيناريو

- مخطوطات

- الإستراحة

- كبير

- تسلسل

- مسلسلات

- السلسلة أ

- الخدمة

- خدماتنا

- عدة

- شاركت

- هي

- أظهرت

- أظهرت

- يظهر

- الأحجام

- So

- جاليات

- بعض

- محدد

- ستانفورد

- جامعة ستانفورد

- بدء

- الولايه او المحافظه

- إحصائي

- خطوة

- خطوات

- الإستراتيجيات

- عدد الطلبة

- بنجاح

- هذه

- الدعم

- الدعم

- نظام

- أنظمة

- جدول

- فريق

- تقنيات

- التكنولوجيين

- من

- أن

- •

- المنطقة

- من مشاركة

- منهم

- تشبه

- ثلاثة

- عبر

- الإنتاجية

- الوقت

- السلاسل الزمنية

- مرات

- إلى

- سويا

- الرموز

- تيشرت

- tp

- مسار

- متدرب

- قادة الإيمان

- عبور

- خدمات ترجمة

- تريليون

- الدروس

- اوبر

- مع

- جامعة

- us

- تستخدم

- مستعمل

- يستخدم

- استخدام

- مختلف

- أماكن

- تحقق من

- سير

- وول مارت

- وكان

- we

- الويب

- خدمات ويب

- التي

- مع

- كلمة

- عمل

- عامل

- أعمال

- ورشة عمل

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت