الرسالة إن تعريف مايكروسوفت لما يشكل وما لا يشكل جهاز كمبيوتر يعمل بالذكاء الاصطناعي يتشكل. مع أحدث إصدار من Windows، ومفتاح Copilot مخصص، ووحدة NPU قادرة على إجراء ما لا يقل عن 40 تريليون عملية في الثانية، ستتمكن قريبًا من تشغيل Microsoft Copilot محليًا، على جهازك.

في ريدموند المتطلبات لنموذج الذكاء الاصطناعي الخاص به على نظام التشغيل Windows، أصبحت شركة Intel رسمية - وهي واحدة من أقوى المصفقين لفئة أجهزة الكمبيوتر الشخصية ذات الذكاء الاصطناعي - خلال مؤتمر عملاق الرقائق قمة الذكاء الاصطناعي في تايبيه هذا الأسبوع.

إن تشغيل نموذج لغة كبير (LLM) محليًا له بعض الفوائد الجوهرية. يجب أن يتمتع المستخدمون النهائيون بزمن وصول أقل وبالتالي أوقات استجابة محسنة، حيث لا يلزم إرسال الاستعلامات من وإلى مركز بيانات بعيد، بالإضافة إلى المزيد من الخصوصية، من الناحية النظرية. وفي الوقت نفسه، بالنسبة لشركة Microsoft، فإن تحويل المزيد من عبء عمل الذكاء الاصطناعي إلى أجهزة العملاء يحرر مواردها الخاصة لمهام أخرى، مثل المساعدة في تدريب نموذج OpenAI التالي أو تقديمه كواجهة برمجة تطبيقات سحابية.

وتأمل مايكروسوفت في تشغيل برنامج Copilot LLM الخاص بها بالكامل على وحدات NPU، أو وحدات المعالجة العصبية، في أجهزة الكمبيوتر الشخصية التي تعمل بنظام التشغيل Windows AI في نهاية المطاف، استنادًا إلى التعليقات على ما يبدو تم إجراؤها بواسطة Intel execs في القمة. يمكننا أن نتخيل أن x86 جالوت يدفع هذا الخط لإقناع الجميع بأن السيليكون الخاص به قوي بما يكفي لتشغيل أشياء ريدموند في المنزل أو في المكتب.

على الرغم من أن فكرة فصل مساعد الطيار عن سر Azure قد تكون جذابة للبعض، إلا أنه لا يبدو أن الجميع من محبيها كليبي متجسد ومن المؤكد تقريبًا أنه سيتم إجراء قدر معين من المعالجة في السحابة في المستقبل المنظور.

لقد قال المسؤولون التنفيذيون في شركة إنتل: إن الأجهزة الأسرع ستمكن المزيد من "عناصر" Copilot من التشغيل محليًا. بمعنى آخر، ستظل تعتمد على اتصال الشبكة في بعض الوظائف على الأقل، وسيتعامل جهاز الكمبيوتر الشخصي المدعم بالذكاء الاصطناعي مع الباقي.

السبب لا ينبغي أن يكون مفاجأة كبيرة. تتمتع أجهزة الكمبيوتر الشخصية المزودة بتقنية الذكاء الاصطناعي هذه بموارد محدودة، كما أن نموذج تشغيل Copilot — OpenAI's GPT-4 — هائل. لا نعرف بالضبط حجم الإصدار الذي تستخدمه Microsoft، ولكن تقديرات وضع نموذج GPT-4 الكامل عند حوالي 1.7 تريليون معلمة. حتى مع التكميم أو تشغيل النموذج على INT4، ستحتاج إلى حوالي 900 جيجابايت من الذاكرة.

كيف نعتقد أنها ستعمل

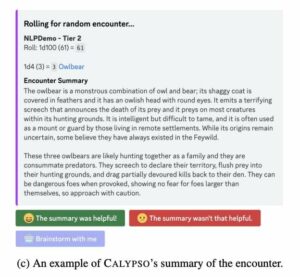

GPT-4 هو ما يسمى بنموذج خليط الخبراء. باختصار، هذا يعني أنه تم تجميعها فعليًا من عدد من النماذج الصغيرة والمتخصصة المدربة مسبقًا والتي يتم توجيه الاستعلامات إليها. من خلال وجود نماذج متعددة محسنة لإنشاء النص والتلخيص وإنشاء التعليمات البرمجية وما إلى ذلك، يمكن تحسين أداء الاستدلال نظرًا لأن النموذج بأكمله لا يحتاج إلى التشغيل لإكمال المهمة.

ويشير استخدام إنتل لمصطلح "العناصر" لوصف تشغيل ميزات Copilot محليًا إلى إمكانية استبدال بعض هؤلاء الخبراء بنماذج أصغر حجمًا وأكثر رشاقة قادرة على العمل على أجهزة الكمبيوتر المحمول. كما اكتشفنا سابقًا، فإن الأجهزة الشخصية الحالية أكثر من قادرة على تشغيل نماذج الذكاء الاصطناعي الأصغر حجمًا من أمثال Mistral أو Meta.

من قبيل الصدفة، مايكروسوفت مؤخرا ضخت 15 مليون يورو (16.3 مليون دولار) في شركة بناء النماذج المصغرة الفرنسية Mistral AI، مع خطط لجعل عملها متاحًا لعملاء Azure. بحجم 7 مليار معلمة فقط، من المؤكد أن جهاز Mistral-7B صغير بما يكفي ليناسب بشكل مريح ذاكرة كمبيوتر شخصي يعمل بالذكاء الاصطناعي، مما يتطلب ذاكرة بسعة 4 جيجابايت عند استخدام التكميم 4 بت.

وهذا لنموذج للأغراض العامة. من الممكن أن تتمكن من التعامل مع نماذج أصغر تم ضبطها لتوليد كود المصدر والتي يتم تحميلها في الذاكرة فقط عند تشغيل التطبيق، على سبيل المثال Visual Studio Code، ويتم اكتشاف اشتراك Github Copilot النشط. تذكر أن برنامج Copilot هو أكثر من مجرد برنامج دردشة آلي؛ إنها مجموعة من ميزات الذكاء الاصطناعي التي يتم دمجها في نظام التشغيل ومكتبة البرامج الخاصة بشركة Microsoft.

لم يذكر Redmond مقدار الذاكرة التي تتطلبها مواصفات جهاز الكمبيوتر الشخصي الذي يعمل بتقنية الذكاء الاصطناعي، ولكن في تجربتنا مع LLMs المحلية، يجب أن تكون سعة 16 جيجابايت من ذاكرة DDR5 السريعة كافية.

ومهما كان المسار الذي ستتبعه مايكروسوفت، فإن الجمع بين النماذج المحلية والبعيدة يمكن أن يؤدي إلى بعض السلوكيات المثيرة للاهتمام. لا نعرف حتى الآن تحت أي ظروف ستتولى هذه النماذج المحلية المسؤولية، لكن نائب رئيس شركة Microsoft لأجهزة Windows، Pavan Davuluri، اقترح أن هذا المزيج قد يكون ديناميكيًا.

"نريد أن نكون قادرين على تحميل التحول بين السحابة والعميل لتوفير أفضل الحوسبة عبر هذين العالمين،" قال على خشبة المسرح خلال AMD's Advancing AI حدث في ديسمبر. "إنه يجمع بين فوائد الحوسبة المحلية، وأشياء مثل تعزيز الخصوصية والاستجابة وزمن الوصول مع قوة السحابة، ونماذج الأداء العالي، ومجموعات البيانات الكبيرة، والاستدلال عبر الأنظمة الأساسية."

على هذا النحو، يمكننا أن نرى بضعة سيناريوهات حول كيفية استخدام Microsoft للذكاء الاصطناعي المحلي. الأول هو إلغاء تحميل العمل من خوادم Microsoft وتحسين أوقات الاستجابة. مع تحسن الأجهزة، يمكن دفع المزيد من ميزات Copilot من السحابة إلى أجهزة المستخدم.

والثاني هو أن يكون بمثابة احتياطي في حالة انقطاع الشبكة. يمكنك أن تتخيل أن جهاز الكمبيوتر الشخصي الخاص بك الذي يعمل بتقنية الذكاء الاصطناعي أصبح أكثر غباءً بدلاً من التوقف تمامًا عند قطع الاتصال بالشبكة.

قيود الأجهزة

قبل أن تكون متحمسًا للغاية بشأن أجهزة الكمبيوتر الشخصية ذات العقول المنقسمة التي تعمل بالذكاء الاصطناعي والتي تقوم بصياغة بيانات خارج الشبكة، لا توجد حاليًا أي أجهزة تلبي متطلبات الأجهزة، وليس بسبب عدم وجود مفتاح Copilot.

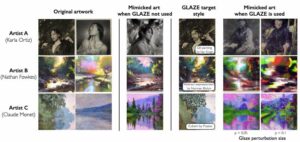

تكمن المشكلة في أن وحدات NPU لا تزال جديدة نسبيًا في شريحة x86، وما هو موجود ليس قويًا بدرجة كافية. كانت AMD من بين أوائل الشركات التي أضافت وحدة NPU إلى معالجاتها المحمولة في أوائل عام 2023 مع إطلاقها Ryzen 7040 رقائق السلسلة.

تلقت هذه التشكيلة دفعة على مدار الساعة في ديسمبر خلال حدث House of Zen's Advancing AI. جلبت AMD أيضًا وحدات NPU الخاصة بها إلى سطح المكتب مع إطلاقها وحدات APU 8000 جيجا في معرض CES في يناير من هذا العام.

طرحت إنتل كتل تسريع الذكاء الاصطناعي المخصصة لها مع إطلاقها بحيرة النيزك أجزاء المعالجات الدقيقة في أواخر ديسمبر. تتميز شرائح Core Ultra هذه بوحدة NPU مشتقة من وحدة معالجة الرؤية Movidius من Intel (VPU)، والتي توفرها Intel تجريبي تشغيل مجموعة متنوعة من أعباء العمل خلال حدث الابتكار العام الماضي.

ولسوء الحظ، فإن الرقائق قادرة فقط على إجراء ما بين 10 إلى 16 تريليون عملية (عادة INT4) في الثانية، وهو أقل بكثير من مواصفات 40 TOPS الخاصة بشركة Microsoft. وهذا يعني أن معظم أجهزة الكمبيوتر الشخصية التي تعمل بالذكاء الاصطناعي والموجودة في السوق لن تفي بالمتطلبات، ليس من دون الاعتماد على وحدة معالجة الرسومات لتعويض الفارق.

تمتلك كل من Intel وAMD شرائح أكثر قدرة تأتي مع Lunar Lake وStrix Point silicon على التوالي. ومع ذلك، على المدى القريب، يبدو أن شركة Qualcomm ستسيطر على السوق.

أجهزة الكمبيوتر المحمولة الرياضية Snapdragon X Elite من Qualcomm المعالجات المحمولة من المقرر إصدارها في وقت ما في منتصف عام 2024 وستحتوي على وحدة NPU قادرة على 45 TOPS. إلى جانب وحدة معالجة الرسومات Adreno القادرة على أداء 4.6 تيرافلوبس من أداء FP32، تقول كوالكوم إن الجزء سيكون قادرًا على تشغيل نماذج الذكاء الاصطناعي التي تصل إلى 13 مليار معلمة بالكامل على الجهاز وإنشاء 30 رمزًا مميزًا في الثانية عند تشغيل LLMs أصغر حجمًا بـ 7 مليارات معلمة.

مع وصول أجهزة الكمبيوتر التي تحتوي على وحدات NPU عالية الأداء ومخازن ذاكرة أكبر، وزيادة قدرة النماذج الصغيرة، نعتقد أن Microsoft ستبدأ في تفريغ المزيد من الوظائف إلى الأجهزة المحلية - بمجرد أن تتمكن الأجهزة من التعامل معها. ®

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://go.theregister.com/feed/www.theregister.com/2024/03/31/microsoft_copilot_hardware/

- :لديها

- :يكون

- :ليس

- $ UP

- 1

- 10

- 13

- 16

- 2023

- 30

- 40

- 7

- a

- ماهرون

- من نحن

- مسرع

- في

- نشط

- في الواقع

- تضيف

- كاف

- تقدم

- AI

- نماذج الذكاء الاصطناعى

- تقريبا

- أيضا

- AMD

- من بين

- كمية

- an

- و

- أي وقت

- API

- تطبيق

- هي

- حول

- AS

- تجميعها

- At

- جذاب

- متاح

- Azure

- الى الخلف

- BE

- بدأ

- سلوك

- أقل من

- الفوائد

- أفضل

- ما بين

- كبير

- مليار

- Blocks

- على حد سواء

- يجلب

- جلبت

- باني

- لكن

- by

- دعوات

- CAN

- قادر على

- حقيبة

- الفئة

- بالتأكيد

- CES

- chatbot

- رقاقة

- شيبس

- ظروف

- زبون

- ساعة حائط

- سحابة

- CO

- الكود

- مجموعة

- الجمع بين

- تأتي

- آت

- إكمال

- إحصاء

- الحوسبة

- صلة

- شكل

- إقناع

- جوهر

- يحشر

- منظمة

- استطاع

- زوجان

- خلق

- عبر

- حاليا

- زبون

- العملاء

- قطع

- البيانات

- مجموعات البيانات

- مراكز البيانات

- ديسمبر

- مخصصة

- تعريف

- مستمد

- وصف

- سطح المكتب

- الكشف عن

- جهاز

- الأجهزة

- فرق

- الاضطرابات

- هل

- لا توجد الآن

- دون

- فعل

- اثنان

- أثناء

- ديناميكي

- في وقت مبكر

- عناصر

- نخبة

- تمكين

- النهاية

- ينتهي

- تعزيز

- ضخم

- كاف

- كامل

- تماما

- حتى

- الحدث/الفعالية

- في النهاية

- كل شخص

- بالضبط

- متحمس

- اداريو

- مُديرين تنفيذيين

- يوجد

- القائمة

- الخبره في مجال الغطس

- خبرائنا

- استكشاف

- فال

- مروحة

- بعيدا

- أسرع

- الميزات

- المميزات

- الاسم الأول

- تناسب

- في حالة

- متوقع

- الفرنسية

- تبدأ من

- بالإضافة إلى

- وظيفة

- مستقبل

- العلاجات العامة

- توليد

- جيل

- دولار فقط واحصل على خصم XNUMX% على جميع

- الحصول على

- عملاق

- GitHub جيثب:

- الذهاب

- وحدة معالجة الرسوميات:

- النمو

- مقبض

- أجهزة التبخير

- يملك

- وجود

- he

- مساعدة

- مرتفع

- أعلى

- الصفحة الرئيسية

- تأمل

- منـزل

- كيفية

- لكن

- HTTPS

- فكرة

- تخيل

- تحسن

- تحسن

- يحسن

- in

- في أخرى

- الابتكار

- إنتل

- وكتابة مواضيع مثيرة للاهتمام

- إلى

- جوهري

- يسن

- قضية

- IT

- انها

- نفسها

- يناير

- JPG

- م

- القفل

- علم

- تُشير

- نقص

- بحيرة

- لغة

- كمبيوتر محمول

- كبير

- أكبر

- اسم العائلة

- العام الماضي

- متأخر

- كمون

- آخر

- إطلاق

- أطلقت

- قيادة

- الأقل

- المكتبة

- مثل

- الإعجابات

- خط

- تشكيلة الفريق

- ll

- LLM

- تحميل

- محلي

- محليا

- تبدو

- خفض

- موج قمري

- آلة

- الآلات

- صنع

- جعل

- تجارة

- مايو..

- يعني

- في غضون

- تعرف علي

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- مييتااا

- مایکروسافت

- ربما

- مليون

- مزيج

- الجوال

- نموذج

- عارضات ازياء

- الأكثر من ذلك

- أكثر

- كثيرا

- متعدد

- قرب

- تقريبا

- حاجة

- صاف

- شبكة

- عصبي

- جديد

- التالي

- الآن

- عدد

- باختصار

- of

- خصم

- الوهب

- Office

- رسمي

- on

- مرة

- ONE

- فقط

- على

- OpenAI

- عمليات

- الأمثل

- or

- OS

- أخرى

- لنا

- خارج

- على مدى

- الخاصة

- المعلمات

- جزء

- أجزاء

- PC

- أجهزة الكمبيوتر

- مجتمع

- إلى

- أداء

- الشخصية

- خطط

- المنصة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- المزيد

- البوينت

- قوة

- قوي

- توفير الطاقة

- سابقا

- خصوصية

- معالجة

- المعالجات

- تزود

- غرض

- دفع

- دفع

- وضع

- كوالكوم

- الاستفسارات

- بدلا

- RE

- سبب

- تلقى

- مؤخرا

- نسبيا

- تذكر

- عن بعد

- المتطلبات الأساسية

- الموارد

- على التوالي

- استجابة

- REST

- توالت

- طريق

- توجيه

- يجري

- تشغيل

- s

- قال

- قول

- يقول

- سيناريوهات

- الثاني

- انظر تعريف

- يبدو

- أرسلت

- مسلسلات

- خوادم

- باكجات

- الشكل

- نقل

- التحول

- ينبغي

- السيليكون

- منذ

- المقاس

- صغير

- الأصغر

- نبتة أنف العجل

- So

- تطبيقات الكمبيوتر

- بعض

- قريبا

- مصدر

- شفرة المصدر

- متخصص

- رياضي

- المسرح

- لا يزال

- وقف

- فروعنا

- أقوى

- ستوديو

- اشتراك

- هذه

- وتقترح

- جناح

- قمة

- مفاجأة

- أخذ

- مع الأخذ

- مهمة

- المهام

- مصطلح

- من

- أن

- •

- نظرية

- هناك.

- وبالتالي

- تشبه

- الأشياء

- اعتقد

- هذا الأسبوع

- هذا العام

- هؤلاء

- مرات

- إلى

- سويا

- الرموز

- جدا

- التوب

- قطار

- تريليون

- ضبطها

- عادة

- الترا

- مع

- وحدة

- الوحدات

- تستخدم

- مستخدم

- المستخدمين

- استخدام

- تشكيلة

- Ve

- الإصدار

- رؤيتنا

- بصري

- وكان

- we

- أسبوع

- كان

- ابحث عن

- متى

- التي

- لماذا

- سوف

- نوافذ

- مع

- بدون

- وون

- كلمات

- للعمل

- العالم

- سوف

- X

- عام

- حتى الآن

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- موقع YouTube

- زن

- زفيرنت