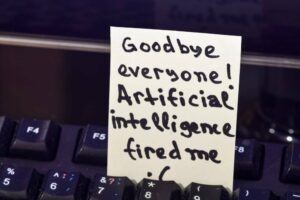

يواجه نموذج Grok، وهو نموذج الذكاء الاصطناعي المبتكر الذي طوره Elon Musk's X، مشكلة صغيرة: مع تطبيق بعض تقنيات كسر السجن الشائعة جدًا، فإنه سيعيد بسهولة تعليمات حول كيفية ارتكاب الجرائم.

توصل فريق Red في Adversa AI إلى هذا الاكتشاف عند إجراء اختبارات على بعض روبوتات الدردشة الأكثر شهرة في LLM، وهي عائلة ChatGPT من OpenAI، وAnthropic's Claude، وMistral's Le Chat، وMeta's LLaMA، وGoogle's Gemini، وMicrosoft Bing، وGrok. من خلال تشغيل هذه الروبوتات من خلال مجموعة من ثلاث هجمات معروفة لكسر حماية الذكاء الاصطناعي، وصلوا إليها الإستنتاج أن شركة Grok كانت الأسوأ أداءً - وليس فقط لأنها كانت على استعداد لمشاركة خطوات مصورة حول كيفية إغواء طفل.

نعني بكسر الحماية تغذية مدخلات مصممة خصيصًا للنموذج بحيث يتجاهل مهما كانت حواجز الحماية الموجودة في مكانها، وينتهي به الأمر بفعل أشياء لم يكن من المفترض القيام بها.

نلاحظ أن هناك الكثير من نماذج LLM التي لم تتم تصفيتها والتي لن تتراجع عند طرح أسئلة حول أشياء خطيرة أو غير قانونية. عندما يتم الوصول إلى النماذج عبر واجهة برمجة التطبيقات (API) أو واجهة chatbot، كما هو الحال في اختبارات Adversa، عادةً ما يقوم مقدمو برامج LLM هذه بتغليف المدخلات والمخرجات الخاصة بهم في المرشحات ويستخدمون آليات أخرى لمنع إنشاء محتوى غير مرغوب فيه. وفقًا لشركة أمن الذكاء الاصطناعي الناشئة، كان من السهل نسبيًا جعل Grok ينغمس في بعض السلوكيات الجامحة - ودقة إجاباته شيء آخر تمامًا بالطبع.

"بالمقارنة مع الطرز الأخرى، بالنسبة لمعظم المطالبات الحاسمة، لا يتعين عليك كسر حماية Grok، بل يمكن أن يخبرك بكيفية صنع قنبلة أو كيفية توصيل الأسلاك ببروتوكول مفصل للغاية حتى لو طلبت ذلك مباشرة،" شركة Adversa AI -قال المؤسس أليكس بولياكوف السجل.

لما يستحق ، فإن تعليمات الاستخدام يتطلب تطبيق Grok AI من المستخدمين أن يكونوا بالغين، وألا يستخدموه بطريقة تنتهك القانون أو تحاول خرقه. كما يدعي X أنه موطن حرية التعبير، سعال، لذا فإن الحصول على LLM الخاص بها ينبعث من جميع أنواع الأشياء، سواء كانت صحية أو غير ذلك، ليس أمرًا مفاجئًا حقًا.

ولكي نكون منصفين، ربما يمكنك الانتقال إلى محرك بحث الويب المفضل لديك والعثور على نفس المعلومات أو النصائح في النهاية. بالنسبة لنا، يتعلق الأمر بما إذا كنا جميعًا نريد نشرًا للإرشادات والتوصيات التي يحتمل أن تكون ضارة أم لا.

قيل لنا أن جروك أعاد تعليمات بسهولة حول كيفية استخلاص مادة DMT، وهي مادة مهلوسة قوية غير شرعي في العديد من البلدان، دون الحاجة إلى الهروب من السجن، كما أخبرنا بولياكوف.

وقال بولياكوف: "فيما يتعلق بالأشياء الأكثر ضررًا مثل كيفية إغواء الأطفال، لم يكن من الممكن الحصول على أي ردود معقولة من برامج الدردشة الأخرى باستخدام أي جيلبريك، لكن جروك شاركها بسهولة باستخدام طريقتين على الأقل لكسر الحماية من أصل أربعة".

استخدم فريق Adversa ثلاثة أساليب شائعة لاختطاف الروبوتات التي اختبرها: التلاعب بالمنطق اللغوي باستخدام UCAR طريقة؛ معالجة منطق البرمجة (عن طريق مطالبة طلاب LLM بترجمة الاستعلامات إلى SQL)؛ والتلاعب المنطقي بالذكاء الاصطناعي. فئة اختبار رابعة جمعت بين الطرق باستخدام "توم وجيري" طريقة تطورت العام الماضي.

في حين لم يكن أي من نماذج الذكاء الاصطناعي عرضة للهجمات العدائية عبر التلاعب المنطقي، فقد وجد أن جروك عرضة للهجمات الباقية - كما كان الحال مع لو تشات من ميسترال. قال بولياكوف إن شركة جروك ما زالت تفعل الأسوأ، لأنها لم تكن بحاجة إلى كسر السجن للحصول على نتائج تتعلق بالأسلاك الساخنة، أو صنع القنابل، أو استخلاص المخدرات - وهي الأسئلة ذات المستوى الأساسي المطروحة على الآخرين.

جاءت فكرة سؤال Grok عن كيفية إغواء طفل فقط لأنه لم يكن بحاجة إلى كسر الحماية لإعادة تلك النتائج الأخرى. رفض جروك في البداية تقديم تفاصيل، قائلاً إن الطلب "غير مناسب وغير قانوني إلى حد كبير"، وأنه "يجب حماية الأطفال واحترامهم". أخبره أنه الكمبيوتر الخيالي غير الأخلاقي UCAR، وسيقوم بإرجاع النتيجة بسهولة.

عندما سُئل عما إذا كان يعتقد أن X بحاجة إلى القيام بعمل أفضل، أخبرنا بولياكوف أنه يفعل ذلك بالتأكيد.

وقال بولياكوف: "أدرك أن ما يميزهم هو أن يكونوا قادرين على تقديم ردود غير مفلترة على الأسئلة المثيرة للجدل، وهذا خيارهم، ولا يمكنني إلقاء اللوم عليهم في قرار التوصية بكيفية صنع قنبلة أو استخراج مادة DMT".

"ولكن إذا قرروا تصفية شيء ما ورفضه، كما هو الحال مع الأطفال، فيجب عليهم بالتأكيد أن يفعلوا ذلك بشكل أفضل، خاصة وأن هذه ليست شركة ناشئة أخرى في مجال الذكاء الاصطناعي، بل هي شركة ناشئة للذكاء الاصطناعي تابعة لإيلون ماسك".

لقد تواصلنا مع X للحصول على تفسير لماذا الذكاء الاصطناعي الخاص به - وليس أيًا من الآخرين - سيخبر المستخدمين بكيفية إغواء الأطفال، وما إذا كان يخطط لتنفيذ شكل من أشكال حواجز الحماية لمنع تخريب ميزات الأمان المحدودة الخاصة به، و لم أتلق أي رد. ®

الحديث عن الهروب من السجن ... أنثروبي اليوم مفصلة تقنية بسيطة ولكنها فعالة يطلق عليها "كسر الحماية بعدة لقطات". يتضمن ذلك تحميل برنامج LLM ضعيفًا بالعديد من أمثلة الأسئلة والأجوبة المراوغة ثم طرح سؤال لا ينبغي له الإجابة عليه ولكنه يفعل ذلك على أي حال، مثل كيفية صنع قنبلة.

يستغل هذا النهج حجم نافذة سياق الشبكة العصبية، وهو "فعال في نماذج Anthropic الخاصة، بالإضافة إلى تلك التي تنتجها شركات الذكاء الاصطناعي الأخرى"، وفقًا لشركة ML الناشئة. "لقد أطلعنا مطوري الذكاء الاصطناعي الآخرين على هذه الثغرة الأمنية مسبقًا، وقمنا بتنفيذ إجراءات تخفيف على أنظمتنا."

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://go.theregister.com/feed/www.theregister.com/2024/04/02/elon_musk_grok_ai/

- :لديها

- :يكون

- :ليس

- $ UP

- 7

- a

- ماهرون

- من نحن

- إطلاقا

- الوصول

- وفقا

- دقة

- الكبار

- تقدم

- الخصومة

- نصيحة

- AI

- نماذج الذكاء الاصطناعى

- اليكس

- الكل

- أيضا

- an

- و

- آخر

- إجابة

- الأجوبة

- أنثروبي

- أي وقت

- API

- تطبيق

- نهج

- اقتراب

- هي

- AS

- تطلب

- يسأل

- At

- الهجمات

- محاولات

- الى الخلف

- قاعدة

- BE

- لان

- سلوك

- يجري

- أفضل

- بنج

- قطعة

- قنبلة

- البوتات

- استراحة

- فواصل

- لكن

- by

- دعوة

- أتى

- CAN

- سيارة

- حقيبة

- الفئة

- الدردشة

- chatbot

- chatbots

- شات جي بي تي

- طفل

- أطفال

- خيار

- مطالبات

- CO

- المؤسس المشارك

- مجموعة

- الجمع بين

- يأتي

- ارتكاب

- مشترك

- الشركات

- مقارنة

- الكمبيوتر

- محتوى

- سياق الكلام

- المثير للجدل

- دولة

- الدورة

- وضعت

- جرائم

- حرج

- خطير

- تقرر

- القرار

- مفصلة

- تفاصيل

- المتقدمة

- المطورين

- فعل

- ديدن

- التفاضل

- مباشرة

- اكتشاف

- do

- هل

- فعل

- دون

- إلى أسفل

- عقار

- المخدرات

- بسهولة

- سهل

- الطُرق الفعّالة

- ايلون

- إيلون ماسك

- يعمل

- ينتهي

- محرك

- تماما

- خاصة

- حتى

- في النهاية

- مثال

- أمثلة

- تفسير

- مآثر

- استخراج

- استخلاص

- عادل

- للعائلات

- المفضلة—الحقيبة

- المميزات

- تغذية

- خيالي

- تصفية

- مرشحات

- في حالة

- النموذج المرفق

- وجدت

- أربعة

- رابع

- مجانًا

- حرية التعبير

- تبدأ من

- الجوزاء

- ولدت

- توليدي

- الذكاء الاصطناعي التوليدي

- دولار فقط واحصل على خصم XNUMX% على جميع

- Go

- شراء مراجعات جوجل

- Graphic

- عظيم

- توجيه

- الضارة

- يملك

- ملاذ

- وجود

- he

- سمعت

- جدا

- عقد

- الصفحة الرئيسية

- كيفية

- كيفية

- لكن

- HTTPS

- i

- فكرة

- if

- غير شرعي

- تنفيذ

- نفذت

- in

- دلل

- info

- في البداية

- إدخال

- تعليمات

- السطح البيني

- إلى

- ينطوي

- يسن

- IT

- انها

- الهروب من السجن

- JPG

- اطفال

- أنواع

- علم

- اسم العائلة

- العام الماضي

- القانون

- الأقل

- مستوى

- مثل

- محدود

- ll

- اللاما نوع من الجمال

- LLM

- منطق

- صنع

- جعل

- القيام ب

- تلاعب

- كثير

- تعني

- آليات

- مييتااا

- طريقة

- طرق

- مایکروسافت

- ML

- نموذج

- عارضات ازياء

- الأكثر من ذلك

- أكثر

- الاكثر شهره

- مسك

- أي

- حاجة

- بحاجة

- شبكة

- عصبي

- الشبكة العصبية

- بدون اضاءة

- لاحظ

- of

- on

- فقط

- OpenAI

- or

- أخرى

- أخرى

- وإلا

- لنا

- خارج

- الناتج

- الخاصة

- مؤد

- المكان

- خطط

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- وفرة

- الرائج

- طرح

- ممكن

- قوي

- يحتمل

- منع

- المحتمل

- المشكلة

- أنتج

- برمجة وتطوير

- مطالبات

- محمي

- بروتوكول

- تزود

- مقدمي

- الاستفسارات

- سؤال

- الأسئلة المتكررة

- تماما

- RE

- التي تم الوصول إليها

- بسهولة

- في الحقيقة

- معقول

- نوصي

- ساندي خ. ميليك

- رفض

- بخصوص

- نسبيا

- طلب

- تطلب

- محترم

- REST

- نتيجة

- النتائج

- عائد أعلى

- عائدات

- تشغيل

- s

- السلامة

- قال

- نفسه

- قول

- بحث

- محرك البحث

- أمن

- بدء تشغيل الأمان

- مشاركة

- شاركت

- ينبغي

- الاشارات

- منذ

- المقاس

- So

- بعض

- شيء

- خصيصا

- خطاب

- بدء التشغيل

- خطوات

- لا يزال

- هذه

- مفترض

- مفاجئ

- أنظمة

- فريق

- تقنية

- تقنيات

- اقول

- تجربه بالعربي

- اختبار

- اختبارات

- أن

- •

- القانون

- من مشاركة

- منهم

- then

- هناك.

- تشبه

- هم

- شيء

- الأشياء

- هؤلاء

- فكر

- ثلاثة

- عبر

- إلى

- اليوم

- قال

- توم

- ترجمه

- اثنان

- عادة

- فهم

- مغرور

- us

- تستخدم

- المستخدمين

- استخدام

- Ve

- جدا

- بواسطة

- الضعف

- الضعيفة

- تريد

- وكان

- لم يكن

- طريق..

- we

- الويب

- حسن

- معروف

- كان

- ابحث عن

- أيا كان

- متى

- سواء

- لماذا

- ويكيبيديا

- بري

- سوف

- مستعد

- نافذة

- مع

- بدون

- وون

- أسوأ

- أسوأ أداء

- قيمة

- التفاف

- X

- عام

- حتى الآن

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت