يشعر الأمريكيون بالقلق من الاستخدام المتزايد للذكاء الاصطناعي (AI) في توظيف وتقييم العمال ، وفقًا لدراسة جديدة صادرة عن مركز بيو للأبحاث.

بيو للأبحاث شملهم الاستطلاع 11,004،2022 بالغًا أمريكيًا في منتصف ديسمبر XNUMX ، يسألون المشاركين عن آرائهم حول تأثير الذكاء الاصطناعي على القوى العاملة. بينما أقر بعض المستجيبين بكفاءة التوظيف المدفوع بالذكاء الاصطناعي ، أعرب الكثيرون عن مخاوفهم من أن التكنولوجيا قد تنتهك الخصوصية ، وتؤثر على التقييمات ، وتؤدي إلى فقدان الوظائف.

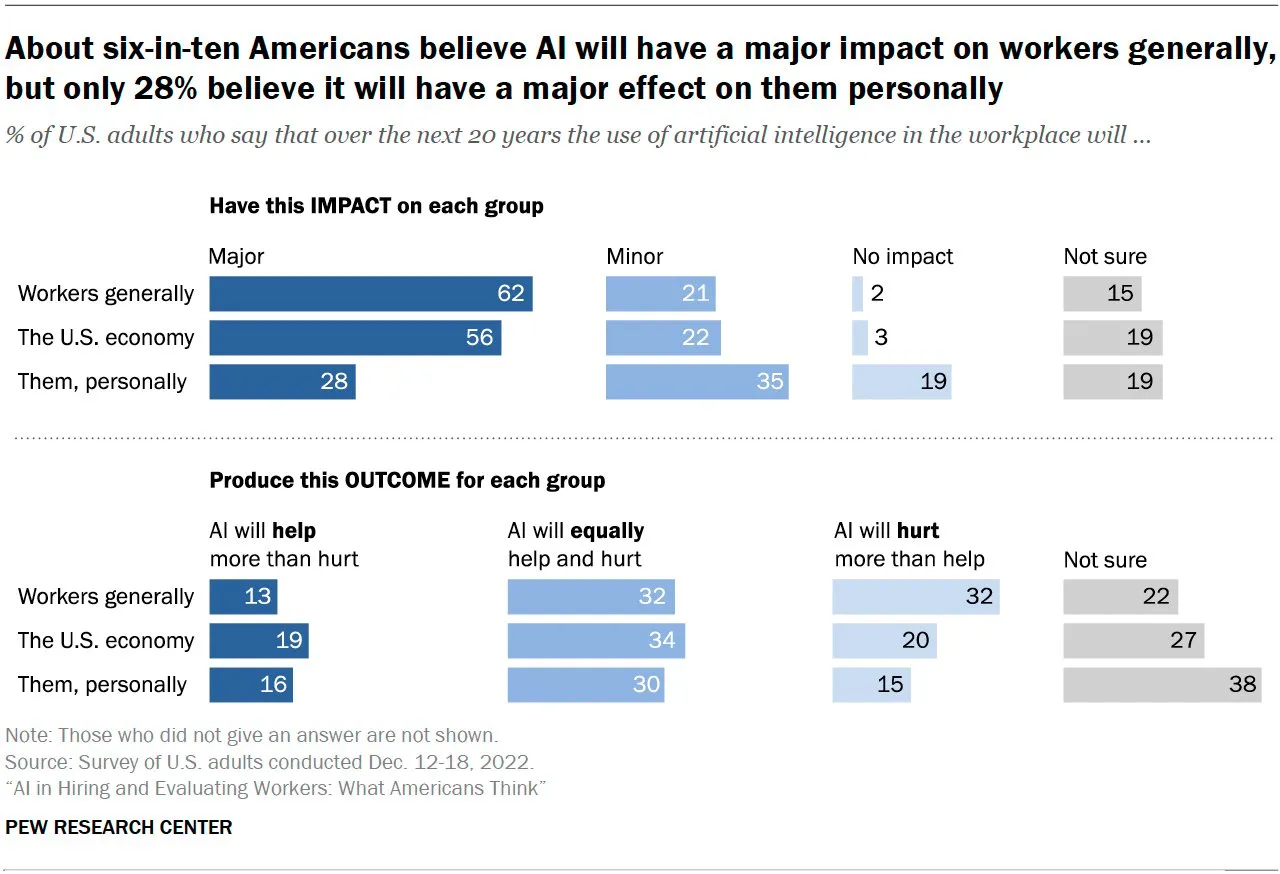

وفقًا للدراسة ، التي نُشرت يوم الخميس ، يعتقد 32٪ من الأمريكيين أن الذكاء الاصطناعي في توظيف وتقييم العمال من المرجح أن يضر المتقدمين للوظائف والموظفين بدلاً من مساعدتهم.

يعارض واحد وسبعون بالمائة من المواطنين الأمريكيين فكرة استخدام الذكاء الاصطناعي لتقرير ما إذا كان سيتم تعيين شخص ما أو فصله من العمل. من ناحية أخرى ، وجدت الدراسة أن 40٪ من الأمريكيين ما زالوا يعتقدون أن الذكاء الاصطناعي يمكن أن يوفر فوائد للمتقدمين للوظائف والموظفين من خلال تسريع عمليات التوظيف ، وتقليل الأخطاء البشرية ، والقضاء على التحيزات المحتملة الكامنة في صنع القرار البشري. كما سلط بعض المستجيبين الضوء على إمكانات تقييمات الأداء التي يحركها الذكاء الاصطناعي لتوفير تقييم أكثر موضوعية واتساقًا لمهارات العاملين وإنتاجيتهم.

يكشف البحث أن 32٪ من الأمريكيين يعتقدون أنه على مدار العشرين عامًا القادمة ، سيُلحق الذكاء الاصطناعي ضررًا أكثر من نفعه للعمال ، حيث أظهر 20٪ فقط وجهة نظر متفائلة ، مع قول ما يقرب من ثلثي المستجيبين إنهم لن يتقدموا بطلب. لوظيفة إذا علموا أنهم سيخضعون للتقييم بواسطة الذكاء الاصطناعي.

تمتد هذه المخاوف إلى جوانب مختلفة من عملية التوظيف ، من استئناف الفرز وتقييم المتقدمين إلى مراقبة الأداء وقرارات الموظفين. يسلط التقرير الضوء على قلق غالبية المشاركين من أن أنظمة الذكاء الاصطناعي ستنتهك خصوصيتهم من خلال جمع الكثير من المعلومات الشخصية ، مثل سجل التصفح أو نشاط وسائل التواصل الاجتماعي. وتقول الدراسة إن تسعين بالمائة من عمال الطبقة العليا ، و 84 بالمائة من عمال الطبقة المتوسطة ، و 70 بالمائة من عمال الطبقة الدنيا لديهم مخاوف من "التعرض للمراقبة بشكل غير لائق إذا تم استخدام الذكاء الاصطناعي لجمع المعلومات وتحليلها".

معالجة المخاوف: السياسة والشفافية والتعليم

مع استمرار الذكاء الاصطناعي في تحقيق تقدم في القوى العاملة ، كان قادة صناعة التكنولوجيا يضغطون من أجل صانعي السياسات والشركات والمطورين لمعالجة مخاوف الجمهور. في الاتحاد الأوروبي ، على سبيل المثال ، حاول المنظمون منع إساءة الاستخدام المحتملة من خلال الدعوة الشفافية في أنظمة الذكاء الاصطناعيوالتعليم والتدريب للعمال للتكيف مع المشهد الوظيفي سريع التغير. يمتلك بعض أشهر العقول في صناعة الذكاء الاصطناعي دعا إلى وقفة في تدريب نماذج أكثر تقدمًا في محاولة لمعالجة هذه المشكلات قبل فوات الأوان.

وفي الوقت نفسه ، بدأ المنظمون في الاهتمام بكيفية تدريب نماذج الذكاء الاصطناعي هذه وكيف يمكن أن تؤثر على حقوق المواطنين. اتخذت إيطاليا الخطوة الأولى عندما حظرت استخدام ChatGPT في البلاد على أساس أنها قد تجمع البيانات بشكل غير قانوني من مستخدميها وتعريض القاصرين للتفاعلات غير الملائمة.

دول أوروبية أخرى كما أعربوا عن مخاوف مماثلة، خاصة لأن نماذج الذكاء الاصطناعي مفيدة بشكل خاص إذا تم تدريبها بشكل صحيح - الأمر الذي يتطلب كميات كبيرة من البيانات.

يقدم الدور المتنامي للذكاء الاصطناعي في مكان العمل فوائد ومخاوف ، مثل الخصوصية والإنصاف والتمييز. من خلال اتباع نهج استباقي للسياسة والشفافية والتعليم ، يتطلع السياسيون إلى ضمان أن يعمل الذكاء الاصطناعي كقوة من أجل الخير - مما يؤكد أن نماذج الذكاء الاصطناعي ستكون مديرين جيدين ليس شيئًا يدور في أذهانهم في الوقت الحالي.

ابق على اطلاع بأخبار العملات المشفرة ، واحصل على تحديثات يومية في صندوق الوارد الخاص بك.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- بلاتوبلوكشين. Web3 Metaverse Intelligence. تضخيم المعرفة. الوصول هنا.

- سك المستقبل مع أدرين أشلي. الوصول هنا.

- المصدر https://decrypt.co/137421/ai-has-most-americans-scared-about-privacy-job-losses