تتسابق المنظمات في جميع أنحاء العالم لاعتماد تقنيات الذكاء الاصطناعي في برامج وأدوات الأمن السيبراني الخاصة بها. أ غالبية المطورين (65٪) استخدام أو التخطيط استخدام الذكاء الاصطناعي في اختبار الجهود في السنوات الثلاث المقبلة. هناك العديد من تطبيقات الأمان التي ستستفيد من الذكاء الاصطناعي التوليدي ، لكن هل يعد إصلاح الكود أحد هذه التطبيقات؟

بالنسبة للعديد من فرق DevSecOps ، يمثل الذكاء الاصطناعي التوليدي الكأس المقدسة لإزالة تراكم الثغرات الأمنية المتزايدة. أكثر من النصف (66٪) من المنظمات تقول إن تراكمها يتكون من أكثر من 100,000 نقطة ضعف ، وأن أكثر من ثلثي نتائج اختبار أمان التطبيقات الثابتة (SAST) التي تم الإبلاغ عنها تظل مفتوحة بعد ثلاثة أشهر من الاكتشاف ، مع 50٪ متبقية مفتوحة بعد 363 يومًا. الحلم هو أنه يمكن للمطور أن يطلب ببساطة من ChatGPT "إصلاح هذه الثغرة الأمنية" ، وأن الساعات والأيام التي قضاها سابقًا في معالجة الثغرات ستكون شيئًا من الماضي.

إنها ليست فكرة مجنونة تمامًا ، من الناحية النظرية. بعد كل شيء ، تم استخدام التعلم الآلي بشكل فعال في أدوات الأمن السيبراني لسنوات لأتمتة العمليات وتوفير الوقت - الذكاء الاصطناعي مفيد للغاية عند تطبيقه على المهام البسيطة والمتكررة. لكن تطبيق الذكاء الاصطناعي التوليدي على تطبيقات التعليمات البرمجية المعقدة به بعض العيوب في الممارسة العملية. بدون إشراف بشري وأمر صريح ، قد ينتهي الأمر بفرق DevSecOps إلى خلق مشاكل أكثر مما تحلها.

مزايا الذكاء الاصطناعي التوليدية والقيود المتعلقة بإصلاح التعليمات البرمجية

يمكن أن تكون أدوات الذكاء الاصطناعي أدوات قوية بشكل لا يصدق لتحليل أو مراقبة الأمن السيبراني البسيط ومنخفض المخاطر أو حتى الاحتياجات العلاجية. ينشأ القلق عندما تصبح المخاطر مترتبة على ذلك. هذه في النهاية مسألة ثقة.

لا يزال الباحثون والمطورون يحددون قدرات تقنية الذكاء الاصطناعي التوليدية الجديدة إنتاج إصلاحات التعليمات البرمجية المعقدة. يعتمد الذكاء الاصطناعي التوليدي على المعلومات الموجودة والمتاحة من أجل اتخاذ القرارات. يمكن أن يكون هذا مفيدًا لأشياء مثل ترجمة التعليمات البرمجية من لغة إلى أخرى ، أو إصلاح العيوب المعروفة. على سبيل المثال ، إذا طلبت من ChatGPT "كتابة كود JavaScript هذا في Python" ، فمن المحتمل أن تحصل على نتيجة جيدة. قد يكون استخدامه لإصلاح تكوين أمان السحابة مفيدًا لأن الوثائق ذات الصلة للقيام بذلك متاحة للجمهور ويمكن العثور عليها بسهولة ، ويمكن للذكاء الاصطناعي اتباع التعليمات البسيطة.

ومع ذلك ، يتطلب إصلاح معظم الثغرات الأمنية في التعليمات البرمجية التصرف بناءً على مجموعة فريدة من الظروف والتفاصيل ، وتقديم سيناريو أكثر تعقيدًا للتنقل فيه بواسطة الذكاء الاصطناعي. قد يوفر الذكاء الاصطناعي "إصلاحًا" ، لكن بدون التحقق ، لا ينبغي الوثوق به. الذكاء الاصطناعي التوليدي ، بحكم التعريف ، لا يمكنه إنشاء شيء غير معروف بالفعل ، ويمكن أن يعاني من الهلوسة التي تؤدي إلى مخرجات مزيفة.

في مثال حديث ، يواجه المحامي عواقب وخيمة بعد استخدامه ChatGPT للمساعدة في كتابة ملفات المحكمة التي استشهدت بست حالات غير موجودة اخترعتها أداة الذكاء الاصطناعي. إذا كان على الذكاء الاصطناعي أن يهلوس الأساليب غير الموجودة ثم طبق تلك الأساليب على كتابة التعليمات البرمجية ، فسيؤدي ذلك إلى إهدار الوقت في "الإصلاح" الذي لا يمكن تجميعه. بالإضافة إلى ذلك ، وفقًا لـ OpenAI's ورقة بيضاء GPT-4، سيتم اكتشاف المآثر الجديدة ، وعمليات كسر الحماية ، والسلوكيات الناشئة بمرور الوقت وسيكون من الصعب منعها. لذلك ، يلزم التفكير بعناية لضمان فحص أدوات أمان الذكاء الاصطناعي وحلول الجهات الخارجية وتحديثها بانتظام لضمان عدم تحولها إلى أبواب خلفية غير مقصودة في النظام.

أن تثق أو لا تثق؟

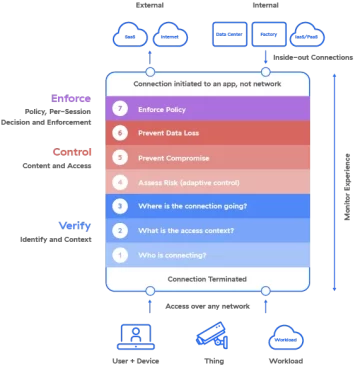

إنها ديناميكية مثيرة للاهتمام أن نرى التبني السريع للذكاء الاصطناعي التوليدي يظهر في ذروة حركة انعدام الثقة. تُبنى غالبية أدوات الأمن السيبراني على فكرة أنه لا ينبغي للمنظمات أبدًا الوثوق والتحقق دائمًا. يُبنى الذكاء الاصطناعي التوليدي على مبدأ الثقة المتأصلة في المعلومات المتاحة له من قبل مصادر معروفة وغير معروفة. يبدو هذا الصدام في المبادئ وكأنه استعارة مناسبة للنضال المستمر الذي تواجهه المنظمات في إيجاد التوازن الصحيح بين الأمن والإنتاجية ، والذي يبدو أنه يتفاقم بشكل خاص في هذه اللحظة.

في حين أن الذكاء الاصطناعي التوليدي قد لا يكون الكأس المقدسة التي كانت فرق DevSecOps تأمل في تحقيقها ، إلا أنه سيساعد على إحراز تقدم تدريجي في تقليل تراكم الثغرات الأمنية. في الوقت الحالي ، يمكن تطبيقه لإجراء إصلاحات بسيطة. للحصول على إصلاحات أكثر تعقيدًا ، سيحتاجون إلى اعتماد منهجية التحقق من الثقة التي تسخر قوة الذكاء الاصطناعي التي تسترشد بمعرفة المطورين الذين كتبوا الرمز ويمتلكونه.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون السيارات / المركبات الكهربائية ، كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- BlockOffsets. تحديث ملكية الأوفست البيئية. الوصول هنا.

- المصدر https://www.darkreading.com/application-security/can-generative-ai-be-trusted-to-fix-your-code-

- :لديها

- :يكون

- :ليس

- $ UP

- 000

- 100

- 7

- a

- وفقا

- التمثيل

- وبالإضافة إلى ذلك

- تبنى

- تبني

- مزايا

- بعد

- AI

- الكل

- سابقا

- دائما

- an

- تحليل

- و

- آخر

- تطبيق

- أمان التطبيق

- التطبيقات

- تطبيقي

- التقديم

- تطبيق

- هي

- At

- أتمتة

- متاح

- خلفي

- الرصيد

- BE

- لان

- أصبح

- كان

- مفيد

- تستفيد

- ما بين

- بنيت

- لكن

- by

- CAN

- قدرات

- حذر

- الحالات

- شات جي بي تي

- ظروف

- استشهد

- اشتباك

- المقاصة

- سحابة

- سحابة الأمن

- الكود

- مجمع

- تتألف

- قلق

- الاعداد

- النتائج

- مترابط منطقيا

- نظر

- استطاع

- محكمة

- إيداعات المحكمة

- مجنون

- خلق

- خلق

- الأمن السيبراني

- أيام

- القرارات

- تعريف

- تفاصيل

- كشف

- تحديد

- المطور

- المطورين

- صعبة

- اكتشف

- do

- توثيق

- حلم

- ديناميكي

- بسهولة

- على نحو فعال

- النهاية

- ضمان

- تماما

- حتى

- مثال

- يوجد

- القائمة

- الخبره في مجال الغطس

- مآثر

- التعبير

- الوجه

- مواجهة

- زائف

- برادة

- العثور على

- النتائج

- تركيبات

- حل

- العيوب

- اتباع

- في حالة

- وجدت

- تبدأ من

- توليدي

- الذكاء الاصطناعي التوليدي

- دولار فقط واحصل على خصم XNUMX% على جميع

- خير

- نصفي

- ارتفاع

- مساعدة

- مفيد

- أمل

- ساعات العمل

- HTML

- HTTPS

- بشكل هائل

- الانسان

- فكرة

- if

- in

- في ازدياد

- لا يصدق

- معلومات

- متأصل

- تعليمات

- وكتابة مواضيع مثيرة للاهتمام

- إلى

- إدخال

- اخترع

- قضية

- IT

- جافا سكريبت

- JPG

- المعرفة

- معروف

- لغة

- محامي

- تعلم

- مثل

- على الأرجح

- القيود

- ll

- خطر قليل

- آلة

- آلة التعلم

- صنع

- أغلبية

- جعل

- كثير

- آلية العمل

- طرق

- ربما

- لحظة

- مراقبة

- المقبلة.

- الأكثر من ذلك

- أكثر

- حركة

- التنقل

- حاجة

- إحتياجات

- أبدا

- جديد

- التالي

- معدوم

- الآن

- of

- on

- ONE

- جاكيت

- OpenAI

- or

- طلب

- المنظمات

- خارج

- على مدى

- مراقبة

- الخاصة

- خاصة

- الماضي

- خطة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- بلايستشن

- قوة

- قوي

- ممارسة

- منع

- سابقا

- مبدأ

- مبادئ

- مشاكل

- العمليات

- إنتاجية

- البرامج

- التقدّم

- تزود

- علانية

- بايثون

- سباق

- سريع

- الأخيرة

- تقليص

- بانتظام

- ذات صلة

- ذات الصلة

- لا تزال

- المتبقية

- تكرارية

- وذكرت

- يمثل

- مطلوب

- يتطلب

- نتيجة

- حق

- s

- حفظ

- قول

- سيناريو

- أمن

- انظر تعريف

- يبدو

- جدي

- طقم

- ينبغي

- الاشارات

- ببساطة

- SIX

- So

- الحلول

- حل

- بعض

- شيء

- مصادر

- قضى

- لا يزال

- النضال

- نظام

- المهام

- فريق

- التكنولوجيا

- تكنولوجيا

- الاختبار

- من

- أن

- •

- المعلومات

- من مشاركة

- منهم

- then

- نظرية

- هناك.

- هم

- شيء

- الأشياء

- طرف ثالث

- هؤلاء

- ثلاثة

- الوقت

- إلى

- أداة

- أدوات

- الثقة

- افضل

- الثلثين

- في النهاية

- فريد من نوعه

- غير معروف

- تحديث

- تستخدم

- مستعمل

- استخدام

- التحقق

- تحقق من

- فحص

- نقاط الضعف

- الضعف

- معروف

- كان

- متى

- التي

- من الذى

- سوف

- مع

- بدون

- في جميع أنحاء العالم

- سوف

- اكتب

- جاري الكتابة

- سنوات

- حتى الآن

- أنت

- حل متجر العقارات الشامل الخاص بك في جورجيا

- زفيرنت