نظرًا لأن التعلم الآلي (ML) أصبح سائدًا واكتسب اعتمادًا على نطاق أوسع ، أصبحت التطبيقات التي تعمل بنظام ML أكثر شيوعًا لحل مجموعة من مشاكل الأعمال المعقدة. غالبًا ما يتطلب حل مشاكل العمل المعقدة هذه استخدام نماذج ML متعددة. يمكن دمج هذه النماذج بشكل تسلسلي لأداء مهام مختلفة ، مثل المعالجة المسبقة ، وتحويل البيانات ، واختيار النموذج ، وتوليد الاستدلال ، ودمج الاستدلال ، والمعالجة اللاحقة. تحتاج المنظمات إلى خيارات مرنة لتنظيم تدفقات عمل تعلم الآلة المعقدة هذه. خطوط أنابيب الاستدلال التسلسلي هي أحد أنماط التصميم هذه لترتيب تدفقات العمل هذه في سلسلة من الخطوات ، مع إثراء كل خطوة أو معالجة إضافية للمخرجات الناتجة عن الخطوات السابقة وتمرير الإخراج إلى الخطوة التالية في خط الأنابيب.

بالإضافة إلى ذلك ، يجب أن توفر خطوط أنابيب الاستدلال التسلسلي هذه ما يلي:

- التنفيذ المرن والمخصص (التبعيات ، والخوارزميات ، ومنطق العمل ، وما إلى ذلك)

- قابل للتكرار ومتسق لتنفيذ الإنتاج

- رفع الأحمال الثقيلة غير المتمايزة عن طريق تقليل إدارة البنية التحتية

في هذا المنشور ، نلقي نظرة على بعض حالات الاستخدام الشائعة لخطوط أنابيب الاستدلال التسلسلي وننتقل عبر بعض خيارات التنفيذ لكل حالة من حالات الاستخدام هذه باستخدام الأمازون SageMaker. نناقش أيضًا الاعتبارات الخاصة بكل خيار من خيارات التنفيذ هذه.

يلخص الجدول التالي حالات الاستخدام المختلفة للاستدلال التسلسلي واعتبارات وخيارات التنفيذ. هذه تمت مناقشتها في هذا المنشور.

| استخدام القضية | وصف حالة الاستخدام | اعتبارات أولية | تعقيد التنفيذ بشكل عام | خيارات التنفيذ الموصى بها | عينة من القطع الأثرية في التعليمات البرمجية وأجهزة الكمبيوتر المحمولة |

| خط أنابيب الاستدلال التسلسلي (مع تضمين خطوات المعالجة المسبقة والمعالجة اللاحقة) | يحتاج خط أنابيب الاستدلال إلى المعالجة المسبقة للبيانات الواردة قبل استدعاء نموذج مدرب لتوليد الاستنتاجات ، ثم الاستدلالات التي تم إنشاؤها بعد العملية ، بحيث يمكن استهلاكها بسهولة بواسطة التطبيقات النهائية | سهولة التنفيذ | منخفض | حاوية الاستدلال باستخدام مجموعة أدوات الاستدلال SageMaker | انشر نموذج PyTorch المدرّب |

| خط أنابيب الاستدلال التسلسلي (مع تضمين خطوات المعالجة المسبقة والمعالجة اللاحقة) | يحتاج خط أنابيب الاستدلال إلى المعالجة المسبقة للبيانات الواردة قبل استدعاء نموذج مدرب لتوليد الاستنتاجات ، ثم الاستدلالات التي تم إنشاؤها بعد العملية ، بحيث يمكن استهلاكها بسهولة بواسطة التطبيقات النهائية | الفصل والتبسيط والنشر والترقيات | متوسط | خط أنابيب الاستدلال SageMaker | خط أنابيب الاستدلال مع حاويات مخصصة و xgBoost |

| مجموعة النموذج التسلسلي | يحتاج خط أنابيب الاستدلال إلى استضافة نماذج متعددة وترتيبها بالتتابع ، بحيث يعزز كل نموذج الاستدلال الناتج عن النموذج السابق ، قبل إنشاء الاستنتاج النهائي | الفصل والتبسيط والنشر والترقيات والمرونة في اختيار إطار النموذج | متوسط | خط أنابيب الاستدلال SageMaker | خط أنابيب الاستدلال مع Scikit-Learn و Linear Learner |

| خط أنابيب الاستدلال التسلسلي (مع استدعاء نموذج مستهدف من مجموعة) | يحتاج خط أنابيب الاستدلال إلى استدعاء نموذج مخصص محدد من مجموعة من النماذج المنشورة ، بناءً على خصائص الطلب أو لتحسين التكلفة ، بالإضافة إلى مهام المعالجة المسبقة والمعالجة اللاحقة | تحسين التكلفة والتخصيص | مرتفع | خط أنابيب الاستدلال SageMaker مع نقاط نهاية متعددة النماذج (MMEs) | نقاط نهاية Amazon SageMaker متعددة النماذج باستخدام Linear Learner |

في الأقسام التالية ، نناقش كل حالة استخدام بمزيد من التفصيل.

خط أنابيب الاستدلال التسلسلي باستخدام حاويات الاستدلال

حالات استخدام خط أنابيب الاستدلال التسلسلي لها متطلبات للمعالجة المسبقة للبيانات الواردة قبل استدعاء نموذج ML مدرب مسبقًا لتوليد الاستدلالات. بالإضافة إلى ذلك ، في بعض الحالات ، قد تحتاج الاستنتاجات التي تم إنشاؤها إلى مزيد من المعالجة ، بحيث يمكن استهلاكها بسهولة بواسطة التطبيقات النهائية. هذا سيناريو شائع لحالات الاستخدام حيث يحتاج مصدر البيانات المتدفقة إلى المعالجة في الوقت الفعلي قبل أن يتم تركيب نموذج عليه. ومع ذلك ، يمكن أن تظهر حالة الاستخدام هذه للاستدلال الدفعي أيضًا.

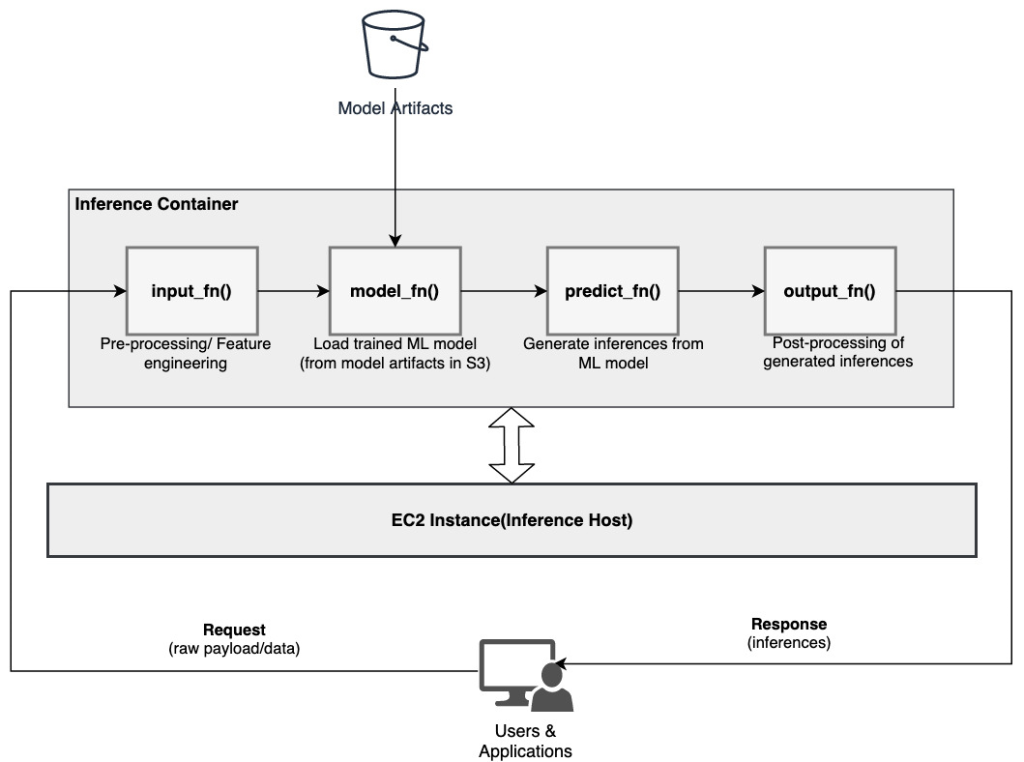

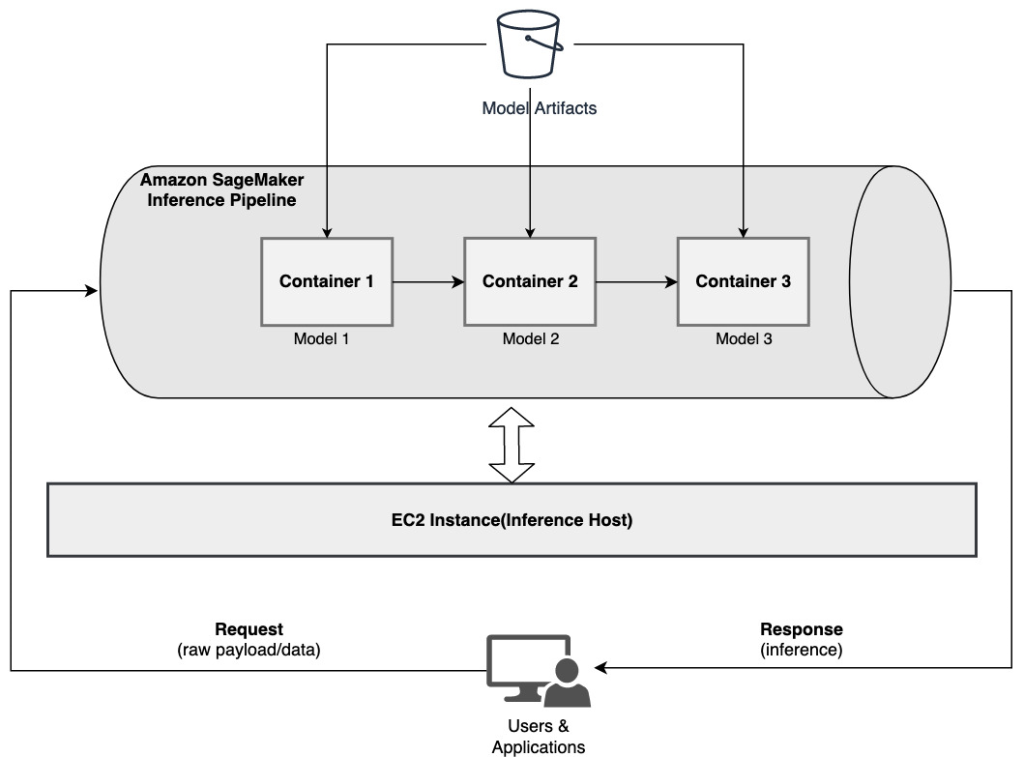

يوفر SageMaker خيارًا لتخصيص حاويات الاستدلال واستخدامها لبناء خط أنابيب استدلال تسلسلي. تستخدم حاويات الاستدلال ملف مجموعة أدوات الاستدلال SageMaker ومبنية عليها خادم SageMaker متعدد النماذج (MMS)، والذي يوفر آلية مرنة لخدمة نماذج ML. يوضح الرسم التخطيطي التالي نمطًا مرجعيًا لكيفية تنفيذ خط أنابيب الاستدلال التسلسلي باستخدام حاويات الاستدلال.

تتوقع SageMaker MMS وجود برنامج نصي بلغة Python يقوم بتنفيذ الوظائف التالية لتحميل النموذج ، وبيانات إدخال المعالجة المسبقة ، والحصول على تنبؤات من النموذج ، والمعالجة اللاحقة لبيانات الإخراج:

- input_fn () - مسؤول عن إلغاء تسلسل ومعالجة بيانات الإدخال

- model_fn () - مسئول عن تحميل النموذج المدرب من القطع الأثرية في خدمة تخزين أمازون البسيطة (أمازون إس 3)

- التنبؤ_fn () - مسؤول عن استخلاص الاستدلالات من النموذج

- output_fn () - مسؤول عن التسلسل والمعالجة اللاحقة لبيانات المخرجات (الاستدلالات)

للحصول على خطوات مفصلة لتخصيص حاوية الاستدلال ، يرجى الرجوع إلى تكييف حاوية الاستدلال الخاصة بك.

حاويات الاستدلال هي نمط تصميم مثالي لحالات استخدام خط أنابيب الاستدلال التسلسلي مع الاعتبارات الأساسية التالية:

- تماسك عالية - يحرك منطق المعالجة والنموذج المقابل وظيفة عمل واحدة وتحتاج إلى مكان مشترك

- كمون عام منخفض - الوقت المنقضي بين وقت تقديم طلب الاستنتاج وتلقي الاستجابة

في خط أنابيب الاستدلال التسلسلي ، يتم تغليف منطق ونموذج المعالجة داخل نفس الحاوية الفردية ، لذلك تظل الكثير من استدعاءات الاستدعاء داخل الحاوية. يساعد هذا في تقليل العدد الإجمالي للقفزات ، مما يؤدي إلى زمن انتقال واستجابة أفضل بشكل عام لخط الأنابيب.

أيضًا ، بالنسبة لحالات الاستخدام التي تكون فيها سهولة التنفيذ معيارًا مهمًا ، يمكن أن تساعد حاويات الاستدلال ، مع وجود خطوات معالجة مختلفة لخط الأنابيب داخل نفس الحاوية.

خط أنابيب الاستدلال التسلسلي باستخدام خط أنابيب الاستدلال SageMaker

يتطلب الاختلاف الآخر لحالة استخدام خط أنابيب الاستدلال التسلسلي فصلًا أوضح بين الخطوات المختلفة في خط الأنابيب (مثل المعالجة المسبقة للبيانات ، وتوليد الاستدلال ، والمعالجة اللاحقة للبيانات ، والتنسيق والتسلسل). قد يكون هذا بسبب مجموعة متنوعة من الأسباب:

- فصل - الخطوات المختلفة لخط الأنابيب لها غرض محدد بوضوح ويجب تشغيلها على حاويات منفصلة بسبب التبعيات الأساسية المعنية. يساعد هذا أيضًا في الحفاظ على تنظيم خط الأنابيب جيدًا.

- أُطر الأعمال - تستخدم الخطوات المختلفة لخط الأنابيب إطارات عمل محددة مناسبة للغرض (مثل scikit أو Spark ML) وبالتالي يلزم تشغيلها في حاويات منفصلة.

- عزل الموارد - الخطوات المختلفة لخط الأنابيب لها متطلبات متفاوتة لاستهلاك الموارد ، وبالتالي تحتاج إلى تشغيلها على حاويات منفصلة لمزيد من المرونة والتحكم.

علاوة على ذلك ، بالنسبة لخطوط أنابيب الاستدلال التسلسلي الأكثر تعقيدًا ، قد يتم تضمين خطوات متعددة لمعالجة طلب وإنشاء استنتاج. لذلك ، من وجهة نظر تشغيلية ، قد يكون من المفيد استضافة هذه الخطوات على حاويات منفصلة لعزل وظيفي أفضل ، وتسهيل الترقيات والتعزيزات الأسهل (قم بتغيير خطوة واحدة دون التأثير على النماذج الأخرى أو خطوات المعالجة).

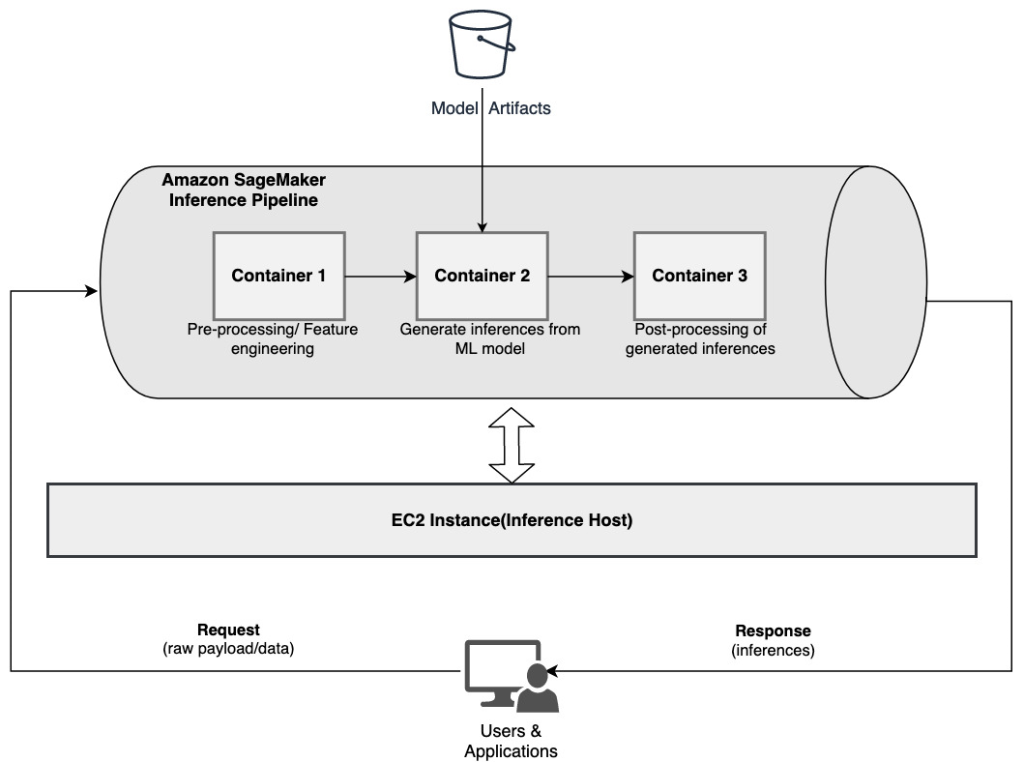

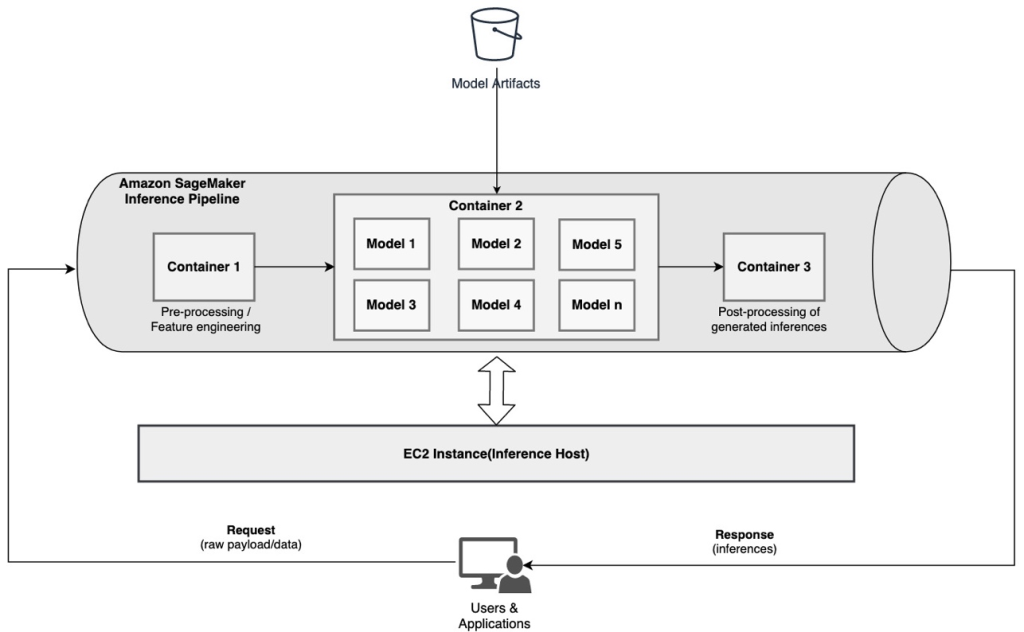

إذا كانت حالة الاستخدام الخاصة بك متوافقة مع بعض هذه الاعتبارات ، أ خط أنابيب الاستدلال SageMaker يوفر خيارًا سهلاً ومرنًا لبناء خط أنابيب استدلال تسلسلي. يوضح الرسم التخطيطي التالي نمطًا مرجعيًا لكيفية تنفيذ خط أنابيب الاستدلال التسلسلي باستخدام خطوات متعددة مستضافة على حاويات مخصصة باستخدام خط أنابيب استدلال SageMaker.

يتكون خط أنابيب الاستدلال من SageMaker من تسلسل خطي من 2-15 حاوية تعالج طلبات الاستدلالات على البيانات. يوفر خط أنابيب الاستدلال خيارًا لاستخدام خوارزميات SageMaker المضمنة مسبقًا أو الخوارزميات المخصصة والمعبأة في حاويات Docker. يتم استضافة الحاويات على نفس المثيل الأساسي ، مما يساعد على تقليل زمن الوصول الإجمالي وتقليل التكلفة.

يوضح مقتطف الشفرة التالي كيف يمكن دمج خطوات ونماذج معالجة متعددة لإنشاء خط أنابيب استدلال تسلسلي.

نبدأ من خلال بناء وتحديد النماذج المستندة إلى Spark ML و XGBoost التي نعتزم استخدامها كجزء من خط الأنابيب:

ثم يتم ترتيب النماذج بالتسلسل ضمن تعريف نموذج خط الأنابيب:

يتم بعد ذلك نشر خط أنابيب الاستدلال خلف نقطة نهاية للاستدلال في الوقت الفعلي عن طريق تحديد نوع وعدد مثيلات ML للمضيف:

يمكن اعتبار خط أنابيب الاستدلال المجمع بأكمله نموذج SageMaker الذي يمكنك استخدامه لإجراء تنبؤات في الوقت الفعلي أو عمليات تحويل دفعة مباشرة ، دون أي معالجة خارجية مسبقة. ضمن نموذج خط أنابيب الاستدلال ، يعالج SageMaker الاستدعاءات كسلسلة من طلبات HTTP التي تنشأ من تطبيق خارجي. تعالج الحاوية الأولى في خط الأنابيب الطلب الأولي ، وتنفذ بعض المعالجة ، ثم ترسل الاستجابة الوسيطة كطلب إلى الحاوية الثانية في خط الأنابيب. يحدث هذا لكل حاوية في خط الأنابيب ، وأخيرًا يُرجع الاستجابة النهائية لتطبيق العميل المتصل.

تتم إدارة خطوط أنابيب الاستدلال من SageMaker بشكل كامل. عند نشر خط الأنابيب ، يقوم SageMaker بتثبيت وتشغيل جميع الحاويات المحددة في كل من ملفات الأمازون الحوسبة المرنة السحابية (Amazon EC2) يتم توفيرها كجزء من وظيفة نقطة النهاية أو التحويل الدفعي. علاوة على ذلك ، نظرًا لأن الحاويات يتم وضعها في نفس الموقع واستضافتها على نفس مثيل EC2 ، يتم تقليل زمن انتقال خط الأنابيب الإجمالي.

مجموعة النموذج التسلسلي باستخدام خط أنابيب الاستدلال SageMaker

نموذج المجموعة هو نهج في ML حيث يتم دمج العديد من نماذج ML واستخدامها كجزء من عملية الاستدلال لتوليد الاستدلالات النهائية. يمكن أن تشمل الدوافع لنماذج المجموعات تحسين الدقة وتقليل حساسية النموذج لميزات إدخال محددة وتقليل تحيز النموذج الفردي ، من بين أمور أخرى. في هذا المنشور ، نركز على حالات الاستخدام المتعلقة بمجموعة النموذج التسلسلي ، حيث يتم دمج العديد من نماذج ML بشكل تسلسلي كجزء من خط أنابيب الاستدلال التسلسلي.

دعنا نفكر في مثال محدد يتعلق بمجموعة نموذج تسلسلي حيث نحتاج إلى تجميع الصور التي تم تحميلها للمستخدم بناءً على موضوعات أو موضوعات معينة. يمكن أن يتكون خط الأنابيب هذا من ثلاثة نماذج ML:

- الموديل : 1 - يقبل الصورة كمدخلات ويقيم جودة الصورة بناءً على دقة الصورة والاتجاه وغير ذلك. يحاول هذا النموذج بعد ذلك رفع مستوى جودة الصورة ويرسل الصور المعالجة التي تلبي حدًا معينًا من الجودة إلى النموذج التالي (الطراز 2).

- الموديل : 2 - يقبل الصور التي تم التحقق من صحتها من خلال النموذج 1 ويقوم بتنفيذها التعرف على الصور لتحديد الكائنات والأماكن والأشخاص والنصوص والإجراءات والمفاهيم المخصصة الأخرى في الصور. يتم إرسال الإخراج من النموذج 2 الذي يحتوي على كائنات محددة إلى النموذج 3.

- الموديل : 3 - يقبل الإخراج من النموذج 2 وينفذ مهام معالجة اللغة الطبيعية (NLP) مثل نمذجة الموضوع لتجميع الصور معًا بناءً على السمات. على سبيل المثال ، يمكن تجميع الصور بناءً على الموقع أو الأشخاص المحددين. يتم إرسال الإخراج (التجميعات) مرة أخرى إلى تطبيق العميل.

يوضح الرسم البياني التالي نمطًا مرجعيًا لكيفية تنفيذ العديد من نماذج ML المستضافة على مجموعة نموذج تسلسلي باستخدام خط أنابيب استدلال SageMaker.

كما تمت مناقشته سابقًا ، تتم إدارة خط أنابيب الاستدلال SageMaker ، مما يمكّنك من التركيز على اختيار نموذج ML وتطويره ، مع تقليل الرفع الثقيل غير المتمايز المرتبط ببناء خط أنابيب المجموعة التسلسلية.

بالإضافة إلى ذلك ، فإن بعض الاعتبارات التي نوقشت سابقًا حول الفصل والخوارزمية واختيار إطار العمل لتطوير النموذج والنشر ذات صلة هنا أيضًا. على سبيل المثال ، نظرًا لاستضافة كل نموذج في حاوية منفصلة ، فإنك تتمتع بالمرونة في تحديد إطار عمل ML الذي يناسب كل نموذج وحالة الاستخدام الإجمالية. علاوة على ذلك ، من وجهة نظر الفصل والتشغيل ، يمكنك الاستمرار في ترقية أو تعديل الخطوات الفردية بسهولة أكبر ، دون التأثير على النماذج الأخرى.

يتكامل خط أنابيب الاستدلال SageMaker أيضًا مع ملف سجل نموذج SageMaker لفهرسة النماذج ، والإصدار ، وإدارة البيانات الوصفية ، والنشر المحكوم في بيئات الإنتاج لدعم أفضل الممارسات التشغيلية المتسقة. تم أيضًا دمج خط أنابيب الاستدلال SageMaker مع الأمازون CloudWatch لتمكين مراقبة نماذج الحاويات المتعددة في خطوط أنابيب الاستدلال. يمكنك أيضًا الحصول على رؤية مقاييس الوقت الحقيقي لفهم الدعوات ووقت الاستجابة بشكل أفضل لكل حاوية في خط الأنابيب ، مما يساعد في استكشاف الأخطاء وإصلاحها وتحسين الموارد.

خط أنابيب الاستدلال التسلسلي (مع استدعاء نموذج مستهدف من مجموعة) باستخدام خط أنابيب استدلال SageMaker

نقاط نهاية متعددة النماذج SageMaker (MMEs) توفر حلاً فعالاً من حيث التكلفة لنشر عدد كبير من نماذج ML خلف نقطة نهاية واحدة. يمكن أن تشمل الدوافع لاستخدام نقاط النهاية متعددة النماذج استدعاء نموذج مخصص محدد بناءً على خصائص الطلب (مثل الأصل والموقع الجغرافي وتخصيص المستخدم وما إلى ذلك) أو ببساطة استضافة نماذج متعددة خلف نفس نقطة النهاية لتحقيق تحسين التكلفة.

عند نشر نماذج متعددة على نقطة نهاية واحدة ممكّنة للنماذج المتعددة ، تشترك جميع النماذج في موارد الحوسبة وحاوية خدمة النموذج. يمكن نشر خط أنابيب الاستدلال SageMaker على MME ، حيث يمكن لإحدى الحاويات الموجودة في خط الأنابيب أن تخدم الطلبات ديناميكيًا بناءً على النموذج المحدد الذي يتم استدعاؤه. من منظور خط الأنابيب ، تحتوي النماذج على متطلبات معالجة مسبقة متطابقة وتتوقع نفس مجموعة الميزات ، ولكن يتم تدريبها لتتماشى مع سلوك معين. يوضح الرسم البياني التالي نمطًا مرجعيًا لكيفية عمل خط الأنابيب المتكامل هذا.

مع MMEs ، يجب أن يحدد طلب الاستنتاج الذي ينشأ من تطبيق العميل النموذج الهدف الذي يجب استدعاؤه. تعالج الحاوية الأولى في خط الأنابيب الطلب الأولي ، وتنفذ بعض المعالجة ، ثم ترسل الاستجابة الوسيطة كطلب إلى الحاوية الثانية في خط الأنابيب ، والتي تستضيف نماذج متعددة. استنادًا إلى النموذج الهدف المحدد في طلب الاستدلال ، يتم استدعاء النموذج لإنشاء استنتاج. يتم إرسال الاستنتاج الذي تم إنشاؤه إلى الحاوية التالية في خط الأنابيب لمزيد من المعالجة. يحدث هذا لكل حاوية لاحقة في خط الأنابيب ، وأخيراً يقوم SageMaker بإرجاع الاستجابة النهائية لتطبيق العميل المتصل.

تستمر عيوب النماذج المتعددة في حاوية S3. عندما يتم استدعاء نموذج معين ، يقوم SageMaker بتحميله ديناميكيًا على الحاوية التي تستضيف نقطة النهاية. إذا تم تحميل النموذج بالفعل في ذاكرة الحاوية ، فسيكون الاستدعاء أسرع لأن SageMaker لا يحتاج إلى تنزيل النموذج من Amazon S3. إذا كان استخدام ذاكرة المثيل مرتفعًا وتم استدعاء نموذج جديد وبالتالي يلزم تحميله ، فسيتم إلغاء تحميل النماذج غير المستخدمة من الذاكرة. تظل النماذج غير المحملة في وحدة تخزين المثيل ، ومع ذلك ، يمكن تحميلها في ذاكرة الحاوية لاحقًا مرة أخرى ، دون تنزيلها من حاوية S3 مرة أخرى.

أحد الاعتبارات الرئيسية أثناء استخدام MME هو فهم سلوك استرجاع النموذج. كما تمت مناقشته سابقًا ، يتم تحميل النماذج ديناميكيًا في ذاكرة الحاوية للمثيل الذي يستضيف نقطة النهاية عند الاستدعاء. لذلك ، قد يستغرق استدعاء النموذج وقتًا أطول عند استدعائه لأول مرة. عندما يكون النموذج بالفعل في ذاكرة حاوية المثيل ، تكون الاستدعاءات اللاحقة أسرع. إذا كان استخدام ذاكرة المثيل مرتفعًا وكان يلزم تحميل نموذج جديد ، فسيتم إلغاء تحميل النماذج غير المستخدمة. إذا كان حجم تخزين المثيل ممتلئًا ، فسيتم حذف النماذج غير المستخدمة من وحدة التخزين. يدير SageMaker عمليات تحميل وتفريغ النماذج بشكل كامل ، دون الحاجة إلى اتخاذ أي إجراءات محددة. ومع ذلك ، من المهم فهم هذا السلوك لأن له آثارًا على زمن انتقال استدعاء النموذج وبالتالي زمن الانتقال الشامل من طرف إلى طرف.

خيارات استضافة خطوط الأنابيب

يوفر SageMaker عدة ملفات نوع الطلب خيارات للاختيار من بينها لنشر نماذج ML وبناء خطوط أنابيب الاستدلال ، بناءً على حالة الاستخدام والإنتاجية ومتطلبات التكلفة. على سبيل المثال ، يمكنك اختيار مثيلات مُحسَّنة لوحدة المعالجة المركزية أو وحدة معالجة الرسومات لإنشاء خطوط أنابيب استدلال تسلسلي ، في حاوية واحدة أو عبر حاويات متعددة. ومع ذلك ، هناك في بعض الأحيان متطلبات حيث يكون من المرغوب فيه التمتع بالمرونة والدعم لتشغيل النماذج على المثيلات القائمة على وحدة المعالجة المركزية أو وحدة معالجة الرسومات داخل نفس خط الأنابيب لتحقيق مرونة إضافية.

يمكنك الآن استخدام NVIDIA Triton Inference Server لخدمة نماذج للاستدلال على SageMaker لمتطلبات الحوسبة غير المتجانسة. الدفع انشر الذكاء الاصطناعي السريع والقابل للتطوير باستخدام خادم الاستدلال NVIDIA Triton في Amazon SageMaker للحصول على تفاصيل إضافية.

وفي الختام

نظرًا لأن المؤسسات تكتشف وتبني حلولًا جديدة مدعومة من ML ، يجب أن تكون الأدوات المطلوبة لتنظيم خطوط الأنابيب هذه مرنة بدرجة كافية لدعمها بناءً على حالة استخدام معينة ، مع تبسيط وتقليل النفقات التشغيلية الجارية. يوفر SageMaker خيارات متعددة لتصميم وبناء تدفقات عمل الاستدلال التسلسلي هذه ، بناءً على متطلباتك.

نتطلع إلى الاستماع منك بشأن حالات الاستخدام التي تقوم بإنشائها باستخدام خطوط أنابيب الاستدلال التسلسلي. إذا كانت لديك أسئلة أو تعليقات ، فيرجى مشاركتها في التعليقات.

عن المؤلفين

راهول شارما هو مهندس حلول أول في AWS Data Lab ، يساعد عملاء AWS على تصميم وبناء حلول AI / ML. قبل انضمامه إلى AWS ، أمضى راهول عدة سنوات في قطاع التمويل والتأمين ، لمساعدة العملاء على بناء منصات البيانات والتحليل.

راهول شارما هو مهندس حلول أول في AWS Data Lab ، يساعد عملاء AWS على تصميم وبناء حلول AI / ML. قبل انضمامه إلى AWS ، أمضى راهول عدة سنوات في قطاع التمويل والتأمين ، لمساعدة العملاء على بناء منصات البيانات والتحليل.

أناند براكاش هو مهندس حلول أول في AWS Data Lab. يركز Anand على مساعدة العملاء في تصميم وبناء الذكاء الاصطناعي / التعلم الآلي ، وتحليلات البيانات ، وحلول قواعد البيانات لتسريع مسارهم إلى الإنتاج.

أناند براكاش هو مهندس حلول أول في AWS Data Lab. يركز Anand على مساعدة العملاء في تصميم وبناء الذكاء الاصطناعي / التعلم الآلي ، وتحليلات البيانات ، وحلول قواعد البيانات لتسريع مسارهم إلى الإنتاج.

ضوال باتل هو مهندس رئيسي لتعلم الآلة في AWS. لقد عمل مع مؤسسات تتراوح من المؤسسات الكبيرة إلى الشركات الناشئة متوسطة الحجم في المشكلات المتعلقة بالحوسبة الموزعة والذكاء الاصطناعي. يركز على التعلم العميق بما في ذلك مجالات البرمجة اللغوية العصبية ورؤية الكمبيوتر. إنه يساعد العملاء على تحقيق استدلال نموذج عالي الأداء على SageMaker.

ضوال باتل هو مهندس رئيسي لتعلم الآلة في AWS. لقد عمل مع مؤسسات تتراوح من المؤسسات الكبيرة إلى الشركات الناشئة متوسطة الحجم في المشكلات المتعلقة بالحوسبة الموزعة والذكاء الاصطناعي. يركز على التعلم العميق بما في ذلك مجالات البرمجة اللغوية العصبية ورؤية الكمبيوتر. إنه يساعد العملاء على تحقيق استدلال نموذج عالي الأداء على SageMaker.

سوراب تريكاندي هو مدير أول للمنتجات في Amazon SageMaker Inference. إنه متحمس للعمل مع العملاء وجعل التعلم الآلي أكثر سهولة. في أوقات فراغه ، يستمتع سوراب بالمشي لمسافات طويلة والتعرف على التقنيات المبتكرة واتباع TechCrunch وقضاء الوقت مع عائلته.

سوراب تريكاندي هو مدير أول للمنتجات في Amazon SageMaker Inference. إنه متحمس للعمل مع العملاء وجعل التعلم الآلي أكثر سهولة. في أوقات فراغه ، يستمتع سوراب بالمشي لمسافات طويلة والتعرف على التقنيات المبتكرة واتباع TechCrunch وقضاء الوقت مع عائلته.

- متقدم (300،XNUMX)

- AI

- ai الفن

- مولد الفن ai

- الروبوت ai

- آلة التعلم الأمازون

- الأمازون SageMaker

- الذكاء الاصطناعي

- شهادة الذكاء الاصطناعي

- الذكاء الاصطناعي في البنوك

- روبوت ذكاء اصطناعي

- روبوتات الذكاء الاصطناعي

- برنامج ذكاء اصطناعي

- التعلم الآلي من AWS

- سلسلة كتلة

- مؤتمر blockchain ai

- عملة عبقرية

- الذكاء الاصطناعي للمحادثة

- مؤتمر التشفير ai

- دال

- التعلم العميق

- google ai

- آلة التعلم

- أفلاطون

- أفلاطون ع

- الذكاء افلاطون البيانات

- لعبة أفلاطون

- أفلاطون داتا

- بلاتوغمينغ

- مقياس ai

- بناء الجملة

- زفيرنت