مع تسارع تبني الذكاء الاصطناعي عبر الصناعة ، يقوم العملاء ببناء نماذج متطورة تستفيد من الاختراقات العلمية الجديدة في التعلم العميق. تتيح لك نماذج الجيل التالي هذه تحقيق أداء متطور يشبه الإنسان في مجالات معالجة اللغة الطبيعية (NLP) ، ورؤية الكمبيوتر ، والتعرف على الكلام ، والبحوث الطبية ، والأمن السيبراني ، والتنبؤ ببنية البروتين ، وغيرها الكثير. . على سبيل المثال ، يمكن لنماذج اللغات الكبيرة مثل GPT-3 و OPT و BLOOM ترجمة النص وتلخيصه وكتابته باستخدام الفروق الدقيقة التي تشبه الإنسان. في مساحة رؤية الكمبيوتر ، يمكن لنماذج نشر النص إلى صورة مثل DALL-E و Imagen إنشاء صور واقعية من اللغة الطبيعية بمستوى أعلى من الفهم البصري واللغوي من العالم من حولنا. توفر هذه النماذج متعددة الوسائط ميزات أكثر ثراءً لمختلف المهام النهائية والقدرة على ضبطها لمجالات محددة ، كما أنها توفر فرصًا تجارية قوية لعملائنا.

تستمر نماذج التعلم العميق هذه في النمو من حيث الحجم ، وتحتوي عادةً على مليارات من معلمات النموذج لتوسيع نطاق أداء النموذج لمجموعة متنوعة من المهام ، مثل إنشاء الصور وتلخيص النص وترجمة اللغة والمزيد. هناك أيضًا حاجة إلى تخصيص هذه النماذج لتقديم تجربة مخصصة للغاية للأفراد. نتيجة لذلك ، يتم تطوير عدد أكبر من النماذج عن طريق ضبط هذه النماذج لمهام مختلفة في المصب. لتحقيق أهداف زمن الانتقال والإنتاجية لتطبيقات الذكاء الاصطناعي ، تُفضل مثيلات وحدة معالجة الرسومات على مثيلات وحدة المعالجة المركزية (نظرًا لعرض وحدات معالجة الرسومات للطاقة الحسابية). ومع ذلك ، فإن مثيلات GPU باهظة الثمن ويمكن أن تزيد التكاليف إذا كنت تنشر أكثر من 10 طرز. على الرغم من أن هذه النماذج يمكن أن تجلب تطبيقات ذكاء اصطناعي مؤثرة ، فقد يكون من الصعب توسيع نطاق نماذج التعلم العميق هذه بطرق فعالة من حيث التكلفة نظرًا لحجمها وعدد النماذج.

الأمازون SageMaker توفر نقاط النهاية متعددة النماذج (MMEs) طريقة قابلة للتطوير وفعالة من حيث التكلفة لنشر عدد كبير من نماذج التعلم العميق. تعد MMEs خيار استضافة شائعًا لاستضافة مئات النماذج القائمة على وحدة المعالجة المركزية بين العملاء مثل Zendesk و Veeva و AT&T. في السابق ، كان لديك خيارات محدودة لنشر المئات من نماذج التعلم العميق التي تحتاج إلى حوسبة سريعة باستخدام وحدات معالجة الرسومات. نعلن اليوم عن دعم MME لوحدة معالجة الرسومات. يمكنك الآن نشر الآلاف من نماذج التعلم العميق خلف نقطة نهاية واحدة من SageMaker. يمكن لـ MME الآن تشغيل نماذج متعددة على نواة GPU ، ومشاركة مثيلات GPU خلف نقطة نهاية عبر طرز متعددة ، وتحميل النماذج وإلغاء تحميلها ديناميكيًا بناءً على حركة المرور الواردة. مع هذا ، يمكنك توفير التكلفة بشكل كبير وتحقيق أفضل أداء للسعر.

في هذا المنشور ، نوضح كيفية تشغيل نماذج التعلم العميق المتعددة على وحدة معالجة الرسومات باستخدام SageMaker MMEs.

SageMaker MMEs

تمكّنك SageMaker MME من نشر نماذج متعددة خلف نقطة نهاية استنتاج واحدة قد تحتوي على مثيل واحد أو أكثر. باستخدام MMEs ، تتم إدارة كل مثيل لتحميل نماذج متعددة وخدمتها. تمكنك MME من كسر التكلفة المتزايدة الخطية لاستضافة نماذج متعددة وإعادة استخدام البنية التحتية في جميع النماذج.

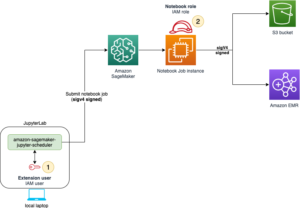

يوضح الرسم البياني التالي بنية SageMaker MME.

يقوم SageMaker MME ديناميكيًا بتنزيل النماذج من ملفات خدمة تخزين أمازون البسيطة (Amazon S3) عند الاستدعاء ، بدلاً من تنزيل جميع الطرز عند إنشاء نقطة النهاية لأول مرة. نتيجة لذلك ، قد يؤدي الاستدعاء الأولي إلى نموذج إلى زيادة زمن انتقال الاستدلال عن الاستدلالات اللاحقة ، والتي يتم استكمالها بزمن انتقال منخفض. إذا تم تحميل النموذج بالفعل على الحاوية عند استدعائه ، فسيتم تخطي خطوة التنزيل والتحميل ويعيد النموذج الاستنتاجات بزمن انتقال منخفض. على سبيل المثال ، افترض أن لديك نموذجًا يتم استخدامه بضع مرات فقط في اليوم. يتم تحميله تلقائيًا عند الطلب ، في حين يتم الاحتفاظ بالنماذج التي يتم الوصول إليها بشكل متكرر في الذاكرة واستدعائها بزمن انتقال منخفض باستمرار.

MMEs SageMaker مع دعم GPU

تعمل وحدات MME من SageMaker مع GPU باستخدام خادم الاستدلال NVIDIA Triton. NVIDIA Triton Inference Server هو برنامج مفتوح المصدر لتقديم الاستدلال يبسط عملية تقديم الاستدلال ويوفر أداء استدلالًا عاليًا. يدعم Triton جميع أطر التدريب والاستدلال الرئيسية ، مثل TensorFlow و NVIDIA® TensorRT ™ و PyTorch و MXNet و Python و ONNX و XGBoost و Scikit-Learn و RandomForest و OpenVINO و C ++ المخصص والمزيد. يوفر التجميع الديناميكي والتشغيل المتزامن والتكميم بعد التدريب وتكوين النموذج الأمثل لتحقيق الاستدلال عالي الأداء. بالإضافة إلى ذلك ، تم تمديد خادم الاستدلال NVIDIA Triton للتنفيذ عقد MME API، للتكامل مع MME.

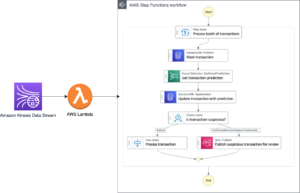

يوضح الرسم التخطيطي التالي سير عمل MME.

خطوات سير العمل كالتالي:

- يتلقى SageMaker MME طلب استدعاء HTTP لطراز معين باستخدام

TargetModelفي الطلب مع الحمولة. - يقوم SageMaker بتوجيه حركة المرور إلى المثيل الصحيح خلف نقطة النهاية حيث يتم تحميل النموذج الهدف. يفهم SageMaker نمط حركة المرور عبر جميع النماذج وراء MME ويوجه الطلبات بذكاء.

- يعتني SageMaker بإدارة النموذج خلف نقطة النهاية ، ويقوم بتحميل النموذج ديناميكيًا إلى ذاكرة الحاوية ، ويفرغ النموذج المستند إلى الأسطول المشترك لمثيلات GPU لتقديم أفضل أداء للسعر.

- يقوم SageMaker بتنزيل النماذج ديناميكيًا من Amazon S3 إلى حجم تخزين المثيل. إذا لم يكن النموذج الذي تم استدعاؤه متاحًا على حجم تخزين المثيل ، فسيتم تنزيل النموذج على وحدة تخزين المثيل. إذا وصل حجم تخزين المثيل إلى السعة ، يقوم SageMaker بحذف أي نماذج غير مستخدمة من وحدة تخزين التخزين.

- يقوم SageMaker بتحميل النموذج إلى ذاكرة حاوية NVIDIA Triton على مثيل مُسارع من خلال GPU وخدمة طلب الاستدلال. تتم مشاركة نواة GPU بين جميع النماذج في مثيل. إذا تم تحميل النموذج بالفعل في ذاكرة الحاوية ، فسيتم تقديم الطلبات اللاحقة بشكل أسرع لأن برنامج SageMaker لا يحتاج إلى تنزيله وتحميله مرة أخرى.

- يعتني SageMaker بتشكيل حركة المرور إلى نقطة نهاية MME ويحافظ على نسخ النماذج المثلى على مثيلات GPU للحصول على أفضل أداء للسعر. يستمر في توجيه حركة المرور إلى المثيل حيث يتم تحميل النموذج. إذا وصلت موارد المثيل إلى السعة بسبب الاستخدام العالي ، يقوم SageMaker بتفريغ النماذج الأقل استخدامًا من الحاوية لتحرير الموارد لتحميل النماذج الأكثر استخدامًا.

يمكن لـ SageMaker MMEs التوسع أفقيًا باستخدام نهج القياس التلقائي ، وتوفير مثيلات حساب GPU إضافية استنادًا إلى مقاييس مثل الاستدعاءات لكل مثيل واستخدام GPU لخدمة أي زيادة في حركة المرور لنقاط نهاية MME.

حل نظرة عامة

في هذا المنشور ، نوضح لك كيفية استخدام الميزات الجديدة لـ SageMaker MMEs مع وحدة معالجة الرسومات مع حالة استخدام رؤية الكمبيوتر. لأغراض التوضيح ، نستخدم نموذج شبكة عصبية تلافيفية ResNet-50 مُدرَّبة مسبقًا يمكنها تصنيف الصور إلى 1,000 فئة. نناقش كيفية القيام بما يلي:

- استخدم حاوية الاستدلال NVIDIA Triton على SageMaker MMEs ، باستخدام إطارات خلفية مختلفة لإطار عمل نموذج Triton مثل PyTorch و TensorRT

- قم بتحويل نماذج ResNet-50 إلى تنسيق محرك TensorRT الأمثل ونشره باستخدام SageMaker MME

- قم بإعداد سياسات القياس التلقائي لـ MME

- احصل على رؤى حول مقاييس المثيل والاستدعاء باستخدام الأمازون CloudWatch

إنشاء نماذج التحف

يستعرض هذا القسم الخطوات لإعداد نموذج ResNet-50 مدرب مسبقًا ليتم نشره على SageMaker MME باستخدام تكوينات نموذج Triton Inference Server. يمكنك إعادة إنتاج جميع الخطوات باستخدام دفتر الملاحظات خطوة بخطوة GitHub جيثب:.

بالنسبة لهذا المنشور ، نعرض النشر باستخدام نموذجين. ومع ذلك ، يمكنك إعداد ونشر مئات النماذج. قد تشترك النماذج أو لا تشترك في نفس الإطار.

قم بإعداد نموذج PyTorch

أولاً ، نقوم بتحميل نموذج ResNet50 مدرب مسبقًا باستخدام حزمة نماذج torchvision. نقوم بحفظ النموذج كملف model.pt بتنسيق TorchScript المحسن والمتسلسل. يجمع TorchScript مرورًا أماميًا لنموذج ResNet50 في وضع متحمس مع مدخلات أمثلة ، لذلك نمرر مثيلًا واحدًا لصورة RGB بثلاث قنوات ملونة بأبعاد 224 × 224.

ثم نحتاج إلى إعداد النماذج لخادم الاستدلال Triton. يُظهر الكود التالي مستودع النموذج للواجهة الخلفية لإطار عمل PyTorch. يستخدم Triton ملف model.pt الموضوع في مستودع النموذج لخدمة التنبؤات.

ملف تكوين النموذج config.pbtxt يجب تحديد اسم النموذج (resnet) ، وخصائص النظام الأساسي والخلفية (pytorch_libtorch), max_batch_size (128) ، وموترات الإدخال والإخراج جنبًا إلى جنب مع نوع البيانات (TYPE_FP32) معلومة. بالإضافة إلى ذلك ، يمكنك تحديد instance_group و dynamic_batching خصائص لتحقيق استدلال عالي الأداء. انظر الكود التالي:

قم بإعداد نموذج TensorRT

نفيديا تينسوررت عبارة عن حزمة SDK لاستدلال التعلم العميق عالي الأداء ، وتتضمن مُحسِّنًا لاستدلال التعلم العميق ووقت تشغيل يوفر زمن انتقال منخفض وإنتاجية عالية لتطبيقات الاستدلال. نحن نستخدم أداة سطر الأوامر trtexec لإنشاء محرك متسلسل TensorRT من ملف أونكس تنسيق النموذج. أكمل الخطوات التالية لتحويل نموذج ResNet-50 مدرب مسبقًا إلى NVIDIA TensorRT:

- قم بتصدير نموذج ResNet-50 المدرب مسبقًا إلى تنسيق ONNX باستخدام torch.onnxتعمل هذه الخطوة على تشغيل النموذج مرة واحدة لتتبع تشغيله باستخدام إدخال عينة ثم تصدير النموذج المتتبع إلى الملف المحدد

model.onnx. - استخدم trtexec لإنشاء خطة محرك TensorRT من ملف

model.onnxملف. يمكنك اختياريًا تقليل دقة حسابات الفاصلة العائمة ، إما ببساطة عن طريق تشغيلها في نقطة عائمة 16 بت ، أو عن طريق تحديد قيم الفاصلة العائمة بحيث يمكن إجراء الحسابات باستخدام أعداد صحيحة 8 بت.

يوضح الكود التالي بنية مستودع النموذج لنموذج TensorRT:

بالنسبة لنموذج TensorRT ، نحدده tensorrt_plan كمنصة وإدخال مواصفات Tensor للصورة ذات البعد 224 × 224 والتي لها قنوات ملونة. موتر الإخراج بأبعاد 1,000،XNUMX من النوع TYPE_FP32، المقابلة لفئات الكائنات المختلفة. انظر الكود التالي:

تخزين القطع الأثرية للنماذج في Amazon S3

تتوقع SageMaker أن تكون عناصر النموذج بتنسيق .tar.gz صيغة. يجب عليهم أيضًا تلبية متطلبات حاوية Triton مثل اسم الطراز والإصدار و config.pbtxt من الملفات والمزيد. tar المجلد الذي يحتوي على ملف النموذج كملف .tar.gz وتحميله على Amazon S3:

الآن بعد أن قمنا بتحميل عناصر النموذج إلى Amazon S3 ، يمكننا إنشاء SageMaker MME.

نشر النماذج باستخدام MME

ننشر الآن نموذج ResNet-50 مع اثنين من الخلفيات الخلفية المختلفة لإطار العمل (PyTorch و TensorRT) إلى SageMaker MME.

لاحظ أنه يمكنك نشر مئات النماذج ، ويمكن للنماذج استخدام نفس إطار العمل. يمكنهم أيضًا استخدام أطر عمل مختلفة ، كما هو موضح في هذا المنشور.

نستخدم AWS SDK لـ Python (Boto3) واجهات برمجة التطبيقات create_model, create_endpoint_configو create_endpoint لإنشاء MME.

حدد وعاء التقديم

في تعريف الحاوية ، حدد ملف model_data_url لتحديد دليل S3 الذي يحتوي على جميع النماذج التي يستخدمها SageMaker MME لتحميل وخدمة التنبؤات. تعيين Mode إلى MultiModel للإشارة إلى أن SageMaker يقوم بإنشاء نقطة النهاية بمواصفات حاوية MME. قمنا بتعيين الحاوية مع صورة تدعم نشر MME مع GPU. انظر الكود التالي:

إنشاء كائن متعدد النماذج

استخدم عميل SageMaker Boto3 لإنشاء النموذج باستخدام ملف create_model API. نقوم بتمرير تعريف الحاوية إلى إنشاء نموذج API مع ModelName و ExecutionRoleArn:

تحديد تكوينات MME

قم بإنشاء تكوينات MME باستخدام ملف create_endpoint_config واجهة برمجة تطبيقات Boto3. حدد مثيل حوسبة GPU المتسارعة بتنسيق InstanceType (نستخدم نوع المثيل g4dn.4xlarge). نوصي بتكوين نقاط النهاية الخاصة بك مع حالتين على الأقل. يتيح ذلك لـ SageMaker توفير مجموعة عالية التوفر من التنبؤات عبر مناطق توافر خدمات متعددة للنماذج.

بناءً على النتائج التي توصلنا إليها ، يمكنك الحصول على أداء سعر أفضل في مثيلات ML المحسّنة مع نواة GPU واحدة. لذلك ، يتم تمكين دعم MME لميزة GPU فقط لمثيلات GPU الأساسية الفردية. للحصول على قائمة كاملة بالمثيلات المدعومة ، راجع أنواع مثيلات GPU المدعومة.

قم بإنشاء MME

باستخدام تكوين نقطة النهاية السابق ، نقوم بإنشاء SageMaker MME باستخدام امتداد create_endpoint API. يقوم SageMaker بإنشاء MME ، وتشغيل مثيل حوسبة ML g4dn.4xlarge ، ونشر نماذج PyTorch و TensorRT ResNet-50 عليها. انظر الكود التالي:

استدعاء النموذج الهدف في MME

بعد إنشاء نقطة النهاية ، يمكننا إرسال طلب استنتاج إلى MME باستخدام امتداد invoke_enpoint API. نحدد ال TargetModel في استدعاء الاحتجاج وتمرير الحمولة لكل نوع نموذج. الكود التالي هو نموذج لاستدعاء نموذج PyTorch ونموذج TensorRT:

قم بإعداد سياسات القياس التلقائي لوحدة GPU MME

تدعم SageMaker MME التدرج التلقائي للنماذج المستضافة. يضبط القياس التلقائي بشكل ديناميكي عدد المثيلات المتوفرة لنموذج استجابة للتغيرات في عبء العمل لديك. عندما يزداد عبء العمل ، يجلب القياس التلقائي المزيد من المثيلات عبر الإنترنت. عندما ينخفض عبء العمل ، يزيل القياس التلقائي المثيلات غير الضرورية بحيث لا تدفع مقابل المثيلات المتوفرة التي لا تستخدمها.

في سياسة القياس التالية ، نستخدم المقياس المخصص GPUUtilization في ال TargetTrackingScalingPolicyConfiguration التكوين وضبط أ TargetValue of 60.0 للقيمة المستهدفة لهذا المقياس. توفر سياسة القياس التلقائي هذه مثيلات إضافية تصل إلى MaxCapacity عندما يكون استخدام GPU أكثر من 60٪.

نوصي باستخدام GPUUtilization or InvocationsPerInstance لتكوين سياسات القياس التلقائي لـ MME الخاص بك. لمزيد من التفاصيل ، انظر تعيين سياسات القياس التلقائي لعمليات النشر متعددة النماذج لنقطة النهاية

مقاييس CloudWatch لوحدات GPU MME

توفر SageMaker MME المقاييس التالية على مستوى المثيل للمراقبة:

- LoadedModelCount - عدد النماذج المحملة في الحاويات

- استخدام GPU - النسبة المئوية لوحدات GPU التي تستخدمها الحاويات

- GPUM الاستخدام - النسبة المئوية لذاكرة وحدة معالجة الرسومات التي تستخدمها الحاويات

- استخدام القرص - نسبة مساحة القرص التي تستخدمها الحاويات

تسمح لك هذه المقاييس بالتخطيط للاستخدام الفعال لموارد مثيل وحدة معالجة الرسومات. في الرسم البياني التالي نرى GPUMemoryUtilization كانت 38.3٪ عندما تم تحميل أكثر من 16 طرازًا من ResNet-50 في الحاوية. مجموع استخدام كل نواة وحدة المعالجة المركزية (CPUUtilization) كانت 60.9٪ ، ونسبة الذاكرة المستخدمة بواسطة الحاويات (MemoryUtilization) كان 9.36٪.

توفر SageMaker MME أيضًا مقاييس تحميل نموذجية للحصول على رؤى نموذجية على مستوى الاستدعاء:

- ModelLoadingWaitTime - الفاصل الزمني للنموذج المراد تنزيله أو تحميله

- ModelUnloadingTime - الفاصل الزمني لتفريغ النموذج من الحاوية

- وقت تنزيل النموذج - حان وقت تنزيل النموذج من Amazon S3

- ModelCacheHit - عدد استدعاءات النموذج التي تم تحميلها بالفعل على الحاوية

في الرسم البياني التالي ، يمكننا ملاحظة أن الأمر استغرق 8.22 ثانية حتى يستجيب النموذج لطلب الاستدلال (ModelLatency) ، وتمت إضافة 24.1 مللي ثانية إلى زمن الانتقال من طرف إلى طرف بسبب النفقات العامة لـ SageMaker (OverheadLatency). يمكننا أيضًا رؤية أي مقاييس أخطاء من الاستدعاءات لاستدعاء استدعاء API لنقطة النهاية ، مثل Invocation4XXErrors و Invocation5XXErrors.

لمزيد من المعلومات حول مقاييس MME CloudWatch ، يرجى الرجوع إلى مقاييس CloudWatch لعمليات النشر متعددة النماذج نقطة النهاية.

نبذة عامة

في هذا المنشور ، تعرفت على دعم SageMaker متعدد النماذج الجديد لوحدة معالجة الرسومات ، والذي يمكّنك من استضافة مئات نماذج التعلم العميق بفعالية من حيث التكلفة على أجهزة الحوسبة السريعة. لقد تعلمت كيفية استخدام خادم الاستدلال NVIDIA Triton ، والذي يُنشئ تكوينًا لمستودع نموذجًا لخلفيات إطار عمل مختلفة ، وكيفية نشر MME مع التحجيم التلقائي. ستسمح لك هذه الميزة بتوسيع نطاق مئات النماذج فائقة التخصيص التي تم ضبطها لتلائم تجارب المستخدم النهائي الفريدة في تطبيقات الذكاء الاصطناعي. يمكنك أيضًا الاستفادة من هذه الميزة لتحقيق أداء سعر ضروري لتطبيق الاستدلال الخاص بك باستخدام وحدات معالجة الرسومات الجزئية.

لبدء استخدام دعم MME لوحدة معالجة الرسومات ، راجع دعم متعدد النماذج لنقطة النهاية لوحدة معالجة الرسومات.

عن المؤلفين

ضوال باتل هو مهندس رئيسي لتعلم الآلة في AWS. لقد عمل مع مؤسسات تتراوح من الشركات الكبيرة إلى الشركات الناشئة متوسطة الحجم في المشكلات المتعلقة بالحوسبة الموزعة والذكاء الاصطناعي. يركز على التعلم العميق ، بما في ذلك مجالات البرمجة اللغوية العصبية ورؤية الكمبيوتر. يساعد العملاء على تحقيق استدلال نموذج عالي الأداء على Amazon SageMaker.

ضوال باتل هو مهندس رئيسي لتعلم الآلة في AWS. لقد عمل مع مؤسسات تتراوح من الشركات الكبيرة إلى الشركات الناشئة متوسطة الحجم في المشكلات المتعلقة بالحوسبة الموزعة والذكاء الاصطناعي. يركز على التعلم العميق ، بما في ذلك مجالات البرمجة اللغوية العصبية ورؤية الكمبيوتر. يساعد العملاء على تحقيق استدلال نموذج عالي الأداء على Amazon SageMaker.

فيكرام إيلانجو هو مهندس حلول متخصص في الذكاء الاصطناعي / التعلم الآلي في Amazon Web Services ، ومقرها في فرجينيا ، الولايات المتحدة. تساعد Vikram عملاء الصناعة المالية والتأمين العالمية في التصميم والتنفيذ والقيادة الفكرية لبناء ونشر تطبيقات التعلم الآلي على نطاق واسع. يركز حاليًا على معالجة اللغة الطبيعية ، والذكاء الاصطناعي المسؤول ، وتحسين الاستدلال ، وتوسيع ML عبر المؤسسة. في أوقات فراغه ، يستمتع بالسفر والتنزه والطهي والتخييم مع عائلته.

فيكرام إيلانجو هو مهندس حلول متخصص في الذكاء الاصطناعي / التعلم الآلي في Amazon Web Services ، ومقرها في فرجينيا ، الولايات المتحدة. تساعد Vikram عملاء الصناعة المالية والتأمين العالمية في التصميم والتنفيذ والقيادة الفكرية لبناء ونشر تطبيقات التعلم الآلي على نطاق واسع. يركز حاليًا على معالجة اللغة الطبيعية ، والذكاء الاصطناعي المسؤول ، وتحسين الاستدلال ، وتوسيع ML عبر المؤسسة. في أوقات فراغه ، يستمتع بالسفر والتنزه والطهي والتخييم مع عائلته.

سوراب تريكاندي هو مدير أول للمنتجات في Amazon SageMaker Inference. إنه متحمس للعمل مع العملاء وتحفزه هدف إضفاء الطابع الديمقراطي على التعلم الآلي. يركز على التحديات الأساسية المتعلقة بنشر تطبيقات ML المعقدة ، ونماذج ML متعددة المستأجرين ، وتحسين التكلفة ، وجعل نشر نماذج التعلم العميق أكثر سهولة. في أوقات فراغه ، يستمتع سوراب بالمشي لمسافات طويلة والتعرف على التقنيات المبتكرة واتباع TechCrunch وقضاء الوقت مع أسرته.

سوراب تريكاندي هو مدير أول للمنتجات في Amazon SageMaker Inference. إنه متحمس للعمل مع العملاء وتحفزه هدف إضفاء الطابع الديمقراطي على التعلم الآلي. يركز على التحديات الأساسية المتعلقة بنشر تطبيقات ML المعقدة ، ونماذج ML متعددة المستأجرين ، وتحسين التكلفة ، وجعل نشر نماذج التعلم العميق أكثر سهولة. في أوقات فراغه ، يستمتع سوراب بالمشي لمسافات طويلة والتعرف على التقنيات المبتكرة واتباع TechCrunch وقضاء الوقت مع أسرته.

ديبتي راغا هو مهندس تطوير برمجيات في فريق Amazon SageMaker. يركز عملها الحالي على بناء الميزات لاستضافة نماذج التعلم الآلي بكفاءة. في أوقات فراغها ، تستمتع بالسفر والمشي لمسافات طويلة وزراعة النباتات.

ديبتي راغا هو مهندس تطوير برمجيات في فريق Amazon SageMaker. يركز عملها الحالي على بناء الميزات لاستضافة نماذج التعلم الآلي بكفاءة. في أوقات فراغها ، تستمتع بالسفر والمشي لمسافات طويلة وزراعة النباتات.

نيخيل كولكارني هي مطور برامج مع AWS Machine Learning ، وتركز على جعل أعباء عمل التعلم الآلي أكثر أداءً على السحابة وهي منشئ مشارك لـ AWS Deep Learning Containers للتدريب والاستدلال. إنه متحمس لأنظمة التعلم العميق الموزعة. خارج العمل ، يستمتع بقراءة الكتب والعبث بالجيتار وصنع البيتزا.

نيخيل كولكارني هي مطور برامج مع AWS Machine Learning ، وتركز على جعل أعباء عمل التعلم الآلي أكثر أداءً على السحابة وهي منشئ مشارك لـ AWS Deep Learning Containers للتدريب والاستدلال. إنه متحمس لأنظمة التعلم العميق الموزعة. خارج العمل ، يستمتع بقراءة الكتب والعبث بالجيتار وصنع البيتزا.

جياهونغ ليو هو مهندس حلول في فريق مزود الخدمة السحابية في NVIDIA. يساعد العملاء في تبني حلول التعلم الآلي والذكاء الاصطناعي التي تستفيد من حوسبة NVIDIA المتسارعة لمواجهة تحديات التدريب والاستدلال. في أوقات فراغه ، يستمتع بالأوريغامي ومشاريع DIY ولعب كرة السلة.

جياهونغ ليو هو مهندس حلول في فريق مزود الخدمة السحابية في NVIDIA. يساعد العملاء في تبني حلول التعلم الآلي والذكاء الاصطناعي التي تستفيد من حوسبة NVIDIA المتسارعة لمواجهة تحديات التدريب والاستدلال. في أوقات فراغه ، يستمتع بالأوريغامي ومشاريع DIY ولعب كرة السلة.

إليوث تريانا هو مدير علاقات المطورين في فريق NVIDIA-AWS. يربط بين رواد منتجات Amazon و AWS والمطورين والعلماء مع تقنيي NVIDIA ورواد المنتجات لتسريع أعباء عمل Amazon ML / DL ومنتجات EC2 وخدمات AWS AI. بالإضافة إلى ذلك ، Eliuth هو راكب الدراجة الجبلية ومتزلج ولاعب بوكر.

إليوث تريانا هو مدير علاقات المطورين في فريق NVIDIA-AWS. يربط بين رواد منتجات Amazon و AWS والمطورين والعلماء مع تقنيي NVIDIA ورواد المنتجات لتسريع أعباء عمل Amazon ML / DL ومنتجات EC2 وخدمات AWS AI. بالإضافة إلى ذلك ، Eliuth هو راكب الدراجة الجبلية ومتزلج ولاعب بوكر.

ماكسيميليانو ماكانتي هو مهندس رئيسي في AWS حاليًا مع DynamoDB ، كنت في فريق إطلاق SageMaker في إعادة: Invent 2017 وقضيت السنوات الخمس التالية في منصة الاستضافة مضيفًا كل أنواع العملاء الذين يواجهون الميزات. في وقت فراغي ، أقوم بجمع أجهزة ألعاب الفيديو القديمة وإصلاحها واللعب بها.

ماكسيميليانو ماكانتي هو مهندس رئيسي في AWS حاليًا مع DynamoDB ، كنت في فريق إطلاق SageMaker في إعادة: Invent 2017 وقضيت السنوات الخمس التالية في منصة الاستضافة مضيفًا كل أنواع العملاء الذين يواجهون الميزات. في وقت فراغي ، أقوم بجمع أجهزة ألعاب الفيديو القديمة وإصلاحها واللعب بها.

- متقدم (300،XNUMX)

- AI

- ai الفن

- مولد الفن ai

- الروبوت ai

- الأمازون SageMaker

- الذكاء الاصطناعي

- شهادة الذكاء الاصطناعي

- الذكاء الاصطناعي في البنوك

- روبوت ذكاء اصطناعي

- روبوتات الذكاء الاصطناعي

- برنامج ذكاء اصطناعي

- التعلم الآلي من AWS

- سلسلة كتلة

- مؤتمر blockchain ai

- عملة عبقرية

- الذكاء الاصطناعي للمحادثة

- مؤتمر التشفير ai

- دال

- التعلم العميق

- google ai

- آلة التعلم

- أفلاطون

- أفلاطون ع

- الذكاء افلاطون البيانات

- لعبة أفلاطون

- أفلاطون داتا

- بلاتوغمينغ

- مقياس ai

- بناء الجملة

- زفيرنت