المُقدّمة

إن تعلم اللغة الإنجليزية ليس بالمهمة السهلة، كما يعلم ذلك عدد لا يحصى من الطلاب. ولكن عندما يكون الطالب جهاز كمبيوتر، فإن أحد الأساليب يعمل بشكل مدهش: ما عليك سوى تغذية جبال من النصوص من الإنترنت إلى نموذج رياضي عملاق يسمى الشبكة العصبية. هذا هو مبدأ التشغيل وراء نماذج اللغة التوليدية مثل ChatGPT من OpenAI، والتي فاجأت قدرتها على التحدث بشكل متماسك (إن لم يكن دائمًا بصدق) حول مجموعة واسعة من المواضيع الباحثين والجمهور على مدار العام الماضي.

لكن هذا النهج له عيوبه. فمن ناحية، فإن إجراء "التدريب" المطلوب لتحويل أرشيفات النصوص الضخمة إلى نماذج لغوية حديثة أمر مكلف ويستغرق وقتاً طويلاً. ومن ناحية أخرى، حتى الأشخاص الذين يدربون نماذج لغوية كبيرة يجدون صعوبة في فهم أعمالهم الداخلية؛ وهذا بدوره يجعل من الصعب التنبؤ بالطرق العديدة التي يمكن أن يفشلوا بها.

وفي مواجهة هذه الصعوبات، اختار بعض الباحثين التدريب نماذج أصغر على مجموعات بيانات أصغر ومن ثم دراسة سلوكهم. "إنه مثل التسلسل ذبابة الفاكهة قال الجينوم مقابل تسلسل الجينوم البشري إيلي بافليك، باحث في نموذج اللغة في جامعة براون.

الآن ، في ورقة تم نشره مؤخرًا على خادم ما قبل الطباعة العلمي arxiv.org، وقد قدم زوج من الباحثين في Microsoft طريقة جديدة لتدريب نماذج لغوية صغيرة: تربيتهم على نظام غذائي صارم من قصص الأطفال.

لقد تبنى باحثو التعلم الآلي هذا الدرس. يحتوي GPT-3.5، وهو نموذج اللغة الكبير الذي يشغل واجهة ChatGPT، على ما يقرب من 200 مليار معلمة، وقد تم تدريبه على مجموعة بيانات تضم مئات المليارات من الكلمات. (لم تصدر OpenAI الأرقام المقابلة لخليفتها، GPT-4.) يتطلب تدريب مثل هذه النماذج الكبيرة عادةً ما لا يقل عن 1,000 معالج متخصص يسمى GPUs يعمل بالتوازي لمدة أسابيع في المرة الواحدة. ولا يستطيع سوى عدد قليل من الشركات حشد الموارد اللازمة، ناهيك عن تدريب النماذج المختلفة ومقارنتها.

أظهر الباحثان أن النماذج اللغوية الأصغر بآلاف المرات من الأنظمة الحديثة اليوم تعلمت بسرعة رواية قصص متسقة ونحوية عندما تم تدريبها بهذه الطريقة. تشير نتائجهم إلى اتجاهات بحثية جديدة قد تكون مفيدة لتدريب نماذج أكبر وفهم سلوكهم.

قال: "لقد وجدت هذه الورقة مفيدة للغاية". شاندرا بهاغافاتولا، باحث في نموذج اللغة في معهد ألين للذكاء الاصطناعي في سياتل. "المفهوم في حد ذاته مثير للاهتمام للغاية."

في يوم من الأيام

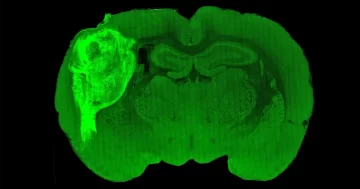

إن الشبكات العصبية الموجودة في قلب نماذج اللغة هي هياكل رياضية مستوحاة بشكل فضفاض من الدماغ البشري. تحتوي كل واحدة منها على العديد من الخلايا العصبية الاصطناعية مرتبة في طبقات، مع اتصالات بين الخلايا العصبية في الطبقات المجاورة. ويخضع سلوك الشبكة العصبية لقوة هذه الاتصالات، التي تسمى المعلمات. في نموذج اللغة، تتحكم المعلمات في الكلمات التي قد ينطقها النموذج بعد ذلك، في ضوء الموجه الأولي والكلمات التي أنشأها بالفعل.

لا ينبض النموذج بالحياة إلا أثناء التدريب، عندما يقارن مخرجاته بشكل متكرر بالنص الموجود في مجموعة بيانات التدريب الخاصة به ويضبط معلماته لزيادة التشابه. من السهل جدًا تجميع شبكة غير مدربة ذات معلمات عشوائية من بضعة أسطر من التعليمات البرمجية، ولكنها لن تؤدي إلا إلى هراء. بعد التدريب، يمكن في كثير من الأحيان مواصلة النص غير المألوف بشكل معقول. غالبًا ما تخضع النماذج الأكبر حجمًا لمزيد من الضبط الدقيق الذي يعلمها الإجابة على الأسئلة واتباع التعليمات، ولكن الجزء الأكبر من التدريب هو إتقان التنبؤ بالكلمات.

يتطلب النجاح في التنبؤ بالكلمات نموذجًا لغويًا لإتقان العديد من المهارات المختلفة. على سبيل المثال، تشير قواعد قواعد اللغة الإنجليزية إلى أن الكلمة التالية بعد كلمة "going" من المرجح أن تكون "to"، بغض النظر عن موضوع النص. بالإضافة إلى ذلك، يحتاج النظام إلى معرفة واقعية لإكمال "عاصمة فرنسا"، وإكمال مقطع يحتوي على كلمة "لا" يتطلب فهم بدائي للمنطق.

وقال "اللغة الخام معقدة للغاية". تيموثي نجوين، باحث في مجال التعلم الآلي في DeepMind. "من أجل ظهور قدرات لغوية مثيرة للاهتمام، لجأ الناس إلى مقولة "المزيد من البيانات أفضل"."

المُقدّمة

رونين الدينأراد عالم الرياضيات الذي انضم إلى Microsoft Research في عام 2022 لدراسة نماذج اللغة التوليدية، تطوير طريقة أرخص وأسرع لاستكشاف قدراته. وكانت الطريقة الطبيعية للقيام بذلك هي استخدام مجموعة بيانات صغيرة، وهذا بدوره يعني أنه سيتعين عليه تدريب النماذج للتخصص في مهمة محددة، حتى لا ينتشروا بشكل كبير. في البداية، أراد تدريب النماذج على حل فئة معينة من مسائل الرياضيات، ولكن بعد ظهر أحد الأيام، بعد قضاء بعض الوقت مع ابنته البالغة من العمر 5 سنوات، أدرك أن قصص الأطفال كانت مناسبة تمامًا.

قال: "لقد خطرت في ذهني حرفيًا بعد أن قرأت لها قصة".

لتوليد قصص أطفال متماسكة، سيحتاج النموذج اللغوي إلى تعلم حقائق حول العالم، وتتبع الشخصيات والأحداث، ومراقبة قواعد النحو - وهي نسخ أبسط من التحديات التي تواجه النماذج الكبيرة. لكن النماذج الكبيرة المدربة على مجموعات ضخمة من البيانات تتعلم عددًا لا يحصى من التفاصيل غير ذات الصلة بالإضافة إلى القواعد المهمة حقًا. وأعرب إلدان عن أمله في أن يكون الإيجاز والمفردات المحدودة في قصص الأطفال سببًا في جعل عملية التعلم أكثر سهولة بالنسبة للنماذج الصغيرة، مما يجعلها أسهل في التدريب والفهم.

ولكن في عالم النماذج اللغوية، فإن كلمة "صغير" أمر نسبي: إذ إن مجموعة البيانات الأصغر بألف مرة من تلك المستخدمة لتدريب GPT-3.5 ستظل بحاجة إلى احتواء ملايين القصص. قال نجوين: "لا أعرف مقدار الأموال التي ترغب في إنفاقها، لكنني أعتقد أنك لن تقوم بتعيين متخصصين لكتابة [ملايين] قصة قصيرة".

قد يتطلب الأمر مؤلفًا غزير الإنتاج بشكل غير عادي لإرضاء هؤلاء القراء النهمين، لكن إلدان كان لديه عدد قليل من المرشحين في ذهنه. من الأفضل أن يكتب لجمهور من نماذج اللغات الصغيرة أكثر من النماذج الكبيرة؟

قصص لعبة

شرع إلدان على الفور في إنشاء مكتبة من قصص الأطفال الاصطناعية التي تم إنشاؤها بواسطة نماذج لغوية كبيرة. لكنه سرعان ما اكتشف أنه حتى النماذج الحديثة ليست مبدعة بشكل طبيعي. إذا طلبت من GPT-4 أن يكتب قصصًا مناسبة للأطفال بعمر 4 سنوات، قال إلدان: "حوالي خمس القصص ستكون عن أطفال يذهبون إلى الحديقة ويخافون من الشرائح". من الواضح أن هذه هي القصة المثالية لمرحلة ما قبل المدرسة، فيما يتعلق بالإنترنت.

كان الحل هو إضافة القليل من العشوائية إلى الموجه. أولاً، استخدم إلدان GPT-4 لإنشاء قائمة تضم 1,500 من الأسماء والأفعال والصفات التي قد يعرفها طفل يبلغ من العمر 4 سنوات - وهي قصيرة بما يكفي ليتمكن من التحقق منها بسهولة بنفسه. ثم كتب برنامجًا حاسوبيًا بسيطًا من شأنه أن يحث GPT-3.5 أو GPT-4 بشكل متكرر على إنشاء قصة مناسبة للعمر تتضمن ثلاث كلمات عشوائية من القائمة، بالإضافة إلى تفاصيل إضافية تم اختيارها عشوائيًا مثل نهاية سعيدة أو تطور في الحبكة. ومن حسن الحظ أن القصص الناتجة كانت أقل تركيزًا على الشرائح المخيفة.

أصبح لدى إلدان الآن إجراء لإنتاج بيانات التدريب حسب الطلب، لكنه لم يكن لديه أي فكرة عن عدد القصص التي سيحتاجها لتدريب نموذج وظيفي، أو حجم هذا النموذج الذي يجب أن يكون. وذلك عندما تعاونت مع يوانزي لي، باحث في التعلم الآلي في مايكروسوفت وجامعة كارنيجي ميلون، لتجربة إمكانيات مختلفة، مستفيدًا من حقيقة إمكانية تدريب النماذج الصغيرة بسرعة كبيرة. كانت الخطوة الأولى هي تحديد كيفية تقييم نماذجهم.

المُقدّمة

في أبحاث نماذج اللغة - كما هو الحال في كل الفصول الدراسية - يعد التقييم موضوعًا مشحونًا بالتوتر. هناك لا يوجد عنوان مثالي الذي يتضمن كل ما يريد الباحثون معرفته، والنماذج التي تتفوق في بعض المهام غالبًا ما تفشل بشكل مذهل في مهام أخرى. مع مرور الوقت، طور الباحثون معايير قياسية مختلفة بناءً على أسئلة ذات إجابات لا لبس فيها، وهو أسلوب جيد إذا كنت تحاول تقييم مهارات معينة. لكن إلدان ولي كانا مهتمين بشيء أكثر غموضًا: ما الحجم الذي يجب أن تكون عليه نماذج اللغة إذا قمت بتبسيط اللغة قدر الإمكان؟

قال إلدان: "من أجل اختبار ما إذا كان النموذج يتحدث الإنجليزية بشكل مباشر، أعتقد أن الشيء الوحيد الذي يمكنك فعله هو السماح للنموذج بتوليد اللغة الإنجليزية بطريقة مفتوحة".

هناك طريقتان فقط لقياس أداء النموذج في مثل هذه الأسئلة النوعية: الاعتماد على طلاب الصف البشري، أو اللجوء مرة أخرى إلى GPT-4. اختار الباحثان المسار الأخير، حيث سمحا للنماذج الكبيرة بكتابة الكتب المدرسية وتقييم المقالات.

قال بهاجافاتولا إنه كان يود أن يرى كيف يمكن مقارنة تقييمات GPT-4 بتقييمات المراجعين البشريين، فقد يكون GPT-4 متحيزًا تجاه النماذج التي ساعد في تدريبها، كما أن غموض النماذج اللغوية يجعل من الصعب تحديد مثل هذه التحيزات. لكنه لا يعتقد أن مثل هذه التفاصيل الدقيقة من شأنها أن تؤثر على المقارنات بين النماذج المختلفة التي تم تدريبها على مجموعات مماثلة من القصص الاصطناعية، وهو محور التركيز الرئيسي لعمل إلدان ولي.

استخدم إلدان ولي إجراءً مكونًا من خطوتين لتقييم كل نموذج من نماذجهما الصغيرة بعد التدريب. أولاً، قاموا بتحفيز النموذج الصغير مع النصف الأول من القصة المميزة عن تلك الموجودة في مجموعة بيانات التدريب بحيث أنشأ نهاية جديدة، وكرر هذه العملية مع 50 قصة اختبار مختلفة. ثانيًا، طلبوا من GPT-4 تصنيف نهايات النموذج الصغير بناءً على ثلاث فئات: الإبداع، والقواعد، والاتساق مع بداية القصة. ثم قاموا بحساب متوسط الدرجات في كل فئة، وانتهى بهم الأمر بثلاث درجات نهائية لكل نموذج.

مع تنفيذ هذا الإجراء، أصبح إلدان ولي جاهزين أخيرًا لمقارنة النماذج المختلفة ومعرفة الطلاب المتميزين.

نتائج الإختبار

وبعد بعض الاستكشافات الأولية، استقر الباحثون على مجموعة بيانات تدريبية تحتوي على ما يقرب من مليوني قصة. ثم استخدموا مجموعة البيانات هذه، التي أطلق عليها اسم TinyStories، لتدريب نماذج تتراوح أحجامها من مليون إلى 2 مليون معلمة، بأعداد مختلفة من الطبقات. لقد كان العمل سريعًا: باستخدام أربع وحدات معالجة رسوميات فقط، لم يستغرق تدريب أكبر هذه النماذج أكثر من يوم واحد.

كافحت أصغر النماذج. على سبيل المثال، تبدأ إحدى القصص الاختبارية برجل لئيم المظهر يخبر فتاة أنه سيأخذ قطتها. لقد علق نموذج ذو مليون معلمة في حلقة مفرغة مع الفتاة التي أخبرت الرجل مرارًا وتكرارًا أنها تريد أن تكونا أصدقاء. لكن أداء الأجسام الأكبر حجمًا - والتي لا تزال أصغر بآلاف المرات من GPT-3.5 - كان جيدًا بشكل مدهش. تروي النسخة المكونة من 28 مليون معلمة قصة متماسكة، على الرغم من أن النهاية كانت قاتمة: "بدأت كاتي في البكاء، لكن الرجل لم يهتم. أخذ القطة بعيدًا ولم تر كاتي قطتها مرة أخرى. النهاية."

بالإضافة إلى اختبار نماذجهم الخاصة، قدم إلدان ولي نفس التحدي لـ OpenAI's GPT-2، وهو نموذج ذو 1.5 مليار معلمة تم إصداره في عام 2019. وكان الأمر أسوأ بكثير - قبل النهاية المفاجئة للقصة، هدد الرجل بأخذ الفتاة. إلى المحكمة والسجن والمستشفى والمشرحة وأخيراً محرقة الجثث.

المُقدّمة

قال نجوين إنه من المثير أن مثل هذه النماذج الصغيرة كانت بطلاقة للغاية، ولكن ربما ليس من المستغرب أن يواجه GPT-2 هذه المهمة: إنه نموذج أكبر ولكنه بعيد عن أحدث التطورات، وقد تم تدريبه على مجموعة بيانات مختلفة تمامًا. وأشار إلى أن "تدريب الطفل الدارج على مهام الأطفال الصغار فقط، مثل اللعب ببعض الألعاب، قد يكون أفضل منك أو مني". "لم نتخصص في هذا الشيء البسيط."

لا تعاني المقارنات بين نماذج TinyStories المختلفة من نفس العوامل المربكة. لاحظ إلدان ولي تلميحات بأن الشبكات التي تحتوي على طبقات أقل، ولكن تحتوي على عدد أكبر من الخلايا العصبية في كل طبقة، كانت أفضل في الإجابة على الأسئلة التي تتطلب معرفة واقعية؛ على العكس من ذلك، كانت الشبكات التي تحتوي على طبقات أكثر وعدد أقل من الخلايا العصبية لكل طبقة أفضل في تتبع الشخصيات ونقاط الحبكة من بداية القصة. وجد بهاجافاتولا هذه النتيجة مثيرة للاهتمام بشكل خاص. وقال إنه إذا أمكن تكرارها في نماذج أكبر، "فإن ذلك سيكون نتيجة رائعة حقًا يمكن أن تنبع من هذا العمل".

درس إلدان ولي أيضًا كيف تعتمد قدرات نماذجهما الصغيرة على مدة فترة التدريب. في كل حالة، أتقنت النماذج القواعد أولاً ثم الاتساق لاحقًا. بالنسبة لإلدان، يوضح هذا النمط كيف تؤدي الاختلافات في هياكل المكافأة إلى اختلافات في أنماط اكتساب اللغة بين الشبكات العصبية والأطفال. بالنسبة لنماذج اللغة، التي تتعلم من خلال التنبؤ بالكلمات، فإن "الحافز على الكلمات "أريد أن أحصل عليها" كبير كما هو الحال في الكلمات "الآيس كريم"." ومن ناحية أخرى، فإن الأطفال "لا يهتمون بما إذا كانوا يقولون "أرغب في تناول بعض الآيس كريم" أو مجرد "آيس كريم، آيس كريم، آيس كريم"."

الجودة مقابل الكمية

ويأمل إلدان ولي أن يحفز البحث الباحثين الآخرين على تدريب نماذج مختلفة عليها مجموعة بيانات TinyStories ومقارنة قدراتهم. ولكن غالبًا ما يكون من الصعب التنبؤ بخصائص النماذج الصغيرة التي ستظهر أيضًا في النماذج الأكبر حجمًا.

"ربما تكون نماذج الفئران للرؤية بمثابة وكلاء جيدين للرؤية البشرية، ولكن هل نماذج الفئران للاكتئاب هي نماذج جيدة للاكتئاب البشري؟" قال بافليك. "في كل حالة يكون الأمر مختلفًا بعض الشيء."

ويشير نجاح نماذج TinyStories أيضًا إلى درس أوسع نطاقًا. يتضمن النهج القياسي لتجميع مجموعات بيانات التدريب مسح النص من جميع أنحاء الإنترنت ثم تصفية البيانات المهملة. يمكن للنص الاصطناعي الذي تم إنشاؤه بواسطة النماذج الكبيرة أن يوفر طريقة بديلة لتجميع مجموعات بيانات عالية الجودة والتي لا يجب أن تكون كبيرة جدًا.

وقال إلدان: "لدينا المزيد والمزيد من الأدلة على أن هذا فعال للغاية، ليس فقط في النماذج ذات الحجم الصغير، ولكن أيضًا في النماذج الأكبر حجمًا". يأتي هذا الدليل من ورقتي متابعة حول نماذج ذات مليار معلمة كتبها إلدان ولي وباحثون آخرون في مايكروسوفت. في ال الورقة الأولىقاموا بتدريب نموذج لتعلم لغة البرمجة Python باستخدام مقتطفات من التعليمات البرمجية التي تم إنشاؤها بواسطة GPT-3.5 بالإضافة إلى تعليمات برمجية منسقة بعناية من الإنترنت. في ال ثانفقد قاموا بتعزيز مجموعة بيانات التدريب باستخدام "كتب مدرسية" اصطناعية تغطي نطاقًا واسعًا من المواضيع لتدريب نموذج لغة للأغراض العامة. في اختباراتهم، تمت مقارنة كلا النموذجين بشكل إيجابي مع النماذج الأكبر التي تم تدريبها على مجموعات بيانات أكبر. لكن تقييم النماذج اللغوية دائمًا ما يكون أمرًا صعبًا، ولا يزال نهج بيانات التدريب التركيبية في بداياته، ومن الضروري إجراء المزيد من الاختبارات المستقلة.

مع نمو النماذج اللغوية الحديثة بشكل أكبر من أي وقت مضى، فإن النتائج المفاجئة التي توصل إليها أبناء عمومتها الصغار هي تذكير بأنه لا يزال هناك الكثير مما لا نفهمه حتى عن أبسط النماذج. ويتوقع نجوين أن يرى المزيد من الأوراق البحثية التي تستكشف النهج الذي ابتكرته شركة TinyStories.

"السؤال هو: أين ولماذا يهم الحجم؟" هو قال. "يجب أن يكون هناك علم بذلك، ونأمل أن تكون هذه الورقة بداية لقصة غنية."

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- PlatoData.Network Vertical Generative Ai. تمكين نفسك. الوصول هنا.

- أفلاطونايستريم. ذكاء Web3. تضخيم المعرفة. الوصول هنا.

- أفلاطون كربون، كلينتك ، الطاقة، بيئة، شمسي، إدارة المخلفات. الوصول هنا.

- أفلاطون هيلث. التكنولوجيا الحيوية وذكاء التجارب السريرية. الوصول هنا.

- المصدر https://www.quantamagazine.org/tiny-language-models-thrive-with-gpt-4-as-a-teacher-20231005/

- :لديها

- :يكون

- :ليس

- :أين

- ] [ص

- $ UP

- 000

- 1

- 200

- 200 مليار

- 2019

- 2022

- 30

- 50

- 500

- a

- القدرات

- القدرة

- من نحن

- استحواذ

- في

- تضيف

- إضافة

- إضافي

- المجاور

- مميزات

- تؤثر

- بعد

- مرة أخرى

- allen

- وحده

- على طول

- سابقا

- أيضا

- البديل

- دائما

- an

- و

- أندرو

- آخر

- إجابة

- الأجوبة

- تظهر

- نهج

- مناسب

- أرشيف

- هي

- تنشأ

- ترتيبها

- فنـون

- مصطنع

- الذكاء الاصطناعي

- AS

- At

- جمهور

- المعزز

- المؤلفة

- بعيدا

- على أساس

- BE

- قبل

- البداية

- سلوك

- وراء

- يجري

- المعايير

- أفضل

- ما بين

- انحيازا

- التحيزات

- كبير

- مليار

- المليارات

- قطعة

- على حد سواء

- دماغ

- أوسع

- بنى

- لكن

- by

- تسمى

- أتى

- CAN

- المرشحين

- قدرات

- الموارد

- يهمني

- بعناية

- كارنيجي ميلون

- حقيبة

- قط

- الفئات

- الفئة

- معين

- تحدى

- التحديات

- الخصائص

- الأحرف

- شات جي بي تي

- أرخص

- التحقق

- أطفال

- اختار

- اختيار

- فئة

- الكود

- متماسك

- يأتي

- الشركات

- قارن

- مقارنة

- مقارنات

- إكمال

- الانتهاء

- معقد

- تضم

- الكمبيوتر

- مفهوم

- قلق

- التواصل

- ثابتة

- تحتوي على

- يحتوي

- استمر

- مراقبة

- العكس بالعكس

- رائع

- المقابلة

- مكلفة

- استطاع

- زوجان

- محكمة

- تغطية

- خلق

- الإبداع

- الإبداع

- من تنسيق

- البيانات

- مجموعة البيانات

- مجموعات البيانات

- يوم

- اتخاذ القرار

- العقل العميق

- الطلب

- الاكتئاب المزمن.

- التفاصيل

- تفاصيل

- تطوير

- المتقدمة

- نظام خاص للتغذية

- الخلافات

- مختلف

- الصعوبات

- مباشرة

- اكتشف

- خامد

- do

- هل

- لا

- لا

- عيوب

- يطلق عليها اسم

- مدة الأقامة

- أثناء

- كل

- في وقت سابق

- أسهل

- بسهولة

- سهل

- الطُرق الفعّالة

- على نحو فعال

- احتضنت

- يغلف

- النهاية

- إنهاء

- انجليزي

- كاف

- خاصة

- تقييم

- تقييم

- التقييمات

- حتى

- أحداث

- EVER

- كل

- كل شىء

- دليل

- مثال

- Excel

- المثيره

- تتوقع

- استكشاف

- اكتشف

- استكشاف

- غير عادي

- مواجهة

- حقيقة

- العوامل

- حقائق

- يفشلون

- بعيدا

- أسرع

- قليل

- أقل

- الأرقام

- تصفية

- نهائي

- أخيرا

- النتائج

- الاسم الأول

- تناسب

- تركز

- ركز

- اتباع

- في حالة

- وجدت

- أربعة

- فرنسا

- الاصدقاء

- تبدأ من

- وظيفي

- إضافي

- هدف عام

- توليد

- ولدت

- توليدي

- عملاق

- بنت

- معطى

- الذهاب

- خير

- حصلت

- يحكم

- وحدات معالجة الرسومات

- درجة

- قواعد

- يفهم، يمسك، يقبض

- متجهم

- النمو

- كان

- نصفي

- يد

- سعيد

- الثابت

- يملك

- he

- قلب

- ساعد

- مفيد

- لها

- عالي الجودة

- تلميحات

- تأجير

- له

- أمل

- نأمل

- مستشفى

- كيفية

- كيفية

- HTTPS

- الانسان

- مئات

- i

- ICE

- مثلجات

- فكرة

- if

- يوضح

- فورا

- in

- حافز

- شامل

- القيمة الاسمية

- مستقل

- بالمعلومات

- في البداية

- في البداية

- موحى

- معهد

- تعليمات

- رؤيتنا

- يستفد

- وكتابة مواضيع مثيرة للاهتمام

- السطح البيني

- Internet

- إلى

- مثيرة للاهتمام

- أدخلت

- IT

- انها

- نفسها

- سجن

- انضم

- م

- احتفظ

- حفظ

- علم

- المعرفة

- لغة

- كبير

- أكبر

- أكبر

- الى وقت لاحق

- طبقة

- طبقات

- قيادة

- تعلم

- تعلم

- تعلم

- الأقل

- أقل

- درس

- اسمحوا

- السماح

- Li

- المكتبة

- الحياة

- مثل

- على الأرجح

- محدود

- خطوط

- قائمة

- القليل

- منطق

- آلة

- آلة التعلم

- مجلة

- الرئيسية

- جعل

- يصنع

- القيام ب

- رجل

- التحكم

- كثير

- هائل

- رئيسي

- اتقان

- الرياضيات

- رياضي

- أمر

- مايو..

- me

- يعني

- قياس

- ميلون

- طريقة

- مایکروسافت

- ربما

- مليون

- ملايين

- مانع

- نموذج

- عارضات ازياء

- مال

- الأكثر من ذلك

- كثيرا

- طبيعي

- تقريبا

- ضروري

- حاجة

- إحتياجات

- شبكة

- الشبكات

- عصبي

- الشبكة العصبية

- الشبكات العصبية

- الخلايا العصبية

- أبدا

- جديد

- التالي

- نجوين

- لا

- وأشار

- الأسماء

- الآن

- أرقام

- رصد

- of

- عرض

- غالبا

- on

- مرة

- ONE

- منها

- فقط

- عتامة

- OpenAI

- تعمل

- or

- طلب

- أخرى

- أخرى

- خارج

- الناتج

- على مدى

- الخاصة

- زوج

- ورق

- أوراق

- موازية

- المعلمات

- متنزهات

- مرور

- الماضي

- نمط

- أنماط

- مجتمع

- إلى

- أداء

- تنفيذ

- ربما

- فترة

- رائدة

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- لعب

- نقاط

- إمكانيات

- ممكن

- نشر

- القوى

- تنبأ

- توقع

- تنبؤ

- تمهيدي

- قدم

- مبدأ

- مشاكل

- الإجراءات

- عملية المعالجة

- المعالجات

- إنتاج

- المهنيين

- البرنامج

- برمجة وتطوير

- جمهور

- بايثون

- نوعي

- كوانتماجازين

- سؤال

- الأسئلة المتكررة

- سريع

- بسرعة

- المثالية

- رفع

- عشوائية

- العشوائية

- نطاق

- تتراوح

- بسرعة

- عرض

- القراء

- استعداد

- أدركت

- في الحقيقة

- مؤخرا

- بغض النظر

- نسبي

- صدر

- اعتمد

- مرارا وتكرارا

- منسوخة

- مطلوب

- يتطلب

- مطلوب

- بحث

- الباحث

- الباحثين

- الموارد

- نتيجة

- مما أدى

- النتائج

- مكافأة

- النوادي الثرية

- تقريبا

- طريق

- القواعد

- تشغيل

- قال

- نفسه

- رأى

- قول

- خائفة

- علوم

- علمي

- سياتل

- الثاني

- انظر تعريف

- التسلسل

- الخادم

- طقم

- باكجات

- التسوية (Settled)

- هي

- قصير

- ينبغي

- أظهرت

- مماثل

- الاشارات

- بساطة

- تبسيط

- ببساطة

- المقاس

- مهارات

- الشرائح

- صغير

- الأصغر

- So

- حل

- حل

- بعض

- شيء

- قريبا

- يتحدث

- متخصصون

- متخصص

- محدد

- أنفق

- الإنفاق

- انتشار

- معيار

- Star

- بدأت

- الولايه او المحافظه

- دولة من بين الفن

- جذع

- خطوة

- لا يزال

- قصص

- قصتنا

- قوة

- صارم

- الهياكل

- طالب

- عدد الطلبة

- مدروس

- دراسة

- موضوع

- تحقيق النجاح

- هذه

- اقترح

- وتقترح

- فائق

- مندهش

- مفاجئ

- اصطناعي

- نظام

- أنظمة

- أخذ

- مع الأخذ

- مهمة

- المهام

- انظم

- اقول

- يقول

- تجربه بالعربي

- الاختبار

- اختبارات

- نص

- من

- أن

- •

- الدولة

- العالم

- من مشاركة

- منهم

- أنفسهم

- then

- تشبه

- هم

- شيء

- اعتقد

- هؤلاء

- على الرغم من؟

- ألف

- الآلاف

- يهدد

- ثلاثة

- تزدهر

- الوقت

- مرات

- إلى

- اليوم

- قال

- جدا

- استغرق

- موضوع

- المواضيع

- نحو

- مسار

- قطار

- متدرب

- قادة الإيمان

- تحول

- حقا

- محاولة

- يحاول

- منعطف أو دور

- تحريف

- اثنان

- عادة

- خضع

- فهم

- فهم

- غير مألوف

- جامعة

- بناء على

- مستعمل

- استخدام

- مختلف

- متفاوتة

- كبير

- الإصدار

- الإصدارات

- مقابل

- جدا

- رؤيتنا

- تريد

- مطلوب

- وكان

- طريق..

- طرق

- we

- ويب بي

- أسابيع

- حسن

- كان

- متى

- سواء

- التي

- من الذى

- لمن

- لماذا

- واسع

- مدى واسع

- سوف

- مع

- كلمة

- كلمات

- للعمل

- عمل

- أعمال

- العالم

- أسوأ

- سوف

- اكتب

- كتب

- عام

- أنت

- زفيرنت