কয়েক দশক ধরে, Amazon মেশিন লার্নিং (ML) এর অগ্রগামী এবং উদ্ভাবন করেছে, এর গ্রাহকদের জন্য আনন্দদায়ক অভিজ্ঞতা এনেছে। প্রথম দিন থেকে, অ্যামাজন বিভিন্ন ব্যবহারের ক্ষেত্রে যেমন বইয়ের সুপারিশ, অনুসন্ধান এবং জালিয়াতি সনাক্তকরণের জন্য ML ব্যবহার করেছে। শিল্পের বাকি অংশের মতো, ত্বরিত হার্ডওয়্যারের অগ্রগতি অ্যামাজন দলগুলিকে নিউরাল নেটওয়ার্ক এবং গভীর শিক্ষা (ডিএল) ব্যবহার করে মডেল আর্কিটেকচারগুলি অনুসরণ করার অনুমতি দিয়েছে।

Amazon অনুসন্ধানের মধ্যে M5 প্রোগ্রামটি Amazon-এর জন্য আবিষ্কার শেখার কৌশলের মালিক এবং বহু-ভাষিক, বহু-স্থানীয়, বহু-সত্তা, মাল্টি-টাস্ক, এবং বহু-মডেল যেমন পাঠ্য, চিত্র এবং ভিডিও জুড়ে বড় আকারের মডেল তৈরি করে। M5 প্রোগ্রামটি খরচ অপ্টিমাইজেশানের উপর কঠোর নিয়ন্ত্রণ বজায় রেখে আমাজন জুড়ে শত শত এমএল টিমের কাছে সর্বজনীন এম্বেডিং এবং বৃহৎ মাপের ফাউন্ডেশন মডেল পরিবেশন করছে। এটি অর্জন করার জন্য, M5 টিম নিয়মিতভাবে খরচ কমাতে নতুন কৌশল মূল্যায়ন করে।

অনেক ML সংস্থার মতো, এক্সিলারেটরগুলি মূলত DL প্রশিক্ষণ এবং অনুমানকে ত্বরান্বিত করতে ব্যবহৃত হয়। যখন AWS প্রথম প্রকাশের সাথে উদ্দেশ্য-নির্মিত এক্সিলারেটর চালু করে এডাব্লুএস ইনফেরেন্টিয়া 2020 সালে, M5 টিম দ্রুত শুরু করে উৎপাদন কাজের চাপ আরো দক্ষতার সাথে স্থাপন করতে তাদের ব্যবহার করুন, খরচ সাশ্রয় এবং বিলম্বতা হ্রাস উভয়. গত বছর, AWS এটি চালু করেছে এডব্লিউএস ট্রেনিয়াম এক্সিলারেটর, যা পরবর্তী প্রজন্মের DL মডেলগুলি বিকাশ ও নির্মাণের জন্য খরচ প্রতি পারফরম্যান্সকে অপ্টিমাইজ করে। এই পোস্টে, আমরা আলোচনা করেছি যে M5 কীভাবে তাদের মডেলগুলিকে প্রশিক্ষণের খরচ 30% কমাতে সক্ষম হয়েছিল, এবং আমরা পথের মধ্যে শিখেছি এমন কিছু সেরা অনুশীলনগুলি ভাগ করে নিয়েছি।

ট্রেনিয়াম উদাহরণ

উদ্দেশ্য-নির্মিত এক্সিলারেটরের অগ্রগতির সাথে, Amazon AWS Inferentia এবং Trainium-এর আকারে আকর্ষক অ্যাক্সিলারেটর সরবরাহ করে। তাদের নাম থেকে বোঝা যায়, এই চিপগুলি যথাক্রমে অনুমান এবং প্রশিক্ষণের কাজের চাপের প্রয়োজনগুলি অতিক্রম করার জন্য অপ্টিমাইজ করা হয়েছে। বিশাল আকারের ফাউন্ডেশন মডেলের প্রশিক্ষণের জন্য যা আকারে বিলিয়ন প্যারামিটারে পৌঁছায়, ট্রেনিয়াম Trn1 এবং Trn1n উদাহরণ তাদের বৈশিষ্ট্যের কারণে আদর্শ পছন্দ। Trn1 দৃষ্টান্তগুলি অত্যাধুনিক দ্বারা চালিত হয়৷ নিউরনকোর-v2, এবং প্রচুর পরিমাণে অ্যাক্সিলারেটর কম্পিউট এবং মেমরি আছে। Trn1n দৃষ্টান্তগুলিও অধিক পরিমাণে নেটওয়ার্কিং ব্যান্ডউইথের (1,600 Gbs) জন্য বেছে নেওয়া যেতে পারে, তাই খরচ অপ্টিমাইজেশানকে মাথায় রেখে পারফরম্যান্ট প্রশিক্ষণের জন্য আদর্শভাবে উপযুক্ত।

এক্সিলারেটর ব্যবহার করতে, তাদের সমর্থন করার জন্য আপনার একটি সফ্টওয়্যার স্তর প্রয়োজন। Trn এবং Inf চিপ সহ, AWS নিউরন SDK PyTorch XLA-এর সাহায্যে অ্যামাজন উদ্দেশ্য-নির্মিত এক্সিলারেটর আনলক করে। PyTorch XLA PyTorch-এর আগ্রহী মোডকে অলস মোডে গ্রাফ-ভিত্তিক বাস্তবায়নে রূপান্তরিত করে। এই গ্রাফগুলি তারপর ব্যবহার করা হয় এবং আরও সংকলন করা হয় যাতে এক্সিলারেটরের সাথে ব্যবহার করা যায়। PyTorch Neuron (Neuron SDK-এর অংশ) PyTorch ব্যবহারকারীদেরকে তাদের মডেলকে ট্রেনিয়াম নিউরনকোরসে কয়েকটি লাইনের কোড দিয়ে প্রশিক্ষণ দিতে সক্ষম করে।

মডেল এবং কাজের চাপ

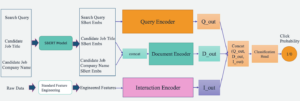

M5 টিম আমাজন জুড়ে বিভিন্ন দলকে আনন্দ আনতে সহায়তা করার জন্য ভিত্তিমূলক মডেল এবং সর্বজনীন উপস্থাপনা প্রশিক্ষণ দেয় এবং স্থাপন করে Amazon.com গ্রাহকদের এরকম একটি মডেল হল একটি টেক্সট এনকোডার মডেল যার পরে একটি মাল্টি-লেয়ার পারসেপ্টরন (এমএলপি) রয়েছে যেখানে কয়েক মিলিয়ন প্রশিক্ষণযোগ্য প্যারামিটার সহ নিউরাল নেটওয়ার্ক আর্কিটেকচার দ্বারা সংজ্ঞায়িত স্পষ্ট বা অন্তর্নিহিত বৈশিষ্ট্য মিথস্ক্রিয়া রয়েছে। এই মডেলটি বিলিয়ন টোকেনের উপর প্রশিক্ষিত, এবং অফলাইন ব্যাচ ইনফারেন্স সেটিংয়ে লক্ষ লক্ষ এমবেডিং তৈরি করতে ব্যবহৃত হয়। এই এমবেডিংগুলি একটি গ্রাহক-মুখী স্তর-1 অ্যামাজন পরিষেবার ইনপুট।

উৎপাদন পাইপলাইনের জন্য অবকাঠামো ব্যবহার করে AWS ব্যাচ সঙ্গে ন্যায্য শেয়ার সারিবদ্ধ কৌশল, মডেল প্রশিক্ষণের জন্য গণনা হিসাবে একটি EFA-সক্ষম মাল্টি-নোড trn1.32xlarge ক্লাস্টার ব্যবহার করে। কার্যকরীভাবে, উত্পাদন পাইপলাইন ক্রমবর্ধমান মডেল প্রশিক্ষণ, প্রশিক্ষিত মডেলের মূল্যায়ন এবং প্রশিক্ষিত মডেলের অফলাইন ব্যাচ অনুমান সম্পাদন করে, সমস্তই অন্তর্নিহিত DL লাইব্রেরি হিসাবে PyTorch ব্যবহার করে।

গোল

আমাদের গ্রাহকদের আনন্দিত করা একটি অগ্রণী নীতি। পাইপলাইনের গ্রাহক-মুখী প্রকৃতির পরিপ্রেক্ষিতে, এটি গুরুত্বপূর্ণ যে সমস্ত পরিষেবা-স্তরের চুক্তিগুলি (এসএলএ) রিগ্রেশন ছাড়াই পূরণ করা হবে। আমরা আমাদের বিদ্যমান GPU উৎপাদন পাইপলাইনকে মানিয়ে নিতে এবং এটিকে Trainium-এ রূপান্তর করার জন্য দুটি গুরুত্বপূর্ণ গ্রহণযোগ্যতার মানদণ্ড চিহ্নিত করেছি:

- মডেল গুণমান - আমাদের মডেলের গুণমান গ্রাহকের অভিজ্ঞতাকে সরাসরি প্রভাবিত করে। আমরা চাই যে জিপিইউ এবং ট্রেনিয়ামের মধ্যে মডেলের মানের মধ্যে 0.1% এর কম পার্থক্য থাকা উচিত।

- প্রশিক্ষণ থ্রুপুট - আমাদের গ্রাহকদের নতুন অভিজ্ঞতা প্রদানের জন্য আমরা পর্যায়ক্রমে আমাদের মডেলগুলিকে প্রশিক্ষণ দিই। আমরা চাই যে মডেল কনভারজেন্স আমাদের উত্পাদন SLA পূরণের জন্য একটি পূর্বনির্ধারিত সময়ের মধ্যে (যেমন 1 সপ্তাহ) অর্জন করতে হবে।

নিম্নলিখিত বিভাগগুলিতে, আমরা এই মানদণ্ড থেকে পিছিয়ে যাওয়ার আমাদের যাত্রা এবং অ্যামাজন-স্কেল উত্পাদন কাজের চাপকে সমর্থন করার জন্য আমাদের শিক্ষাগুলি ভাগ করি।

প্রশিক্ষণ স্ক্রিপ্ট

মডেল প্রশিক্ষণ দিয়ে শুরু করার আগে, আমাদের প্রশিক্ষণ স্ক্রিপ্টে পরিবর্তন করতে হবে যাতে এটি XLA অনুগত হয়। মডেলের আকারের পরিপ্রেক্ষিতে, আমরা মডেলটিকে প্রশিক্ষণ দিতে ডিস্ট্রিবিউটেড ডেটা প্যারালাল (ডিডিপি) ব্যবহার করি। DDP আমাদেরকে কোনো কোড পরিবর্তন ছাড়াই মডেল প্রশিক্ষণ চালানোর জন্য ব্যবহৃত মেশিনের সংখ্যা বাড়িয়ে মডেল প্রশিক্ষণের থ্রুপুট বাড়ানোর অনুমতি দেয়। আমরা প্রদত্ত নির্দেশাবলী অনুসরণ নিউরন পাইটর্চ এমএলপি প্রশিক্ষণ টিউটোরিয়াল আমাদের প্রশিক্ষণ স্ক্রিপ্টগুলিতে XLA-নির্দিষ্ট নির্মাণ যোগ করতে। এই কোড পরিবর্তনগুলি কার্যকর করা সহজ। নিম্নলিখিত অনুশীলন থেকে কিছু উল্লেখযোগ্য প্রযুক্তিগত শিক্ষা রয়েছে যা আমাদের মডেল থ্রুপুটকে ব্যাপকভাবে উন্নত করেছে:

- xm.mark_step() এর বসানো -

xm.mark_step()অলসভাবে সংগৃহীত গণনা গ্রাফগুলি সংকলন করে এবং চালায়। আহ্বানmark_stepখুব বেশি বার ছোট গ্রাফের একটি বড় সংখ্যার দিকে নিয়ে যাবে, যেখানে এটিকে খুব কম বার আহ্বান করলে কয়েকটি, কিন্তু বড় গ্রাফ হবে৷ আপনার আবেদনের উপর নির্ভর করে, আপনার মডেল প্রশিক্ষণের থ্রুপুট এবং বাস্তবায়ন আপনার প্লেসমেন্টের উপর ভিত্তি করে পরিবর্তিত হবেxm.mark_step(). আমাদের বাস্তবায়ন একটি স্থানxm.mark_step()একটি ফরোয়ার্ড এবং ব্যাকওয়ার্ড পাসের পরে, এবং একটি অপ্টিমাইজার ধাপের পরে৷ - এক্সএলএ মাল্টিপ্রসেসিং ডিভাইস লোডারের সাথে ডেটা লোডার মোড়ানো - এটি একটি গুরুত্বপূর্ণ পদক্ষেপ যা সহজেই মিস করা যেতে পারে। মাল্টিপ্রসেসিং ডিভাইস লোডার

torch_xla.distributed.parallel_loader.MpDeviceLoaderথ্রুপুট উন্নত করার জন্য ডিভাইস রানের সাথে প্রিলোড এবং ওভারল্যাপ করার বিকল্পগুলির সাথে প্রতিটি XLA ডিভাইসে প্রশিক্ষণ ডেটা লোড করে। ডিভাইস লোডারও আহ্বান করেxm.mark_step()এবং তাই হোস্ট থেকে ডিভাইসে ডেটা লোড করার জন্য গ্রাফ তৈরি করতে সক্ষম।

Trainium জন্য সংকলন

ঐতিহ্যগতভাবে, GPU-এর সাথে মডেল ডেভেলপমেন্ট চক্র মডেল বা প্রশিক্ষণ স্ক্রিপ্ট পরিবর্তন করা এবং সরাসরি GPU ডিভাইসে এটি চালানো জড়িত। ট্রেনিয়ামের মতো এক্সিলারেটর যেগুলি এক্সএলএ ব্যবহার করে মডেল প্রশিক্ষণের আগে এক্সিলারেটরে চালানোর জন্য একটি অতিরিক্ত পদক্ষেপের প্রয়োজন হয়। XLA গণনা গ্রাফগুলি কম্পাইল করার পরেই চালানো যেতে পারে। সাধারণত, এই সংকলনটি সম্পাদন করার দুটি উপায় রয়েছে: সময়ের আগে (AOT), যেখানে আপনি প্রথমে সমস্ত গ্রাফ ট্রেস এবং কম্পাইল করেন এবং তারপরে সেগুলি চালান, বা জাস্ট ইন টাইম (JIT), যেখানে গ্রাফগুলি ট্রেস করা হয়, কম্পাইল করা হয় এবং চালানো হয়। সম্মুখীন হয় নিউরন SDK এই দুটিই বাক্সের বাইরে সরবরাহ করে। সাধারণত, AOT সংকলন প্রথমে সঞ্চালিত হয়। এই সংকলনের পরে গ্রাফগুলি চালানো হয়। যদি নতুন গ্রাফের সম্মুখীন হয়, নিউরন রানটাইম তাদের চালানোর আগে একটি JIT সংকলন আহ্বান করে। AOT সংকলন সম্পাদন করতে, নিউরন SDK প্রদান করে neuron_parallel_compile, একটি সংকলন ইউটিলিটি যা প্রশিক্ষণ স্ক্রিপ্টের ট্রায়াল রান থেকে গ্রাফ বের করে এবং সমান্তরাল AOT সংকলন করে।

AOT সংকলনের একটি গুরুত্বপূর্ণ দিক হল প্রশিক্ষণ চলাকালীন কোনো নতুন কম্পিউটেশন গ্রাফ তৈরি না করা নিশ্চিত করা। নতুন গণনা গ্রাফের একটি উৎস (এবং সেইজন্য পুনঃসংকলন) হল মডেল প্রশিক্ষণের সময় প্রশিক্ষণ ব্যাচগুলির গতিশীল আকার। আমরা দেখেছি যে স্থির আকার এবং নির্দিষ্ট-আকারের ব্যাচগুলি ব্যবহার করা প্রশিক্ষণের সময় সংকলনকে দূর করে এবং মডেলের নির্ভুলতার উপর কোনও প্রভাব ছাড়াই প্রশিক্ষণের থ্রুপুটকে ব্যাপকভাবে উন্নত করে। প্রশিক্ষণে এই ধরনের সীমাবদ্ধতা প্রয়োগ করে, আমরা লক্ষ্য করেছি যে AOT সংকলনের সময় সমস্ত গ্রাফ ট্রেস করার জন্য মডেল প্রশিক্ষণের মাত্র 4-5 ধাপ, মডেল যাচাইকরণের এক ধাপ এবং মডেলটিকে একবার চেকপয়েন্ট করা প্রয়োজন। এটি লক্ষ্য করা গুরুত্বপূর্ণ যে নিউরন SDK ক্রমাগত বিকশিত হচ্ছে এবং ভবিষ্যতে গতিশীল আকারগুলিকেও সমর্থন করবে৷

তদ্ব্যতীত, সংকলিত গ্রাফগুলি এতে সংরক্ষণ করা হয় নিউরন পারসিস্টেন্ট ক্যাশে ডিস্কে বা একটিতে আমাজন সিম্পল স্টোরেজ সার্ভিস (Amazon S3) বালতি। এটি বিশেষ করে প্রোডাকশন ওয়ার্কলোডের জন্য উপযোগী যেখানে মডেল আর্কিটেকচার এবং ট্রেনিং কনফিগারেশন পরিবর্তন হয় না। অতএব, সংকলনের ওভারহেড মাত্র এক বার ব্যয় হয়। ক্যাশে ব্যবহার করা পরিবেশের পতাকা সেট করার মতোই সহজ:

নিউরন কম্পাইলার তিনটি প্রদান করে কম্পাইলার-স্তরের অপ্টিমাইজেশান অপশন (O1, O2, O3) সংকলনের সময় এবং মডেল রান থ্রুপুট ভারসাম্য বজায় রাখতে। O1 কম্পিউট গ্রাফে মূল অপ্টিমাইজেশান সক্ষম করে এবং সংকলনের সময় কমিয়ে দেয়, O3 উচ্চতর সংকলন সময়ের খরচে উন্নত মডেল রান থ্রুপুট প্রদান করে এবং O2 (ডিফল্ট বিকল্প) হল দুটির মধ্যে ভারসাম্য। আমাদের ব্যবহারের ক্ষেত্রে, আমরা O1 অপ্টিমাইজেশান ব্যবহার করেছি এবং ডিফল্ট অপ্টিমাইজেশান (O86) এর তুলনায় থ্রুপুটে প্রায় 5-7% হ্রাস পর্যবেক্ষণ করার সময় মডেল নির্ভুলতা মেট্রিক্সে কোনও পরিবর্তন ছাড়াই কম্পাইলেশন টাইমে 2% হ্রাস লক্ষ্য করেছি। ব্যবহারের ক্ষেত্রের উপর নির্ভর করে, আপনি অপ্টিমাইজেশানের বিভিন্ন স্তর বেছে নিতে পারেন।

সংক্ষেপে, আমরা সংকলনের জন্য নিম্নলিখিত পতাকা ব্যবহার করেছি:

চেকপয়েন্ট সামঞ্জস্য

সংকলন সফলভাবে সম্পন্ন হলে, আমরা ট্রেনিয়ামে আমাদের মডেলগুলিকে প্রশিক্ষণ দিতে এগিয়ে যেতে পারি। পূর্বে উল্লিখিত হিসাবে, আমরা ক্রমবর্ধমানভাবে আমাদের মডেলগুলিকে প্রশিক্ষণ দিই, যার অর্থ আমরা একটি পূর্বে প্রশিক্ষিত মডেল চেকপয়েন্ট লোড করি এবং নতুন ডেটা সহ প্রশিক্ষণ চালিয়ে যাই। PyTorch এবং PyTorch XLA চেকপয়েন্ট আন্তঃঅপারেবিলিটির মাধ্যমে এক্সিলারেটরগুলির মধ্যে বিরামহীন স্থানান্তরের অনুমতি দেয়। GPU এবং Trainium-এর মধ্যে চলাফেরার নমনীয়তা থাকার ফলে আমরা পূর্ববর্তী GPU মডেলটিকে নির্বিঘ্নে লোড করতে এবং ট্রেনিয়াম মেশিনে ট্রেন করতে সক্ষম করেছি। এটি নিশ্চিত করার জন্য গুরুত্বপূর্ণ ছিল যে আমরা কোনও উত্পাদন ডাউনটাইম বা মডেলের নির্ভুলতার ক্ষতি ছাড়াই আমাদের মডেলটিকে সেরা পূর্বে প্রশিক্ষিত মডেলের সাথে শুরু করতে পারি।

যেহেতু GPU মডেলটি স্ট্যান্ডার্ড PyTorch মডেল সেভিং ইউটিলিটি ব্যবহার করে সংরক্ষণ করা হয়েছিল, তাই আমরা Trainium ডিভাইসে GPU মডেল লোড করতে PyTorch চেকপয়েন্ট লোডিং ইউটিলিটি ব্যবহার করতে সক্ষম হয়েছি।

উদাহরণস্বরূপ, GPU/CPU-তে, আপনি নিম্নলিখিত কোড দিয়ে মডেলটি সংরক্ষণ করতে পারেন:

তারপরে আপনি ট্রেনিয়ামে মডেলটি লোড করুন:

একইভাবে, আপনি নিম্নলিখিত কোড সহ ট্রেনিয়ামে মডেলটি সংরক্ষণ করতে পারেন:

এবং GPU/CPU-তে মডেলটি আবার লোড করুন:

প্রকৃতপক্ষে, যেহেতু আমরা মডেল প্রশিক্ষণের জন্য DDP ব্যবহার করি, মডেল লোডিং পূর্ববর্তী চেকপয়েন্ট প্রশিক্ষণের জন্য ব্যবহৃত মেশিনের সংখ্যার অজ্ঞেয়। এটি আমাদেরকে কোন কোড পরিবর্তন বা মডেল প্রশিক্ষণের প্রতিকূল প্রভাব ছাড়াই অনুভূমিকভাবে Trn1 ফ্লিট স্কেল করতে দেয়। এই PyTorch-ভিত্তিক চেকপয়েন্টগুলি AWS Inferentia2 বা অন্যান্য অ্যাক্সিলারেটরের অনুমান ব্যবহারের ক্ষেত্রে সরাসরি ব্যবহার করা যেতে পারে বা এমনকি টর্চ-স্ক্রিপ্ট করা যেতে পারে।

অপারেশনাল স্থিতিশীলতা

এটি যথেষ্ট জোর দেওয়া যায় না যে উত্পাদনে চলমান কাজের চাপের জন্য একাধিক এসএলএ পূরণ করা প্রয়োজন। আমাদের ব্যবহারের ক্ষেত্রে, মডেলের গুণমান এবং প্রশিক্ষণের থ্রুপুট এসএলএ ছাড়াও, উত্পাদন পাইপলাইনটি কার্যকরীভাবে স্থিতিশীল হওয়া অপরিহার্য, যার অর্থ মডেল প্রশিক্ষণ, মূল্যায়ন এবং অনুমান করার সময় ন্যূনতম ডাউনটাইম এবং বাধাগুলি।

বিদ্যমান জিপিইউ ভিত্তিক পাইপলাইনের মতো, আমরা পাইপলাইনটিকে কার্যকরীভাবে স্থিতিশীল করতে অসংখ্য প্রক্রিয়া যুক্ত করেছি। মডেল প্রশিক্ষণ শুরু করার আগে, আমরা মেশিনের স্বাস্থ্যের মূল্যায়ন করার জন্য একাধিক স্যানিটি পরীক্ষা চালাই। এই পরীক্ষাগুলি সাধারণত এক্সিলারেটর ডিভাইসগুলির স্বাস্থ্য যাচাই করার জন্য সাধারণ টেনসর অপারেশনগুলিকে অন্তর্ভুক্ত করে। আমরা লক্ষ্য করেছি যে বিতরণ করা প্রশিক্ষণের জন্য, দৃষ্টান্তগুলির মধ্যে যৌথ যোগাযোগ যাচাই করার জন্য পরীক্ষা চালানো গুরুত্বপূর্ণ। আমরা ব্যবহার করি NCCOM টেস্ট স্যুট এটি অর্জনের জন্য নিউরন SDK থেকে, অল-গেদার, অল-রিডুস এবং রিডুস-স্ক্যাটারের মতো বিভিন্ন ধরনের অপারেশন চালাচ্ছে।

এমনকি আমরা উল্লেখিত পরামর্শগুলি অনুসরণ করার পরেও, আমরা লক্ষ্য করেছি যে অন্তর্নিহিত এক্সিলারেটর নির্বিশেষে যে কোনও পাইপলাইনে ক্ষণস্থায়ী সমস্যাগুলি অনিবার্য৷ যেকোনো প্রশিক্ষণ পাইপলাইনে স্থিতিস্থাপকতা তৈরি করতে, আমরা এই সম্ভাব্য সমস্যাগুলি সমাধান করার জন্য পুনরায় চেষ্টা করার প্রক্রিয়া তৈরি করার পরামর্শ দিই। আমরা ব্যাবহার করি AWS ব্যাচ স্বয়ংক্রিয় পুনরায় চেষ্টা মডেল প্রশিক্ষণের সময় একটি ক্ষণস্থায়ী ব্যর্থতার সম্মুখীন যে কাজগুলি পুনরায় চেষ্টা করতে। প্রশিক্ষণের শেষের দিকে ব্যর্থতার সম্মুখীন হলে এই পুনঃসূচনা ব্যয়বহুল হতে পারে। এই সমস্যা মোকাবেলা করার জন্য, আমরা আমাদের প্রশিক্ষণ স্ক্রিপ্টগুলিকে পূর্বে প্রশিক্ষিত মডেল চেকপয়েন্ট লোড করতে এবং সেই বিন্দু থেকে প্রশিক্ষণ চালিয়ে যাওয়ার জন্য অভিযোজিত করেছি। এই কার্যকারিতা সহ, আমরা ন্যূনতম ওভারহেড সহ ব্যর্থ প্রশিক্ষণের কাজগুলি আক্রমনাত্মকভাবে পুনরায় চালু করতে সক্ষম।

এই স্থিতিস্থাপকতা ব্যবস্থার সাথে, আমরা আমাদের বিদ্যমান GPU পাইপলাইনের সাফল্যের হারের সাথে তুলনীয়, Trn98.5-এ আমাদের কাজের চাপের জন্য 1% সাফল্যের হার অর্জন করতে সক্ষম হয়েছি।

ফলাফল

আমাদের মডেলগুলির যথার্থতা যাচাই করার জন্য, আমরা একই GPU চেকপয়েন্ট থেকে দুটি মডেল শুরু করেছি এবং একটিকে ট্রেনিয়ামে এবং অন্যটিকে তুলনামূলক GPU-তে প্রশিক্ষণ দিয়েছি। উভয় মডেল একই প্রশিক্ষণ হাইপারপ্যারামিটারের সাথে প্রশিক্ষিত হয়েছিল। মেট্রিক্স গণনার জন্য ব্যবহৃত ডেটাসেট হল একটি হোল্ডআউট ডেটাসেট, এবং আমরা প্রতিটি N গ্লোবাল ধাপে এই ডেটাসেটের মডেলের যথার্থতা মূল্যায়ন করি। X-অক্ষ হল বিশ্বব্যাপী ধাপ, এবং Y-অক্ষ হল মডেলের সঠিকতা। আমরা নিম্নলিখিত গ্রাফের প্রতিটি পয়েন্টে মডেল নির্ভুলতার মধ্যে 0.1% এর কম পার্থক্য লক্ষ্য করেছি।

উপরন্তু, মডেল প্রশিক্ষণের খরচ-কার্যকারিতা মূল্যায়ন করার জন্য, আমরা মডেল কনভারজেন্সে পৌঁছাতে নেওয়া দেয়াল ঘড়ির সময় তুলনা করতে পছন্দ করি। আমরা বিশ্বাস করি যে প্রতি টোকেন খরচ, প্রাপ্ত FLOPS/ডলার এবং অন্যান্য কারণগুলির তুলনায় এটি খরচ সাশ্রয়ের আরও বাস্তব দৃষ্টিভঙ্গি প্রদান করে। trn1.32xl এবং তুলনীয় প্রশিক্ষণের সময় বিবেচনা করে অ্যামাজন ইলাস্টিক কম্পিউট ক্লাউড (Amazon EC2) উদাহরণে, আমরা লক্ষ্য করেছি যে ট্রেনিয়াম মডেল কনভারজেন্সের জন্য 30% পর্যন্ত সস্তা খরচ অফার করে।

উপসংহার

আপনার DL কাজের চাপের জন্য বিভিন্ন এক্সিলারেটর মূল্যায়ন করার সময় বিবেচনা করার জন্য অনেকগুলি কারণ রয়েছে। সবচেয়ে গুরুত্বপূর্ণ কিছু হল মডেলের গুণমান, থ্রুপুট, খরচ এবং প্রাপ্যতা। আপনার চয়ন করা অ্যাক্সিলারেটরের উপর ভিত্তি করে আপনার মডেলের গুণমান এবং থ্রুপুট যে বলিদান না হয় তা নিশ্চিত করা সর্বোত্তম।

অন্নপূর্ণা নিউরন টিমের সাথে আমাদের অংশীদারিত্ব এবং সহযোগিতার জন্য ধন্যবাদ, Amazon Search M5 টিম ট্রেনিয়ামে যাওয়ার মাধ্যমে 30% পর্যন্ত খরচ বাঁচাতে সক্ষম হয়েছে। দলটি ট্রেনিয়াম ব্যবহার করতে এবং বাজারে তুলনীয় অ্যাক্সিলারেটরের সাথে মডেলের গুণমান এবং থ্রুপুট সমতা অর্জন করতে সক্ষম। চেকপয়েন্ট ইন্টারঅপারেবিলিটি এবং XLA-এর সমর্থন সহ ন্যূনতম কোড পরিবর্তন M5কে তাদের কাজের চাপের জন্য একাধিক অ্যাক্সিলারেটরের মধ্যে বেছে নেওয়ার অনুমতি দিয়েছে। এটি M5 টিমকে Trainium-এর বৃহৎ কম্পিউট শক্তির সুবিধা নিতে এবং Amazon.com গ্রাহকদের খুশি করার জন্য অ্যাক্সিলারেটর অজ্ঞেয়বাদী সমাধান তৈরি করতে সক্ষম করেছে। একটি অপারেশনাল দৃষ্টিকোণ থেকে, Trainium আমাজন স্কেলে টায়ার-1 পরিষেবাগুলিকে সমর্থন করতে সক্ষম বলে প্রমাণিত হয়েছে। M5 টিম সর্বনিম্ন খরচে Amazon-এর জন্য সেরা মডেলগুলি সরবরাহ করতে ট্রেনিয়ামে আরও বেশি কাজের চাপ নিয়ে চলেছে৷

সংক্ষেপে, M5 টিম এক্সিলারেটরের বহরে Trainium যুক্ত করে সাশ্রয়ী, উৎপাদন-গ্রেড ML প্রশিক্ষণ সম্পাদন করতে সক্ষম হয়েছে। এমএল ওয়ার্কলোডের জন্য উদ্দেশ্য-নির্মিত অ্যামাজন সিলিকনের সুবিধাগুলি কাটাতে আমরা আপনাকে Trainium এবং AWS Inferentia-এর মতো অন্যান্য নিউরন ডিভাইসগুলি দেখতে উৎসাহিত করি। বিভিন্ন মডেল সমন্বিত অনেক টিউটোরিয়ালের একটি দিয়ে সহজে শুরু করুন, যেমন লামা 2, ট্রেনিয়ামে উপলব্ধ.

লেখক সম্পর্কে

অভিনন্দন পাটনি অ্যামাজন অনুসন্ধানের একজন সিনিয়র সফটওয়্যার ইঞ্জিনিয়ার। তিনি স্কেলেবল ডিস্ট্রিবিউটেড ডিপ লার্নিং ট্রেনিং এবং রিয়েল টাইম ইনফারেন্সের জন্য বিল্ডিং সিস্টেম এবং টুলিংয়ের উপর ফোকাস করেন।

অভিনন্দন পাটনি অ্যামাজন অনুসন্ধানের একজন সিনিয়র সফটওয়্যার ইঞ্জিনিয়ার। তিনি স্কেলেবল ডিস্ট্রিবিউটেড ডিপ লার্নিং ট্রেনিং এবং রিয়েল টাইম ইনফারেন্সের জন্য বিল্ডিং সিস্টেম এবং টুলিংয়ের উপর ফোকাস করেন।

জেমস পার্ক অ্যামাজন ওয়েব সার্ভিসের একজন সলিউশন আর্কিটেক্ট। তিনি AWS-এ প্রযুক্তি সমাধান ডিজাইন, নির্মাণ এবং স্থাপন করতে Amazon.com-এর সাথে কাজ করেন এবং AI এবং মেশিন লার্নিং-এ তার বিশেষ আগ্রহ রয়েছে। অবসর সময়ে তিনি নতুন সংস্কৃতি, নতুন অভিজ্ঞতা খুঁজে পেতে এবং সাম্প্রতিক প্রযুক্তির প্রবণতাগুলির সাথে আপ টু ডেট থাকতে উপভোগ করেন৷ আপনি তাকে খুঁজে পেতে পারেন লিঙ্কডইন.

জেমস পার্ক অ্যামাজন ওয়েব সার্ভিসের একজন সলিউশন আর্কিটেক্ট। তিনি AWS-এ প্রযুক্তি সমাধান ডিজাইন, নির্মাণ এবং স্থাপন করতে Amazon.com-এর সাথে কাজ করেন এবং AI এবং মেশিন লার্নিং-এ তার বিশেষ আগ্রহ রয়েছে। অবসর সময়ে তিনি নতুন সংস্কৃতি, নতুন অভিজ্ঞতা খুঁজে পেতে এবং সাম্প্রতিক প্রযুক্তির প্রবণতাগুলির সাথে আপ টু ডেট থাকতে উপভোগ করেন৷ আপনি তাকে খুঁজে পেতে পারেন লিঙ্কডইন.

জেরি মানিল অ্যামাজন সার্চে একজন সফটওয়্যার ইঞ্জিনিয়ার। তিনি বিতরণকৃত প্রশিক্ষণ অবকাঠামোর দক্ষতা, দৃঢ়তা এবং মাপযোগ্যতা উন্নত করার জন্য কাজ করেন।

জেরি মানিল অ্যামাজন সার্চে একজন সফটওয়্যার ইঞ্জিনিয়ার। তিনি বিতরণকৃত প্রশিক্ষণ অবকাঠামোর দক্ষতা, দৃঢ়তা এবং মাপযোগ্যতা উন্নত করার জন্য কাজ করেন।

কেন সু অ্যামাজন সার্চে একজন সফটওয়্যার ইঞ্জিনিয়ার। তিনি প্রশিক্ষণের দক্ষতা এবং মাপযোগ্য বিতরণকৃত প্রশিক্ষণ কর্মপ্রবাহের উন্নতিতে কাজ করেন। কাজের বাইরে, তিনি হাইকিং এবং টেনিস পছন্দ করেন।

কেন সু অ্যামাজন সার্চে একজন সফটওয়্যার ইঞ্জিনিয়ার। তিনি প্রশিক্ষণের দক্ষতা এবং মাপযোগ্য বিতরণকৃত প্রশিক্ষণ কর্মপ্রবাহের উন্নতিতে কাজ করেন। কাজের বাইরে, তিনি হাইকিং এবং টেনিস পছন্দ করেন।

RJ আমাজনের মধ্যে একজন প্রকৌশলী। তিনি প্রশিক্ষণের জন্য বিতরণ করা সিস্টেমগুলির জন্য সিস্টেমগুলি তৈরি এবং অপ্টিমাইজ করেন এবং এমএল ইনফারেন্সের জন্য লেটেন্সি কমাতে দত্তক নেওয়ার সিস্টেমগুলিকে অপ্টিমাইজ করার উপর কাজ করেন। কাজের বাইরে, তিনি খাবারের রেসিপি তৈরির জন্য জেনারেটিভ এআই ব্যবহার করে অন্বেষণ করছেন।

RJ আমাজনের মধ্যে একজন প্রকৌশলী। তিনি প্রশিক্ষণের জন্য বিতরণ করা সিস্টেমগুলির জন্য সিস্টেমগুলি তৈরি এবং অপ্টিমাইজ করেন এবং এমএল ইনফারেন্সের জন্য লেটেন্সি কমাতে দত্তক নেওয়ার সিস্টেমগুলিকে অপ্টিমাইজ করার উপর কাজ করেন। কাজের বাইরে, তিনি খাবারের রেসিপি তৈরির জন্য জেনারেটিভ এআই ব্যবহার করে অন্বেষণ করছেন।

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- PlatoData.Network উল্লম্ব জেনারেটিভ Ai. নিজেকে ক্ষমতায়িত করুন। এখানে প্রবেশ করুন.

- প্লেটোএআইস্ট্রিম। Web3 ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- প্লেটোইএসজি। কার্বন, ক্লিনটেক, শক্তি, পরিবেশ সৌর, বর্জ্য ব্যবস্থাপনা. এখানে প্রবেশ করুন.

- প্লেটো হেলথ। বায়োটেক এবং ক্লিনিক্যাল ট্রায়াল ইন্টেলিজেন্স। এখানে প্রবেশ করুন.

- উত্স: https://aws.amazon.com/blogs/machine-learning/how-amazon-search-m5-saved-30-for-llm-training-cost-by-using-aws-trainium/

- : আছে

- : হয়

- :না

- :কোথায়

- $ ইউপি

- 1

- 100

- 2020

- 7

- 8

- 9

- 98

- a

- সক্ষম

- দ্রুততর করা

- দ্রুততর

- বেগবর্ধক ব্যক্তি

- ত্বক

- গ্রহণযোগ্যতা

- সঠিকতা

- অর্জন করা

- অর্জন

- দিয়ে

- খাপ খাওয়ানো

- যোগ

- যোগ

- যোগ

- অতিরিক্ত

- দত্তক

- উন্নয়নের

- অগ্রগতি

- সুবিধা

- প্রতিকূল

- পর

- চুক্তি

- এগিয়ে

- AI

- সব

- অনুমতি

- অনুমতি

- অনুমতি

- বরাবর

- এছাড়াও

- মর্দানী স্ত্রীলোক

- আমাজন EC2

- অ্যামাজন ওয়েব সার্ভিসেস

- Amazon.com

- পরিমাণ

- an

- এবং

- কোন

- পৃথক্

- আবেদন

- আন্দাজ

- স্থাপত্য

- রয়েছি

- AS

- দৃষ্টিভঙ্গি

- পরিমাপ করা

- সাহায্য

- At

- অটোমেটেড

- স্বয়ংক্রিয়ভাবে

- উপস্থিতি

- সহজলভ্য

- ডেস্কটপ AWS

- এডাব্লুএস ইনফেরেন্টিয়া

- পিছনে

- ভারসাম্য

- ব্যান্ডউইথ

- ভিত্তি

- BE

- কারণ

- হয়েছে

- আগে

- শুরু হয়

- বিশ্বাস করা

- সুবিধা

- সর্বোত্তম

- সেরা অভ্যাস

- মধ্যে

- কোটি কোটি

- বই

- উভয়

- বক্স

- আনয়ন

- নির্মাণ করা

- ভবন

- তৈরী করে

- কিন্তু

- by

- আচ্ছাদন

- হিসাব

- CAN

- না পারেন

- সক্ষম

- কেস

- মামলা

- পরিবর্তন

- পরিবর্তন

- বৈশিষ্ট্য

- সস্তা

- চিপস

- পছন্দ

- বেছে নিন

- মনোনীত

- ঘড়ি

- গুচ্ছ

- কোড

- সহযোগিতা

- সমষ্টিগত

- এর COM

- যোগাযোগ

- তুলনীয়

- তুলনা করা

- তুলনা

- বাধ্যকারী

- প্রণীত

- সম্পূর্ণ

- অনুবর্তী

- গণনা

- গনা

- কনফিগারেশন

- বিবেচনা

- বিবেচনা করা

- প্রতিনিয়ত

- সীমাবদ্ধতার

- গঠন করে

- অবিরত

- চলতে

- নিয়ন্ত্রণগুলি

- অভিসৃতি

- মূল

- মূল্য

- খরচ বাঁচানো

- সাশ্রয়ের

- ব্যয়বহুল

- খরচ

- Counter

- পথ

- নির্মিত

- নির্ণায়ক

- সংকটপূর্ণ

- ক্রেতা

- গ্রাহক অভিজ্ঞতা

- গ্রাহকদের

- চক্র

- উপাত্ত

- তারিখ

- দিন

- DDP

- কয়েক দশক ধরে

- গভীর

- গভীর জ্ঞানার্জন

- ডিফল্ট

- সংজ্ঞায়িত

- আমোদ

- আনন্দদায়ক

- নির্ভর করে

- স্থাপন

- স্থাপন

- নকশা

- সনাক্তকরণ

- উন্নয়নশীল

- উন্নয়ন

- যন্ত্র

- ডিভাইস

- পার্থক্য

- বিভিন্ন

- সরাসরি

- আবিষ্কার

- আলোচনা করা

- বিঘ্ন

- বণ্টিত

- বিতরণ সিস্টেম

- বিতরণ করা প্রশিক্ষণ

- না

- ডাউনটাইম

- কারণে

- সময়

- প্রগতিশীল

- প্রতি

- আগ্রহী

- পূর্বে

- নিকটতম

- সহজে

- প্রভাব

- প্রভাব

- দক্ষতা

- দক্ষতার

- ঘটিয়েছে

- জোর

- সক্ষম করা

- সম্ভব

- উত্সাহিত করা

- শেষ

- প্রয়োগ

- প্রকৌশলী

- যথেষ্ট

- নিশ্চিত করা

- পরিবেশ

- বিশেষত

- মূল্যায়ন

- মূল্যায়নের

- মূল্যায়ন

- এমন কি

- প্রতি

- নব্য

- উদাহরণ

- অতিক্রম করা

- ব্যায়াম

- বিদ্যমান

- অভিজ্ঞতা

- অভিজ্ঞতা

- এক্সপ্লোরিং

- চায়ের

- সত্য

- কারণের

- ব্যর্থ

- ব্যর্থতা

- বৈশিষ্ট্য

- সমন্বিত

- কয়েক

- আবিষ্কার

- প্রথম

- পতাকা

- ফ্লিট

- নমনীয়তা

- গুরুত্ত্ব

- অনুসৃত

- অনুসরণ

- খাদ্য

- জন্য

- সর্বপ্রথম

- ফর্ম

- অগ্রবর্তী

- পাওয়া

- ভিত

- মূল

- প্রতারণা

- জালিয়াতি সনাক্তকরণ

- তাজা

- থেকে

- কার্যকারিতা

- কার্যকরীভাবে

- অধিকতর

- ভবিষ্যৎ

- সাধারণত

- উত্পাদন করা

- প্রজন্ম

- সৃজক

- জেনারেটিভ এআই

- পাওয়া

- প্রদত্ত

- বিশ্বব্যাপী

- জিপিইউ

- জিপিইউ

- চিত্রলেখ

- গ্রাফ

- বৃহত্তর

- অতিশয়

- হার্ডওয়্যারের

- আছে

- জমিদারি

- he

- স্বাস্থ্য

- সাহায্য

- ঊর্ধ্বতন

- তাকে

- অনুভূমিকভাবে

- নিমন্ত্রণকর্তা

- কিভাবে

- এইচটিএমএল

- HTTP

- HTTPS দ্বারা

- শত শত

- শত মিলিয়ন

- আদর্শ

- আদর্শভাবে

- চিহ্নিত

- if

- ভাবমূর্তি

- প্রভাব

- অনুজ্ঞাসূচক

- বাস্তবায়ন

- বাস্তবায়ন

- গুরুত্বপূর্ণ

- গুরুত্বপূর্ণ দৃষ্টিভঙ্গি

- উন্নত

- উন্নত

- উন্নতি

- in

- অন্তর্ভুক্ত করা

- বৃদ্ধি

- ক্রমবর্ধমান

- যথাযোগ্য

- শিল্প

- অনিবার্য

- পরিকাঠামো

- ইনপুট

- নির্দেশাবলী

- পারস্পরিক ক্রিয়ার

- স্বার্থ

- আন্তঃক্রিয়া

- পূজা

- নিরপেক্ষ

- সমস্যা

- IT

- এর

- জে আই টি JIT

- জবস

- যাত্রা

- JPG

- মাত্র

- শুধু একটি

- বড়

- বড় আকারের

- মূলত

- বৃহত্তর

- গত

- গত বছর

- অদৃশ্যতা

- সর্বশেষ

- চালু

- স্তর

- নেতৃত্ব

- জ্ঞানী

- শিক্ষা

- কম

- মাত্রা

- লাইব্রেরি

- মত

- পছন্দ

- লাইন

- লিঙ্কডইন

- LLM

- বোঝা

- লোডার

- বোঝাই

- লোড

- দেখুন

- ক্ষতি

- অধম

- মেশিন

- মেশিন লার্নিং

- মেশিন

- নিয়ন্ত্রণের

- করা

- মেকিং

- অনেক

- বাজার

- মালিক

- অর্থ

- পরিমাপ

- মেকানিজম

- সম্মেলন

- স্মৃতি

- উল্লিখিত

- মিলিত

- ছন্দোবিজ্ঞান

- লক্ষ লক্ষ

- মন

- যত্সামান্য

- ছোট

- মিস

- ML

- মোড

- মডেল

- মডেল

- অধিক

- সেতু

- পদক্ষেপ

- প্যাচসমূহ

- চলন্ত

- বহু

- অবশ্যই

- নাম

- প্রকৃতি

- প্রয়োজন

- চাহিদা

- নেটওয়ার্ক

- নেটওয়ার্কিং

- নেটওয়ার্ক

- নার্ভীয়

- স্নায়বিক নেটওয়ার্ক

- নিউরাল নেটওয়ার্ক

- নতুন

- পরবর্তী

- না।

- বিঃদ্রঃ

- সংখ্যা

- অনেক

- of

- অফার

- অফলাইন

- on

- ONE

- কেবল

- কর্মক্ষম

- অপারেশনস

- অপ্টিমাইজেশান

- অপ্টিমিজ

- অপ্টিমাইজ

- সেরা অনুকূল রূপ

- সর্বোচ্চকরন

- পছন্দ

- অপশন সমূহ

- or

- ক্রম

- সংগঠন

- অন্যান্য

- আমাদের

- বাইরে

- বাহিরে

- শেষ

- মালিক

- সমান্তরাল

- পরামিতি

- প্রধানতম

- সমতা

- অংশ

- বিশেষ

- অংশীদারিত্ব

- পাস

- পথ

- প্রতি

- সম্পাদন করা

- কর্মক্ষমতা

- সম্পাদিত

- সঞ্চালিত

- কাল

- প্রবর্তিত

- পাইপলাইন

- জায়গা

- স্থাননির্ণয়

- জায়গা

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- বিন্দু

- পোস্ট

- সম্ভাব্য

- ক্ষমতা

- চালিত

- ব্যবহারিক

- চর্চা

- পছন্দ করা

- আগে

- পূর্বে

- সমস্যা

- এগিয়ে

- উত্পাদনের

- কার্যক্রম

- প্রমাণিত

- প্রদান

- প্রদত্ত

- উপলব্ধ

- অন্বেষণ করা

- পাইটার্চ

- গুণ

- দ্রুত

- হার

- নাগাল

- বাস্তব

- প্রকৃত সময়

- কাটা

- সুপারিশ করা

- সুপারিশ

- হ্রাস করা

- হ্রাস

- হ্রাস

- নিয়মিতভাবে

- মুক্তি

- প্রয়োজন

- প্রয়োজনীয়

- প্রয়োজন

- সমাধান

- যথাক্রমে

- বিশ্রাম

- বলিষ্ঠতা

- চালান

- দৌড়

- রান

- রানটাইম

- একই

- সংরক্ষণ করুন

- সংরক্ষিত

- রক্ষা

- জমা

- মাপযোগ্য

- স্কেল

- আরোহী

- লিপি

- স্ক্রিপ্ট

- SDK

- নির্বিঘ্ন

- নির্বিঘ্নে

- সার্চ

- বিভাগে

- সচেষ্ট

- জ্যেষ্ঠ

- সেবা

- সেবা

- ভজনা

- বিন্যাস

- আকার

- শেয়ার

- উচিত

- গুরুত্বপূর্ণ

- সিলিকোন

- অনুরূপ

- সহজ

- আয়তন

- ছোট

- So

- সফটওয়্যার

- সফটওয়্যার ইঞ্জিনিয়ার

- সলিউশন

- কিছু

- উৎস

- স্থিতিশীল

- মান

- দৃষ্টিকোণ

- শুরু

- শুরু হচ্ছে

- রাষ্ট্র-এর-শিল্প

- স্থির

- স্থিত

- ধাপ

- প্রারম্ভিক ব্যবহারের নির্দেশাবলী

- স্টোরেজ

- সঞ্চিত

- অকপট

- কৌশল

- যথাযথ

- সাফল্য

- সফলভাবে

- এমন

- সংক্ষিপ্ত করা

- সংক্ষিপ্তসার

- সমর্থন

- সমর্থক

- সিস্টেম

- গ্রহণ করা

- ধরা

- টীম

- দল

- কারিগরী

- প্রযুক্তি

- প্রযুক্তিঃ

- পরীক্ষা

- পরীক্ষা

- পাঠ

- চেয়ে

- যে

- সার্জারির

- ভবিষ্যৎ

- তাদের

- তাহাদিগকে

- তারপর

- সেখানে।

- অতএব

- এইগুলো

- তারা

- এই

- তিন

- দ্বারা

- থ্রুপুট

- সময়

- বার

- থেকে

- টোকেন

- টোকেন

- অত্যধিক

- মশাল

- প্রতি

- চিহ্ন

- রচনা

- রেলগাড়ি

- প্রশিক্ষিত

- প্রশিক্ষণ

- ট্রেন

- ট্রান্সফরমার

- রূপান্তর

- রূপান্তর

- প্রবণতা

- পরীক্ষা

- টিউটোরিয়াল

- দুই

- সাধারণত

- নিম্নাবস্থিত

- সার্বজনীন

- আনলক করে

- us

- ব্যবহার

- ব্যবহার ক্ষেত্রে

- ব্যবহৃত

- ব্যবহারকারী

- ব্যবহারসমূহ

- ব্যবহার

- ইউটিলিটি

- উপযোগ

- যাচাই করুন

- বৈধতা

- বৈচিত্র্য

- বিভিন্ন

- যাচাই

- ভিডিও

- চেক

- প্রাচীর

- ছিল

- উপায়..

- উপায়

- we

- ওয়েব

- ওয়েব সার্ভিস

- সপ্তাহান্তিক কাল

- আমরা একটি

- ছিল

- কখন

- যেহেতু

- যে

- যখন

- ইচ্ছা

- সঙ্গে

- মধ্যে

- ছাড়া

- হয়া যাই ?

- কর্মপ্রবাহ

- কাজ

- কাজ

- XM

- বছর

- আপনি

- আপনার

- zephyrnet