মেশিন লার্নিং (এমএল) মডেলের আকার––বড় ভাষা মডেল (এলএলএম) এবং ভিত্তি মডেল (এফএম)––বছরের পর বছর দ্রুত বাড়ছে, এবং এই মডেলগুলির জন্য দ্রুত এবং আরও শক্তিশালী এক্সিলারেটর প্রয়োজন, বিশেষ করে জেনারেটিভ AI এর জন্য। AWS Inferentia2 এলএলএম এবং জেনারেটিভ এআই ইনফারেন্সের খরচ কমিয়ে উচ্চ কার্যক্ষমতা প্রদানের জন্য গ্রাউন্ড আপ থেকে ডিজাইন করা হয়েছে।

এই পোস্টে, আমরা দেখাই যে কিভাবে AWS Inferentia-এর দ্বিতীয় প্রজন্ম AWS Inferentia1 এর সাথে প্রবর্তিত ক্ষমতার উপর ভিত্তি করে তৈরি করে এবং LLM এবং FM গুলি স্থাপন ও চালানোর অনন্য চাহিদা পূরণ করে।

AWS Inferentia-এর প্রথম প্রজন্ম, একটি উদ্দেশ্য-নির্মিত অ্যাক্সিলারেটর যা 2019 সালে চালু করা হয়েছে, গভীর শিক্ষার অনুমানকে ত্বরান্বিত করার জন্য অপ্টিমাইজ করা হয়েছে। AWS Inferentia ML ব্যবহারকারীদের তাদের অনুমান খরচ কমাতে এবং তাদের পূর্বাভাস থ্রুপুট এবং লেটেন্সি উন্নত করতে সাহায্য করেছে। AWS Inferentia1 এর সাথে, গ্রাহকরা তুলনামূলক অনুমান-অপ্টিমাইজডের তুলনায় 2.3x বেশি থ্রুপুট এবং প্রতি অনুমান প্রতি 70% পর্যন্ত কম খরচ দেখেছেন অ্যামাজন ইলাস্টিক কম্পিউট ক্লাউড (Amazon EC2) উদাহরণ।

AWS Inferentia2, নতুনটিতে বৈশিষ্ট্যযুক্ত Amazon EC2 Inf2 দৃষ্টান্ত এবং সমর্থিত আমাজন সেজমেকার, বড় আকারের জেনারেটিভ AI অনুমানের জন্য অপ্টিমাইজ করা হয়েছে এবং এটি AWS থেকে প্রথম অনুমান ফোকাসড উদাহরণ যা ডিস্ট্রিবিউটেড ইনফারেন্সের জন্য অপ্টিমাইজ করা হয়েছে, উচ্চ-গতি, ত্বরণকারীর মধ্যে কম লেটেন্সি সংযোগ সহ।

আপনি এখন ব্যয়বহুল প্রশিক্ষণের দৃষ্টান্তের প্রয়োজন ছাড়াই একটি একক Inf175 দৃষ্টান্তে একাধিক অ্যাক্সিলারেটর জুড়ে অনুমানের জন্য একটি 2-বিলিয়ন-প্যারামিটার মডেল দক্ষতার সাথে স্থাপন করতে পারেন। এখন অবধি, যাদের কাছে বড় মডেল ছিল তারা শুধুমাত্র প্রশিক্ষণের জন্য তৈরি করা উদাহরণগুলি ব্যবহার করতে পারে, কিন্তু এটি সম্পদের অপচয়––প্রদত্ত যে তারা আরও ব্যয়বহুল, আরও শক্তি খরচ করে এবং তাদের কাজের চাপ সমস্ত কিছু ব্যবহার করে না উপলব্ধ সংস্থান (যেমন দ্রুত নেটওয়ার্কিং এবং স্টোরেজ)। AWS Inferentia2 এর সাথে, আপনি AWS Inferentia4 এর তুলনায় 10 গুণ বেশি থ্রুপুট এবং 1 গুণ কম লেটেন্সি অর্জন করতে পারেন। এছাড়াও, AWS Inferentia-এর দ্বিতীয় প্রজন্ম আরও ডেটা প্রকার, কাস্টম অপারেটর, গতিশীল টেনসর এবং আরও অনেক কিছুর জন্য উন্নত সমর্থন যোগ করে।

AWS Inferentia2-এর 4 গুণ বেশি মেমরি ক্ষমতা, AWS Inferentia16.4-এর চেয়ে 1 গুণ বেশি মেমরি ব্যান্ডউইথ এবং একাধিক অ্যাক্সিলারেটর জুড়ে বড় মডেলগুলিকে শার্ড করার জন্য স্থানীয় সমর্থন রয়েছে। এক্সিলারেটর ব্যবহার করে নিউরন লিঙ্ক এবং নিউরন কালেকটিভ কমিউনিকেশন তাদের মধ্যে বা একটি অ্যাক্সিলারেটর এবং নেটওয়ার্ক অ্যাডাপ্টারের মধ্যে ডেটা স্থানান্তরের গতি সর্বাধিক করতে। AWS Inferentia2 বড় মডেলগুলির জন্য আরও উপযুক্ত, যার জন্য একাধিক অ্যাক্সিলারেটর জুড়ে শার্ডিং প্রয়োজন, যদিও AWS Inferentia1 এখনও ছোট মডেলগুলির জন্য একটি দুর্দান্ত বিকল্প কারণ এটি বিকল্পগুলির তুলনায় ভাল মূল্য-কর্মক্ষমতা প্রদান করে।

স্থাপত্যের বিবর্তন

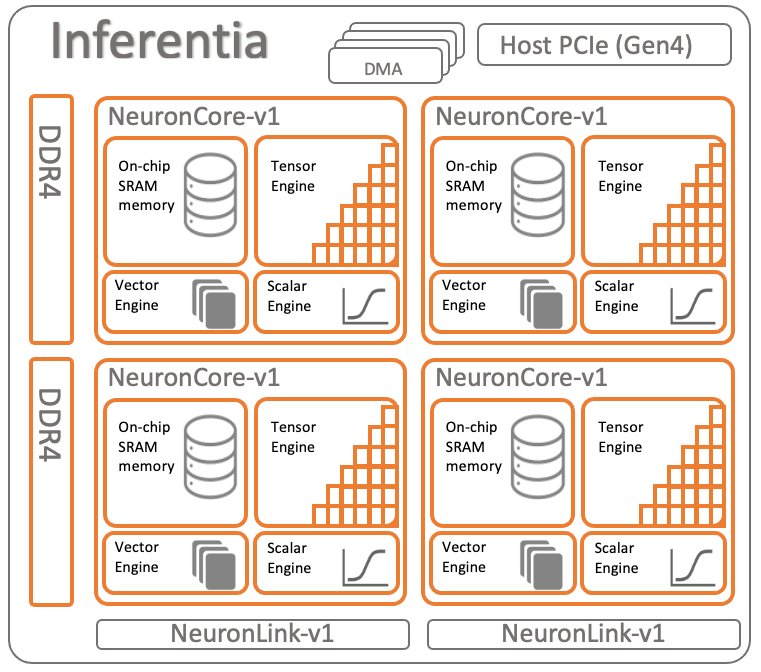

AWS Inferentia এর উভয় প্রজন্মের তুলনা করতে, আসুন পর্যালোচনা করি AWS Inferentia1 এর আর্কিটেকচার. এটির প্রতি চিপে চারটি নিউরনকোরস v1 রয়েছে, যা নিম্নলিখিত চিত্রটিতে দেখানো হয়েছে।

চিপ প্রতি স্পেসিফিকেশন:

- গনা - মোট 128 INT8 TOPS এবং 64FP16/BF16 TFLOPS-এ চারটি কোর বিতরণ করছে

- স্মৃতি - 8 GB DRAM (50 GB/সেকেন্ড ব্যান্ডউইথ), চারটি কোর দ্বারা ভাগ করা

- নিউরন লিঙ্ক - দুই বা ততোধিক কোর জুড়ে মডেল শার্ডিংয়ের জন্য কোরের মধ্যে লিঙ্ক

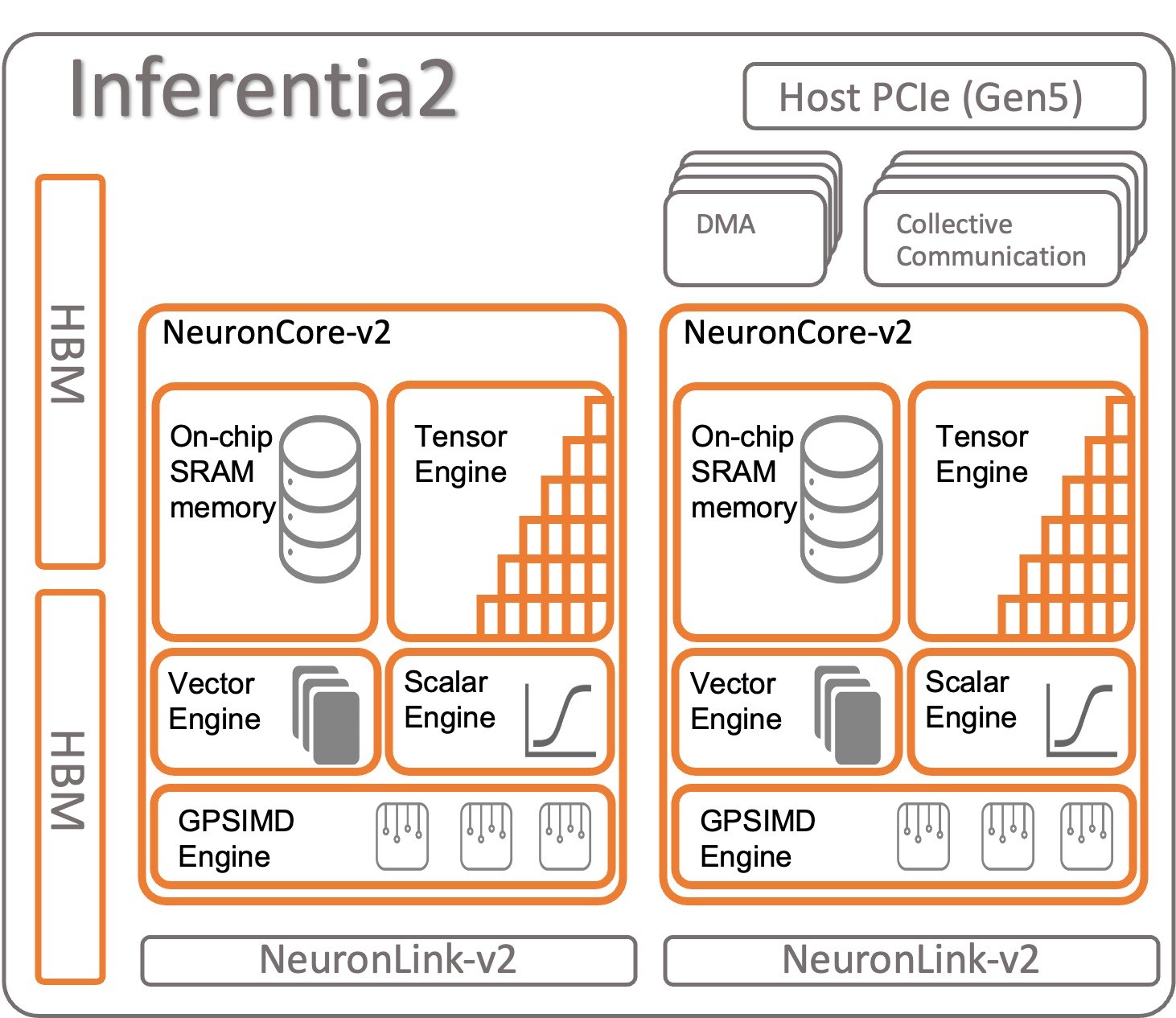

আসুন AWS Inferentia2 কিভাবে সংগঠিত হয় তা দেখি। প্রতিটি AWS Inferentia2 চিপের উপর ভিত্তি করে দুটি আপগ্রেড করা কোর রয়েছে NeuronCore-v2 আর্কিটেকচার। AWS Inferentia1-এর মতো, আপনি প্রতিটি নিউরনকোরে বিভিন্ন মডেল চালাতে পারেন বা শার্ড বড় মডেলগুলিতে একাধিক কোর একত্রিত করতে পারেন।

চিপ প্রতি স্পেসিফিকেশন:

- গনা - দুটি কোর মোট 380 INT8 TOPS, 190 FP16/BF16/cFP8/TF32 TFLOPS, এবং 47.5 FP32 TFLOPS বিতরণ করছে

- স্মৃতি - 32 GB HBM, উভয় কোর দ্বারা ভাগ করা হয়েছে৷

- নিউরন লিঙ্ক - দুই বা ততোধিক কোর জুড়ে মডেল শার্ডিংয়ের জন্য চিপগুলির মধ্যে লিঙ্ক (প্রতি ডিভাইসে 384 জিবি/সেকেন্ড)

NeuronCore-v2 আছে a চারটি স্বাধীন ইঞ্জিন সহ মডুলার ডিজাইন:

- ScalarEngine (v3 এর চেয়ে 1 গুণ দ্রুত) – ফ্লোটিং পয়েন্ট সংখ্যা––১৬০০ (BF1600/FP16) FLOPS-এ কাজ করে

- ভেক্টর ইঞ্জিন (v10 এর চেয়ে 1 গুণ দ্রুত) - নর্মালাইজেশন, পুলিং এবং অন্যদের মতো গণনার জন্য একক অপারেশন সহ সংখ্যার ভেক্টরগুলিতে কাজ করে।

- TensorEngine (v6 এর চেয়ে 1 গুণ দ্রুত) - কনভ, রিশেপ, ট্রান্সপোজ এবং অন্যান্যের মতো টেনসর গণনা সম্পাদন করে।

- GPSIMD-ইঞ্জিন - আপনার তৈরি করার জন্য আটটি সম্পূর্ণ প্রোগ্রামেবল 512-বিট প্রশস্ত সাধারণ-উদ্দেশ্য প্রসেসর রয়েছে কাস্টম অপারেটর সঙ্গে স্ট্যান্ডার্ড PyTorch কাস্টম C++ অপারেটর API. এটি একটি নতুন বৈশিষ্ট্য, যা NeuronCore-v2 এ চালু করা হয়েছে।

AWS Inferentia2 NeuronCore-v2 দ্রুত এবং আরও অপ্টিমাইজ করা হয়েছে। এছাড়াও, এটি রেসনেট 50 এর মতো সাধারণ মডেল থেকে শুরু করে বৃহৎ ভাষার মডেল বা GPT-3 (175 বিলিয়ন প্যারামিটার) এর মতো বিলিয়ন প্যারামিটার সহ ফাউন্ডেশন মডেল পর্যন্ত বিভিন্ন ধরণের এবং আকারের মডেলগুলিকে ত্বরান্বিত করতে সক্ষম। AWS Inferentia2 এর একটি বড় এবং দ্রুত অভ্যন্তরীণ মেমরি রয়েছে, যখন AWS Inferentia1 এর সাথে তুলনা করা হয়েছে, যেমনটি নিম্নলিখিত টেবিলে দেখানো হয়েছে।

| চিপ | নিউরন কোর | মেমরি প্রকার | মেমরি সাইজ | স্মৃতি ব্যান্ডউইথ |

| এডাব্লুএস ইনফেরেন্টিয়া | x4 (v1) | DDR4 | 8GB | 50GB/S |

| AWS Inferentia 2 | x2 (v2) | HBM | 32GB | 820GB/S |

আপনি AWS Inferentia2-এ যে মেমরিটি খুঁজে পান তা হল হাই-ব্যান্ডউইথ মেমরি (HBM) টাইপ। প্রতিটি AWS Inferentia2 চিপে 32 GB থাকে এবং নিউরনলিঙ্ক (ডিভাইস-টু-ডিভাইস ইন্টারকানেক্ট) ব্যবহার করে খুব বড় মডেলগুলি বিতরণ করতে অন্যান্য চিপের সাথে একত্রিত করা যেতে পারে। উদাহরণস্বরূপ, একটি inf2.48xlarge-এ 12 AWS Inferentia2 এক্সিলারেটর রয়েছে যার মোট 384 GB অ্যাক্সিলারেটেড মেমরি রয়েছে। AWS Inferentia2 মেমরির গতি AWS Inferentia16.4 এর চেয়ে 1 গুণ বেশি, যেমনটি আগের টেবিলে দেখানো হয়েছে।

অন্যান্য বৈশিষ্ট্য

AWS Inferentia2 নিম্নলিখিত অতিরিক্ত বৈশিষ্ট্যগুলি অফার করে:

- হার্ডওয়্যার সমর্থিত – cFP8 (নতুন, কনফিগারযোগ্য FP8), FP16, BF16, TF32, FP32, INT8, INT16 এবং INT32। আরো তথ্যের জন্য, পড়ুন তথ্যের ধরণ.

- অলস টেনসর অনুমান - আমরা আলোচনা করি অলস টেনসর অনুমান পরে এই পোস্টে।

- কাস্টম অপারেটর - বিকাশকারীরা ব্যবহার করতে স্ট্যান্ডার্ড PyTorch কাস্টম অপারেটর প্রোগ্রামিং ইন্টারফেস ব্যবহার করতে পারেন কাস্টম সি++ অপারেটর বৈশিষ্ট্য একটি কাস্টম অপারেটর নিম্ন-স্তরের আদিম দ্বারা গঠিত টেনসর কারখানার কার্যাবলী এবং GPSIMD-ইঞ্জিন দ্বারা ত্বরান্বিত।

- নিয়ন্ত্রণ-প্রবাহ (শীঘ্রই আসছে) - এটি মডেলের ভিতরে নেটিভ প্রোগ্রামিং ল্যাঙ্গুয়েজ কন্ট্রোল প্রবাহের জন্য শেষ পর্যন্ত প্রিপ্রসেস এবং পোস্টপ্রসেস ডেটা এক স্তর থেকে অন্য স্তরে।

- গতিশীল-আকৃতি (শীঘ্রই আসছে) - যখন আপনার মডেল গতিশীলভাবে যেকোনো অভ্যন্তরীণ স্তরের আউটপুটের আকার পরিবর্তন করে তখন এটি কার্যকর। উদাহরণস্বরূপ: একটি ফিল্টার যা ইনপুট ডেটার উপর ভিত্তি করে মডেলের ভিতরে আউটপুট টেনসরের আকার বা আকৃতি হ্রাস করে।

AWS Inferentia1 এবং AWS Inferentia2-এ ত্বরান্বিত মডেল

সার্জারির AWS নিউরন SDK আপনার মডেল কম্পাইল এবং চালানোর জন্য ব্যবহৃত হয়। এটি স্থানীয়ভাবে PyTorch এবং TensorFlow এর সাথে একত্রিত। এইভাবে, আপনাকে একটি অতিরিক্ত টুল চালানোর প্রয়োজন নেই। এই ML ফ্রেমওয়ার্কগুলির মধ্যে একটিতে লেখা আপনার আসল কোডটি ব্যবহার করুন এবং কোড পরিবর্তনের কয়েকটি লাইন সহ, আপনি AWS Inferentia এর সাথে যেতে পারেন।

আসুন দেখি কিভাবে PyTorch ব্যবহার করে AWS Inferentia1 এবং AWS Inferentia2 এ একটি মডেল কম্পাইল এবং রান করা যায়।

টর্চভিশন থেকে একটি প্রাক-প্রশিক্ষিত মডেল (ResNet 50) লোড করুন

একটি প্রাক-প্রশিক্ষিত মডেল লোড করুন এবং এটিকে উষ্ণ করার জন্য একবার চালান:

Inferentia1 এ ত্বরিত মডেলটি ট্রেস করুন এবং স্থাপন করুন

মডেলটিকে AWS Inferentia-এ ট্রেস করতে, আমদানি করুন torch_neuron এবং ট্রেসিং ফাংশন আহ্বান করুন। মনে রাখবেন যে মডেলটি কাজ করার জন্য PyTorch Jit হতে হবে।

ট্রেসিং প্রক্রিয়া শেষে, মডেলটিকে একটি সাধারণ PyTorch মডেল হিসাবে সংরক্ষণ করুন। মডেলটি একবার কম্পাইল করুন এবং যতবার প্রয়োজন ততবার লোড করুন। নিউরন SDK রানটাইম ইতিমধ্যেই PyTorch-এ একত্রিত হয়েছে এবং আপনার মডেলকে ত্বরান্বিত করতে স্বয়ংক্রিয়ভাবে AWS Inferentia1 চিপে অপারেটরদের পাঠানোর জন্য দায়ী৷

আপনার অনুমান কোডে, আপনাকে সর্বদা আমদানি করতে হবে torch_neuron ইন্টিগ্রেটেড রানটাইম সক্রিয় করতে।

আপনি পাস করতে পারেন অতিরিক্ত পরামিতি কম্পাইলারকে মডেলটিকে অপ্টিমাইজ করার উপায় কাস্টমাইজ করতে বা নিউরন-পাইপলাইন-কোরগুলির মতো বিশেষ বৈশিষ্ট্যগুলি সক্ষম করতে। থ্রুপুট বাড়ানোর জন্য আপনার মডেলকে একাধিক কোর জুড়ে ভাগ করুন।

Inferentia2 এ ত্বরিত মডেলের ট্রেসিং এবং স্থাপন করা

AWS Inferentia2 এর জন্য, প্রক্রিয়াটি একই রকম। শুধুমাত্র পার্থক্য হল আপনি যে প্যাকেজটি আমদানি করেন তা x দিয়ে শেষ হয়: torch_neuronx. নিউরন SDK আপনার জন্য স্বচ্ছভাবে মডেলের সংকলন এবং চালানোর যত্ন নেয়। আপনিও পাস করতে পারেন কম্পাইলারের অতিরিক্ত পরামিতি অপারেশন সূক্ষ্ম-টিউন বা নির্দিষ্ট কার্যকারিতা সক্রিয় করতে.

AWS Inferentia2 নামক একটি মডেল চালানোর জন্য একটি দ্বিতীয় পদ্ধতির প্রস্তাব দেয় অলস টেনসর অনুমান. এই মোডে, আপনি আগে মডেলটিকে ট্রেস বা কম্পাইল করবেন না; পরিবর্তে, আপনি যখনই আপনার কোড চালান তখন কম্পাইলারটি ফ্লাইতে চলে। এটি উৎপাদনের জন্য সুপারিশ করা হয় না, যে ট্রেসড মোড আছে অনেক সুবিধা অলস টেনসর অনুমানের উপর। যাইহোক, আপনি যদি এখনও আপনার মডেলটি বিকাশ করেন এবং এটি দ্রুত পরীক্ষা করার প্রয়োজন হয়, তাহলে অলস টেনসর অনুমান একটি ভাল বিকল্প হতে পারে। অলস টেনসর ব্যবহার করে কীভাবে একটি মডেল কম্পাইল এবং চালানো যায় তা এখানে:

এখন যেহেতু আপনি AWS Inferentia2 এর সাথে পরিচিত, একটি ভাল পরবর্তী পদক্ষেপ হল শুরু করা পাইটর্চ or টেনসরফ্লো এবং কিভাবে একটি dev পরিবেশ সেট আপ করতে হয় এবং টিউটোরিয়াল এবং উদাহরণগুলি চালাতে হয় তা শিখুন। এছাড়াও, চেক করুন AWS নিউরন নমুনা GitHub রেপো, যেখানে আপনি Inf2, Inf1, এবং Trn1 চালানোর জন্য মডেলগুলি কীভাবে প্রস্তুত করবেন তার একাধিক উদাহরণ খুঁজে পেতে পারেন।

AWS Inferentia1 এবং AWS Inferentia2 এর মধ্যে বৈশিষ্ট্য তুলনার সারাংশ

AWS Inferentia2 কম্পাইলার হল XLA-ভিত্তিক, এবং AWS এর অংশ OpenXLA উদ্যোগ। এটি AWS Inferentia1 এর থেকে সবচেয়ে বড় পার্থক্য, এবং এটি প্রাসঙ্গিক কারণ PyTorch, TensorFlow এবং JAX-এর নেটিভ XLA ইন্টিগ্রেশন রয়েছে। XLA অনেক কর্মক্ষমতা উন্নতি নিয়ে আসে, এটি একটি একক কার্নেল লঞ্চের ফলাফল গণনা করার জন্য গ্রাফটিকে অপ্টিমাইজ করে। এটি পরপর টেনসর ক্রিয়াকলাপকে একত্রে ফিউজ করে এবং AWS Inferentia2-এ ত্বরান্বিত মডেল চালানোর জন্য সর্বোত্তম মেশিন কোড আউটপুট করে। নিউরন SDK-এর অন্যান্য অংশগুলিও AWS Inferentia2-তে উন্নত করা হয়েছিল, মডেলগুলি ট্রেসিং এবং চালানোর সময় ব্যবহারকারীর অভিজ্ঞতাকে যতটা সম্ভব সহজ রেখে৷ নিম্নলিখিত টেবিলটি কম্পাইলার এবং রানটাইম উভয় সংস্করণে উপলব্ধ বৈশিষ্ট্যগুলি দেখায়।

| বৈশিষ্ট্য | টর্চ-নিউরন | টর্চ-নিউরনক্স |

| টেনসরবোর্ড | হাঁ | হাঁ |

| সমর্থিত উদাহরণ | Inf1 | Inf2 এবং Trn1 |

| অনুমান সমর্থন | হাঁ | হাঁ |

| প্রশিক্ষণ সহায়তা | না | হাঁ |

| স্থাপত্য | নিউরনকোর-v1 | নিউরনকোর-v2 |

| ট্রেস API | torch_neuron.trace() | torch_neuronx.trace() |

| বিতরণকৃত অনুমান | নিউরনকোর পাইপলাইন | যৌথ যোগাযোগ |

| IR | গ্রাফডিফ | এইচএলও |

| সংকলনকারী | নিউরন-সিসি | neuronx-cc |

| পর্যবেক্ষণ | নিউরন-মনিটর / মনিটর-টপ | নিউরন-মনিটর / মনিটর-টপ |

মধ্যে আরো বিস্তারিত তুলনা জন্য torch-neuron (Inf1) এবং torch-neuronx (Inf2), পড়ুন অনুমানের জন্য টর্চ-নিউরন (Inf1) বনাম টর্চ-নিউরনক্স (Inf2 এবং Trn1) এর তুলনা.

মডেল পরিবেশন

Inf2 এ স্থাপন করার জন্য একটি মডেল ট্রেস করার পরে, আপনার কাছে অনেকগুলি স্থাপনার বিকল্প রয়েছে। আপনি বিভিন্ন উপায়ে রিয়েল-টাইম ভবিষ্যদ্বাণী বা ব্যাচ পূর্বাভাস চালাতে পারেন। Inf2 উপলব্ধ কারণ EC2 দৃষ্টান্তগুলি স্থানীয়ভাবে অন্যান্য AWS পরিষেবাগুলির সাথে একত্রিত হয় যা ব্যবহার করে গভীর শিক্ষার পাত্রে (DLCs) যেমন অ্যামাজন ইলাস্টিক কনটেইনার পরিষেবা (আমাজন ইসিএস), অ্যামাজন ইলাস্টিক কুবারনেটস পরিষেবা (আমাজন ইকেএস), এবং সেজমেকার।

AWS Inferentia2 সবচেয়ে জনপ্রিয় স্থাপনার প্রযুক্তির সাথে সামঞ্জস্যপূর্ণ। AWS Inferentia2 ব্যবহার করে মডেল স্থাপনের জন্য আপনার কাছে থাকা কয়েকটি বিকল্পের একটি তালিকা এখানে রয়েছে:

- SageMaker - ডেটা প্রস্তুত করতে এবং এমএল মডেল তৈরি, প্রশিক্ষণ এবং স্থাপন করতে সম্পূর্ণরূপে পরিচালিত পরিষেবা৷

- টর্চ সার্ভ - পাইটর্চ ইন্টিগ্রেটেড ডিপ্লয়মেন্ট মেকানিজম

- টেনসরফ্লো পরিবেশন করা - টেনসরফ্লো ইন্টিগ্রেটেড ডিপ্লয়মেন্ট মেকানিজম

- গভীর জাভা লাইব্রেরি - মডেল স্থাপন এবং প্রশিক্ষণের জন্য ওপেন সোর্স জাভা মেকানিজম

- Triton, - মডেল স্থাপনের জন্য NVIDIA ওপেন সোর্স পরিষেবা

উচ্চতার চিহ্ন

নিম্নলিখিত সারণী AWS Inferentia2 AWS Inferentia1 এর উপর যে উন্নতিগুলি এনেছে তা হাইলাইট করে। বিশেষ করে, আমরা লেটেন্সি পরিমাপ করি (প্রতিটি অ্যাক্সিলারেটর ব্যবহার করে মডেলটি কত দ্রুত একটি ভবিষ্যদ্বাণী করতে পারে), থ্রুপুট (প্রতি সেকেন্ডে কতগুলি অনুমান), এবং প্রতি অনুমানের খরচ (মার্কিন ডলারে প্রতিটি অনুমানের মূল্য কত)। মিলিসেকেন্ডে লেটেন্সি যত কম হবে এবং ইউএস ডলারে খরচ হবে তত ভালো। থ্রুপুট যত বেশি হবে তত ভালো।

এই প্রক্রিয়ায় দুটি মডেল ব্যবহার করা হয়েছিল—–উভয় বৃহৎ ভাষার মডেল: ELECTRA বড় বৈষম্যকারী এবং BERT বড় আনকেসড। PyTorch (1.13.1) এবং Hugging Face transformers (v4.7.0), এই পরীক্ষায় ব্যবহৃত প্রধান লাইব্রেরিগুলি পাইথন 3.8-এ চলে। ব্যাচের আকার = 1 এবং 10 (একটি রেফারেন্স হিসাবে পূর্ববর্তী বিভাগ থেকে কোড ব্যবহার করে) এর জন্য মডেলগুলি কম্পাইল করার পরে, প্রতিটি মডেলকে উষ্ণ করা হয়েছিল (প্রসঙ্গ শুরু করার জন্য একবার আহ্বান করা হয়েছিল) এবং তারপরে একটি সারিতে 10 বার আহ্বান করা হয়েছিল। নিম্নলিখিত সারণী এই সাধারণ বেঞ্চমার্কে সংগৃহীত গড় সংখ্যা দেখায়।

| ণশড | ব্যাচ আকার | বাক্যের দৈর্ঘ্য | Latency (ms) | Inf2 থেকে Inf1 উন্নতি (x টাইমস) | থ্রুপুট (প্রতি সেকেন্ডে অনুমান) | অনুমান প্রতি খরচ (EC2 us-east-1) ** | |||

| Inf1 | Inf2 | Inf1 | Inf2 | Inf1 | Inf2 | ||||

| ইলেক্ট্রালার্জ ডিসক্রিমিনেটর | 1 | 256 | 35.7 | 8.31 | 4.30 | 28.01 | 120.34 | $0.0000023 | $0.0000018 |

| ইলেক্ট্রালার্জ ডিসক্রিমিনেটর | 10 | 256 | 343.7 | 72.9 | 4.71 | 2.91 | 13.72 | $0.0000022 | $0.0000015 |

| বার্টলার্জ আনকেসড | 1 | 128 | 28.2 | 3.1 | 9.10 | 35.46 | 322.58 | $0.0000018 | $0.0000007 |

| বার্টলার্জ আনকেসড | 10 | 128 | 121.1 | 23.6 | 5.13 | 8.26 | 42.37 | $0.0000008 | $0.0000005 |

* c6a.8x বড় এই বেঞ্চমার্কে 32 AMD Epyc 7313 CPU ব্যবহার করা হয়েছিল।

**EC2 পাবলিক প্রাইসিং us-east-1-এ 20 এপ্রিল: inf2.xlarge: $0.7582/hr; inf1.xlarge: $0.228/ঘন্টা। অনুমানের প্রতি খরচ একটি ব্যাচের উপাদান প্রতি খরচ বিবেচনা করে। (প্রতি অনুমানে খরচ মডেল আহ্বান/ব্যাচ আকারের মোট খরচের সমান।)

প্রশিক্ষণ এবং অনুমান কর্মক্ষমতা সম্পর্কে অতিরিক্ত তথ্যের জন্য, পড়ুন Trn1/Trn1n পারফরম্যান্স.

উপসংহার

AWS Inferentia2 হল একটি শক্তিশালী প্রযুক্তি যা কর্মক্ষমতা উন্নত করতে এবং গভীর শিক্ষার মডেল অনুমানের খরচ কমানোর জন্য ডিজাইন করা হয়েছে। AWS Inferentia1 এর চেয়ে বেশি পারফরম্যান্স, এটি 4 গুণ বেশি থ্রুপুট পর্যন্ত, 10 গুণ কম লেটেন্সি পর্যন্ত, এবং অন্যান্য তুলনাযোগ্য অনুমান-অপ্টিমাইজ করা EC50 দৃষ্টান্তগুলির তুলনায় 2% ভাল পারফরম্যান্স/ওয়াট পর্যন্ত অফার করে। শেষ পর্যন্ত, আপনি কম অর্থ প্রদান করেন, একটি দ্রুত আবেদন করেন এবং আপনার স্থায়িত্বের লক্ষ্যগুলি পূরণ করেন।

আপনার অনুমান কোডকে AWS Inferentia2-এ স্থানান্তর করা সহজ এবং সহজ, যা জেনারেটিভ এআই-এর জন্য বৃহৎ ভাষার মডেল এবং ফাউন্ডেশন মডেল সহ বিস্তৃত বিভিন্ন মডেলকে সমর্থন করে।

আপনি অনুসরণ করে শুরু করতে পারেন AWS নিউরন SDK ডকুমেন্টেশন একটি উন্নয়ন পরিবেশ সেট আপ করতে এবং আপনার ত্বরিত গভীর শিক্ষা প্রকল্প শুরু করতে। আপনাকে শুরু করতে সাহায্য করার জন্য, Hugging Face তাদের নিউরন সমর্থন যোগ করেছে সর্বোত্তম লাইব্রেরি, যা দ্রুত প্রশিক্ষণ এবং অনুমানের জন্য মডেলগুলিকে অপ্টিমাইজ করে, এবং তাদের কাছে Inf2-এ চালানোর জন্য প্রস্তুত অনেক উদাহরণ কাজ রয়েছে। এছাড়াও, আমাদের চেক করুন AWS Inferentia2 এ বড় মডেল ইনফারেন্স কন্টেনার ব্যবহার করে বড় ভাষার মডেল স্থাপন করুন মডেল ইনফারেন্স কন্টেনার ব্যবহার করে AWS Inferentia2-এ LLM স্থাপন করার বিষয়ে জানতে। অতিরিক্ত উদাহরণের জন্য, দেখুন AWS নিউরন নমুনা GitHub রেপো.

লেখক সম্পর্কে

সমীর আরাজ্জো এডাব্লুএসে একটি এআই / এমএল সলিউশন আর্কিটেক্ট। তিনি এআই / এমএল সমাধান তৈরি করতে গ্রাহকদের সহায়তা করেন যা এডাব্লুএস ব্যবহার করে তাদের ব্যবসায়ের চ্যালেঞ্জগুলি সমাধান করে। তিনি কম্পিউটার ভিশন, প্রাকৃতিক ভাষা প্রক্রিয়াজাতকরণ, পূর্বাভাস, এমএল প্রান্তে এবং আরও অনেকগুলি সম্পর্কিত বেশ কয়েকটি এআই / এমএল প্রকল্পগুলিতে কাজ করছেন। তিনি তার ফ্রি সময়ে হার্ডওয়্যার এবং অটোমেশন প্রকল্পগুলির সাথে খেলতে পছন্দ করেন এবং রোবোটিকের প্রতি তাঁর বিশেষ আগ্রহ রয়েছে।

সমীর আরাজ্জো এডাব্লুএসে একটি এআই / এমএল সলিউশন আর্কিটেক্ট। তিনি এআই / এমএল সমাধান তৈরি করতে গ্রাহকদের সহায়তা করেন যা এডাব্লুএস ব্যবহার করে তাদের ব্যবসায়ের চ্যালেঞ্জগুলি সমাধান করে। তিনি কম্পিউটার ভিশন, প্রাকৃতিক ভাষা প্রক্রিয়াজাতকরণ, পূর্বাভাস, এমএল প্রান্তে এবং আরও অনেকগুলি সম্পর্কিত বেশ কয়েকটি এআই / এমএল প্রকল্পগুলিতে কাজ করছেন। তিনি তার ফ্রি সময়ে হার্ডওয়্যার এবং অটোমেশন প্রকল্পগুলির সাথে খেলতে পছন্দ করেন এবং রোবোটিকের প্রতি তাঁর বিশেষ আগ্রহ রয়েছে।

- এসইও চালিত বিষয়বস্তু এবং পিআর বিতরণ। আজই পরিবর্ধিত পান।

- ইভিএম ফাইন্যান্স। বিকেন্দ্রীভূত অর্থের জন্য ইউনিফাইড ইন্টারফেস। এখানে প্রবেশ করুন.

- কোয়ান্টাম মিডিয়া গ্রুপ। IR/PR প্রশস্ত। এখানে প্রবেশ করুন.

- প্লেটোএআইস্ট্রিম। Web3 ডেটা ইন্টেলিজেন্স। জ্ঞান প্রসারিত. এখানে প্রবেশ করুন.

- উত্স: https://aws.amazon.com/blogs/machine-learning/aws-inferentia2-builds-on-aws-inferentia1-by-delivering-4x-higher-throughput-and-10x-lower-latency/

- : আছে

- : হয়

- :কোথায়

- $ ইউপি

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 16

- 2019

- 224

- 32

- 50

- 7

- 8

- a

- সম্পর্কে

- দ্রুততর করা

- দ্রুততর

- ত্বরক

- বেগবর্ধক ব্যক্তি

- ত্বক

- অর্জন করা

- দিয়ে

- যোগ

- অতিরিক্ত

- অতিরিক্ত তথ্য

- যোগ করে

- পর

- আবার

- AI

- এআই / এমএল

- সব

- ইতিমধ্যে

- এছাড়াও

- বিকল্প

- বিকল্প

- যদিও

- সর্বদা

- মর্দানী স্ত্রীলোক

- আমাজন EC2

- অ্যামাজন ওয়েব সার্ভিসেস

- এএমডি

- an

- এবং

- অন্য

- কোন

- আবেদন

- অভিগমন

- এপ্রিল

- স্থাপত্য

- রয়েছি

- AS

- At

- স্বয়ংক্রিয়ভাবে

- স্বয়ংক্রিয়তা

- সহজলভ্য

- গড়

- ডেস্কটপ AWS

- এডাব্লুএস ইনফেরেন্টিয়া

- পিছনে

- ব্যান্ডউইথ

- ভিত্তি

- BE

- কারণ

- হয়েছে

- উচ্চতার চিহ্ন

- উত্তম

- মধ্যে

- বিশাল

- বৃহত্তম

- বিলিয়ন

- কোটি কোটি

- উভয়

- আনে

- বৃহত্তর

- নির্মাণ করা

- তৈরী করে

- নির্মিত

- ব্যবসায়

- কিন্তু

- by

- সি ++

- নামক

- CAN

- পেতে পারি

- ক্ষমতা

- সক্ষম

- ধারণক্ষমতা

- যত্ন

- চ্যালেঞ্জ

- পরিবর্তন

- চেক

- চিপ

- চিপস

- কোড

- সমষ্টিগত

- মেশা

- মিলিত

- আসছে

- শীঘ্রই আসছে

- তুলনীয়

- তুলনা করা

- তুলনা

- তুলনা

- উপযুক্ত

- স্থিরীকৃত

- গণনা

- গনা

- কম্পিউটার

- কম্পিউটার ভিশন

- কানেক্টিভিটি

- বিবেচনা করে

- গ্রাস করা

- আধার

- কন্টেনারগুলি

- প্রসঙ্গ

- নিয়ন্ত্রণ

- মূল

- মূল্য

- খরচ

- পারা

- সৃষ্টি

- তৈরি করা হচ্ছে

- প্রথা

- গ্রাহকদের

- কাস্টমাইজ

- উপাত্ত

- গভীর

- গভীর জ্ঞানার্জন

- প্রদান করা

- প্রদান

- দাবি

- স্থাপন

- মোতায়েন

- বিস্তৃতি

- নকশা

- পরিকল্পিত

- বিশদ

- দেব

- ডেভেলপারদের

- উন্নয়নশীল

- উন্নয়ন

- যন্ত্র

- পার্থক্য

- বিভিন্ন

- আলোচনা করা

- বিতরণ করা

- বণ্টিত

- না

- ডলার

- ডন

- Dont

- প্রগতিশীল

- পরিবর্তনশীল

- প্রতি

- প্রান্ত

- দক্ষতার

- উপাদান

- সক্ষম করা

- শেষ

- প্রান্ত

- শক্তি

- উন্নত

- পরিবেশ

- সমান

- বিশেষত

- অবশেষে

- প্রতি

- উদাহরণ

- ব্যয়বহুল

- অভিজ্ঞতা

- পরীক্ষা

- মুখ

- কারখানা

- পরিচিত

- দ্রুত

- দ্রুত

- বৈশিষ্ট্য

- সুগঠনবিশিষ্ট

- বৈশিষ্ট্য

- কয়েক

- ছাঁকনি

- আবিষ্কার

- প্রথম

- প্রথম প্রজন্ম

- নির্দলীয়

- প্রবাহ

- দৃষ্টি নিবদ্ধ করা

- অনুসরণ

- জন্য

- ভিত

- চার

- অবকাঠামো

- বিনামূল্যে

- থেকে

- সম্পূর্ণরূপে

- ক্রিয়া

- বৈশিষ্ট্য

- ভবিষ্যৎ

- সাধারন ক্ষেত্রে

- প্রজন্ম

- প্রজন্ম

- সৃজক

- জেনারেটিভ এআই

- পাওয়া

- GitHub

- প্রদত্ত

- Go

- গোল

- ভাল

- চিত্রলেখ

- মহান

- স্থল

- ক্রমবর্ধমান

- ছিল

- হার্ডওয়্যারের

- আছে

- he

- সাহায্য

- সাহায্য

- সাহায্য

- এখানে

- ঊর্ধ্বতন

- হাইলাইট

- তার

- কিভাবে

- কিভাবে

- যাহোক

- এইচটিএমএল

- HTTP

- HTTPS দ্বারা

- if

- আমদানি

- উন্নত করা

- উন্নত

- উন্নতি

- উন্নতি

- in

- সুদ্ধ

- বৃদ্ধি

- স্বাধীন

- তথ্য

- ইনিশিয়েটিভ

- ইনপুট

- ভিতরে

- উদাহরণ

- পরিবর্তে

- সংহত

- ঐক্যবদ্ধতার

- স্বার্থ

- ইন্টারফেসগুলি

- অভ্যন্তরীণ

- উপস্থাপিত

- প্রার্থনা

- IT

- জাভা

- জে আই টি JIT

- JPG

- মাত্র

- রাখা

- পালন

- ভাষা

- বড়

- বড় আকারের

- বৃহত্তর

- অদৃশ্যতা

- পরে

- শুরু করা

- চালু

- স্তর

- শিখতে

- শিক্ষা

- কম

- লাইব্রেরি

- লাইব্রেরি

- মত

- পছন্দ

- লাইন

- LINK

- লিঙ্কডইন

- তালিকা

- বোঝা

- দেখুন

- নিম্ন

- হ্রাসকরন

- মেশিন

- মেশিন লার্নিং

- প্রধান

- করা

- পরিচালিত

- অনেক

- চরমে তোলা

- মাপ

- পদ্ধতি

- সম্মেলন

- পূরণ

- স্মৃতি

- মাইগ্রেট

- মন

- ML

- মোড

- মডেল

- মডেল

- অধিক

- সেতু

- সবচেয়ে জনপ্রিয়

- MS

- অনেক

- বহু

- স্থানীয়

- প্রাকৃতিক

- স্বাভাবিক ভাষা প্রক্রিয়াকরণ

- প্রয়োজন

- চাহিদা

- নেটওয়ার্ক

- নেটওয়ার্কিং

- নতুন

- পরবর্তী

- সাধারণ

- এখন

- সংখ্যার

- এনভিডিয়া

- of

- অফার

- on

- ONE

- কেবল

- ওপেন সোর্স

- পরিচালনা

- অপারেশন

- অপারেশনস

- অপারেটর

- অপারেটরদের

- অনুকূল

- অপ্টিমাইজ

- সেরা অনুকূল রূপ

- পছন্দ

- অপশন সমূহ

- or

- সংগঠিত

- মূল

- অন্যান্য

- অন্যরা

- আমাদের

- আউটপুট

- শেষ

- প্যাকেজ

- পরামিতি

- অংশ

- বিশেষ

- যন্ত্রাংশ

- পাস

- বেতন

- কর্মক্ষমতা

- সঞ্চালিত

- Plato

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটোডাটা

- কেলি

- বিন্দু

- জনপ্রিয়

- সম্ভব

- পোস্ট

- ক্ষমতাশালী

- ভবিষ্যদ্বাণী

- ভবিষ্যতবাণী

- প্রস্তুত করা

- আগে

- পূর্বে

- মূল্য

- প্রক্রিয়া

- প্রক্রিয়াজাতকরণ

- প্রসেসর

- উত্পাদনের

- প্রোগ্রামিং

- প্রকল্প

- প্রকল্প

- উপলব্ধ

- প্রকাশ্য

- পাইথন

- পাইটার্চ

- রেঞ্জিং

- প্রস্তুত

- প্রকৃত সময়

- সুপারিশ করা

- হ্রাস করা

- হ্রাস

- হ্রাস

- সংশ্লিষ্ট

- প্রাসঙ্গিক

- প্রয়োজন

- Resources

- দায়ী

- ফলাফল

- এখানে ক্লিক করুন

- রোবোটিক্স

- সারিটি

- চালান

- দৌড়

- ঋষি নির্মাতা

- সংরক্ষণ করুন

- রক্ষা

- করাত

- SDK

- দ্বিতীয়

- দ্বিতীয় প্রজন্মের

- অধ্যায়

- দেখ

- পাঠান

- পাঠানোর

- সেবা

- সেবা

- সেট

- বিভিন্ন

- আকৃতি

- শারডিং

- ভাগ

- প্রদর্শনী

- প্রদর্শিত

- শো

- অনুরূপ

- সহজ

- একক

- আয়তন

- মাপ

- ক্ষুদ্রতর

- সলিউশন

- সমাধান

- কিছু

- শীঘ্রই

- প্রশিক্ষণ

- নির্দিষ্ট

- বিশেষভাবে

- স্পীড

- মান

- শুরু

- শুরু

- ধাপ

- এখনো

- স্টোরেজ

- অকপট

- এমন

- সমর্থন

- সমর্থিত

- সমর্থন

- সাস্টেনিবিলিটি

- টেবিল

- লাগে

- কাজ

- প্রযুক্তি

- প্রযুক্তিঃ

- tensorflow

- পরীক্ষা

- চেয়ে

- যে

- সার্জারির

- গ্রাফ

- তাদের

- তাহাদিগকে

- তারপর

- এইগুলো

- তারা

- এই

- থ্রুপুট

- সময়

- বার

- থেকে

- একসঙ্গে

- টুল

- সমাজের সারাংশ

- মশাল

- টর্চভিশন

- মোট

- চিহ্ন

- অনুসরণযোগ্য

- রচনা

- রেলগাড়ি

- প্রশিক্ষণ

- হস্তান্তর

- ট্রান্সফরমার

- স্বচ্ছভাবে

- টিউটোরিয়াল

- দুই

- আদর্শ

- ধরনের

- অনন্য

- পর্যন্ত

- আপগ্রেড

- us

- মার্কিন ডলার

- ব্যবহার

- ব্যবহৃত

- ব্যবহারকারী

- ব্যবহারকারীর অভিজ্ঞতা

- ব্যবহারকারী

- ব্যবহার

- v1

- বৈচিত্র্য

- বনাম

- খুব

- দৃষ্টি

- উষ্ণ

- ছিল

- অপব্যয়

- উপায়..

- উপায়

- we

- ওয়েব

- ওয়েব সার্ভিস

- ছিল

- কখন

- যে

- যখন

- হু

- ব্যাপক

- উইকিপিডিয়া

- ইচ্ছা

- সঙ্গে

- ছাড়া

- হয়া যাই ?

- কাজ

- লিখিত

- X

- XM

- আপনি

- আপনার

- zephyrnet