এত ডেটা, এত কম সময়। মেশিন লার্নিং (এমএল) বিশেষজ্ঞ, ডেটা বিজ্ঞানী, প্রকৌশলী এবং উত্সাহীরা বিশ্বজুড়ে এই সমস্যার মুখোমুখি হয়েছেন। প্রাকৃতিক ভাষা প্রক্রিয়াকরণ থেকে কম্পিউটারের দৃষ্টিভঙ্গি, সারণী থেকে টাইম সিরিজ, এবং এর মধ্যে সবকিছু, আপনি যতগুলি জিপিইউ পেতে পারেন তার বিপরীতে ডেটা চালানোর সময় গতির জন্য অপ্টিমাইজ করার পুরনো সমস্যাটি অগণিত সমাধানকে অনুপ্রাণিত করেছে। আজ, আমরা পাইটর্চ বিকাশকারীদের জন্য নেটিভ ওপেন-সোর্স ফ্রেমওয়ার্ক ব্যবহার করে বৈশিষ্ট্যগুলি ঘোষণা করতে পেরে খুশি, যেমন পাইটর্চ লাইটনিং এবং পাইটর্চ ডিডিপি, যা মেঘে তাদের পথ প্রবাহিত করবে।

আমাজন সেজমেকার ML-এর জন্য একটি সম্পূর্ণ-পরিচালিত পরিষেবা, এবং SageMaker মডেল প্রশিক্ষণ স্কেলে উচ্চ-কর্মক্ষমতা প্রশিক্ষণের জন্য একটি অপ্টিমাইজ করা গণনা পরিবেশ। সেজমেকার মডেল ট্রেনিং উচ্চ কর্মক্ষমতা এবং কম খরচে এমএল মডেলগুলিকে সহজে প্রশিক্ষণ এবং পুনরুত্পাদন করার জন্য একটি নিরবিচ্ছিন্ন নিয়ন্ত্রণ বিমানের সাথে দূরবর্তী প্রশিক্ষণের অভিজ্ঞতা প্রদান করে। আমরা সেজমেকার প্রশিক্ষণ পোর্টফোলিওতে নতুন বৈশিষ্ট্যগুলি ঘোষণা করতে পেরে রোমাঞ্চিত যেগুলি স্কেলে PyTorch চালানোকে আরও সহজ এবং আরও অ্যাক্সেসযোগ্য করে তোলে:

- PyTorch লাইটনিং এখন একত্রিত করা যেতে পারে SageMaker এর বিতরণ করা ডেটা সমান্তরাল লাইব্রেরি কোড পরিবর্তনের শুধুমাত্র এক লাইনের সাথে।

- সেজমেকার মডেল প্রশিক্ষণ এখন NCCL ব্যাকএন্ডের সাথে স্থানীয় PyTorch ডিস্ট্রিবিউটেড ডেটা প্যারালালের জন্য সমর্থন রয়েছে, যা ডেভেলপারদের SageMaker-এ আগের চেয়ে সহজে স্থানান্তর করতে দেয়।

এই পোস্টে, আমরা এই নতুন বৈশিষ্ট্যগুলি নিয়ে আলোচনা করব, এবং এছাড়াও শিখব যে কীভাবে অ্যামাজন সার্চ মডেল প্রশিক্ষণের সময়কে গতি বাড়ানোর জন্য সেজমেকারে অপ্টিমাইজড ডিস্ট্রিবিউটেড ট্রেনিং ব্যাকএন্ড সহ PyTorch Lightning চালায়।

অ্যামাজন অনুসন্ধান কেস স্টাডিতে ডুব দেওয়ার আগে, যারা পরিচিত নন তাদের জন্য আমরা কিছু পটভূমি দিতে চাই SageMaker এর বিতরণ করা ডেটা সমান্তরাল লাইব্রেরি. 2020 সালে, আমরা স্কেলে বিতরণ করা গ্রেডিয়েন্ট ডিসেন্টের জন্য একটি কাস্টম ক্লাস্টার কনফিগারেশন তৈরি এবং চালু করেছি যা সামগ্রিক ক্লাস্টারের কার্যকারিতা বাড়ায়, যা Amazon Science-এ চালু করা হয়েছে হেরিং. উভয় প্যারামিটার সার্ভার এবং রিং-ভিত্তিক টপোলজির সেরা ব্যবহার করে, সেজমেকার ডিস্ট্রিবিউটেড ডেটা প্যারালাল (এসএমডিডিপি) এর জন্য অপ্টিমাইজ করা হয়েছে অ্যামাজন ইলাস্টিক কম্পিউট ক্লাউড (Amazon EC2) নেটওয়ার্ক টপোলজি সহ ইএফএ. বৃহত্তর ক্লাস্টার আকারের জন্য, SMDDP Horovod (TensorFlow) এবং PyTorch বিতরণকৃত ডেটা সমান্তরালে 20-40% থ্রুপুট উন্নতি করতে সক্ষম। ছোট ক্লাস্টার মাপ এবং সমর্থিত মডেলের জন্য, আমরা সুপারিশ করি সেজমেকার ট্রেনিং কম্পাইলার, যা সামগ্রিক কাজের সময় 50% পর্যন্ত কমাতে সক্ষম।

গ্রাহক স্পটলাইট: অ্যামাজন অনুসন্ধানের সাথে সেজমেকারের অপ্টিমাইজ করা ব্যাকএন্ডে পাইটর্চ লাইটনিং

অ্যামাজন অনুসন্ধান অনুসন্ধান এবং আবিষ্কার অভিজ্ঞতার জন্য দায়ী Amazon.com. এটি Amazon-এ কেনার জন্য পণ্য খুঁজছেন এমন গ্রাহকদের অনুসন্ধানের অভিজ্ঞতার ক্ষমতা দেয়৷ উচ্চ স্তরে, Amazon অনুসন্ধান Amazon.com-এ বিক্রি হওয়া সমস্ত পণ্যের জন্য একটি সূচক তৈরি করে। যখন একজন গ্রাহক একটি প্রশ্নে প্রবেশ করেন, তখন Amazon অনুসন্ধান গ্রাহকের প্রশ্নের সাথে প্রাসঙ্গিক এবং আকর্ষণীয় পণ্যগুলিকে মেলানোর জন্য গভীর শিক্ষার মডেল সহ বিভিন্ন ধরনের ML কৌশল ব্যবহার করে৷ তারপরে এটি গ্রাহককে ফলাফল দেখানোর আগে পণ্যগুলিকে র্যাঙ্ক করে।

অ্যামাজন অনুসন্ধান বিজ্ঞানীরা পাইটর্চ লাইটনিংকে ডিপ লার্নিং মডেলগুলিকে প্রশিক্ষণ দেওয়ার জন্য একটি প্রধান কাঠামো হিসাবে ব্যবহার করেছেন যা PyTorch-এর উপরে যুক্ত করা ব্যবহারযোগ্য বৈশিষ্ট্যগুলির কারণে অনুসন্ধান র্যাঙ্কিংকে শক্তিশালী করে। এই নতুন SageMaker লঞ্চের আগে PyTorch Lightning-এ লেখা গভীর শিক্ষার মডেলগুলির জন্য SMDDP সমর্থিত ছিল না। এটি অ্যামাজন অনুসন্ধান বিজ্ঞানীদের বাধা দেয় যারা PyTorch Lightning ব্যবহার করে ডেটা সমান্তরাল কৌশলগুলি ব্যবহার করে তাদের মডেল প্রশিক্ষণকে স্কেল করতে পছন্দ করে, তাদের প্রশিক্ষণের সময় উল্লেখযোগ্যভাবে কমিয়ে দেয় এবং তাদের নতুন পরীক্ষাগুলি পরীক্ষা করা থেকে বাধা দেয় যার জন্য আরও স্কেলযোগ্য প্রশিক্ষণের প্রয়োজন হয়।

দলের প্রাথমিক বেঞ্চমার্কিং ফলাফলগুলি একটি নমুনা মডেলের জন্য 7.3 গুণ দ্রুত প্রশিক্ষণের সময় দেখায় যখন একটি একক-নোড প্রশিক্ষণ বেসলাইনের তুলনায় আটটি নোডে প্রশিক্ষণ দেওয়া হয়। এই বেঞ্চমার্কিং-এ ব্যবহৃত বেসলাইন মডেল হল একটি মাল্টি-লেয়ার পারসেপ্ট্রন নিউরাল নেটওয়ার্ক যেখানে সাতটি ঘন সম্পূর্ণভাবে সংযুক্ত স্তর এবং 200 টিরও বেশি প্যারামিটার রয়েছে। নিম্নলিখিত সারণী ml.p3.16xlarge SageMaker প্রশিক্ষণ দৃষ্টান্তে বেঞ্চমার্কিং ফলাফলের সংক্ষিপ্ত বিবরণ দেয়।

| দৃষ্টান্তের সংখ্যা | প্রশিক্ষণের সময় (মিনিট) | উন্নতি |

| 1 | 99 | বেসলাইন |

| 2 | 55 | 1.8x |

| 4 | 27 | 3.7x |

| 8 | 13.5 | 7.3x |

এরপরে, আমরা নতুন লঞ্চের বিশদ বিবরণে ডুব দিই। আপনি যদি চান, আপনি আমাদের সংশ্লিষ্ট মাধ্যমে পদক্ষেপ করতে পারেন উদাহরণ নোটবুক।

SageMaker বিতরণকৃত প্রশিক্ষণ লাইব্রেরির সাথে PyTorch Lightning চালান

আমরা ঘোষণা করতে পেরে আনন্দিত যে SageMaker ডেটা সমান্তরাল এখন SageMaker প্রশিক্ষণের মধ্যে PyTorch Lightning-এর সাথে নির্বিঘ্নে একত্রিত হয়েছে।

PyTorch Lightning হল একটি ওপেন সোর্স ফ্রেমওয়ার্ক যা PyTorch-এ কাস্টম মডেল লেখার জন্য একটি সরলীকরণ প্রদান করে। টেনসরফ্লো-এর জন্য কেরাস যা করেছে তার মতো কিছু উপায়ে, বা এমনকি যুক্তিযুক্তভাবে আলিঙ্গন ফেস, PyTorch Lightning একটি উচ্চ-স্তরের API প্রদান করে যার মধ্যে PyTorch-এর অনেক নিম্ন-স্তরের কার্যকারিতার জন্য বিমূর্ততা রয়েছে। এর মধ্যে রয়েছে মডেল সংজ্ঞায়িত করা, প্রোফাইলিং, মূল্যায়ন, ছাঁটাই, মডেল সমান্তরালতা, হাইপারপ্যারামিটার কনফিগারেশন, ট্রান্সফার লার্নিং এবং আরও অনেক কিছু।

পূর্বে, PyTorch Lightning ডেভেলপাররা কীভাবে তাদের প্রশিক্ষণ কোডকে উচ্চ-পারফরম্যান্স SageMaker GPU ক্লাস্টারে নির্বিঘ্নে স্থানান্তর করতে হয় সে সম্পর্কে অনিশ্চিত ছিল। উপরন্তু, SageMaker ডেটা সমান্তরাল দ্বারা প্রবর্তিত দক্ষতা লাভের সুবিধা নেওয়ার তাদের জন্য কোন উপায় ছিল না।

PyTorch Lightning-এর জন্য, সাধারণভাবে বলতে গেলে, SageMaker Training-এ এই APIগুলি চালানোর জন্য সামান্য-কোন-কোড পরিবর্তন করা উচিত নয়। উদাহরণে নোটবুক আমরা ব্যবহার করি ডিডিপি স্ট্র্যাটেজি এবং DDPP প্লাগইন পদ্ধতি।

একটি অপ্টিমাইজড ব্যাকএন্ড হিসাবে SageMaker ডেটা সমান্তরাল সহ PyTorch Lightning ব্যবহার করার জন্য তিনটি ধাপ রয়েছে:

- একটি সমর্থিত ব্যবহার করুন AWS ডিপ লার্নিং কন্টেইনার (DLC) আপনার বেস ইমেজ হিসাবে, অথবা ঐচ্ছিকভাবে আপনার নিজস্ব ধারক তৈরি করুন এবং সেজমেকার ডেটা প্যারালাল ব্যাকএন্ড নিজেই ইনস্টল করুন. নিশ্চিত করুন যে আপনার প্রয়োজনীয় প্যাকেজগুলিতে PyTorch Lightning অন্তর্ভুক্ত রয়েছে, যেমন a এর সাথে

requirements.txtফাইল. - আপনার প্রশিক্ষণ স্ক্রিপ্টে কিছু ছোটখাটো কোড পরিবর্তন করুন যা অপ্টিমাইজ করা ব্যাকএন্ড সক্ষম করে। এর মধ্যে রয়েছে:

- এসএম ডিডিপি লাইব্রেরি আমদানি করুন:

- সেজমেকারের জন্য পাইটর্চ লাইটনিং পরিবেশ সেট আপ করুন:

- আপনি যদি 1.5.10 এর থেকে পুরানো PyTorch Lightning-এর সংস্করণ ব্যবহার করেন তবে আপনাকে আরও কয়েকটি ধাপ যোগ করতে হবে।

- প্রথমে, পরিবেশ পরিবর্তনশীল যোগ করুন:

- দ্বিতীয়ত, আপনি ব্যবহার নিশ্চিত করুন

DDPPlugin, বরংDDPStrategy. আপনি যদি আরও সাম্প্রতিক সংস্করণ ব্যবহার করেন, যা আপনি সহজেই স্থাপন করে সেট করতে পারেনrequirements.txtমধ্যেsource_dirআপনার কাজের জন্য, তাহলে এটির প্রয়োজন নেই। নিম্নলিখিত কোড দেখুন:

- ঐচ্ছিকভাবে, আপনার প্রক্রিয়া গ্রুপ ব্যাকএন্ড হিসাবে সংজ্ঞায়িত করুন

"smddp"মধ্যেDDPSTrategyবস্তু যাইহোক, যদি আপনি PyTorch DDP ব্যাকএন্ডের সাথে PyTorch Lightning ব্যবহার করেন, যা সমর্থিত, তাহলে সহজভাবে এটি সরিয়ে ফেলুন `process_group_backend` পরামিতি। নিম্নলিখিত কোড দেখুন:

- নিশ্চিত করুন যে আপনার একটি বন্টন পদ্ধতি অনুমানকারীতে উল্লেখ করা আছে, যেমন

distribution={"smdistributed":{"dataparallel":{"enabled":True}আপনি যদি হেরিং ব্যাকএন্ড ব্যবহার করেন, বাdistribution={"pytorchddp":{"enabled":True}.

- উপযুক্ত পরামিতি একটি সম্পূর্ণ তালিকা জন্য

distributionপ্যারামিটার, আমাদের ডকুমেন্টেশন দেখুন এখানে.

এখন আপনি আপনার SageMaker প্রশিক্ষণ কাজ চালু করতে পারেন! আপনি পাইথন SDK, Boto3, SageMaker কনসোল, এর মাধ্যমে আপনার প্রশিক্ষণের কাজটি চালু করতে পারেন এডাব্লুএস কমান্ড লাইন ইন্টারফেস (AWS CLI), এবং অগণিত অন্যান্য পদ্ধতি। একটি AWS দৃষ্টিকোণ থেকে, এটি হয় একটি একক API কমান্ড: create-training-job. আপনি আপনার স্থানীয় টার্মিনাল থেকে এই কমান্ডটি চালু করেন কিনা, একটি এডাব্লুএস ল্যাম্বদা ফাংশন, একটি অ্যামাজন সেজমেকার স্টুডিও নোটবুক, একটি KubeFlow পাইপলাইন, বা অন্য কোনো গণনা পরিবেশ সম্পূর্ণরূপে আপনার উপর নির্ভর করে।

অনুগ্রহ করে মনে রাখবেন যে PyTorch Lightning এবং SageMaker Data Parallel-এর মধ্যে ইন্টিগ্রেশন বর্তমানে PyTorch-এর শুধুমাত্র নতুন সংস্করণগুলির জন্য সমর্থিত, 1.11 থেকে শুরু হয়৷ উপরন্তু, PyTorch 1.12 থেকে শুরু হওয়া SageMaker-এর জন্য এই রিলিজটি শুধুমাত্র AWS DLC-তে পাওয়া যায়। নিশ্চিত করুন যে আপনি এই ছবিটিকে আপনার ভিত্তি হিসাবে নির্দেশ করেছেন৷ ভিতরে us-east-1, এই ঠিকানাটি নিম্নরূপ:

তারপরে আপনি এটিকে আপনার বেস ইমেজ হিসাবে ব্যবহার করে আপনার ডকার কন্টেইনারকে প্রসারিত করতে পারেন, অথবা আপনি এটিকে পরিবর্তনশীল হিসাবে পাস করতে পারেন image_uri এর যুক্তি সেজমেকার প্রশিক্ষণ অনুমানকারী।

ফলস্বরূপ, আপনি AWS-এ উপলব্ধ সেরা পারফরম্যান্স সহ SageMaker Training-এর অপ্টিমাইজ করা GPU-তে আপনার PyTorch Lightning কোড চালাতে সক্ষম হবেন।

SageMaker-এ PyTorch বিতরণ করা ডেটা সমান্তরাল চালান

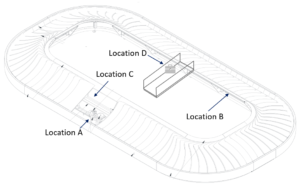

সবচেয়ে বড় সমস্যা PyTorch বিতরণ করা ডেটা সমান্তরাল (DDP) সমাধান প্রতারণামূলকভাবে সহজ: গতি। একটি ভাল বিতরণ করা প্রশিক্ষণ কাঠামো স্থিতিশীলতা, নির্ভরযোগ্যতা এবং সবচেয়ে গুরুত্বপূর্ণভাবে, স্কেলে চমৎকার কর্মক্ষমতা প্রদান করা উচিত। PyTorch DDP একক-নোড এবং মাল্টি-নোড উভয় সেটিংসে একাধিক GPU ডিভাইসে তাদের মডেলগুলিকে প্রতিলিপি করার জন্য API সহ টর্চ ডেভেলপারদের প্রদানের মাধ্যমে এটি সরবরাহ করে। ফ্রেমওয়ার্ক তারপর প্রশিক্ষণ ডেটাসেট থেকে প্রতিটি মডেলের অনুলিপিতে বিভিন্ন অবজেক্টের শার্ডিং পরিচালনা করে, প্রতিটি মডেল কপির প্রতিটি ধাপে সিঙ্ক্রোনাইজ করার জন্য গ্রেডিয়েন্টের গড় করে। এটি সম্পূর্ণ প্রশিক্ষণ রানের মোট সমাপ্তিতে একটি মডেল তৈরি করে। নিম্নলিখিত চিত্রটি এই প্রক্রিয়াটি চিত্রিত করে।

PyTorch DDP বড় ডেটাসেট ব্যবহার করে এমন প্রকল্পগুলিতে সাধারণ। প্রতিটি ডেটাসেটের সুনির্দিষ্ট আকার ব্যাপকভাবে পরিবর্তিত হবে, তবে একটি সাধারণ নির্দেশিকা হল ডেটাসেট, গণনার আকার এবং মডেলের আকার একই অনুপাতের স্কেল করা। বলা স্কেলিং আইন, এই তিনটির সর্বোত্তম সংমিশ্রণ বিতর্কের জন্য অনেক বেশি এবং অ্যাপ্লিকেশনের উপর ভিত্তি করে পরিবর্তিত হবে। AWS-এ, একাধিক গ্রাহকদের সাথে কাজ করার উপর ভিত্তি করে, আমরা ডেটা সমান্তরাল কৌশলগুলির সুবিধাগুলি স্পষ্টভাবে দেখতে পারি যখন একটি সামগ্রিক ডেটাসেটের আকার কমপক্ষে কয়েক দশ GBs হয়। যখন ডেটাসেটগুলি আরও বড় হয়, তখন সামগ্রিক পরীক্ষার গতি বাড়ানোর এবং আপনার সময়কে মান উন্নত করার জন্য কিছু ধরণের ডেটা সমান্তরাল কৌশল প্রয়োগ করা একটি গুরুত্বপূর্ণ কৌশল।

পূর্বে, যে সমস্ত গ্রাহকরা প্রাঙ্গনে বা অন্যান্য গণনা পরিবেশে বিতরণ করা প্রশিক্ষণের জন্য PyTorch DDP ব্যবহার করছিলেন তাদের একটি কাঠামোর অভাব ছিল যাতে তাদের প্রকল্পগুলিকে সহজে SageMaker প্রশিক্ষণে স্থানান্তরিত করা যায় যাতে একটি নিরবিচ্ছিন্ন নিয়ন্ত্রণ সমতলের সাথে উচ্চ-কার্যক্ষমতা সম্পন্ন GPU-এর সুবিধা নেওয়া যায়। বিশেষত, তাদের হয় তাদের ডেটা সমান্তরাল ফ্রেমওয়ার্ক এসএমডিডিপিতে স্থানান্তরিত করতে হবে, অথবা সেজমেকার প্রশিক্ষণে ম্যানুয়ালি পাইটর্চ ডিডিপি-এর ক্ষমতা বিকাশ ও পরীক্ষা করতে হবে। আজ, সেজমেকার ট্রেনিং তাদের PyTorch DDP কোডে অনবোর্ডিং গ্রাহকদের জন্য একটি নিরবচ্ছিন্ন অভিজ্ঞতা প্রদান করতে পেরে খুশি।

এটি কার্যকরভাবে ব্যবহার করার জন্য, আপনাকে আপনার প্রশিক্ষণ স্ক্রিপ্টগুলিতে কোন পরিবর্তন করতে হবে না।

আপনি নিম্নলিখিত কোডে এই নতুন প্যারামিটারটি দেখতে পারেন। মধ্যে distribution প্যারামিটার, সহজভাবে যোগ করুন pytorchddp এবং সেট সক্রিয় হিসাবে true.

এই নতুন কনফিগারেশনটি SageMaker Python SDK সংস্করণ 2.102.0 এবং PyTorch DLC এর 1.11 এ শুরু হয়।

PyTorch DDP বিকাশকারীদের জন্য যারা জনপ্রিয় সাথে পরিচিত টর্চরান ফ্রেমওয়ার্ক, এটি জেনে রাখা সহায়ক যে এটি সেজমেকার প্রশিক্ষণ পরিবেশে প্রয়োজনীয় নয়, যা ইতিমধ্যেই শক্তিশালী দোষ সহনশীলতা প্রদান করে। যাইহোক, কোড পুনঃলিখন কমাতে, আপনি অন্য লঞ্চার স্ক্রিপ্ট আনতে পারেন যা এই কমান্ডটি আপনার এন্ট্রি পয়েন্ট হিসাবে চালায়।

এখন PyTorch বিকাশকারীরা সহজেই তাদের স্ক্রিপ্টগুলিকে SageMaker-এ স্থানান্তর করতে পারে, নিশ্চিত করে যে তাদের স্ক্রিপ্ট এবং কন্টেনারগুলি একাধিক কম্পিউট পরিবেশে নির্বিঘ্নে চলতে পারে।

এটি তাদের ভবিষ্যতে সুবিধা নিতে প্রস্তুত করে সেজমেকারের বিতরণকৃত প্রশিক্ষণ লাইব্রেরি যেগুলি AWS-অপ্টিমাইজড ট্রেনিং টপোলজি প্রদান করে যাতে 40% পর্যন্ত স্পিডআপ এনহান্সমেন্ট প্রদান করা যায়। PyTorch বিকাশকারীদের জন্য, এটি কোডের একক লাইন! PyTorch DDP কোডের জন্য, আপনি সহজভাবে ব্যাকএন্ড সেট করতে পারেন smddp শুরুতে (দেখুন একটি PyTorch প্রশিক্ষণ স্ক্রিপ্ট পরিবর্তন করুন), নিম্নলিখিত কোডে দেখানো হয়েছে:

আমরা উপরে দেখেছি, আপনি এর ব্যাকএন্ডও সেট করতে পারেন DDPStrategy থেকে smddp লাইটনিং ব্যবহার করার সময়। এই পর্যন্ত হতে পারে 40% সামগ্রিক গতি বড় ক্লাস্টার জন্য! সেজমেকারে বিতরণ করা প্রশিক্ষণ সম্পর্কে আরও জানতে দেখুন আমাদের অন-ডিমান্ড ওয়েবিনার, সমর্থন নোটবুক, প্রাসঙ্গিক ডকুমেন্টেশন, এবং কাগজপত্র.

উপসংহার

এই পোস্টে, আমরা সেজমেকার ট্রেনিং পরিবারের মধ্যে দুটি নতুন বৈশিষ্ট্য চালু করেছি। এটি PyTorch বিকাশকারীদের জন্য PyTorch DDP এবং PyTorch Lightning উভয় SageMaker-এ তাদের বিদ্যমান কোড ব্যবহার করা আরও সহজ করে তোলে।

আমরা আরও দেখিয়েছি যে কীভাবে Amazon অনুসন্ধান তাদের গভীর শিক্ষার মডেলগুলিকে প্রশিক্ষণের জন্য SageMaker প্রশিক্ষণ ব্যবহার করে, এবং বিশেষ করে PyTorch Lightning-এর সাথে SageMaker ডেটা সমান্তরাল অপ্টিমাইজ করা যৌথ লাইব্রেরি ব্যাকএন্ড হিসাবে। সামগ্রিকভাবে বিতরণ প্রশিক্ষণে চলে যাওয়া Amazon অনুসন্ধানকে 7.3x দ্রুত ট্রেনের সময় অর্জনে সহায়তা করেছে।

লেখক সম্পর্কে

এমিলি ওয়েবার SageMaker চালু হওয়ার ঠিক পরে AWS-এ যোগদান করেছে, এবং তখন থেকেই বিশ্বকে এটি সম্পর্কে জানানোর চেষ্টা করছে! গ্রাহকদের জন্য নতুন ML অভিজ্ঞতা তৈরির বাইরে, এমিলি তিব্বতি বৌদ্ধধর্মের ধ্যান ও অধ্যয়ন উপভোগ করেন।

এমিলি ওয়েবার SageMaker চালু হওয়ার ঠিক পরে AWS-এ যোগদান করেছে, এবং তখন থেকেই বিশ্বকে এটি সম্পর্কে জানানোর চেষ্টা করছে! গ্রাহকদের জন্য নতুন ML অভিজ্ঞতা তৈরির বাইরে, এমিলি তিব্বতি বৌদ্ধধর্মের ধ্যান ও অধ্যয়ন উপভোগ করেন।

করণ ধীমান কানাডার টরন্টোতে অবস্থিত AWS-এর একজন সফটওয়্যার ডেভেলপমেন্ট ইঞ্জিনিয়ার। তিনি মেশিন লার্নিং স্পেস এবং ডিস্ট্রিবিউটেড কম্পিউটিং ওয়ার্কলোড ত্বরান্বিত করার জন্য সমাধান তৈরির বিষয়ে অত্যন্ত উত্সাহী।

করণ ধীমান কানাডার টরন্টোতে অবস্থিত AWS-এর একজন সফটওয়্যার ডেভেলপমেন্ট ইঞ্জিনিয়ার। তিনি মেশিন লার্নিং স্পেস এবং ডিস্ট্রিবিউটেড কম্পিউটিং ওয়ার্কলোড ত্বরান্বিত করার জন্য সমাধান তৈরির বিষয়ে অত্যন্ত উত্সাহী।

বিশ্ব কারিয়া AWS ডিপ ইঞ্জিনে একজন সফটওয়্যার ডেভেলপমেন্ট ইঞ্জিনিয়ার। মেশিন লার্নিং এবং ডিস্ট্রিবিউটেড সিস্টেমের সংযোগস্থলে তার আগ্রহ রয়েছে এবং তিনি প্রযুক্তি এবং এআইতে নারীদের ক্ষমতায়নের বিষয়েও আগ্রহী।

বিশ্ব কারিয়া AWS ডিপ ইঞ্জিনে একজন সফটওয়্যার ডেভেলপমেন্ট ইঞ্জিনিয়ার। মেশিন লার্নিং এবং ডিস্ট্রিবিউটেড সিস্টেমের সংযোগস্থলে তার আগ্রহ রয়েছে এবং তিনি প্রযুক্তি এবং এআইতে নারীদের ক্ষমতায়নের বিষয়েও আগ্রহী।

ইমান এলনাহরাউয়ী অ্যামাজন অনুসন্ধানের একজন প্রধান সফ্টওয়্যার ইঞ্জিনিয়ার হলেন মেশিন লার্নিং ত্বরণ, স্কেলিং এবং অটোমেশনের প্রচেষ্টার নেতৃত্ব দিচ্ছেন৷ তার দক্ষতা মেশিন লার্নিং, ডিস্ট্রিবিউটেড সিস্টেম এবং ব্যক্তিগতকরণ সহ একাধিক ক্ষেত্রে বিস্তৃত।

ইমান এলনাহরাউয়ী অ্যামাজন অনুসন্ধানের একজন প্রধান সফ্টওয়্যার ইঞ্জিনিয়ার হলেন মেশিন লার্নিং ত্বরণ, স্কেলিং এবং অটোমেশনের প্রচেষ্টার নেতৃত্ব দিচ্ছেন৷ তার দক্ষতা মেশিন লার্নিং, ডিস্ট্রিবিউটেড সিস্টেম এবং ব্যক্তিগতকরণ সহ একাধিক ক্ষেত্রে বিস্তৃত।

- AI

- ai শিল্প

- এআই আর্ট জেনারেটর

- আইআই রোবট

- আমাজন সেজমেকার

- কৃত্রিম বুদ্ধিমত্তা

- কৃত্রিম বুদ্ধিমত্তা সার্টিফিকেশন

- ব্যাংকিং এ কৃত্রিম বুদ্ধিমত্তা

- কৃত্রিম বুদ্ধিমত্তার রোবট

- কৃত্রিম বুদ্ধিমত্তার রোবট

- কৃত্রিম বুদ্ধিমত্তা সফ্টওয়্যার

- এডাব্লুএস মেশিন লার্নিং

- blockchain

- ব্লকচেইন সম্মেলন এআই

- coingenius

- কথোপকথন কৃত্রিম বুদ্ধিমত্তা

- ক্রিপ্টো সম্মেলন এআই

- ডাল-ই

- গভীর জ্ঞানার্জন

- গুগল আই

- মেশিন লার্নিং

- Plato

- প্লেটো এআই

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটো গেম

- প্লেটোডাটা

- প্লেটোগেমিং

- স্কেল ai

- বাক্য গঠন

- zephyrnet